Содержание

- 2. Big Data Определения (не верные): Big Data – это когда данных больше, чем 100Гб (500Гб, 1ТБ,

- 3. Big Data - примеры GPS-сигналы от автомобилей для транспортной компании Данные, снимаемые с датчиков в большом

- 4. Популярность термина https://trends.google.com/trends/explore?q=big%20data

- 5. MapReduce MapReduce

- 6. Парадигма MapReduce MapReduce – это модель распределенной обработки данных, предложенная компанией Google для обработки больших объёмов

- 7. Типичная реализация подхода MapReduce Подход состоит из нескольких стадий. Применение Map-функции к каждому элементу исходной коллекции.

- 8. Типичная реализация подхода MapReduce Сортировка всех пар Key/Value и создание новых экземпляров объектов, где все значения

- 9. Типичная реализация подхода MapReduce Выполнение функции Reduce — для каждого сгруппированного экземпляра Key/Value объекта. Функция Reduce

- 10. Дополнительные факты про MapReduce 1) Все запуски функции map работают независимо и могут работать параллельно, в

- 11. Парадигма MapReduce Паради́гма— это совокупность идей и понятий, определяющих подход к решению задач в определенной области.

- 12. Пример

- 13. Hadoop

- 14. Hadoop MapReduce Hadoop –программная платформа (software framework) построения распределенных приложений для массово-параллельной обработки (massive parallel processing,

- 15. Проекты, связанные с Hadoop, но не входящих в Hadoop core Hive – инструмент для SQL-like запросов

- 16. Упрощенный вид кластера Hadoop (уровень HDFS)

- 17. Характеристики HDFS hdfs лучше работает с небольшим числом больших файлов/блоков; один раз записали, много раз считали;

- 18. Пример кластера Hadoop (уровень mapreduce)

- 19. Архитектура Hadoop

- 20. Пример WordCount https://habr.com/ru/company/dca/blog/268277/ Суть реализации задачи WordCount создать 2 класса, наследуемых от org.apache.hadoop.mapred.MapReduceBase. реализация интерфейса org.apache.hadoop.mapred.Mapper

- 21. Пример WordCount Hadoop сделает самостоятельно: копирование jar-файла с заданием; разбиение входных данных на части; назначение каждому

- 22. Hadoop & big data

- 23. Приемы и стратегии разработки MapReduce-приложений

- 24. Map only job Примеры задач только со стадией Map : Фильтрация данных (например, «Найти все записи

- 25. Map only job

- 26. Combine

- 27. Цепочки MapReduce-задач Задача: имеется набор текстовых документов, необходимо посчитать, сколько слов встретилось от 1 до 1000

- 28. Map-Reduce на примере MongoDB Входные коллекции: Выходная коллекция:

- 29. Map-Reduce на примере MongoDB Функцию map: Функция reduce:

- 30. Map-Reduce на примере MongoDB Запуск: Требования на реализацию функции reduce: Тип возвращаемого значения функции reduce должен

- 31. Пример 2. Map-Reduce на примере MongoDB Задача: Найти среднее количество интересов у людей разных возрастов

- 32. Пример 2. Map-Reduce на примере MongoDB

- 33. Пример 2. Map-Reduce на примере MongoDB

- 34. Пример 2. Map-Reduce на примере MongoDB Команда для вызова:

- 35. Немного дегтя Инструмент: Объект: Комментарии:

- 36. Немного дегтя Инструмент: Характеристики: Комментарии: Имеет встроенный прицел Теперь его можно метать Имеет встроенный нож Это

- 37. Немного дегтя Инструмент: Характеристики: Комментарии: Имеет встроенную косу Теперь им можно косить траву ЗАЧЕМ ?

- 38. Что не так с MapReduce

- 39. Что есть Apache Spark

- 40. Spark & Hadoop

- 41. Ядро Spark Ядро отвечает за: управление памятью и восстановление после отказов планирование, распределение и отслеживание заданий

- 42. RDD (Resilient Distributed Dataset) Трансформации – это операции, совершаемые над RDD; результатом трансформации становится новый RDD,

- 43. Spark. Примеры Пример 1. Загрузка данных Загружать данные в Spark можно двумя путями: а). Непосредственно из

- 44. Combine Команда для вызова:

- 45. Combine Команда для вызова:

- 47. Скачать презентацию

Основы JDBC (Java DataBase Connectivity)

Основы JDBC (Java DataBase Connectivity) Логическая функция ЕСЛИ

Логическая функция ЕСЛИ Автоматизированная система организации спортивных мероприятий

Автоматизированная система организации спортивных мероприятий Выборки

Выборки Безопасный интернет

Безопасный интернет Программирование в Algodoo

Программирование в Algodoo Бірөлшемді және екіөлшемді массивтер

Бірөлшемді және екіөлшемді массивтер Списки в Python (тема 2)

Списки в Python (тема 2) Geschichte und zweck des computers

Geschichte und zweck des computers Формирование выходных документов на отгружаемую продукцию с помощью сетей Петри

Формирование выходных документов на отгружаемую продукцию с помощью сетей Петри Система тестирования студентов средствами Telegram-бота

Система тестирования студентов средствами Telegram-бота Понятие массива

Понятие массива Повідомлення та інформація

Повідомлення та інформація Создание элементов управления

Создание элементов управления Алгоритмы обработки массивов

Алгоритмы обработки массивов Файловая система

Файловая система Санау жүйелері: екілік, сегіздік, ондық, он алтылық

Санау жүйелері: екілік, сегіздік, ондық, он алтылық Составление и отладка линейных программ

Составление и отладка линейных программ Презентация по теме Создание реляционной базы данных

Презентация по теме Создание реляционной базы данных Интернет угрозы. Что надо знать родителям

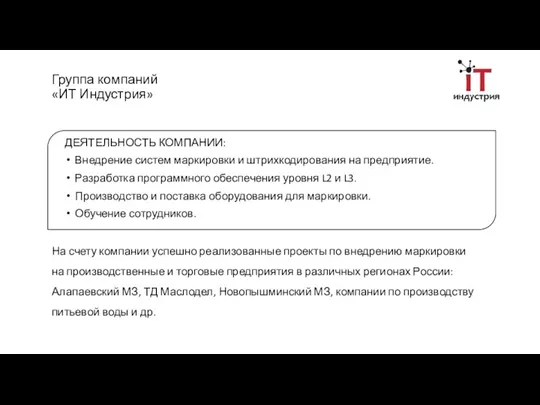

Интернет угрозы. Что надо знать родителям Группа компаний ИТ Индустрия

Группа компаний ИТ Индустрия Шифрование и дешифрование текста высокой важности

Шифрование и дешифрование текста высокой важности Сохранение и печать документов. 9 класс

Сохранение и печать документов. 9 класс Медиа-карта Красноярского края

Медиа-карта Красноярского края Эффективное Googlение

Эффективное Googlение Информационные технологии. Основные понятия и определения

Информационные технологии. Основные понятия и определения Технология автоматизации в Битрикс24

Технология автоматизации в Битрикс24 Теоретико-системные основы математического моделирования

Теоретико-системные основы математического моделирования