Основные свойства MPI - Message Passing Interface, интерфейс передачи сообщений Стандарт MPI 4.0. Лекция 4 презентация

Содержание

- 2. Основные свойства MPI - Message Passing Interface, интерфейс передачи сообщений Стандарт MPI 4.0 Языки программирования: FORTRAN/Matlab

- 3. Основные свойства Наличие групп процессов (безопасность сообщений), топологий процессов Структурирование передаваемого сообщения, типизация, гетерогенность Режимы: normal

- 4. Чего нет в MPI Функции управления процессами Работа с удаленной памятью Разделяемая общая память Потоки

- 5. Основные понятия MPI-программа – программа запускаемая одновременно на нескольких процессорах Каждая копия программы выполняется как отдельный

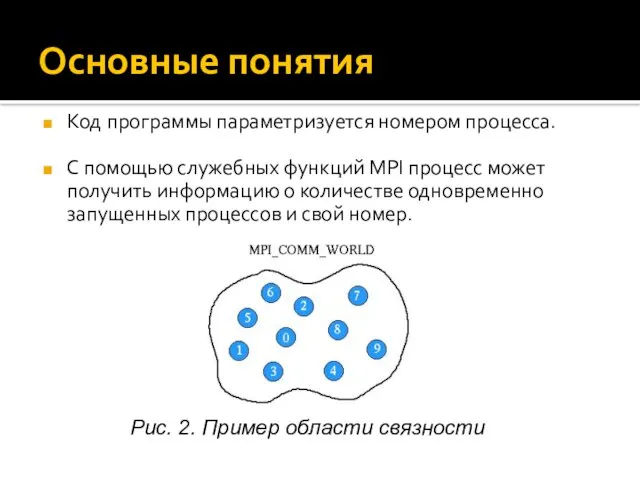

- 6. Основные понятия Код программы параметризуется номером процесса. С помощью служебных функций MPI процесс может получить информацию

- 7. Основные понятия Рис. 3. Коммуникаторы и группы в MPI

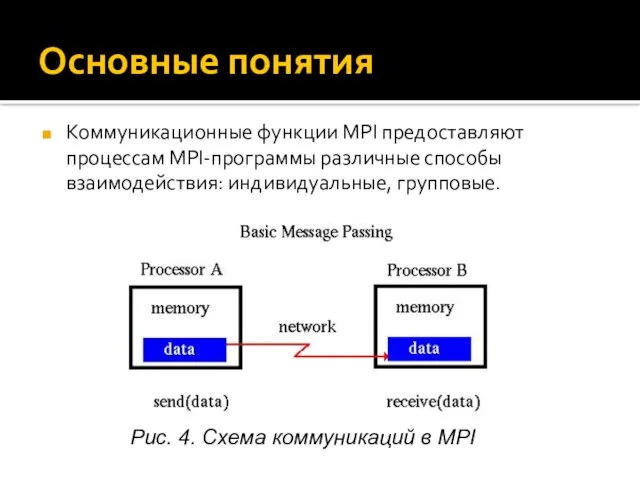

- 8. Основные понятия Коммуникационные функции MPI предоставляют процессам MPI-программы различные способы взаимодействия: индивидуальные, групповые. Рис. 4. Схема

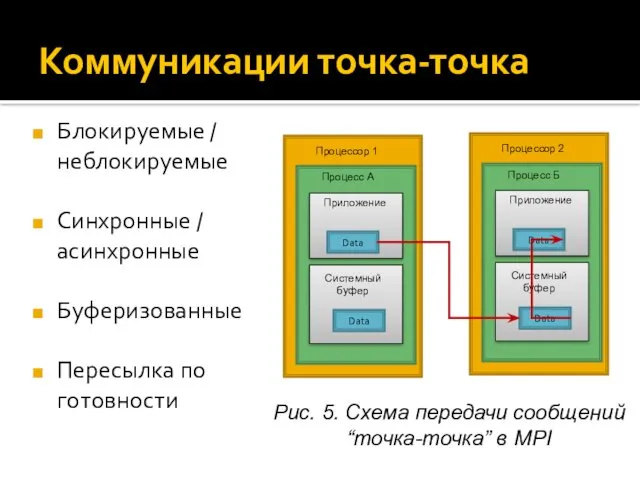

- 9. Коммуникации точка-точка Блокируемые / неблокируемые Синхронные / асинхронные Буферизованные Пересылка по готовности Рис. 5. Схема передачи

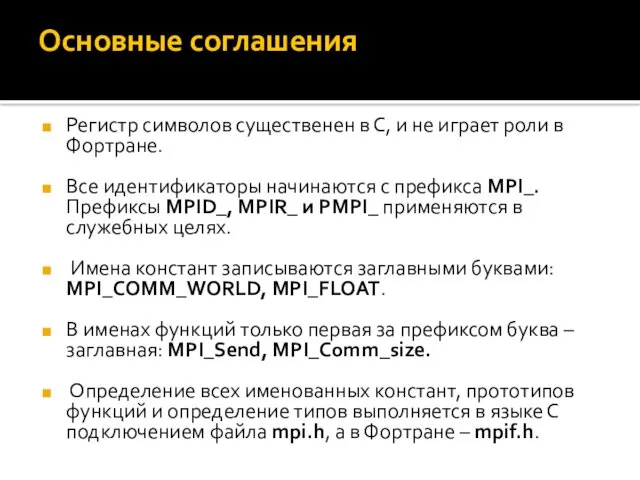

- 10. Основные соглашения Регистр символов существенен в С, и не играет роли в Фортране. Все идентификаторы начинаются

- 11. Соответствие между MPI-типами и типами языка Cи

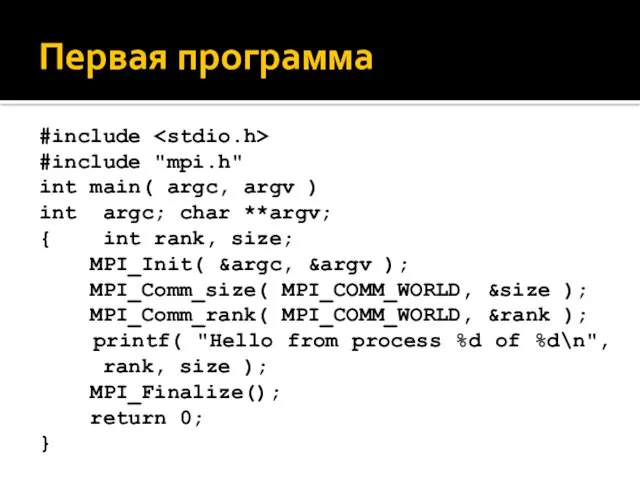

- 12. Первая программа #include #include "mpi.h" int main( argc, argv ) int argc; char **argv; { int

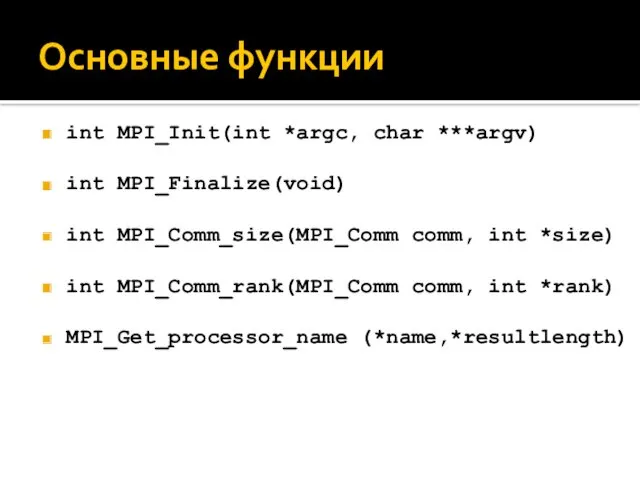

- 13. Основные функции int MPI_Init(int *argc, char ***argv) int MPI_Finalize(void) int MPI_Comm_size(MPI_Comm comm, int *size) int MPI_Comm_rank(MPI_Comm

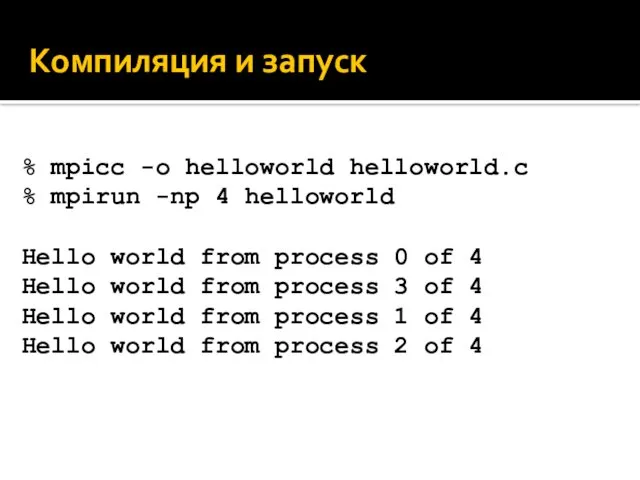

- 14. Компиляция и запуск % mpicc -o helloworld helloworld.c % mpirun -np 4 helloworld Hello world from

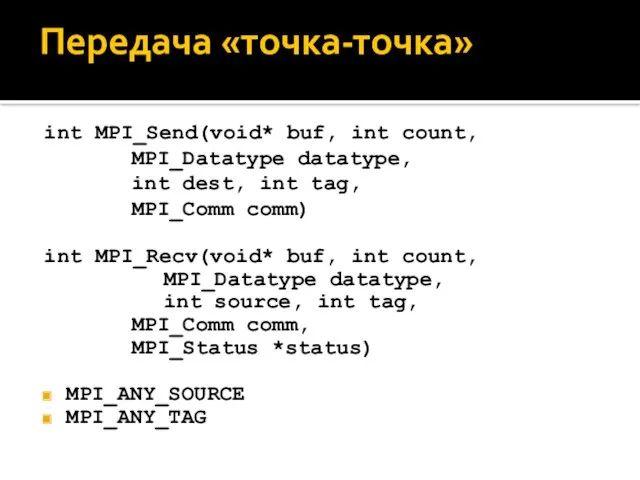

- 15. int MPI_Send(void* buf, int count, MPI_Datatype datatype, int dest, int tag, MPI_Comm comm) int MPI_Recv(void* buf,

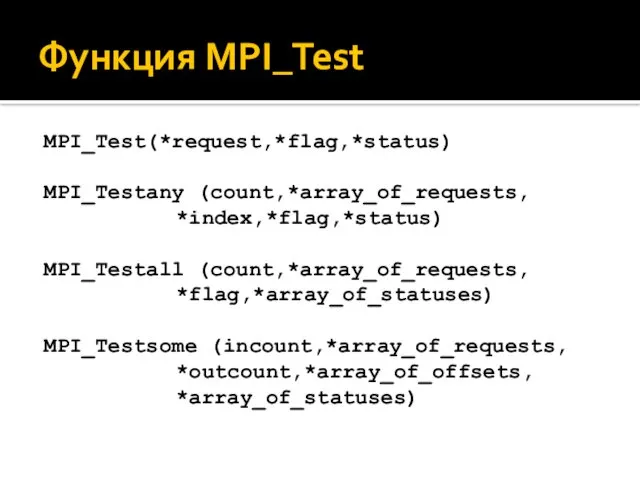

- 16. Функция MPI_Test MPI_Test(*request,*flag,*status) MPI_Testany (count,*array_of_requests, *index,*flag,*status) MPI_Testall (count,*array_of_requests, *flag,*array_of_statuses) MPI_Testsome (incount,*array_of_requests, *outcount,*array_of_offsets, *array_of_statuses)

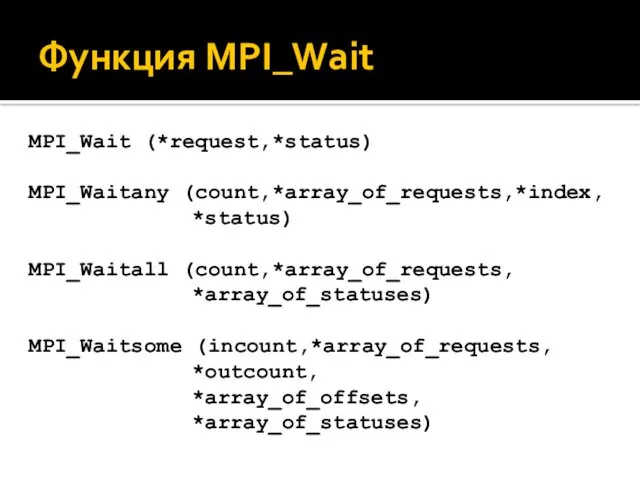

- 17. Функция MPI_Wait MPI_Wait (*request,*status) MPI_Waitany (count,*array_of_requests,*index, *status) MPI_Waitall (count,*array_of_requests, *array_of_statuses) MPI_Waitsome (incount,*array_of_requests, *outcount, *array_of_offsets, *array_of_statuses)

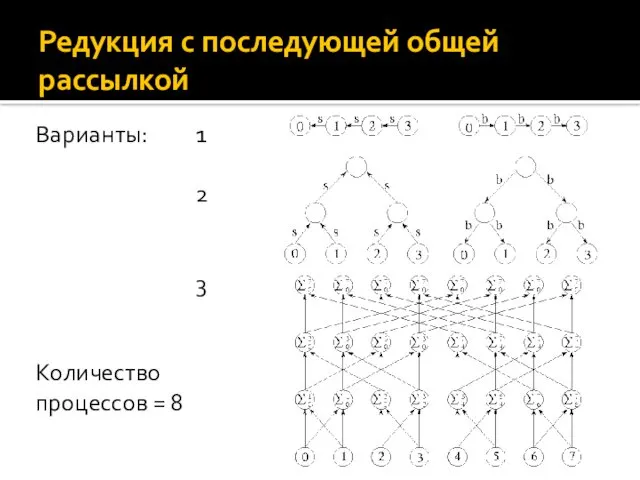

- 18. Редукция с последующей общей рассылкой Варианты: 1 2 3 Количество процессов = 8

- 19. Последовательный вариант редукции Рис. 6. Схема редукции

- 20. Вариант редукции: пирамида Рис. 7. Схема редукции

- 21. Вариант редукции: бабочка Рис. 8. Схема редукции

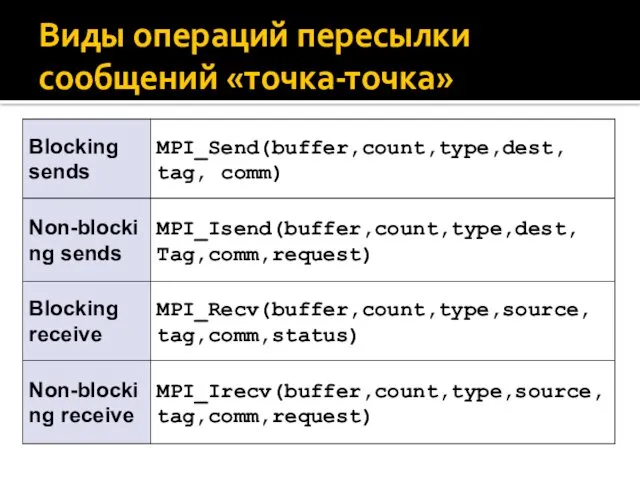

- 22. Виды операций пересылки сообщений «точка-точка»

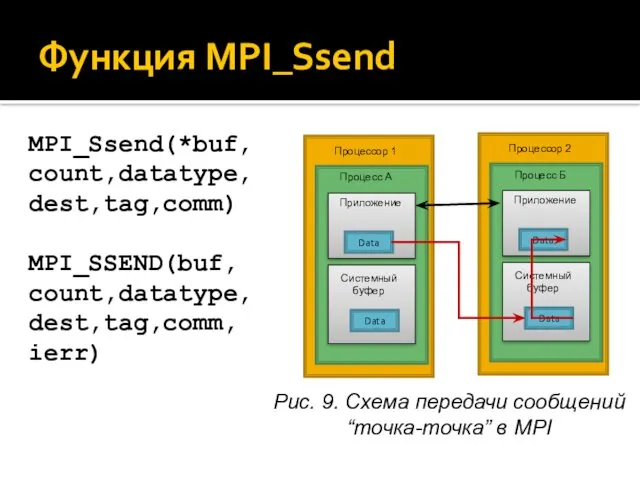

- 23. Функция MPI_Ssend MPI_Ssend(*buf, count,datatype, dest,tag,comm) MPI_SSEND(buf, count,datatype, dest,tag,comm, ierr) Рис. 9. Схема передачи сообщений “точка-точка” в

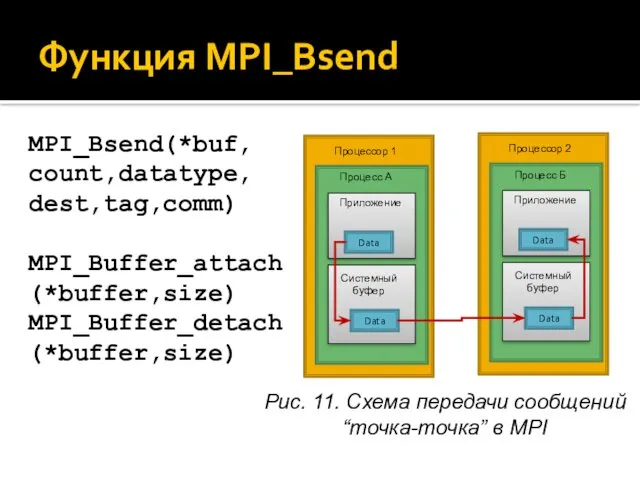

- 24. Функция MPI_Bsend MPI_Bsend(*buf, count,datatype, dest,tag,comm) MPI_Buffer_attach (*buffer,size) MPI_Buffer_detach (*buffer,size) Рис. 11. Схема передачи сообщений “точка-точка” в

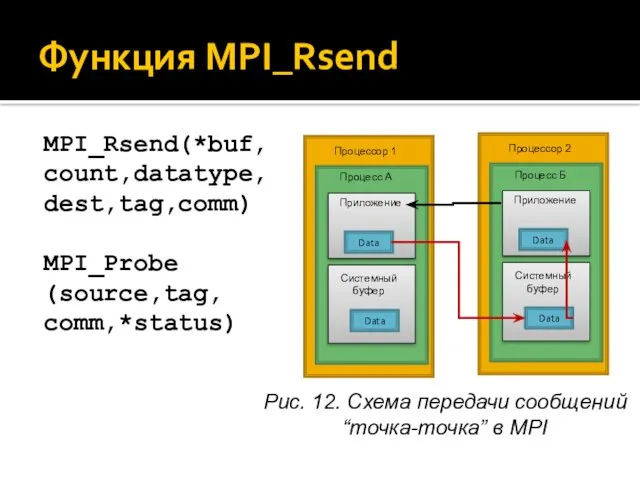

- 25. Функция MPI_Rsend MPI_Rsend(*buf,count,datatype, dest,tag,comm) MPI_Probe (source,tag, comm,*status) Рис. 12. Схема передачи сообщений “точка-точка” в MPI Процесс

- 26. Функция MPI_Sendrecv MPI_Sendrecv(*sendbuf,sendcount,sendtype, dest,sendtag, *recvbuf,recvcount,recvtype, source,recvtag,comm,*status)

- 27. Коллективные операции Необходимы для общего взаимодействия и синхронизации процессов. Функция общей синхронизации: int MPI_Barrier(MPI_Comm comm)

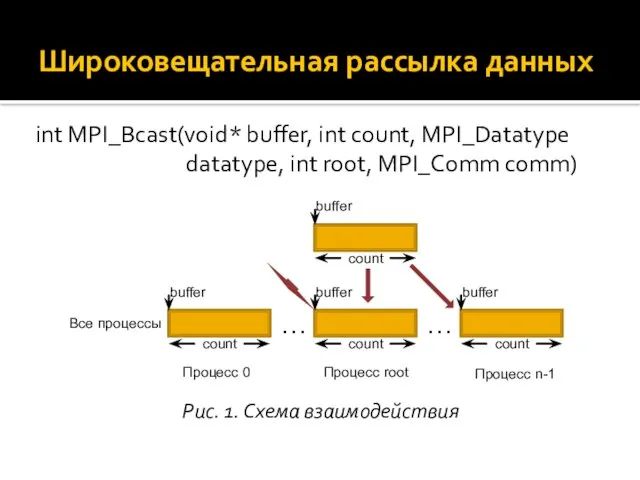

- 28. Широковещательная рассылка данных int MPI_Bcast(void* buffer, int count, MPI_Datatype datatype, int root, MPI_Comm comm) Рис. 1.

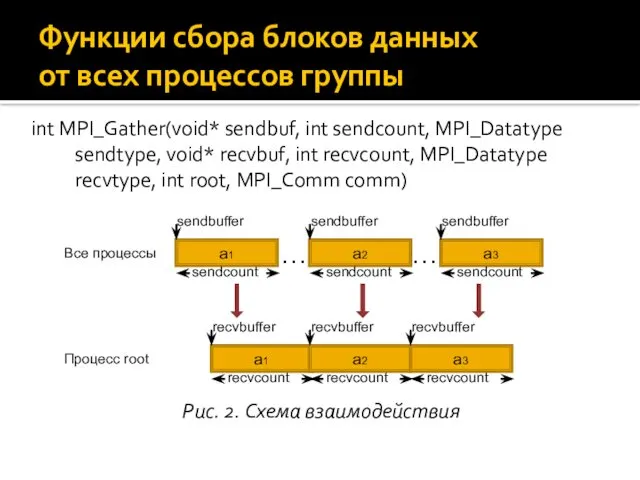

- 29. int MPI_Gather(void* sendbuf, int sendcount, MPI_Datatype sendtype, void* recvbuf, int recvcount, MPI_Datatype recvtype, int root, MPI_Comm

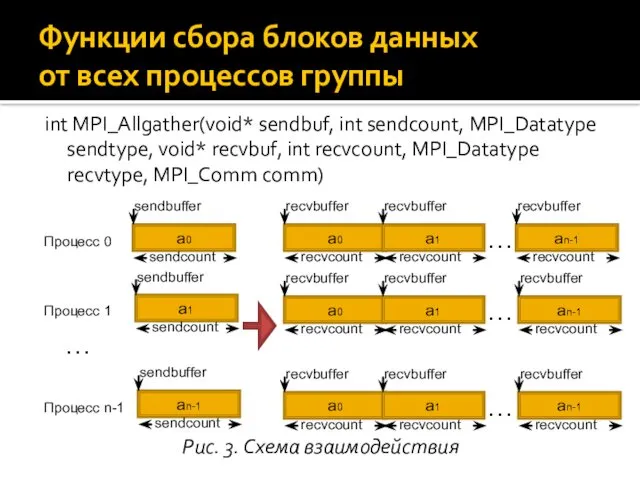

- 30. int MPI_Allgather(void* sendbuf, int sendcount, MPI_Datatype sendtype, void* recvbuf, int recvcount, MPI_Datatype recvtype, MPI_Comm comm) Функции

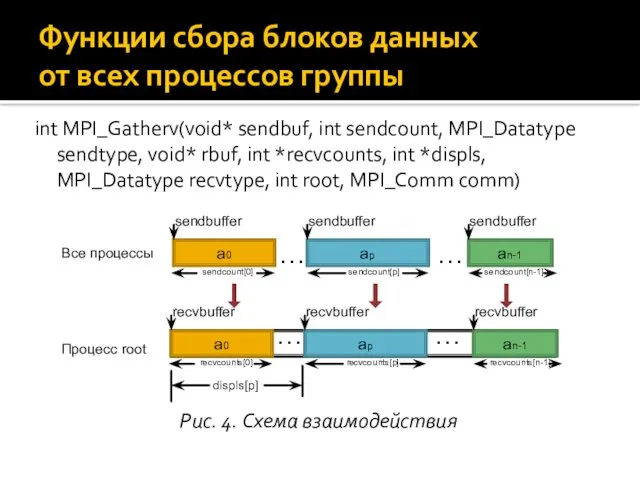

- 31. int MPI_Gatherv(void* sendbuf, int sendcount, MPI_Datatype sendtype, void* rbuf, int *recvcounts, int *displs, MPI_Datatype recvtype, int

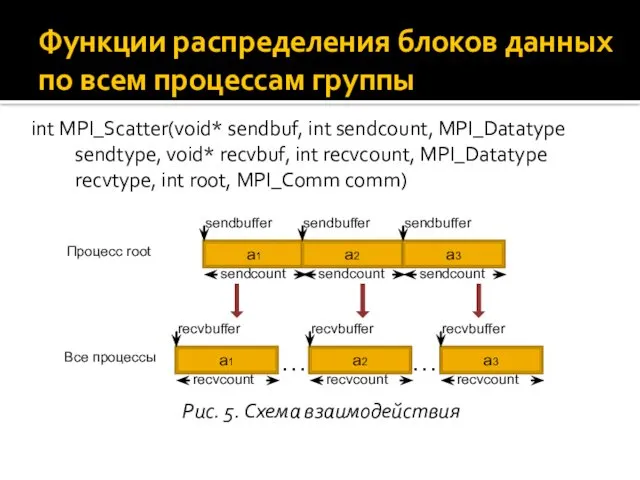

- 32. int MPI_Scatter(void* sendbuf, int sendcount, MPI_Datatype sendtype, void* recvbuf, int recvcount, MPI_Datatype recvtype, int root, MPI_Comm

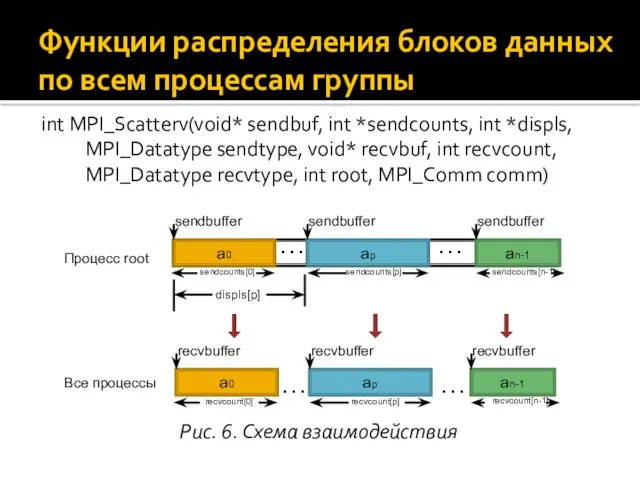

- 33. int MPI_Scatterv(void* sendbuf, int *sendcounts, int *displs, MPI_Datatype sendtype, void* recvbuf, int recvcount, MPI_Datatype recvtype, int

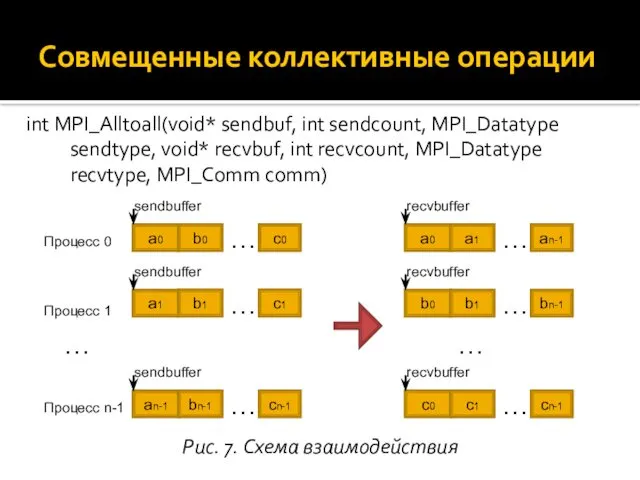

- 34. int MPI_Alltoall(void* sendbuf, int sendcount, MPI_Datatype sendtype, void* recvbuf, int recvcount, MPI_Datatype recvtype, MPI_Comm comm) Совмещенные

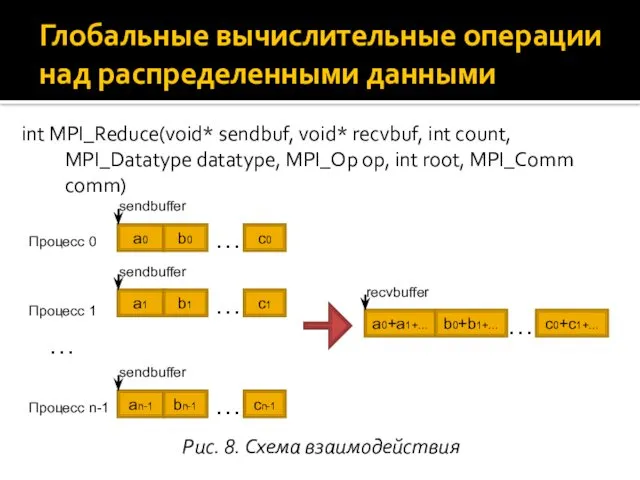

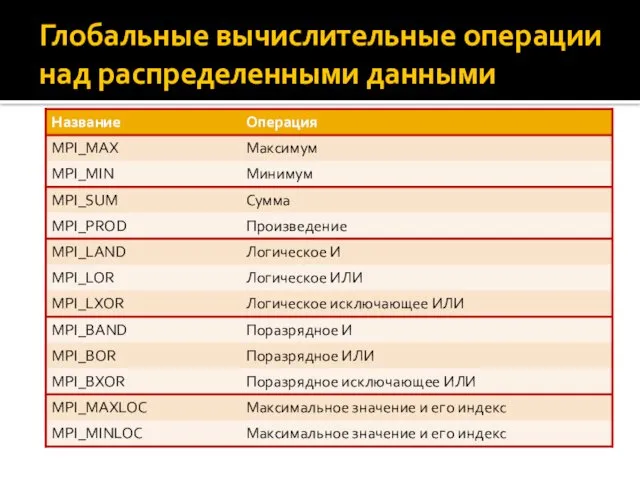

- 35. int MPI_Reduce(void* sendbuf, void* recvbuf, int count, MPI_Datatype datatype, MPI_Op op, int root, MPI_Comm comm) Глобальные

- 36. Глобальные вычислительные операции над распределенными данными

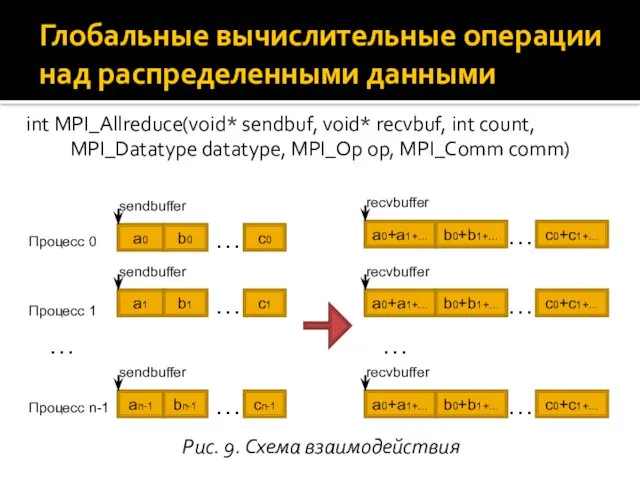

- 37. int MPI_Allreduce(void* sendbuf, void* recvbuf, int count, MPI_Datatype datatype, MPI_Op op, MPI_Comm comm) Глобальные вычислительные операции

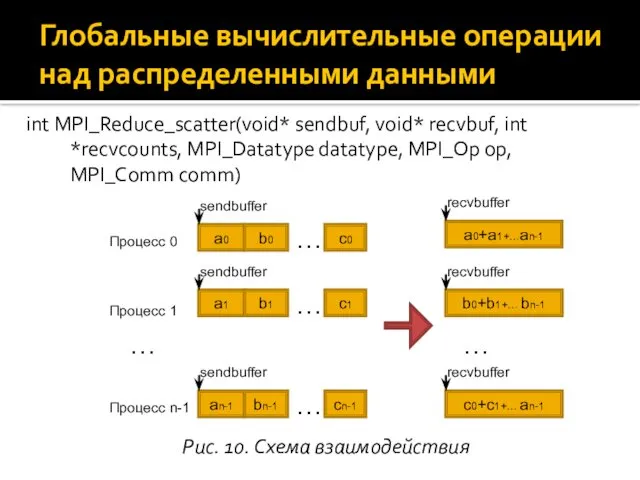

- 38. int MPI_Reduce_scatter(void* sendbuf, void* recvbuf, int *recvcounts, MPI_Datatype datatype, MPI_Op op, MPI_Comm comm) Глобальные вычислительные операции

- 40. Скачать презентацию

Презентация-тест по теме Действия с информацией

Презентация-тест по теме Действия с информацией Методы и средства проектирования ПО. Введение

Методы и средства проектирования ПО. Введение Программирование на языке Паскаль

Программирование на языке Паскаль Поиск медицинской информации. Источники, возможности, лайфхаки

Поиск медицинской информации. Источники, возможности, лайфхаки Урок Алгоритмы

Урок Алгоритмы Разработка прогнозной модели качества приборов на основе нейросетевой модели

Разработка прогнозной модели качества приборов на основе нейросетевой модели Управление ремонтами и обслуживанием оборудования, решение на основе 1С:Предприятие 8

Управление ремонтами и обслуживанием оборудования, решение на основе 1С:Предприятие 8 Характеристики языка Java

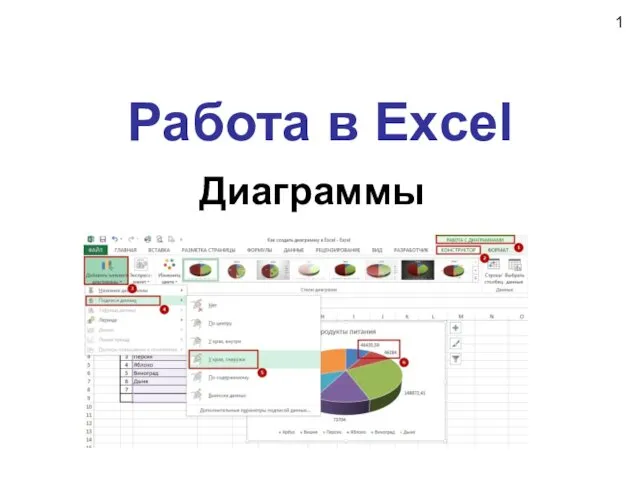

Характеристики языка Java Диаграммы

Диаграммы Введение в R

Введение в R Регистрация аккаунта Payoneer

Регистрация аккаунта Payoneer Презентация Правовая охрана программ и данных

Презентация Правовая охрана программ и данных Java-ның интегралданған орталары

Java-ның интегралданған орталары Портфолио моих достижений

Портфолио моих достижений Операционные системы. Взаимодействие между процессами. (Лекция 9)

Операционные системы. Взаимодействие между процессами. (Лекция 9) Использование облачных технологий в образовании

Использование облачных технологий в образовании Выполнения алгоритма

Выполнения алгоритма Информация и ее свойства

Информация и ее свойства Возможности динамических, электронных таблиц. Математическая обработка числовых данных

Возможности динамических, электронных таблиц. Математическая обработка числовых данных Исследование применения негативных PR технологий в электоральный период в России на современном этапе

Исследование применения негативных PR технологий в электоральный период в России на современном этапе Стандарты в области информационных систем. Лекция 2

Стандарты в области информационных систем. Лекция 2 Презентации

Презентации Функції. Масиви

Функції. Масиви Первый канал

Первый канал Теория. HTML 5

Теория. HTML 5 Система автоматизации Умный дом. Разработка подсистем Обработчик событий и Контроллер

Система автоматизации Умный дом. Разработка подсистем Обработчик событий и Контроллер Задача 20.1

Задача 20.1 Full application. Voice changer

Full application. Voice changer