Содержание

- 2. Цели лекции 1. Объяснить сущность проблемы мультиколлинеарности 2. Изучить последствия мультиколлинеарности 3. Указать средства обнаружения мультиколлинеарности

- 3. Коллинеарность и мультиколлинеарность Термин «коллинеарность» характеризует линейную связь между двумя объясняющими переменными. «Мультиколлинеарность» означает линейную связь

- 4. Виды мультиколлинеарности. Строгая и нестрогая мультиколлинеарность 1. Строгая мультиколлинеарность – наличие линейной функциональной связи между объясняющими

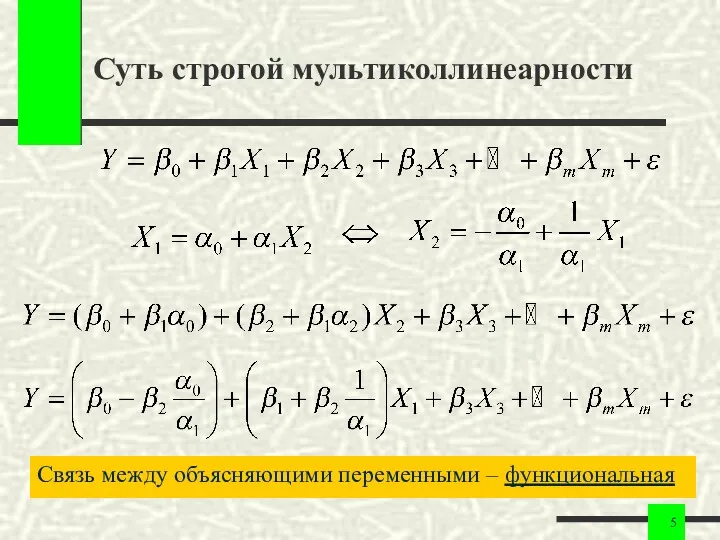

- 5. Суть строгой мультиколлинеарности Связь между объясняющими переменными – функциональная

- 6. Суть строгой мультиколлинеарности. Выводы Строгая мультиколлинеарность не позволяет однозначно определить коэффициенты регрессии и разделить вклады объясняющих

- 7. Нестрогая мультиколлинеарность. Пример Связь между объясняющими переменными – корреляционная

- 8. Сложность проблемы мультиколлинеарности 1. Корреляционные связи есть всегда. Проблема мультиколлинеарности – сила проявления корреляционных связей. 2.

- 9. Причины возникновения мультиколлинеарности 1. Ошибочное включение в уравнение регрессии двух или более линейно зависимых переменных. 2.

- 10. Мультиколлинеарность как результат логической ошибки Ошибочное признание независимыми содержательно зависимых переменных: Оценка коэффициентов уравнения невозможна!

- 11. Мультиколлинеарность из-за доминантной переменной Доминантная переменная «забивает» влияние остальных: Влияние остальных переменных становится незначимым

- 12. Неизбежность мультиколлинеарности 1. Мультиколлинеарность – нормальное явление. Практически любая модель содержит мультиколлинеарность. 2. Мы не обращаем

- 13. Механизм действия мультиколлинеарности Мультиколлинеарность проявляется в совместном действии факторов: 1. Построить модель – значит определить вклад

- 14. Зависимость мультиколлинеарности от выборки Мультиколлинеарность – явление, проявляющееся на уровне выборки: 1. В одной выборке мультиколлинеарность

- 15. Зависимость мультиколлинеарности от смысла задачи Мультиколлинеарность может быть выявлена при содержательном анализе задачи и данных При

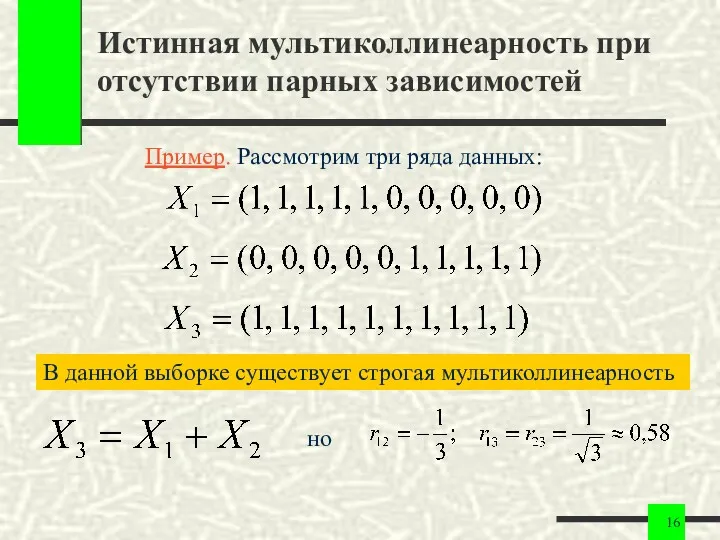

- 16. Истинная мультиколлинеарность при отсутствии парных зависимостей Пример. Рассмотрим три ряда данных: В данной выборке существует строгая

- 17. Последствия мультиколлинеарности: диагноз и прогноз 1. Оценки коэффициентов остаются несмещенными. 2. Стандартные ошибки коэффициентов увеличиваются. 3.

- 18. Последствия мультиколлинеарности: диагноз и прогноз 5. Численная неустойчивость процедуры оценивания, вызванная ошибками машинного округления и накоплением

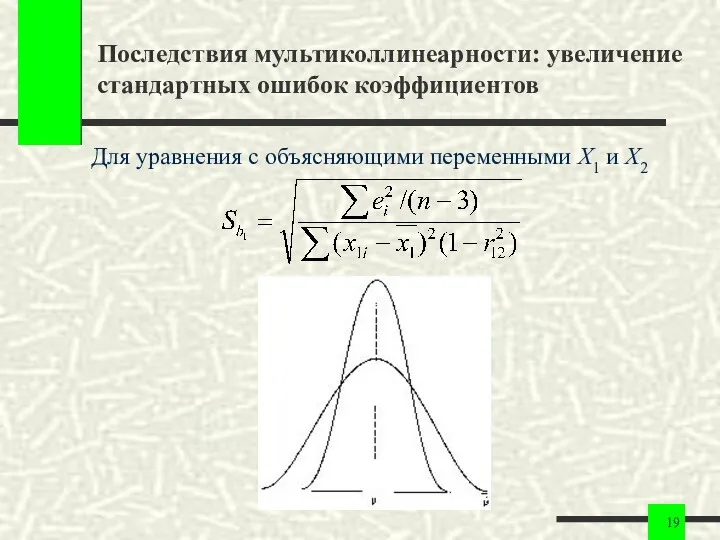

- 19. Последствия мультиколлинеарности: увеличение стандартных ошибок коэффициентов Для уравнения с объясняющими переменными X1 и X2

- 20. Последствия мультиколлинеарности: увеличение стандартных ошибок коэффициентов Практически отсюда следует возможность получить незначимый коэффициент или «неправильный» знак

- 21. Обнаружение мультиколлинеарности. Основной признак Внешним признаком наличия мультиколлинеарности служат слишком большие значения элементов матрицы Основной признак

- 22. Обнаружение мультиколлинеарности. Дополнительные признаки 1. Высокие R2 и F-статистика, но некоторые (или даже все) коэффициенты незначимы,

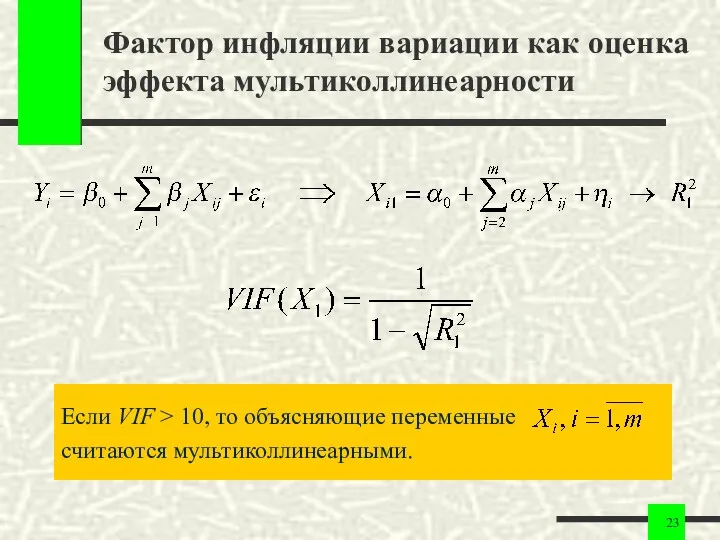

- 23. Фактор инфляции вариации как оценка эффекта мультиколлинеарности Если VIF > 10, то объясняющие переменные считаются мультиколлинеарными.

- 24. Методы устранения мультиколлинеарности 1. Изменить или увеличить выборку. 2. Исключить из модели одну или несколько переменных.

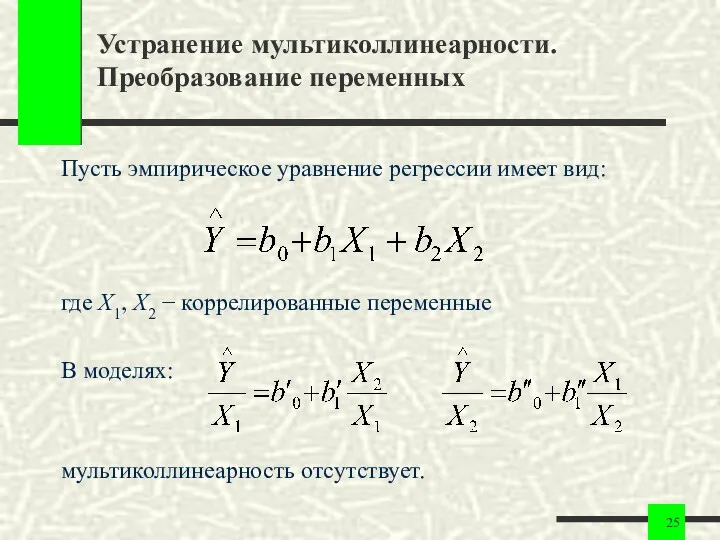

- 25. Устранение мультиколлинеарности. Преобразование переменных Пусть эмпирическое уравнение регрессии имеет вид: где X1, X2 − коррелированные переменные

- 27. Скачать презентацию

Упрощение выражений (3)

Упрощение выражений (3) Презентация к технологической карте по математике на тему Умножение многозначного числа на однозначное

Презентация к технологической карте по математике на тему Умножение многозначного числа на однозначное Умножение числа 2. Умножение на 2

Умножение числа 2. Умножение на 2 Решение системы неравенств

Решение системы неравенств Графы. Дискретная математика

Графы. Дискретная математика Умножение и деление обыкновенных дробей

Умножение и деление обыкновенных дробей презентация к уроку математики во 2 классе по теме: Умножение

презентация к уроку математики во 2 классе по теме: Умножение Ачыш ясау өчен — 1 өлеш рухлану һәм 9 өлеш тир түгү кирәк

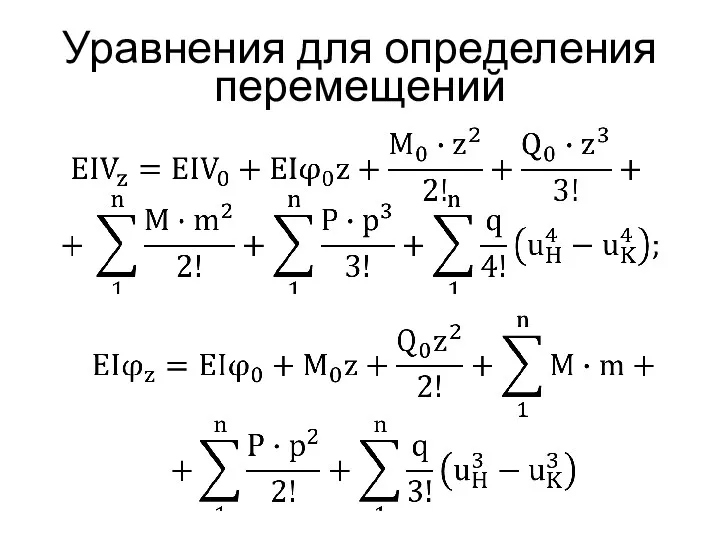

Ачыш ясау өчен — 1 өлеш рухлану һәм 9 өлеш тир түгү кирәк Уравнения для определения перемещений

Уравнения для определения перемещений Функция. Область определения и область значений функции

Функция. Область определения и область значений функции Раскрытие скобок

Раскрытие скобок Анаграммы. Урок алгебры в 8 классе

Анаграммы. Урок алгебры в 8 классе Деление положительных и отрицательных чисел

Деление положительных и отрицательных чисел Конспект урока математики во 2 классе Таблица умножения и деления на 6

Конспект урока математики во 2 классе Таблица умножения и деления на 6 Презентация к уроку математики 1 класс Составление таблиц сложения +5, 6, 7, 8, 9

Презентация к уроку математики 1 класс Составление таблиц сложения +5, 6, 7, 8, 9 Сорбонки. Математика 1 класс. Счёт до 12. УМК любой

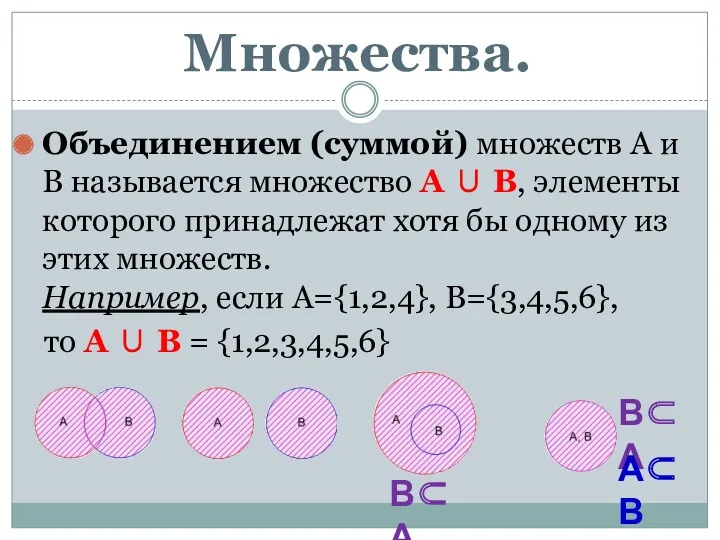

Сорбонки. Математика 1 класс. Счёт до 12. УМК любой Множества. Комбинаторика

Множества. Комбинаторика Геометрические фигуры и их площади

Геометрические фигуры и их площади Понятие алгоритма действий

Понятие алгоритма действий Час занимательной математики

Час занимательной математики Интересные факты о математике

Интересные факты о математике Задачи выпуклого программирования

Задачи выпуклого программирования Степень с рациональным показателем и ее свойства

Степень с рациональным показателем и ее свойства Элементы корреляционного и регрессионного анализа

Элементы корреляционного и регрессионного анализа 20231017_prizma

20231017_prizma Счёт до пяти.

Счёт до пяти. Отношения объектов и их множеств

Отношения объектов и их множеств Решение нелокальных краевых задач для уравнения влагопереноса методами теории случайных процессов

Решение нелокальных краевых задач для уравнения влагопереноса методами теории случайных процессов