Содержание

- 2. КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ 2 Определение Под информацией понимают совокупность сведений о явлениях, процессах, событиях, фактах и

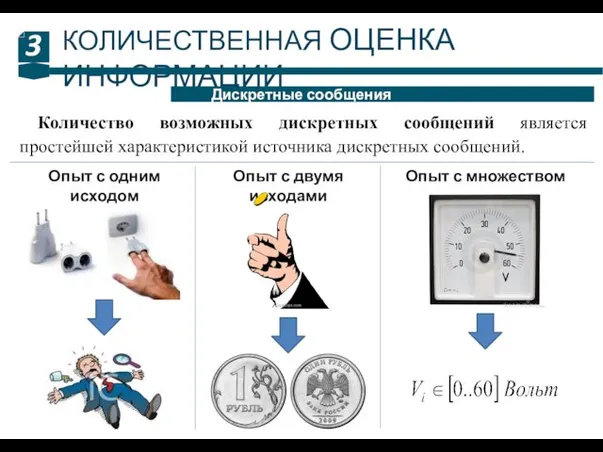

- 3. КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ 3 Дискретные сообщения Количество возможных дискретных сообщений является простейшей характеристикой источника дискретных сообщений.

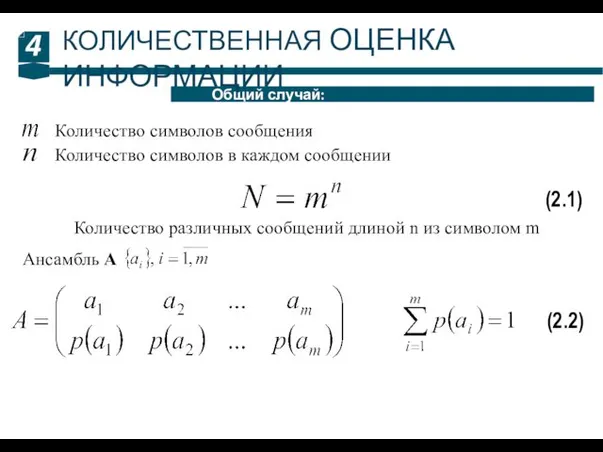

- 4. 4 Общий случай: КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ Количество символов сообщения Количество символов в каждом сообщении Количество различных

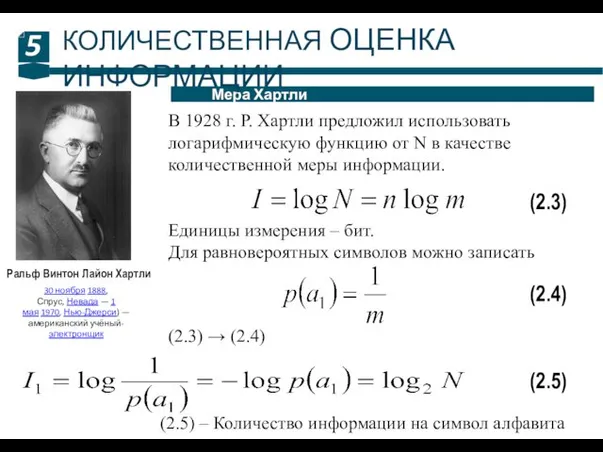

- 5. 5 Мера Хартли КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ Ральф Винтон Лайон Хартли 30 ноября 1888, Спрус, Невада —

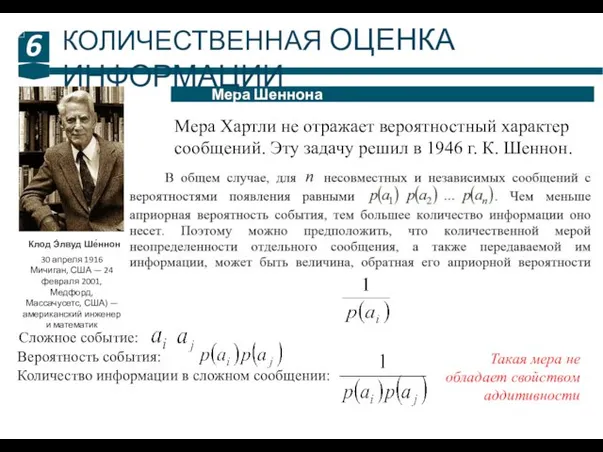

- 6. 6 Мера Шеннона КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ Клод Э́лвуд Ше́ннон 30 апреля 1916 Мичиган, США — 24

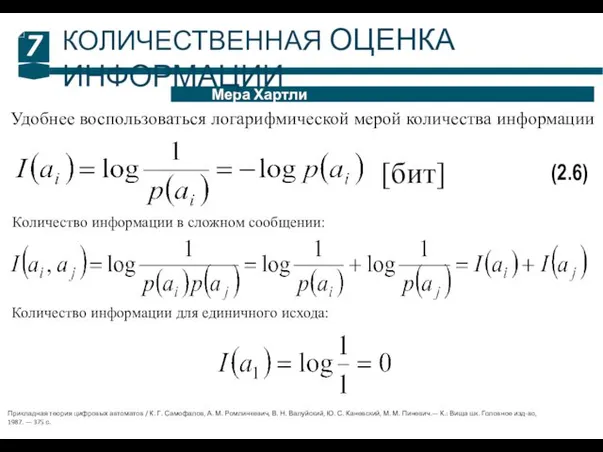

- 7. 7 Мера Хартли КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ Удобнее воспользоваться логарифмической мерой количества информации (2.6) Количество информации в

- 8. 8 Частная энтропия КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ (2.7) [бит/символ] Количество информации и неопределенность для всей совокупности случайных

- 9. 9 Свойства энтропии: КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ Чем выше энтропия источника, тем большее количество информации в среднем

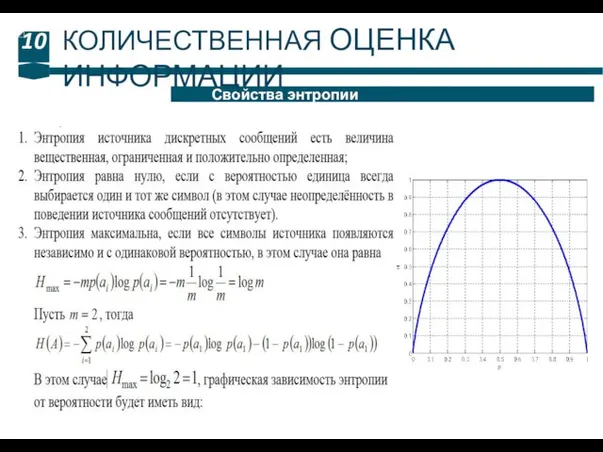

- 10. 10 Свойства энтропии КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ

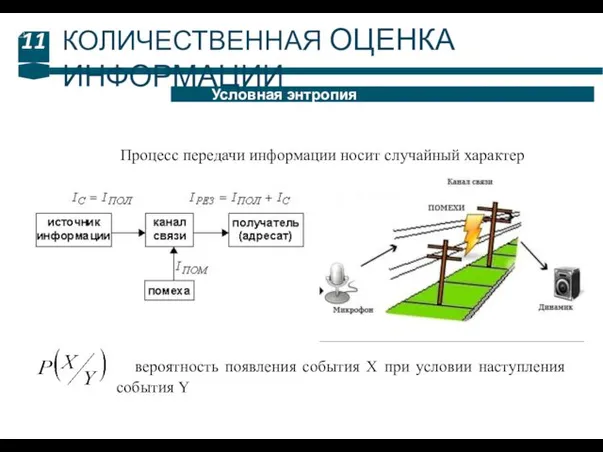

- 11. 11 Условная энтропия КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ Процесс передачи информации носит случайный характер вероятность появления события X

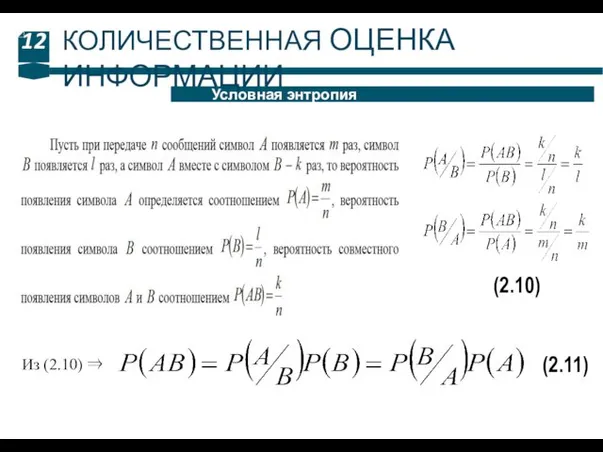

- 12. 12 Условная энтропия КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ (2.10) Из (2.10) ⇒ (2.11)

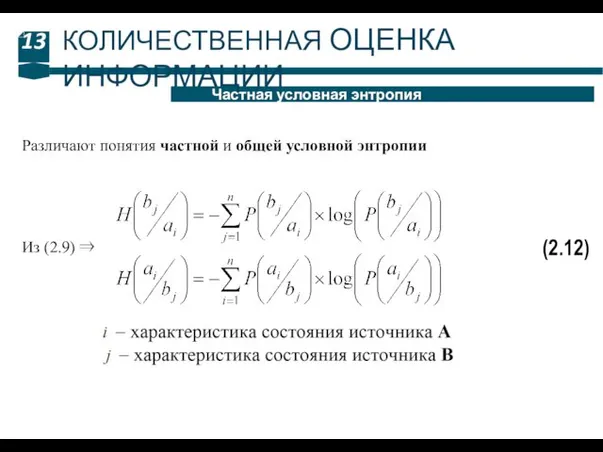

- 13. 13 Частная условная энтропия КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ (2.12) Из (2.9) ⇒ Различают понятия частной и общей

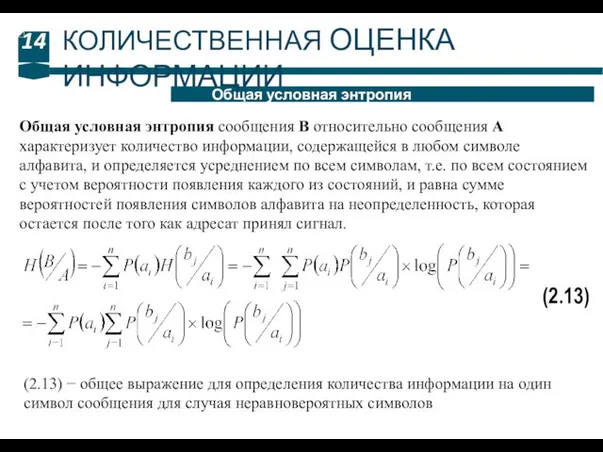

- 14. 14 Общая условная энтропия КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ Общая условная энтропия сообщения B относительно сообщения А характеризует

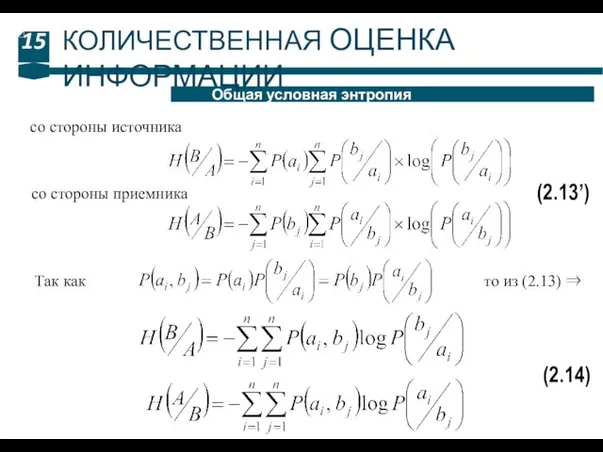

- 15. 15 Общая условная энтропия КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ (2.13’) со стороны источника со стороны приемника Так как

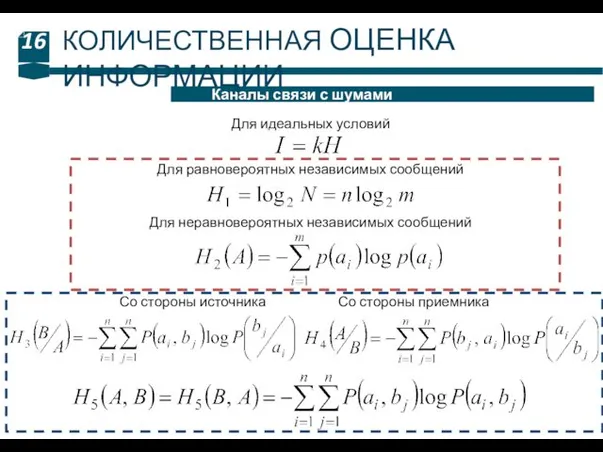

- 16. 16 Каналы связи с шумами КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ Для идеальных условий Для равновероятных независимых сообщений Для

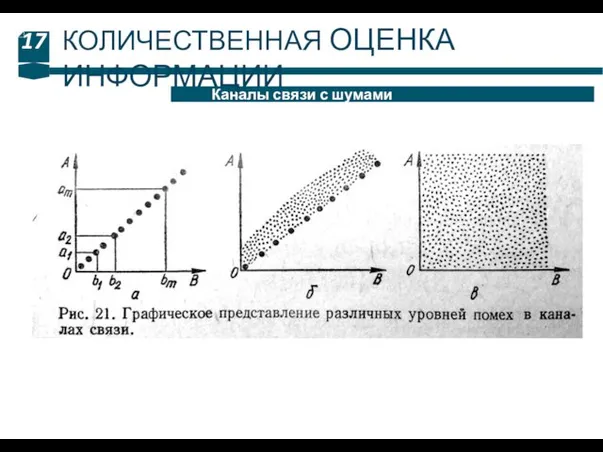

- 17. 17 Каналы связи с шумами КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ

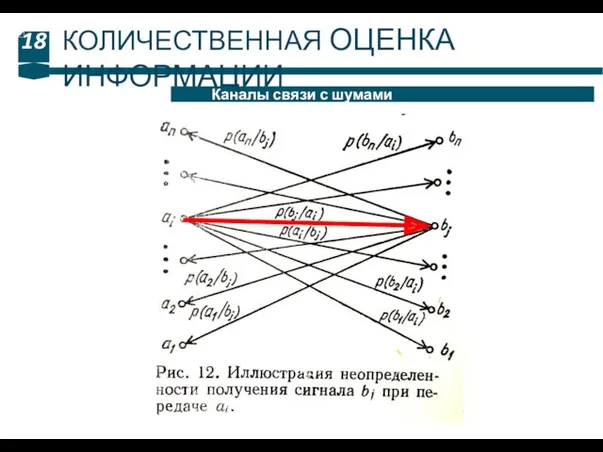

- 18. 18 Каналы связи с шумами КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ

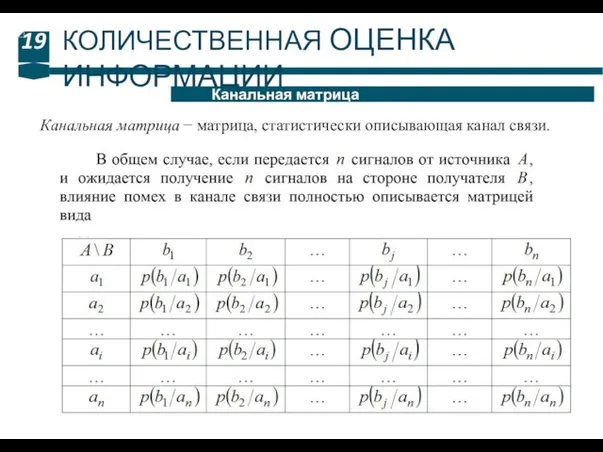

- 19. 19 Канальная матрица КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ Канальная матрица − матрица, статистически описывающая канал связи.

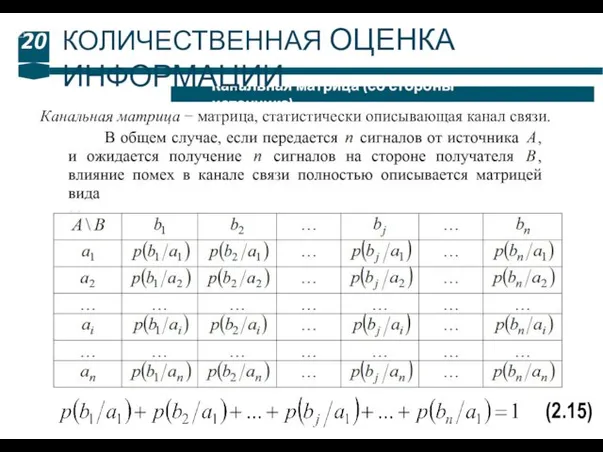

- 20. 20 Канальная матрица (со стороны источника) КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ Канальная матрица − матрица, статистически описывающая канал

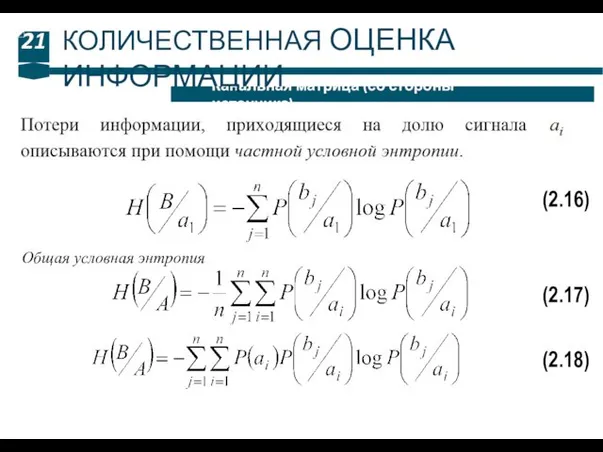

- 21. 21 Канальная матрица (со стороны источника) КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ (2.16) (2.17) Общая условная энтропия (2.18)

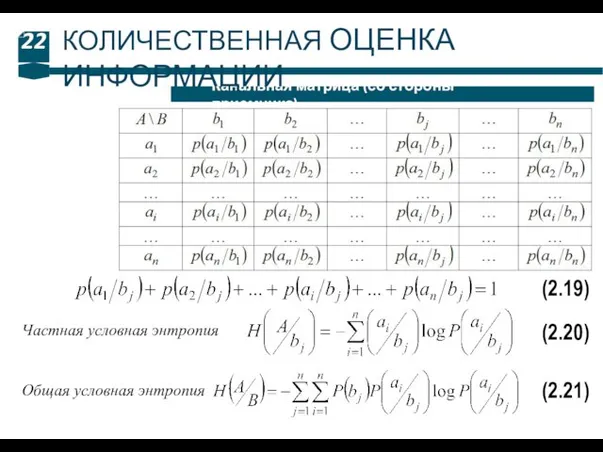

- 22. 22 Канальная матрица (со стороны приемника) КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ (2.19) (2.20) Частная условная энтропия Общая условная

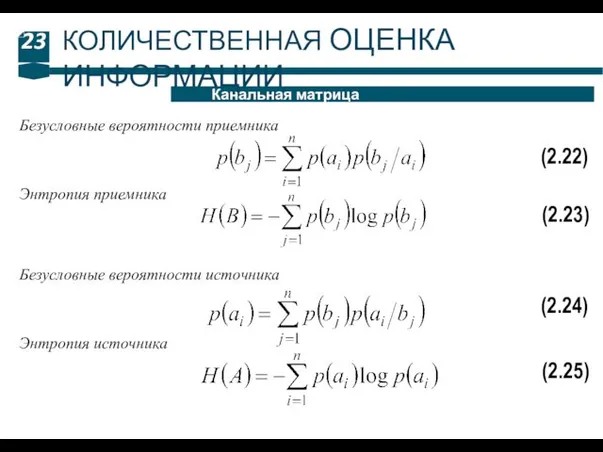

- 23. 23 Канальная матрица КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ (2.22) Безусловные вероятности приемника (2.23) Энтропия приемника (2.24) Безусловные вероятности

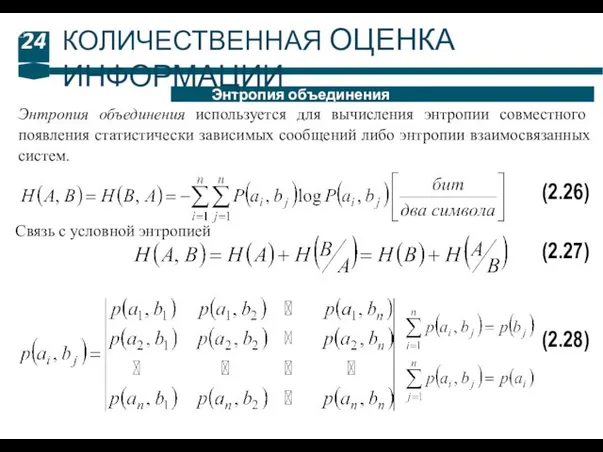

- 24. 24 Энтропия объединения КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ Энтропия объединения используется для вычисления энтропии совместного появления статистически зависимых

- 26. Скачать презентацию

![8 Частная энтропия КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ (2.7) [бит/символ] Количество информации](/_ipx/f_webp&q_80&fit_contain&s_1440x1080/imagesDir/jpg/36915/slide-7.jpg)

Механизация крыла

Механизация крыла Кроссворды для знатоков физики

Кроссворды для знатоков физики Флагманская программа ассоциация военно-патриотических клубов Красноярского края

Флагманская программа ассоциация военно-патриотических клубов Красноярского края Аналіз та оцінка ефективності роботи системи контролю в Державній службі України з надзвичайних ситуацій

Аналіз та оцінка ефективності роботи системи контролю в Державній службі України з надзвичайних ситуацій Усадьба Деда Мороза 2011 г.

Усадьба Деда Мороза 2011 г. Регуляція клітинного циклу. (Лекція 3)

Регуляція клітинного циклу. (Лекція 3) Черные металлы

Черные металлы Основы электроники

Основы электроники Курсовая работа

Курсовая работа Сон ребенка

Сон ребенка Образы русской природы в стихотворениях С.Я. Маршака

Образы русской природы в стихотворениях С.Я. Маршака Острая сердечная недостаточность при инфаркте миокарда

Острая сердечная недостаточность при инфаркте миокарда Экология жилых помещений: Риск здоровью в собственном доме

Экология жилых помещений: Риск здоровью в собственном доме Поражение суставов при иммунодефицитных состоянии

Поражение суставов при иммунодефицитных состоянии презентация 5класс

презентация 5класс уроки географии 5 класс

уроки географии 5 класс Дымовые трубы ТЭС. Лекция 8

Дымовые трубы ТЭС. Лекция 8 Призентации Диск Диск

Призентации Диск Диск Жидкофазное спекание

Жидкофазное спекание Коран. Священні проповіді

Коран. Священні проповіді Пути преодоления солеотложения в установке электроцентробежного насоса

Пути преодоления солеотложения в установке электроцентробежного насоса Презентация Учимся работать вместе Диск

Презентация Учимся работать вместе Диск История государства и права древней Индии

История государства и права древней Индии Отчет о деятельности ПОС ИСИ за 2018 год

Отчет о деятельности ПОС ИСИ за 2018 год Адаптация – результат эволюции

Адаптация – результат эволюции викторина о Франции

викторина о Франции Отечество

Отечество Физическая культура для лиц с ОВЗ

Физическая культура для лиц с ОВЗ