Содержание

- 2. Термин "нечеткая логика" В узком смысле, нечеткая логика — это логическое исчисление, являющееся расширением многозначной логики.

- 3. Основатель Впервые термин нечеткая логика (fuzzy logic) был введен амерканским профессором Лотфи Заде в 1965 году

- 4. Пример В феврале 1991 года была сконструирована первая стиральная машина, в системе управления которой сочетались нечеткая

- 5. Примеры применения нечеткой логики: Распознавание рукописных символов в карманных компьютерах (записных книжках) (Sony) Однокнопочное управление стиральными

- 6. Примеры применения нечеткой логики: Автоматическое управление воротами плотины на гидроэлектростанциях Упрощенное управление роботами Наведение телекамер при

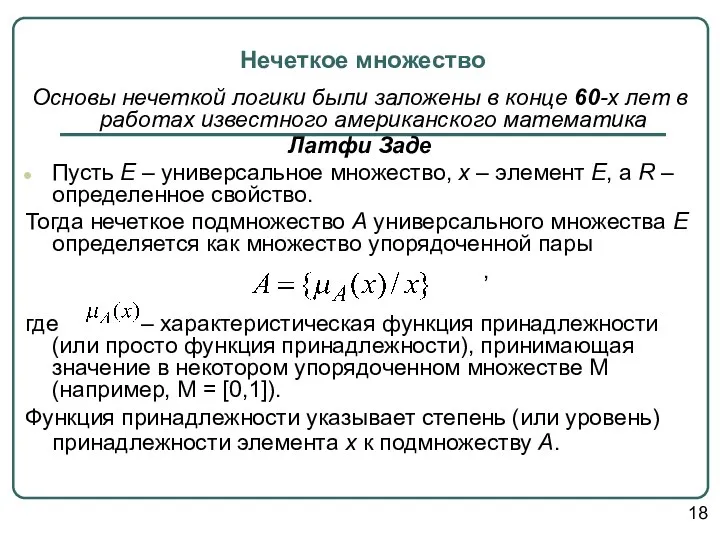

- 7. Нечеткое множество Основы нечеткой логики были заложены в конце 60-х лет в работах известного американского математика

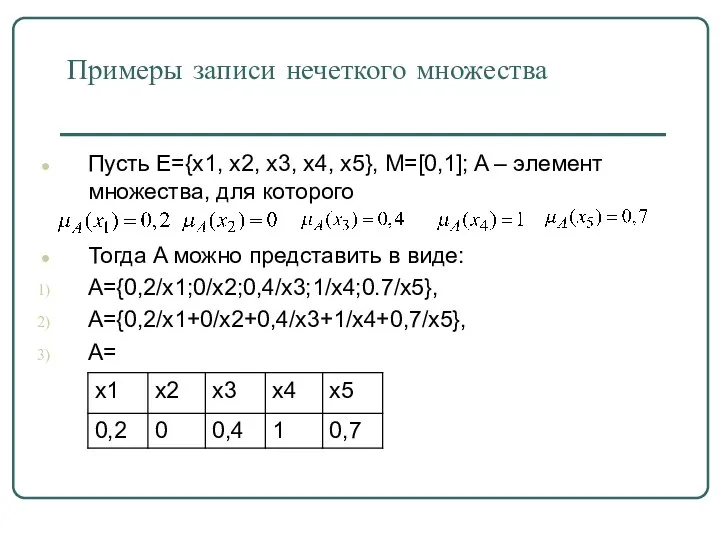

- 8. Примеры записи нечеткого множества Пусть Е={x1, x2, x3, x4, x5}, M=[0,1]; A – элемент множества, для

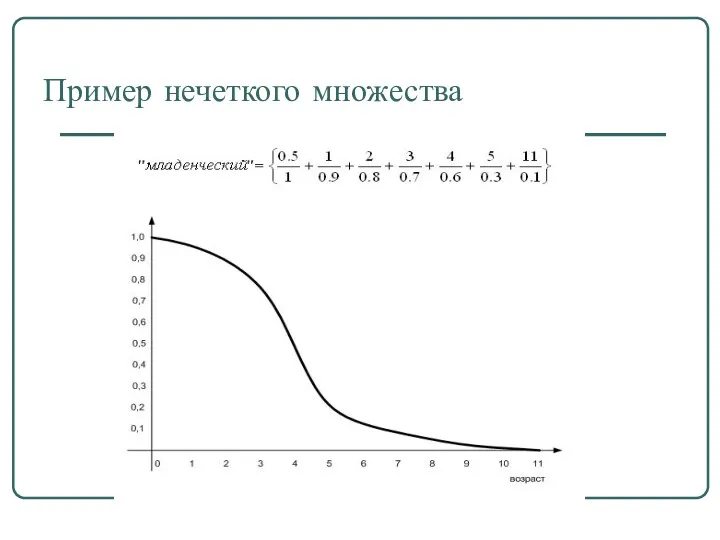

- 9. Пример нечеткого множества

- 10. Основные характеристики нечётких множеств Пусть М=[0,1] и А – нечеткое множество с элементами из универсального множества

- 11. Нечеткое множество пусто, если . Непустое субнормальное множество можно нормализовать по формуле: Нечеткое множество унимодально, если

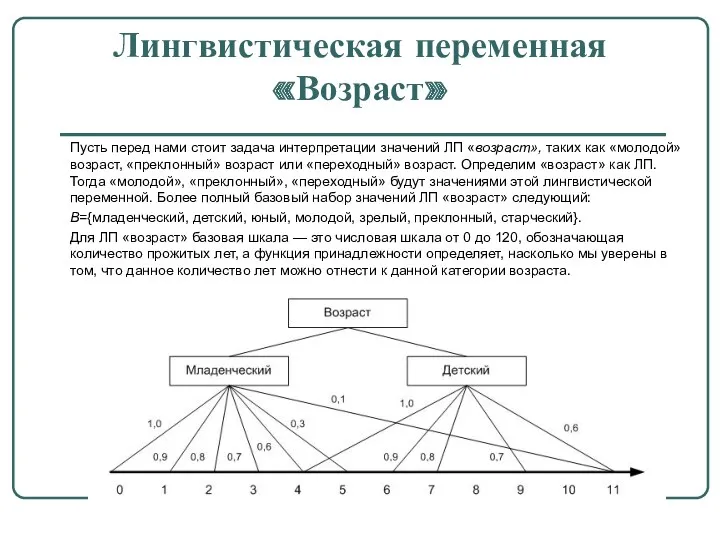

- 12. * Лингвистическая переменная «Возраст» Пусть перед нами стоит задача интерпретации значений ЛП «возраст», таких как «молодой»

- 13. Характеристики нечетких множеств

- 14. Методы определения функции принадлежности Прямые (опросы экспертов) Косвенные (парные сравнения) L-R - функции

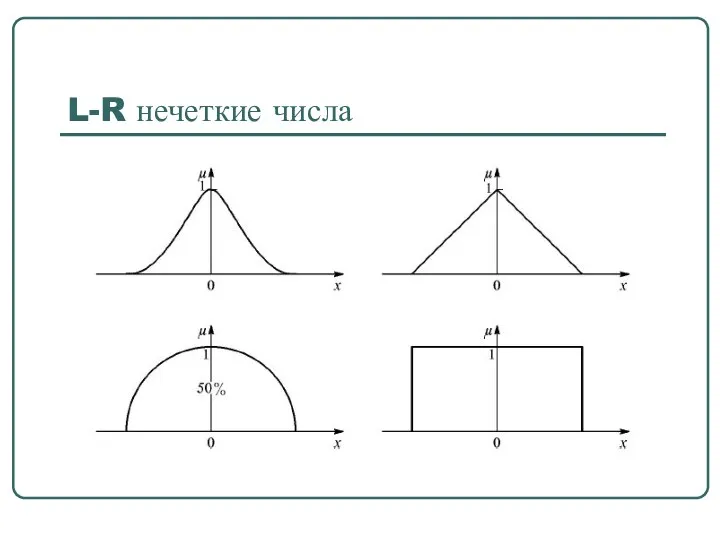

- 15. L-R нечеткие числа

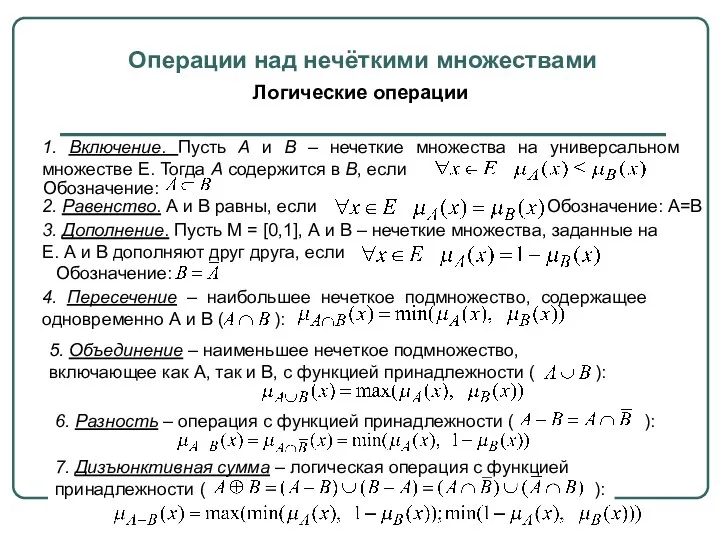

- 16. Операции над нечёткими множествами Логические операции 1. Включение. Пусть А и В – нечеткие множества на

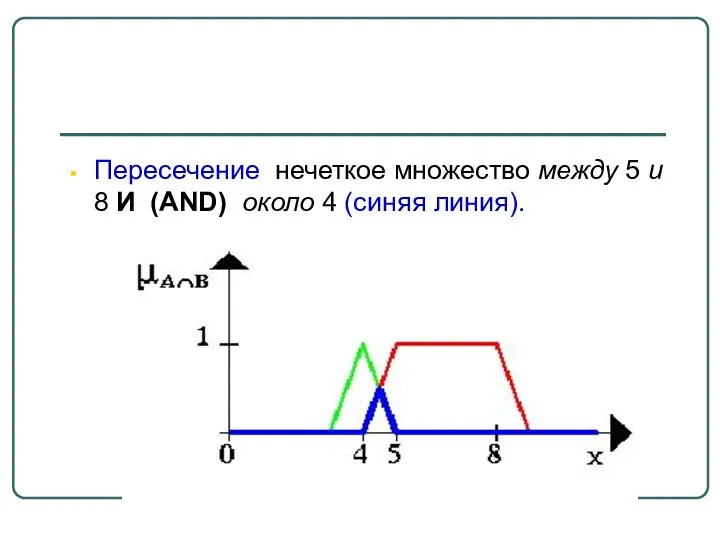

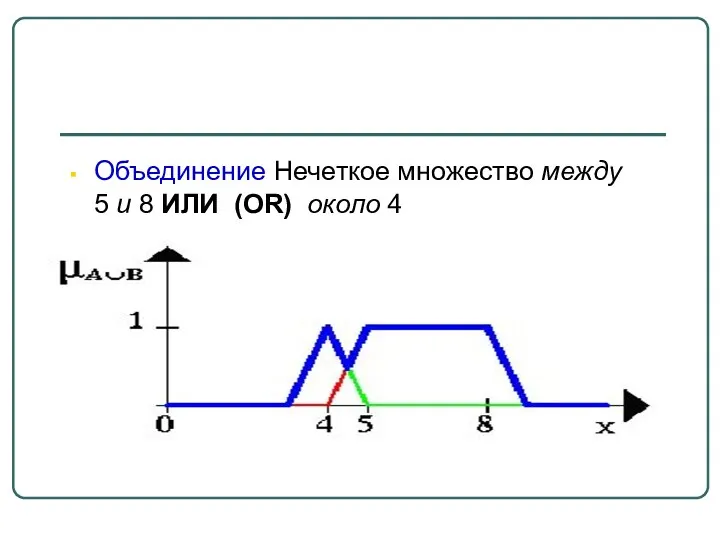

- 17. Пример Пусть A нечеткий интервал от 5 до 8 и B нечеткое число около 4

- 18. Пересечение нечеткое множество между 5 и 8 И (AND) около 4 (синяя линия).

- 19. Объединение Нечеткое множество между 5 и 8 ИЛИ (OR) около 4

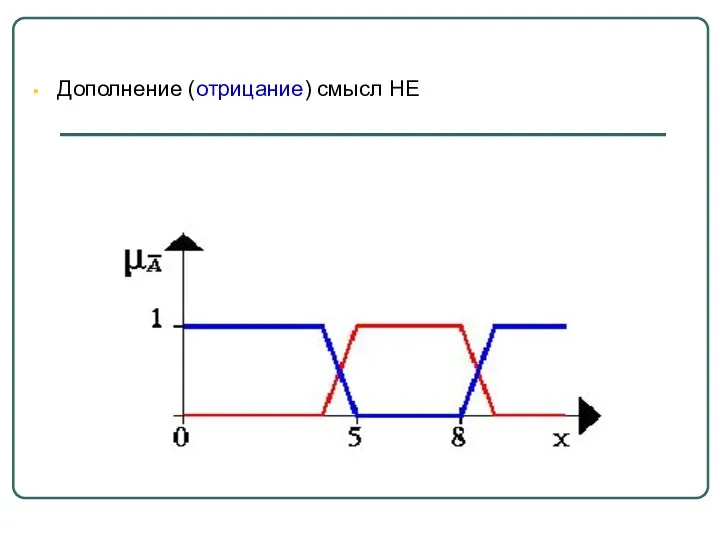

- 20. Дополнение (отрицание) смысл НЕ

- 21. Концентрация Лингвистический смысл «очень»

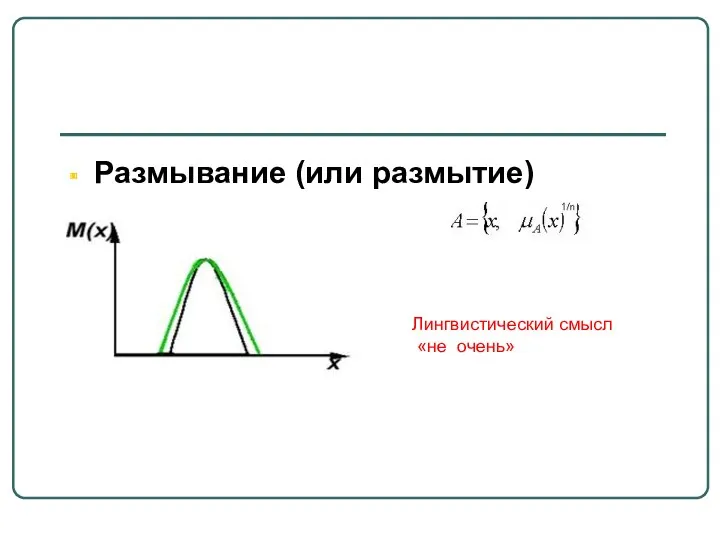

- 22. Размывание (или размытие) Лингвистический смысл «не очень»

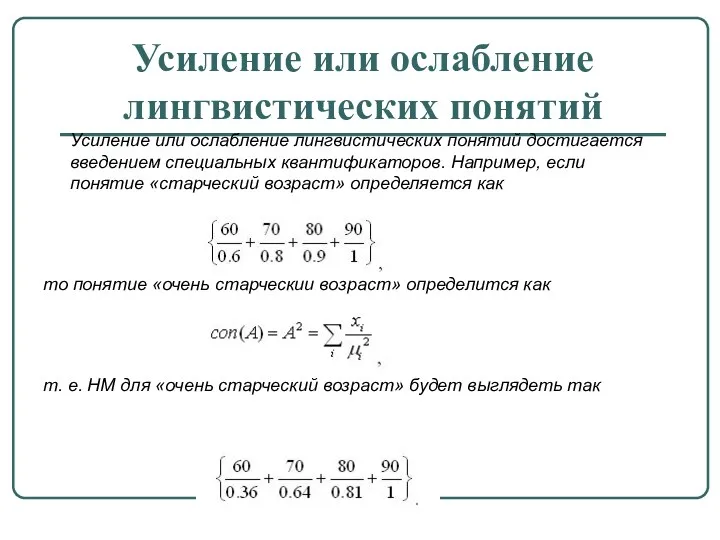

- 23. Усиление или ослабление лингвистических понятий Усиление или ослабление лингвистических понятий достигается введением специальных квантификаторов. Например, если

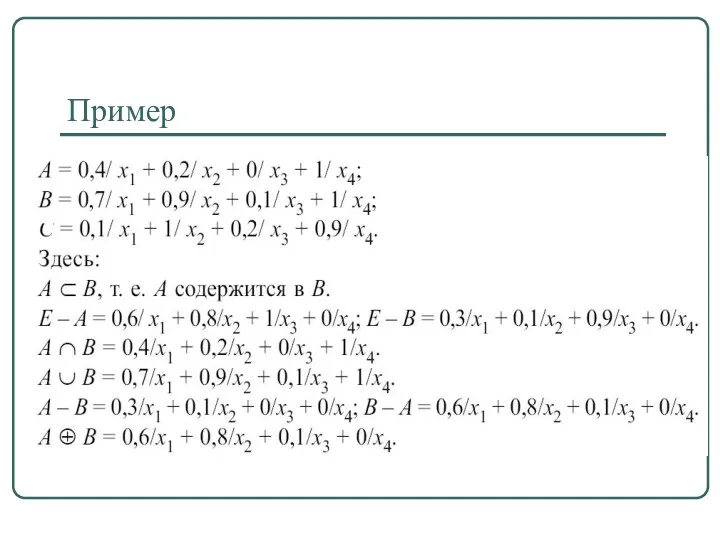

- 24. Пример

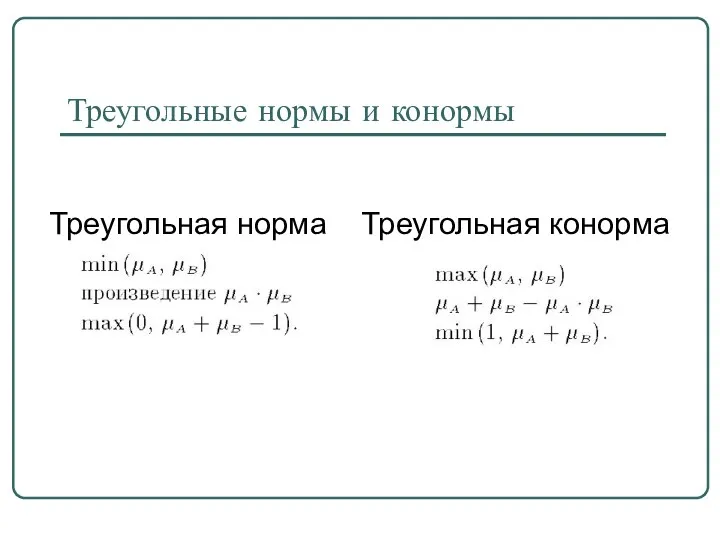

- 25. Треугольные нормы и конормы Треугольная норма Треугольная конорма

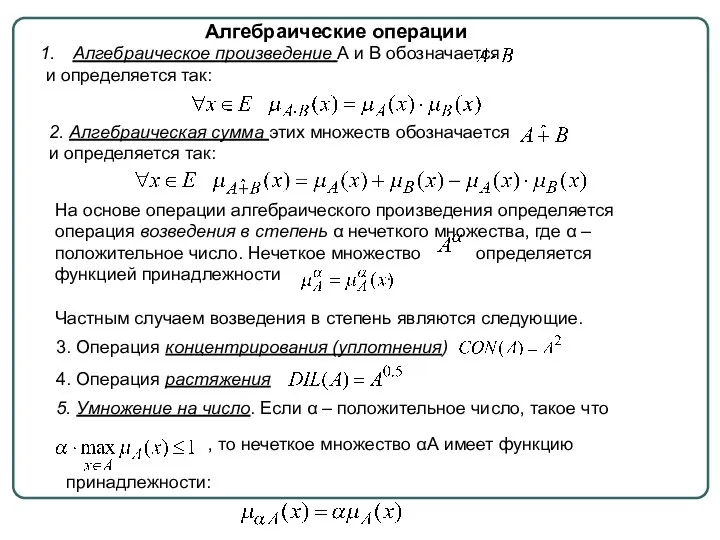

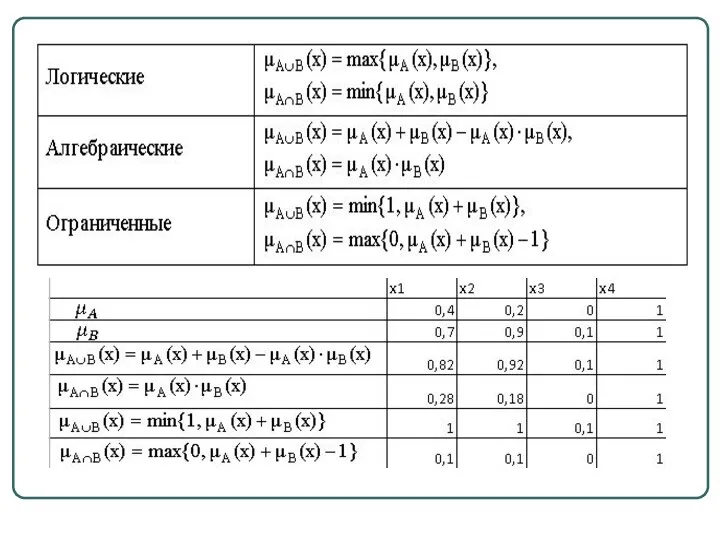

- 26. 2. Алгебраическая сумма этих множеств обозначается и определяется так: На основе операции алгебраического произведения определяется операция

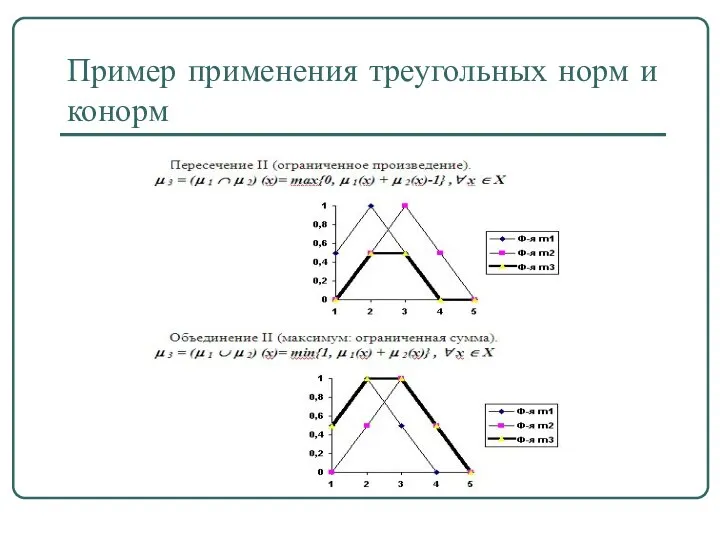

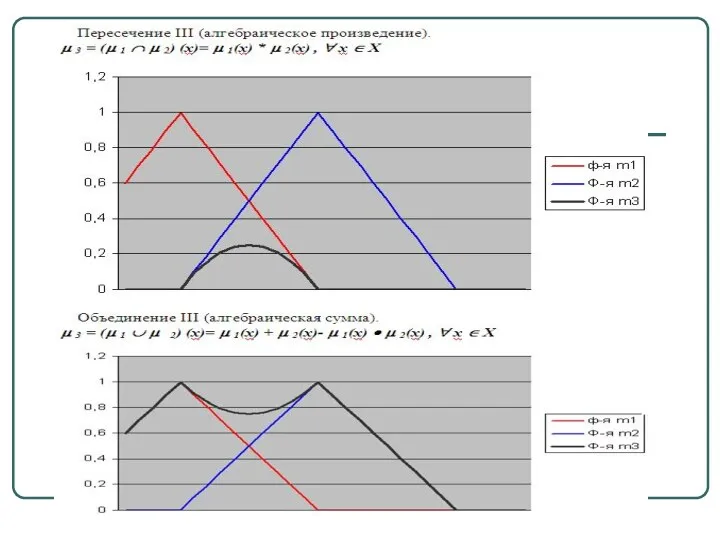

- 28. Пример применения треугольных норм и конорм

- 30. Нечеткие отношения. Операции над нечеткими отношениями Нечеткая логика и нейронные сети

- 31. Пример нечеткого отношения

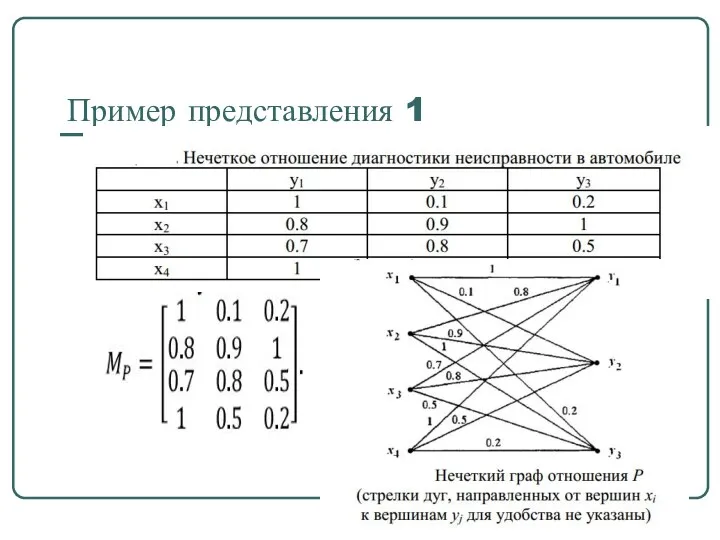

- 32. Пример представления 1

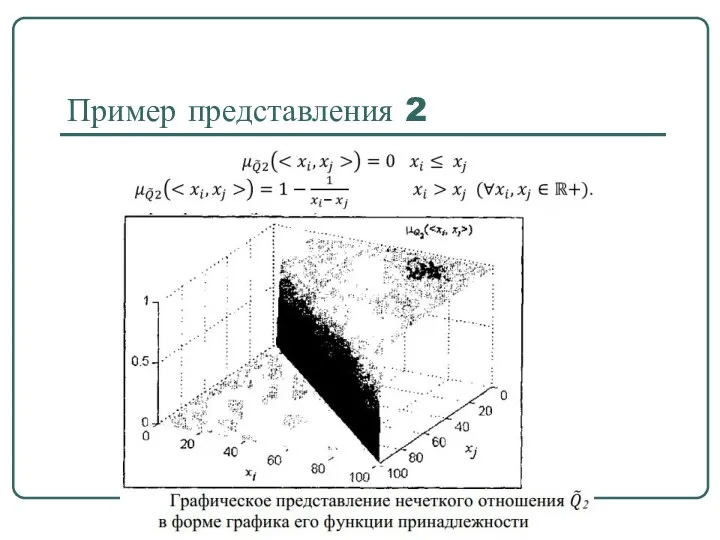

- 33. Пример представления 2

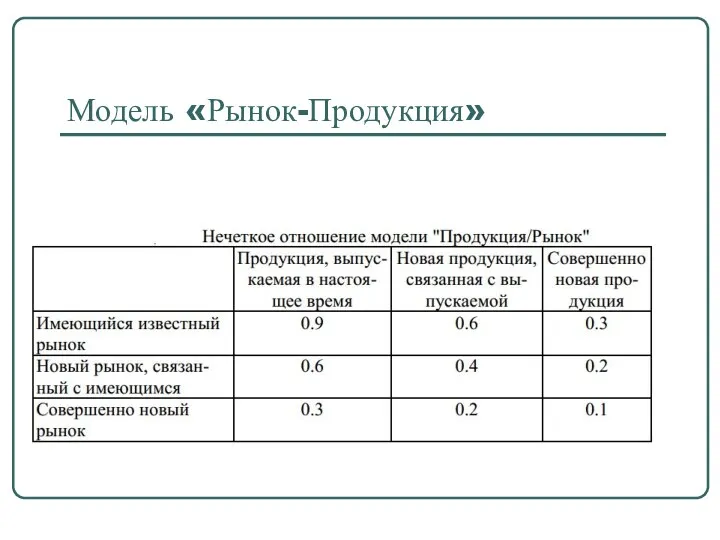

- 34. Модель «Рынок-Продукция»

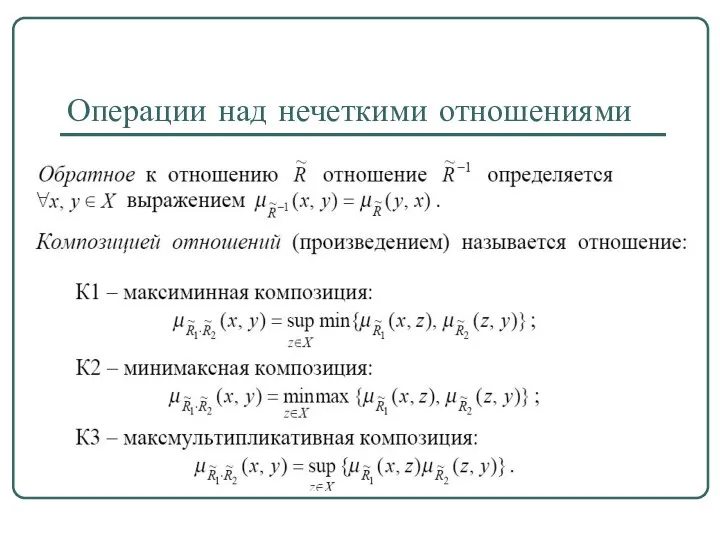

- 35. Операции над нечеткими отношениями

- 36. Операции над нечеткими отношениями

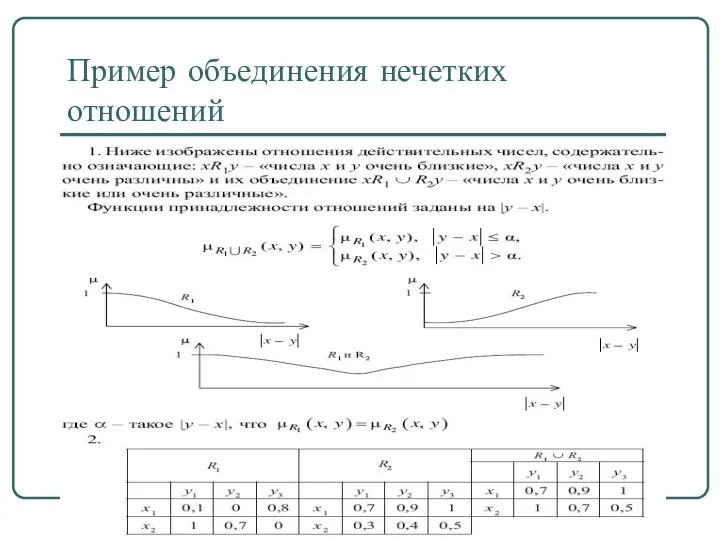

- 37. Пример объединения нечетких отношений

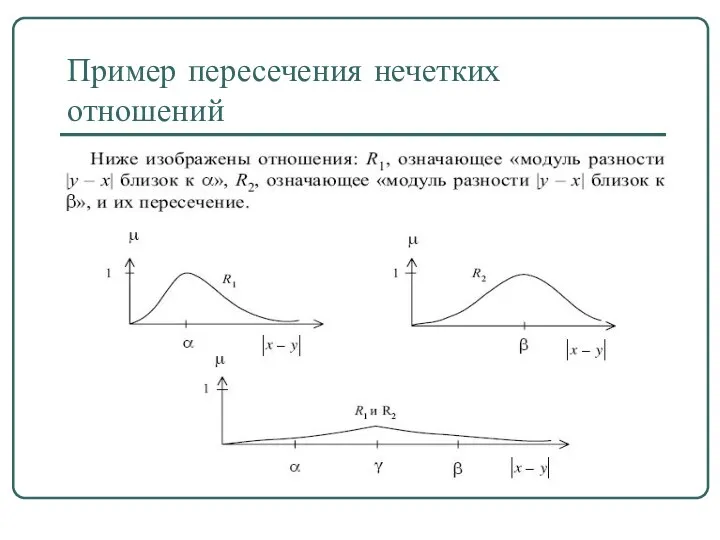

- 38. Пример пересечения нечетких отношений

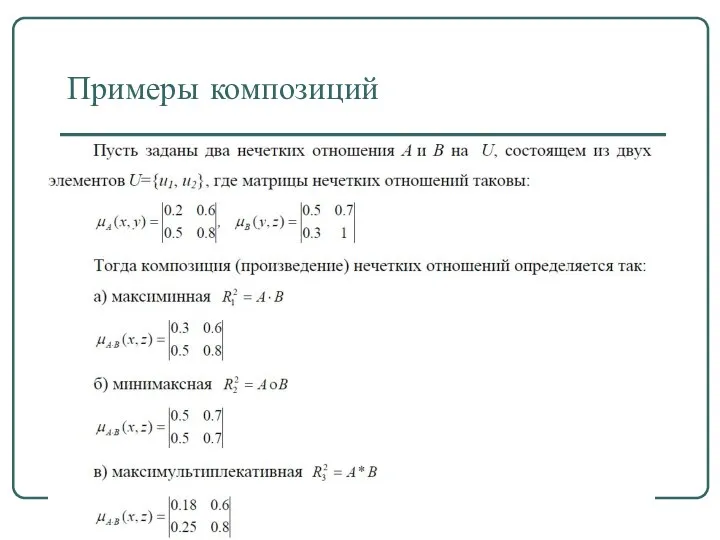

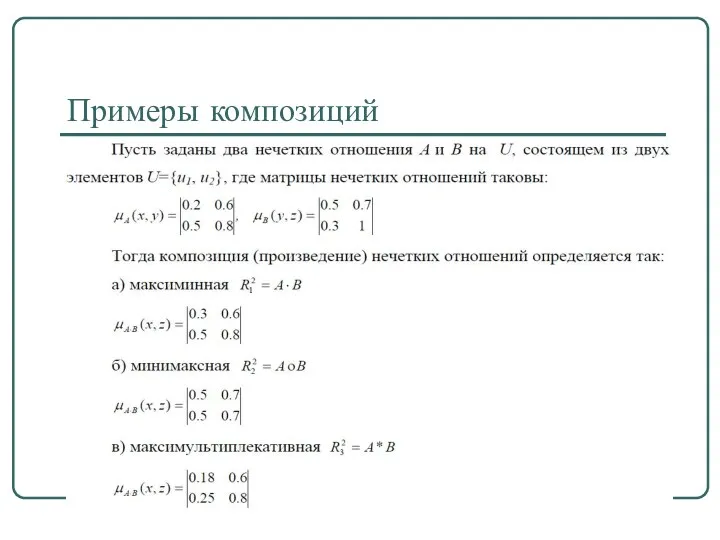

- 39. Примеры композиций

- 40. Примеры композиций

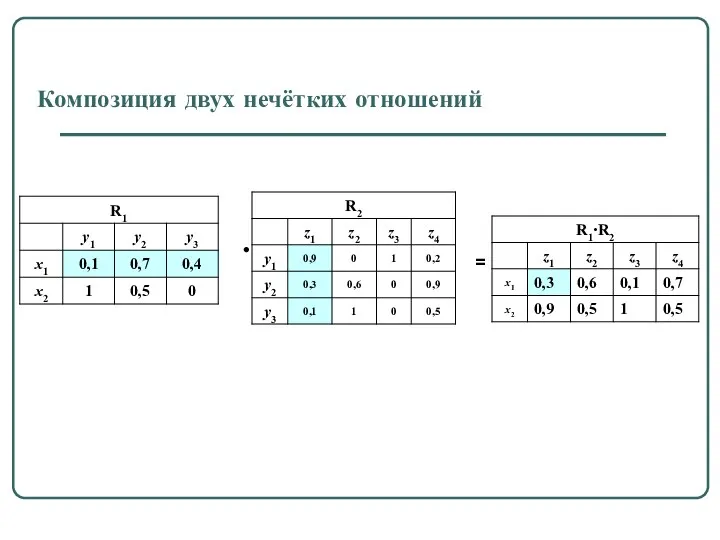

- 41. Композиция двух нечётких отношений • =

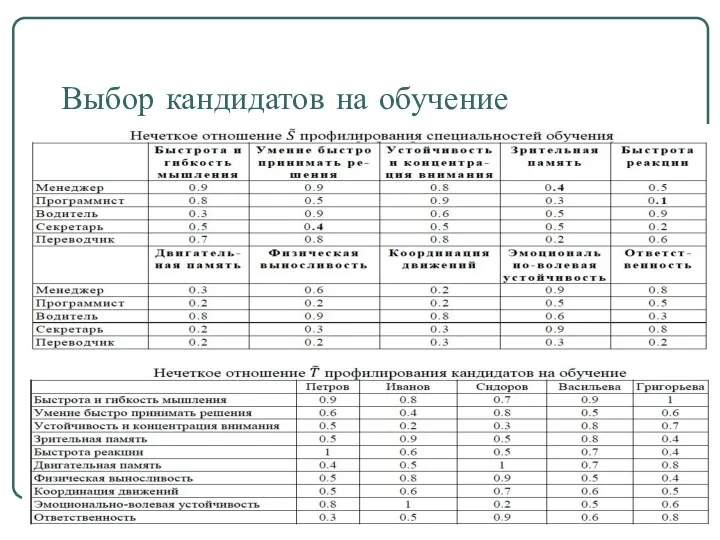

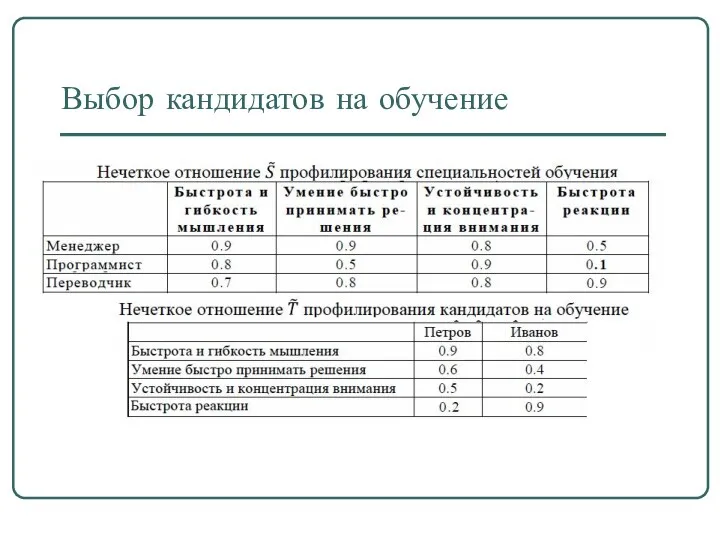

- 42. Выбор кандидатов на обучение

- 43. Выбор кандидатов на обучение

- 44. Нечеткая и лингвистическая переменные. Нечеткие числа Нечеткая логика и нейронные сети

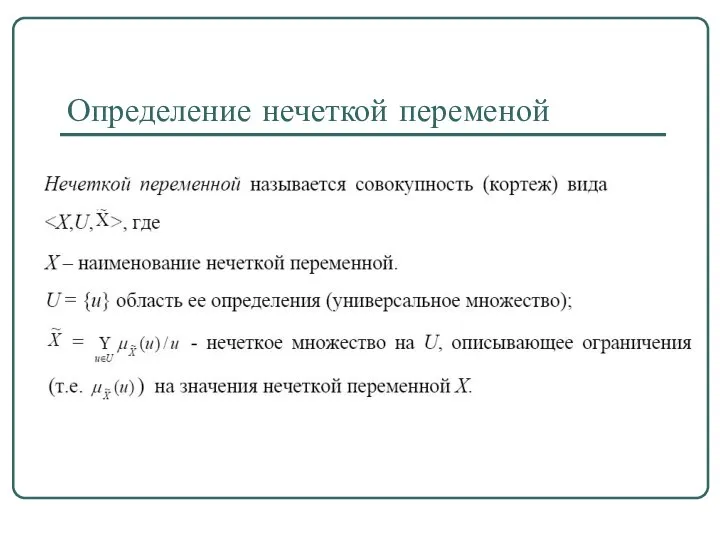

- 45. Определение нечеткой переменой

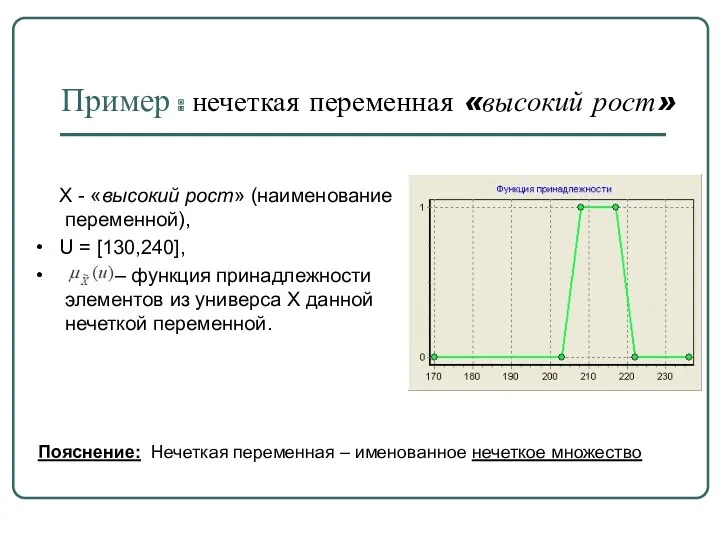

- 46. Пример : нечеткая переменная «высокий рост» Х - «высокий рост» (наименование переменной), U = [130,240], –

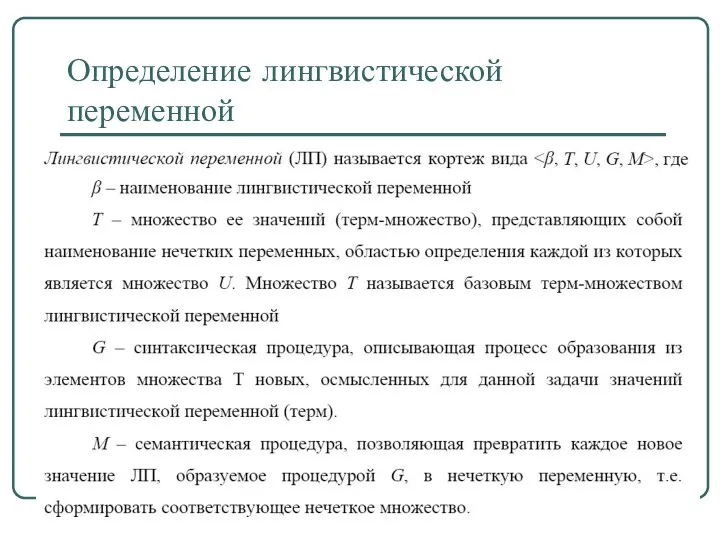

- 47. Определение лингвистической переменной

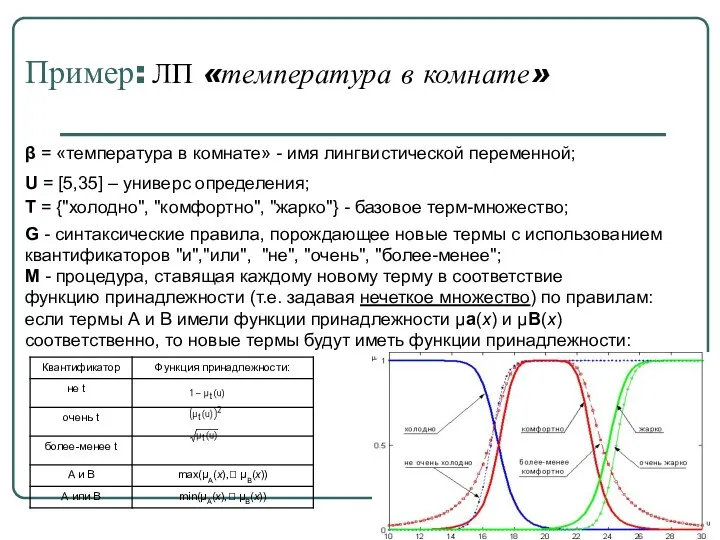

- 48. Пример: ЛП «температура в комнате» β = «температура в комнате» - имя лингвистической переменной; U =

- 49. Пример : ЛП «дисциплина» β – дисциплина; Т – {«Сложная дисциплина», «Интересная дисциплина», «Пригодится в будущей

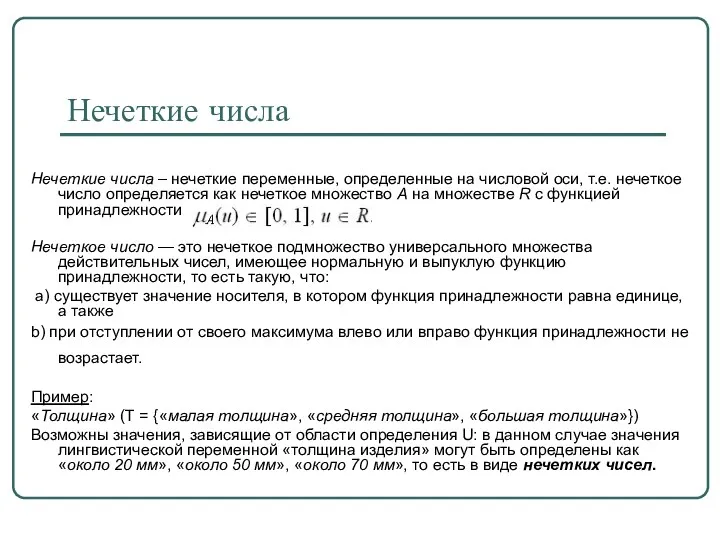

- 50. Пример: толщина детали Пусть эксперт определяет толщину выпускаемого изделия с помощью понятий «малая толщина», «средняя толщина»

- 51. Пример: толщина детали Функции принадлежности нечетких множеств: «малая толщина» = А1, «средняя толщина» = А2, «большая

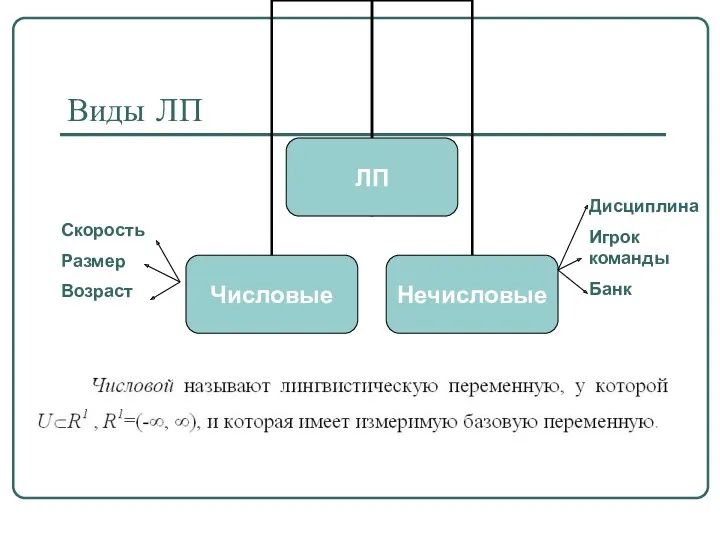

- 52. Виды ЛП Скорость Размер Возраст Дисциплина Игрок команды Банк

- 53. Нечеткие числа Нечеткие числа – нечеткие переменные, определенные на числовой оси, т.е. нечеткое число определяется как

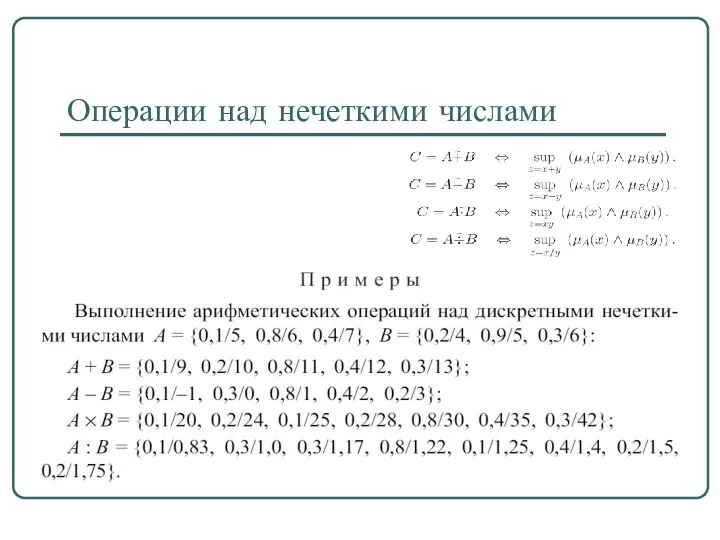

- 54. Операции над нечеткими числами

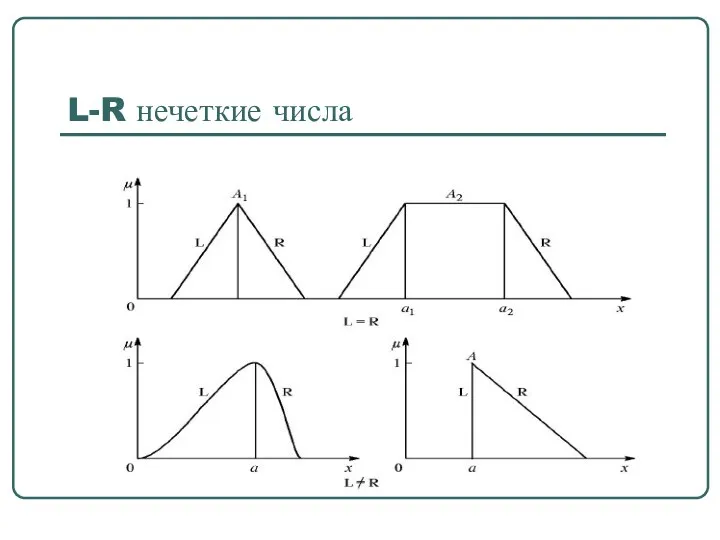

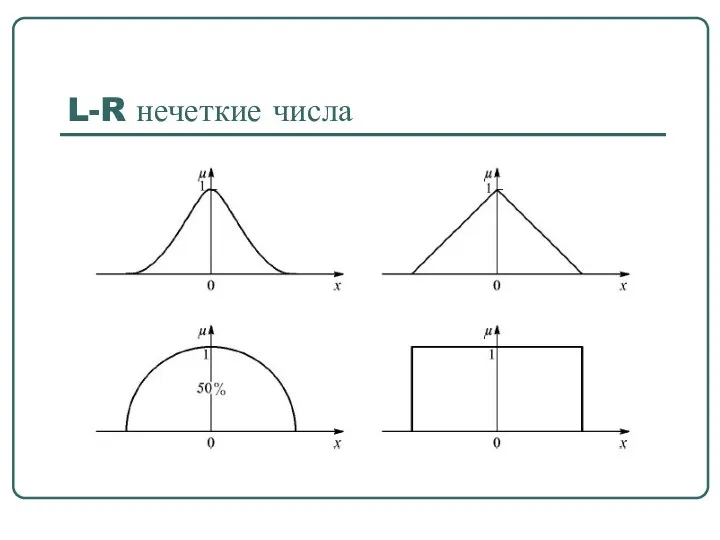

- 55. L-R нечеткие числа

- 56. L-R нечеткие числа

- 57. L-R нечеткие числа Толерантные нечеткие числа (L-R)-типа называют трапезоидными числами. Если мы оцениваем параметр качественно, например,

- 58. Нечеткий вывод Нечеткая логика и нейронные сети

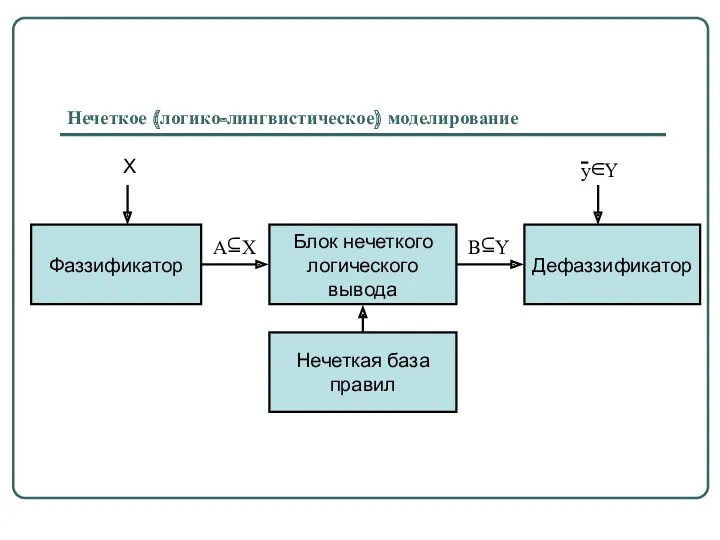

- 59. Нечеткое (логико-лингвистическое) моделирование

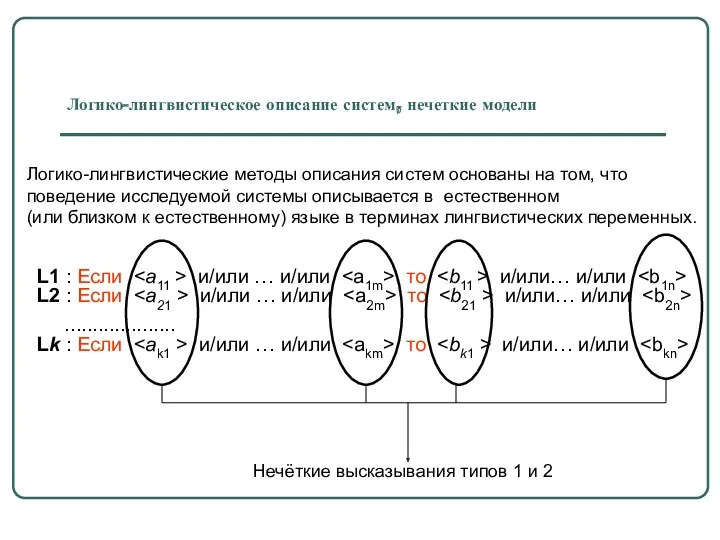

- 60. Логико-лингвистическое описание систем, нечеткие модели L1 : Если и/или … и/или то и/или… и/или L2 :

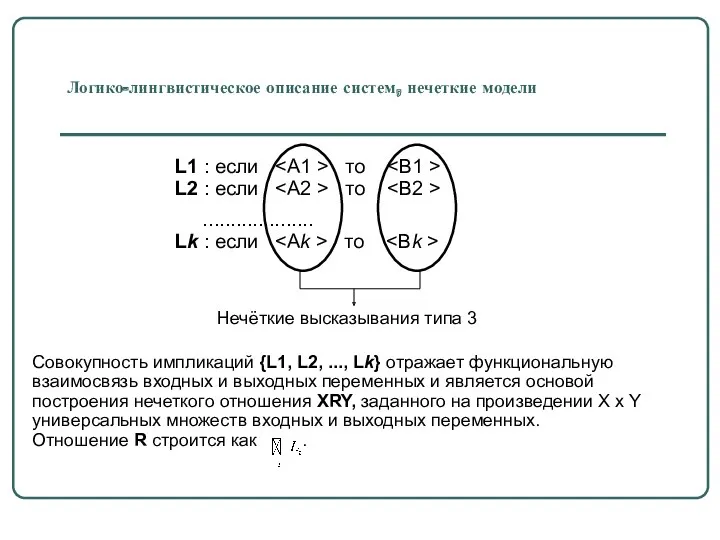

- 61. Логико-лингвистическое описание систем, нечеткие модели Совокупность импликаций {L1, L2, ..., Lk} отражает функциональную взаимосвязь входных и

- 62. Рост баскетболиста Множество определения – [170,236] Множество термов - {очень высокий, высокий, средний, низкий} Лингвистические переменные

- 63. Рост баскетболиста Множество определения – [170,236] Очень высокий высокий средний низкий Система “Набор баскетболистов”

- 64. Система “Набор баскетболистов” Техника игры баскетболиста Множество определения – [0,100] очень хорошая отличная средняя хорошая плохая

- 65. Система “Набор баскетболистов” Уверенность принятия в команду Множество определения – [0,100] полная средняя малая не берём

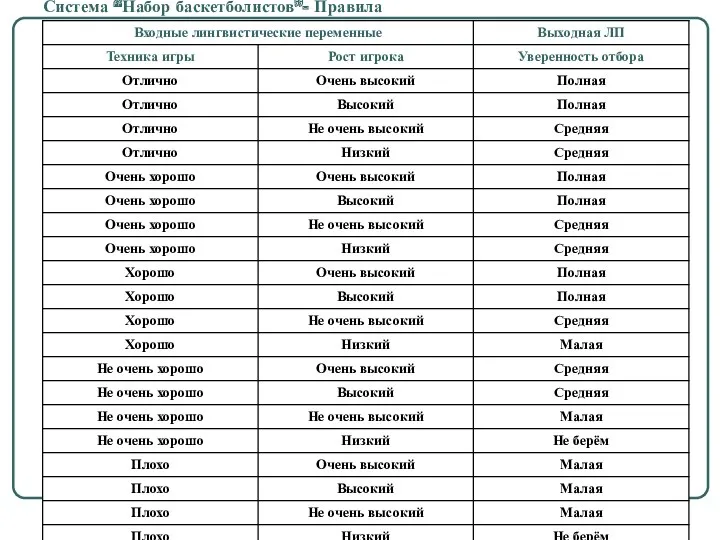

- 66. Система “Набор баскетболистов”- Правила

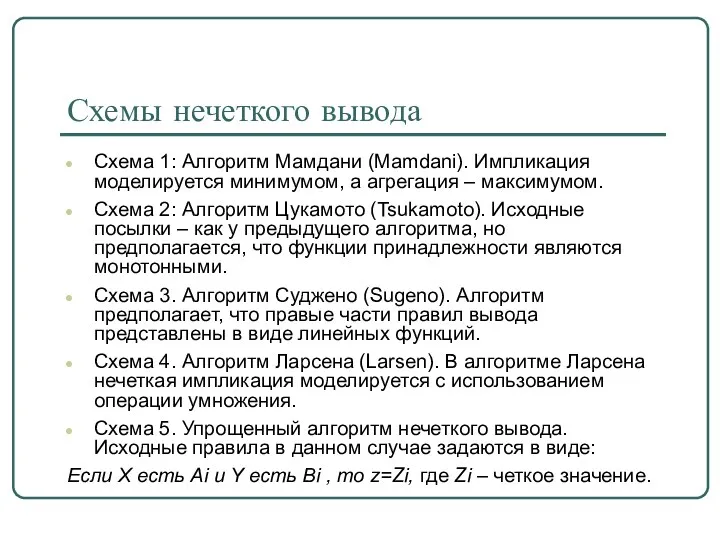

- 67. Схемы нечеткого вывода Схема 1: Алгоритм Мамдани (Mamdani). Импликация моделируется минимумом, а агрегация – максимумом. Схема

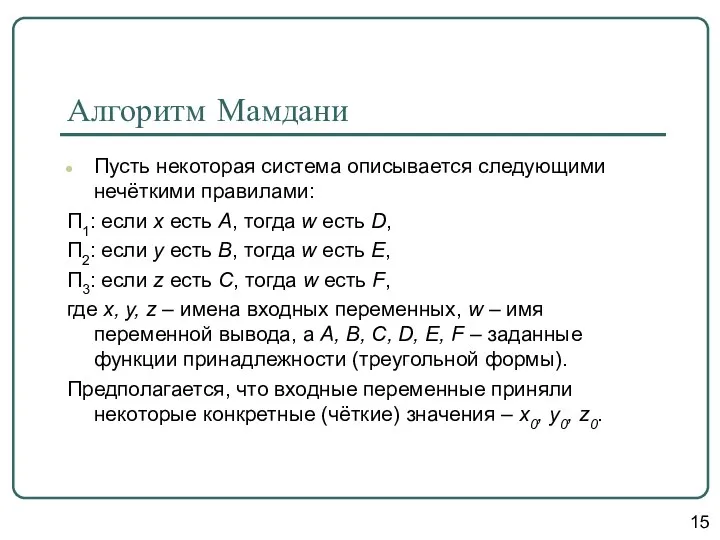

- 68. Алгоритм Мамдани Пусть некоторая система описывается следующими нечёткими правилами: П1: если x есть A, тогда w

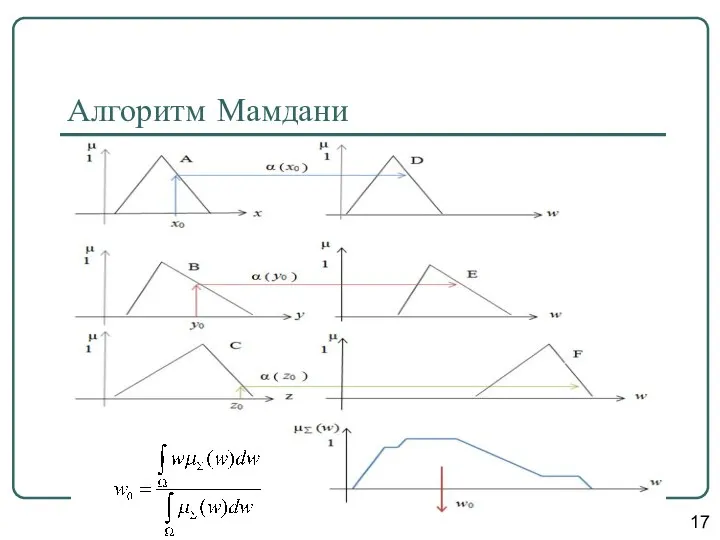

- 69. Алгоритм Мамдани Этап 1. Для данных значений и исходя из функций принадлежности A, B, C, находятся

- 70. 17 Алгоритм Мамдани

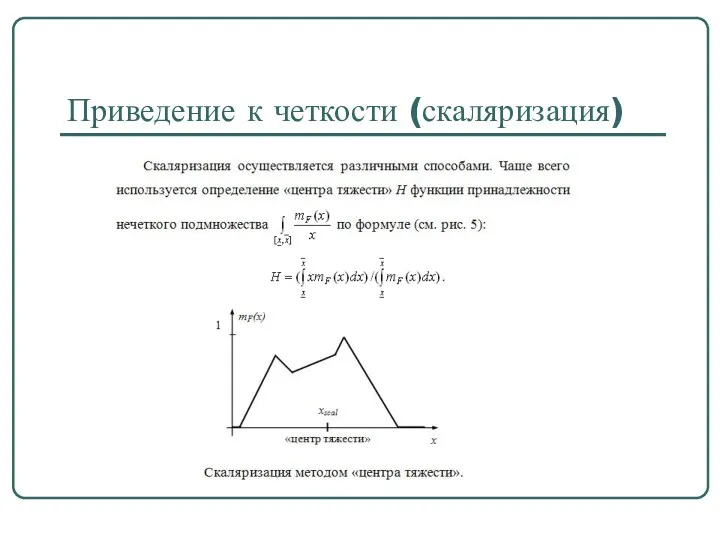

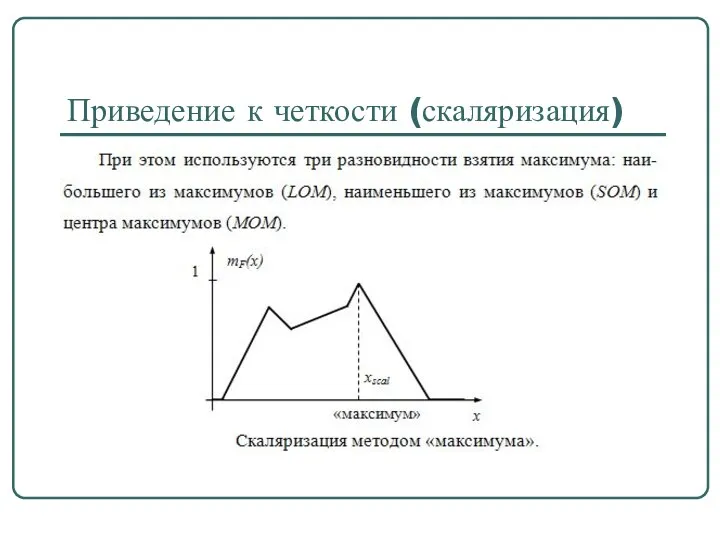

- 71. Приведение к четкости (скаляризация)

- 72. Приведение к четкости (скаляризация)

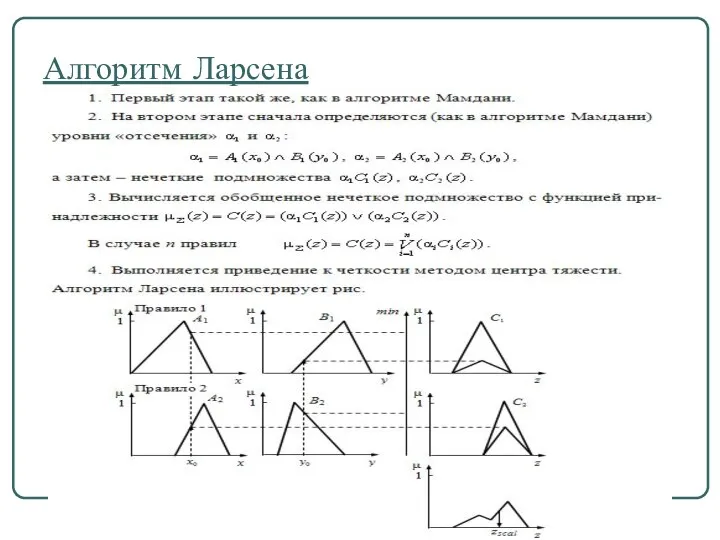

- 73. Алгоритм Ларсена

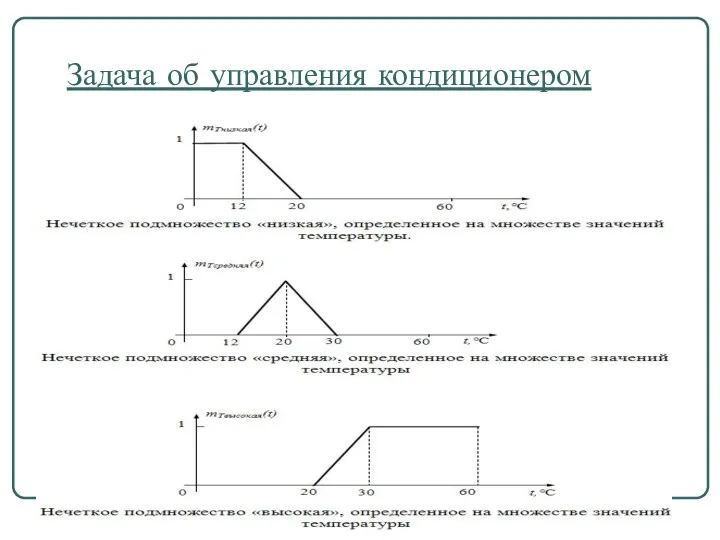

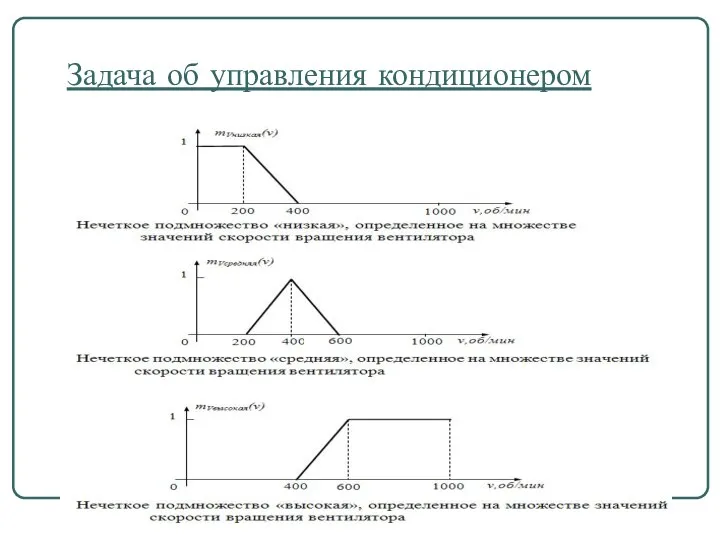

- 74. Задача об управления кондиционером Правила:

- 75. Задача об управления кондиционером

- 76. Задача об управления кондиционером

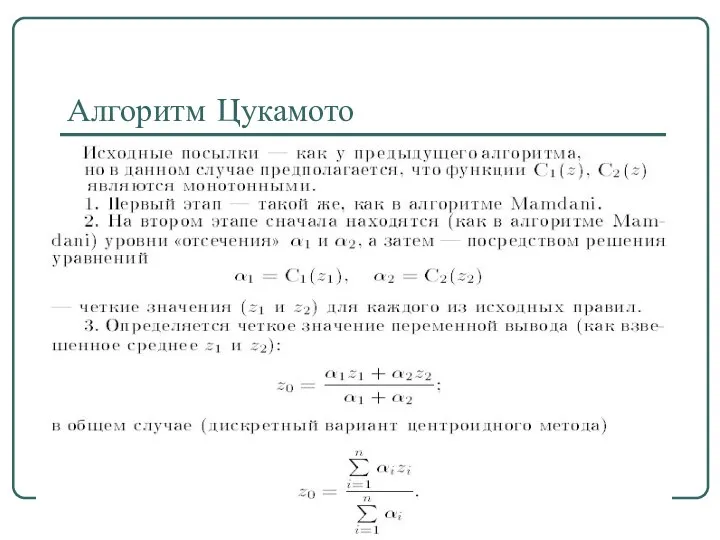

- 79. Алгоритм Цукамото

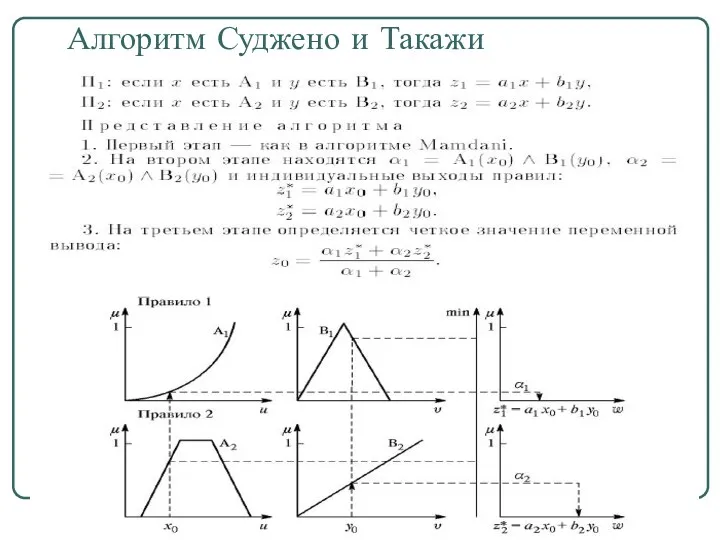

- 81. Алгоритм Суджено и Такажи

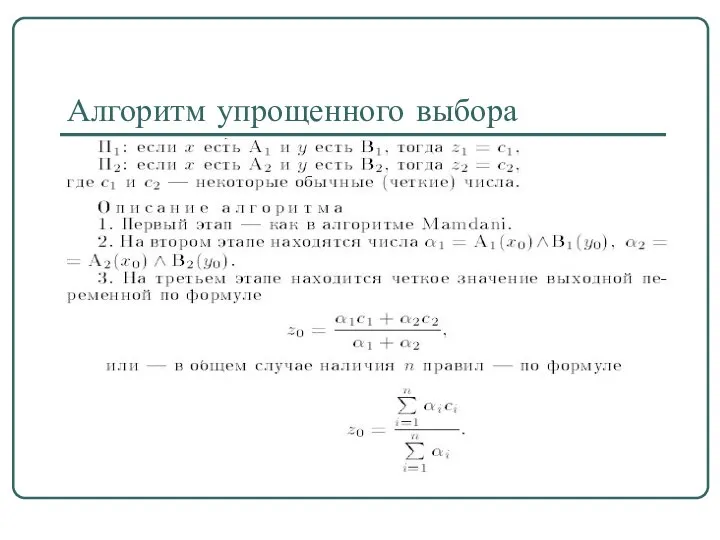

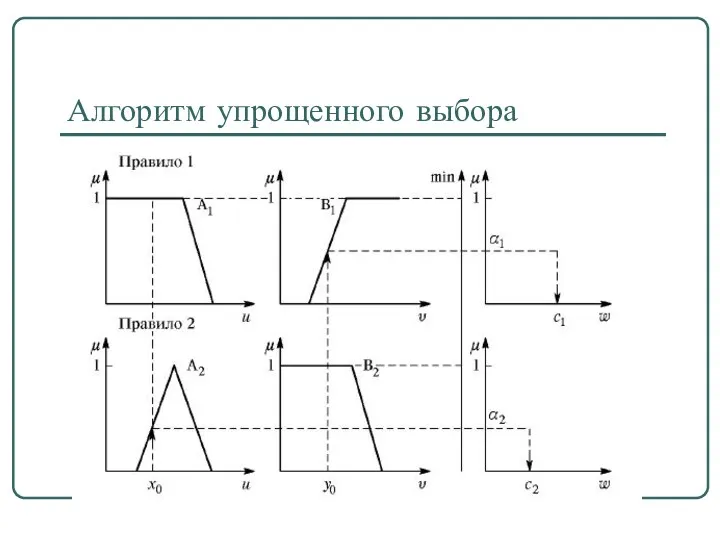

- 82. Алгоритм упрощенного выбора

- 83. Алгоритм упрощенного выбора

- 84. Спасибо за внимание! Успехов!!!

- 85. Нейроны и нейронные сети Нечеткая логика и нейронные сети

- 86. Нейронные сети… - раздел искусственного интеллекта, в котором для обработки сигналов используются явления, аналогичные происходящим в

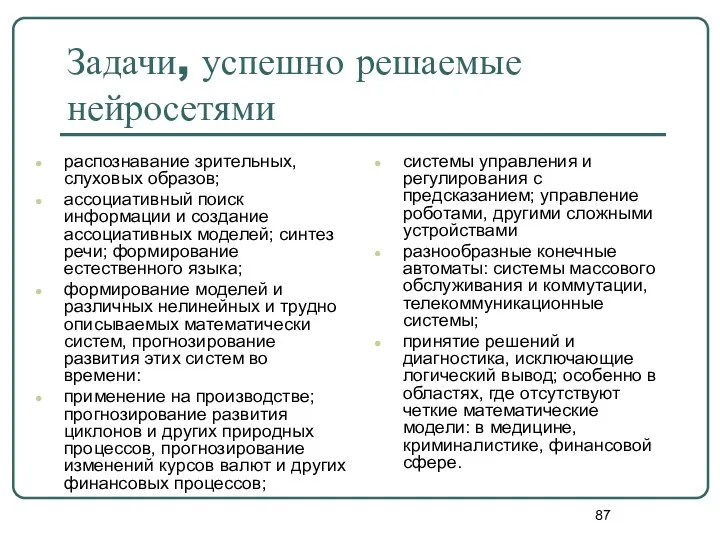

- 87. Задачи, успешно решаемые нейросетями распознавание зрительных, слуховых образов; ассоциативный поиск информации и создание ассоциативных моделей; синтез

- 88. Сферы знаний Биокибернетика Электроника Прикладная математика Статистика Автоматика Медицина нейронные сети

- 89. Нейрокомпьютер… - программно-техническая система (ее также можно назвать специализированной ЭВМ), которая реализует, или, как говорят, обеспечивает

- 90. История нейрокомпьютера Уровень интереса 40-е 60-е 50-е 70-е 80-е 90-е ХХI век первые попытки разработки ИИС

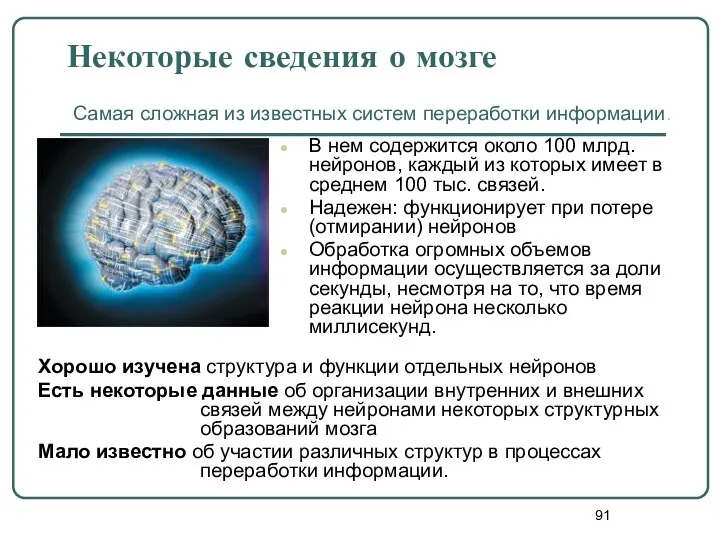

- 91. Некоторые сведения о мозге В нем содержится около 100 млрд. нейронов, каждый из которых имеет в

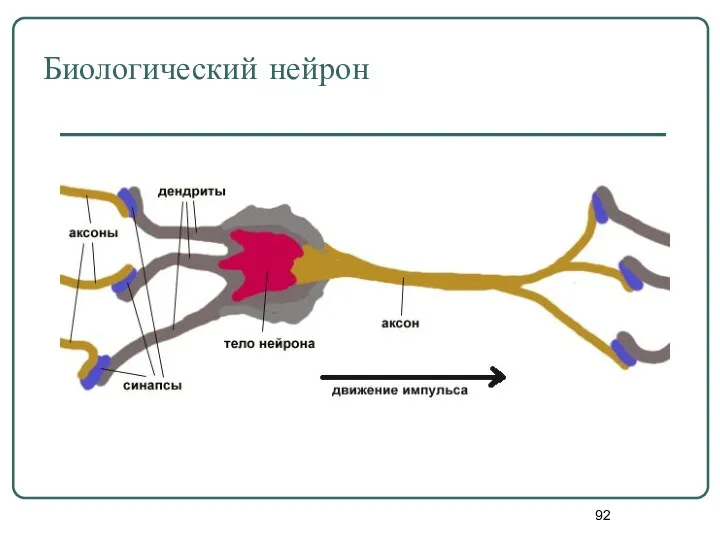

- 92. Биологический нейрон

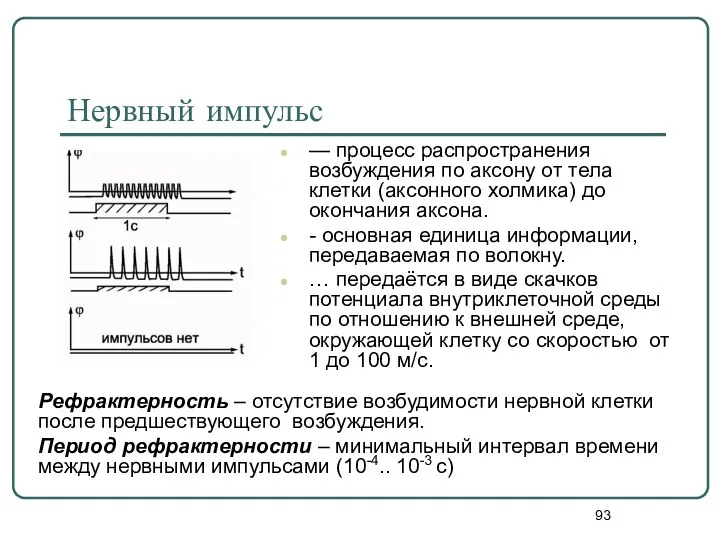

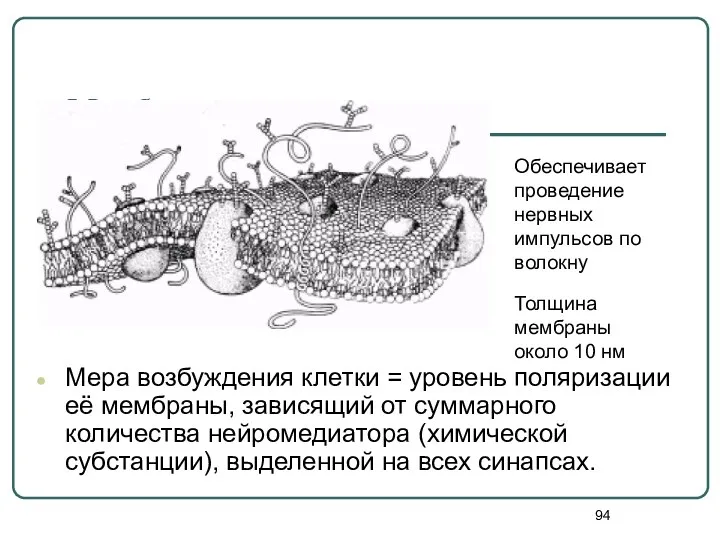

- 93. Нервный импульс — процесс распространения возбуждения по аксону от тела клетки (аксонного холмика) до окончания аксона.

- 94. Мембрана Мера возбуждения клетки = уровень поляризации её мембраны, зависящий от суммарного количества нейромедиатора (химической субстанции),

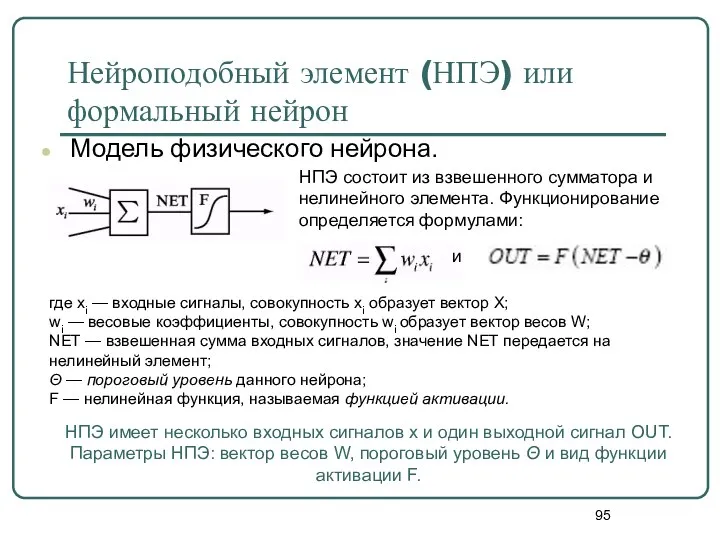

- 95. Нейроподобный элемент (НПЭ) или формальный нейрон Модель физического нейрона. где xi — входные сигналы, совокупность xi

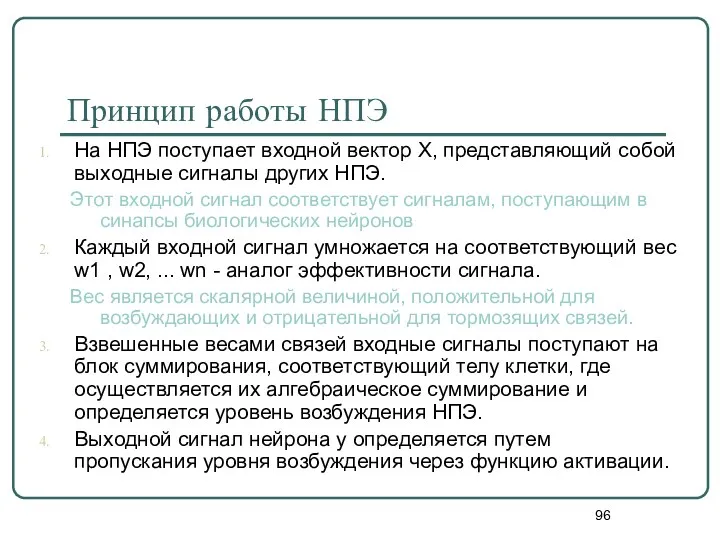

- 96. Принцип работы НПЭ На НПЭ поступает входной вектор X, представляющий собой выходные сигналы других НПЭ. Этот

- 97. Виды функций активации F

- 98. Жесткая ступенька и пологая ступенька Жёсткая ступенька + простая; + реализация требует малых затрат; не позволяет

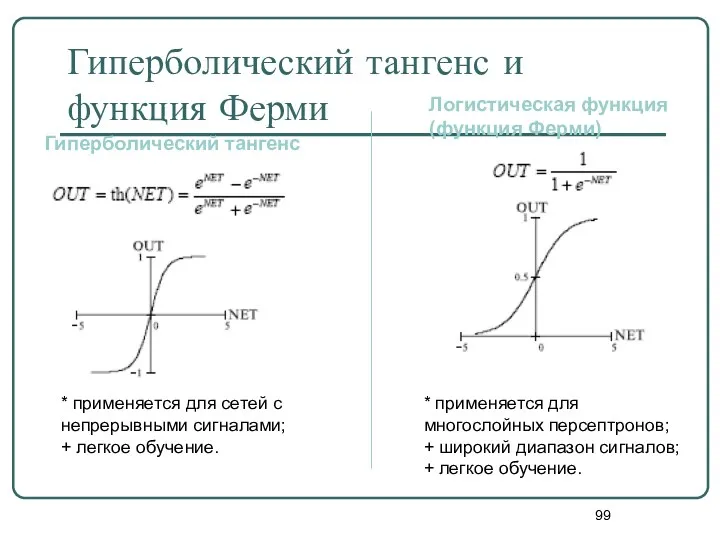

- 99. Гиперболический тангенс и функция Ферми Гиперболический тангенс Логистическая функция (функция Ферми) * применяется для многослойных персептронов;

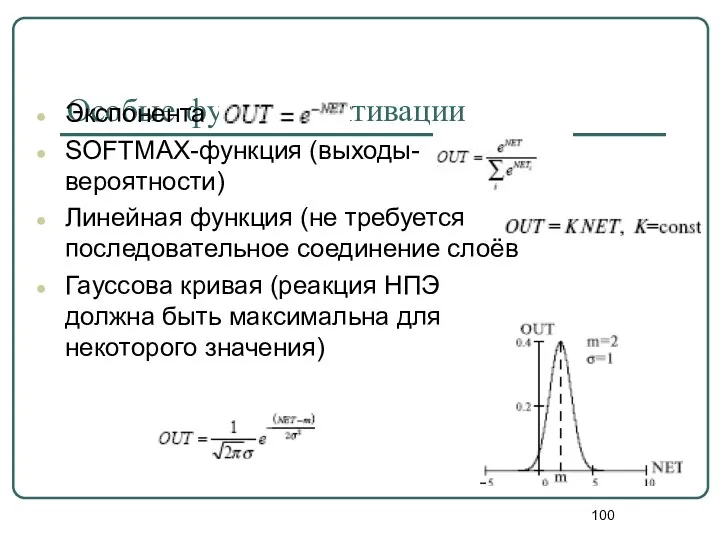

- 100. Особые функции активации Экспонента SOFTMAX-функция (выходы-вероятности) Линейная функция (не требуется последовательное соединение слоёв Гауссова кривая (реакция

- 101. Выбор функции активации определяется… спецификой задачи. удобством реализации на ЭВМ, в виде электрической схемы или другим

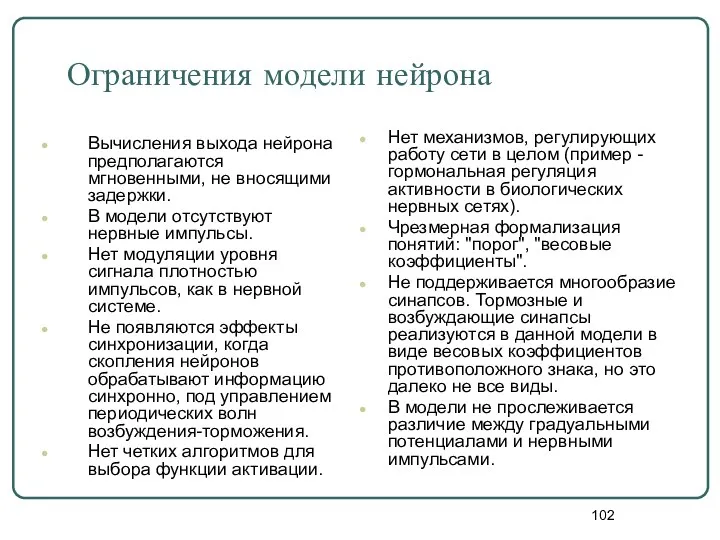

- 102. Ограничения модели нейрона Вычисления выхода нейрона предполагаются мгновенными, не вносящими задержки. В модели отсутствуют нервные импульсы.

- 103. Нейроподобная сеть - совокупность нейроподобных элементов, определенным образом соединенных друг с другом и с внешней средой.

- 104. Особенности архитектуры нейросети топология межнейронных связей; выбор определенного подмножества НПЭ для ввода и вывода информации; наличие

- 105. Искусственные нейронные сети

- 106. Важнейшие свойства биологических нейросетей Способность к полной обработке информации: ассоциативность (сеть может восстанавливать полный образ по

- 107. Отличия между биологическими НС и ЭВМ на архитектуре фон Неймана (с) И.В. Попова

- 108. Подходы к созданию нейронных сетей Информационный подход: безразлично, какие механизмы лежат в основе работы искусственных нейронных

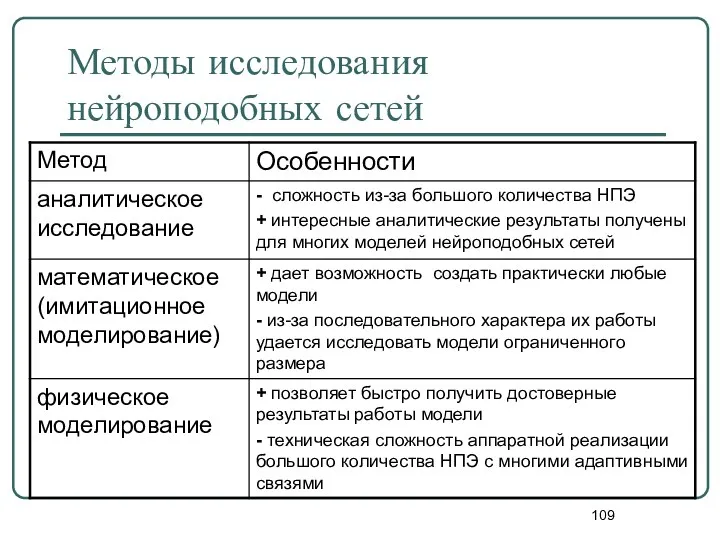

- 109. Методы исследования нейроподобных сетей

- 110. Категории моделей нейронных сетей модели отдельных нейронов; модели небольших групп нейронов; модели нейронных сетей; модели мыслительной

- 111. Виды обучения нейронных сетей

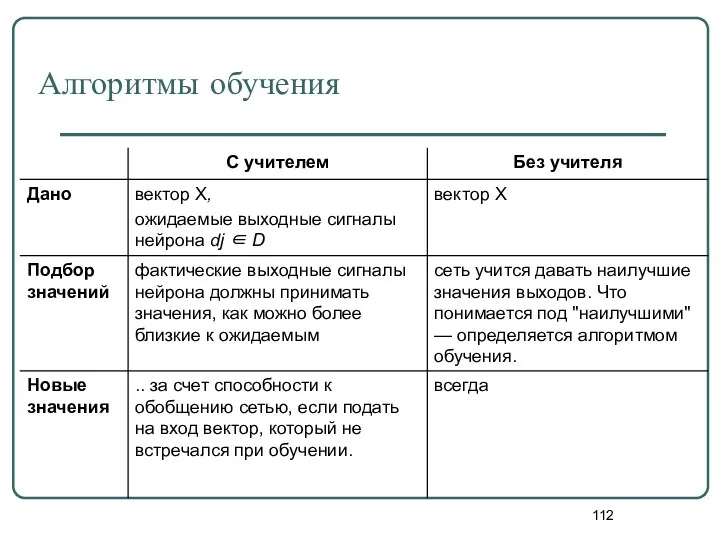

- 112. Алгоритмы обучения

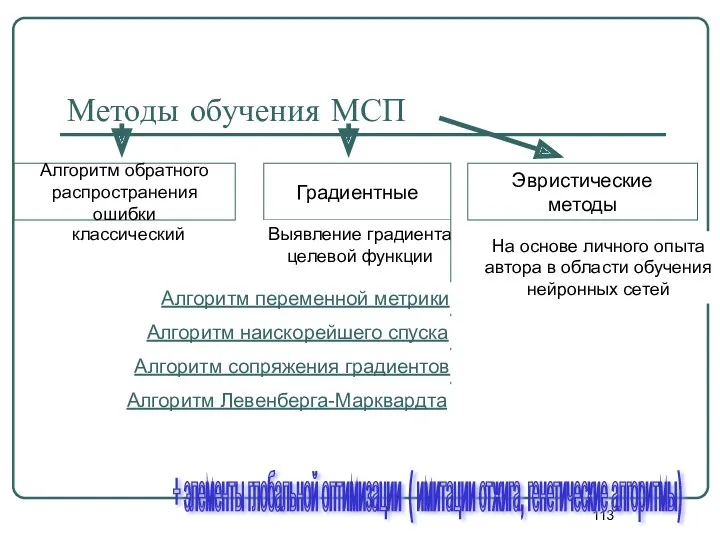

- 113. Методы обучения МСП классический Алгоритм обратного распространения ошибки Градиентные Эвристические методы Выявление градиента целевой функции На

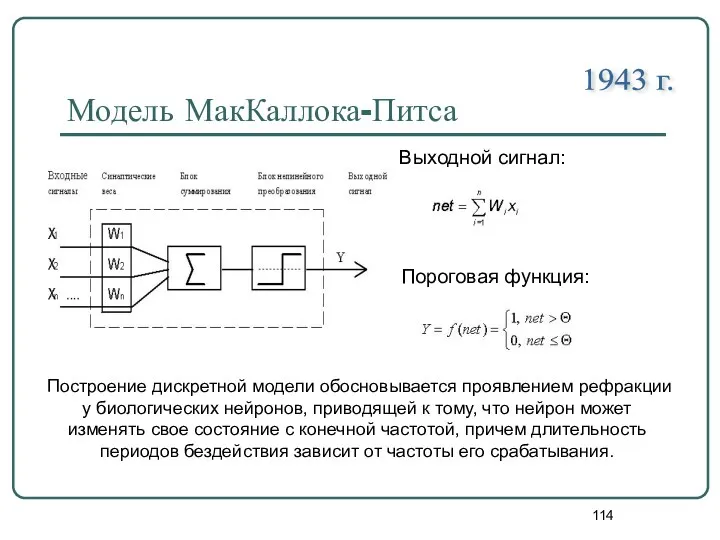

- 114. Модель МакКаллока-Питса Выходной сигнал: Пороговая функция: Построение дискретной модели обосновывается проявлением рефракции у биологических нейронов, приводящей

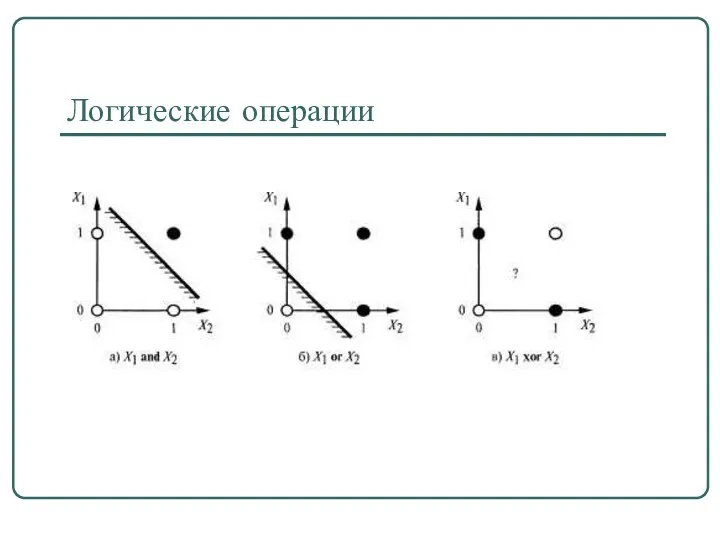

- 115. Логические операции

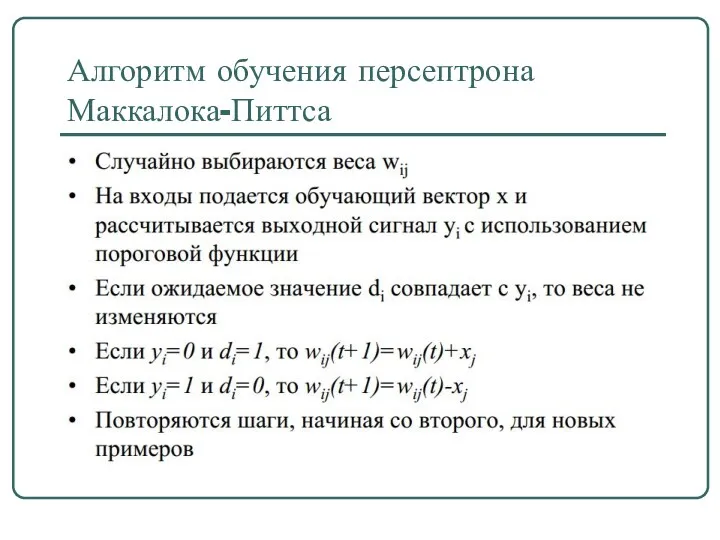

- 116. Алгоритм обучения персептрона Маккалока-Питтса

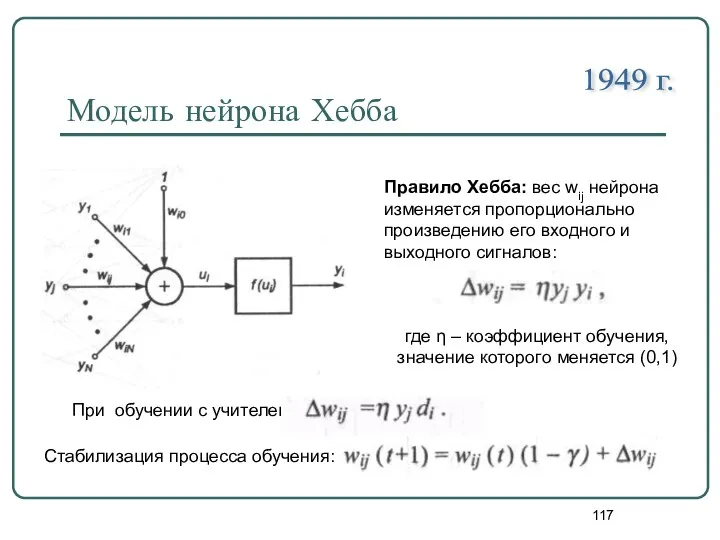

- 117. Модель нейрона Хебба 1949 г. Правило Хебба: вес wij нейрона изменяется пропорционально произведению его входного и

- 118. Классификация нейронных сетей Нейронная сеть Однонаправленные Рекуррентные ( с обратной связью) Однослойные Многослойные Количество слоёв нейронов

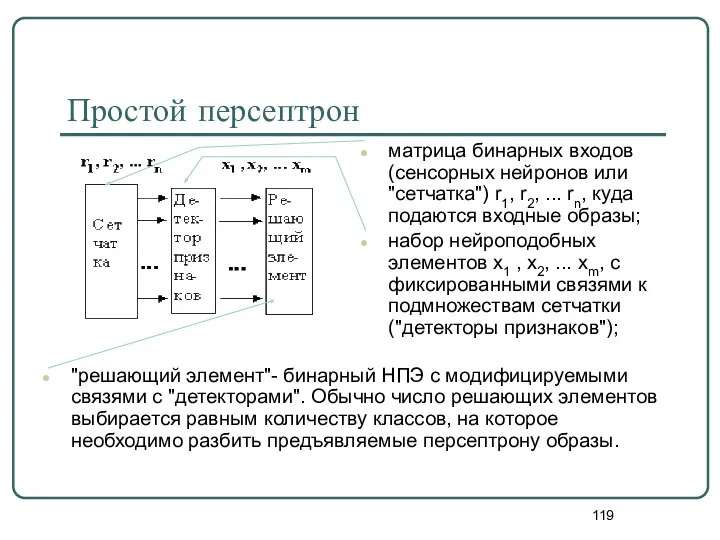

- 119. Простой персептрон матрица бинарных входов (сенсорных нейронов или "сетчатка") r1, r2, ... rn, куда подаются входные

- 120. Персептрон Розенблатта Простой персептрон, для которого справедливы условия: n=m и xi = ri, при этом детекторы

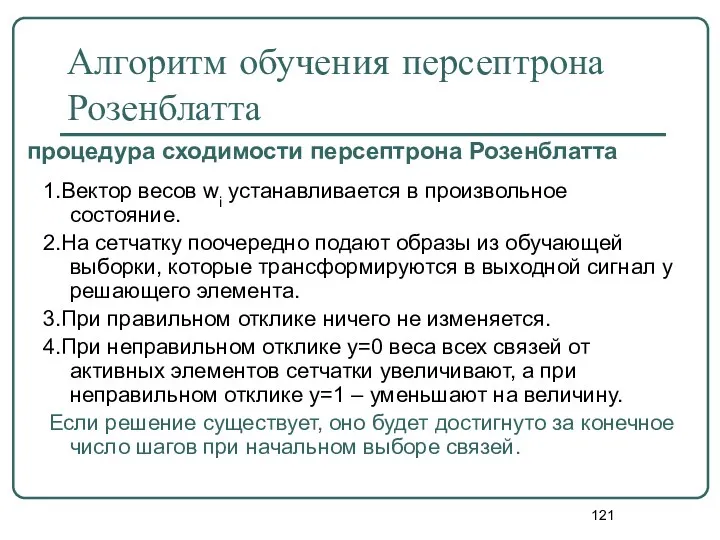

- 121. Алгоритм обучения персептрона Розенблатта 1.Вектор весов wi устанавливается в произвольное состояние. 2.На сетчатку поочередно подают образы

- 122. Характеристики персептрона Тип входных сигналов: бинарные или аналоговые (действительные). Размерности входа и выхода ограничены при программной

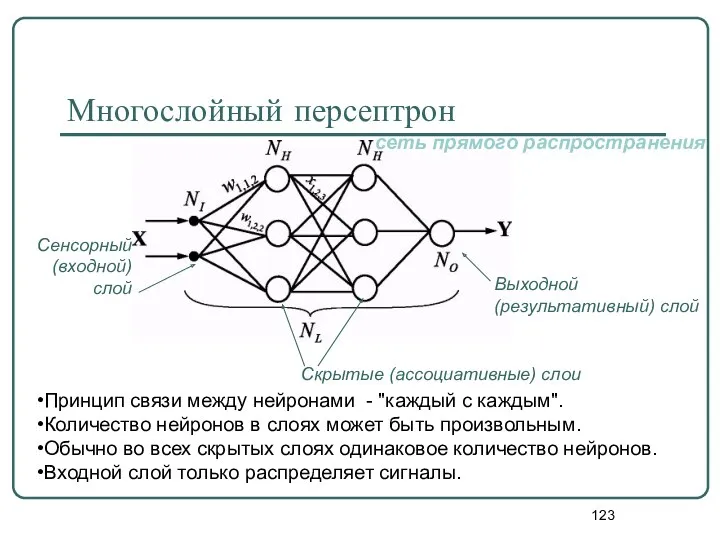

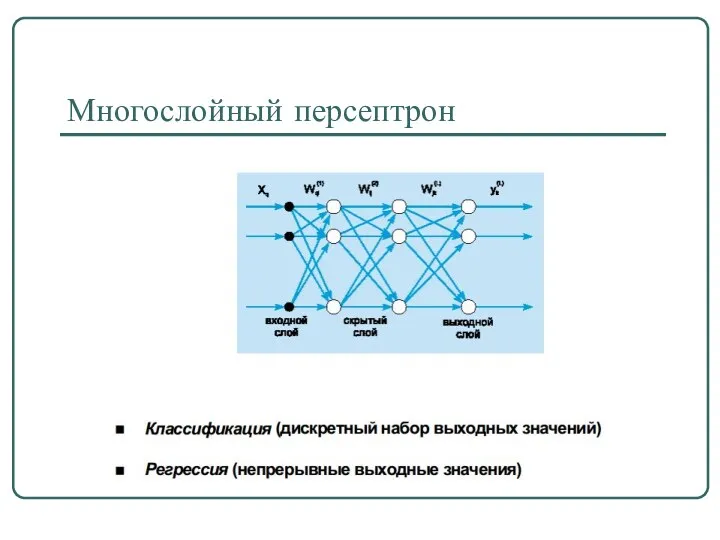

- 123. Многослойный персептрон Принцип связи между нейронами - "каждый с каждым". Количество нейронов в слоях может быть

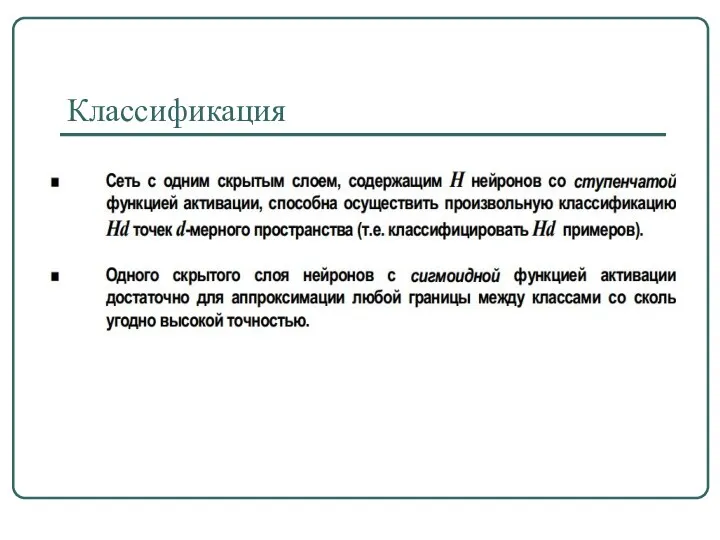

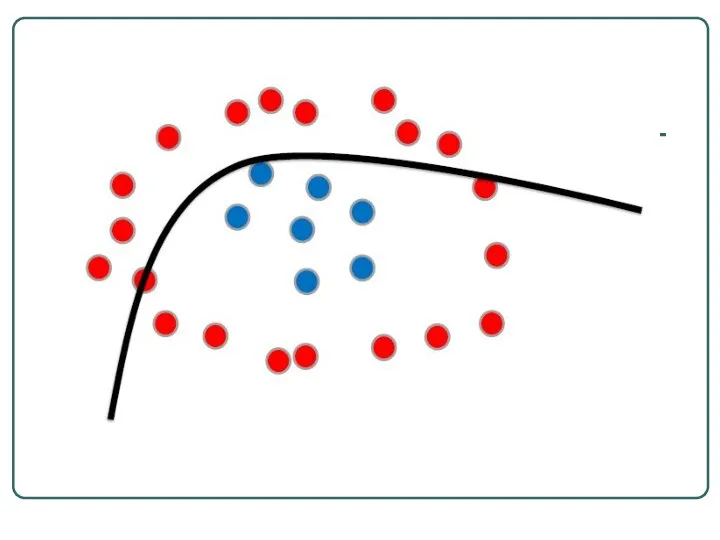

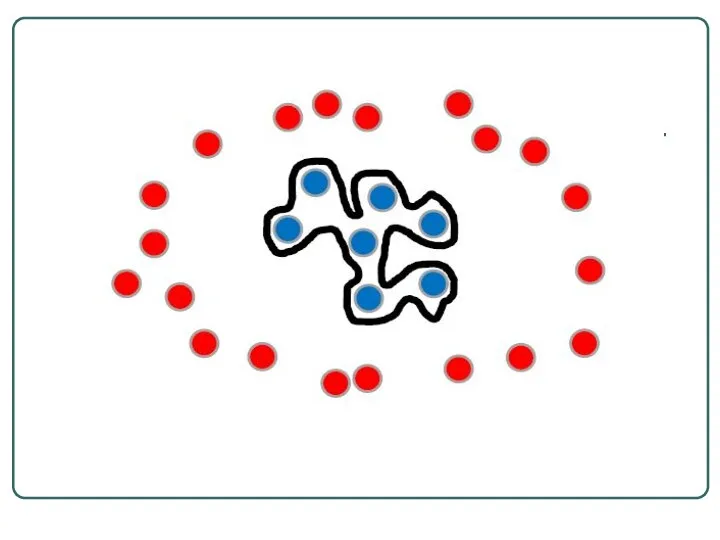

- 124. Классификация

- 125. Регрессия (аппроксимация)

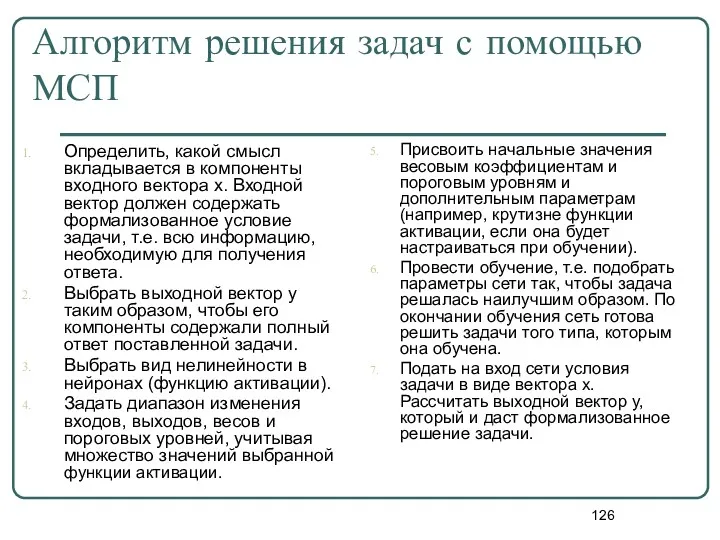

- 126. Алгоритм решения задач с помощью МСП Определить, какой смысл вкладывается в компоненты входного вектора х. Входной

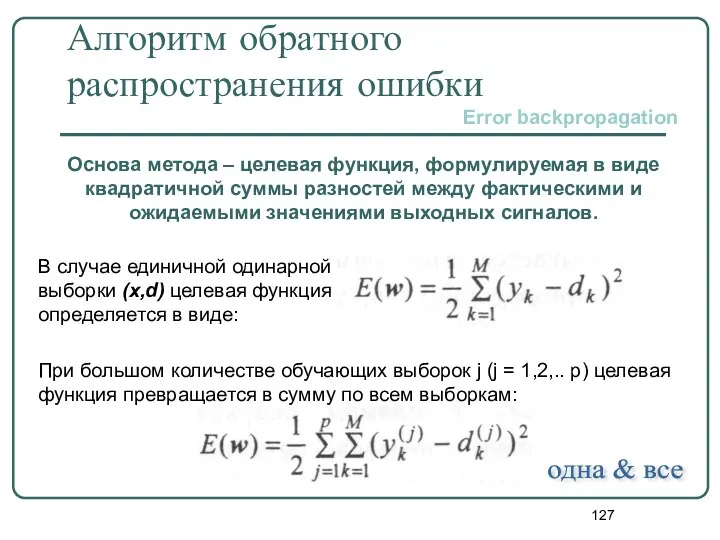

- 127. Алгоритм обратного распространения ошибки Основа метода – целевая функция, формулируемая в виде квадратичной суммы разностей между

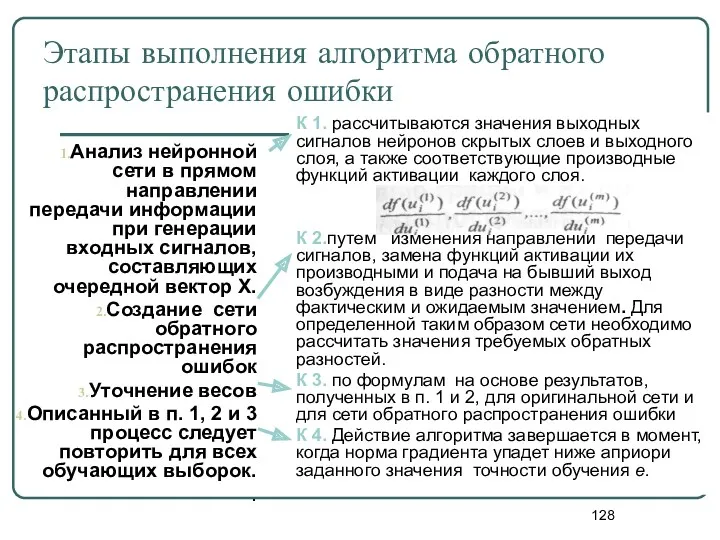

- 128. Этапы выполнения алгоритма обратного распространения ошибки Анализ нейронной сети в прямом направлении передачи информации при генерации

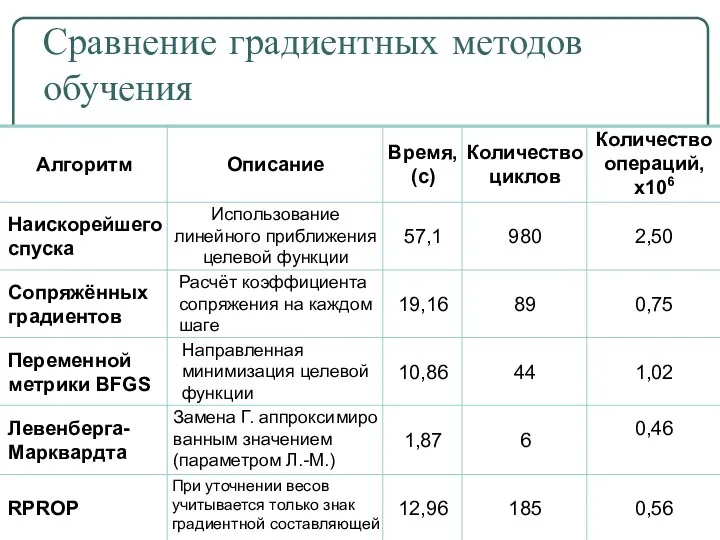

- 129. Сравнение градиентных методов обучения

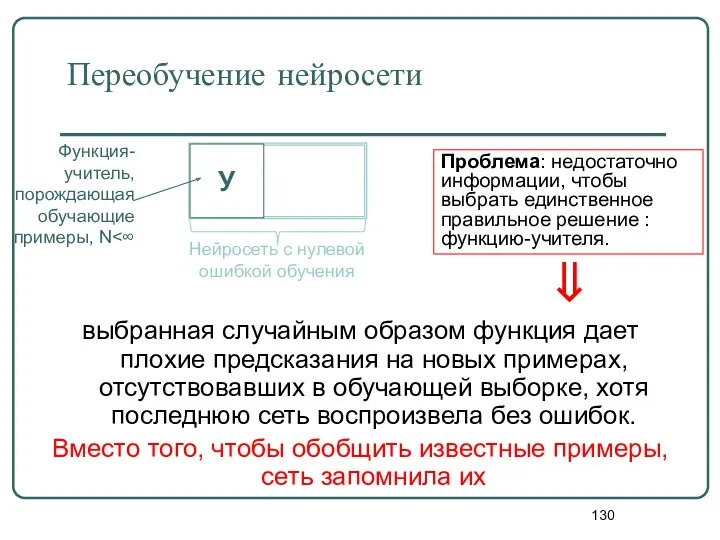

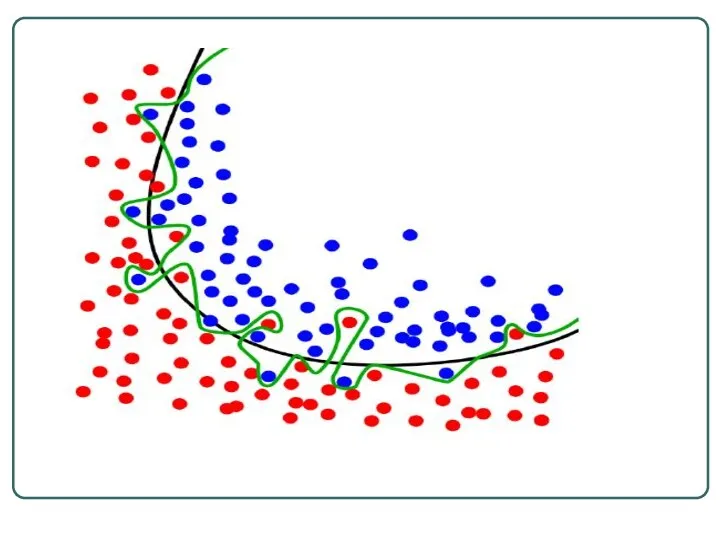

- 130. Переобучение нейросети выбранная случайным образом функция дает плохие предсказания на новых примерах, отсутствовавших в обучающей выборке,

- 131. Многослойный персептрон

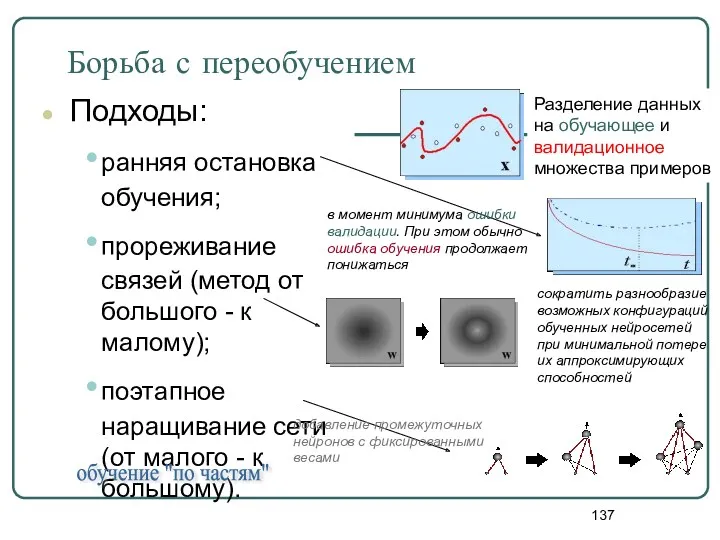

- 137. Борьба с переобучением Подходы: ранняя остановка обучения; прореживание связей (метод от большого - к малому); поэтапное

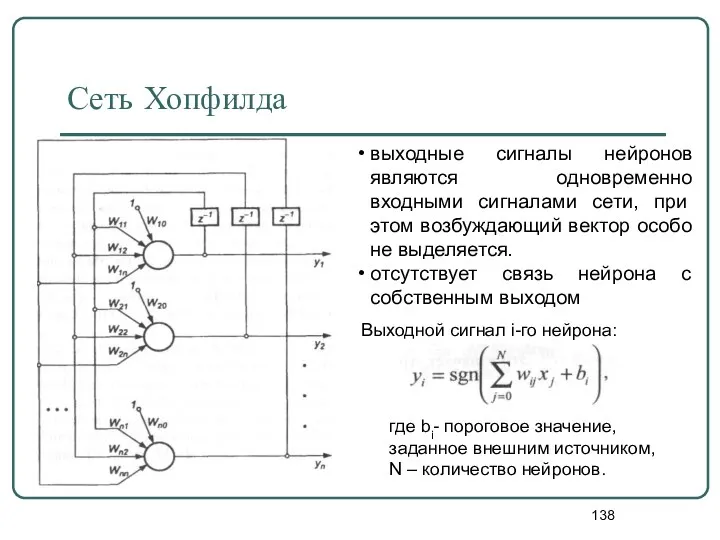

- 138. Сеть Хопфилда выходные сигналы нейронов являются одновременно входными сигналами сети, при этом возбуждающий вектор особо не

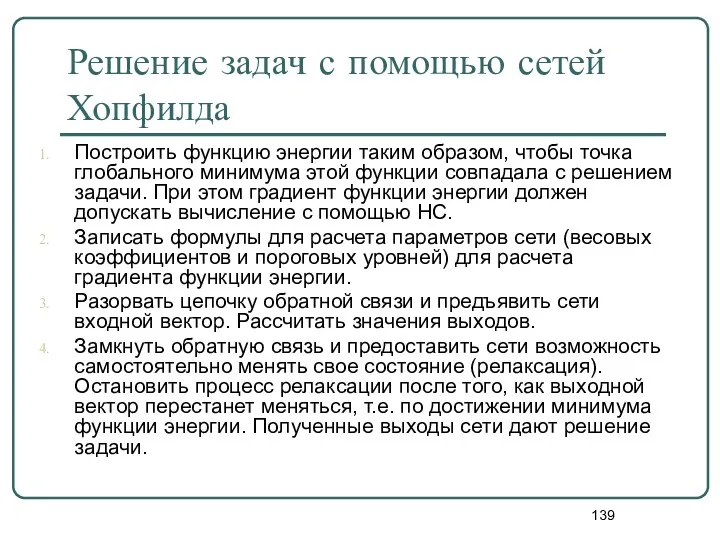

- 139. Решение задач с помощью сетей Хопфилда Построить функцию энергии таким образом, чтобы точка глобального минимума этой

- 140. Такая форма предполагает однократное предъявление всех р обучающих выборок, в результате чего матрица весов сети принимает

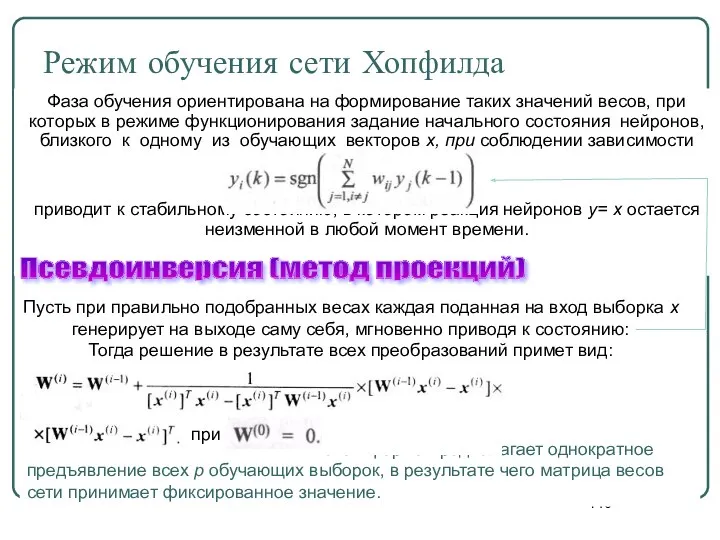

- 141. Режим распознавания сети Хопфилда Обучение Тестирование Образцы - 10 цифр, представленных в пиксельной форме размерностью 7x7.

- 142. Свойства современных нейросетей Обучаемость. Выбрав одну из моделей НС, создав сеть и выполнив алгоритм обучения, мы

- 144. Скачать презентацию

![Основные характеристики нечётких множеств Пусть М=[0,1] и А – нечеткое](/_ipx/f_webp&q_80&fit_contain&s_1440x1080/imagesDir/jpg/383619/slide-9.jpg)

![Рост баскетболиста Множество определения – [170,236] Множество термов - {очень](/_ipx/f_webp&q_80&fit_contain&s_1440x1080/imagesDir/jpg/383619/slide-61.jpg)

![Рост баскетболиста Множество определения – [170,236] Очень высокий высокий средний низкий Система “Набор баскетболистов”](/_ipx/f_webp&q_80&fit_contain&s_1440x1080/imagesDir/jpg/383619/slide-62.jpg)

![Система “Набор баскетболистов” Техника игры баскетболиста Множество определения – [0,100] очень хорошая отличная средняя хорошая плохая](/_ipx/f_webp&q_80&fit_contain&s_1440x1080/imagesDir/jpg/383619/slide-63.jpg)

![Система “Набор баскетболистов” Уверенность принятия в команду Множество определения – [0,100] полная средняя малая не берём](/_ipx/f_webp&q_80&fit_contain&s_1440x1080/imagesDir/jpg/383619/slide-64.jpg)

Философия XX века. Экзистенциализм

Философия XX века. Экзистенциализм Традиции и революции в естествознании. Религиозная традиция

Традиции и революции в естествознании. Религиозная традиция Морковная терапия. Ассоциативный символизм: Принципы моркови

Морковная терапия. Ассоциативный символизм: Принципы моркови Социальные ценности и нормы

Социальные ценности и нормы Познание как деятельность

Познание как деятельность Античная философия. Диалектика Сократа

Античная философия. Диалектика Сократа Человек как главная философская проблема

Человек как главная философская проблема Общество (динамический анализ)

Общество (динамический анализ) Закон исключенного третьего

Закон исключенного третьего Русская философия

Русская философия Динамика и типология культуры

Динамика и типология культуры Социология как наука

Социология как наука Йога, как педагогический метод развития личности

Йога, как педагогический метод развития личности Характер философского знания и задачи философии

Характер философского знания и задачи философии Цінності як ядро світоглядної проблематики

Цінності як ядро світоглядної проблематики Общество и человек. Происхождение человека и становление общества

Общество и человек. Происхождение человека и становление общества Диоген Синопский

Диоген Синопский Тарих, саясат және оқу-білім философиясы

Тарих, саясат және оқу-білім философиясы Қазақ ойшылдарының философиясы. Абай философиясы

Қазақ ойшылдарының философиясы. Абай философиясы Неклассическая философия (середина XIX – XX в.в.)

Неклассическая философия (середина XIX – XX в.в.) Философия и наука

Философия и наука Філософія нового часу і німецька класична філософія

Філософія нового часу і німецька класична філософія Мораль. Нравственность. Армия. Лекция 20

Мораль. Нравственность. Армия. Лекция 20 Категория бытие в философии

Категория бытие в философии Эссенциализм. Онтология, антропология. (Лекция 2)

Эссенциализм. Онтология, антропология. (Лекция 2) Философия иррационализма. А. Шопенгауэр, Ф. Ницше

Философия иррационализма. А. Шопенгауэр, Ф. Ницше Неміс классикалық философиясы

Неміс классикалық философиясы Виды и роль ценностей в обществе

Виды и роль ценностей в обществе