Содержание

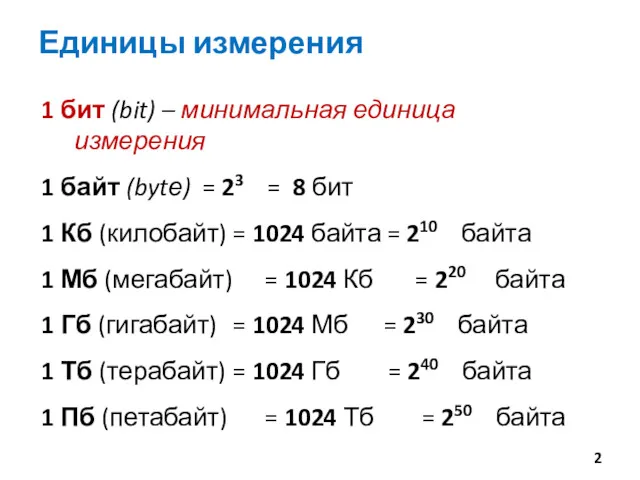

- 2. Единицы измерения 1 бит (bit) – минимальная единица измерения 1 байт (bytе) = 23 = 8

- 3. Перевод в другие единицы Пример 5 Кбайт = 5 * 1024 байт = 5120 байт 15

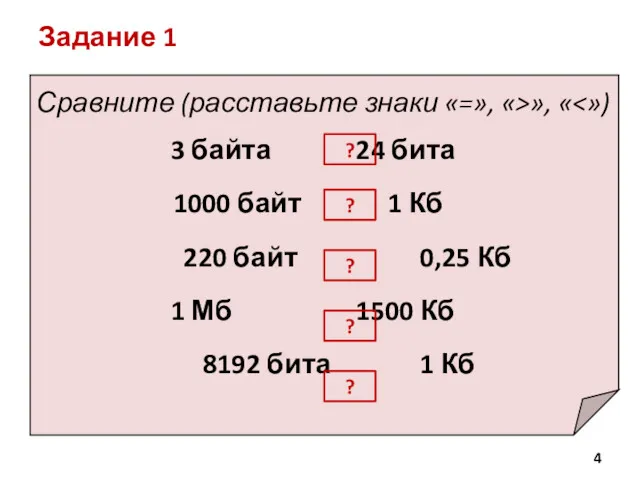

- 4. Задание 1 Сравните (расставьте знаки «=», «>», « 3 байта 24 бита 1000 байт 1 Кб

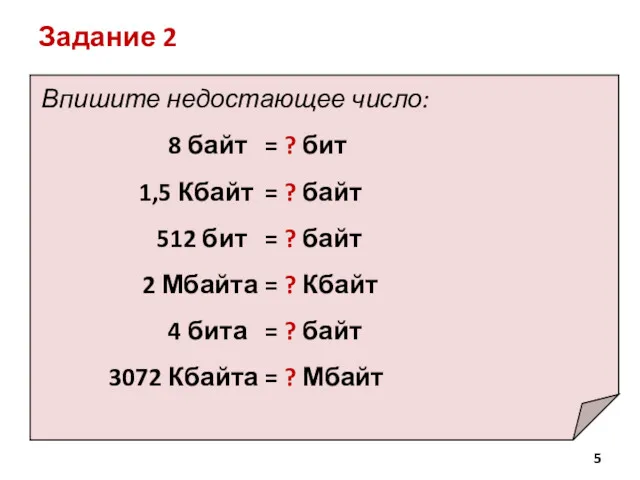

- 5. Впишите недостающее число: 8 байт = ? бит 1,5 Кбайт = ? байт 512 бит =

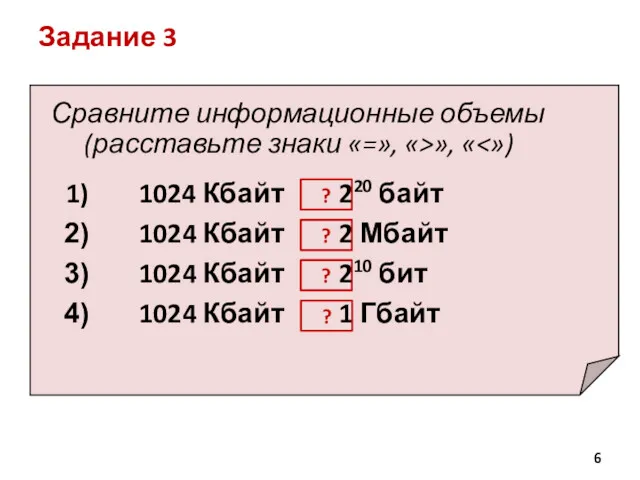

- 6. Задание 3 Сравните информационные объемы (расставьте знаки «=», «>», « 1024 Кбайт 220 байт 1024 Кбайт

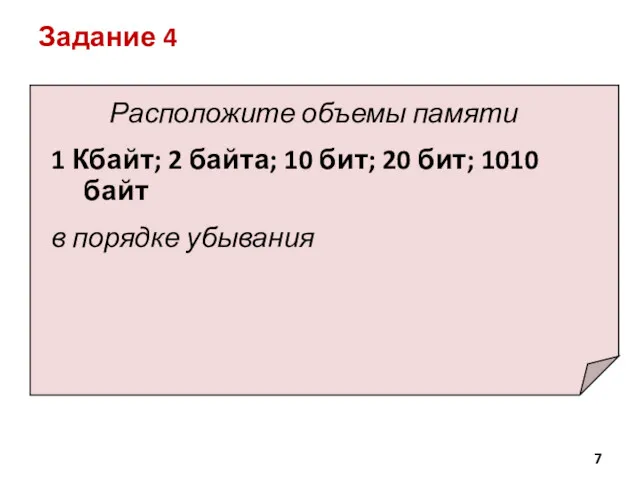

- 7. Задание 4 Расположите объемы памяти 1 Кбайт; 2 байта; 10 бит; 20 бит; 1010 байт в

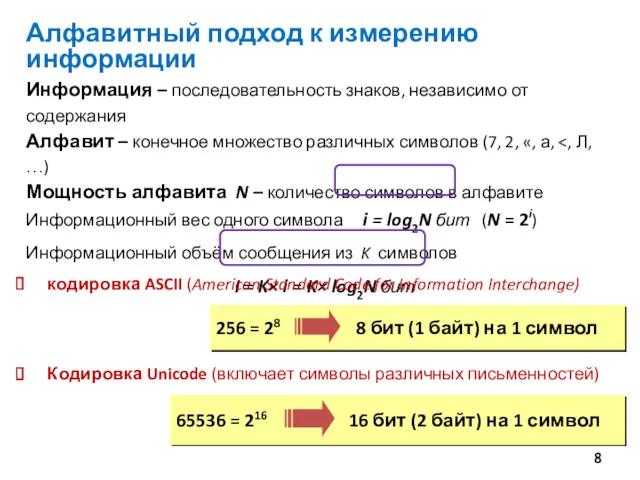

- 8. Алфавитный подход к измерению информации Информация – последовательность знаков, независимо от содержания Алфавит – конечное множество

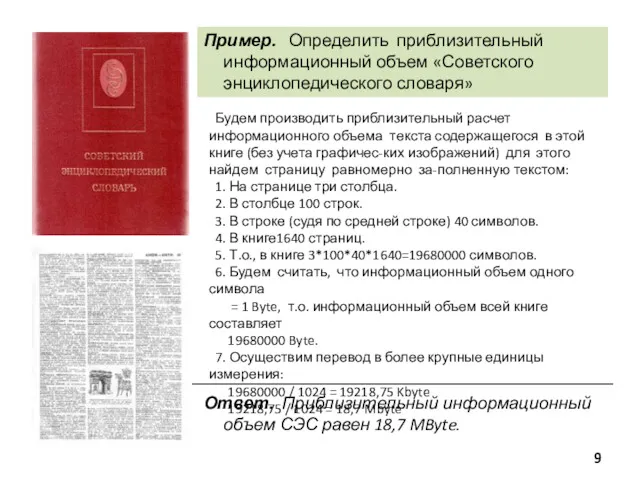

- 9. Пример. Определить приблизительный информационный объем «Советского энциклопедического словаря» Будем производить приблизительный расчет информационного объема текста содержащегося

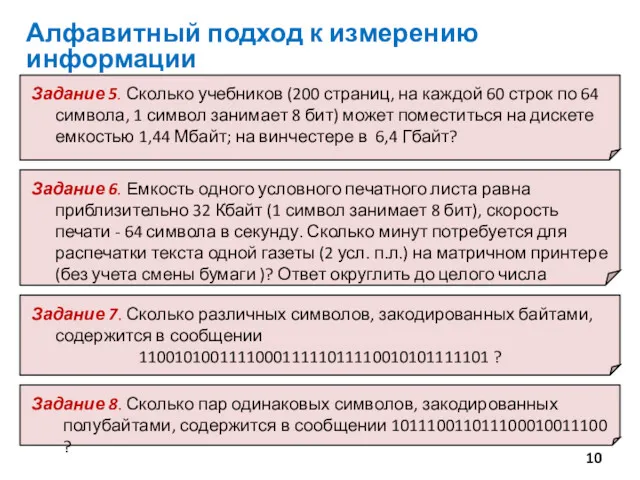

- 10. Алфавитный подход к измерению информации

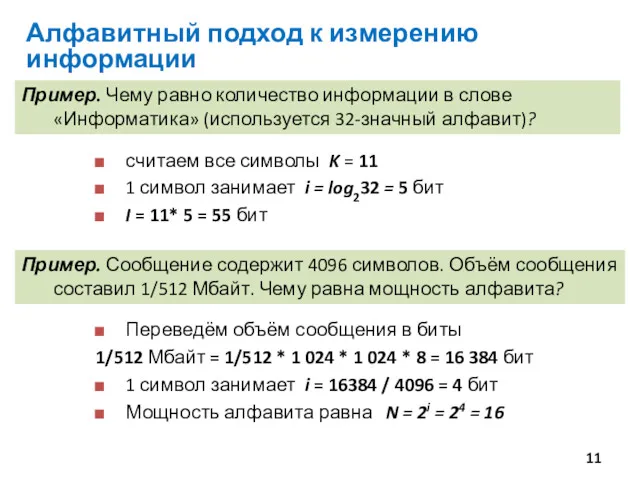

- 11. Пример. Чему равно количество информации в слове «Информатика» (используется 32-значный алфавит)? считаем все символы K =

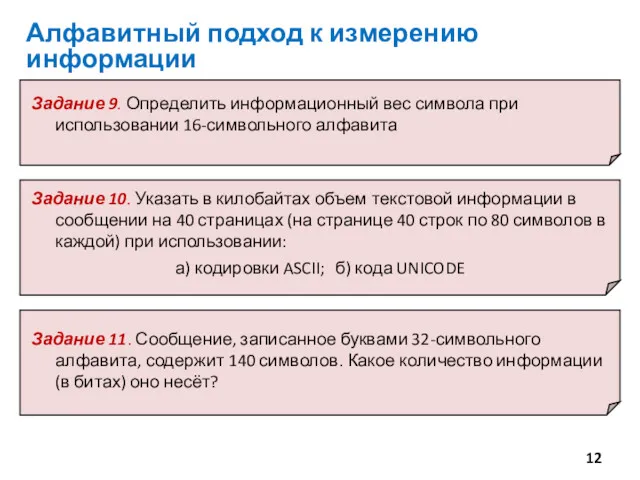

- 12. Алфавитный подход к измерению информации

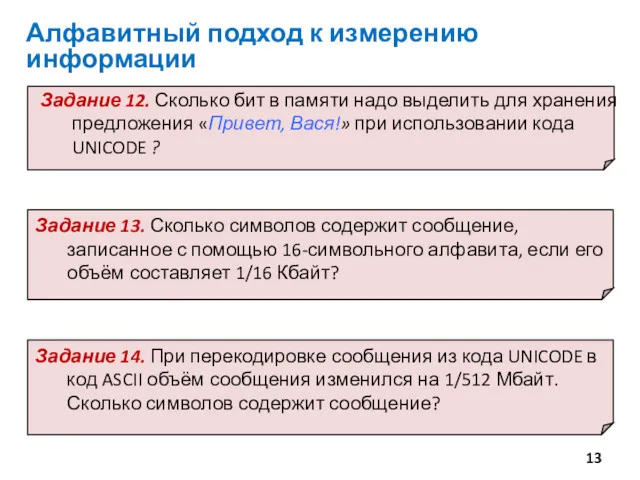

- 13. Алфавитный подход к измерению информации

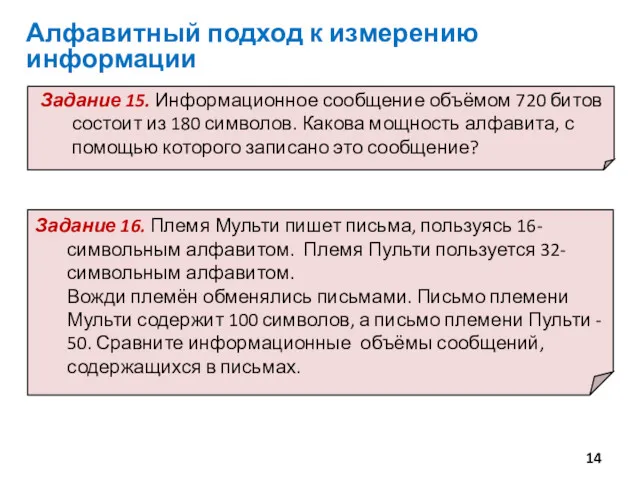

- 14. Алфавитный подход к измерению информации

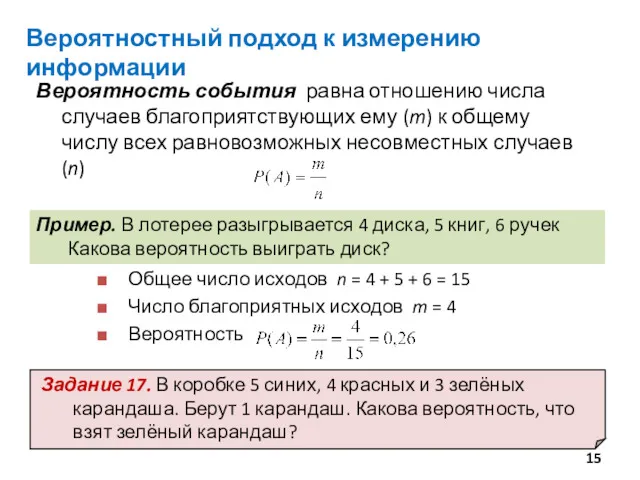

- 15. Вероятностный подход к измерению информации Вероятность события равна отношению числа случаев благоприятствующих ему (m) к общему

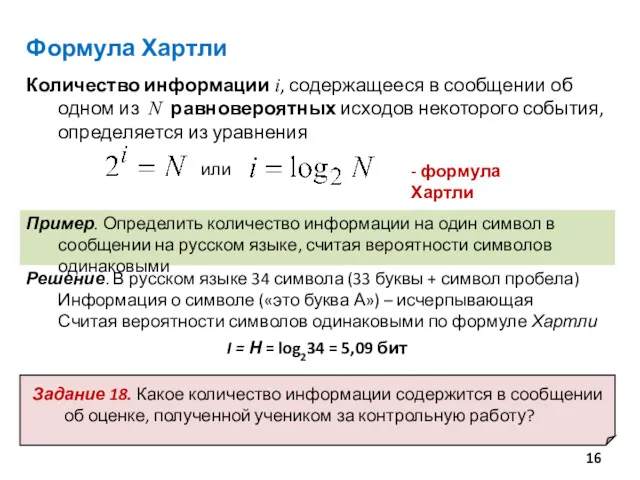

- 16. Пример. Определить количество информации на один символ в сообщении на русском языке, считая вероятности символов одинаковыми

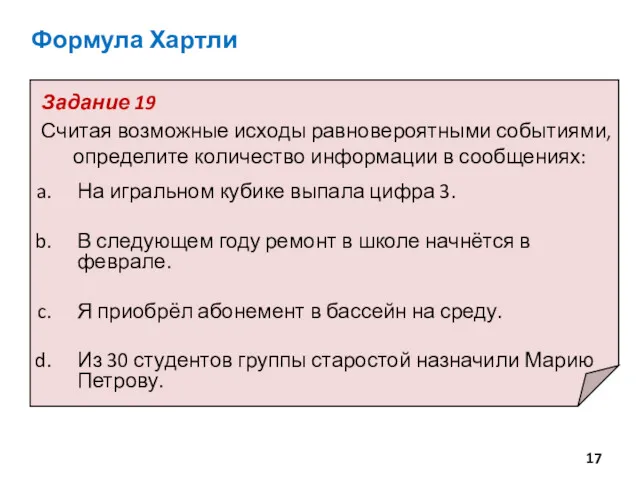

- 17. Задание 19 Считая возможные исходы равновероятными событиями, определите количество информации в сообщениях: На игральном кубике выпала

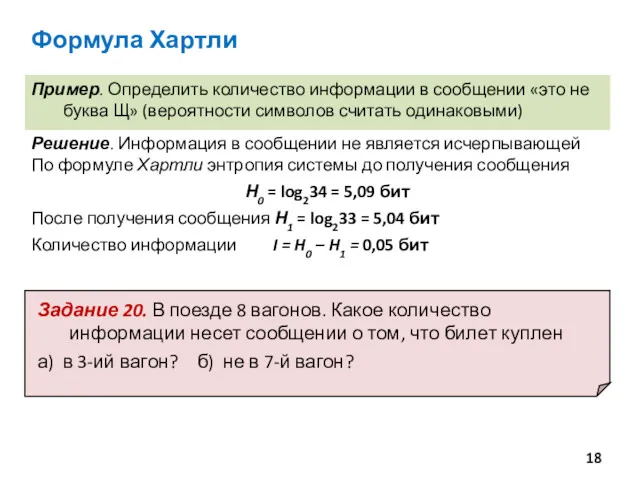

- 18. Формула Хартли Пример. Определить количество информации в сообщении «это не буква Щ» (вероятности символов считать одинаковыми)

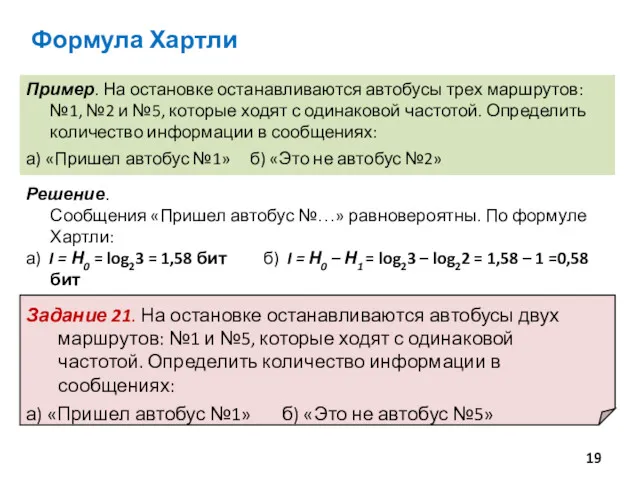

- 19. Пример. На остановке останавливаются автобусы трех маршрутов: №1, №2 и №5, которые ходят с одинаковой частотой.

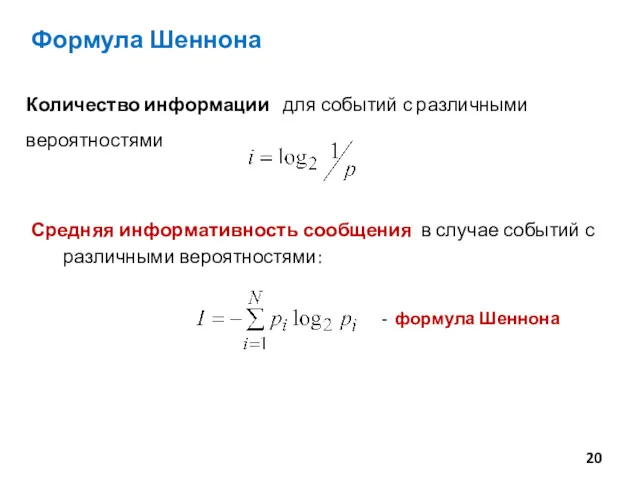

- 20. Формула Шеннона

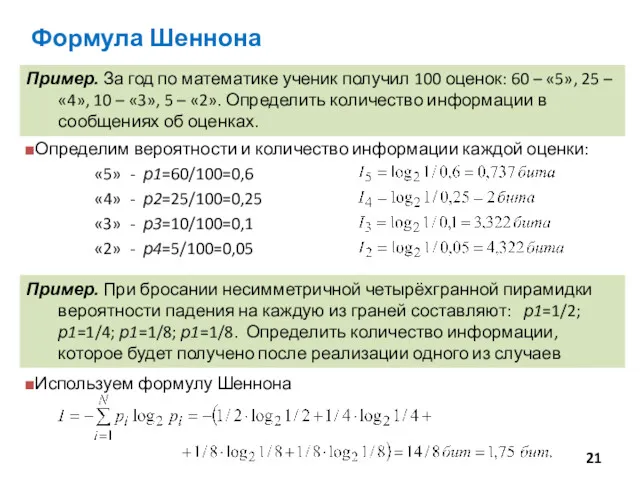

- 21. Пример. За год по математике ученик получил 100 оценок: 60 – «5», 25 – «4», 10

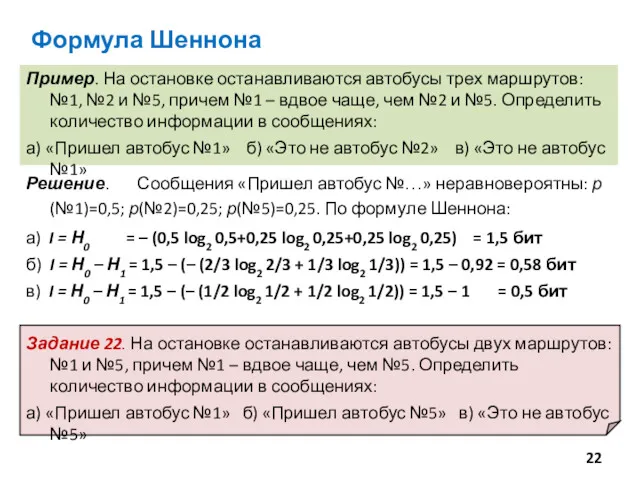

- 22. Формула Шеннона Пример. На остановке останавливаются автобусы трех маршрутов: №1, №2 и №5, причем №1 –

- 24. Скачать презентацию

Информация как предмет защиты. Категории защищаемой информации. Методы и средства защиты информации

Информация как предмет защиты. Категории защищаемой информации. Методы и средства защиты информации Структура и функции MS DOS

Структура и функции MS DOS Бази даних (БД). СУБД

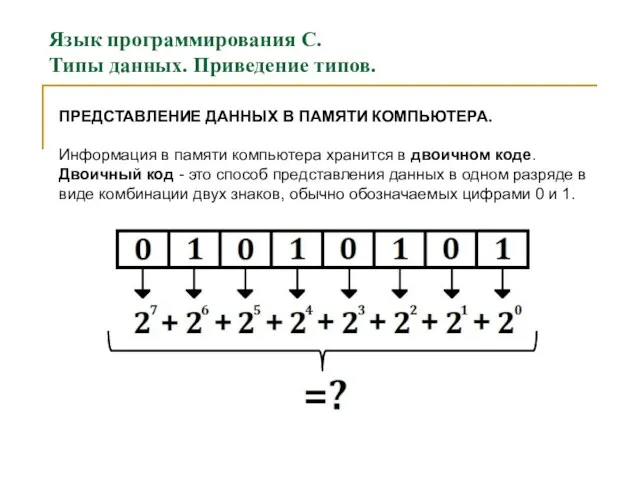

Бази даних (БД). СУБД Язык программирования С. Типы данных. Приведение типов. (Лекция 4)

Язык программирования С. Типы данных. Приведение типов. (Лекция 4) Презентация к уроку информатики 3 класс

Презентация к уроку информатики 3 класс Книга по информатике

Книга по информатике Массовые коммуникации и Интернет

Массовые коммуникации и Интернет Циклы и списки. Модуль 2

Циклы и списки. Модуль 2 Операционная система. Назначение и основные функции

Операционная система. Назначение и основные функции Разработка системы управления сайтом туристического агентства

Разработка системы управления сайтом туристического агентства Размещение архивной информации в сети Интернет Уральского Федерального округа

Размещение архивной информации в сети Интернет Уральского Федерального округа Система электронных дневников и журналов

Система электронных дневников и журналов Топологии компьютерных сетей

Топологии компьютерных сетей Fixed Points

Fixed Points Тірілген графика. Айнымалылармен жұмыс

Тірілген графика. Айнымалылармен жұмыс Краткая информация о Microsoft Office Enterprise 2007 Russian

Краткая информация о Microsoft Office Enterprise 2007 Russian Мемы как явление субкультуры

Мемы как явление субкультуры Розробка Android-додатку “PDF читач”

Розробка Android-додатку “PDF читач” Регистрация на портале госуслуг студентов и сотрудников БелГУ

Регистрация на портале госуслуг студентов и сотрудников БелГУ Методы и приемы программирования в среде LabView

Методы и приемы программирования в среде LabView Программируемые логические контроллеры

Программируемые логические контроллеры Creating Packages

Creating Packages Файлы и файловые структуры

Файлы и файловые структуры C++. Функции

C++. Функции Основы программирования. Представление графов

Основы программирования. Представление графов Принципы обработки информации компьютером. Алгоритмы и способы их описания

Принципы обработки информации компьютером. Алгоритмы и способы их описания История создания компьютера

История создания компьютера Прогресс техники. Создание робота

Прогресс техники. Создание робота