Содержание

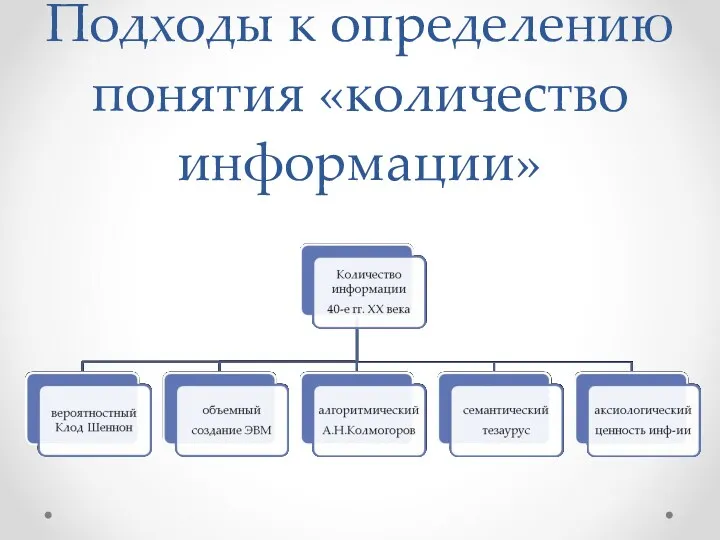

- 2. Подходы к определению понятия «количество информации»

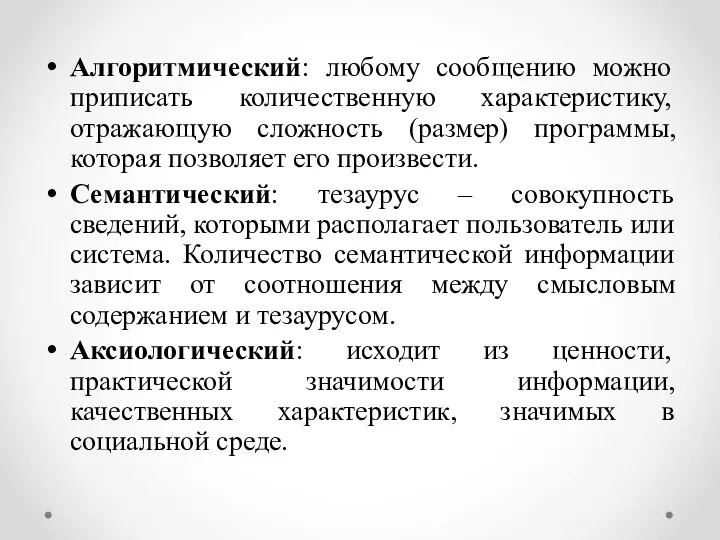

- 3. Алгоритмический: любому сообщению можно приписать количественную характеристику, отражающую сложность (размер) программы, которая позволяет его произвести. Семантический:

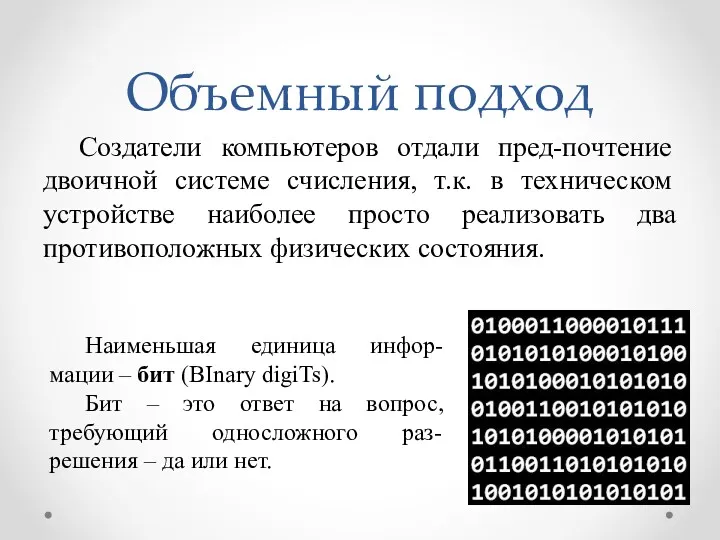

- 4. Объемный подход Создатели компьютеров отдали пред-почтение двоичной системе счисления, т.к. в техническом устройстве наиболее просто реализовать

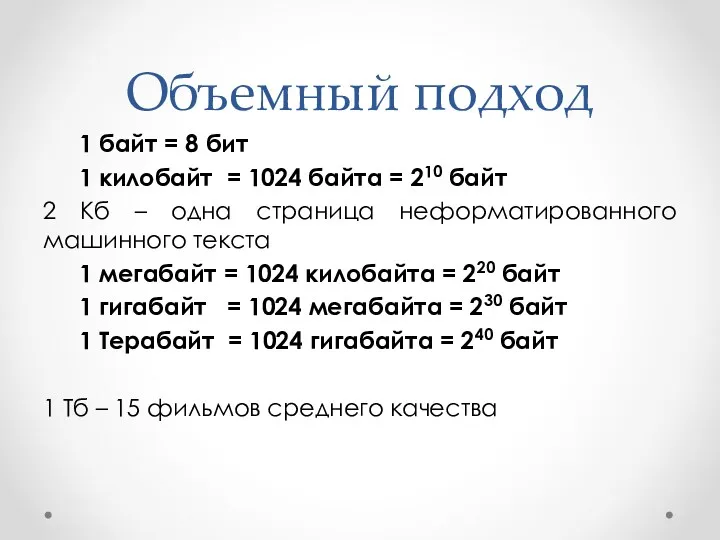

- 5. Объемный подход 1 байт = 8 бит 1 килобайт = 1024 байта = 210 байт 2

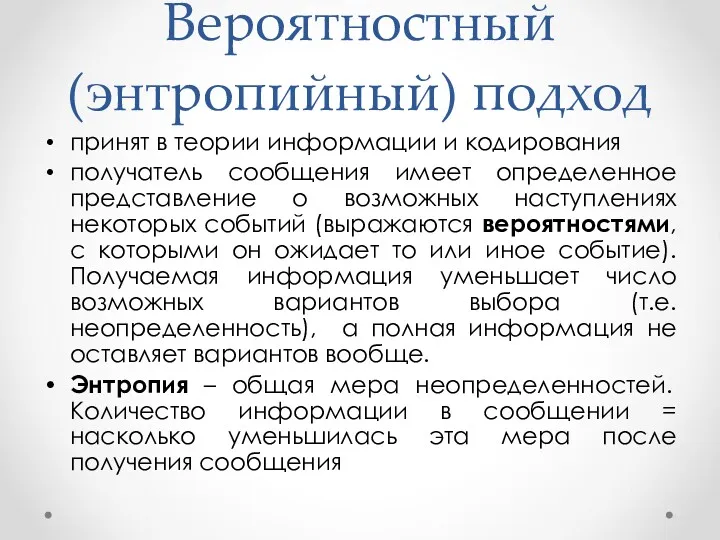

- 6. Вероятностный (энтропийный) подход принят в теории информации и кодирования получатель сообщения имеет определенное представление о возможных

- 7. Вероятность Идет ли сейчас снег? Вероятность – это число в интервале от 0 до 1. p=1

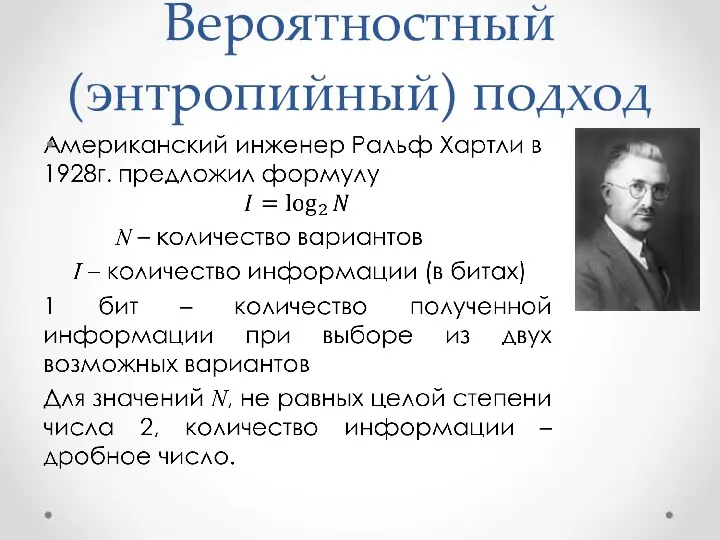

- 8. Вероятностный (энтропийный) подход

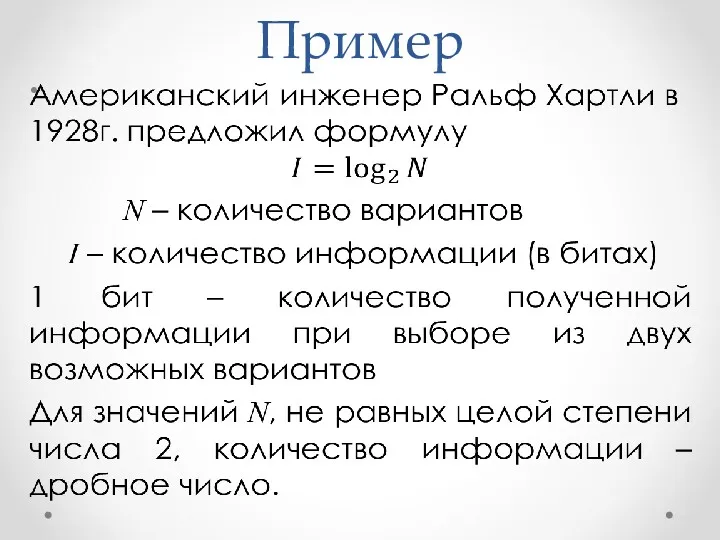

- 9. Пример

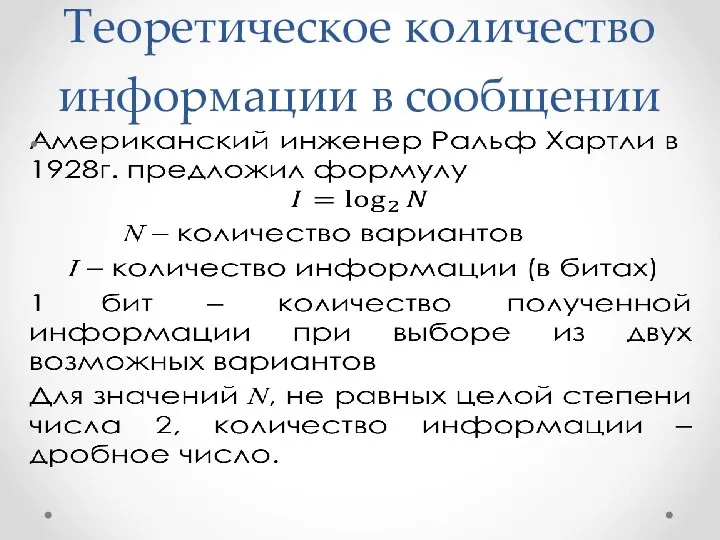

- 10. Теоретическое количество информации в сообщении

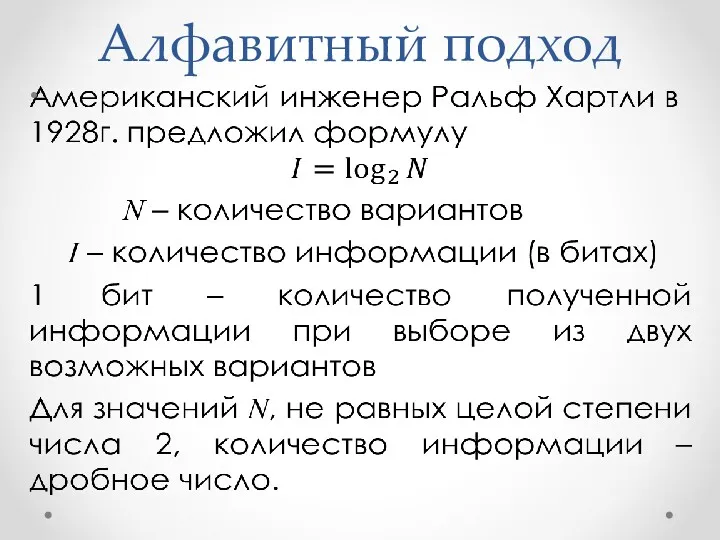

- 11. Алфавитный подход

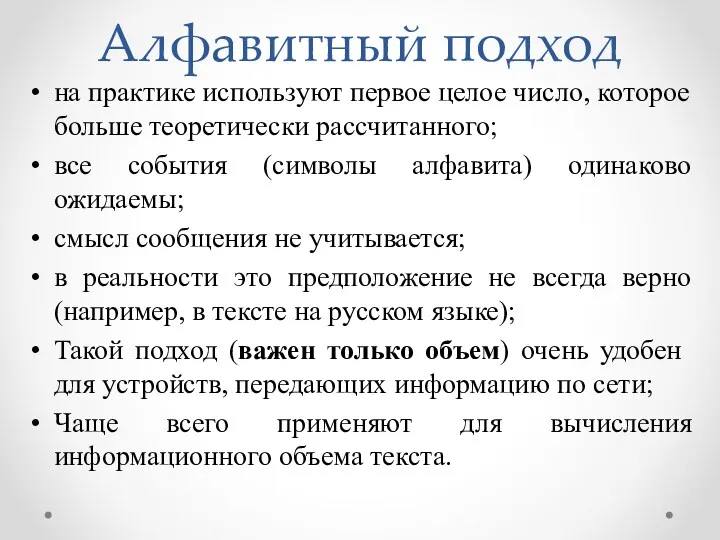

- 12. Алфавитный подход на практике используют первое целое число, которое больше теоретически рассчитанного; все события (символы алфавита)

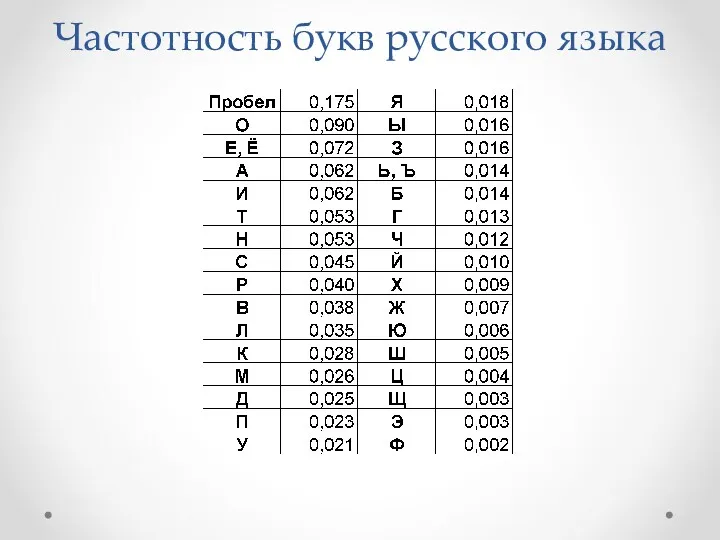

- 13. Частотность букв русского языка

- 14. Понятие вероятности Классический игральный кубик имеет 6 граней. Вероятность выпадения каждой грани равна 1/6. Вероятность выпадения

- 15. Вероятностный (энтропийный) подход

- 16. Понятие энтропии Энтропия – в естественных науках - мера беспорядка системы, состоящей из многих элементов в

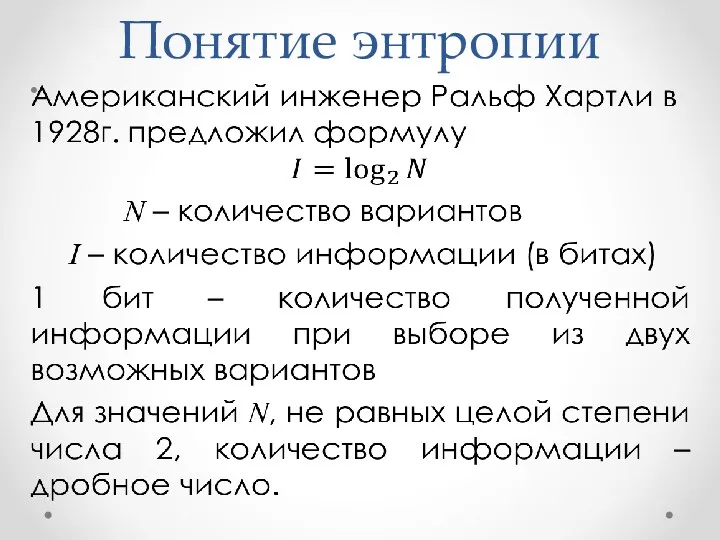

- 17. Понятие энтропии

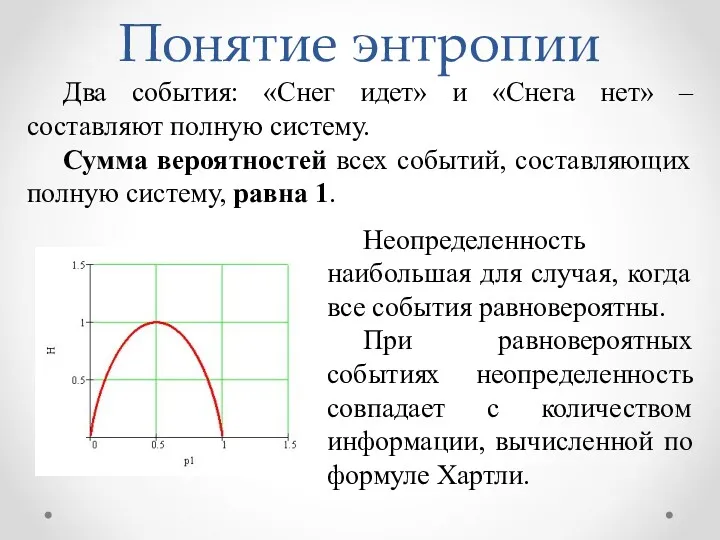

- 18. Понятие энтропии Неопределенность наибольшая для случая, когда все события равновероятны. При равновероятных событиях неопределенность совпадает с

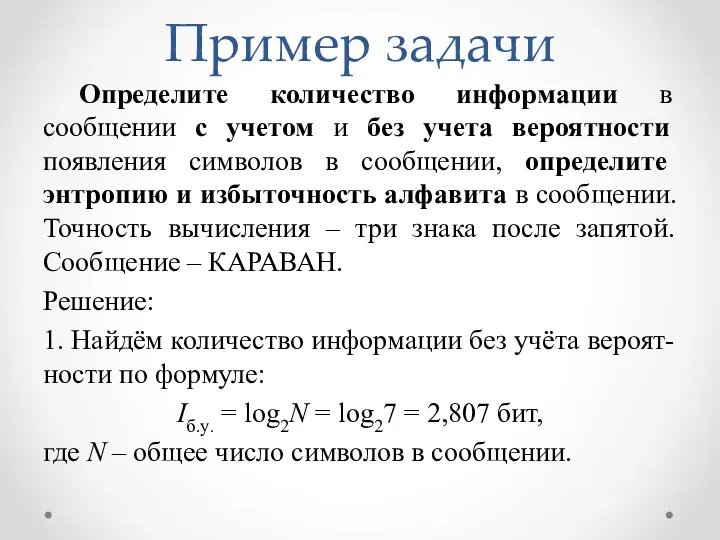

- 19. Пример задачи Определите количество информации в сообщении с учетом и без учета вероятности появления символов в

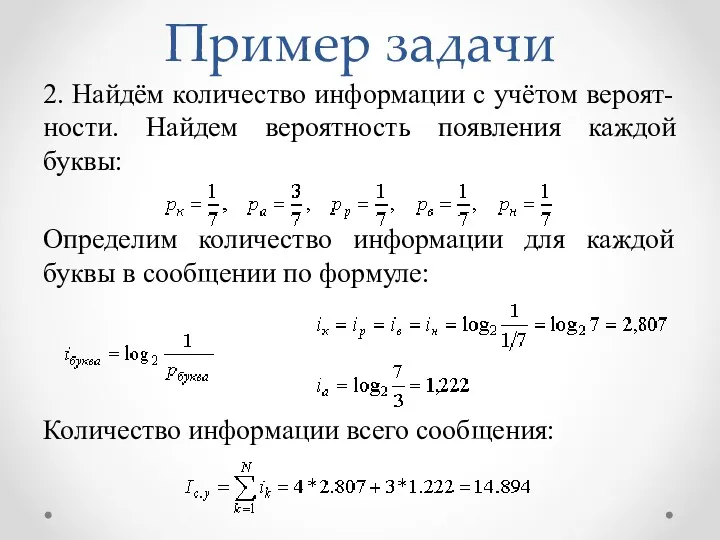

- 20. Пример задачи 2. Найдём количество информации с учётом вероят-ности. Найдем вероятность появления каждой буквы: Определим количество

- 22. Скачать презентацию

Иcтория и направления развития компании Yahoo!

Иcтория и направления развития компании Yahoo! Игровые методы в преподавании информатики

Игровые методы в преподавании информатики Прокси-сервера

Прокси-сервера Мобильді құрылғыларға арналған операциялық жүйелер

Мобильді құрылғыларға арналған операциялық жүйелер Глобальное информационное общество

Глобальное информационное общество Билл Гейтс

Билл Гейтс Регистр

Регистр Анализ алгоритма, содержащего цикл и ветвление

Анализ алгоритма, содержащего цикл и ветвление Компьютерные игры The elder scrolls

Компьютерные игры The elder scrolls Деректер базасының түрлері

Деректер базасының түрлері Урок по теме Устройства компьютера

Урок по теме Устройства компьютера Сокет - бағдарламалық интерфейсі

Сокет - бағдарламалық интерфейсі Методы оптимизации в электронных таблицах

Методы оптимизации в электронных таблицах Дифференцированный подход в изучении физики и информатики

Дифференцированный подход в изучении физики и информатики Электронные таблицы. Работа с формулами

Электронные таблицы. Работа с формулами Автоматическая обработка информации. Машина Поста

Автоматическая обработка информации. Машина Поста Внеклассное мероприятие Король ринга

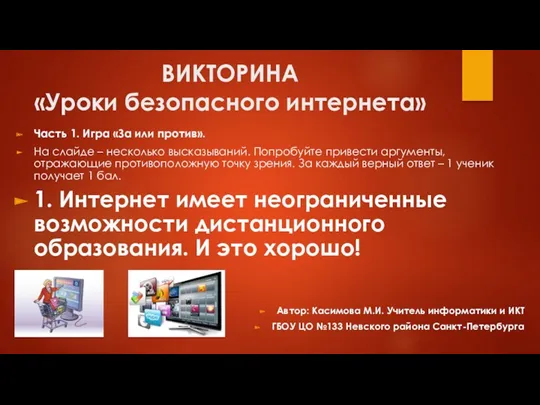

Внеклассное мероприятие Король ринга Уроки безопасного интернета. Викторина

Уроки безопасного интернета. Викторина Методы кодирования. Циклический код. Использование образующих матриц

Методы кодирования. Циклический код. Использование образующих матриц Комп'ютерні мережі та їх призначення. Поняття про мережну взаємодію. Типи комп'ютерних мереж

Комп'ютерні мережі та їх призначення. Поняття про мережну взаємодію. Типи комп'ютерних мереж Введение в операционную систему и виртуализацию

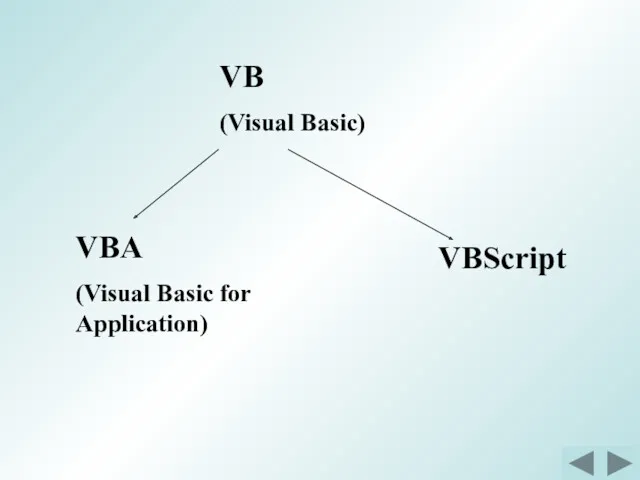

Введение в операционную систему и виртуализацию Общие сведения о VBA

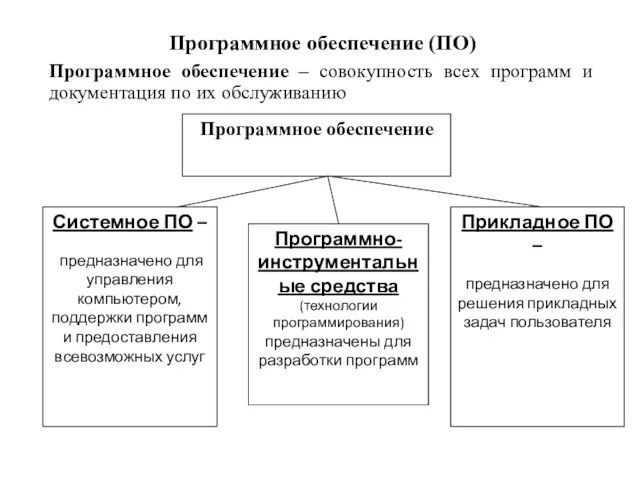

Общие сведения о VBA ПО и ОС Windows

ПО и ОС Windows История компьютера

История компьютера Нормативно-правовые документы и стандарты в области защиты информации и информационной безопасности

Нормативно-правовые документы и стандарты в области защиты информации и информационной безопасности База данных

База данных Програмний комплекс автоматизації центрів надання адміністративних послуг (Інформаційна система Вулик)

Програмний комплекс автоматизації центрів надання адміністративних послуг (Інформаційна система Вулик) От идеи – до результата. О реализации проектов по информационной работе в МГО Профсоюза

От идеи – до результата. О реализации проектов по информационной работе в МГО Профсоюза