Содержание

- 2. 1. Задача консолідації 1.1 Введення 1.2 Джерела даних 1.3 Основні задачі консолідації даних

- 3. 1.1 Введення Цінність і достовірність знань, отриманих в результаті інтелектуального аналізу бізнес-даних, залежить не тільки від

- 4. Визначення_____________________________________ Консолідація – комплекс методів і процедур, спрямованих на вилучення даних з різних джерел, забезпечення необхідного

- 5. 1.2 Джерела даних Ключовим поняттям консолідації є джерело даних – об'єкт, що містить структуровані дані, які

- 6. 1.3 Основні задачі консолідації даних У процесі консолідації даних вирішуються наступні завдання: – вибір джерел даних;

- 7. Визначення____________________________________ Очищення даних – комплекс методів і процедур, спрямованих на усунення причин, що заважають коректній обробці:

- 8. Рис 1. Узагальнена схема процесу консолідації

- 9. Приклад________________________________________ Процес збирання, зберігання та оперативної обробки даних на типовому підприємстві зазвичай містить кілька рівнів. На

- 10. 2 Сховища даних 2.1 Введення в сховища даних 2.2 Передумови появи СД 2.3 Основні особливості концепції

- 11. 2 Сховища даних 2.1 Введення в сховища даних До середини 80-х рр. XX ст. практично повністю

- 12. Визначення____________________________________________________ Транзакція – деякий набір операцій над базою даних, який розглядається як єдине завершене, з точки

- 13. Приклад__________________________________________________________ Типовим прикладом застосування OLTP-систем є масове обслуговування клієнтів, наприклад бронювання авіаквитків або оплата послуг телефонних

- 14. 2.2 Передумови появи СД Наприкінці 90-их з'явилася потреба в інформаційних системах, які дозволяли б проводити глибоку

- 15. Рис 4. Структура інформаційної СППР

- 16. Таблиця 1 - Відмінності СППР і OLTP-систем Вимоги до СППР і OLTP-системам істотно відрізняються Тому в

- 17. 2.3 Основні особливості концепції СД Визначення_______________________________________ Сховище даних – різновид систем зберігання, орієнтована на підтримку процесу

- 18. 2.4 Основні вимоги до СД Вимоги, сформульовані Р. Кімболом: - висока швидкість отримання даних зі сховища;

- 19. 3 Основні концепції сховищ даних 3.1 Основні положення концепції СД 3.2 Задачі, що розв’язує СД 3.3

- 20. 3 Основні концепції сховищ даних 3.1 Основні положення концепції СД Технічний директор компанії Prism Solutions Білл

- 21. Використання концепції СД у СППР і аналізі даних сприяє досягненню таких цілей, як: - своєчасне забезпечення

- 22. 3.2 Задачі, що розв’язує СД Основними завданнями, які потрібно вирішити в процесі розробки СД, є: -

- 23. 3.3 Деталізовані і агреговані дані Дані в СД зберігаються як в деталізованому, так і в агрегованому

- 24. Приклад________________________________________________ Всім добре відомо, що в будь-якій книзі крім власне тексту міститься значну кількість додаткової інформації.

- 25. Визначення___________________________________ Метадані - високорівневі засоби відображення інформаційної моделі та опису структури даних, використовуваної в СД. Метадані

- 26. Можна виділити три основні підходи до використання СД: - регулярні звіти - підготовка звітів стандартних форм,

- 27. 3.6 Короткий огляд архітектури СД Типи архітектур сховищ - реляційні, багатовимірні, гібридні і віртуальні. Реляційні CД

- 28. Багатовимірні СД реалізують багатовимірне представлення даних на фізичному рівні у вигляді багатовимірних кубів. Дана технологія отримала

- 29. 4 Багатовимірні сховища даних 4.1 Основи багатовимірного представлення даних 4.2 Вимірювання і факти – базові поняття

- 30. 4 Багатовимірні сховища даних Призначення багатомірних сховищ даних (БСД) – підтримка систем, орієнтованих на аналітичну обробку

- 31. 4.1 Основи багатовимірного представлення даних Доведено, що реляційна модель не є оптимальною з точки зору завдань

- 32. 4.2 Вимірювання і факти – базові поняття багатовимірної моделі даних В основі багатовимірного подання даних лежить

- 33. 4.3 Структура багатовимірного куба У світло-коричневому околі будуть розташовува-тися факти, що відносяться до продажу цементу індивідуаль-ному

- 34. Фактами в даному випадку можуть бути Ціна, Кількість, Сума. Тоді виділений сегмент буде містити інформацію про

- 35. 4.4 Робота з вимірюваннями У процесі пошуку і вилучення з гіперкубу потрібної інформації над його вимірами

- 36. Транспонування застосовується до плоских таблиць, отриманих, наприклад, у результаті зрізу, і дозволяє змінити порядок стовпчиків і

- 37. 5 Реляційні сховища даних 5.1 Схеми побудови РСД 5.2 Переваги і недоліки РСД

- 38. 5 Реляційні сховища даних Визначення___________________________________________________ Реляційна БД (relational database) – сукупність відношень, котрі містять всю інформацію,

- 39. 5.1 Схеми побудови РСД На логічному рівні розрізняють дві схеми побудови РСД – «зірка» і «сніжинка».

- 40. Основне функціональне відмінність схеми «сніжинка» від схеми «зірка» – це можливість роботи з ієрархічними рівнями, що

- 41. 5.2 Переваги і недоліки РСД Основні переваги РСД: – практично необмежений обсяг збережених даних; – оскільки

- 42. Вибір реляційної моделі при побудові СД доцільний: – Значний обсяг збережених даних (багатовимірні СД стають неефективними).

- 43. 6 Гібридні сховища даних MOLAP (висока продуктивність) + ROLAP (можливість зберігати великі масиви даних) = HOLAP

- 44. Приклад________________________________________ У супермаркеті, щодня обслуговуючому десятки тисяч покупців, встановлено реєстраційну OLTP-систему. При цьому максимальному рівню деталізації

- 45. Якщо дані з OLTP-системи мають великий об'єм (кілька десятків тисяч записів на день і більше) і

- 46. 6.1 Вітрини даних Концепція вітрини даних (data marts) полягає у виділенні профільних даних, найчастіше використовуваних за

- 47. Рис. 13 Консолідація з використанням вітрин даних

- 48. Переваги вітрин даних: – зміст даних, тематично орієнтованих на конкретного користувача; – відносно невеликий обсяг збережених

- 49. Рис. 14 Приклад централізованого СД з вітринами даних

- 50. 7 Віртуальні сховища даних Проблеми, пов’язані з фізичною реалізацією ідеї СД: - Виникає необхідність аналізувати інформацію

- 51. Визначення_____________________________________ Віртуальним сховищем даних називається система, яка працює з розрізненими джерелами даних і емулює роботу звичайного

- 52. Рис. 15 Віртуальне СД

- 53. Недоліки: – Збільшується навантаження на OLTP-систему. – Тимчасова недоступність хоча б одного з джерел може призвести

- 54. Рис. 16 Варіант організації ВС для торгового підприємства

- 55. 8 Введення в ETL 8.1 Основні цілі і задачі ETL 8.2 Вилучення даних у ETL 8.2

- 56. 8 Введення в ETL Витяг даних із різнотипних джерел і перенесення їх в сховище даних з

- 57. Визначення____________________________________ ETL – комплекс методів, що реалізують процес переносу вихідних даних з різних джерел в аналітичний

- 58. 8.1 Основні цілі і задачі ETL ETL-система повинна забезпечувати виконання трьох основних етапів: – Витяг даних

- 59. Рис. 17 Узагальнена структура процесу ETL

- 60. ETL слід розглядати не тільки як процес перенесення даних з одного додатку в інше, але і

- 61. 8.2 Вилучення даних у ETL Процедуру вилучення можна реалізувати двома основними способами. Рис. 19 Витяг даних

- 62. Рис. 20 Витяг даних і засобами тієї системи, в якій вони зберігаються

- 63. Після вилучення дані поміщаються до так званої проміжної області, де для кожного джерела даних створюється своя

- 64. 8.3 Вибір джерел даних, що використовуються Всі джерела можна розділити на дві групи - розташовані в

- 65. 8.4 Особливості організації процесу вилучення даних Приклад_______________________________________________________ Легко уявити, що відвідувач супермаркету зайшов туди раптово: не

- 66. Інший важливий момент - визначення глибини вивантаження даних по часу при первинному заповненні сховища 8.5 Особливості

- 67. Структуровані файли різних форматів. До таких джерел відносяться текстові файли з роздільниками, файли електронних таблиць (наприклад,

- 68. 9 Очищення даних у ETL 9.1 Два рівня очищення даних 9.2 Критерії оцінки якості даних 9.3

- 69. 9 Очищення даних у ETL 9.1 Два рівня очищення даних Первинне очищення даних виконується на етапі

- 70. 9.2 Критерії оцінки якості даних Основний критерій - критичність помилок Три категорії помилок: – дані високої

- 71. 9.3 Основні види проблем у даних, через які вони потребують очищення Рис. 22 Порушення структури даних

- 72. 10 Перетворення даних у ETL 10.1 Перетворення структури даних 10.2 Агрегування даних 10.3 Переклад значень 10.4

- 73. 10 Перетворення даних у ETL 10.1 Перетворення структури даних Мета перетворення даних – підготовка даних до

- 74. У багатьох випадках витягнуті дані непридатні до безпосереднього завантаження в СД через відмінності їх структури від

- 75. 10.2 Агрегування даних Для достовірного опису предметної області використання даних з максимальним рівнем деталізації не завжди

- 76. Типи агрегатів: Середнє; Сума; Максимум; Мінімум; Кількість унікальних значень; Кількість; Медіана Рис. 24 Приклад агрегування

- 77. 10.3 Переклад значень Приклад. Згідно заведеному в організації порядку ідентифікаційний номер операції може бути закодований у

- 78. 10.4 Створення нових даних Приклад. OLTP-система містить інформацію тільки про кількість і ціну проданого товару, а

- 79. 10.5 Очищення даних Очищення – процедура коригування даних, які в будь-якому сенсі не задовольняють визначеним критеріям

- 80. 10.6 Вибір місця для виконання перетворення даних Можливі варіанти: - Перетворення в процесі вилучення даних. На

- 81. 11 Завантаження даних у сховище 11.1 Організація процесу завантаження 11.2 Неповне завантаження даних 11.3 Багатопотокова організація

- 82. 11 Завантаження даних у сховище Процес завантаження полягає в перенесенні даних з проміжних таблиць до структури

- 83. 11.2 Неповне завантаження даних Не завжди дані завантажуються повністю: в завантаженні деяких записів може бути відмовлено.

- 84. Що робити? Послідовність дій: зберегти дані, що не потрапили до СД, у вигляді таблиці або файлу

- 85. Рис. 25 Послідовність дій за наявності відхилених записів у процедурі завантаження у СД

- 86. Що робити у разі повторної невдачі? відновити стан сховища, яким воно було до завантаження (наприклад, за

- 87. 11.3 Багатопотокова організація процесу завантаження даних При черговому завантаженні у СД переноситься не вся інформація із

- 88. Для забезпечення цих функцій завантажувані дані розподіляються по двох паралельних потоках (data flow) - потоку додавання

- 89. 11.4 Операції після операції завантаження З точки зору аналітика, найбільш важливим завданням є верифікація даних. Перш

- 90. Крім того, може виявитися корисним порівнювати дані не тільки в різних розрізах після їх завантаження у

- 91. 12 Завантаження даних з локальних джерел 12.1 Переваги та недоліки відмови від сховищ даних 12.2 Проблеми,

- 92. Це може знадобитися в разі, коли: організація відмовилася від використання СД або коли сховище мається, але

- 93. Частина даних поступає в аналітичну систему через СД з відповідною очісткою і підготовкою, а решта -

- 94. 12.1 Переваги та недоліки відмови від сховищ даних Головна перевага використання СД в аналітичних технологіях -

- 95. Можливі причини відмови від використання СД: 1 Організація не має достатніх ресурсів (фінансових, технічних, кадрових) для

- 96. 12.2 Проблеми, що виникають при прямому доступі до джерел даних Необхідність самостійно визначати тип і формат

- 97. Відсутність автоматичних засобів підтримки цілісності, несуперечності і унікальності даних (при роботі з локальними файлами); Відсутність автоматичних

- 98. 12.3 Переваги використання безпосереднього доступу до джерел даних - Відсутність ETL-процесу знімає проблему «вікна завантаження». Можливість

- 99. Джерела, що найбільш часто зустрічаються, доступ до яких проводиться безпосередньо: текстові файли з роздільниками (TXT, CSV);

- 100. 13 Збагачення даних 13.1 Дані і інформація 13.2 Необхідність збагачення даних

- 101. 13 Збагачення даних 13.1 Дані і інформація Дані - поняття об'єктивне. Вони або реально існують як

- 102. Приступаючи до аналізу даних з метою пошуку прихованих закономірностей і вилучення знань, ми повинні задатися низкою

- 103. 13.2 Необхідність збагачення даних Рис. 29 Збагачення даних

- 104. Визначення. Збагачення даних - процес насичення даних новою інформацією, яка дозволяє зробити їх більш цінними і

- 105. Зовнішнє збагачення припускає залучення додаткової інформації із зовнішніх джерел, що дозволить підвищити цінність і значимість даних

- 106. Внутрішнє збагачення не припускає залучення зовнішньої інформації. У цьому випадку підвищення інформативності й значимості даних може

- 108. Скачать презентацию

Понятие пользовательского интерфейса

Понятие пользовательского интерфейса Мультимедиа

Мультимедиа Разработка и реализация сайта интернет-магазина ювелирных изделий

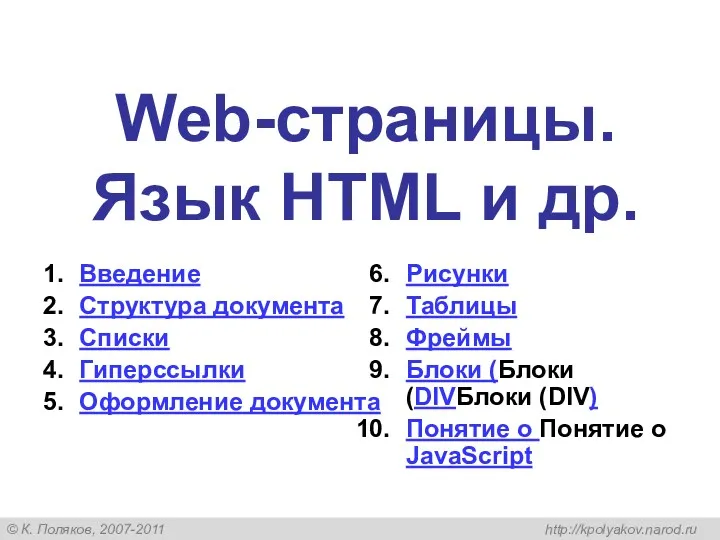

Разработка и реализация сайта интернет-магазина ювелирных изделий Web-страницы. Язык HTML и другие

Web-страницы. Язык HTML и другие Разработка мультимедийного сопровождения для оценки недвижимого имущества

Разработка мультимедийного сопровождения для оценки недвижимого имущества Покадрова анімація. Анімація на основі фотоколажу. Експортування анімації

Покадрова анімація. Анімація на основі фотоколажу. Експортування анімації ЗАСОБИ СТВОРЕННЯ ЕЛЕКТРОННОГО ДОКУМЕНТООБІГУ

ЗАСОБИ СТВОРЕННЯ ЕЛЕКТРОННОГО ДОКУМЕНТООБІГУ Передача информации (технические системы передачи информации)

Передача информации (технические системы передачи информации) Локальные компьютерные сети

Локальные компьютерные сети Всесильна ли логика в познании законов мышления? Теория информации

Всесильна ли логика в познании законов мышления? Теория информации Установка СУФД-портала

Установка СУФД-портала Инструментальные средства разработки программного обеспечения

Инструментальные средства разработки программного обеспечения Відношення між класами і об’єктами. Відношення “is а” та “has a” Солтер, Клепер С++

Відношення між класами і об’єктами. Відношення “is а” та “has a” Солтер, Клепер С++ Требования СНиП к оборудованию компьютерных сетей

Требования СНиП к оборудованию компьютерных сетей Основы программирования (АлгЯзык)

Основы программирования (АлгЯзык) Розроблення програмного забезпечення для приладобудування. Підключення матричної клавіатури

Розроблення програмного забезпечення для приладобудування. Підключення матричної клавіатури Подпрограммы. Выполнение подпрограмм

Подпрограммы. Выполнение подпрограмм Файли в мові С

Файли в мові С Презентация по информатике

Презентация по информатике VR/AR технологии в играх

VR/AR технологии в играх Сравнительный анализ дизайна интернет-сайтов

Сравнительный анализ дизайна интернет-сайтов Понятие Алгоритм и Формы его записи. Исполнители алгоритмов

Понятие Алгоритм и Формы его записи. Исполнители алгоритмов Базы данных и экспертные системы. (Лекция 1)

Базы данных и экспертные системы. (Лекция 1) How to create an app. Mobile App Development Company

How to create an app. Mobile App Development Company Тестирование программного обеспечения

Тестирование программного обеспечения Оформление списка литературы к научной работе

Оформление списка литературы к научной работе Классный час: Дети в ...Интернете

Классный час: Дети в ...Интернете Характеристики интернет-коммуникаций. Мультимедия

Характеристики интернет-коммуникаций. Мультимедия