Слайд 2

Oracle Real Application Clusters

Управление кластерами БД как сетью распределенных вычислений

предприятия осуществляется за счет использования интегрированного кластерного программного обеспечения (integrated clusterware). Это программное обеспечение представляет собой набор общих сервисов по обслуживанию кластеров, встроенных в Oracle Database 10g с целью облегчить создание кластеров базы данных и управление ими. Решение Oracle Real Application Clusters 10g также включает новое программное обеспечение для управления рабочей нагрузкой кластеров, предназначенное для перераспределения вычислительных возможностей компонентов кластерной базы данных, как только это потребуется для решения бизнес-задач.

Слайд 3

Включены усовершенствованные возможности автоматизированного управления и новая консоль Database Control с

web-интерфейсом.

Database Control представляет собой диагностический монитор, отображающий в графическом виде текущее состояние функционирующей базы данных. Администраторы могут проводить профилактический мониторинг баз данных и быстро получать предупреждения и рекомендации с целью обеспечения оптимальной производительности и надежности работы систем.

Консоль Database Control может даже выявить неудачно написанный фрагмент кода приложения, предложить лучший вариант и автоматически настроить базу данных для обеспечения оптимальной производительности.

Можно проводить диагностику производительности, настройку приложений и управление распределением памяти.

Слайд 4

Oracle Database 10g включает также модуль автоматического

управления хранилищем данных (Automatic Storage

Management, ASM) – ПО, предназначенное для упрощения конфигурирования системы хранения данных и управления базами данных.

Модуль ASM автоматически реализует взаимодействие базы данных с файлами данных и подсистемами хранения данных, распределяет нагрузку на систему хранения данных, исключает необходимость постоянного мониторинга систем хранения данных для поиска «точек повышенной загрузки» и «узких мест», которые снижают скорость обработки данных; упрощает структуру информационного центра и снижает расходы на управление системой. Oracle сотрудничает с компаниями-разработчиками промышленных систем хранения данных, такими, как EMC, Hitachi, HP, Network Appliance и Xiotech, для обеспечения совместной работы модуля ASM с сетевыми устройствами хранения данных и сетями хранилищ данных, предлагаемыми этими компаниями.

Слайд 5

СУБД Oracle 10g для Linux-кластеров обладает высокой масштабируемостью, что было доказано

на вычислительных комплексах с 32 и более узлами. Как выяснилось, не существует принципиальных технологических барьеров для увеличения числа узлов в кластерах. RAC обеспечивает высокую степень утилизации ресурсов, причем на недорогих blade-фермах.

Технология Oracle RAC основана на архитектуре с разделяемым диском (shared disk architecture), что отличает ее от СУБД других производителей, которые строятся на принципиальной иной архитектуре (shared nothing architecture). Данные в такой архитектуре искусственно разнесены по сегментам базы данных. При добавлении новых blade-серверов все данные нужно заново сегментировать, чтобы перенести часть из них на новые серверы. Аналогично, когда нужно изъять из системы blade-серверы, данные тоже приходится предварительно сегментировать.

Слайд 6

Слайд 7

Модуль Oracle Transportable Tablespaces обеспечивает пользователей сети распределенных вычислений чрезвычайно быстрым

механизмом перемещения подмножества данных из одной базы данных Oracle в другую, позволяет выделять фрагменты баз данных Oracle, переносить или копировать их в другое место, а затем присоединять к другой базе данных. Перемещение фрагментов данных заключается лишь в считывании или записи небольшого количества метаданных. Кроме того, Transportable Tablespaces может одновременно составлять таблицы «только для чтения» из двух или более баз данных.

Слайд 8

Модуль Oracle Streams позволяет распространять данные среди баз данных, узлов или

ферм blade-серверов сети распределенных вычислений. Он создает унифицирован-ную структуру для распространения данных, формирования очередей сообщений, репликации, управления событиями, загрузки данных в хранилище, оповещений и публикации/ подписки в рамках единой технологии. Oracle Streams может синхронизировать одновременно две или более копии баз данных по мере их обновления. Модуль автоматически регистрирует изменения в базе данных, распространяет эти изменения в узлы, которые подписаны на получение этих изменений, реализует их; а также обнаруживает и разрешает возможные конфликты по данным. Модуль может использоваться приложениями и непосредственно для организации очередей сообщений, обеспечивающих связь между приложениями в пределах сети распределенных вычислений.

Слайд 9

Модули Distributed SQL и Distributed Transactions

С помощью модуля Oracle Distributed SQL

пользователи сети распределенных вычислений могут эффективно получать и объединять данные, хранящиеся в различных базах данных Oracle и базах данных других производителей. Прозрачный удаленный доступ к данным посредством Distributed SQL позволяет приложениям работать с любой другой базой данных без внесения каких-либо изменений в код программ. В процессе интеграции данных из нескольких источников СУБД Oracle оптимизирует планы исполнения запросов. Кроме того, СУБД Oracle автоматически выполняет транзакции с данными из нескольких источников. Функция Oracle XA позволяет пользователям сети распределенных вычислений координировать выполнение транзакций, затрагивающих несколько баз данных.

Гетерогенный доступ посредством механизмов Transparent Gateways

Слайд 10

В данную группу включены следующие продукты:

Oracle Open System Gateways –

подгруппа продуктов (шлюзов), обеспечивающих доступ (посредством SQL) к данным, хранящимся в отличных от Oracle базах данных на всех платформах открытых систем. В настоящий момент поддерживается доступ к следующим базам данных: MS SQL Server, Sybase, Rdb, Ingres, Informix, Teradata, RMS

Mainframe Integration Gateways – подгруппа продуктов (шлюзов), обеспечивающих доступ к СУБД DB2 на мэйнфреймах.

Replication Services (сервисы репликации), обеспечивающие репликацию данных из БД Oracle в «чужие» базы данных (равно как и из «чужих» баз данных в БД Oracle). Для репликации используются прозрачные шлюзы.

Enterprise Integration Gateways – включает шлюзы к СУБД DB2 для платформы AS/400 (DB2/400) и шлюз к системам IBM DRDA, а также Procedural Gateways (процедурные шлюзы),

Слайд 11

Procedural Gateways (процедурные шлюзы), обеспечиваю-щие обработку вызовов удаленных процедур, причем удаленные

процедуры определены и выполняются в отличной от Oracle программной системе. В эту подгруппу включен и Access Manager (менеджер доступа), основным назначением которого является поддержка доступа «чужих» приложений посредством языка запросов SQL к базам данных Oracle.

Пользователи СРВ могут применять функции планирования работ в СУБД Oracle. Функции управления очередями заданий (jobs) обеспечивает гибкий механизм планирова-ния задач СУБД. Задания можно выполнять в определен-ное время и с определенными временными интервалами. Имеется возможность указать максимальное число про-цессов, которое будет использоваться для выполнения заданий. При использовании OracleReal Application Cluster 10g можно направить задание на любой из доступных узлов для исполнения соответствующим экземпляром Oracle Database.

Слайд 12

Oracle Resource Manager позволяет администраторам ресурсов ограничивать ресурсы СУБД Oracle, выделяемые

пользователям сети. Функция управления ресурсами гарантирует, что каждый пользователь сети получит долю имеющихся вычислительных ресурсов в соответствии с их (пользователей) приоритетами

Стандартная среда сети распределенных вычислений

Комплект инструментов Oracle Globus содержит набор компонентов, которые можно использовать для создания приложений СРВ, а также инструменты программирования.

Комплект Globus стал де-факто стандартом среды разработки СРВ.

Oracle Globus Development Kit (OGDK) содержит сценарии для эффективного использования технологии Oracle с комплектом инструментов Globus.

Слайд 13

Доступ через СРВ к Oracle10g Utilities

Модуль Globus Resource Allocation Manager (GRAM)

обеспечивает выделение ресурсов, создание и мониторинг процессов, а также управление ими. GRAM преобразуют запросы на языке Resource Specification Language (RSL) в команды, понятные локальным планировщикам. Применяя эту функцию, пользователи СРВ могут удаленно задействовать такие утилиты Oracle, как export, import и sqlplus, для выполнения необходимых действий в Oracle Database 10g. Этот механизм можно использовать для настройки удаленных баз данных в сети распределенных вычислений. Доступ через СРВ к Oracle10g Database

OGDK использует модуль Globus GRAM для исполнения программ PL/SQL или команд SQL, описанных в Globus RSL. Он может применяться и для передачи заданий планиров-щику Oracle через API PL/SQL планировщика, вследствие чего пользователи сети могут выполнять задачи на удален-ных базах данных, планировать и контролировать их испол-нение.

Слайд 14

Служба информации о ресурсах сети (GRIS) для Oracle Database

Служба информации о

ресурсах сети распределенных вычислений (GRIS), входящая в комплекс инструментов Globus, предоставляет информацию для контроля за ресурсами сети распределенных вычислений и их обнаружения. Эта функция позволяет пользователям сети распределенных вычислений обнаруживать базы данных Oracle и проверять их. GRIS для Oracle Database отображает атрибуты и свойства базы данных, которые могут потребоваться пользователям сети распределенных вычислений.

Слайд 15

Универсальность Oracle по отношению к операционным системам и оборудованию означает, что

все продукты семейства Oracle 10g способны поддерживать неоднородные СРВ, которые, как известно, позволяют использовать любое имеющееся оборудование, а не только оборудование одного производителя.

Oracle 10g может работать как в конфигурациях СРВ, так и вне их, так что можно, например, взять приложение, разработанное для SMP-систем, и перенести его в инфраструктуру СРВ.

Oracle 10g работает на всех популярных операционных системах, причем обеспечивает одни и те же функции и возможности, так как базовый код остается тем же. Универсальность Oracle означает, что, в каком бы направлении ни развивалась сеть распределенных вычислений, какая бы операционная система в ней ни доминировала, Oracle 10g все равно будет работать в этой сети.

Слайд 16

Утилизация простаивающих ресурсов – один из примеров применения СРВ. Идея утилизации

неиспользуемых ресур-сов тысяч персональных компьютеров, простаивающих каждую ночь, чрезвычайно привлекательна. У такого решения огромный потенциал. Особенно популярно оно среди ученых: при значительной нехватке средств им приходится решать параллельные задачи. Типичным примером СРВ является центральный сервер, распределяющий работу между большим числом небольших компьютеров. Этот же сервер собирает и систематизирует результаты расчетов. И все же у такой модели СРВ много ограничений. Главная проблема в том, что ресурсы – простаивающие персональные компьютеры – часто выходят из-под административного контроля тех, кто ими пользуется. Степень готовности и надежности распределенных ресурсов ограничена, что чрезвычайно затрудняет планирование вычислений.

Слайд 17

Кроме того, слабость или отсутствие модели доверия (trust model) в таких

СРВ препятствуют их использованию для обработки какой бы то ни было конфиденциальной или частной информации. Наконец, класс приложений, допускающих распараллеливание, весьма ограничен, что минимизирует преимущества таких сетей распределенных вычислений для многих организаций.

Тем не менее утилизация ресурсов посредством сети распределенных вычислений успешно применяется для решения сложных проблем. Примером такой реализации сети распределенных вычислений можно считать проект SETI@home, в котором свободные компьютеры, подключенные к интернету, обрабатывают данные радиотелескопа с целью поиска признаков существования внеземных цивилизаций.

Слайд 18

Разделение ресурсов – еще один способ реализации сети распределенных вычислений. Внедрив

сеть распределенных вычислений с разделением ресурсов, организации смогут задействовать недоиспользуемые ресурсы в пределах одного или нескольких предприятий. Участники такой сети распределенных вычислений получают возможность легко обмениваться вычислительными ресурсами и данными, перемещая приложения и информацию по сети распределенных вычислений с тем, чтобы задействовать свободные ресурсы.

В результате создается умеренное число средних и крупных узлов, которые могут относиться к одному административному домену или охватывать несколько административных доменов. Планировщики сети распределенных вычислений следят за наличием свободных ресурсов и должным образом распределяют их.

Слайд 19

Для внедрения сети распределенных вычислений такого типа многие заказчики применяют технологию

Oracle. CERN выбрал технологических партнеров для реализации проекта сети распределенных вычислений LHC (Большой Адронный Коллайдер), которая позволит тысячам физиков во всем мире анализировать петабайты распределенных данных об элементарных частицах. Одним из участников проекта является компания Oracle с программными продуктами Oracle Database 10g и Oracle Application Server 10g, отвечающие требованиям сети распределенных вычислений LHC. Oracle Database 10g гарантирует масштабируемость, разделение информации и функции поддержки сверхбольших баз данных (VLDB), необходимые тысячам пользователей для обмена данными в рамках сети распределенных вычислений LHC. Oracle Transportable Tablespaces обеспечит CERN быстродействующим механизмом распределения больших объемов данных между множеством узлов.

Слайд 20

Значительное количество администрируемых доменов, организационные барьеры, проблемы доверия и интенсивное перемещение

данных между узлами сети ставят под вопрос для многих организаций эффективность подхода разделения ресурсов

Сеть распределенных вычислений с выделением ресурсов решает эти проблемы за счет создания централизованных пулов вычислительных ресурсов, которые могут предоставляться всем приложениям-участникам.

Слайд 21

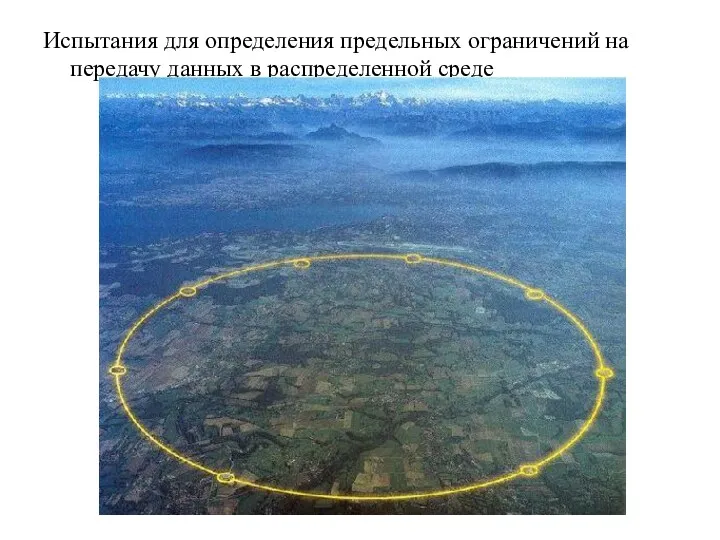

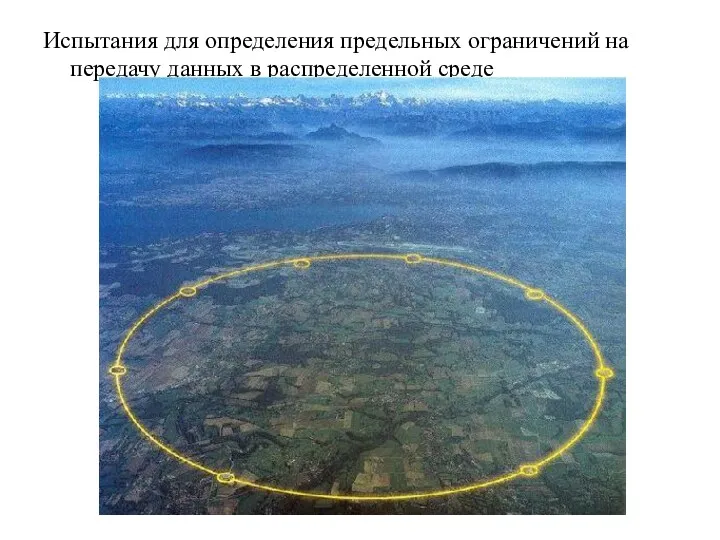

Испытания для определения предельных ограничений на передачу данных в распределенной среде

Слайд 22

Сотрудники Центра ядерных исследований CERN совершили масштабные испытания распределенной компьютерной сети

Солидного адронного коллайдера (БАК), наибольшего ускорителя элементарных частиц. Основной задачей нынешних испытаний было узнать предельные ограничения на передачу данных в распределенной среде. На протяжении опыта Scale Testing for the Experiment Programme ’09 объемные массивы данных передавались между вычислительными узлами, расположенными в разных государствах. В Европе сейчас насчитывается 11 вычислительных узлов, соединенных выделенными волоконно-оптическими каналами. Эти узлы передают информацию на обработку еще в 140 центров 33 государств. Ян Берд, начальник компьютерного подразделения CERN, сказал, что тестирование прошло удачно, и мощностей телекоммуникационной инфраструктуры хватит с запасом. Скорость передачи данных по сетевым каналам на момент запуска БАК составит 1,3 Гбайт/с. Во время испытаний удалось достичь скорости в 4 Гбайт/с.

Слайд 23

Грид-вычисления ( grid — решётка, сеть) — это форма распределенных вычислений, в которой «виртуальный

суперкомпьютер» представлен в виде кластеров, соединённых с помощью сети, слабосвязанных гетерогенных компьютеров, работающих вместе для выполнения огромного количества заданий (операций, работ). Эта технология применяется для решения научных, математических задач, требующих значительных вычислительных ресурсов. Грид-вычисления используются также в коммерческой инфраструктуре для решения таких трудоёмких задач, как экономическое прогнозирование, сейсмоанализ, разработка и изучение свойств новых лекарств.

Грид с точки зрения сетевой организации представляет собой согласованную, открытую и стандартизованную среду, которая обеспечивает гибкое, безопасное, скоординированное разделение вычислительных ресурсов и ресурсов хранения информации, которые являются частью этой среды, в рамках одной виртуальной организации

Слайд 24

Технология GRID используется для реализации географически распределенной вычислительной и информационной среды,

которая объединяет в единую инфраструктуру ресурсы различных типов и обеспечивает коллективный доступ к этим ресурсам В классической реализации GRID фокусируется на обеспечении распределенных вычислений в фиксированной среде с заданной конфигурацией. Основное решение – объедине-ние ресурсов в межпрограммном слое. Необходимо создавать специальную инфраструктуру GRID вследствие сложности установки, поддержки, управления, масштабирования GRID-сети, функциональных ограничений программного обеспечения.

Одна из современных задач развития GRID это общедоступность и расширение области ее использования, что требует значительного уменьшения сложности ее установки и поддержки

Слайд 25

В настоящее время выделяют три основных типа грид-систем:

Добровольные гриды — гриды

на основе использования добровольно предоставляемого свободного ресурса персональных компьютеров;

Научные гриды — хорошо распараллеливаемые приложения программируются специальным образом (например, с использованием Globus Toolkit);

Гриды на основе выделения вычислительных ресурсов по требованию (коммерческий грид, enterprise grid) — обычные коммерческие приложения работают на виртуальном компьютере, который, в свою очередь, состоит из нескольких физических компьютеров, объединённых с помощью грид-технологий.

Слайд 26

Общедоступная GRID должна обеспечивать предоставление по требованию инфраструктуры и приложений, ориентированных

на использование высоких технологий во всех сферах деятельности человеческого сообщества - медицина, электронные медиа, инженерная сфера, обеспечение коммуникаций для электронного бизнеса и тому подобное для широкого слоя пользователей в хорошо защищенной, общедоступной, расширяемой и стандартизированной компьютерной среде через Промежуточное программное обеспечение GRID, поддерживающее массовое распространение, должно обладать многими свойствами инфраструктуры «по требованию». Оно должно быть разделяемым между разными пользователями, предоставлять стандартизиро-ванные службы и протоколы связи, а также быть гибким и расширяемым. Вычислительная парадигма современной GRID строится вокруг основной цели: предоставлять ресурсы столь же легко, как электричество через сеть.

Слайд 27

Предъявляемые требования к интеграции и интероперабель-ности большого количества приложений, обусловили развитие

технологии GRID в направлении открытой архитектуры OGSA (Open Grid Services Architecture).

Объединение GRID и соответствующих стандартов WEB-служб - большой шаг в направлении уменьшения сложности использования, управления и поддержки GRID. Использование стандарта WSRF, который является низкоуровневым описанием инфраструктуры, реализации модели OGSA, предлагает возможность предоставлять низкоуровневую виртуализацию доступных ресурсов, что значительно повышает универсальность GRID.

Основной идеей сегодняшней GRID становиться формирование динамической среды, состоящей из взаимодействующих неоднородных вычислительных узлов, без определенной фиксированной инфраструктуры и с минимальными административными требованиями.

Слайд 28

Мобильные GRID

Наиболее актуальные современные исследования в области GRID посвящены необходимости

решения проблемы совместимости GRID и мобильных сетей.

Использование беспроводных устройств, которые имеют достаточно ограниченные ресурсы вычислительной мощности, энергии, адресного пространства, накладывают существенные ограничения при решении вычислительных заданий повышенной ресурсоемкости и хранения больших объемов данных, однако за счет привлечения дополнительных ресурсов, доступных при сочетании с GRID, такое использование вполне возможно. Более того использование мобильных GRID позволило бы обеспечить применение приложений GRID в тех местах где это можно лишь представить, а в будущем технология GRID могла бы

войти в набор обычных услуг для мобильных пользователей

Слайд 29

Мобильные GRID характеризуется динамической структурой и допускают перемещение как пользователей GRID,

так и запрашиваемых ресурсов. Узлы мобильных GRID не является кластерами или супер-компьютерами, это произвольный диапазон мобильных устройств с гетерогенными свойствами: вычислительный ресурс процессора, объем памяти, пропускная способность каналов связи, задержка. Кроме того, мобильная сеть подвержена проблемам разрыва связей и выхода узлов из строя или перемещения за пределы досягаемости. Мобильные узлы имеют гетерогенное время выполнения подзадачи, и могут останавливать вычисление произвольно в случае непредвиденного перемещения. В связи с этим совместное выполнение задания временно откладывается, и возникают проблемы реконфигурации, репликации, резервирования данных, и тому подобное.

Слайд 30

Такие нестабильные ситуации называются автономными отказами, они приводят к задержке и

блокировке выполнения подзадач и как следствие к частичной или полной потере результатов выполнения задания. Отмеченные проблемы осложняют планирование и управление выполняемыми подзадачами.

Таким образом, характеристики и особенности мобильных GRID обуславливают необходимость разработки стратегий управления и механизмов планирования которые бы адаптировались к динамической вычислительной среде.

Слайд 31

Тенденции

·тенденции в области компьютерных платформ:

Каждый производитель компьютерной платформы либо анонсировал,

либо уже поставляет так называемые blade-серверы (blade servers). Они обеспечивают самую дешевую вычислительную мощность – иногда на 80% дешевле той, что дают системы на основе симметричной многопроцессорной обработки (SMP). Blade-серверы легко составляются в blade-фермы (blade farms), которые представляют собой самую эффективную и масштабируемую разновидность недорогой вычислительной системы. Теперь blade-фермы оснащаются каналами межкомпьютерного взаимодействия (interconnects), что превращает их в кластеры – самую экономически эффективную форму недорогих вычислительных комплексов. Эти кластеры, скорее всего, станут архитектурой вычислительной техники будущего.

Слайд 32

· тенденции в области операционных систем:

В сфере программного обеспечения Linux

опережает по темпам роста популярности другие операционные системы. Linux пока нельзя масштабировать до крупной SMP-системы. Но на blade-серверах, оснащенных несколькими недорогими процессорами, Linux работает отлично. Экономические преимущества blade-серверов перед SMP-системами обеспечивают первым доминирование, а так как Linux уже сейчас является ключевой операционной системой для blade-серверов, это еще сильнее ускоряет распространение Linux. Наконец, у Linux есть ценовое преимущество, которое приобретает все большее значение по мере роста числа blade-серверов, что опять-таки способствует распространению этой ОС. И вполне естественно, что недорогие кластеры хорошо сочетаются с недорогой операционной системой Linux.

Слайд 33

· виртуализация:

Виртуализация – один из самых модных сегодня терминов как

в индустрии программного обеспечения, так и в индустрии аппаратуры. Нет ничего более виртуального, чем коммунальные услуги. Множество поставщиков стараются доказать, что их новая стратегия состоит в виртуализации или коммунальных вычислениях, – а это именно то, что характерно для сети распределенных вычислений. С большой долей вероятности можно утверждать, что скоро все они возьмут на вооружение сети распределенных вычислений.

Презентация, задание к уроку, домашнее задание к уроку информатики в 5 классе по теме Основная позиция пальцев на клавиатуре

Презентация, задание к уроку, домашнее задание к уроку информатики в 5 классе по теме Основная позиция пальцев на клавиатуре Компьютерные сети

Компьютерные сети Методы и средства защиты в технических каналах

Методы и средства защиты в технических каналах Основные понятия языка. Лекция 2

Основные понятия языка. Лекция 2 Формы. Настройка внешнего вида формы

Формы. Настройка внешнего вида формы Проблемы применения инновационных технологий в сельском хозяйстве

Проблемы применения инновационных технологий в сельском хозяйстве Лига юных журналистов Воронежа. Годовой отчёт

Лига юных журналистов Воронежа. Годовой отчёт Базы данных. Информационные системы

Базы данных. Информационные системы Математическая логика (Булева алгебра)

Математическая логика (Булева алгебра) Передача информации

Передача информации Кибербуллинг

Кибербуллинг Выбор современного журналиста: текст или жанр

Выбор современного журналиста: текст или жанр Особенности автоматизации бухгалтерского учета

Особенности автоматизации бухгалтерского учета Операционные системы. (11 класс)

Операционные системы. (11 класс) Режимы и способы обработки данных

Режимы и способы обработки данных Типы данных SQL

Типы данных SQL Разработка автоматизированной системы заказа такси онлайн

Разработка автоматизированной системы заказа такси онлайн Компьютерная презентация в PowerPoint. Начальное знакомство

Компьютерная презентация в PowerPoint. Начальное знакомство Эволюция и классификация языков программирования. Основные понятия языков программирования. Компиляция и интерпретация

Эволюция и классификация языков программирования. Основные понятия языков программирования. Компиляция и интерпретация Компьютерные сети

Компьютерные сети Слагаемые телевизионного репортажа

Слагаемые телевизионного репортажа Технологии программирования (методы программирования)

Технологии программирования (методы программирования) Информационные ресурсы и сервисы интернета

Информационные ресурсы и сервисы интернета Организация ИТ-инфраструктуры предприятий

Организация ИТ-инфраструктуры предприятий Интерактивная игра по теме Компьютерная графика

Интерактивная игра по теме Компьютерная графика Путешествие по острову Инфорландия

Путешествие по острову Инфорландия Внеклассное мероприятие Спаси компьютер от вируса

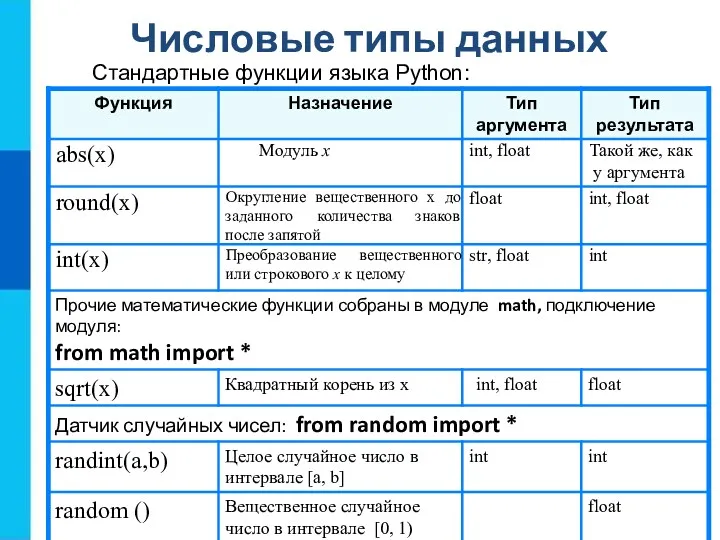

Внеклассное мероприятие Спаси компьютер от вируса Числовые типы данных. Стандартные функции языка Python

Числовые типы данных. Стандартные функции языка Python