Содержание

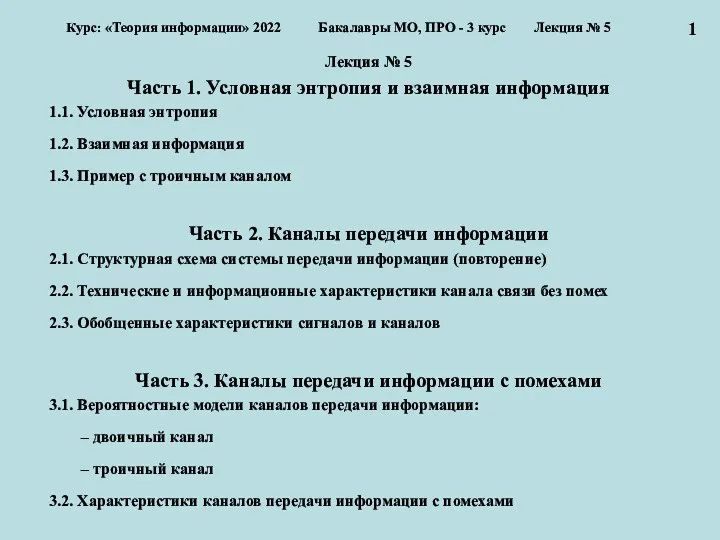

- 2. Лекция № 5 Часть 1. Условная энтропия и взаимная информация 1.1. Условная энтропия 1.2. Взаимная информация

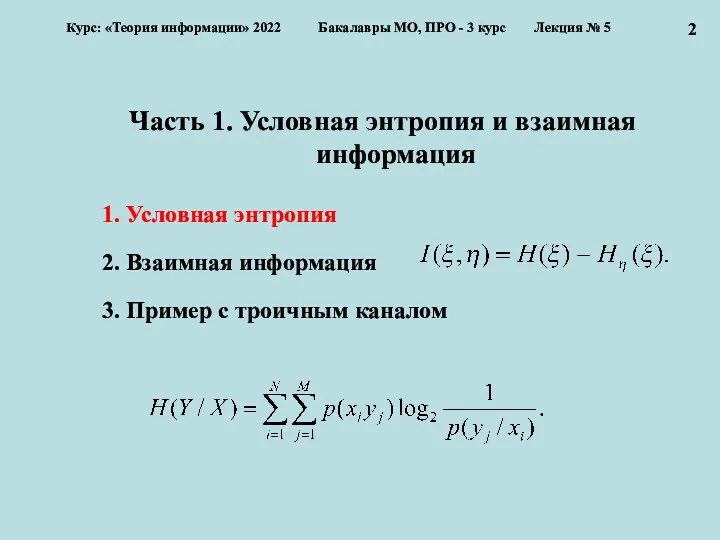

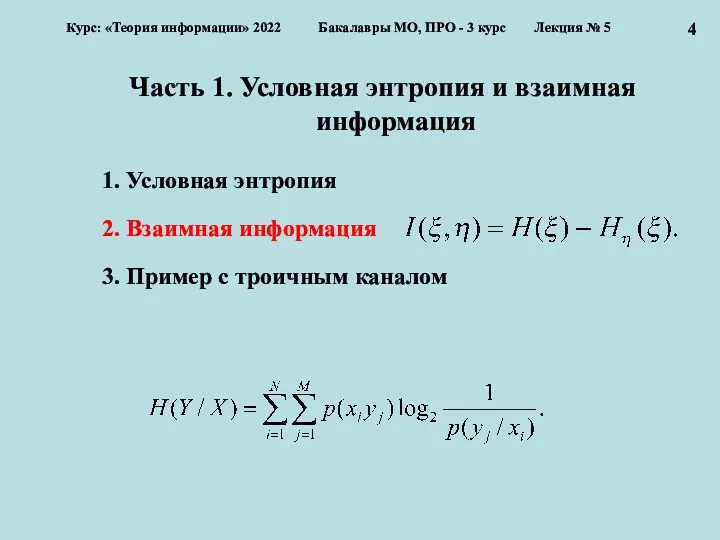

- 3. Часть 1. Условная энтропия и взаимная информация 1. Условная энтропия 2. Взаимная информация 3. Пример с

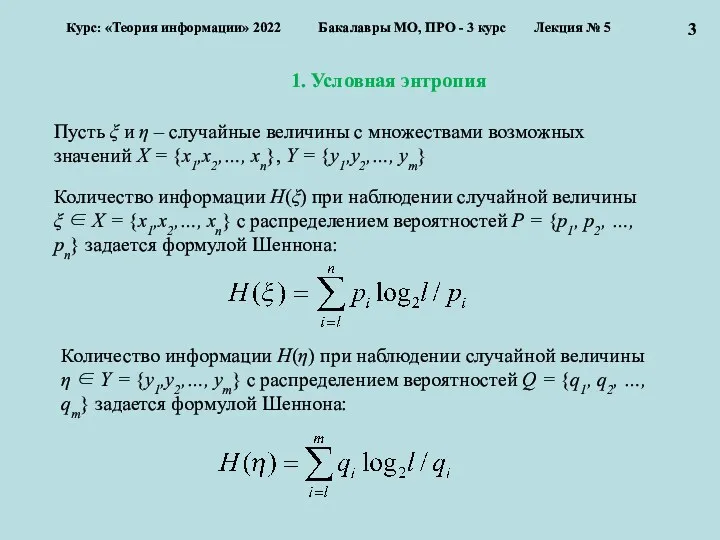

- 4. 1. Условная энтропия Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3 курс Лекция № 5

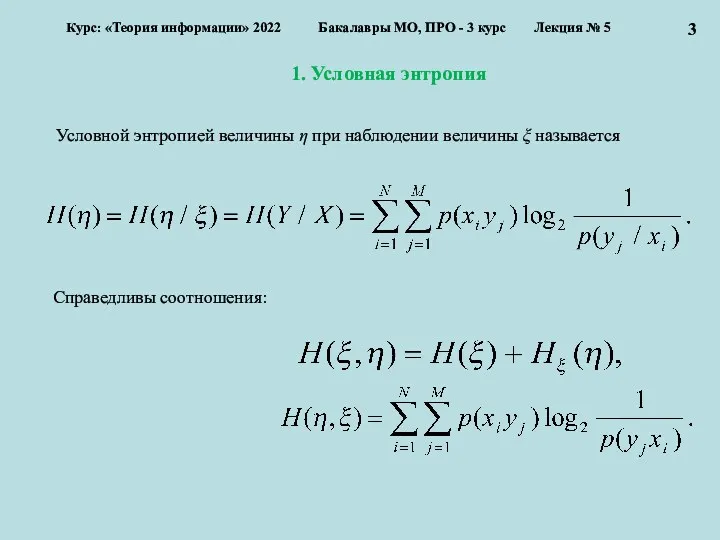

- 5. 1. Условная энтропия Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3 курс Лекция № 5

- 6. Часть 1. Условная энтропия и взаимная информация 1. Условная энтропия 2. Взаимная информация 3. Пример с

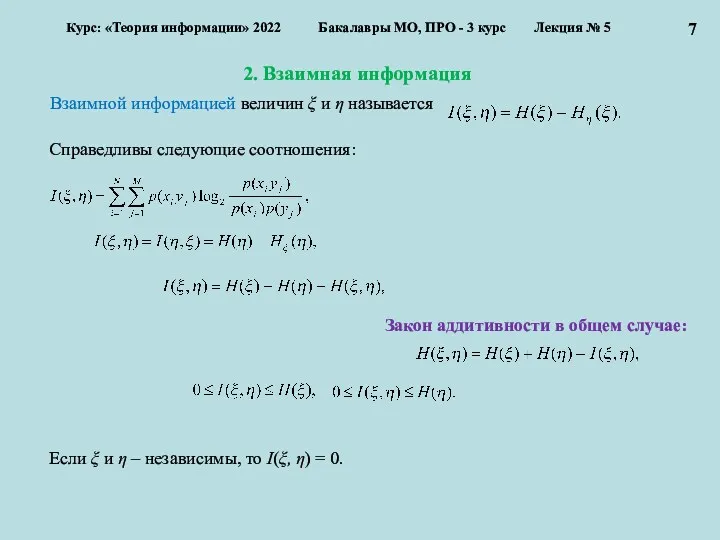

- 7. 2. Взаимная информация Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3 курс Лекция № 5

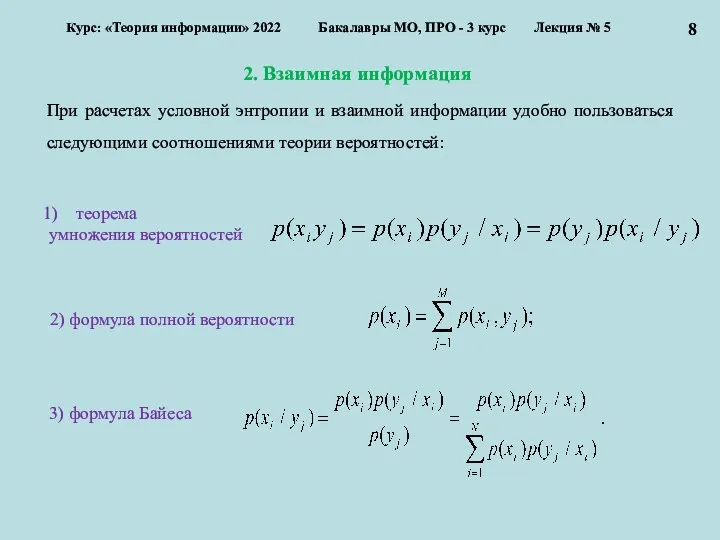

- 8. 2. Взаимная информация Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3 курс Лекция № 5

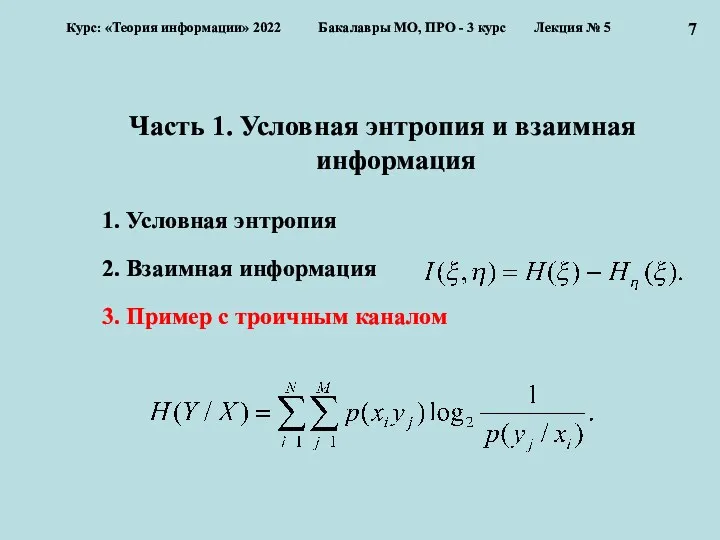

- 9. Часть 1. Условная энтропия и взаимная информация 1. Условная энтропия 2. Взаимная информация 3. Пример с

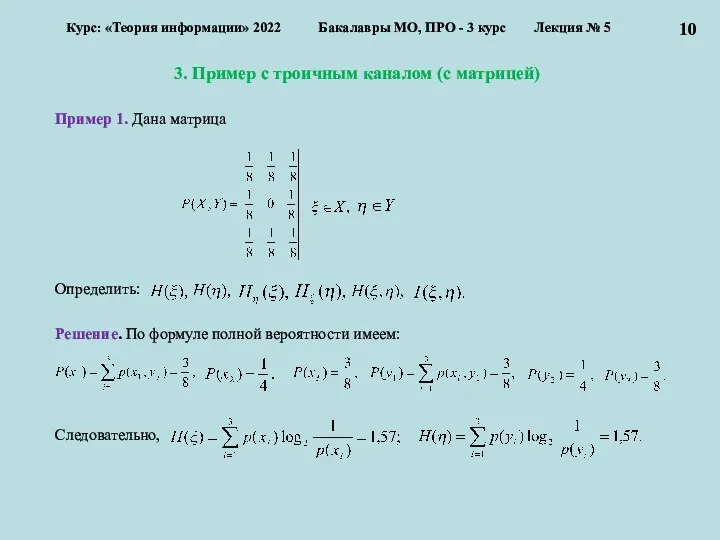

- 10. 3. Пример с троичным каналом (с матрицей) Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3

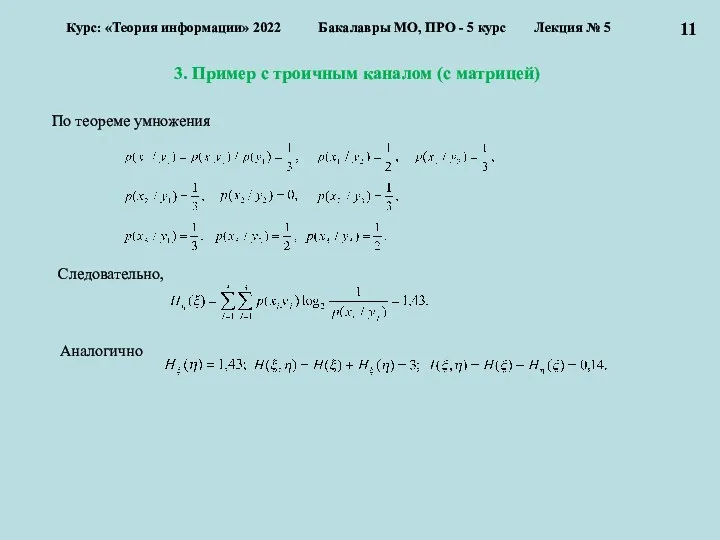

- 11. 3. Пример с троичным каналом (с матрицей) Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 5

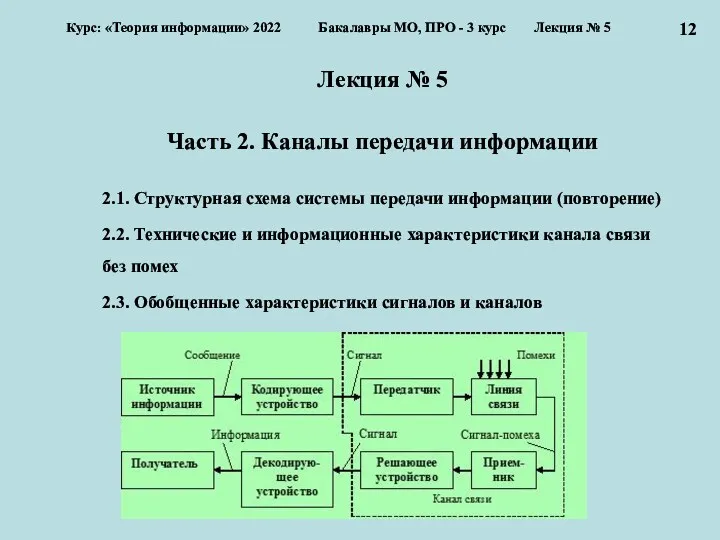

- 12. Лекция № 5 Часть 2. Каналы передачи информации 2.1. Структурная схема системы передачи информации (повторение) 2.2.

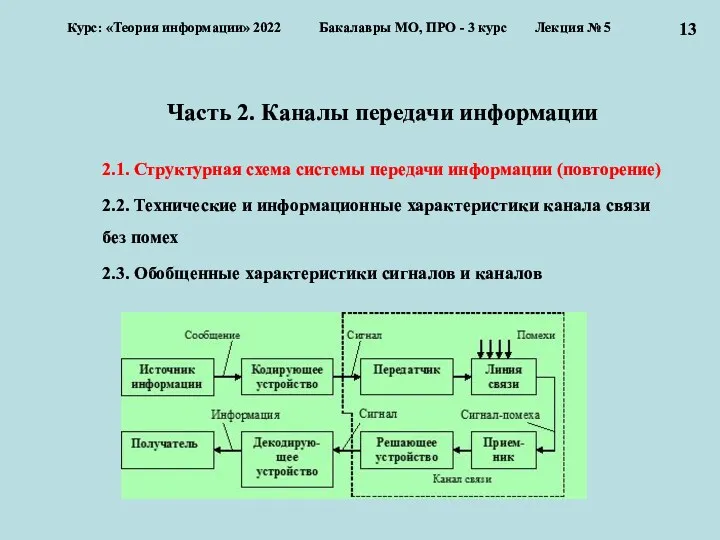

- 13. Часть 2. Каналы передачи информации 2.1. Структурная схема системы передачи информации (повторение) 2.2. Технические и информационные

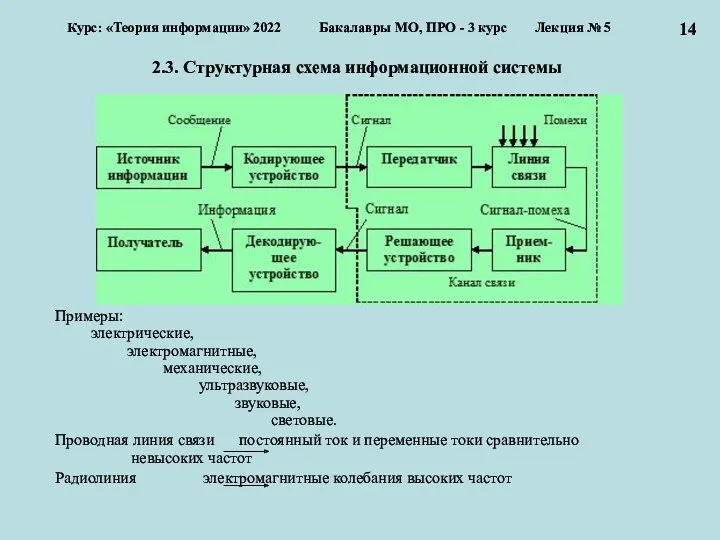

- 14. 2.3. Структурная схема информационной системы Примеры: электрические, электромагнитные, механические, ультразвуковые, звуковые, световые. Проводная линия связи постоянный

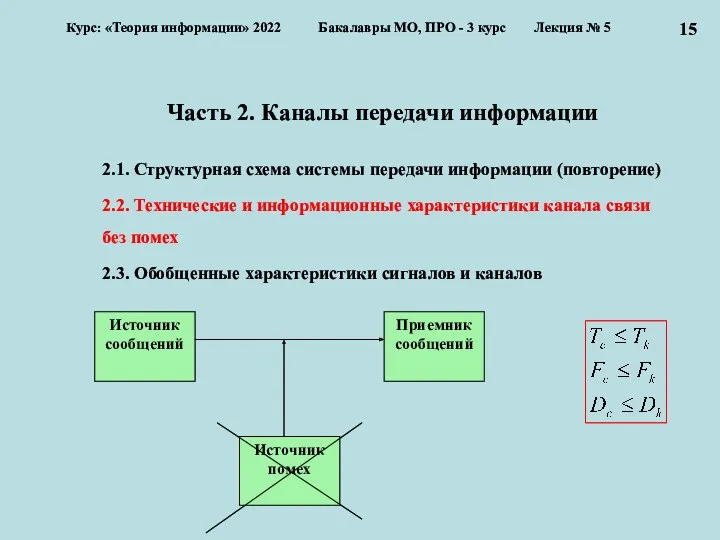

- 15. Часть 2. Каналы передачи информации 2.1. Структурная схема системы передачи информации (повторение) 2.2. Технические и информационные

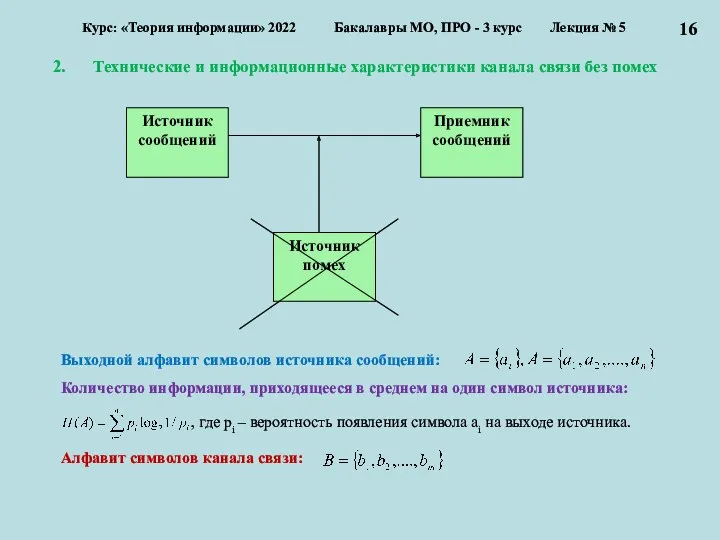

- 16. Технические и информационные характеристики канала связи без помех Курс: «Теория информации» 2022 Бакалавры МО, ПРО -

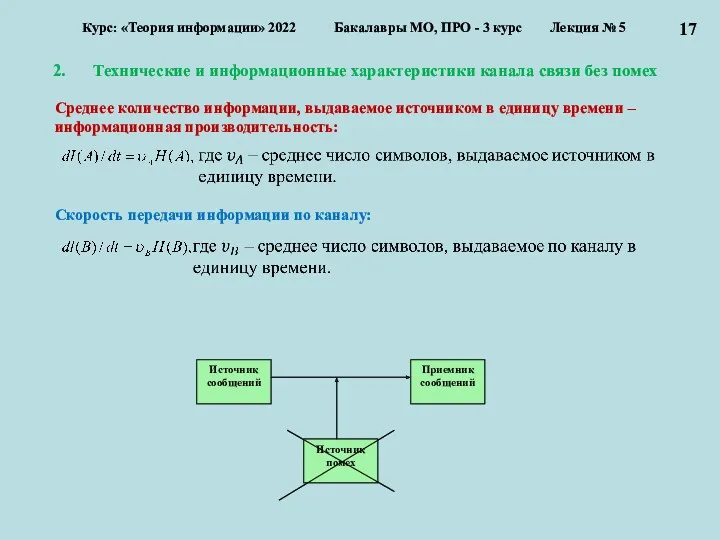

- 17. Технические и информационные характеристики канала связи без помех Курс: «Теория информации» 2022 Бакалавры МО, ПРО -

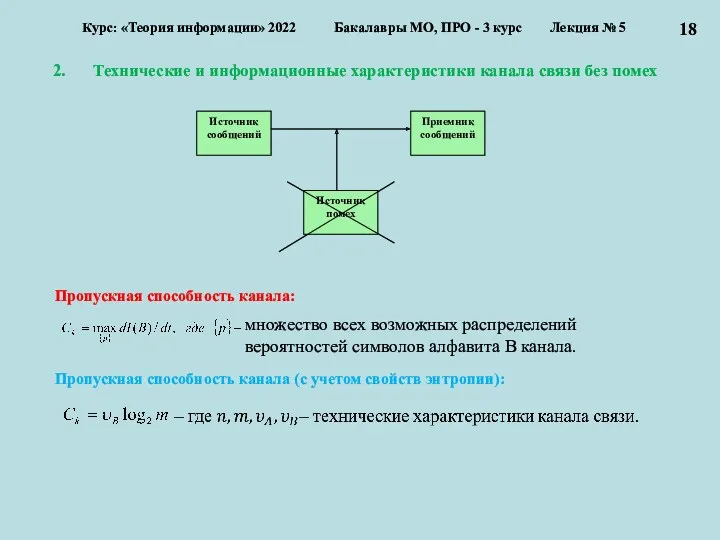

- 18. Технические и информационные характеристики канала связи без помех Курс: «Теория информации» 2022 Бакалавры МО, ПРО -

- 19. Часть 2. Каналы передачи информации 2.1. Структурная схема системы передачи информации (повторение) 2.2. Технические и информационные

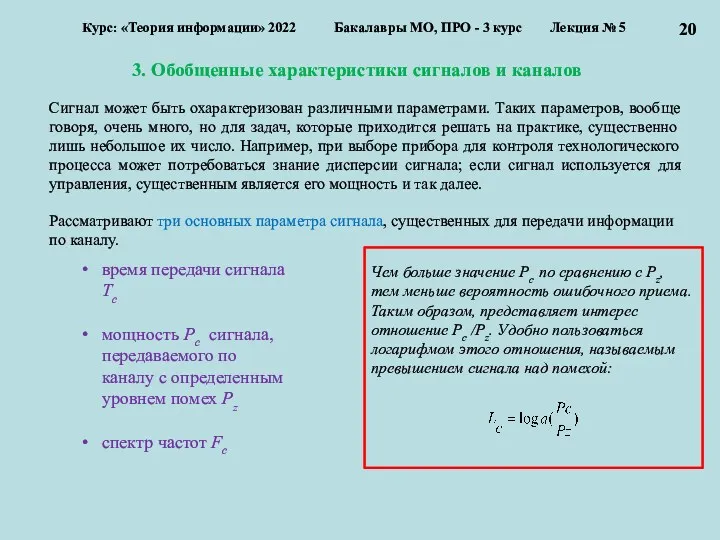

- 20. 3. Обобщенные характеристики сигналов и каналов Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3 курс

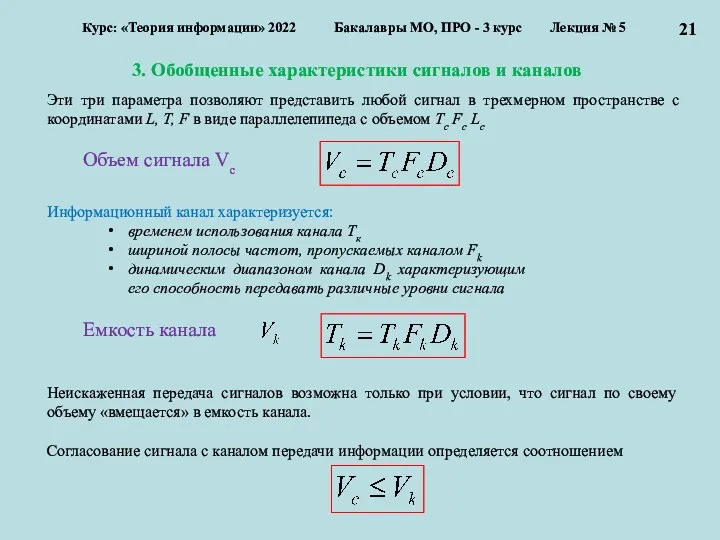

- 21. 3. Обобщенные характеристики сигналов и каналов Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3 курс

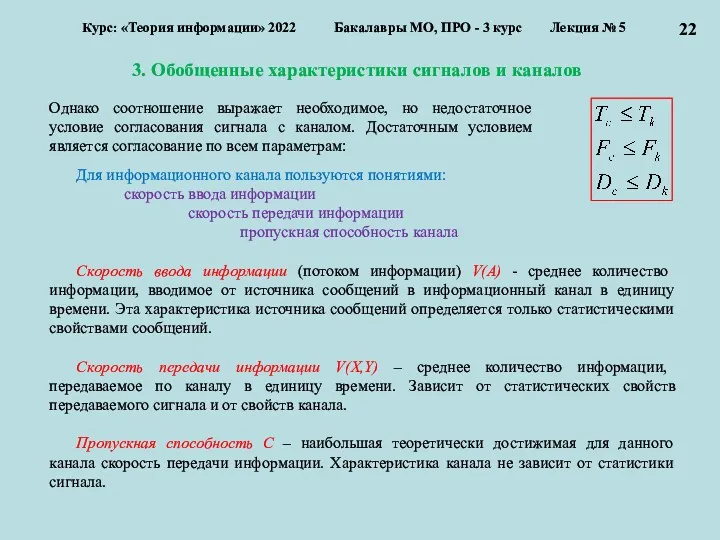

- 22. 3. Обобщенные характеристики сигналов и каналов Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3 курс

- 23. 3. Обобщенные характеристики сигналов и каналов Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3 курс

- 24. 3. Обобщенные характеристики сигналов и каналов Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3 курс

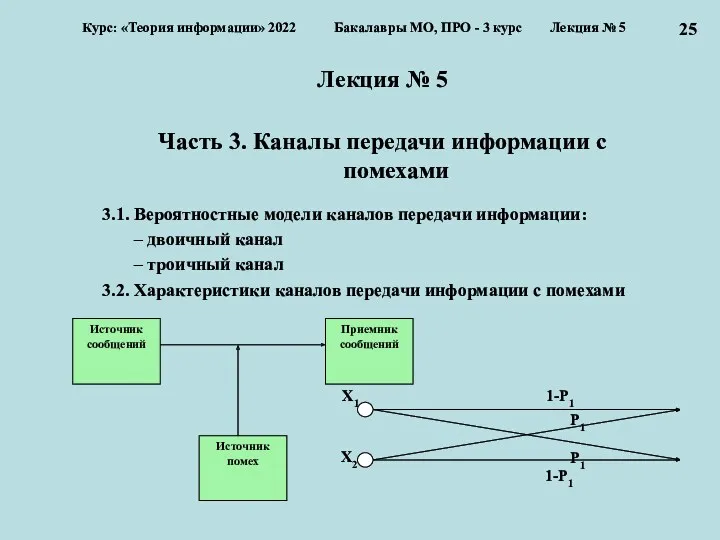

- 25. Лекция № 5 Часть 3. Каналы передачи информации с помехами 3.1. Вероятностные модели каналов передачи информации:

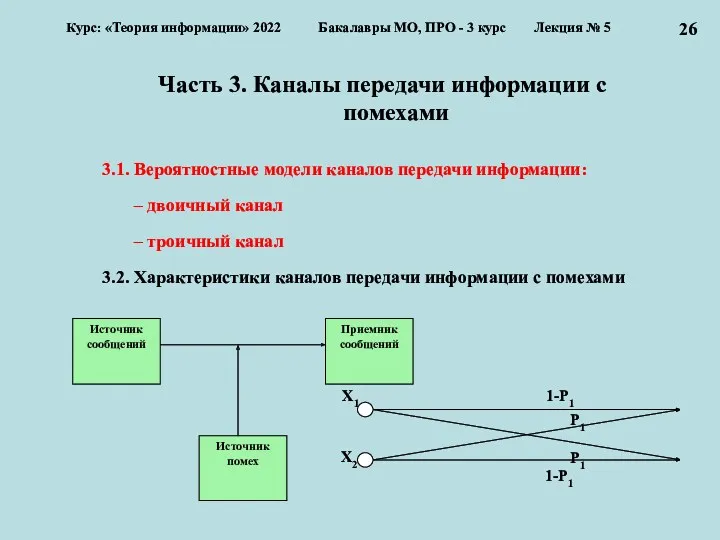

- 26. Часть 3. Каналы передачи информации с помехами 3.1. Вероятностные модели каналов передачи информации: – двоичный канал

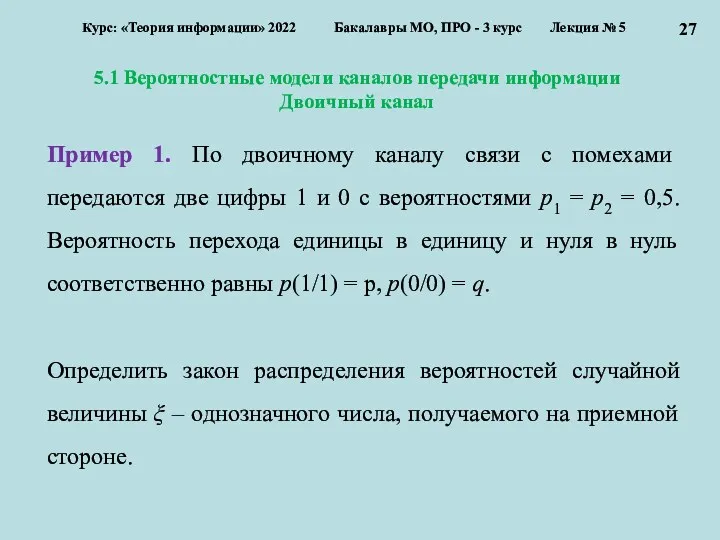

- 27. 5.1 Вероятностные модели каналов передачи информации Двоичный канал Курс: «Теория информации» 2022 Бакалавры МО, ПРО -

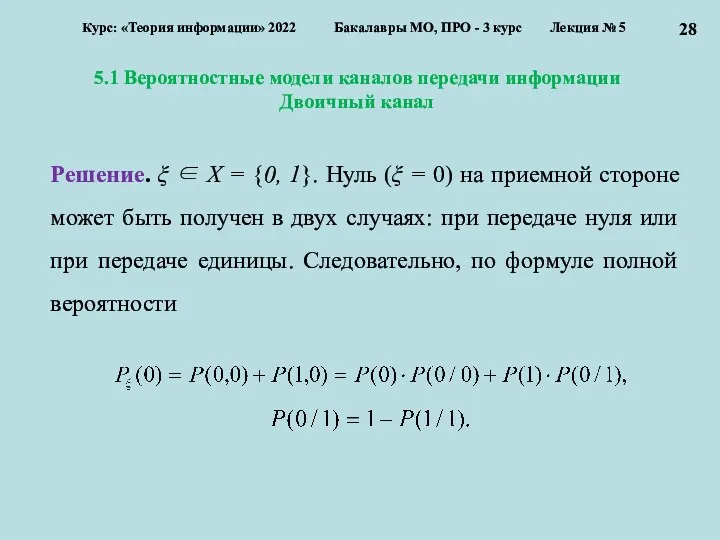

- 28. 5.1 Вероятностные модели каналов передачи информации Двоичный канал Курс: «Теория информации» 2022 Бакалавры МО, ПРО -

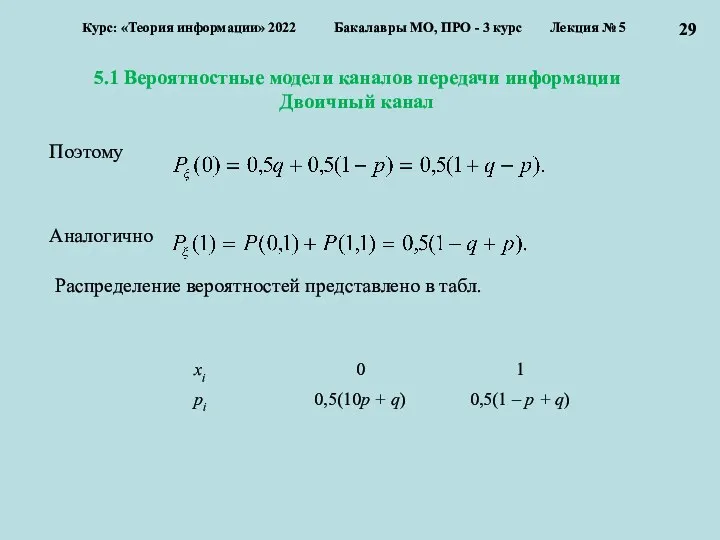

- 29. 5.1 Вероятностные модели каналов передачи информации Двоичный канал Курс: «Теория информации» 2022 Бакалавры МО, ПРО -

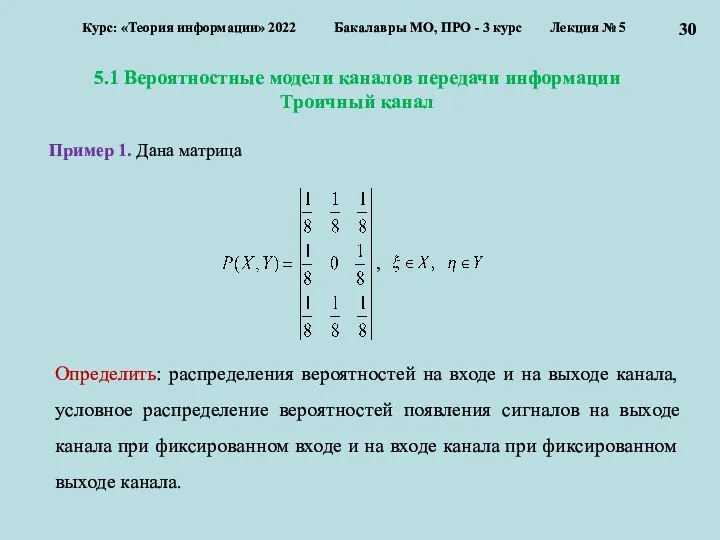

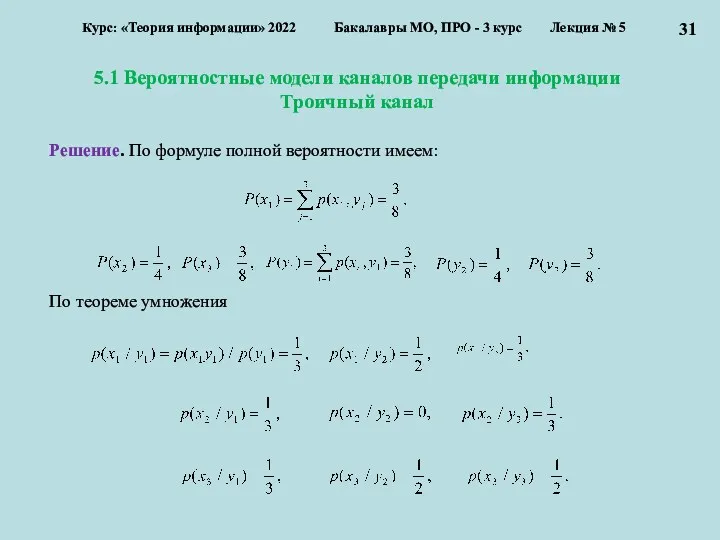

- 30. 5.1 Вероятностные модели каналов передачи информации Троичный канал Курс: «Теория информации» 2022 Бакалавры МО, ПРО -

- 31. 5.1 Вероятностные модели каналов передачи информации Троичный канал Курс: «Теория информации» 2022 Бакалавры МО, ПРО -

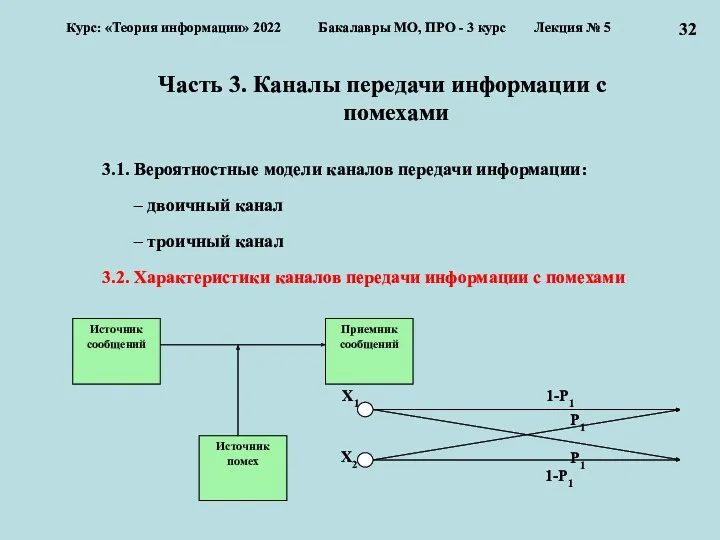

- 32. Часть 3. Каналы передачи информации с помехами 3.1. Вероятностные модели каналов передачи информации: – двоичный канал

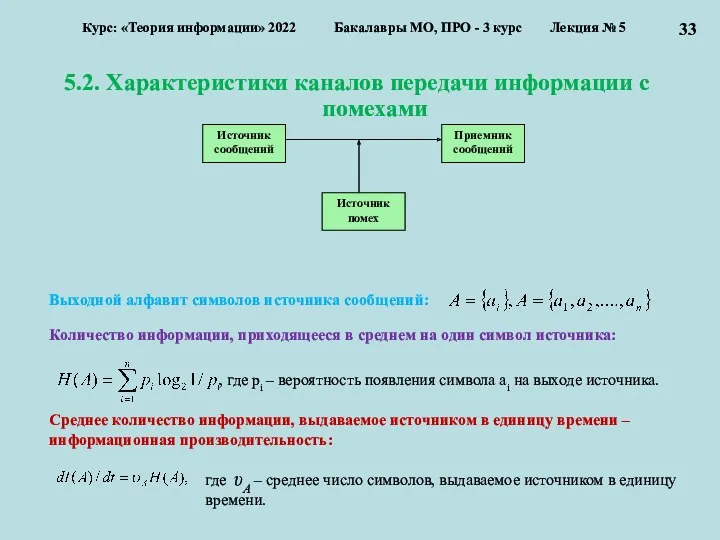

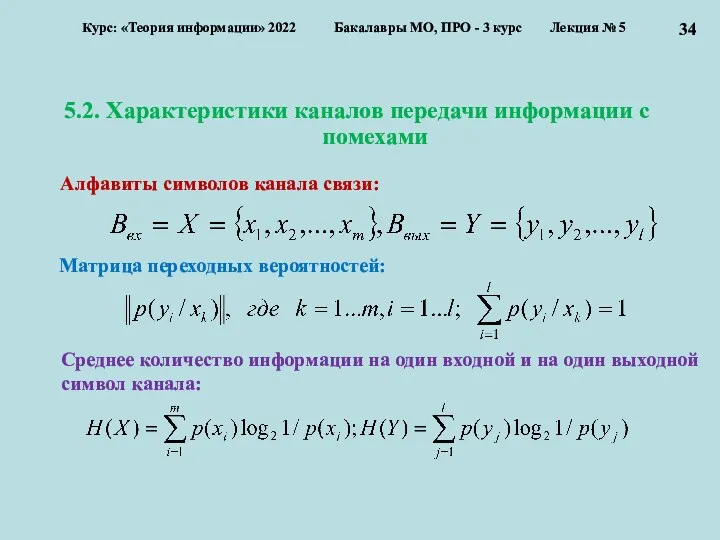

- 33. 5.2. Характеристики каналов передачи информации с помехами Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3

- 34. 5.2. Характеристики каналов передачи информации с помехами Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3

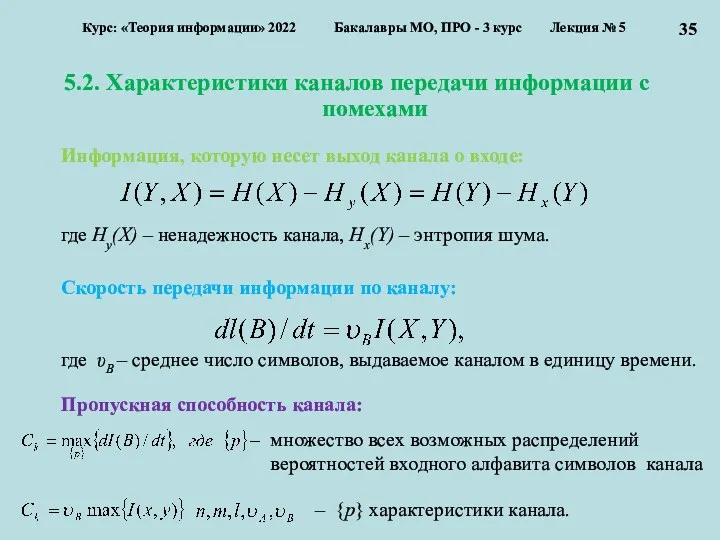

- 35. 5.2. Характеристики каналов передачи информации с помехами Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3

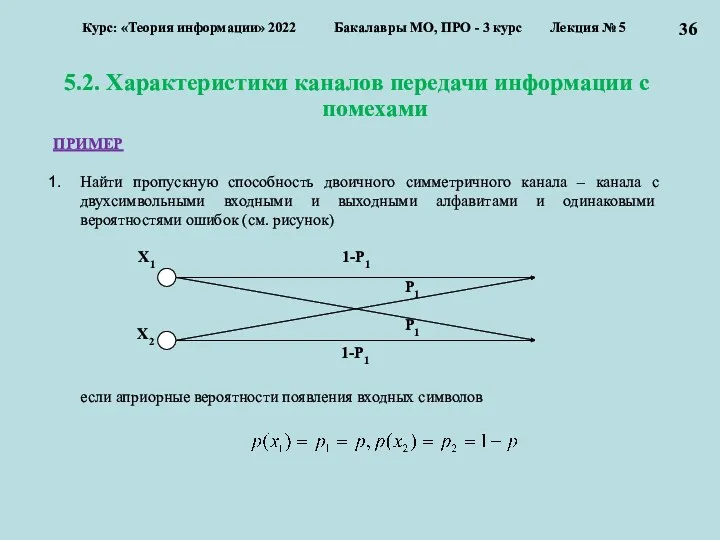

- 36. 5.2. Характеристики каналов передачи информации с помехами Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3

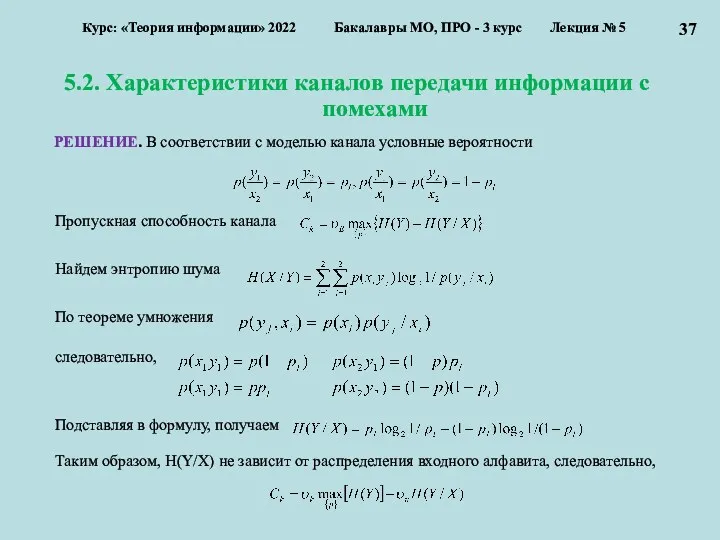

- 37. 5.2. Характеристики каналов передачи информации с помехами Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3

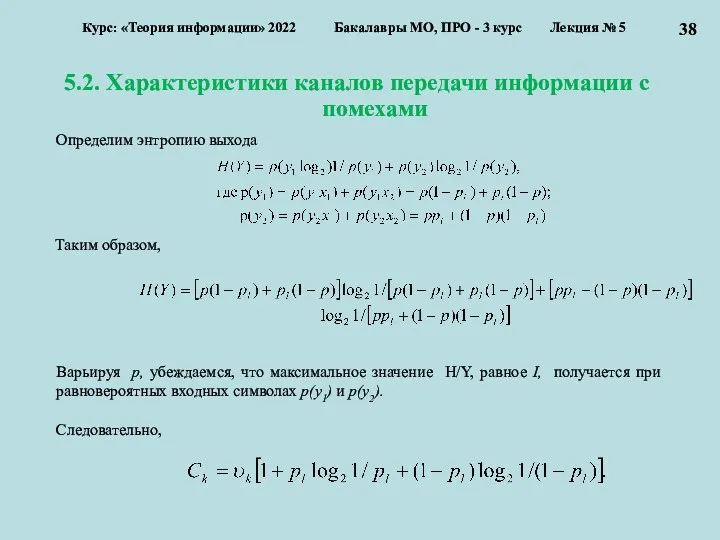

- 38. 5.2. Характеристики каналов передачи информации с помехами Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3

- 39. Лекция № 5 Часть 1. Условная энтропия и взаимная информация 1.1. Условная энтропия 1.2. Взаимная информация

- 40. Часть 1. Результаты Шеннона и проблемы кодирования 1. Теорема Шеннона для канала без помех 2. Теорема

- 41. Часть 1. Результаты Шеннона и проблемы кодирования 1. Теорема Шеннона для канала без помех 2. Теорема

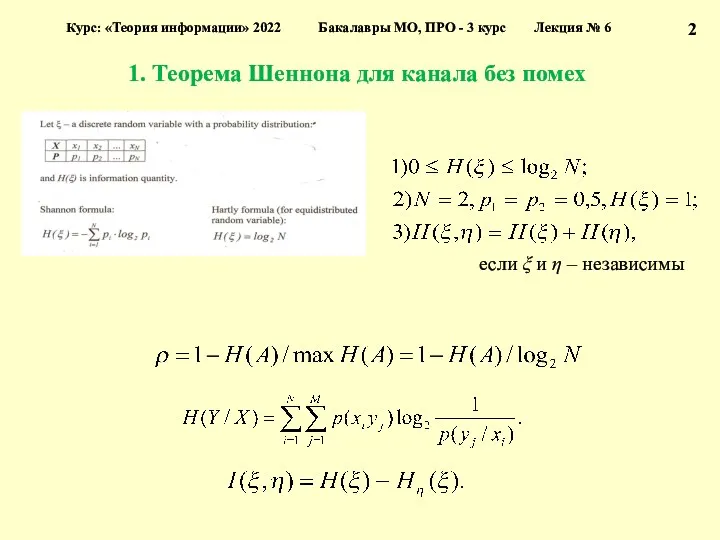

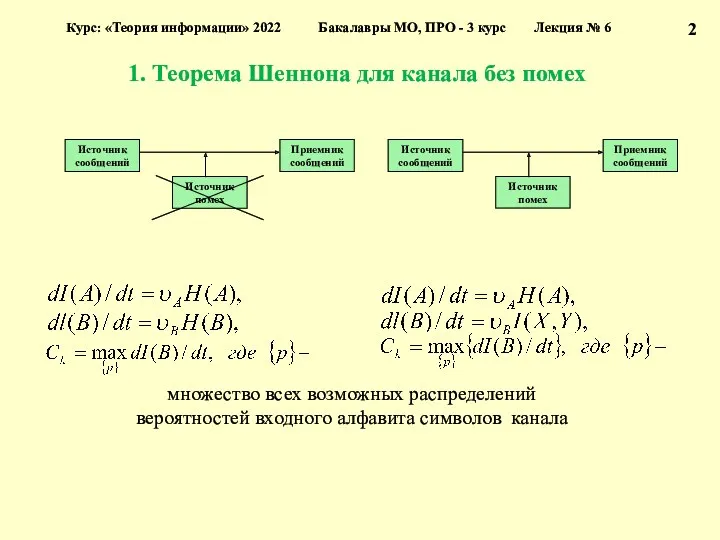

- 42. 1. Теорема Шеннона для канала без помех 2 Курс: «Теория информации» 2022 Бакалавры МО, ПРО -

- 43. 1. Теорема Шеннона для канала без помех 2 Курс: «Теория информации» 2022 Бакалавры МО, ПРО -

- 44. 2 Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3 курс Лекция № 6 Если выполняется

- 45. 2 Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3 курс Лекция № 6 Можно ли

- 46. 1. Теорема Шеннона для канала без помех 2 Курс: «Теория информации» 2022 Бакалавры МО, ПРО -

- 47. 1. Теорема Шеннона для канала без помех 2 Курс: «Теория информации» 2022 Бакалавры МО, ПРО -

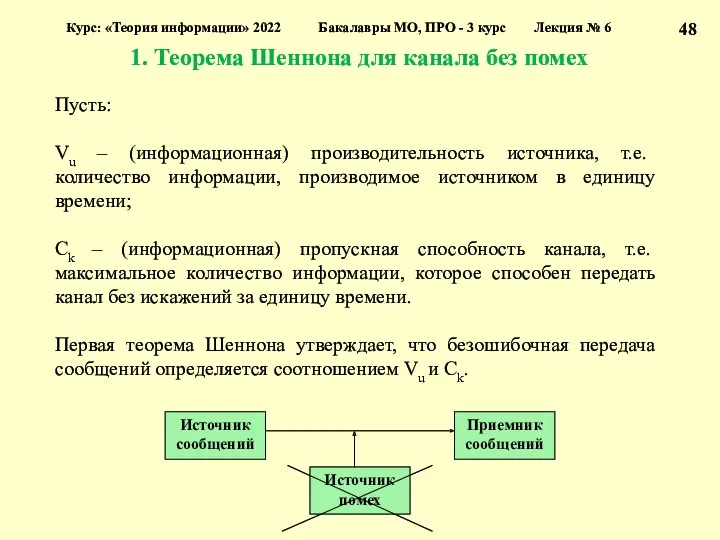

- 48. 1. Теорема Шеннона для канала без помех Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3

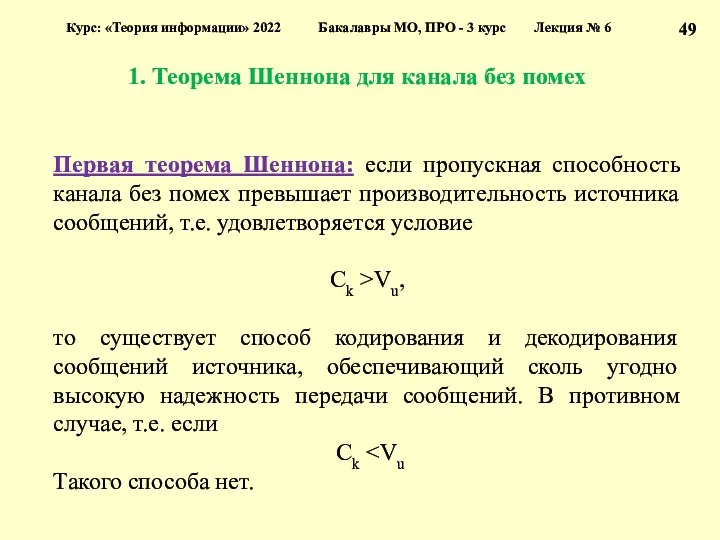

- 49. 1. Теорема Шеннона для канала без помех Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3

- 50. 1. Теорема Шеннона для канала без помех Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3

- 51. 1. Теорема Шеннона для канала без помех Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3

- 52. Лекция № 6 Часть 1. Результаты Шеннона и проблемы кодирования 1. Теорема Шеннона для канала без

- 53. 2. Теорема Шеннона для канала с помехами Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3

- 54. 2. Теорема Шеннона для канала с помехами Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3

- 55. 2. Теорема Шеннона для канала с помехами Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3

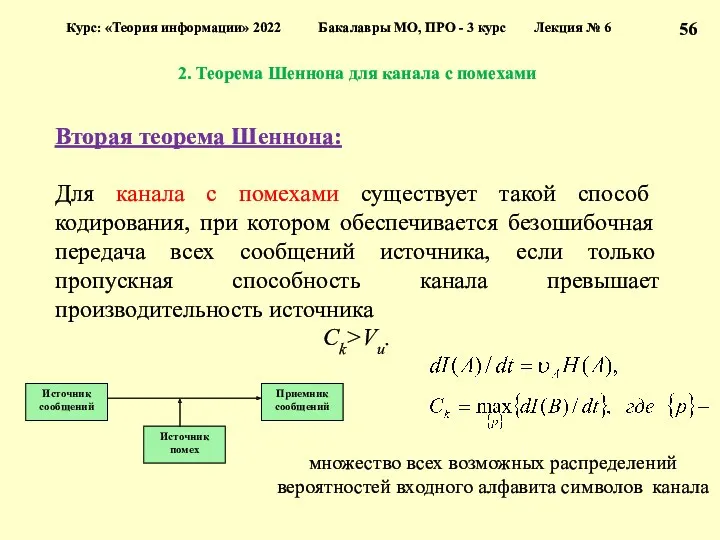

- 56. 2. Теорема Шеннона для канала с помехами Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3

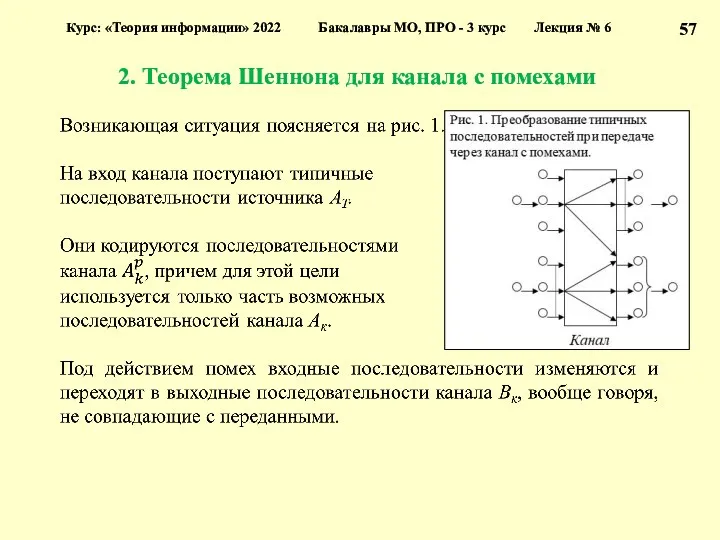

- 57. 2. Теорема Шеннона для канала с помехами Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3

- 58. 2. Теорема Шеннона для канала с помехами Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3

- 59. 2. Теорема Шеннона для канала с помехами Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3

- 60. 2. Теорема Шеннона для канала с помехами Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3

- 61. 2. Теорема Шеннона для канала с помехами Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3

- 62. Лекция № 6 Часть 1. Результаты Шеннона и проблемы кодирования 1. Теорема Шеннона для канала без

- 63. 3. Значение результатов Шеннона для задач передачи, хранения и поиска информации Курс: «Теория информации» 2022 Бакалавры

- 64. 3. Значение результатов Шеннона для задач передачи, хранения и поиска информации Курс: «Теория информации» 2022 Бакалавры

- 65. 3. Значение результатов Шеннона Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3 курс Лекция №

- 66. 3. Значение результатов Шеннона Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3 курс Лекция №

- 67. 3. Значение результатов Шеннона Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3 курс Лекция №

- 68. 3. Значение результатов Шеннона Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3 курс Лекция №

- 69. 3. Значение результатов Шеннона Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3 курс Лекция №

- 70. 3. Значение результатов Шеннона Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3 курс Лекция №

- 71. 3. Значение результатов Шеннона Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3 курс Лекция №

- 72. 3. Значение результатов Шеннона Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3 курс Лекция №

- 73. Лекция № 6 Часть 1. Результаты Шеннона и проблемы кодирования 1. Теорема Шеннона для канала без

- 74. 4. Современные технические средства передачи информации Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3 курс

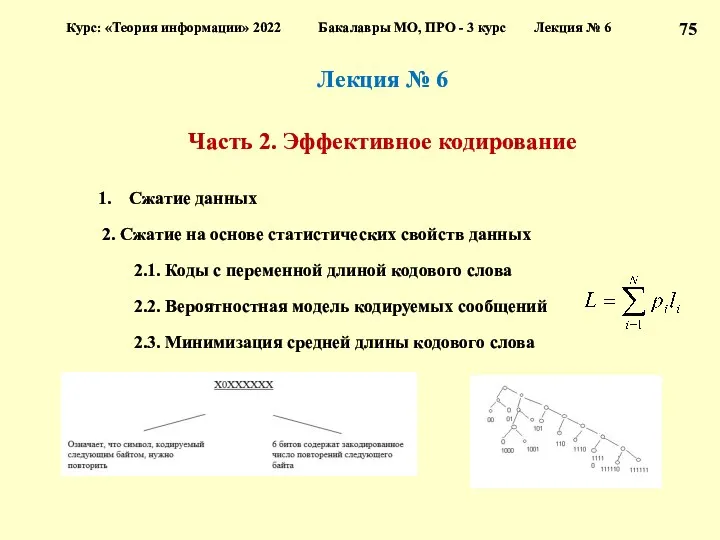

- 75. Лекция № 6 Часть 2. Эффективное кодирование Сжатие данных 2. Сжатие на основе статистических свойств данных

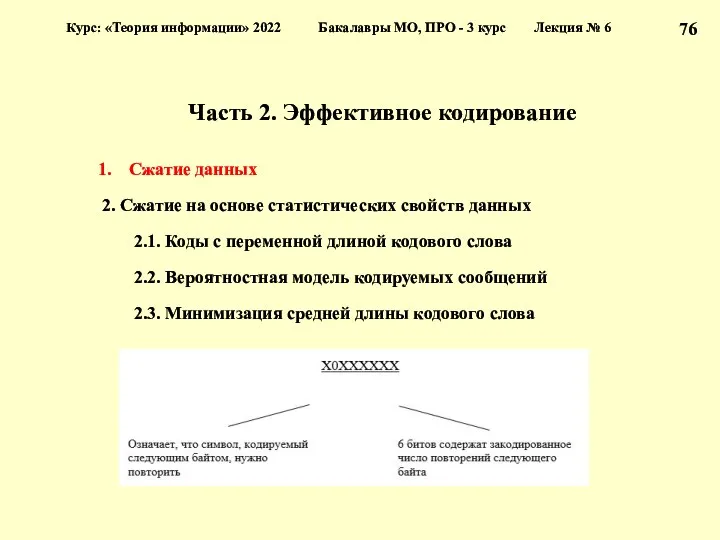

- 76. Часть 2. Эффективное кодирование Сжатие данных 2. Сжатие на основе статистических свойств данных 2.1. Коды с

- 77. 1. Сжатие данных Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3 курс Лекция № 6

- 78. 1. Сжатие данных Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3 курс Лекция № 6

- 79. 1. Сжатие данных Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3 курс Лекция № 6

- 80. 1. Сжатие данных Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3 курс Лекция № 6

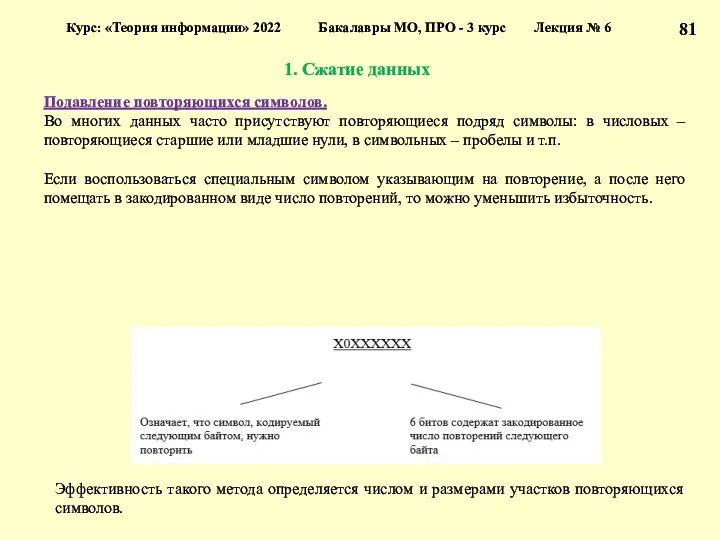

- 81. 1. Сжатие данных Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3 курс Лекция № 6

- 82. 1. Сжатие данных Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3 курс Лекция № 6

- 83. 1. Сжатие данных Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3 курс Лекция № 6

- 84. 1. Сжатие данных Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3 курс Лекция № 6

- 85. 1. Сжатие данных Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3 курс Лекция № 6

- 86. Лекция № 6 Часть 2. Эффективное кодирование Сжатие данных 2. Сжатие на основе статистических свойств данных

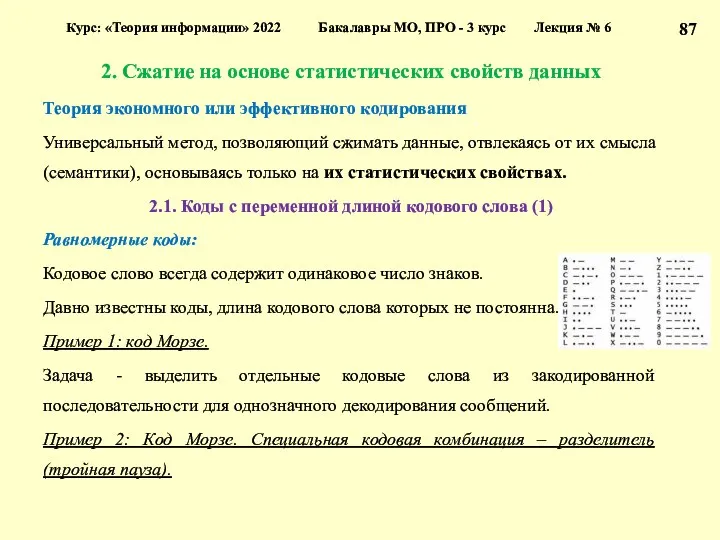

- 87. 2. Сжатие на основе статистических свойств данных Теория экономного или эффективного кодирования Универсальный метод, позволяющий сжимать

- 88. 2. Сжатие на основе статистических свойств данных 2.1. Коды с переменной длиной кодового слова (2) Префиксные

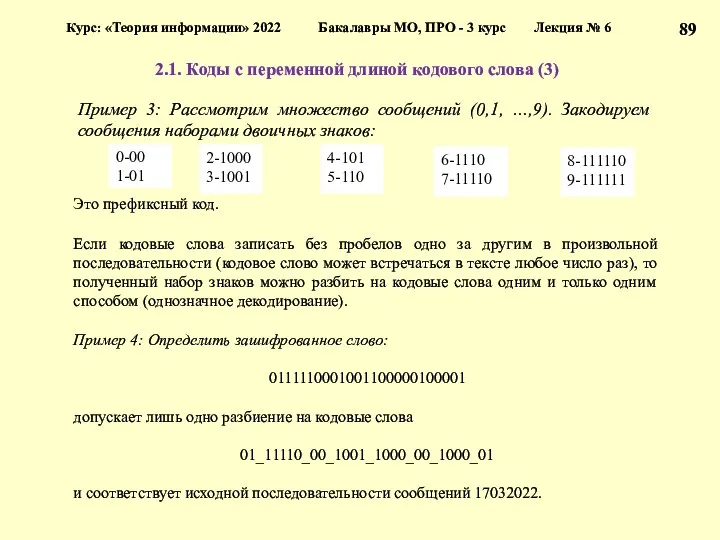

- 89. 2.1. Коды с переменной длиной кодового слова (3) Курс: «Теория информации» 2022 Бакалавры МО, ПРО -

- 90. 2.1. Коды с переменной длиной кодового слова (4) Курс: «Теория информации» 2022 Бакалавры МО, ПРО -

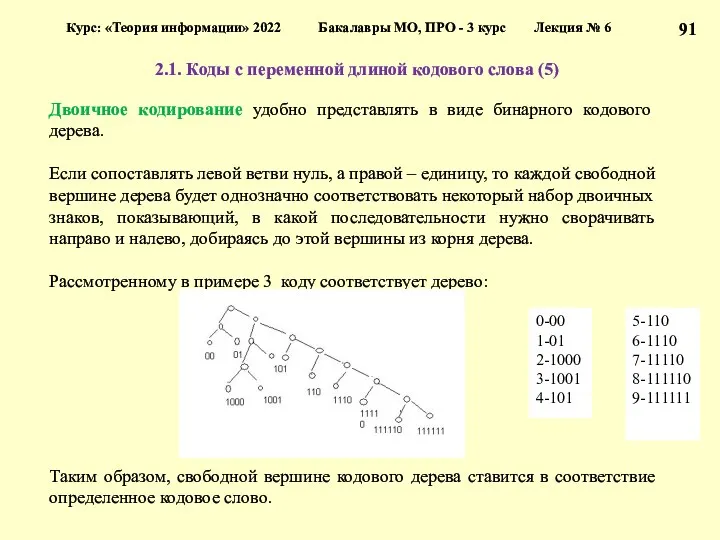

- 91. 2.1. Коды с переменной длиной кодового слова (5) Курс: «Теория информации» 2022 Бакалавры МО, ПРО -

- 92. 2.1. Коды с переменной длиной кодового слова (5) Курс: «Теория информации» 2022 Бакалавры МО, ПРО -

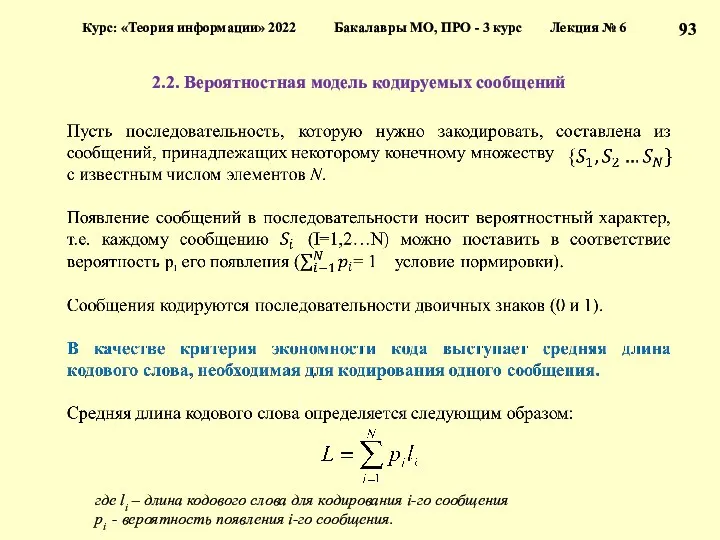

- 93. 2.2. Вероятностная модель кодируемых сообщений Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3 курс Лекция

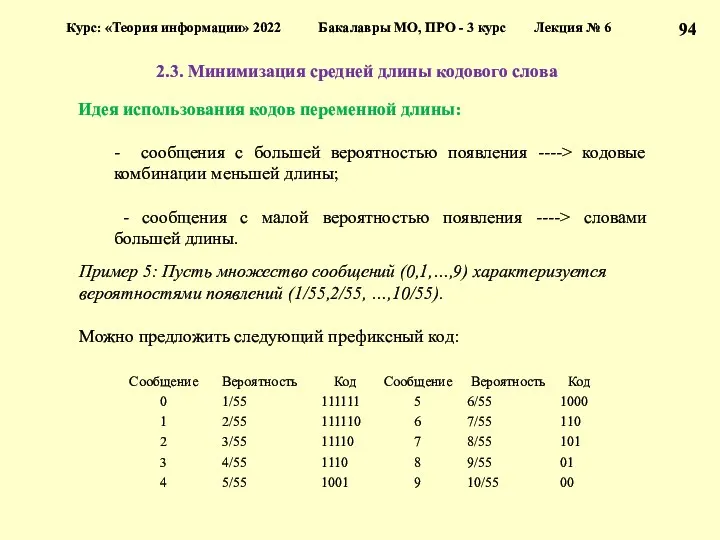

- 94. 2.3. Минимизация средней длины кодового слова Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3 курс

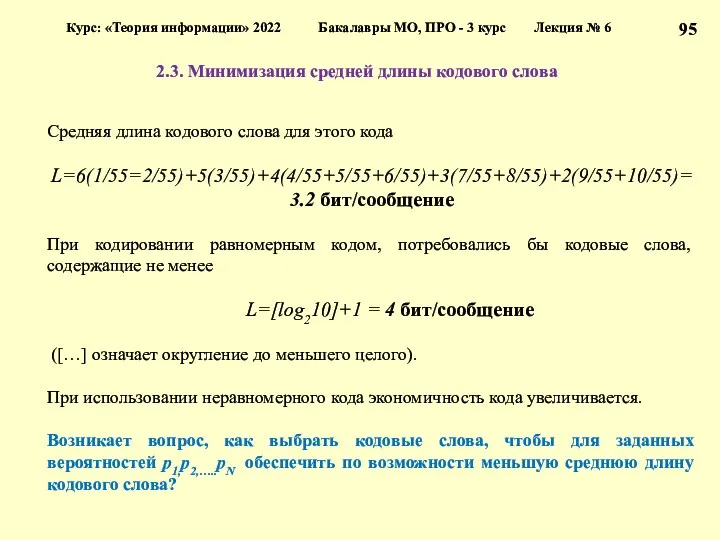

- 95. 2.3. Минимизация средней длины кодового слова Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3 курс

- 96. Лекция № 6 Часть 1. Результаты Шеннона и проблемы кодирования 1. Теорема Шеннона для канала без

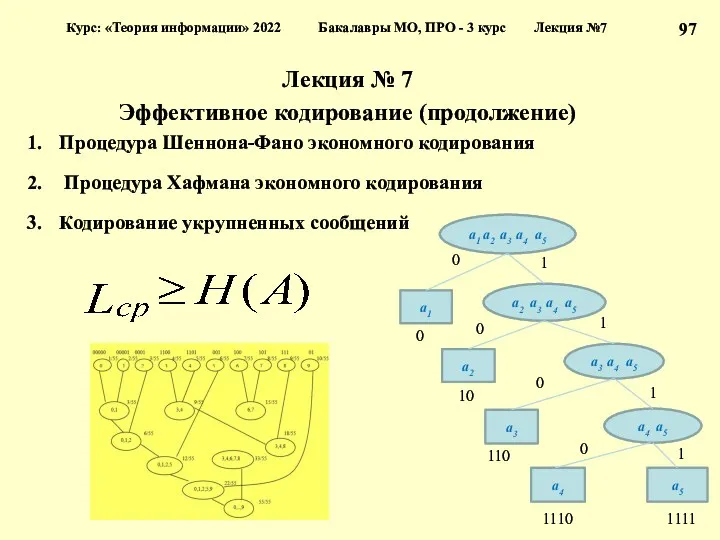

- 97. Лекция № 7 Эффективное кодирование (продолжение) Процедура Шеннона-Фано экономного кодирования Процедура Хафмана экономного кодирования Кодирование укрупненных

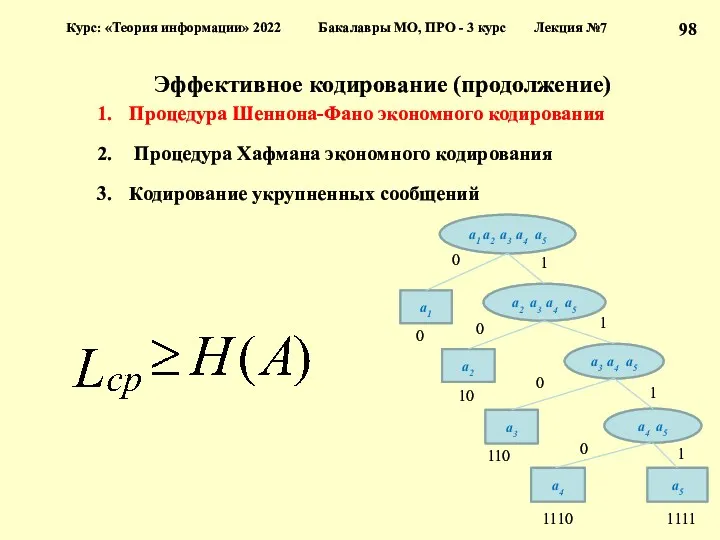

- 98. Эффективное кодирование (продолжение) Процедура Шеннона-Фано экономного кодирования Процедура Хафмана экономного кодирования Кодирование укрупненных сообщений Курс: «Теория

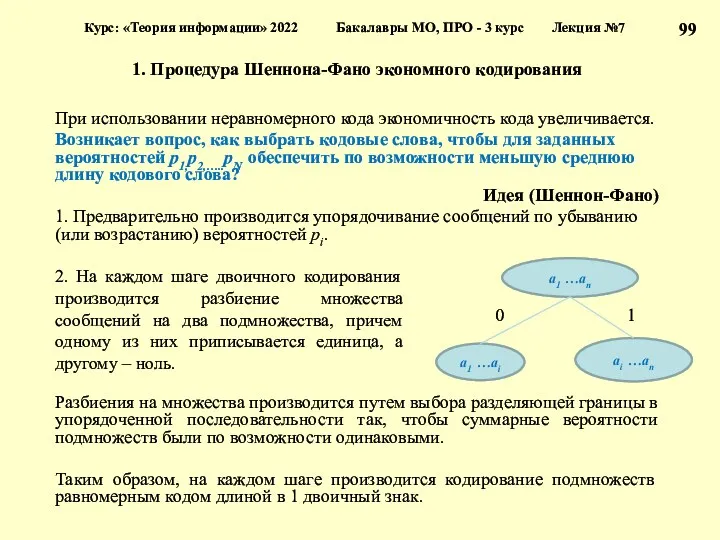

- 99. 1. Процедура Шеннона-Фано экономного кодирования При использовании неравномерного кода экономичность кода увеличивается. Возникает вопрос, как выбрать

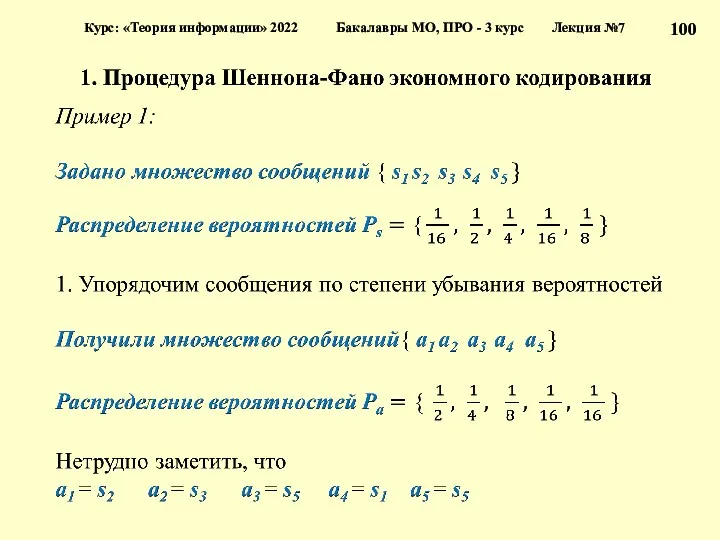

- 100. Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3 курс Лекция №7

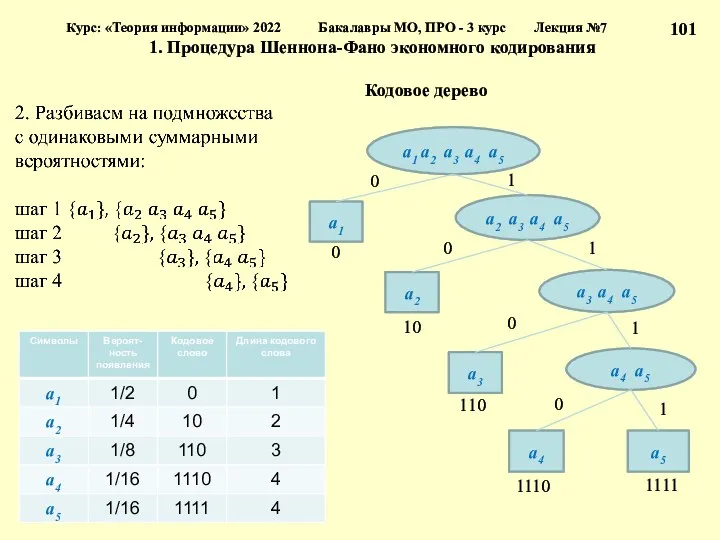

- 101. Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3 курс Лекция №7 1. Процедура Шеннона-Фано экономного

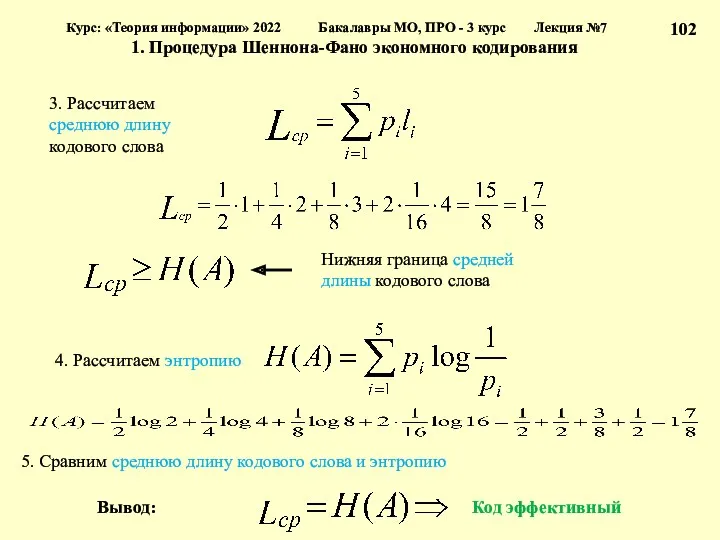

- 102. Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3 курс Лекция №7 1. Процедура Шеннона-Фано экономного

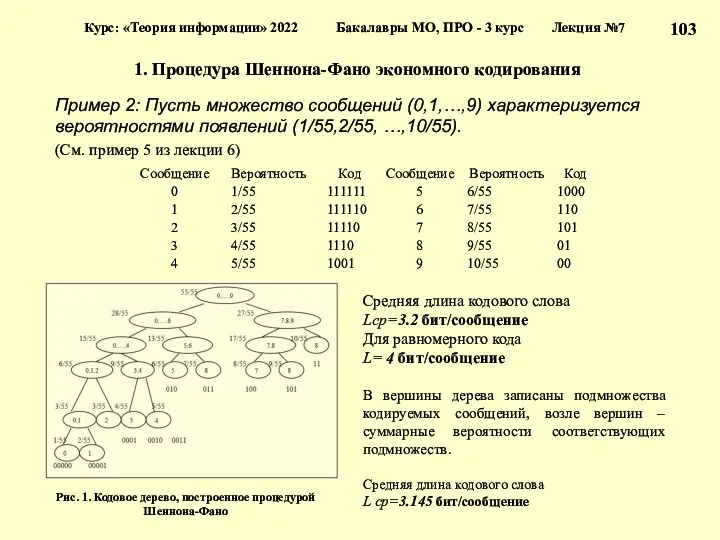

- 103. 1. Процедура Шеннона-Фано экономного кодирования Пример 2: Пусть множество сообщений (0,1,…,9) характеризуется вероятностями появлений (1/55,2/55, …,10/55).

- 104. Эффективное кодирование (продолжение) Процедура Шеннона-Фано экономного кодирования Процедура Хафмана экономного кодирования Кодирование укрупненных сообщений Применение алгоритмов

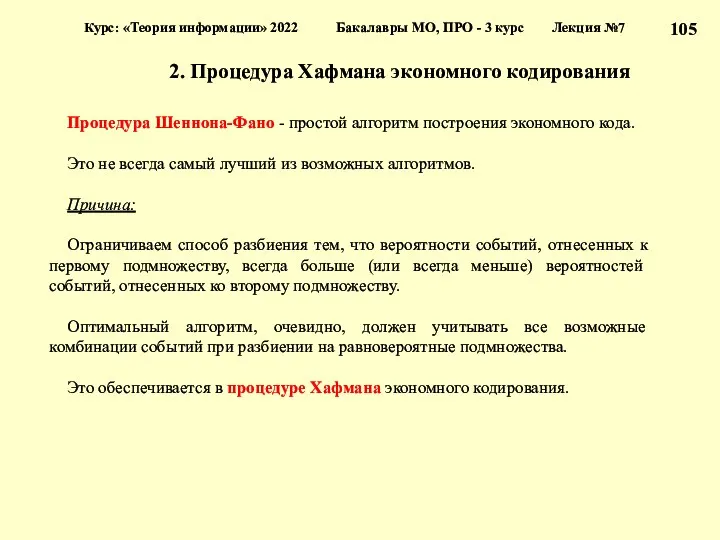

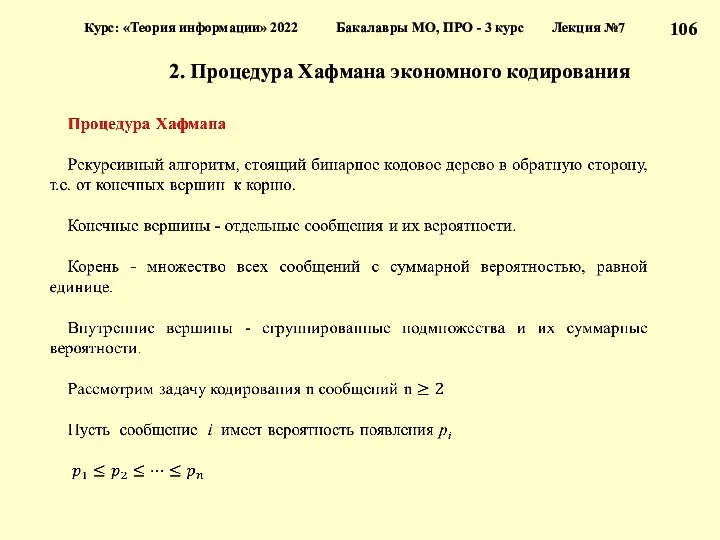

- 105. 2. Процедура Хафмана экономного кодирования Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3 курс Лекция

- 106. 2. Процедура Хафмана экономного кодирования Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3 курс Лекция

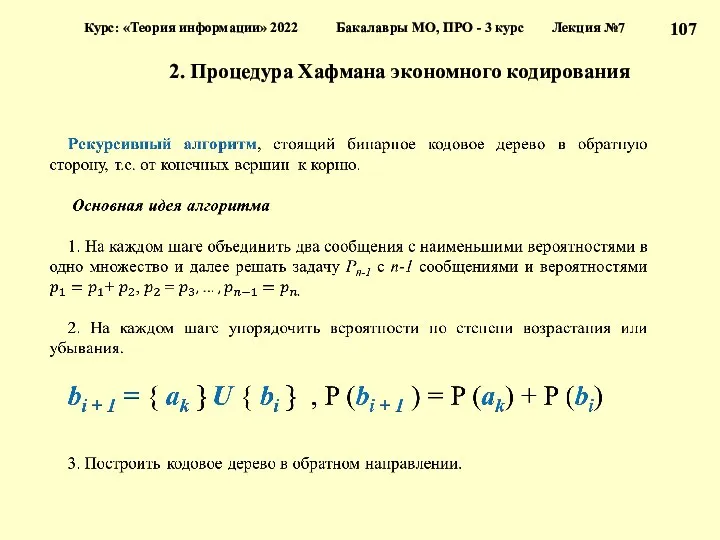

- 107. 2. Процедура Хафмана экономного кодирования Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3 курс Лекция

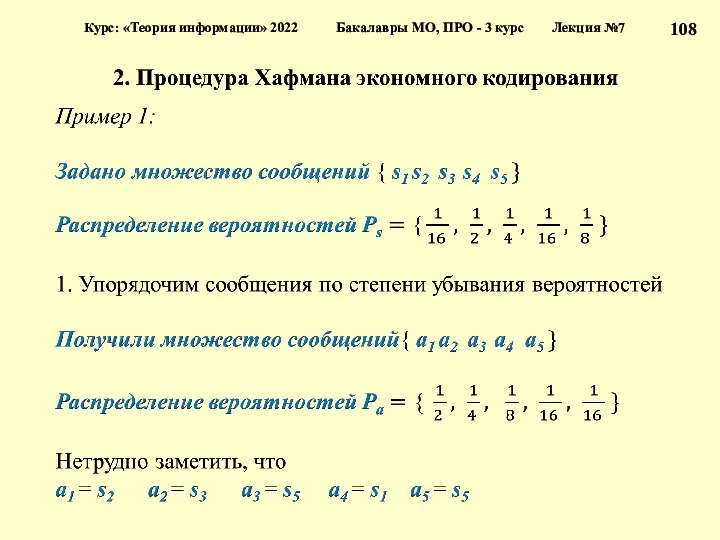

- 108. Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3 курс Лекция №7

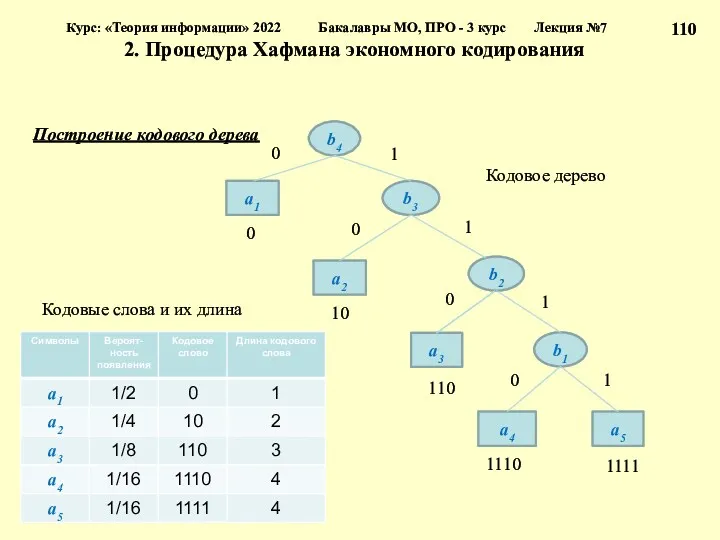

- 109. Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3 курс Лекция №7 2. Процедура Хафмана экономного

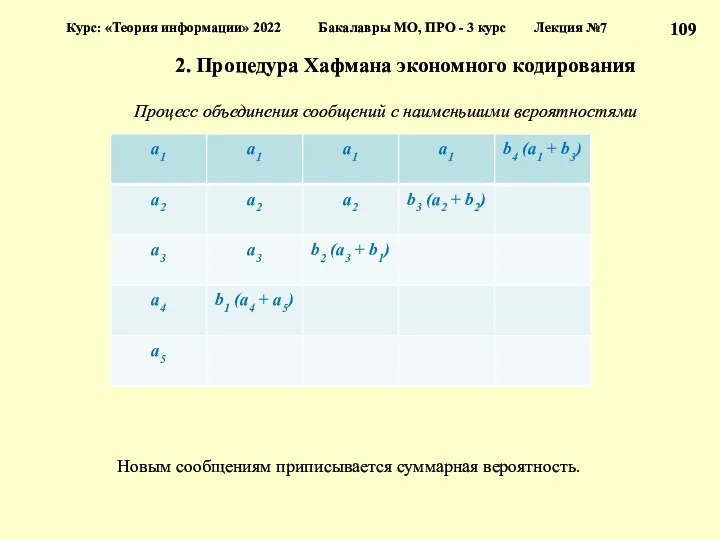

- 110. Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3 курс Лекция №7 2. Процедура Хафмана экономного

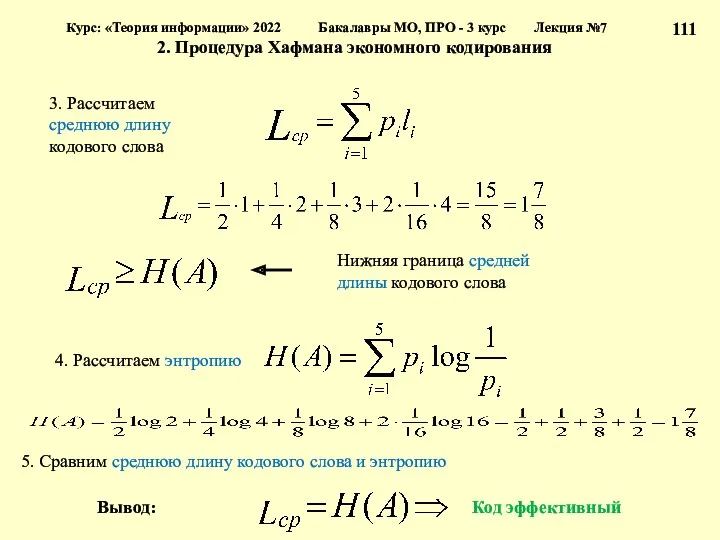

- 111. Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3 курс Лекция №7 2. Процедура Хафмана экономного

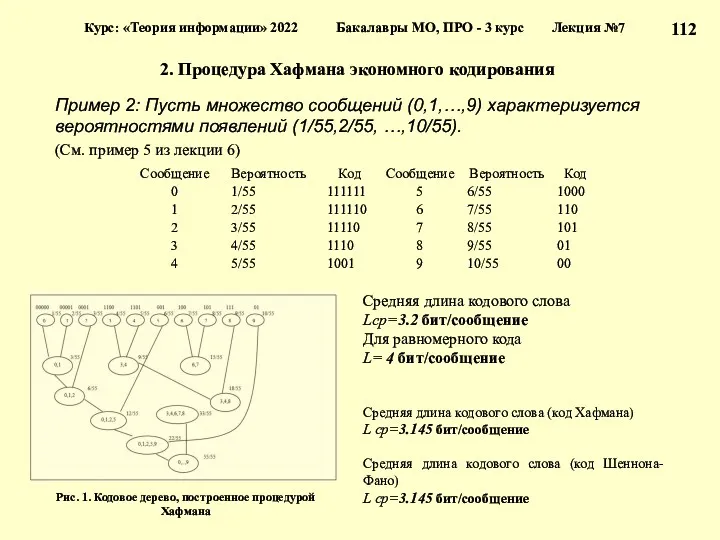

- 112. 2. Процедура Хафмана экономного кодирования Пример 2: Пусть множество сообщений (0,1,…,9) характеризуется вероятностями появлений (1/55,2/55, …,10/55).

- 113. Эффективное кодирование (продолжение) Процедура Шеннона-Фано экономного кодирования Процедура Хафмана экономного кодирования Кодирование укрупненных сообщений Курс: «Теория

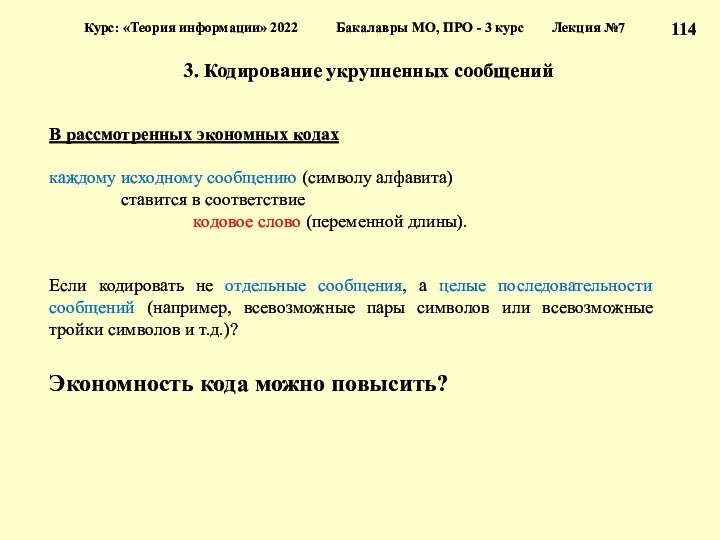

- 114. 3. Кодирование укрупненных сообщений Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3 курс Лекция №7

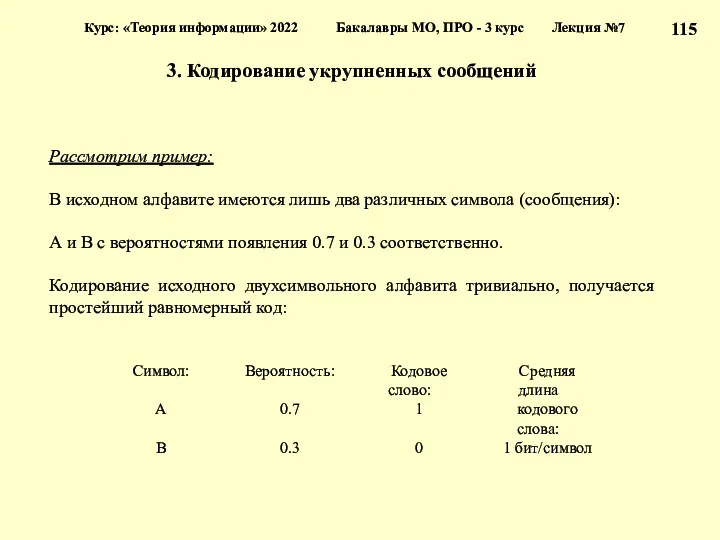

- 115. 3. Кодирование укрупненных сообщений Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3 курс Лекция №7

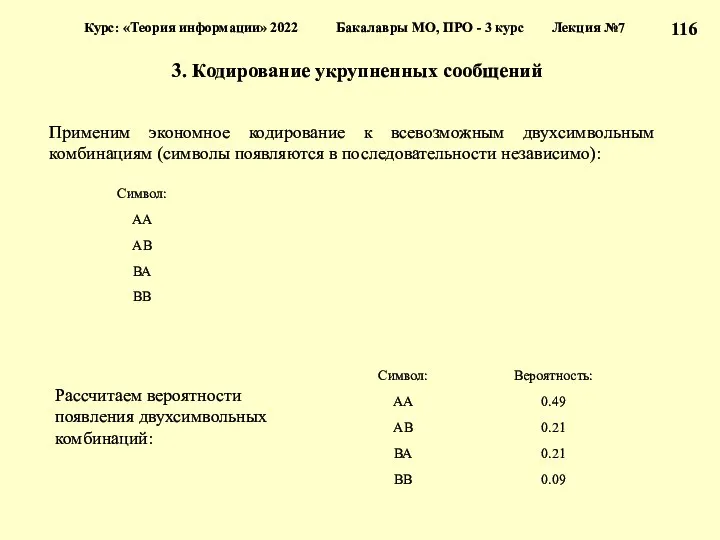

- 116. 3. Кодирование укрупненных сообщений Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3 курс Лекция №7

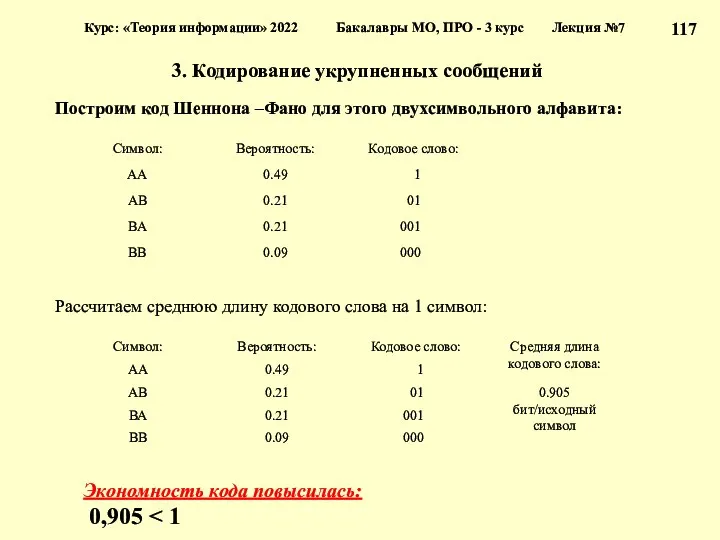

- 117. 3. Кодирование укрупненных сообщений Построим код Шеннона –Фано для этого двухсимвольного алфавита: Рассчитаем среднюю длину кодового

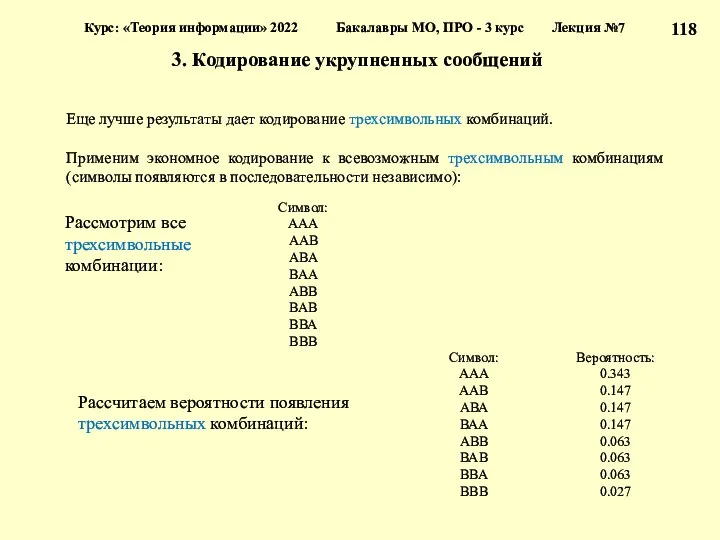

- 118. 3. Кодирование укрупненных сообщений Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3 курс Лекция №7

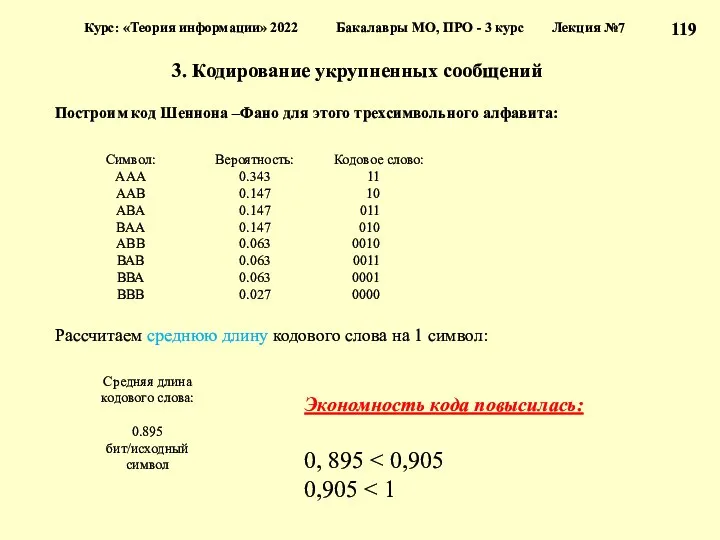

- 119. 3. Кодирование укрупненных сообщений Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3 курс Лекция №7

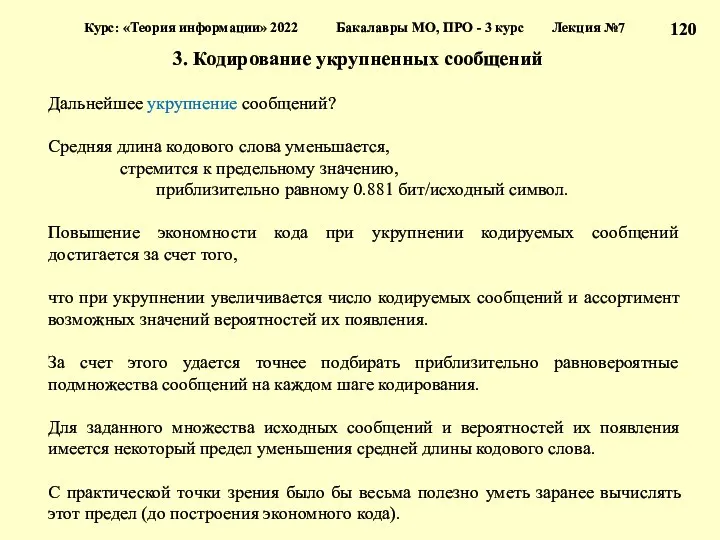

- 120. 3. Кодирование укрупненных сообщений Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3 курс Лекция №7

- 122. Скачать презентацию

Презентация по теме Электронные таблицы Excel

Презентация по теме Электронные таблицы Excel Защита от компьютерных вирусов. Признаки заражения компьютера

Защита от компьютерных вирусов. Признаки заражения компьютера Автоматизированное проектирование ИС. (Лекция 5)

Автоматизированное проектирование ИС. (Лекция 5) Виды компьютерной графики

Виды компьютерной графики Lesson 07. Документирование результатов тестирования

Lesson 07. Документирование результатов тестирования Информация. Носители информации

Информация. Носители информации Исследование степени сжатия информации различными архиваторами

Исследование степени сжатия информации различными архиваторами Разработка диалоговых программ

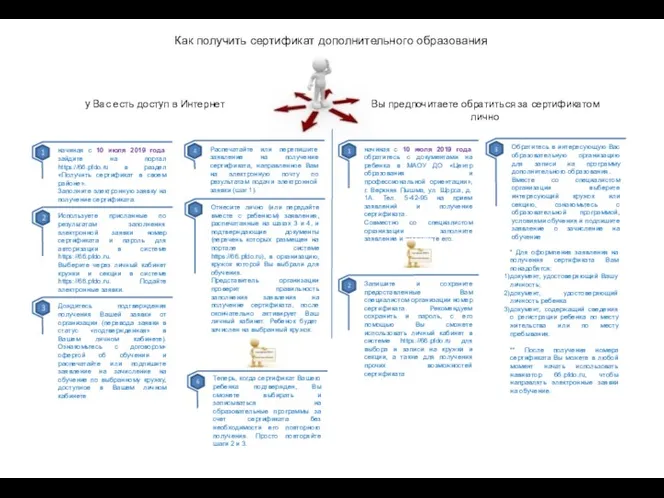

Разработка диалоговых программ Как получить сертификат дополнительного образования

Как получить сертификат дополнительного образования Понятие Алгоритм и Формы его записи. Исполнители алгоритмов

Понятие Алгоритм и Формы его записи. Исполнители алгоритмов Основные функции программы Microsoft Word

Основные функции программы Microsoft Word OLAP-технологии. Хранилища данных

OLAP-технологии. Хранилища данных Виды графики

Виды графики MS Excel

MS Excel Правовая информатика. Освоение информационных аспектов юридической деятельности

Правовая информатика. Освоение информационных аспектов юридической деятельности Специалист по социальным сетям

Специалист по социальным сетям Компьютерная графика. Обработка графической информации

Компьютерная графика. Обработка графической информации Программный комплекс для моделирования и анализа динамики ЛА в MATLAB/Simulink

Программный комплекс для моделирования и анализа динамики ЛА в MATLAB/Simulink Системы счисления. Математические основы информатики

Системы счисления. Математические основы информатики Локальные сети: общая характеристика, принципы работы

Локальные сети: общая характеристика, принципы работы Диаграммы и графики для power point

Диаграммы и графики для power point Интеграция информационной системы DPD

Интеграция информационной системы DPD Програмування мовою С/C++

Програмування мовою С/C++ Тестирование ПО. Дефект. Лекция 3

Тестирование ПО. Дефект. Лекция 3 Разработка элементов ЭОР на основе облачных сервисов

Разработка элементов ЭОР на основе облачных сервисов Правила использования сети интернет

Правила использования сети интернет Туристическое приложение с персонализированными динамическими маршрутами Помощник Туриста

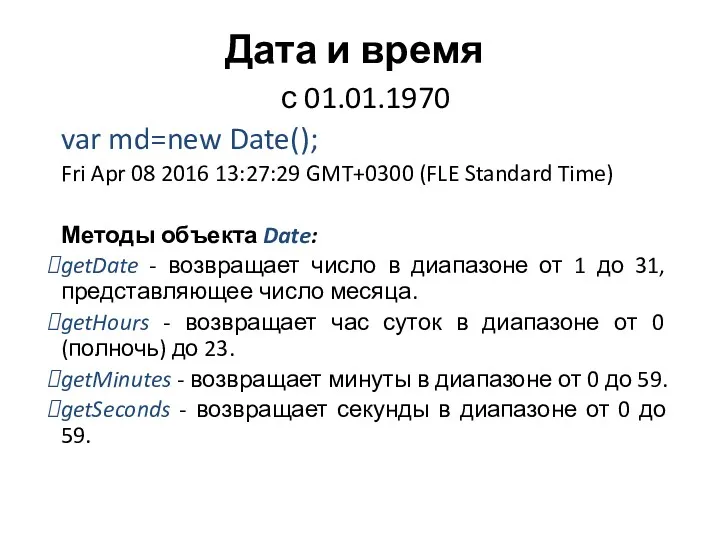

Туристическое приложение с персонализированными динамическими маршрутами Помощник Туриста Дата и время. Методы объекта Date

Дата и время. Методы объекта Date