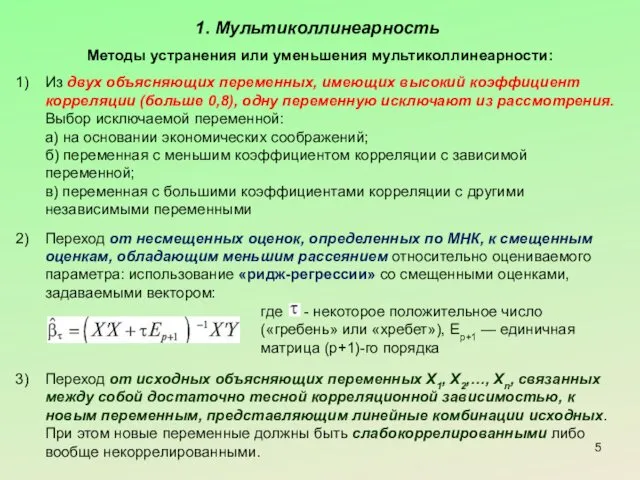

1. Мультиколлинеарность

Методы устранения или уменьшения мультиколлинеарности:

Из двух объясняющих переменных, имеющих высокий

коэффициент корреляции (больше 0,8), одну переменную исключают из рассмотрения. Выбор исключаемой переменной:

а) на основании экономических соображений;

б) переменная с меньшим коэффициентом корреляции с зависимой переменной;

в) переменная с большими коэффициентами корреляции с другими независимыми переменными

Переход от несмещенных оценок, определенных по МНК, к смещенным оценкам, обладающим меньшим рассеянием относительно оцениваемого параметра: использование «ридж-регрессии» со смещенными оценками, задаваемыми вектором:

Переход от исходных объясняющих переменных Х1, Х2,…, Xn, связанных между собой достаточно тесной корреляционной зависимостью, к новым переменным, представляющим линейные комбинации исходных. При этом новые переменные должны быть слабокоррелированными либо вообще некоррелированными.

где - некоторое положительное число («гребень» или «хребет»), Ep+1 — единичная матрица (р+1)-го порядка

Запрошення

Запрошення Наука иммунология

Наука иммунология Викторина для 11 класса

Викторина для 11 класса ВИЧ - инфекция

ВИЧ - инфекция Презентация Игра как ведущий вид деятельности дошкольника

Презентация Игра как ведущий вид деятельности дошкольника Публичный доклад по итогам работы. Отдел культуры, спорта и молодежи Администрации Песчанокопского района

Публичный доклад по итогам работы. Отдел культуры, спорта и молодежи Администрации Песчанокопского района Презентация к уроку химии: Оксиды. Номенклатура. Классификация

Презентация к уроку химии: Оксиды. Номенклатура. Классификация Портрет пожилого человека

Портрет пожилого человека Гитары Gibson

Гитары Gibson ЕГЭ по биологии. Задания части С

ЕГЭ по биологии. Задания части С Викинги. Культура, быт

Викинги. Культура, быт Синупрет. Дозы и способы применения

Синупрет. Дозы и способы применения Введение в предмет “Религиоведение”

Введение в предмет “Религиоведение” История хип-хопа и современной электронной музыки

История хип-хопа и современной электронной музыки Советско-китайские отношения времен застоя. Тема 25

Советско-китайские отношения времен застоя. Тема 25 Треугольник. Первый признак равенства треугольников

Треугольник. Первый признак равенства треугольников Дефекты сварных соединений. Фотоальбом

Дефекты сварных соединений. Фотоальбом БТС-Биоуправляемые протезы

БТС-Биоуправляемые протезы Презентация по тем Белки

Презентация по тем Белки Ледяные композиции (круглые скульптуры, сказочные замки)

Ледяные композиции (круглые скульптуры, сказочные замки) Паллиативная медицинская помощь в России и за рубежом

Паллиативная медицинская помощь в России и за рубежом Проект озеленення приватного будинку

Проект озеленення приватного будинку Красная книга растений. 5 класс. Диск

Красная книга растений. 5 класс. Диск Презентация Маленькая планета

Презентация Маленькая планета Духовно - нравственное воспитание

Духовно - нравственное воспитание презентация об алкоголизме

презентация об алкоголизме Географическая игра Антарктида

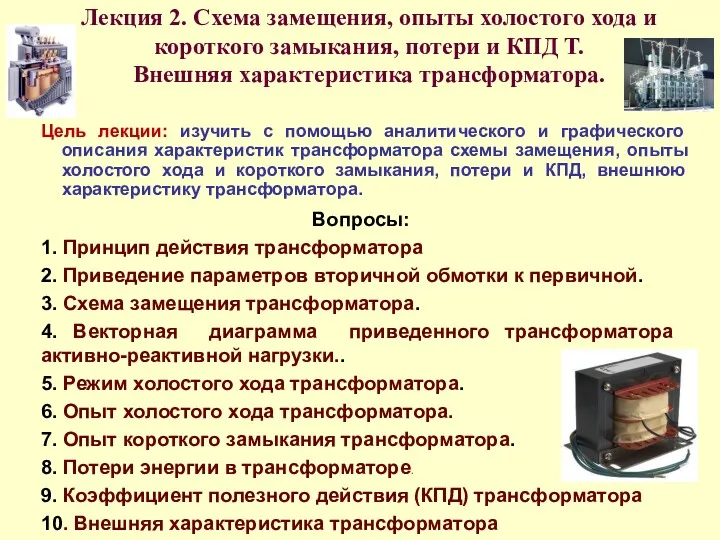

Географическая игра Антарктида Схема замещения, опыты холостого хода и короткого замыкания, потери и КПД Т. Внешняя характеристика трансформатора

Схема замещения, опыты холостого хода и короткого замыкания, потери и КПД Т. Внешняя характеристика трансформатора