Содержание

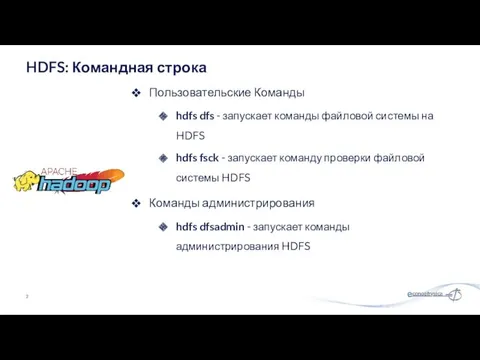

- 2. Пользовательские Команды hdfs dfs - запускает команды файловой системы на HDFS hdfs fsck - запускает команду

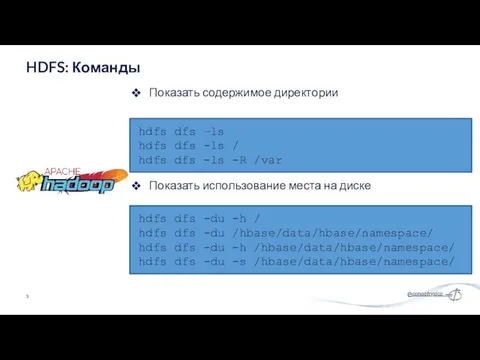

- 3. Показать содержимое директории HDFS: Команды hdfs dfs –ls hdfs dfs -ls / hdfs dfs -ls -R

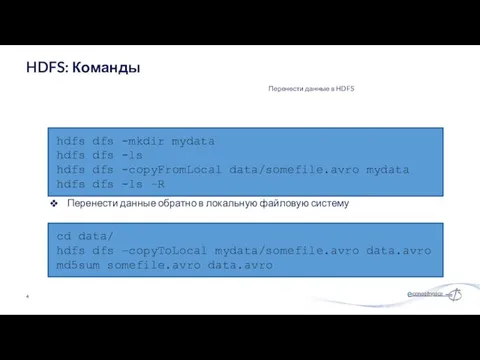

- 4. Перенести данные в HDFS HDFS: Команды hdfs dfs -mkdir mydata hdfs dfs -ls hdfs dfs -copyFromLocal

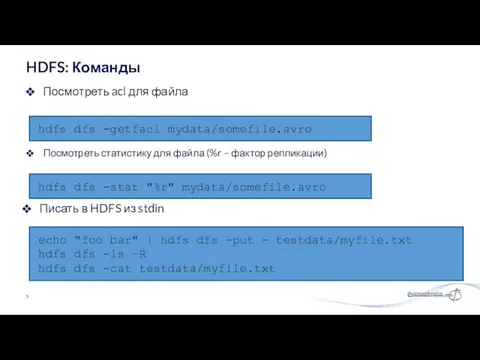

- 5. Посмотреть acl для файла HDFS: Команды hdfs dfs -getfacl mydata/somefile.avro hdfs dfs -stat "%r" mydata/somefile.avro echo

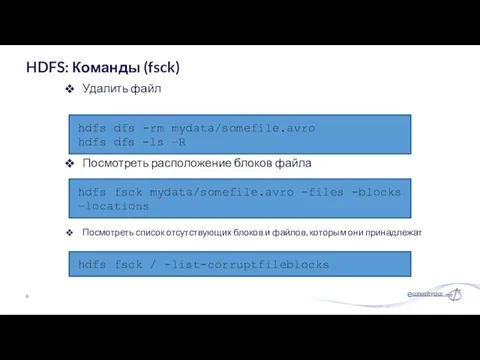

- 6. Удалить файл HDFS: Команды (fsck) hdfs dfs -rm mydata/somefile.avro hdfs dfs -ls –R hdfs fsck mydata/somefile.avro

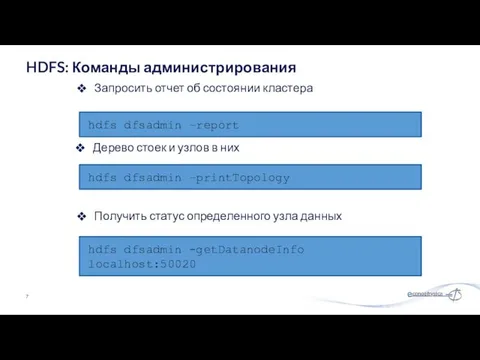

- 7. Запросить отчет об состоянии кластера HDFS: Команды администрирования hdfs dfsadmin –report hdfs dfsadmin –printTopology hdfs dfsadmin

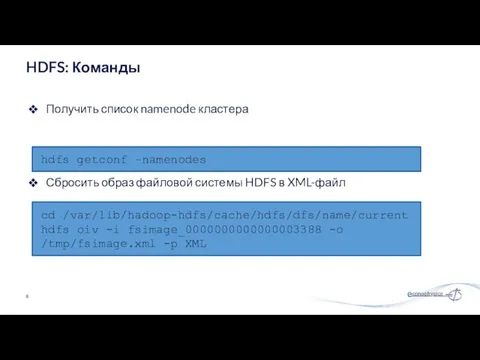

- 8. Получить список namenode кластера HDFS: Команды hdfs getconf –namenodes cd /var/lib/hadoop-hdfs/cache/hdfs/dfs/name/current hdfs oiv -i fsimage_0000000000000003388 -o

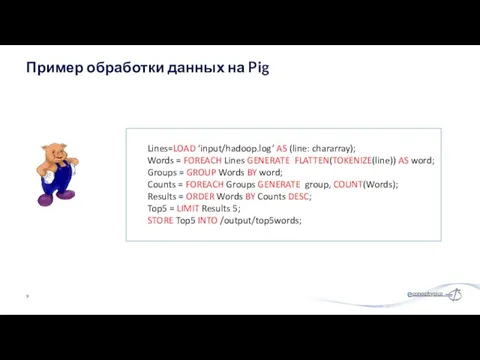

- 9. Пример обработки данных на Pig Lines=LOAD ‘input/hadoop.log’ AS (line: chararray); Words = FOREACH Lines GENERATE FLATTEN(TOKENIZE(line))

- 10. Варианты: Пакетный режим: отправить скрипт напрямую Интерактивный режим: Grunt, командная строка Java-класс PigServer, JDBC-подобный интерфейс Режимы

- 11. Скалярные типы: Int, long, float, double, boolean, null, chararray, bytearry; Сложные типы: field, tuple, bag, relation;

- 12. Локальный режим Используется локальный хост и локальная файловая система Ни Hadoop, ни HDFS не требуются Полезно

- 13. Загрузка данных LOAD loads input data Lines=LOAD ‘input/access.log’ AS (line: chararray); Проекция FOREACH … GENERTE …

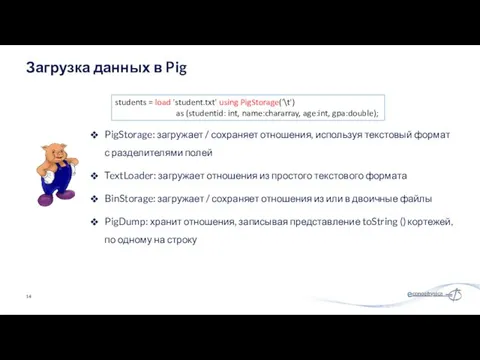

- 14. PigStorage: загружает / сохраняет отношения, используя текстовый формат с разделителями полей TextLoader: загружает отношения из простого

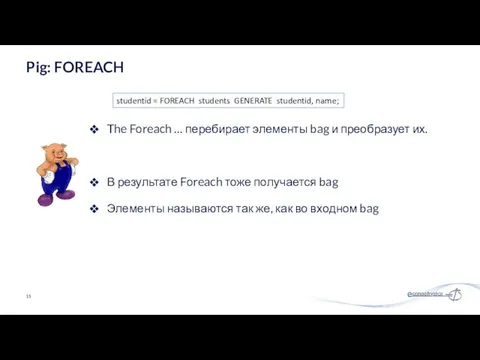

- 15. The Foreach … перебирает элементы bag и преобразует их. В результате Foreach тоже получается bag Элементы

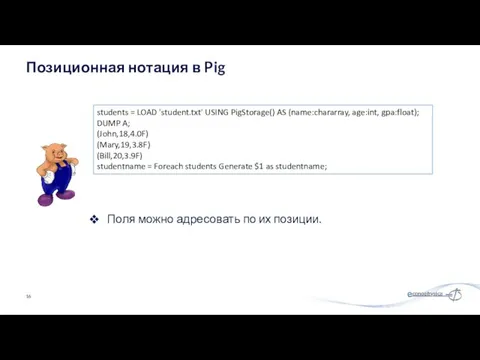

- 16. Поля можно адресовать по их позиции. Позиционная нотация в Pig students = LOAD 'student.txt' USING PigStorage()

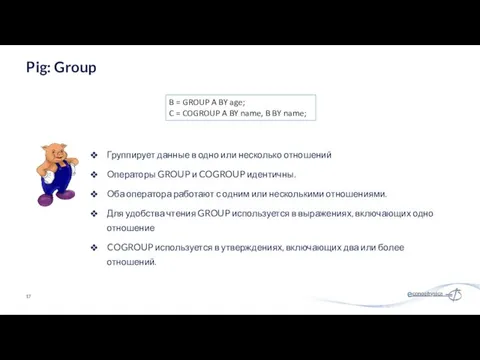

- 17. Группирует данные в одно или несколько отношений Операторы GROUP и COGROUP идентичны. Оба оператора работают с

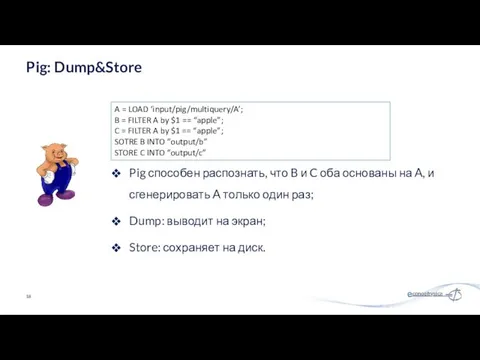

- 18. Pig: Dump&Store A = LOAD ‘input/pig/multiquery/A’; B = FILTER A by $1 == “apple”; C =

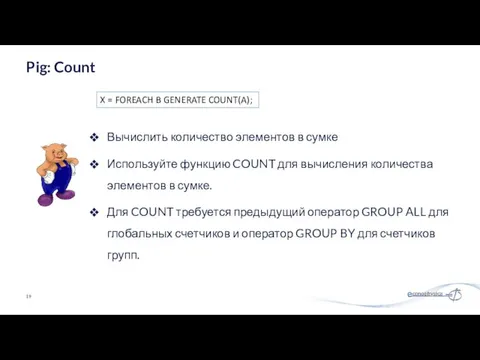

- 19. Вычислить количество элементов в сумке Используйте функцию COUNT для вычисления количества элементов в сумке. Для COUNT

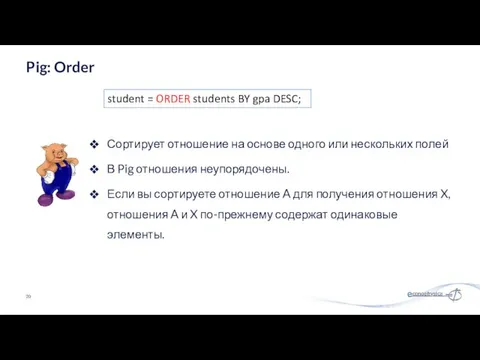

- 20. Сортирует отношение на основе одного или нескольких полей В Pig отношения неупорядочены. Если вы сортируете отношение

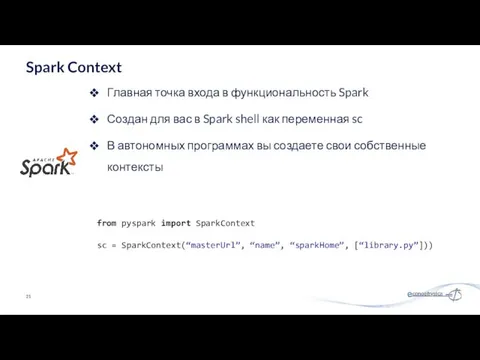

- 21. Главная точка входа в функциональность Spark Создан для вас в Spark shell как переменная sc В

- 22. # Превратить локальную коллекцию в RDD sc.parallelize ([1, 2, 3]) # Загрузить текстовый файл из локальной

- 23. nums = sc.parallelize ([1, 2, 3]) # Пропустить каждый элемент через функцию squares = nums.map (lambda

- 24. nums = sc.parallelize([1, 2, 3]) # Взять значение RDD в локальную переменную nums.collect() # => [1,

- 25. Подключиться к удаленной машине; Найти набор данных на удаленной машине командами HDFS; Оценить размер набора данных

- 26. Открыть оболочку командной строки Pig; Загрузить набор данных в Pig; Выполнить describe чтобы убедиться, что набор

- 27. Открыть оболочку командной строки Spark; Загрузить набор данных в Spark; Отфильтровать пассажиров по значению пола: женский;

- 28. Pclass Класс пассажира (1 = 1st; 2 = 2nd; 3 = 3rd) survival Выживание (0 =

- 29. Спасибо за внимание! mgubin@tpu.ru

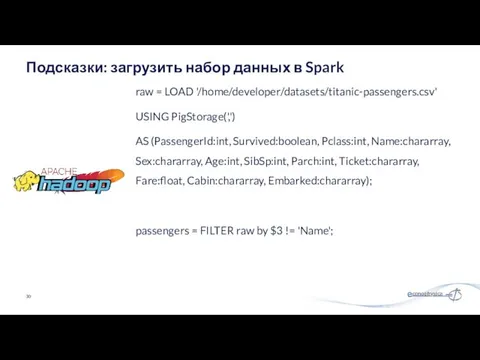

- 30. raw = LOAD '/home/developer/datasets/titanic-passengers.csv' USING PigStorage(',') AS (PassengerId:int, Survived:boolean, Pclass:int, Name:chararray, Sex:chararray, Age:int, SibSp:int, Parch:int, Ticket:chararray,

- 32. Скачать презентацию

![# Превратить локальную коллекцию в RDD sc.parallelize ([1, 2, 3])](/_ipx/f_webp&q_80&fit_contain&s_1440x1080/imagesDir/jpg/65354/slide-21.jpg)

![nums = sc.parallelize ([1, 2, 3]) # Пропустить каждый элемент](/_ipx/f_webp&q_80&fit_contain&s_1440x1080/imagesDir/jpg/65354/slide-22.jpg)

![nums = sc.parallelize([1, 2, 3]) # Взять значение RDD в](/_ipx/f_webp&q_80&fit_contain&s_1440x1080/imagesDir/jpg/65354/slide-23.jpg)

Презентация (татар теле)

Презентация (татар теле) Абиотические факторы среды. Температура

Абиотические факторы среды. Температура Основы VBA. Арифметические операторы VBA

Основы VBA. Арифметические операторы VBA Блеск и сила здоровых волос

Блеск и сила здоровых волос pifagoreyskaya_druzhba_etika_no_22

pifagoreyskaya_druzhba_etika_no_22 Хрящевая и костная ткани

Хрящевая и костная ткани Упаковка товара

Упаковка товара Первая помощь при разных критических ситуациях

Первая помощь при разных критических ситуациях Презентация по теме инновационного проекта

Презентация по теме инновационного проекта Проектная деятельность Новые педагогические технологии

Проектная деятельность Новые педагогические технологии Технология VLSM. Маски подсети переменной длины

Технология VLSM. Маски подсети переменной длины Презентация класса. 2 класс

Презентация класса. 2 класс Построение чертежа юбки

Построение чертежа юбки Викторина Наша древняя столица по книге Н.П. Кончаловской

Викторина Наша древняя столица по книге Н.П. Кончаловской Причины родовой боли. Обезболивание родов

Причины родовой боли. Обезболивание родов История движения Российских Студенческих отрядов

История движения Российских Студенческих отрядов Сталинградская битва - 200 дней и ночей

Сталинградская битва - 200 дней и ночей Хохломская роспись

Хохломская роспись Наземная цементировочная техника

Наземная цементировочная техника Холодная война. Сущность, признаки, истоки

Холодная война. Сущность, признаки, истоки Иллюстрации Ивана Билибина к Сказке о царе Салтане, о сыне его славном и могучем богатыре князе Гвидоне Салтановиче

Иллюстрации Ивана Билибина к Сказке о царе Салтане, о сыне его славном и могучем богатыре князе Гвидоне Салтановиче Системно-деятельностный подход

Системно-деятельностный подход Телерентгенография

Телерентгенография Схемы электроснабжения шахт и рудников

Схемы электроснабжения шахт и рудников Принцип развития: диалектика и синергетика

Принцип развития: диалектика и синергетика Українська вишиванка. Види орнаментів в українській вишиванці

Українська вишиванка. Види орнаментів в українській вишиванці Иоганн Себастьян Бах

Иоганн Себастьян Бах Религия как историко- культурный феномен

Религия как историко- культурный феномен