Содержание

- 2. Проверка https Если сайт не имеет SSL сертификата и открывается по адресу с http, необходимо настроить

- 3. Проверка главного зеркала Нужно выбрать главный вариант для адреса сайта между https://www.site.ru и https://site.ru Далее: -

- 4. Проверка редиректов Проверить корректность отработки 301 редиректов и отсутствие многоступенчатых редиректов. Для проверки взять 5-10 страниц

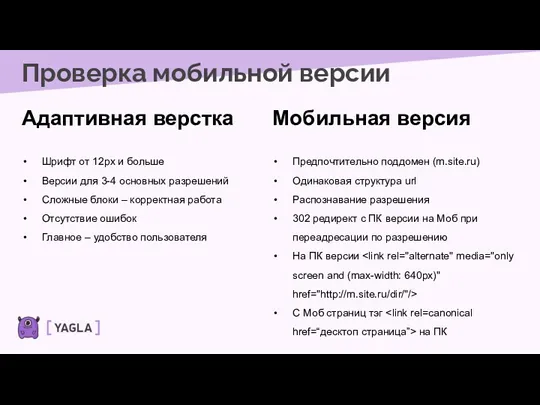

- 5. Проверка мобильной версии Адаптивная верстка Шрифт от 12px и больше Версии для 3-4 основных разрешений Сложные

- 6. Проверка скорости работы сайта Проверка скорости работы сайта, используем сервис https://developers.google.com/speed/pagespeed/insights/ Проверяем 5-10 страниц Показатель для

- 7. Сканирование сайта Для проверки всех страниц сайта (а также изображений, скриптов и тд.) примерно так как

- 8. Сканирование сайта Что ищем Битые (нерабочие) ссылки Страницы с кодом ответа отличным от 200 OK Дубли

- 9. Просмотр ошибок Яндекс Вебмастер Проверяем разделы ”Диагностика”, "Безопасность и нарушения”, "Страницы в поиске” Следуем рекомендациям сервиса,

- 10. Просмотр ошибок Google Search Console Проверяем разделы ”Покрытие”, ”Удобство страниц”, ”Удобство для мобильных”, ”Проверка кода”, ”Меры

- 11. Поиск дублей и неявных дублей Явный дубль – страницы полные копии друг друга Неявные дубли –

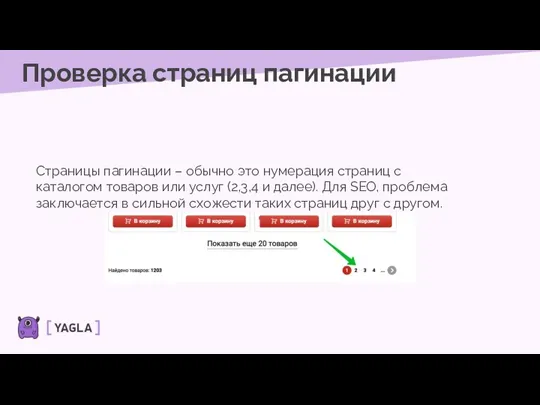

- 12. Проверка страниц пагинации Страницы пагинации – обычно это нумерация страниц с каталогом товаров или услуг (2,3,4

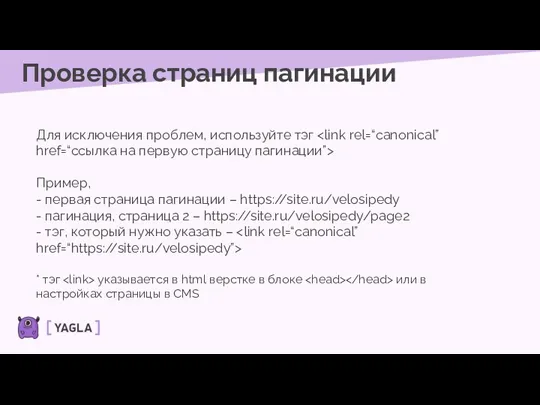

- 13. Проверка страниц пагинации Для исключения проблем, используйте тэг Пример, - первая страница пагинации – https://site.ru/velosipedy -

- 14. Проверка robots.txt и sitemap.xml Robots.txt – инструкции для роботов-пауков (краулеров) поисковых систем, указывают, что можно, а

- 15. Проверка robots.txt и sitemap.xml Robots.txt Настраивается индивидуально для каждого сайта. Важно знать атрибуты: - user-agent -

- 16. Проверка robots.txt и sitemap.xml Sitemap.xml Обычно формируется средствами CMS или программистами. Реже с помощью программ –

- 17. Проверка ЧПУ ЧПУ – формирование URL адресов страниц в формате понятном человеку. Непонятно (не ЧПУ): site.ru/catalog.php?brand=432&name=5433

- 18. Поиск неуникального контента Использование не уникальных текстов (в рамках интернета) на страницах сайта. Для проверки используются

- 20. Скачать презентацию

Служби миттєвого обміну повідомленнями (10 клас)

Служби миттєвого обміну повідомленнями (10 клас) Статический анализатор кода PVS-Studio

Статический анализатор кода PVS-Studio 25_28_Инф_безопасность

25_28_Инф_безопасность Проведённая работа на ГПО. Основы использования нейронной сети

Проведённая работа на ГПО. Основы использования нейронной сети Роль журналиста в обществе

Роль журналиста в обществе Прикладное решение для вузов 1С:Университет

Прикладное решение для вузов 1С:Университет linux (Линукс)

linux (Линукс) Sportarena. Сайт спортивных новостей

Sportarena. Сайт спортивных новостей Информатика. Что такое информатика

Информатика. Что такое информатика Основы работы с Docker

Основы работы с Docker Блок-схема - это графический способ представления алгоритма с помощью геометрических фигур, называемых блоками и стрелок

Блок-схема - это графический способ представления алгоритма с помощью геометрических фигур, называемых блоками и стрелок Нормативные принципы и теории функционирования СМИ

Нормативные принципы и теории функционирования СМИ Объектно-ориентированное программирование. Введение

Объектно-ориентированное программирование. Введение Введение в СУБД ORACLE. Лекция 1

Введение в СУБД ORACLE. Лекция 1 Моделирование как метод познания(информатика 9 кл)

Моделирование как метод познания(информатика 9 кл) Системы счисления

Системы счисления Файловые архивы. Общение в Интернете

Файловые архивы. Общение в Интернете Техническое обеспечение автоматизированных информационных систем

Техническое обеспечение автоматизированных информационных систем Вставка таблиц в HTML-документ

Вставка таблиц в HTML-документ Информационные ресурсы

Информационные ресурсы Кодирование текстовой информации. Кодирование и декодирование последовательностей

Кодирование текстовой информации. Кодирование и декодирование последовательностей Common Type System. Value and reference types in C#

Common Type System. Value and reference types in C# Веб 2.0 в продвижении услуг библиотеки

Веб 2.0 в продвижении услуг библиотеки Разработка электронного портала. Интернет представительства и их структура

Разработка электронного портала. Интернет представительства и их структура Научно-издательский центр ИНФРА-М

Научно-издательский центр ИНФРА-М Представление о программных средах компьютерной графики и черчения, мультимедийных средах

Представление о программных средах компьютерной графики и черчения, мультимедийных средах Моделирование на UML. Диаграммы. Лекция 2

Моделирование на UML. Диаграммы. Лекция 2 Неделя детской книги

Неделя детской книги