Содержание

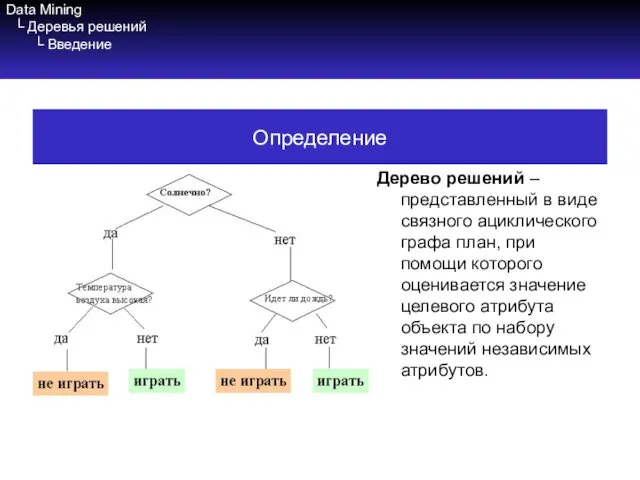

- 2. Data Mining └ Деревья решений └ Введение Дерево решений – представленный в виде связного ациклического графа

- 3. Data Mining └ Деревья решений └ Введение Если зависимая переменная принимает дискретные значения – решает задачу

- 4. Data Mining └ Деревья решений └ Введение Пример дерева и исходных данных

- 5. Data Mining └ Деревья решений └ Преимущества и недостатки Преимущества деревьев решений: Просты в понимании и

- 6. Data Mining └ Деревья решений └ Преимущества и недостатки Недостатки деревьев решений Проблема получения оптимального дерева

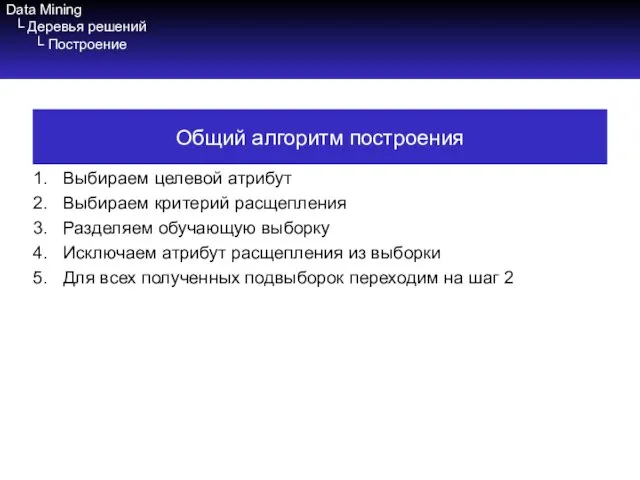

- 7. Data Mining └ Деревья решений └ Построение Выбираем целевой атрибут Выбираем критерий расщепления Разделяем обучающую выборку

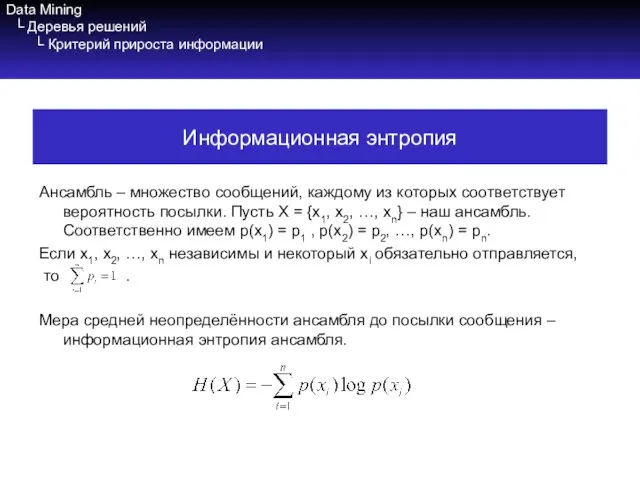

- 8. Data Mining └ Деревья решений └ Критерий прироста информации Ансамбль – множество сообщений, каждому из которых

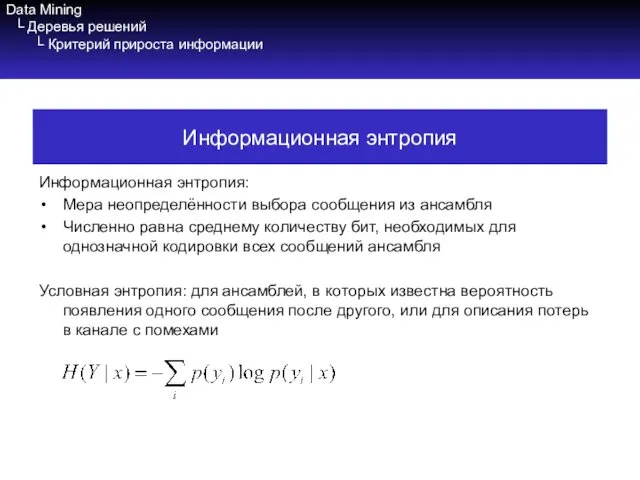

- 9. Data Mining └ Деревья решений └ Критерий прироста информации Информационная энтропия: Мера неопределённости выбора сообщения из

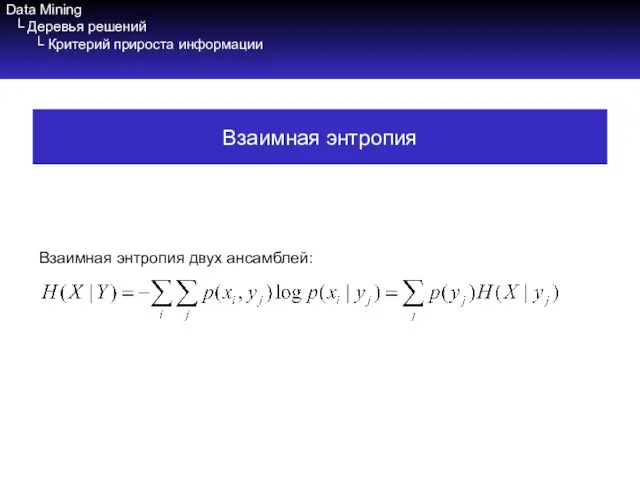

- 10. Data Mining └ Деревья решений └ Критерий прироста информации Взаимная энтропия двух ансамблей: Взаимная энтропия

- 11. Data Mining └ Деревья решений └ Критерий прироста информации Энтропия: Неотрицательна: H(X)≥0 Ограничена сверху: Для независимых

- 12. Data Mining └ Деревья решений └ Критерий прироста информации Взаимная информация (information gain): I(Y|X) = H(Y)

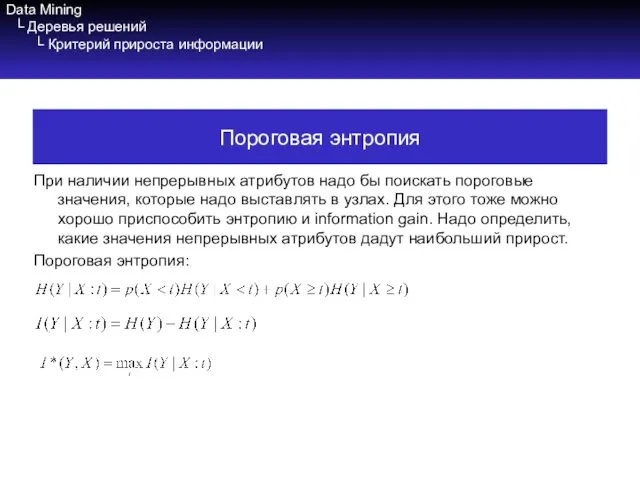

- 13. Data Mining └ Деревья решений └ Критерий прироста информации При наличии непрерывных атрибутов надо бы поискать

- 15. Скачать презентацию

Bhop school “long road” basic course of bunny-hopping

Bhop school “long road” basic course of bunny-hopping 3DMask. Разработка приложения для мобильных устройств

3DMask. Разработка приложения для мобильных устройств Back-end

Back-end ER-моделирование баз данных

ER-моделирование баз данных IMS. Подсистема IP мультимедиа

IMS. Подсистема IP мультимедиа Моделирование памяти. Информационные объекты MATRIX. Организация циклов

Моделирование памяти. Информационные объекты MATRIX. Организация циклов Искусственный интеллект

Искусственный интеллект Информационное обеспечение логистики

Информационное обеспечение логистики Использование программы киностудия Windows Live в образовательном процессе

Использование программы киностудия Windows Live в образовательном процессе Точні та наближені алгоритми мінімізації числа виконавців при заданих директивних термінах

Точні та наближені алгоритми мінімізації числа виконавців при заданих директивних термінах Создание коллажа в программе Photoshop

Создание коллажа в программе Photoshop Государственная политика в информационной сфере

Государственная политика в информационной сфере Альтернативный интернет

Альтернативный интернет Адресация компьютеров в сети

Адресация компьютеров в сети ISO normy w IT

ISO normy w IT Writing. An e-mail of request

Writing. An e-mail of request Битрикс24

Битрикс24 Серверы. Протоколы Интернета

Серверы. Протоколы Интернета Технологии доступа к данным в среде Visual Studio 2010 (Лекция 18)

Технологии доступа к данным в среде Visual Studio 2010 (Лекция 18) Вирусы и антивирусные программы

Вирусы и антивирусные программы Технологии аналитики и визуализации больших данных (лекция № 7)

Технологии аналитики и визуализации больших данных (лекция № 7) Форумы

Форумы Ақпараттық технология. АТ күнделікті өмірдегі маңызы. АТ қолданудың мақсаты. АТ перспективасы. АТ адамға кері әсері

Ақпараттық технология. АТ күнделікті өмірдегі маңызы. АТ қолданудың мақсаты. АТ перспективасы. АТ адамға кері әсері Создание Web-сайта

Создание Web-сайта Циклические структуры

Циклические структуры Spring Colours

Spring Colours Личности в истории информатики. Джон Непер

Личности в истории информатики. Джон Непер Образовательная платформа ЮРАЙТ для профессионального образования

Образовательная платформа ЮРАЙТ для профессионального образования