Содержание

- 2. Что означает термин “информатика” ? Что такое информация? “Информатика” - это франкоязычный синоним более распространенного в

- 3. С в о й с т в а и н ф о р м а ц

- 4. Д о с т у п н о с т ь информации – мера возможности получить

- 5. Что можно делать с информацией ? Информацию можно: создавать; передавать; воспринимать; запоминать; искать; копировать; В каком

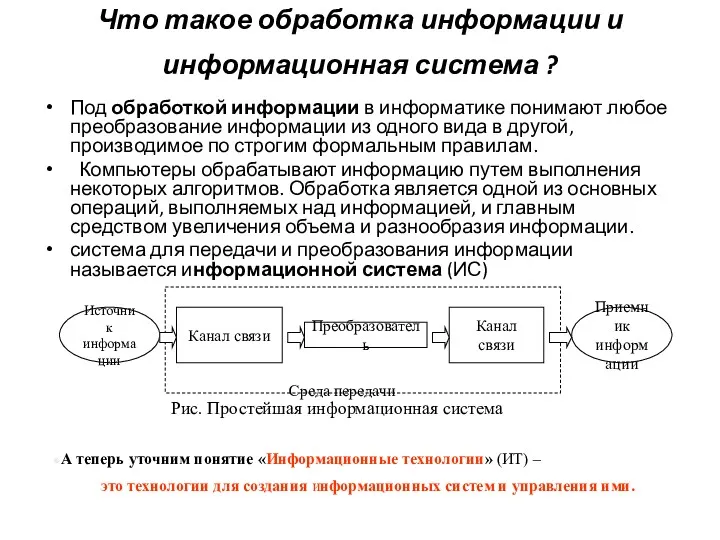

- 6. Что такое обработка информации и информационная система ? Под обработкой информации в информатике понимают любое преобразование

- 7. Эволюция информатики Истоки и этапы развития ИТ На ранних этапах развития общества профессиональные навыки передавались в

- 8. Второй этап развития информационной технологии начал свой отсчет около 6 тыс. лет назад и связан с

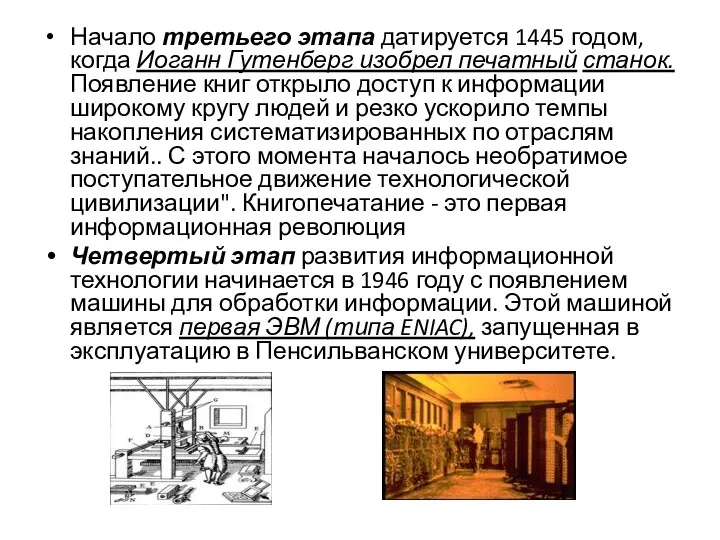

- 9. Начало третьего этапа датируется 1445 годом, когда Иоганн Гутенберг изобрел печатный станок. Появление книг открыло доступ

- 10. Пятый этап развития информационной технологии наступил в 1982 году после публикации эталонной модели взаимодействия открытых систем

- 11. Эволюция информатики Информационный кризис Человечество в процессе своего существования прежде всего уделяло внимание созданию о рудий

- 12. Эти причины породили весьма парадоксальную ситуацию — в мире накоплен громадный информационный потенциал, но люди не

- 13. ДВА ПОДХОДА К ИЗМЕРЕНИЮ КОЛИЧЕСТВА ИНФОРМАЦИИ. Вопрос “как измерить информацию?” Ответ на него зависит от того,

- 14. Под информацией в быту (житейский аспект) понимают сведения об окружающем мире и протекающих в нем процессах,

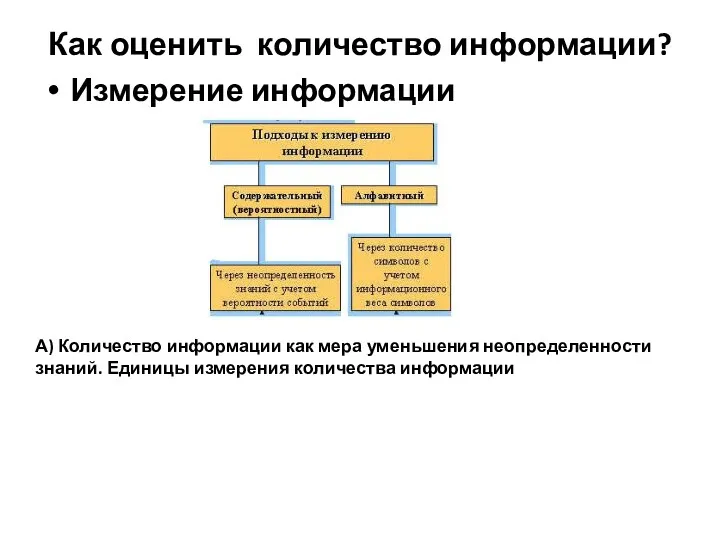

- 15. Как оценить количество информации? Измерение информации А) Количество информации как мера уменьшения неопределенности знаний. Единицы измерения

- 16. Формула Шеннона. Количество информации как мера уменьшения неопределенности знаний. Информацию, которую получает человек, можно считать мерой

- 17. Единицы измерения количества информации. За единицу количества информации принят 1 бит - количество информации, содержащееся в

- 18. Пример. После экзамена по информатике, который сдавали ваши друзья, объявляются оценки ("2", "3", "4" или "5").

- 19. Алфавитный подход к измерению информации позволяет определить количество информации, заключенной тексте. Алфавитный подход является объективным, т.е.

- 20. Информационный объем сообщения (информационная емкость сообщения) – количество информации в сообщении, измеренное в битах, байтах или

- 21. ИСТОРИЯ РАЗВИТИЯ СРЕДСТВ ВЫЧИСЛИТЕЛЬНОЙ ТЕХНИКИ

- 22. Историческая справка Абак (500 н.э.) 1614 г. Джон Непер таблицы логарифмов 1620 г. Р. Биссакар логарифмическая

- 23. 1642 г. Блез Паскаль арифметическая машина

- 24. ЛЕЙБНИЦ (Leibniz) Готфрид Вильгельм (1 июля 1646, Лейпциг — 14 ноября 1716, Ганновер), немецкий философ, математик,

- 25. 1834 г. Чарльз Бэббидж составил проект "аналитической" машины

- 26. 1930 г. Вэннивер Буш построил дифферен-циальный анализатор 1936 г. Алан Тьюринг и независимо от него Э.

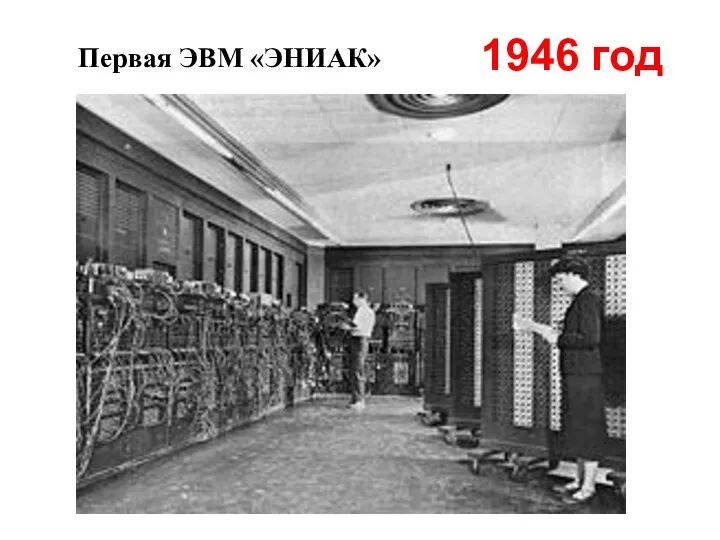

- 27. 1945 г. Джон фон Нейман основные принципы работы и компоненты современных компьютеров 1946 г. Дж. Эккерт

- 28. Структура ЭВМ фон Неймана

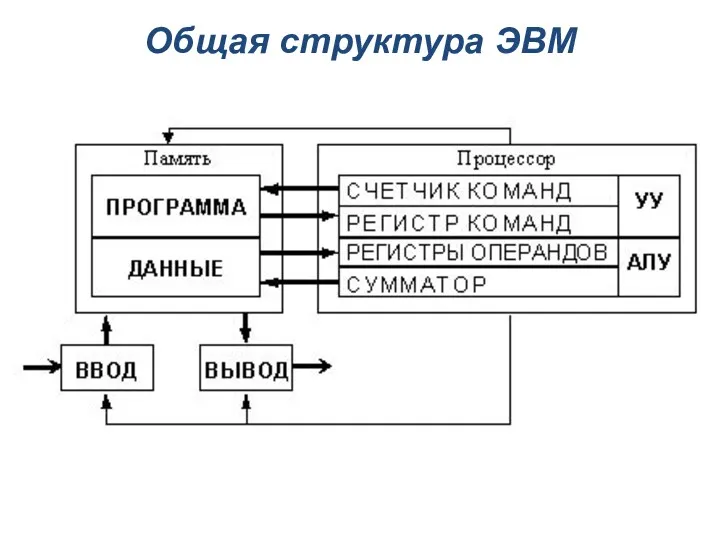

- 29. Общая структура ЭВМ

- 30. 1948 г. Bell Laboratories Уильям Шокли, Уолтер Браттейн и Джон Бардин создали транзистор 1957 г. Американской

- 31. 1951 г. МЭСМ (малая электронная счетная машина) Создатель Сергей Алексеевич Лебедев 1952 г. БЭСМ—1 (большая электронная

- 32. 1958 г. Джек Килби из фирмы Texas Instruments создал первую интегральную схему

- 33. 1957 г. язык Фортран (Джон Бэкус). 1959 г. язык Алгол 1965 г. язык Бейсик (Дж. Кемени

- 34. 1968 г. Основана фирма Intel 1973 г. Фирма IBM (International Business Machines Corporation) первый жёсткий диск

- 35. 1980 г. Control Data суперкомпьютер Cyber 205. 1980 г. компании Sharp, Sanyo, Panasonic, Casio и американская

- 36. 1983 г. Гибкие диски 1984 г. Laptop 1984 г. CD-ROM. 1984 г. Корпорация Apple Computer компьютер

- 37. 1984 г. компьютерная сеть FIDO (Том Дженнингс и Джон Мэдил). 1985 г. объектно-ориентированный язык С++ (Бьярн

- 38. 1992 г. web-браузер Mosaic (Эрик Бина и Марк Андриссен) 1994 г. браузер Netscape Navigator. 1995 г.

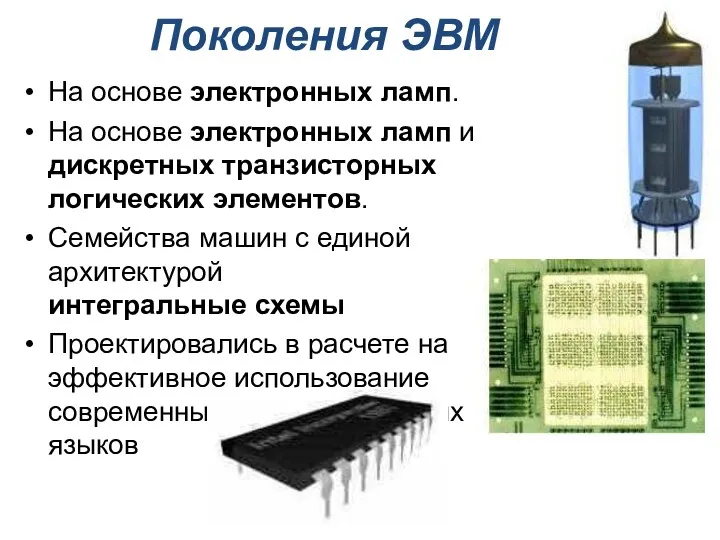

- 39. Поколения ЭВМ На основе электронных ламп. На основе электронных ламп и дискретных транзисторных логических элементов. Семейства

- 40. Первая ЭВМ «ЭНИАК» 1946 год

- 41. ЭВМ второго поколения 1959 - 1967 года

- 42. ЭВМ третьего поколения 1968 - 1973 года Первая интегральная микросхема, выпущенная компанией Texas Instruments

- 43. ЭВМ четвертого поколения с 1974 года до наших дней В 1971 году фирмой Intel (США) создан

- 44. Основы построения ЭВМ Принципы функционирования универсальных вычислительных устройств: 1. Принцип программного управления. 2. Принцип однородности памяти.

- 46. Скачать презентацию

Отличительные особенности электронной деловой переписки

Отличительные особенности электронной деловой переписки Инструментальные программные средства. Системы программирования

Инструментальные программные средства. Системы программирования Трансляция программы. Лекция 3

Трансляция программы. Лекция 3 Составление отчёта по выявленному нарушению в ППК ПАБ

Составление отчёта по выявленному нарушению в ППК ПАБ 1015355

1015355 История средств хранения, передачи и обработки информации. 9 класс

История средств хранения, передачи и обработки информации. 9 класс Системи автоматизованого проектування (САПР). Лекция 1

Системи автоматизованого проектування (САПР). Лекция 1 Современная поэзия. Где смотреть

Современная поэзия. Где смотреть Информационные ресурсы и сервисы интернета. Коммуникационные технологии

Информационные ресурсы и сервисы интернета. Коммуникационные технологии Диаграмма композитной структуры. Диаграмма пакетов. Диаграмма объектов

Диаграмма композитной структуры. Диаграмма пакетов. Диаграмма объектов Подключение к глобальной сети. Лекция 7

Подключение к глобальной сети. Лекция 7 KELI GROUP. Features

KELI GROUP. Features Find numbers 0-10 and click them

Find numbers 0-10 and click them Программный продукт ЭкоСфера-предприятие

Программный продукт ЭкоСфера-предприятие Основные этапы моделирования

Основные этапы моделирования Создание документов в WORD

Создание документов в WORD Blockchain - журнал с записями в хронологическом порядке

Blockchain - журнал с записями в хронологическом порядке Методы программирования в реальном времени

Методы программирования в реальном времени Язык SQL для работы с базами данных

Язык SQL для работы с базами данных САПР: системы автоматизированного проектирования

САПР: системы автоматизированного проектирования Тестирование документации

Тестирование документации Алгоритмы с повторением

Алгоритмы с повторением Quantitative research in management: methodology. Introduction to IBM SPSS

Quantitative research in management: methodology. Introduction to IBM SPSS Компьютерные сети. Адреса в интернете

Компьютерные сети. Адреса в интернете Информация в живой и неживой природе. Информационные процессы

Информация в живой и неживой природе. Информационные процессы Брейн ринг по информатике

Брейн ринг по информатике Составление библиографического описания: библиографическое описание документа, общие требования

Составление библиографического описания: библиографическое описание документа, общие требования От скуки на все руки. Кроссворд

От скуки на все руки. Кроссворд