Содержание

- 2. Литература Хайкин С. Нейронные сети. Полный курс, 2-е изд. – М.: «И.Д. Вильямс», 2016. Галушкин А.И.

- 3. Искусственные нейронные сети – вычислительные структуры, которые моделируют процессы человеческого мозга Способность к обучению Искусственный нейрон

- 4. 1904 С.Рамон-и-Кахаль Открытие нейронов – нервных клеток 1943 У.Мак-Каллок, У.Питтс Модель искусственного нейрона; основные принципы построения

- 5. 1957 В.И.Арнольд, А.Н.Колмогоров Решение 13 проблемы Гильберта: любую непрерывную функцию многих переменных можно представить как суперпозицию

- 6. Немного истории 1986 Д.Румельхарт, Дж.Хинтон, Р.Вильямс Метод обратного распространения ошибки Середина 1980х Нейросетевой бум Новые модели

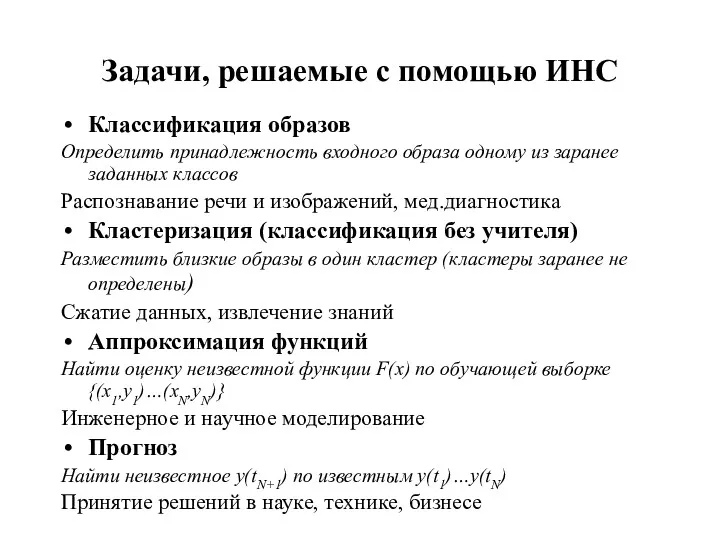

- 7. Задачи, решаемые с помощью ИНС Классификация образов Определить принадлежность входного образа одному из заранее заданных классов

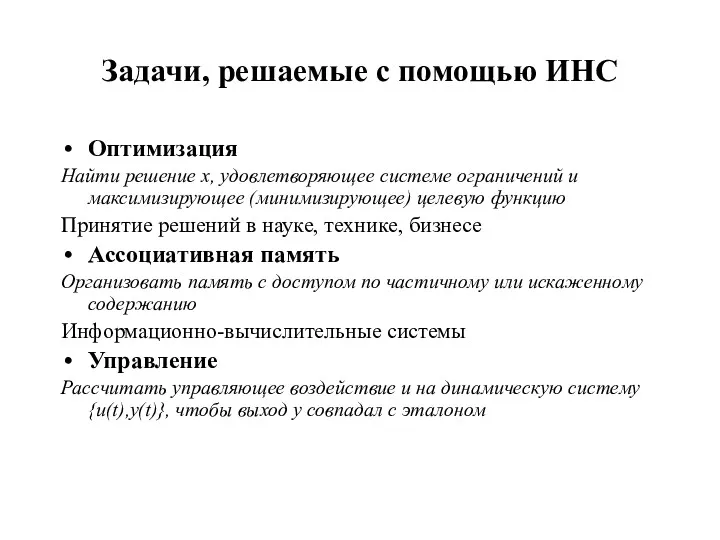

- 8. Оптимизация Найти решение x, удовлетворяющее системе ограничений и максимизирующее (минимизирующее) целевую функцию Принятие решений в науке,

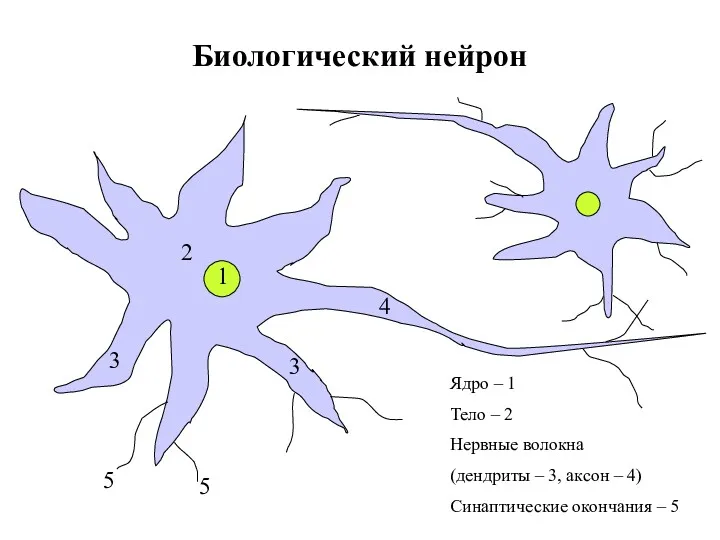

- 9. Биологический нейрон Ядро – 1 Тело – 2 Нервные волокна (дендриты – 3, аксон – 4)

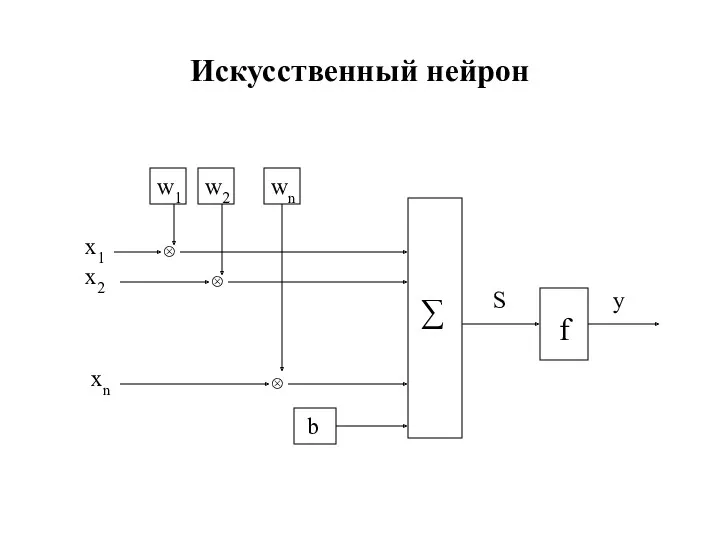

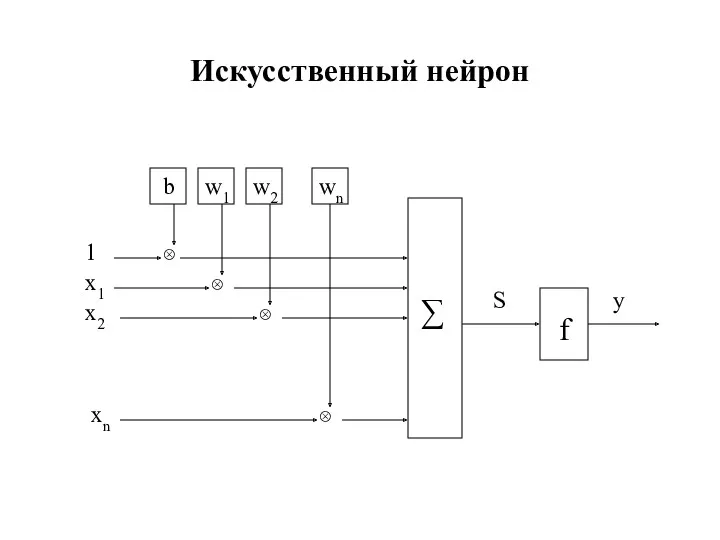

- 10. Искусственный нейрон ⊗ ⊗ b ∑ f w1 w2 wn ⊗ x1 x2 xn S y

- 11. Искусственный нейрон ∑ f ⊗ ⊗ w1 w2 wn ⊗ x1 x2 xn S y ⊗

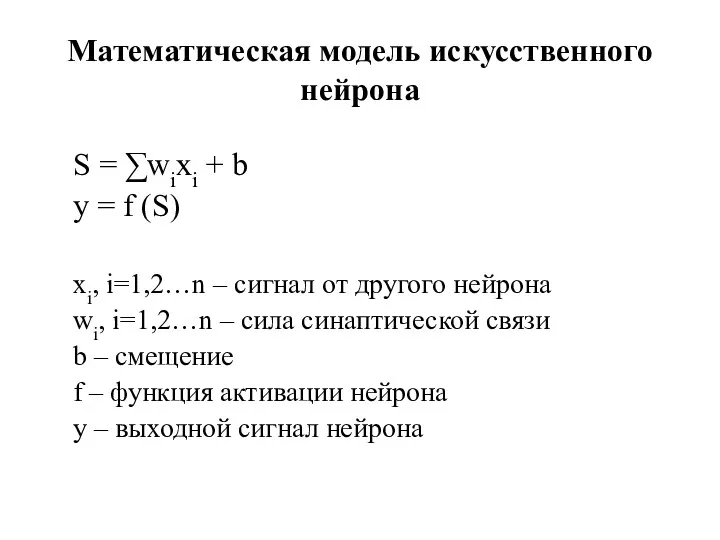

- 12. Математическая модель искусственного нейрона S = ∑wixi + b y = f (S) xi, i=1,2…n –

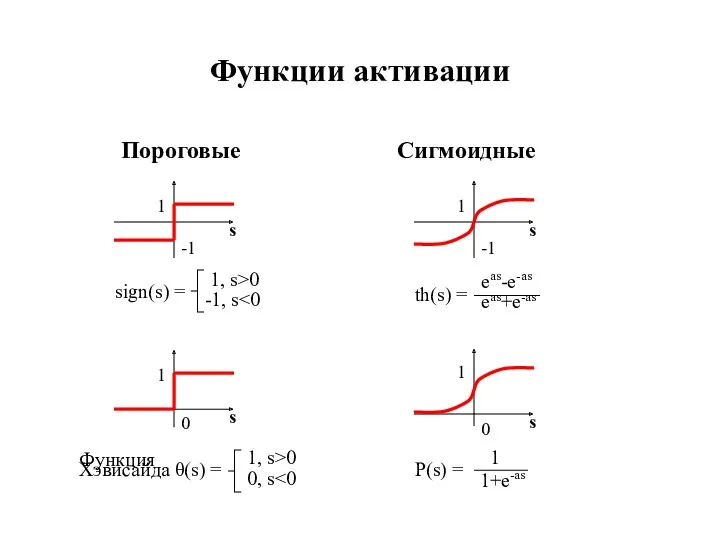

- 13. Функции активации Пороговые Сигмоидные s

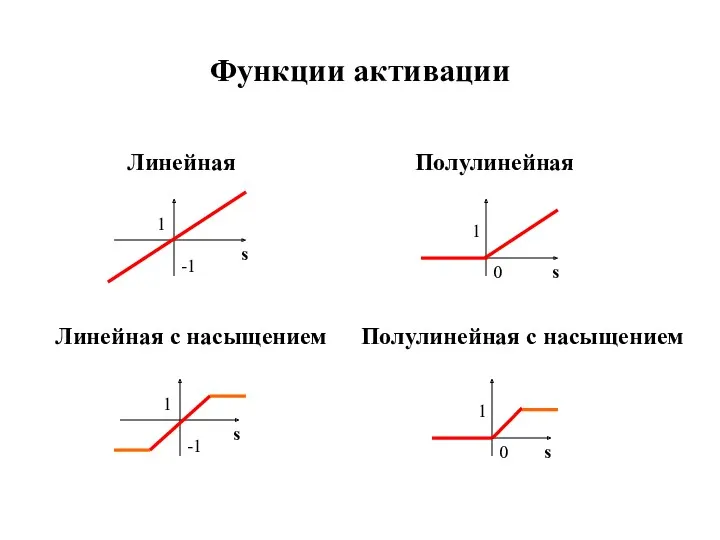

- 14. Линейная Полулинейная Линейная с насыщением Полулинейная с насыщением 1 -1 1 0 s s Функции активации

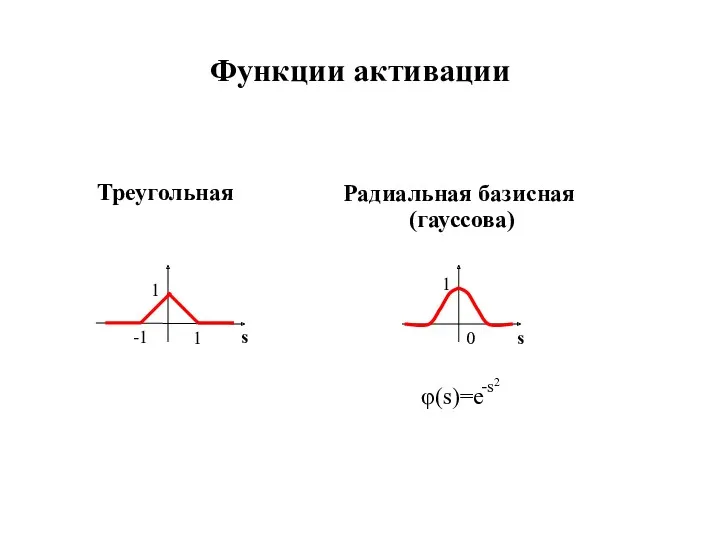

- 15. Треугольная Радиальная базисная (гауссова) Функции активации

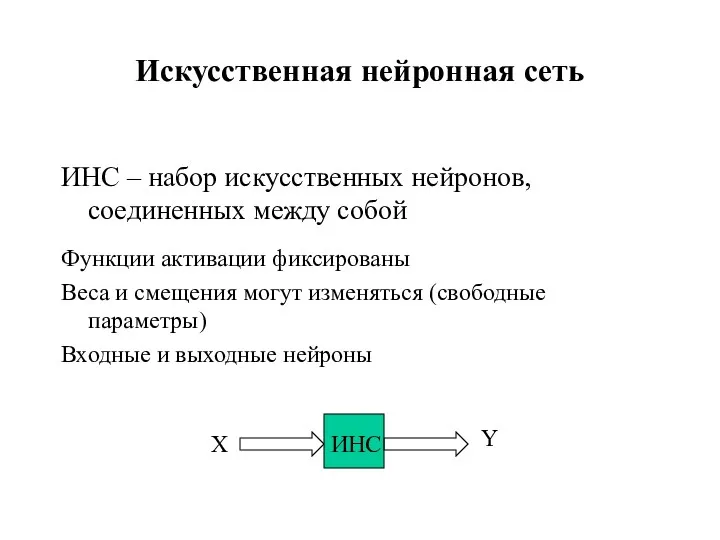

- 16. Искусственная нейронная сеть ИНС – набор искусственных нейронов, соединенных между собой Функции активации фиксированы Веса и

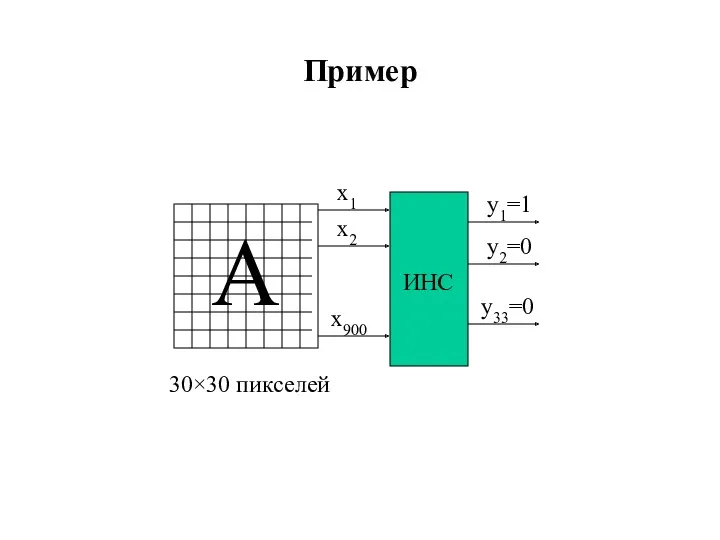

- 17. Пример

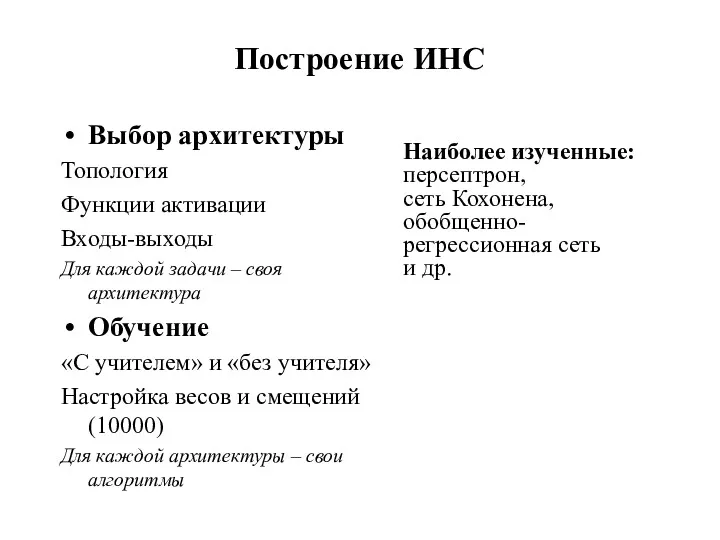

- 18. Построение ИНС Выбор архитектуры Топология Функции активации Входы-выходы Для каждой задачи – своя архитектура Обучение «С

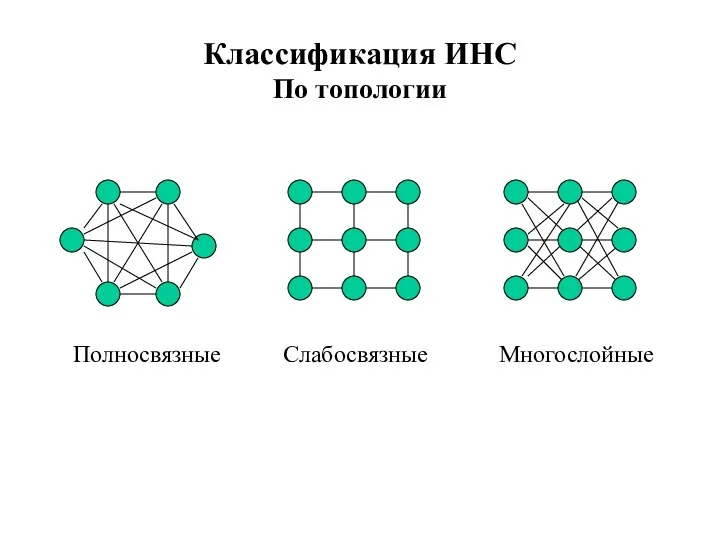

- 19. Классификация ИНС По топологии Полносвязные Слабосвязные Многослойные

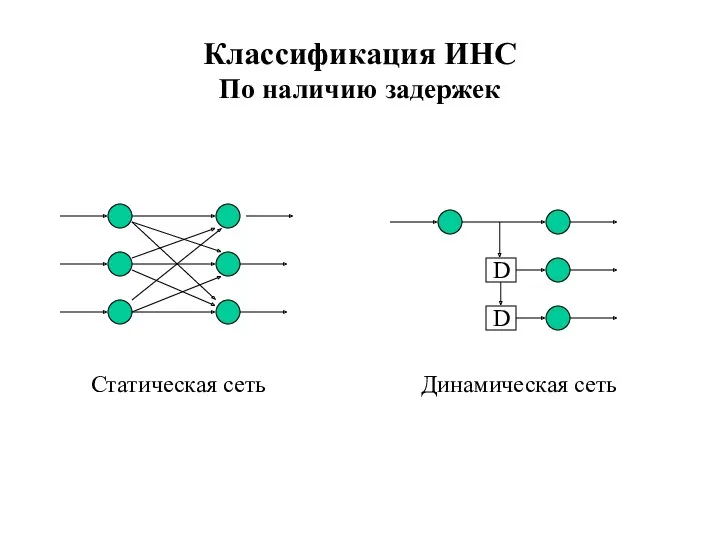

- 20. Классификация ИНС По наличию задержек Статическая сеть Динамическая сеть D D

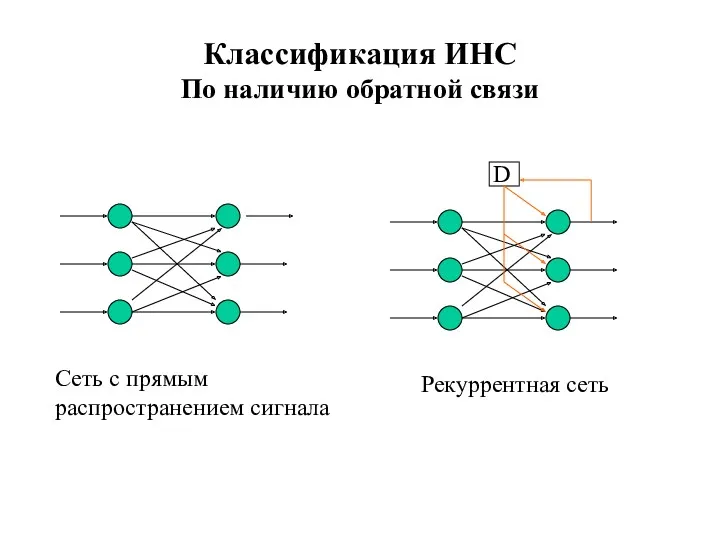

- 21. Классификация ИНС По наличию обратной связи

- 22. По функциям активации Однородные Неоднородные По типу входного сигнала Бинарный Целый Действительный Классификация ИНС

- 23. Увеличение числа слоев и числа нейронов повышает возможности сети, но замедляет обучение Введение обратных связей повышает

- 24. Обучение ИНС Нейронная сеть – адаптивная система Способность сети обрабатывать информацию развивается в результате обучения на

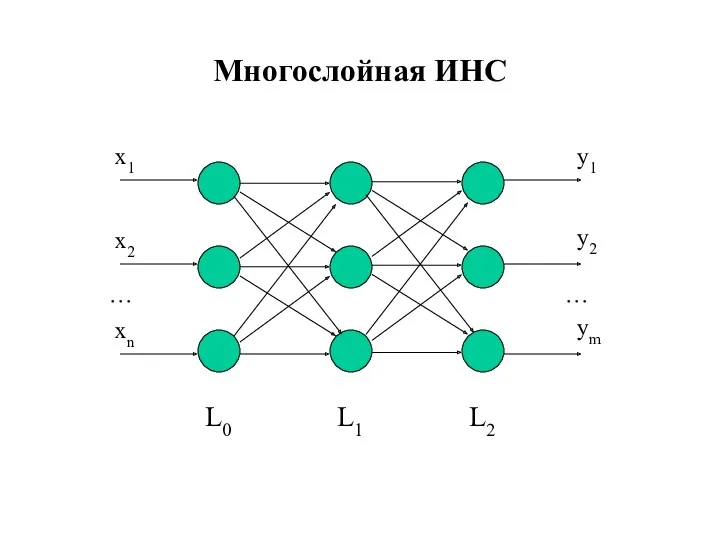

- 25. Многослойная ИНС x1 x2 xn y1 y2 ym … … L0 L1 L2

- 26. Теоретические результаты Теорема Хехт-Нильсена m-мерная функция от n переменных с заданной точностью может быть приближена функцией,

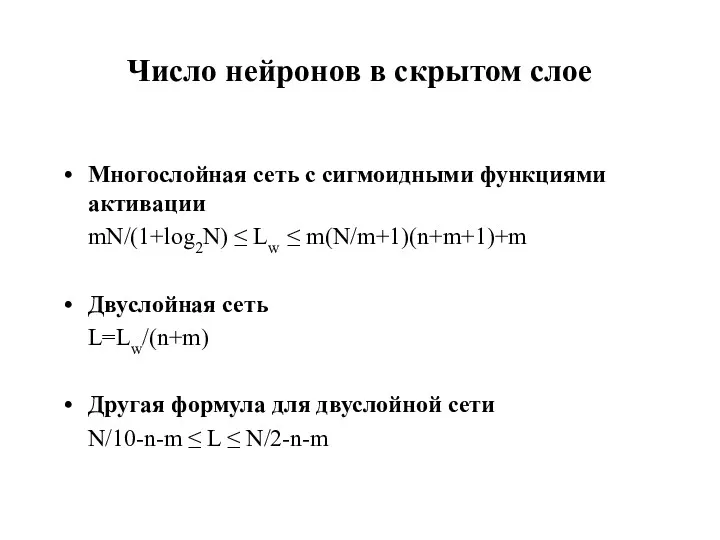

- 27. Число нейронов в скрытом слое Многослойная сеть с сигмоидными функциями активации mN/(1+log2N) ≤ Lw ≤ m(N/m+1)(n+m+1)+m

- 28. Отсутствует строгая теория, касающаяся Многослойных сетей (число слоев больше 2) Большинства рекуррентных сетей Сетей со связями

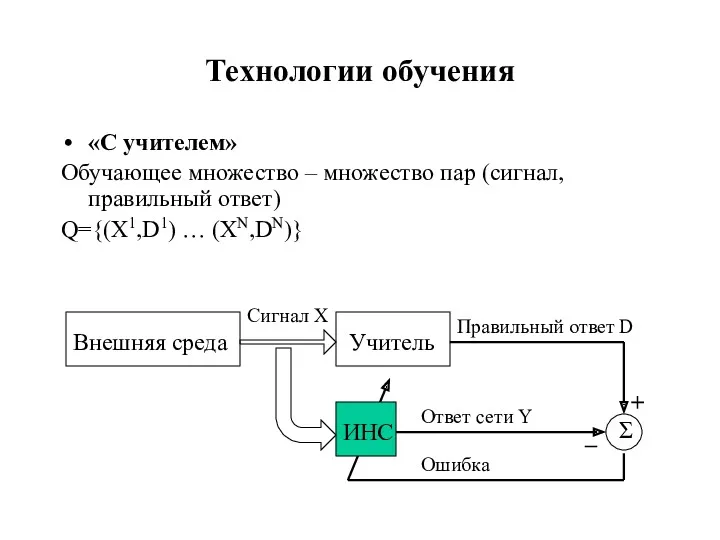

- 29. Технологии обучения «С учителем» Обучающее множество – множество пар (сигнал, правильный ответ) Q={(X1,D1) … (XN,DN)}

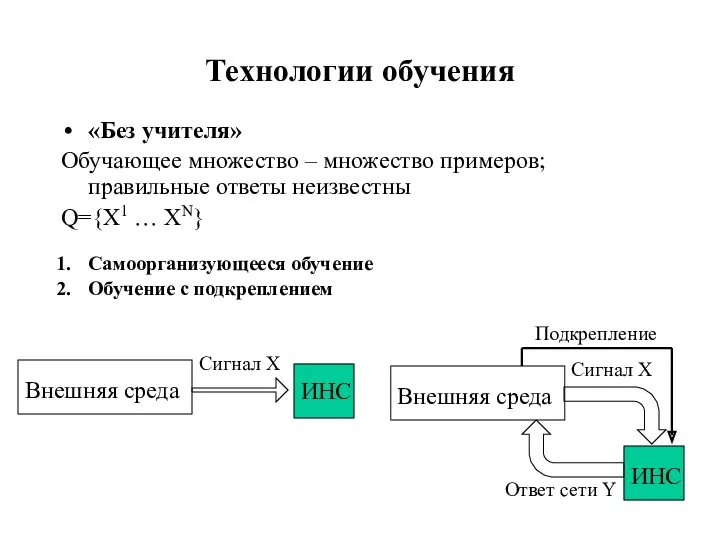

- 30. Технологии обучения «Без учителя» Обучающее множество – множество примеров; правильные ответы неизвестны Q={X1 … XN} Самоорганизующееся

- 31. Сеть обучена, если она дает правильные ответы на примеры из обучающего множества Сеть способна к обобщению,

- 32. Обучение «с учителем» Имеется неизвестная функция Y=F(X), X∈G⊆ Rn, Y∈Rm Задано множество Q={(X1,D1) … (XN,DN)}, где

- 33. Проблемы обучения Недообучение Сеть недостаточно точно аппроксимирует данные обучающего множества (не способна обучиться) Усложнить сеть Переобучение

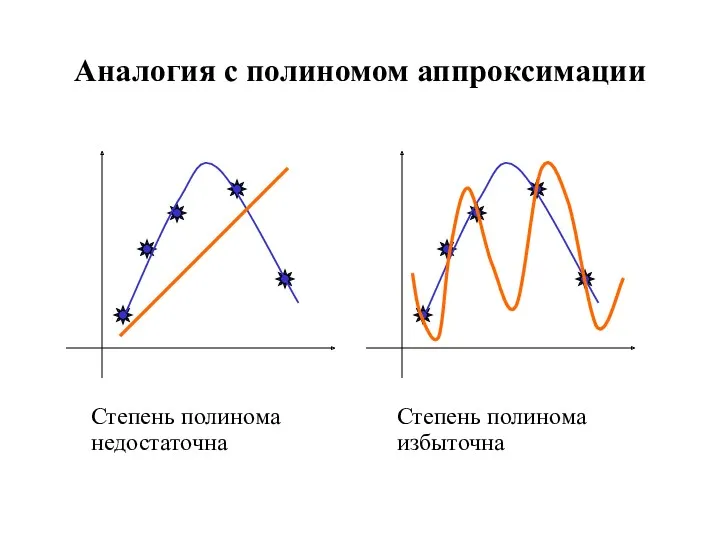

- 34. Аналогия с полиномом аппроксимации Степень полинома недостаточна Степень полинома избыточна

- 35. Контрольное и тестовое множества Как проверить качество обучения? Кросс-проверка Q=Q1∪Q2 (обучающее+контрольное) E(Q1) и E(Q2) убывают –

- 36. Обучение ИНС – задача многомерной оптимизации Задача оптимизации: min E(W) W Произвольный вид функции E, большая

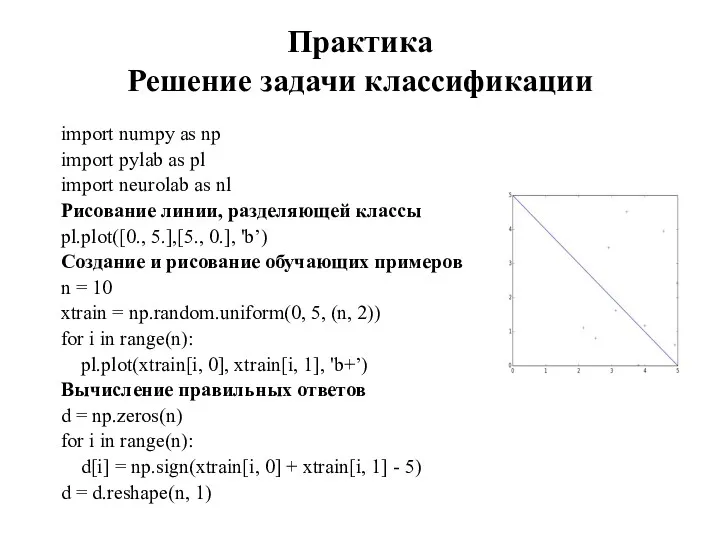

- 37. Практика Решение задачи классификации import numpy as np import pylab as pl import neurolab as nl

- 38. Практика Решение задачи классификации Создание сети прямого распространения с сигмоидными функциями активации MyFirstNet = nl.net.newff([[0, 5],

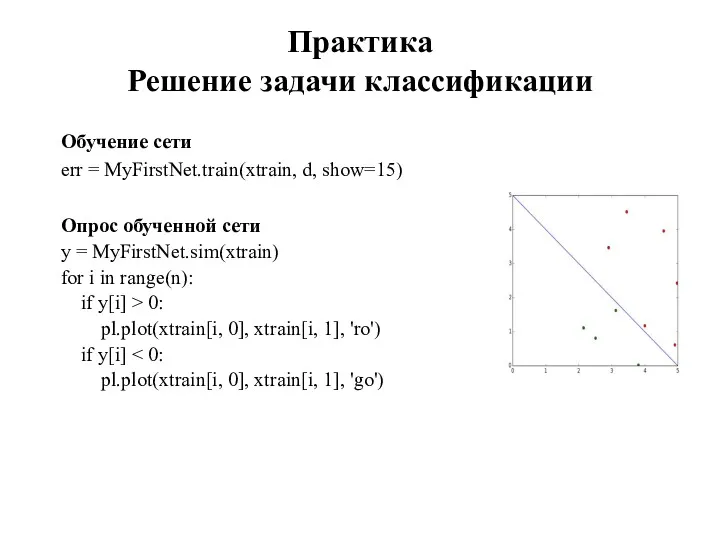

- 39. Обучение сети err = MyFirstNet.train(xtrain, d, show=15) Опрос обученной сети y = MyFirstNet.sim(xtrain) for i in

- 40. Создание тестового множества ntest = 25 * 25 xtest = np.zeros(ntest * 2) xtest = xtest.reshape(ntest,

- 42. Скачать презентацию

Виды Баз Данных

Виды Баз Данных Модель OSI и стек TCP/IP

Модель OSI и стек TCP/IP Готовимся в проектной работе

Готовимся в проектной работе Корпоративные системы электронного документооборота. Классификация систем электронного документооборота

Корпоративные системы электронного документооборота. Классификация систем электронного документооборота Положення та принципи організації комп’ютерної технології на підприємстві

Положення та принципи організації комп’ютерної технології на підприємстві Влияние цифровизации на здравоохранение

Влияние цифровизации на здравоохранение Определение и проблемы языков программирования

Определение и проблемы языков программирования Помехоустойчивое кодирование. Линейные коды

Помехоустойчивое кодирование. Линейные коды Вредоносное программное обеспечение. Описание. Классификация

Вредоносное программное обеспечение. Описание. Классификация Сравнительный анализ дизайна интернет-сайтов

Сравнительный анализ дизайна интернет-сайтов Інформаційні технології та системи в економіці: визначення, еволюція та сучасна класифікація

Інформаційні технології та системи в економіці: визначення, еволюція та сучасна класифікація Jizzax viloyat xalq ta’limi xodimlarini qayta tayyorlash va ularning malakasini oshirish hududiy markazi tomonidan tayyorlangan

Jizzax viloyat xalq ta’limi xodimlarini qayta tayyorlash va ularning malakasini oshirish hududiy markazi tomonidan tayyorlangan Програмне забезпечення комп’ютера за новою програмою

Програмне забезпечення комп’ютера за новою програмою Создание веб-сайтов

Создание веб-сайтов Миниатюра аватара

Миниатюра аватара Открытость деятельности органов власти

Открытость деятельности органов власти Моделирование равноускоренного движения в электронных таблицах

Моделирование равноускоренного движения в электронных таблицах Автоматизированное тестирование

Автоматизированное тестирование Понятие информации и измерение информации

Понятие информации и измерение информации Создание однотабличной и многотабличной базы данных

Создание однотабличной и многотабличной базы данных Дизайн приложения и функций. Приложения “Родитель ” или “Ребенок ”

Дизайн приложения и функций. Приложения “Родитель ” или “Ребенок ” Программа для программирования Scratch

Программа для программирования Scratch Методология и этапы проектирования баз данных

Методология и этапы проектирования баз данных Покадрова анімація. Анімація на основі фотоколажу. Експортування анімації

Покадрова анімація. Анімація на основі фотоколажу. Експортування анімації Язык программирования Go

Язык программирования Go История развития глобальных сетей

История развития глобальных сетей Информационная система персональных данных

Информационная система персональных данных Программирование на языке Python 8 класс

Программирование на языке Python 8 класс