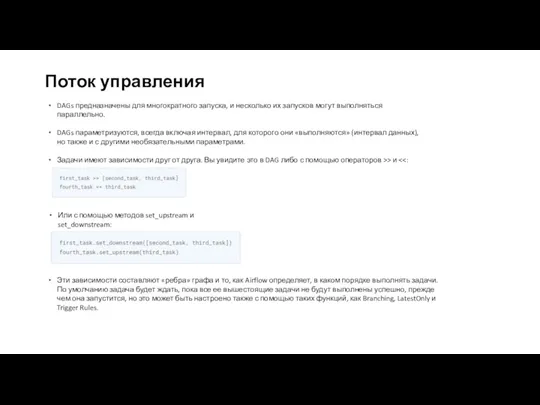

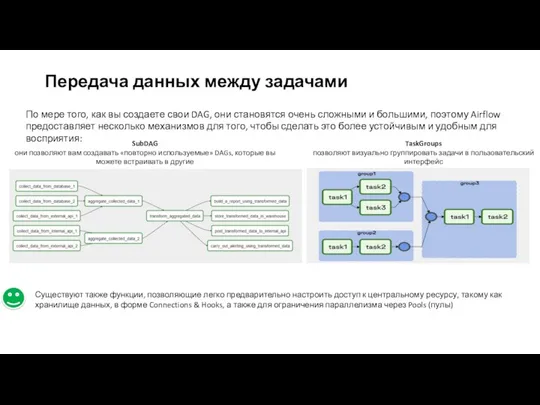

Поток управления

DAGs предназначены для многократного запуска, и несколько их запусков могут

выполняться параллельно.

DAGs параметризуются, всегда включая интервал, для которого они «выполняются» (интервал данных), но также и с другими необязательными параметрами.

Задачи имеют зависимости друг от друга. Вы увидите это в DAG либо с помощью операторов >> и <<:

Или с помощью методов set_upstream и set_downstream:

Эти зависимости составляют «ребра» графа и то, как Airflow определяет, в каком порядке выполнять задачи. По умолчанию задача будет ждать, пока все ее вышестоящие задачи не будут выполнены успешно, прежде чем она запустится, но это может быть настроено также с помощью таких функций, как Branching, LatestOnly и Trigger Rules.

Презентация по информатике 6 класс Компьютер - универсальная машина для работы с информацией

Презентация по информатике 6 класс Компьютер - универсальная машина для работы с информацией Business Studio - инструмент для проектирования бизнес-архитектуры

Business Studio - инструмент для проектирования бизнес-архитектуры Основы логики

Основы логики Жүйелік және қолданбалы программалау. Системное и прикладное программирование

Жүйелік және қолданбалы программалау. Системное и прикладное программирование Программно-аппаратный комплекс управления индивидуально-тренировочным процессом

Программно-аппаратный комплекс управления индивидуально-тренировочным процессом Разработка WPF приложений в стиле ViewModel First

Разработка WPF приложений в стиле ViewModel First АРМ Реестр государственных и муниципальных услуг

АРМ Реестр государственных и муниципальных услуг Мәліметтер қорымен жұмыс

Мәліметтер қорымен жұмыс Запуск программы для выполнением ВПР учащимся

Запуск программы для выполнением ВПР учащимся Центры обработки данных, как средство реализации информационных технологий. (Лекция 11)

Центры обработки данных, как средство реализации информационных технологий. (Лекция 11) Технические средства телеком-муникационных технологий

Технические средства телеком-муникационных технологий C#: циклы, массивы

C#: циклы, массивы Электронная цифровая подпись (ЭЦП)

Электронная цифровая подпись (ЭЦП) Представление информации

Представление информации Презентация проекта МТПЛ Использование ИКТ в организации коррекционно - образовательного пространства для детей групп компенсирующей направленности

Презентация проекта МТПЛ Использование ИКТ в организации коррекционно - образовательного пространства для детей групп компенсирующей направленности Введение в теорию графов

Введение в теорию графов Информационные ресурсы для научной работы

Информационные ресурсы для научной работы Телеграм бот для видеоигр

Телеграм бот для видеоигр Искусственный интеллект и ЭВМ

Искусственный интеллект и ЭВМ Архитектура персонального компьютера

Архитектура персонального компьютера Класс Hashtable

Класс Hashtable Роль информационной деятельности в современном обществе, его экономической, социальной, культурной, образовательной сферах

Роль информационной деятельности в современном обществе, его экономической, социальной, культурной, образовательной сферах JDBC, стандарты

JDBC, стандарты Алгоритмы и структуры данных. Лекция 1. Основные понятия

Алгоритмы и структуры данных. Лекция 1. Основные понятия Bitcoin- electronic money

Bitcoin- electronic money Internet etikasi va odob-axloq qoidalari

Internet etikasi va odob-axloq qoidalari Методы проведения стандартных и сертификационных и испытаний

Методы проведения стандартных и сертификационных и испытаний Методы сбора и обработки данных при помощи Python

Методы сбора и обработки данных при помощи Python