Содержание

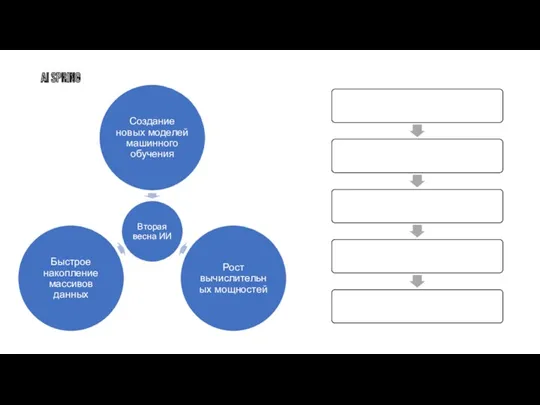

- 2. AI SPRING

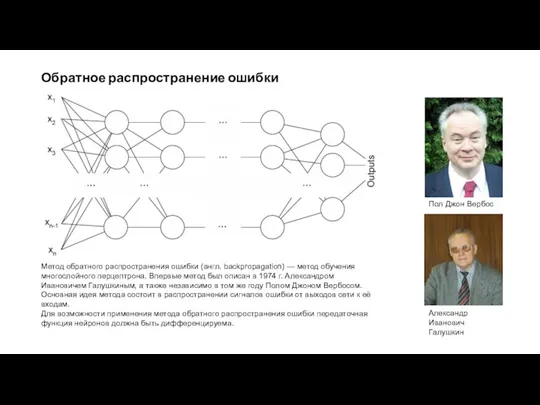

- 3. Обратное распространение ошибки Пол Джон Вербос Метод обратного распространения ошибки (англ. backpropagation) — метод обучения многослойного

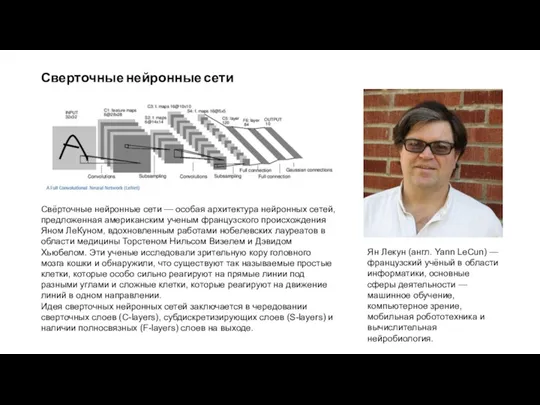

- 4. Сверточные нейронные сети Свёрточные нейронные сети — особая архитектура нейронных сетей, предложенная американским ученым французского происхождения

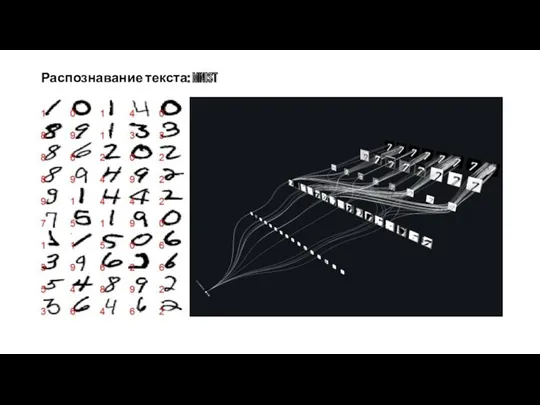

- 5. Распознавание текста: MNIST

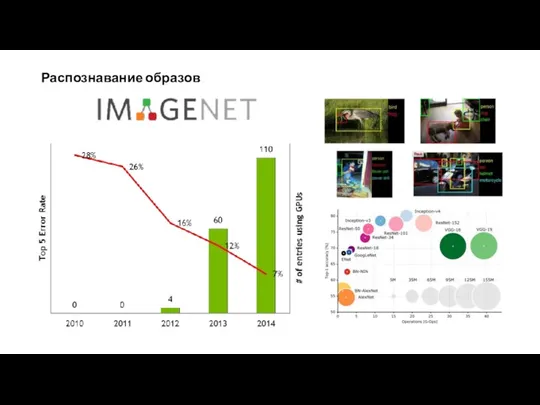

- 6. Распознавание образов

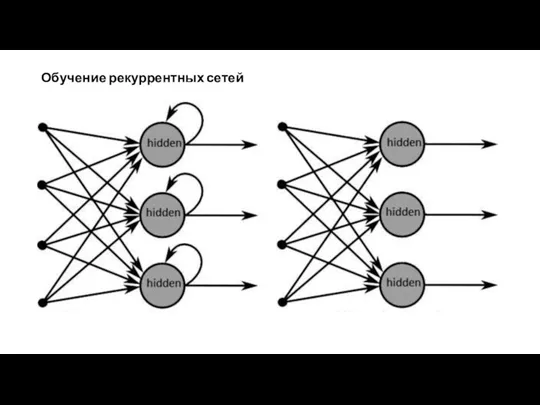

- 7. Обучение рекуррентных сетей

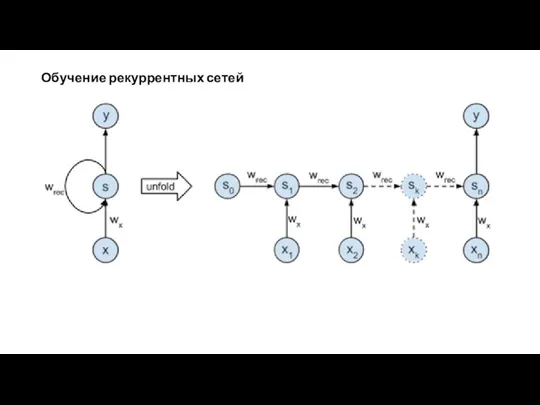

- 8. Обучение рекуррентных сетей

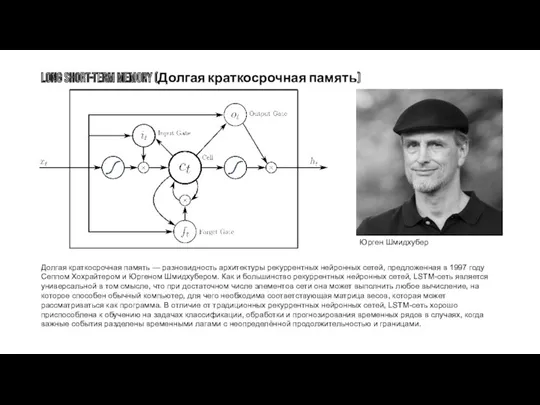

- 9. Long short-term memory (Долгая краткосрочная память) Долгая краткосрочная память — разновидность архитектуры рекуррентных нейронных сетей, предложенная

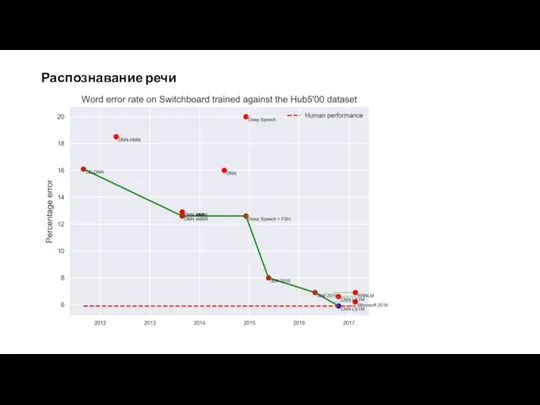

- 10. Распознавание речи В октябре 2016 года команда разработчиков из подразделения Microsoft, занимающегося исследованиями в области искусственного

- 11. Распознавание речи

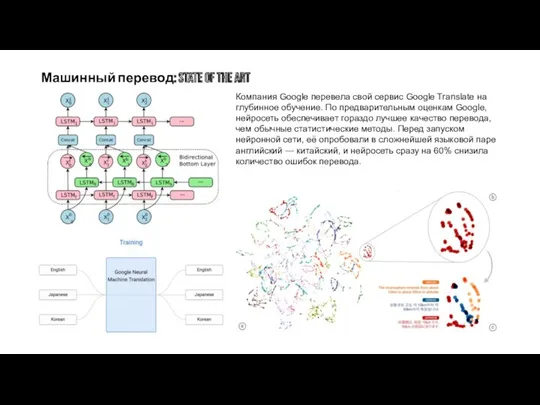

- 12. Машинный перевод: State of the art Компания Google перевела свой сервис Google Translate на глубинное обучение.

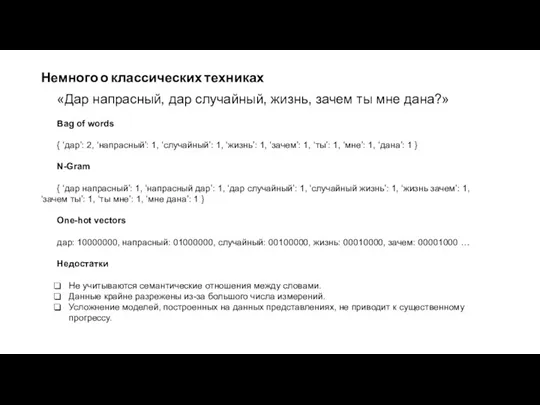

- 13. Немного о классических техниках «Дар напрасный, дар случайный, жизнь, зачем ты мне дана?» Bag of words

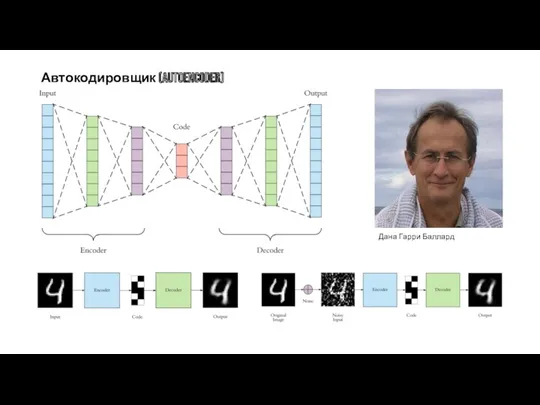

- 14. Автокодировщик (AUTOENCODER) Дана Гарри Баллард

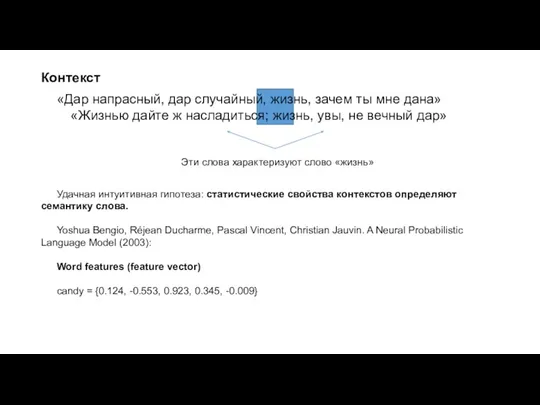

- 15. Контекст «Дар напрасный, дар случайный, жизнь, зачем ты мне дана» «Жизнью дайте ж насладиться; жизнь, увы,

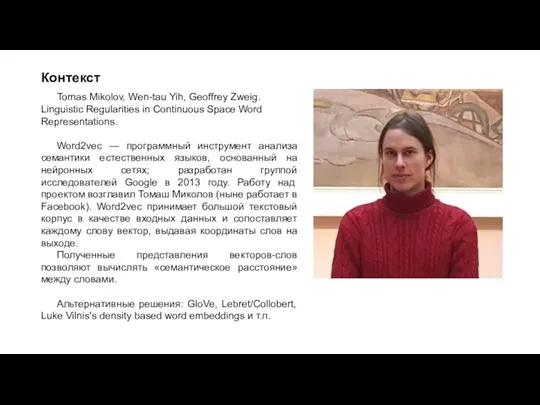

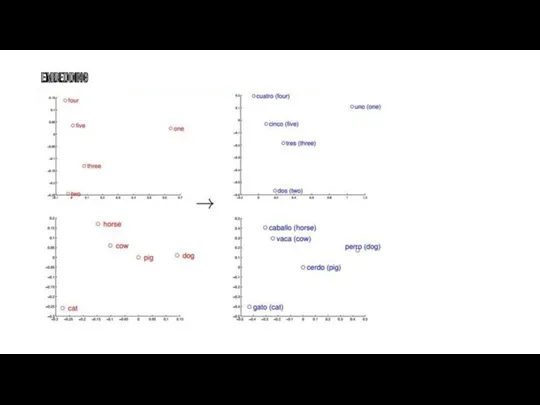

- 16. Контекст Tomas Mikolov, Wen-tau Yih, Geoffrey Zweig. Linguistic Regularities in Continuous Space Word Representations. Word2vec —

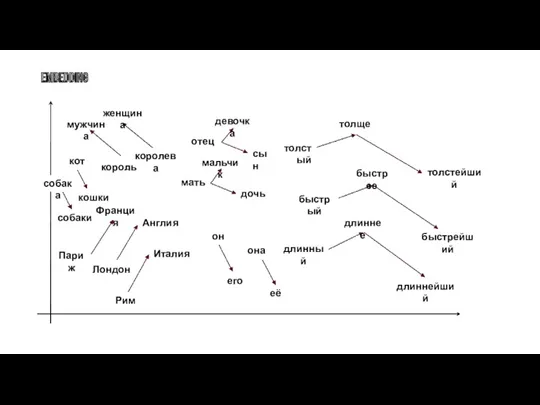

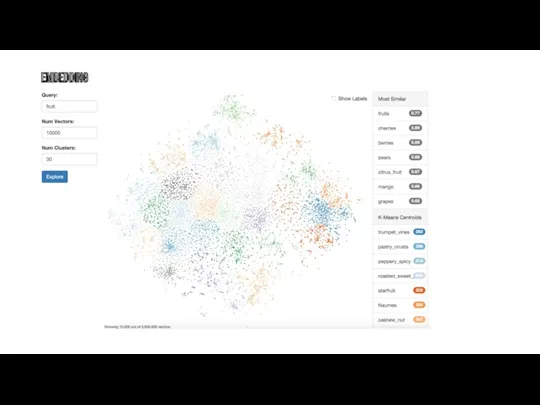

- 17. EMBEDDING

- 18. EMBEDDING

- 19. EMBEDDING

- 20. Разное «В чём разница между снеговиком и снежной бабой? — Снежные яйца (snowballs)» «Люблю своих любовниц

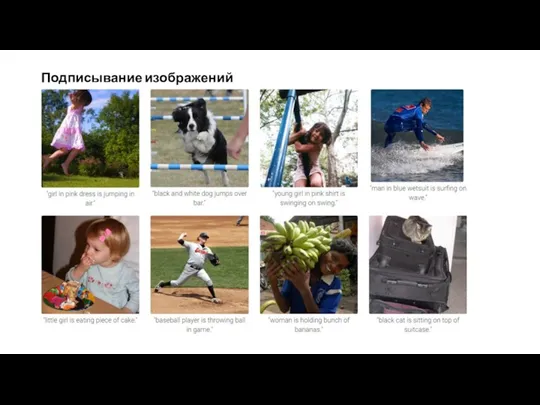

- 21. Подписывание изображений

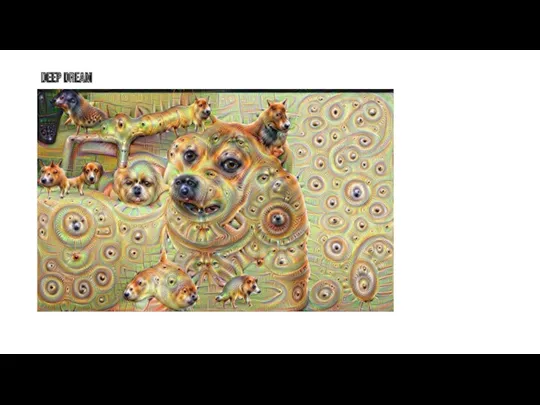

- 22. Deep Dream

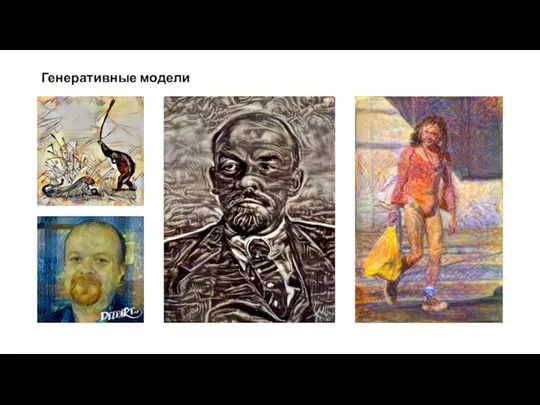

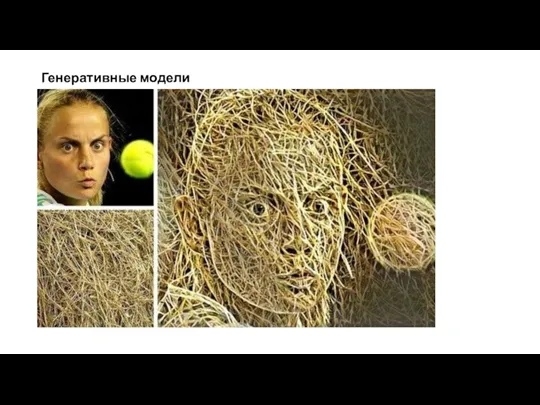

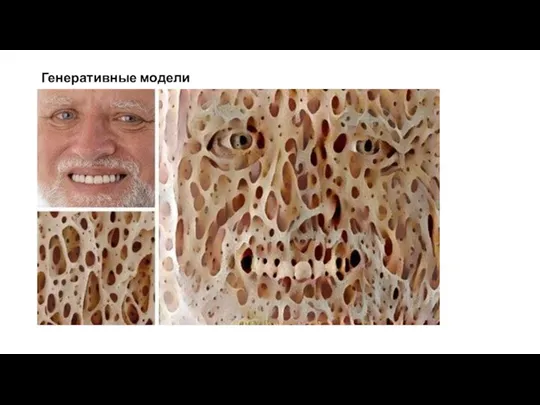

- 23. Генеративные модели

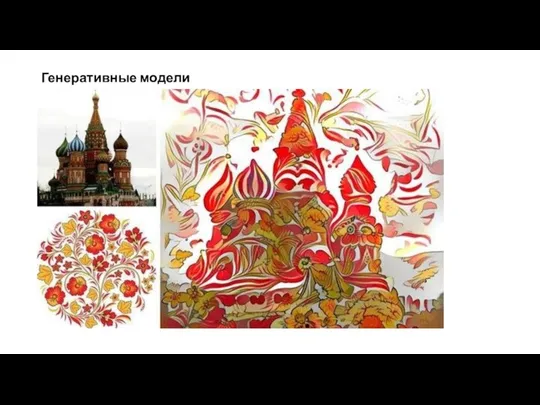

- 24. Генеративные модели

- 25. Генеративные модели

- 26. Генеративные модели

- 27. Генеративные модели

- 28. Генеративные модели

- 29. Генеративные модели

- 30. Генеративные модели

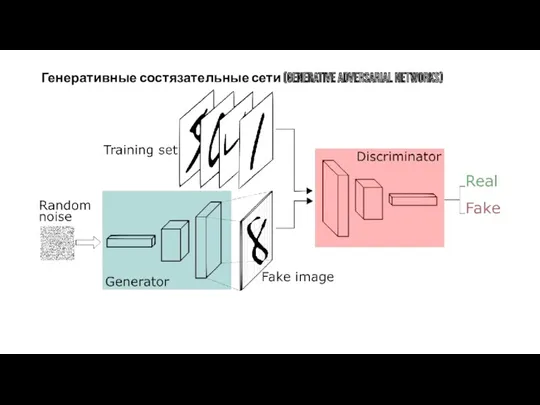

- 31. Генеративные состязательные сети (Generative adversarial networks)

- 32. Колоризация Программист Райан Дал создал систему для автоматической раскраски снимков на основе сверточных нейронных сетей. В

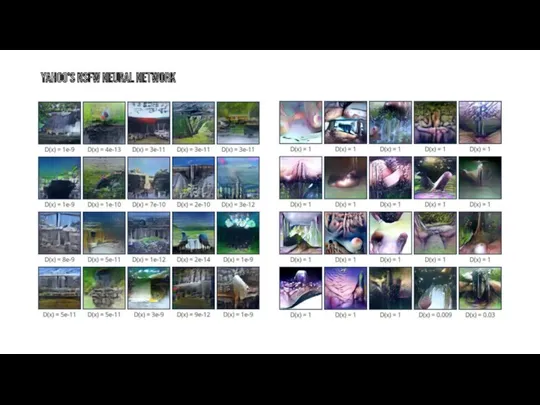

- 33. Yahoo's NSFW Neural Network

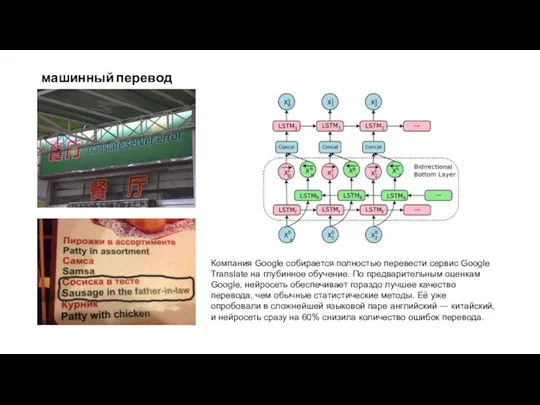

- 34. машинный перевод Компания Google собирается полностью перевести сервис Google Translate на глубинное обучение. По предварительным оценкам

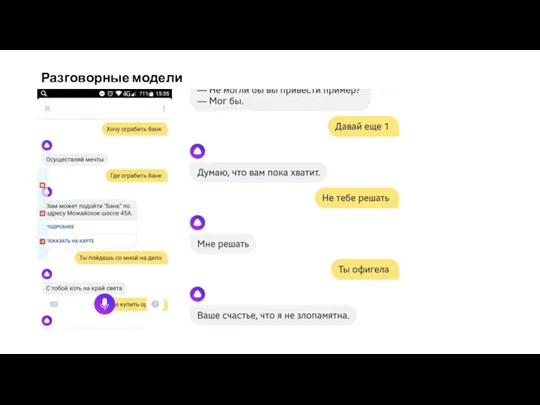

- 35. Разговорные модели

- 36. Распознавание человеческой активности

- 37. Оборудование LOIHI TrueNorth TPU Volta ? ?

- 38. Спасибо за внимание!

- 40. Скачать презентацию

История создания электронной почты

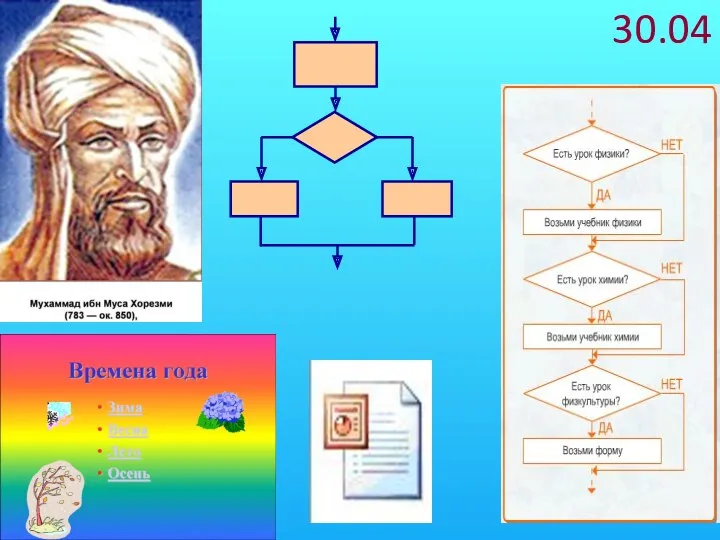

История создания электронной почты Алгоритмы с ветвлениями, 6 класс

Алгоритмы с ветвлениями, 6 класс Создание базы данных в Microsoft Access 2007 с помощью шаблонов и конструктора таблиц

Создание базы данных в Microsoft Access 2007 с помощью шаблонов и конструктора таблиц Кодирование звука и видео

Кодирование звука и видео Проект Создание ЭОР учителю с помощью некоторых сервисов

Проект Создание ЭОР учителю с помощью некоторых сервисов Презентация к уроку Носители информации (3 класс)

Презентация к уроку Носители информации (3 класс) Внедрение системы управления бизнес-процессами на предприятии

Внедрение системы управления бизнес-процессами на предприятии Введение в информатику: понятие об информации и информационных процессах. Информатика как наука

Введение в информатику: понятие об информации и информационных процессах. Информатика как наука Моя безопасность в информационном веке (классный час)

Моя безопасность в информационном веке (классный час) Основы работы в Adobe Photoshop

Основы работы в Adobe Photoshop Functions of Computers

Functions of Computers Представление об организации баз данных и системах управления базами данных

Представление об организации баз данных и системах управления базами данных Виртуальные экскурсии: технологии создания

Виртуальные экскурсии: технологии создания Сеть и облачные технологии

Сеть и облачные технологии Сайт о компьютерной игре. Посадочная и регистрационная страницы

Сайт о компьютерной игре. Посадочная и регистрационная страницы Сети обмена данными

Сети обмена данными Інструменти пошуку в Інтернеті

Інструменти пошуку в Інтернеті Моделирование, как метод познания. Типы информационных моделей

Моделирование, как метод познания. Типы информационных моделей Возможности использования Intel Perceptual Computing SDK в игровых приложениях (Лекция 6)

Возможности использования Intel Perceptual Computing SDK в игровых приложениях (Лекция 6) Практика в ООО Норд Хаус

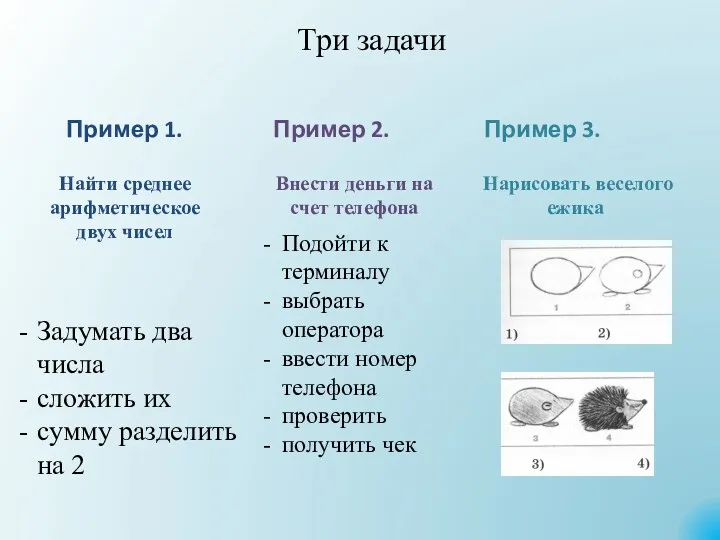

Практика в ООО Норд Хаус Презентация Понятие алгоритма. Исполнители алгоритма. Свойства алгоритма.

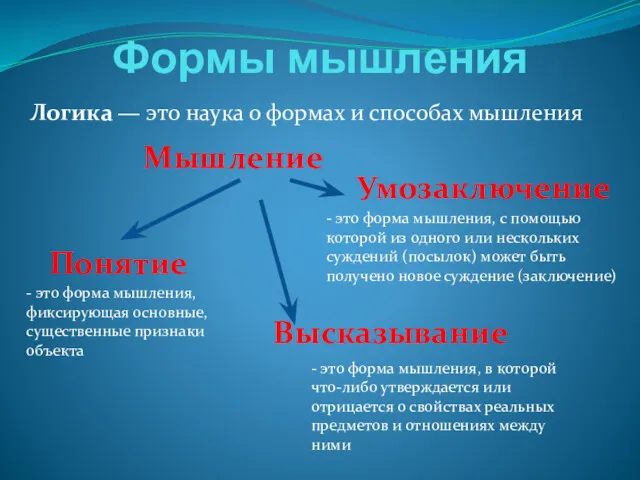

Презентация Понятие алгоритма. Исполнители алгоритма. Свойства алгоритма. Формы мышления. Логика

Формы мышления. Логика Обзор веб-ресурсов по веб-дизайну и веб-разработке

Обзор веб-ресурсов по веб-дизайну и веб-разработке ЕАС ОПС Реализация лотерейных билетов и выплата выигрышей

ЕАС ОПС Реализация лотерейных билетов и выплата выигрышей Стандарты разработки и документирования программных средств

Стандарты разработки и документирования программных средств Алгоритм создания рабочей программы

Алгоритм создания рабочей программы Системи управління базами даних Access

Системи управління базами даних Access Теория автоматического управления

Теория автоматического управления