Слайд 2

Нейронная сеть

Число слоев/число нейронов по слоям

Обратные связи

Активационные функции

Число входов

Число выходов

Алгоритм настройки

весов(обучения)

Тип задачи, решаемой сетью

Слайд 3

Режимы функционирования нейросетей

Обучение

Работа

Слайд 4

Виды обучения

С учителем

T={(Xi,di)}, i=1,N

Xi- входной вектор

di – выходной вектор

Без учителя

T={Xi}, i=1,N

Xi-

входной вектор

Слайд 5

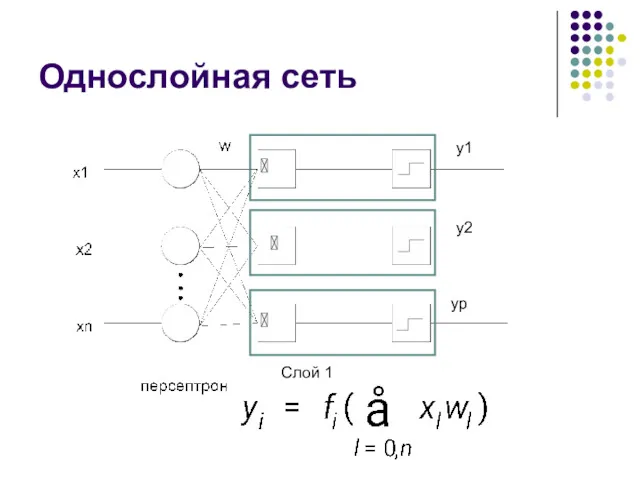

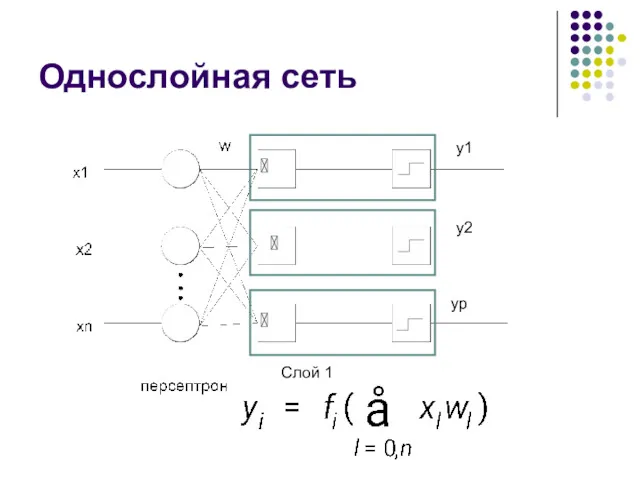

Однослойная сеть

y1

y2

yp

Слой 1

Слайд 6

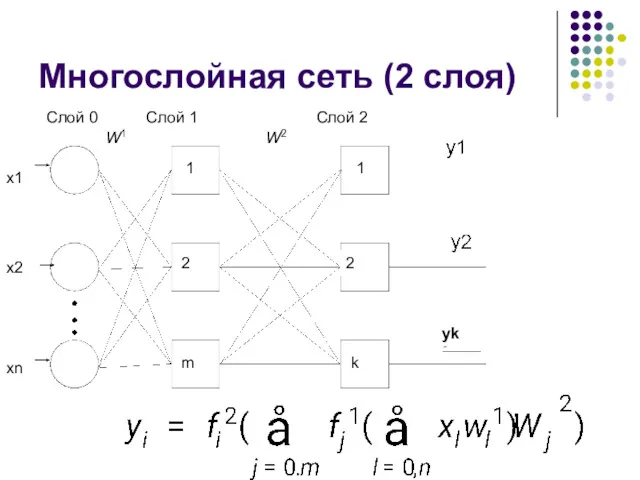

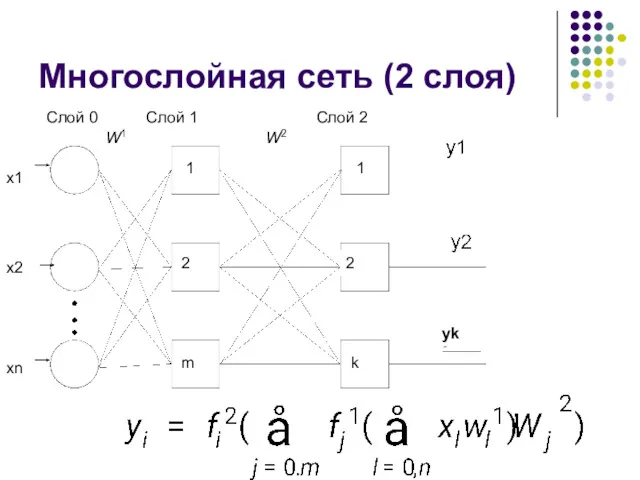

Многослойная сеть (2 слоя)

yk

Слой 1

Слой 2

Слой 0

W1

W2

1

2

m

1

2

k

x1

x2

xn

Слайд 7

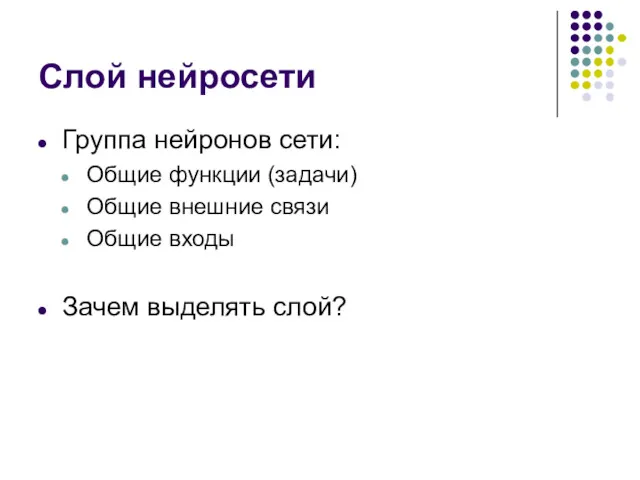

Слой нейросети

Группа нейронов сети:

Общие функции (задачи)

Общие внешние связи

Общие входы

Зачем выделять слой?

Слайд 8

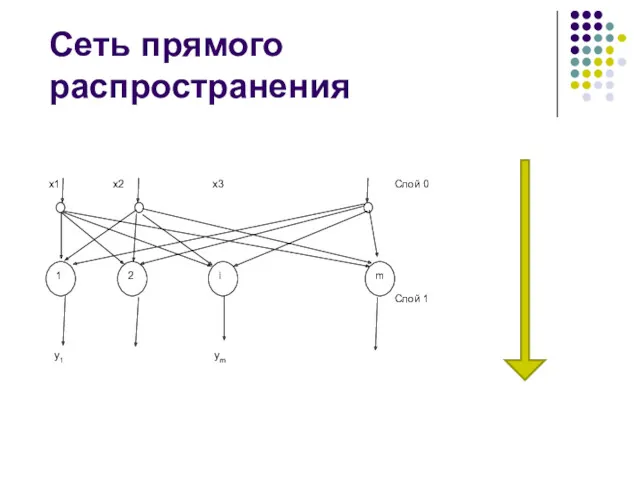

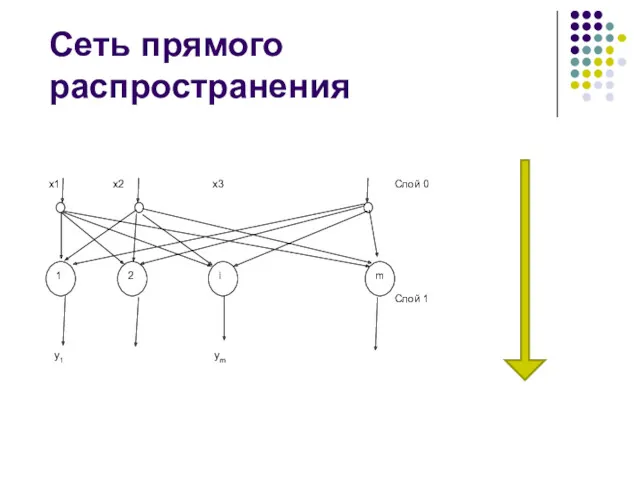

Сеть прямого распространения

1

2

i

m

x1 x2 x3

y1 ym

Слой 0

Слой 1

Слайд 9

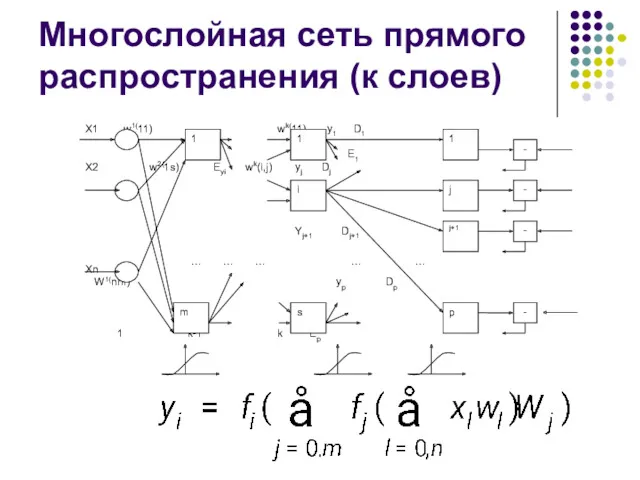

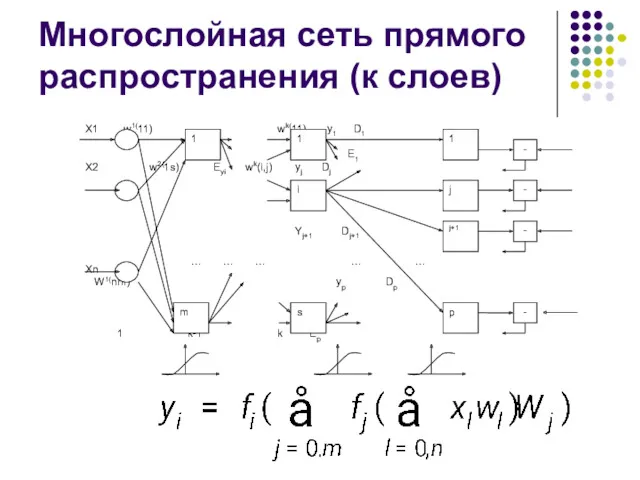

Многослойная сеть прямого распространения (к слоев)

Слайд 10

Обратное распространение ошибки

Слайд 11

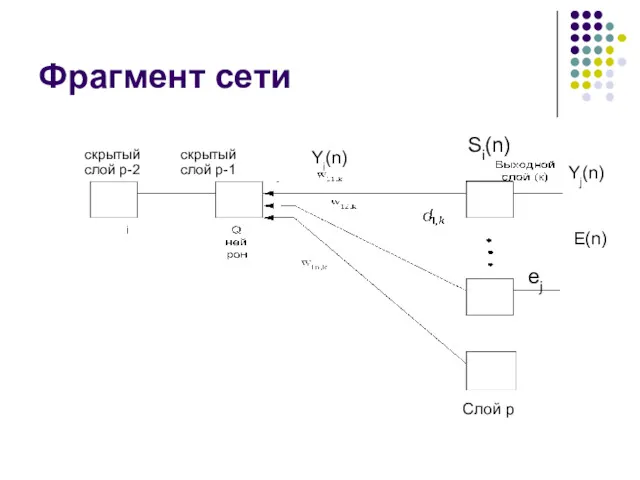

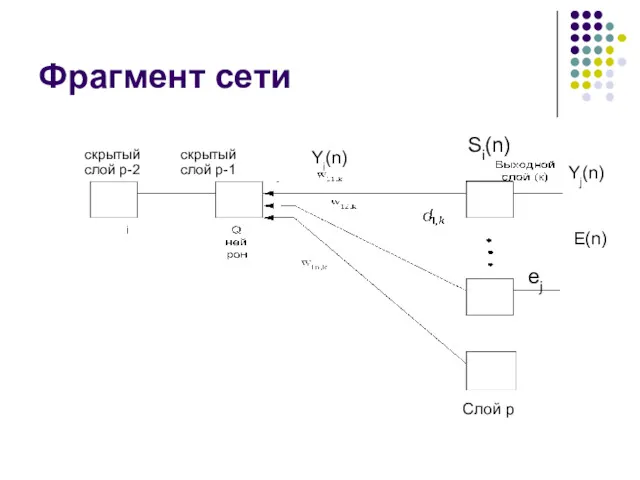

Фрагмент сети

ej

E(n)

Yi(n)

Yj(n)

Si(n)

скрытый скрытый

слой p-2 слой p-1

Слой p

Слайд 12

Обучение по ошибке

Глобальная задача – сложная.

E(n)=Σej(n)2

ej(n)=Dj-Yj(n)

Зависит от всех настраиваемых параметров.

Слайд 13

![Функции пакета Neural NetWork ToolBox MatLab net = newff([0 8],[2](/_ipx/f_webp&q_80&fit_contain&s_1440x1080/imagesDir/jpg/137046/slide-12.jpg)

Функции пакета Neural NetWork ToolBox MatLab

net = newff([0 8],[2 1],{'tansig' ‘purelin'},'trainlm');

net=train(net,p,t);

y2

= sim(net,p)

lab3_prim.m

Слайд 14

Алгоритмы

TRAINCGB

TRAINBFG

TRAINOSS

TRAINGD

TRAINRP

TRAINLM

Слайд 15

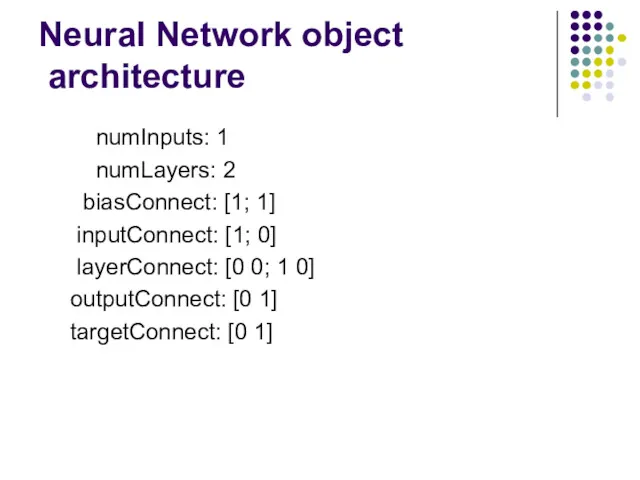

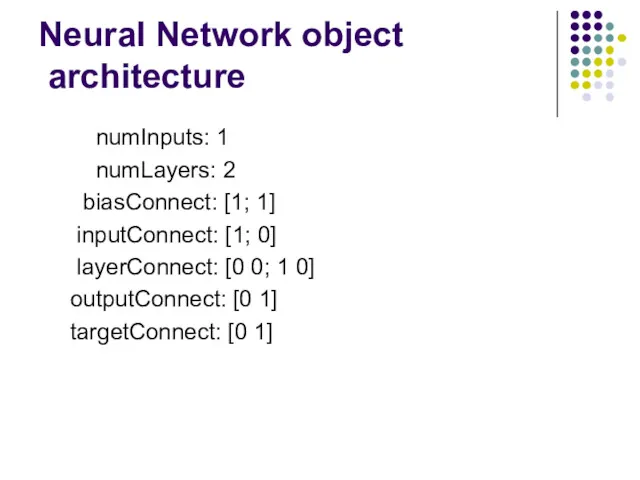

Neural Network object

architecture

numInputs: 1

numLayers: 2

biasConnect: [1; 1]

inputConnect: [1; 0]

layerConnect: [0 0; 1 0]

outputConnect: [0 1]

targetConnect: [0 1]

Слайд 16

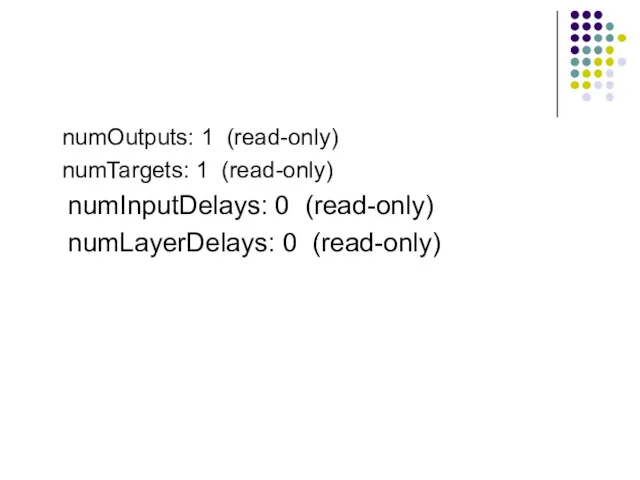

numOutputs: 1 (read-only)

numTargets: 1 (read-only)

numInputDelays: 0 (read-only)

numLayerDelays: 0 (read-only)

Слайд 17

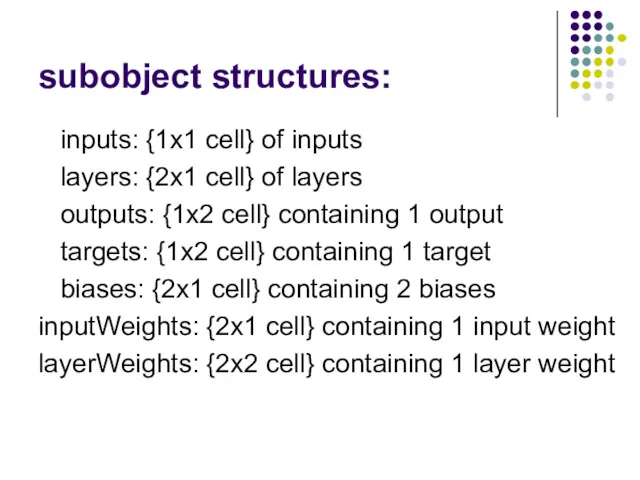

subobject structures:

inputs: {1x1 cell} of inputs

layers: {2x1 cell} of

layers

outputs: {1x2 cell} containing 1 output

targets: {1x2 cell} containing 1 target

biases: {2x1 cell} containing 2 biases

inputWeights: {2x1 cell} containing 1 input weight

layerWeights: {2x2 cell} containing 1 layer weight

Слайд 18

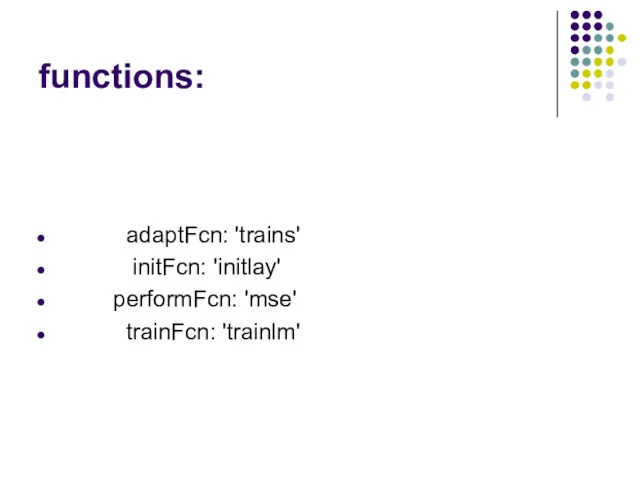

functions:

adaptFcn: 'trains'

initFcn: 'initlay'

performFcn: 'mse'

trainFcn: 'trainlm'

Слайд 19

trainParam:

.epochs,

.goal,

.show,

.time

Слайд 20

weight and bias values:

IW: {2x1 cell} containing 1 input weight matrix

LW:

{2x2 cell} containing 1 layer weight matrix

b: {2x1 cell} containing 2 bias vectors

Слайд 21

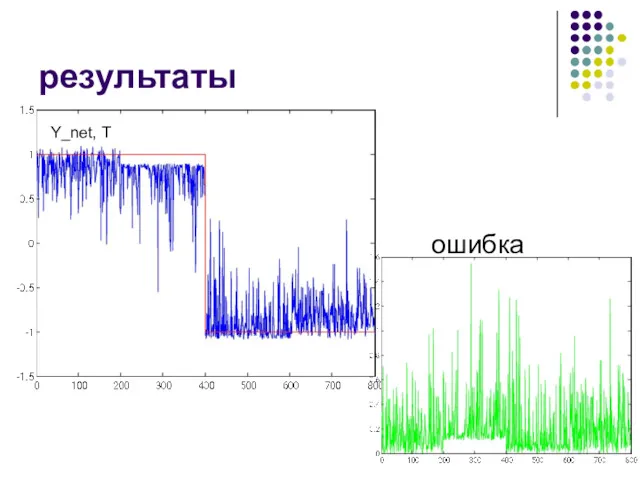

Ошибка обучения

(Р, Т) – обучающая выборка

Р – входные вектора

Т – выходные

вектора

net – нейронная сеть

Y=sim(net, P) – выходы сети

Средняя Абсолютная ошибка обучения

Е_обучения =mean(abs(Y-T))

Слайд 22

Ошибка обучения

(Р, Т) – обучающая выборка

Р – входные вектора

Т – выходные

вектора {-1, 1}

N – число обучающих пар

net – нейронная сеть

Y=sim(net, P) – выходы сети

Ошибка классификации обучения

Е_обучения_cls =sum((sign(Y)=~T))/N

Слайд 23

Ошибка обобщения (теста)

(Р_тест, Т_тест) – тест выборка

Р_тест – входные вектора

Т_тест –

выходные вектора

net – нейронная сеть

Y_тест=sim(net, P_тест) – выходы сети

Средняя Абсолютная ошибка обучения

Е_тест =mean(abs(Y_тест-T_тест))

Слайд 24

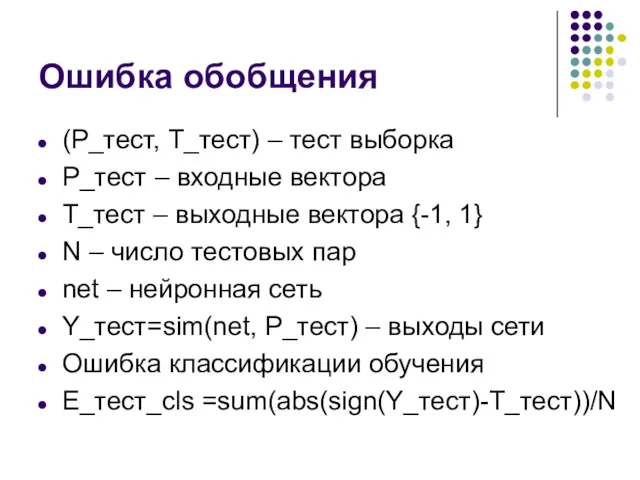

Ошибка обобщения

(Р_тест, Т_тест) – тест выборка

Р_тест – входные вектора

Т_тест – выходные

вектора {-1, 1}

N – число тестовых пар

net – нейронная сеть

Y_тест=sim(net, P_тест) – выходы сети

Ошибка классификации обучения

Е_тест_cls =sum(abs(sign(Y_тест)-T_тест))/N

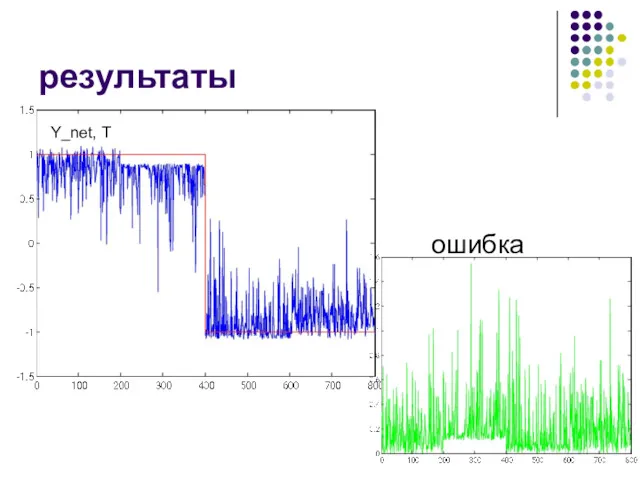

Слайд 25

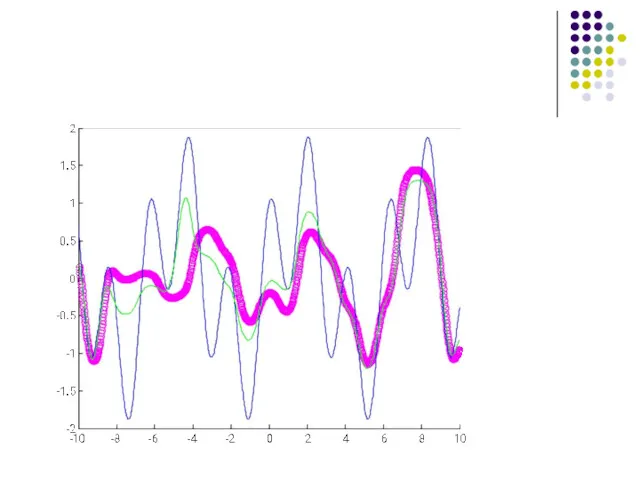

Обучение сети. lab3_prim_2.m

3 – нелинейных нейрона, градиентный алгоритм

Целевое состояние

Обучение

Слайд 26

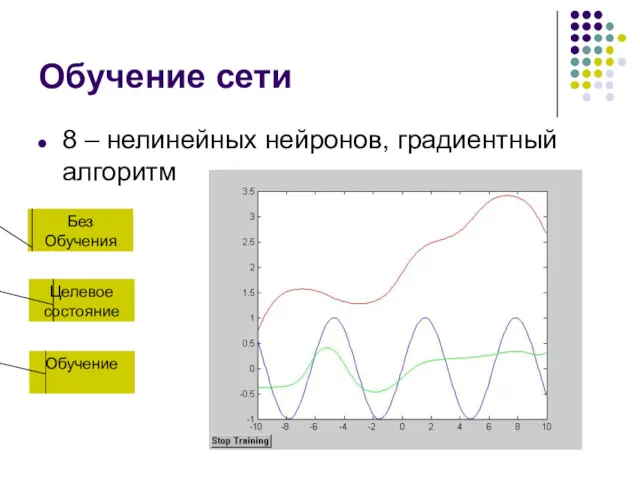

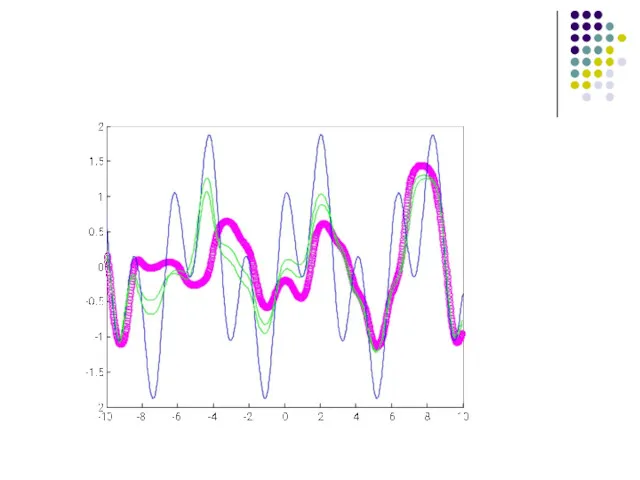

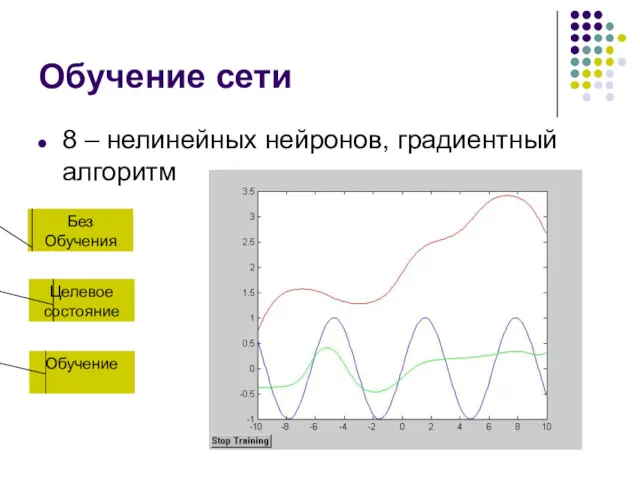

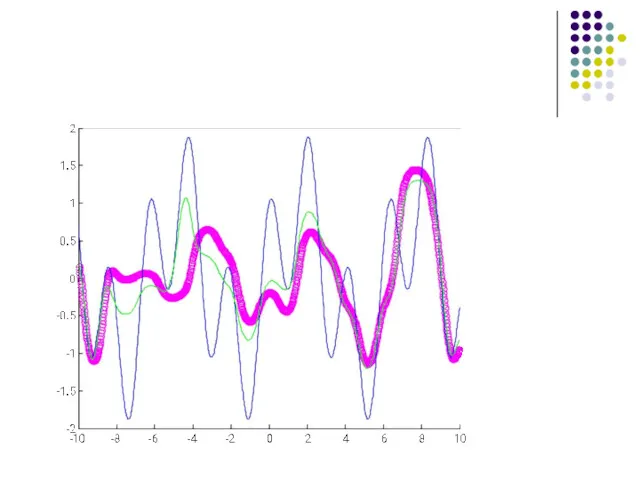

Обучение сети

8 – нелинейных нейронов, градиентный алгоритм

Целевое состояние

Обучение

Слайд 27

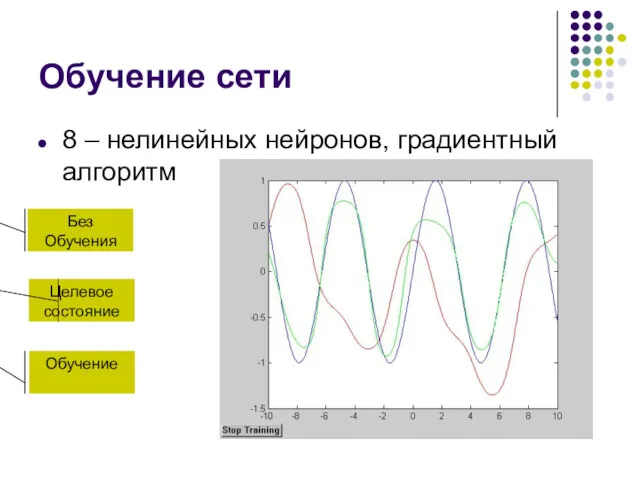

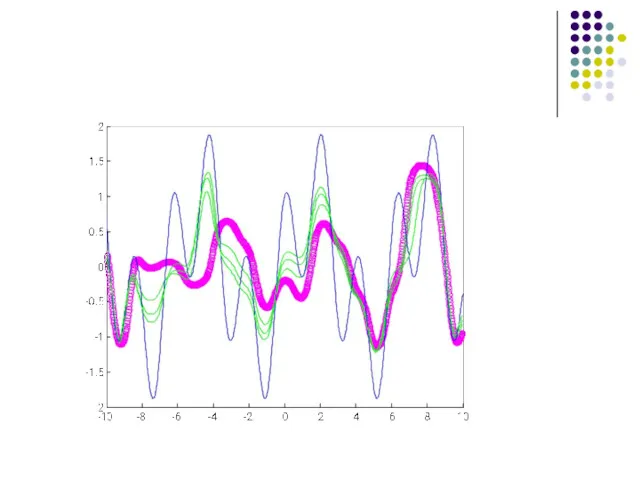

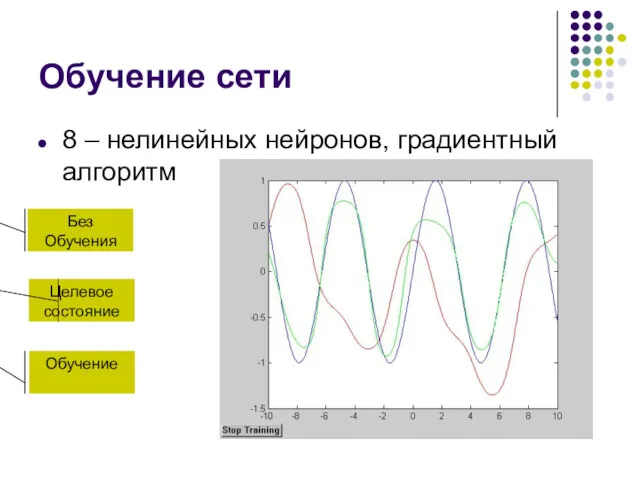

Обучение сети

8 – нелинейных нейронов, градиентный алгоритм

Целевое состояние

Обучение

Слайд 28

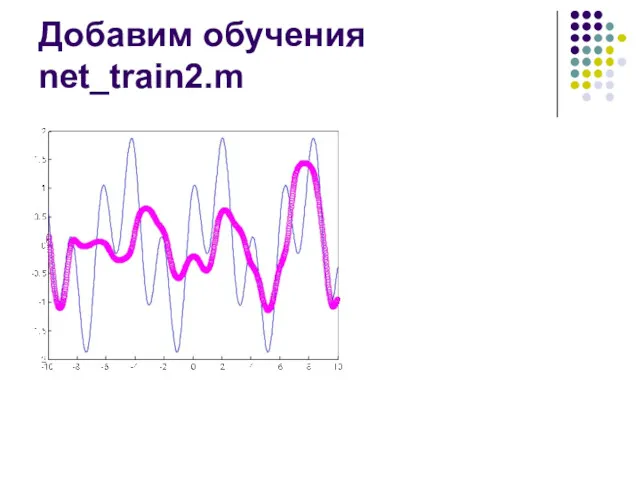

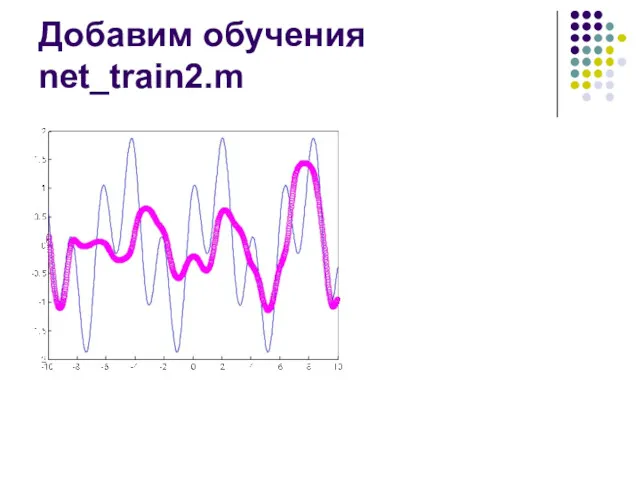

Добавим обучения net_train2.m

Слайд 29

Слайд 30

Слайд 31

Слайд 32

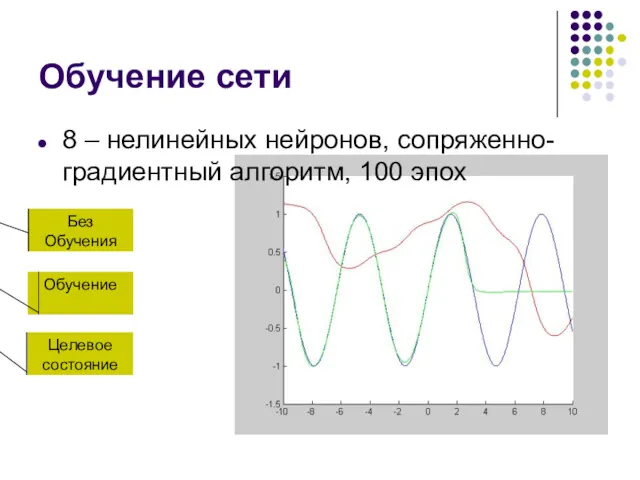

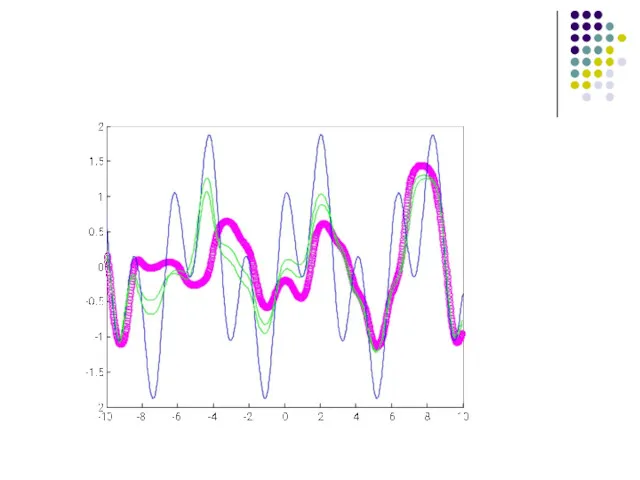

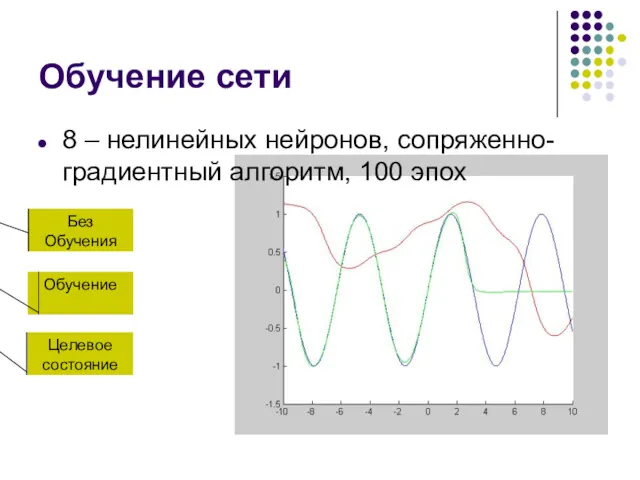

Обучение сети

8 – нелинейных нейронов, сопряженно-градиентный алгоритм, 100 эпох

Целевое

состояние

Обучение

Без Обучения

Слайд 33

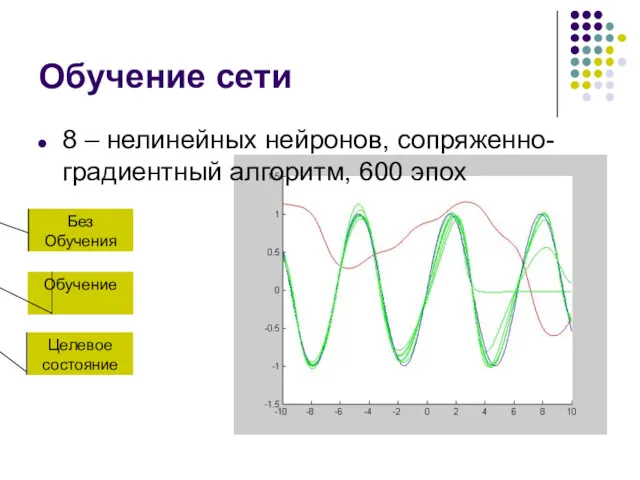

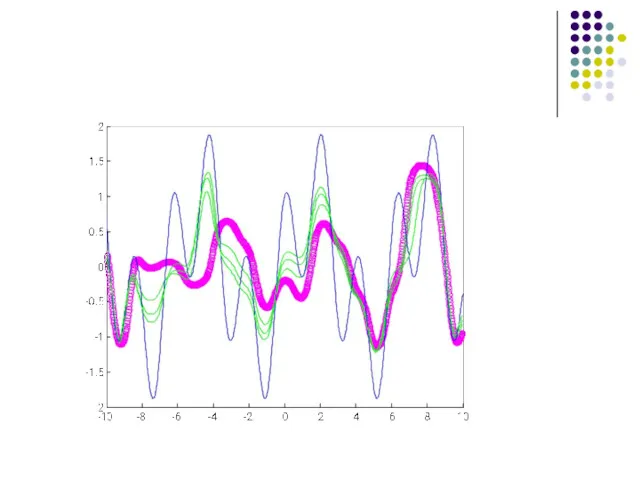

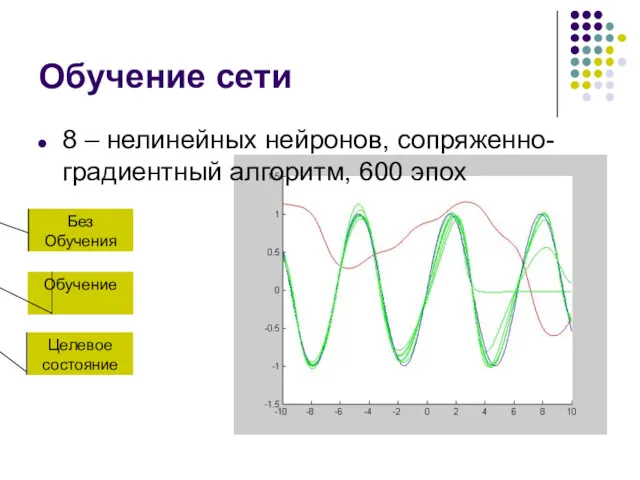

Обучение сети

8 – нелинейных нейронов, сопряженно-градиентный алгоритм, 600 эпох

Целевое

состояние

Обучение

Без Обучения

Слайд 34

Слайд 35

Слайд 36

Слайд 37

Проблемы

Локальные минимумы

Переобучение

Паралич сети

Устойчивость/пластичность

![Функции пакета Neural NetWork ToolBox MatLab net = newff([0 8],[2](/_ipx/f_webp&q_80&fit_contain&s_1440x1080/imagesDir/jpg/137046/slide-12.jpg)

Введение в объектно-ориентированное программирование Lazarus

Введение в объектно-ориентированное программирование Lazarus Госорган в соцсетях. Жизнь или имитация

Госорган в соцсетях. Жизнь или имитация Определение и краткая история функционального программирования

Определение и краткая история функционального программирования Безопасность ОС и сетей. Лекция 13

Безопасность ОС и сетей. Лекция 13 Сайт компании Безант (для оптового отдела)

Сайт компании Безант (для оптового отдела) The Internet

The Internet Интеллектуальная система безопасности на базе программно-аппаратного комплекса Orwell 2k

Интеллектуальная система безопасности на базе программно-аппаратного комплекса Orwell 2k Информационные модели

Информационные модели Разработка Telegram-бота с помощью JavaScript

Разработка Telegram-бота с помощью JavaScript Технология Умный дом

Технология Умный дом Объекты администрирования в информационных системах

Объекты администрирования в информационных системах ОСНОВНЫЕ КОМАНДЫ DOS

ОСНОВНЫЕ КОМАНДЫ DOS Высказывания сложные и простые

Высказывания сложные и простые Microsoft Word жұмыс алаңы

Microsoft Word жұмыс алаңы Scikit-learn

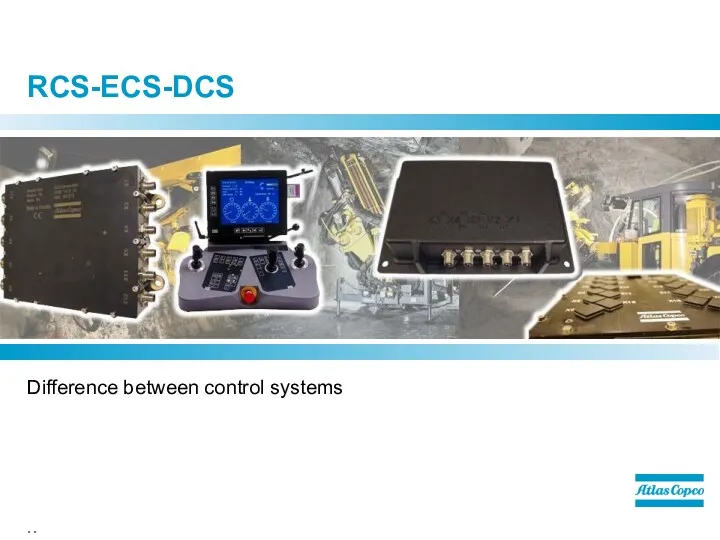

Scikit-learn RCS-ECS-DCS. Difference between control systems

RCS-ECS-DCS. Difference between control systems HTML құжатында кестелерді қалыптастыру. Кесте параметрлерін тағайындау тегтері

HTML құжатында кестелерді қалыптастыру. Кесте параметрлерін тағайындау тегтері Битва за килобиты

Битва за килобиты Решение задач ЕГЭ типа А3

Решение задач ЕГЭ типа А3 Работа с файлами. Бинарные и текстовые файлы

Работа с файлами. Бинарные и текстовые файлы Что такое cad-cистема?

Что такое cad-cистема? Презентация по информатике и ИКТ на тему: Применение здоровьесберегающих технологий на уроках информатики и ИКТ

Презентация по информатике и ИКТ на тему: Применение здоровьесберегающих технологий на уроках информатики и ИКТ Изучение методов создания прототипа модели с использованием установок аддитивного производства

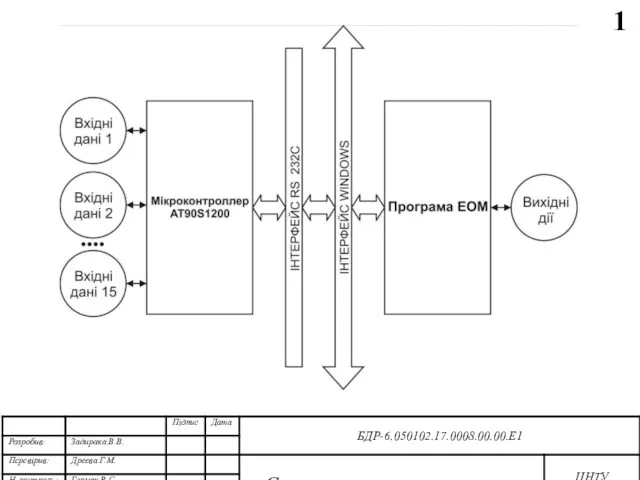

Изучение методов создания прототипа модели с использованием установок аддитивного производства Структурна та функціональна схеми системи. Діаграма взаємодії процесів. Блок-схеми основної програми та роботи підпрограм

Структурна та функціональна схеми системи. Діаграма взаємодії процесів. Блок-схеми основної програми та роботи підпрограм Тема 4. Ветвления Python

Тема 4. Ветвления Python Представление текстов в памяти компьютера. Кодировочные таблицы

Представление текстов в памяти компьютера. Кодировочные таблицы Операционная система Windows 7 Aero

Операционная система Windows 7 Aero Access (Форми). Лекція 5. Конструктор форм

Access (Форми). Лекція 5. Конструктор форм