Решение задач идентификации, прогнозирования и других с помощью искусственных нейронных сетей. Лекция 19-20 презентация

Содержание

- 2. Поиск идеального образа по имеющейся неполной или зашумленной его версии называется задачей распознавания образов.

- 3. Ассоциативный характер памяти сети Хопфилда качественно отличает ее от обычной, адресной, компьютерной памяти. В последней извлечение

- 4. При использовании ассоциативной памяти доступ к информации производится непосредственно по ее содержанию, т.е. по частично известным

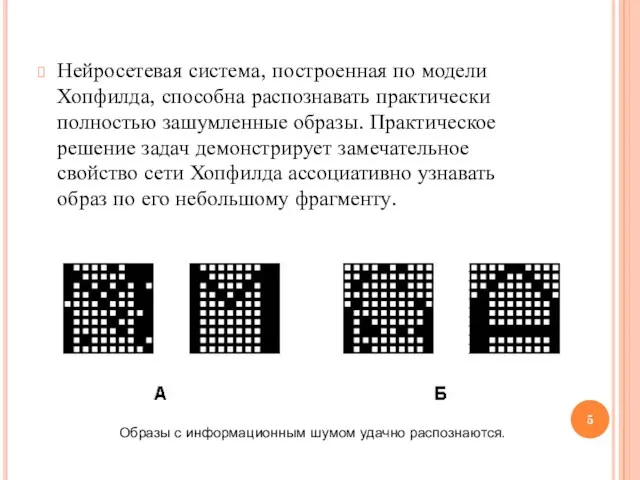

- 5. Нейросетевая система, построенная по модели Хопфилда, способна распознавать практически полностью зашумленные образы. Практическое решение задач демонстрирует

- 6. Важнейшей особенностью работы сети Хопфилда является способность к генерации ложных образов. Ложный образ является устойчивым локальным

- 7. Несмотря на интересные качества, нейронная сеть в классической модели Хопфилда далека от совершенства: Она обладает относительно

- 8. Нейронные сети встречного распространения Нейронные сети встречного распространения, состоящие из входного слоя нейронов и слоев нейронов

- 9. Области применения: распознавание образов, восстановление образов (ассоциативная память), сжатие данных (с потерями). Недостатки: Сеть не дает

- 10. Задачи, решаемые нейросетями: Классификация образов – состоит в указании принадлежности входного образа, представленного вектором признаков, к

- 11. Кластеризация/категоризация – классификация образов без учителя, когда отсутствует обучающая выборка с метками классов. Алгоритм кластеризации основан

- 12. Аппроксимация функций – состоит в нахождении оценки неизвестной функции, которая генерирует входные для нейросети данные (т.е.

- 13. Предсказание/прогноз – состоит в предсказании следующего значения в некотором наборе значений по известным предыдущим значениям. Применяется

- 14. Оптимизация – задачей алгоритма оптимизации является нахождение такого решения, которое удовлетворяет системе ограничений и максимизирует или

- 15. Память, адресуемая по содержанию (ассоциативная память) – содержимое памяти может быть вызвано даже по частичному или

- 16. Управление – в системах управления с эталонной моделью целью управления является расчет такого входного воздействия, при

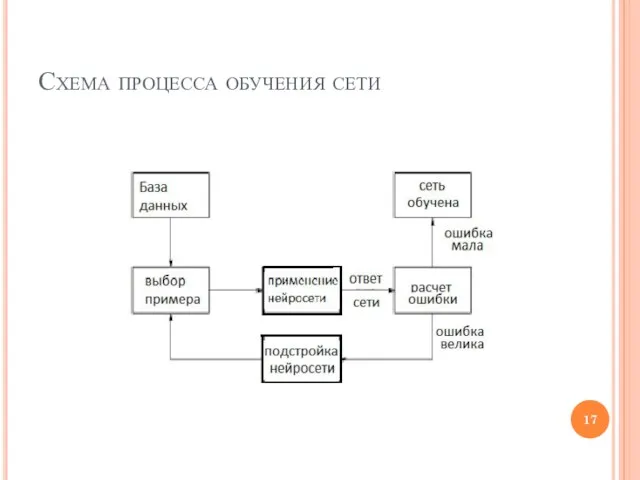

- 17. Схема процесса обучения сети

- 18. Обучающая выборка Вся информация, которую сеть имеет о задаче, содержится в наборе примеров для обучения. Поэтому

- 19. Математическое описание процесса обучения В процессе функционирования нейронная сеть формирует выходной сигнал Y в соответствии с

- 20. Если выбраны множество обучающих примеров и способ вычисления функции ошибки E, то обучение нейронной сети превращается

- 21. Для решения этой задачи могут быть использованы следующие итерационные алгоритмы: Алгоритмы локальной оптимизации с вычислением частных

- 22. 1. Алгоритмы локальной оптимизации с вычислением частных производных первого порядка: Градиентный алгоритм (метод скорейшего спуска) (например,

- 23. 2. Алгоритмы локальной оптимизации с вычислением частных производных первого и второго порядка: Метод Ньютона. Методы оптимизации

- 24. 3. Стохастическими методами являются: Поиск в случайном направлении. Имитация отжига. Метод Монте-Карло (численный метод статистических испытаний).

- 25. 4. Задачи глобальной оптимизации решаются с помощью перебора значений переменных, от которых зависит целевая функция (функция

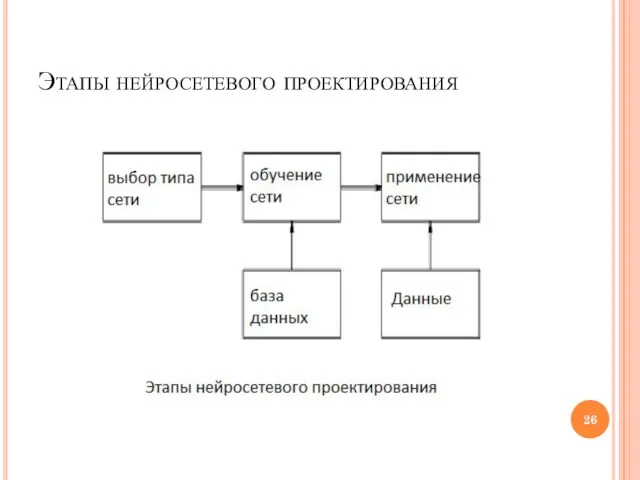

- 26. Этапы нейросетевого проектирования

- 27. Основные недостатки аппарата искусственных нейронных сетей Отсутствие строгой теории по выбору структуры нейросети Практическая невозможность извлечения

- 28. КОГНИТРОН Фукушимы КОГНИТРОН: самоорганизующаяся многослойная нейросеть. Создание КОГНИТРОНА (K.Fukushima, 1975) явилось плодом синтеза усилий нейрофизиологов и

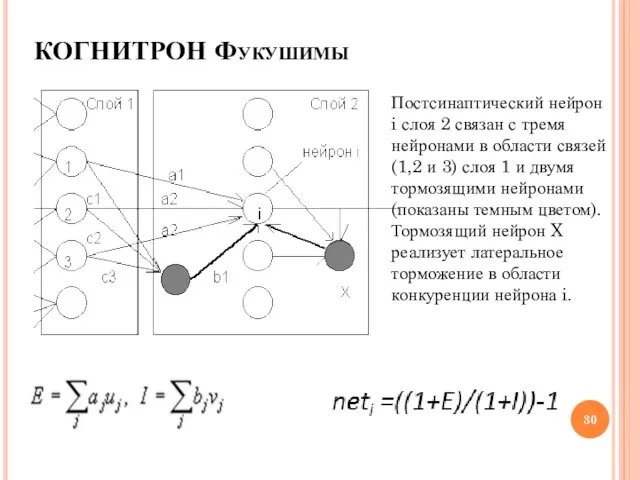

- 29. КОГНИТРОН состоит из иерархически связанных слоев нейронов двух типов - тормозящих и возбуждающих. Состояние возбуждения каждого

- 30. КОГНИТРОН Фукушимы Постсинаптический нейрон i слоя 2 связан с тремя нейронами в области связей (1,2 и

- 31. Обучение весов возбуждающих нейронов происходит по принципу WTA - "победитель забирает все" в области конкуренции -

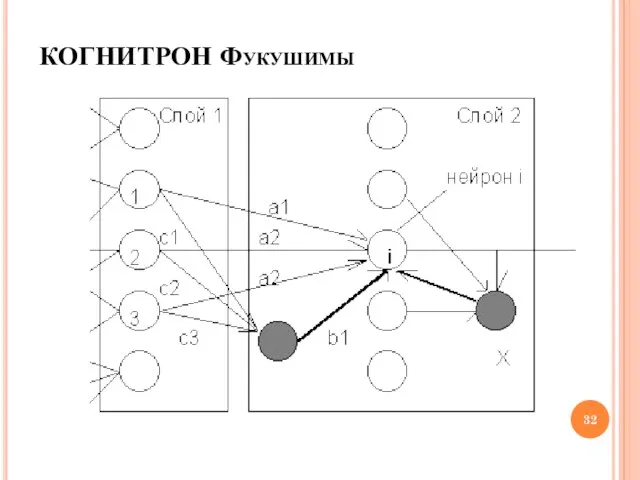

- 32. КОГНИТРОН Фукушимы

- 33. Перекрывающиеся области конкуренции близких нейронов второго слоя содержат относительно небольшое число других нейронов, поэтому конкретный нейрон-победитель

- 34. В целом КОГНИТРОН представляет собой иерархию слоев, последовательно связанных друг с другом, как было рассмотрено выше

- 35. Входные слои чувствительны к отдельным элементарным структурам, например, линиям определенной ориентации или цвета. Последующие слои реагируют

- 36. Автором КОГНИТРОНА Фукушимой эта сеть применялась для оптического распознавания символов - арабских цифр. Несмотря на успешные

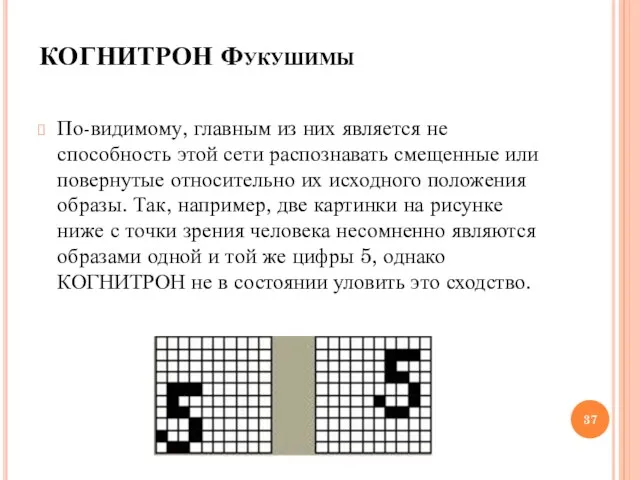

- 37. По-видимому, главным из них является не способность этой сети распознавать смещенные или повернутые относительно их исходного

- 38. О распознавании образов независимо от их положения, ориентации, а иногда и размера и других деформации, говорят

- 39. НЕОКОГНИТРОН и инвариантное распознавание образов Новая работа Фукушимы была опубликована в 1980 г. НЕОКОГНИТРОН хотя и

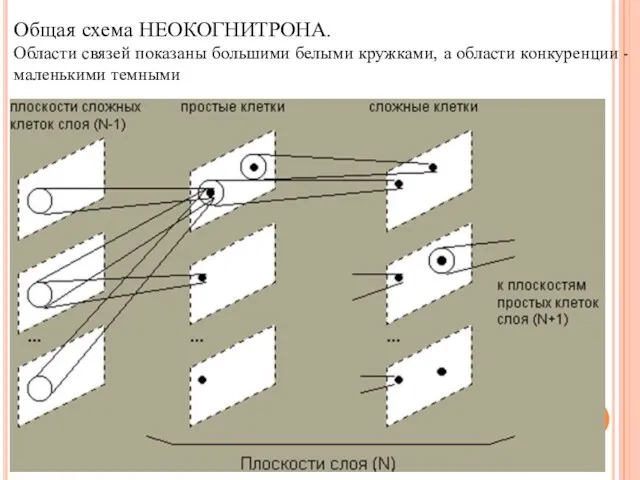

- 40. НЕОКОГНИТРОН НЕОКОГНИТРОН состоит из иерархии нейронных слоев, каждый из которых состоит из массива плоскостей. Каждый элемент

- 41. Общая схема НЕОКОГНИТРОНА. Области связей показаны большими белыми кружками, а области конкуренции - маленькими темными

- 42. По мере распространения информации от слоя к слою картинка нейронной активности становится все менее чувствительной к

- 43. Обучение НЕОКОГНИТРОНА аналогично уже рассмотренному обучению КОГНИТРОНА. При этом изменяются только синаптические веса простых клеток. После

- 44. НЕОКОГНИТРОН В целом функционирование НЕОКОГНИТРОНА происходит следующим образом: Копии входного изображения поступают на все плоскости простых

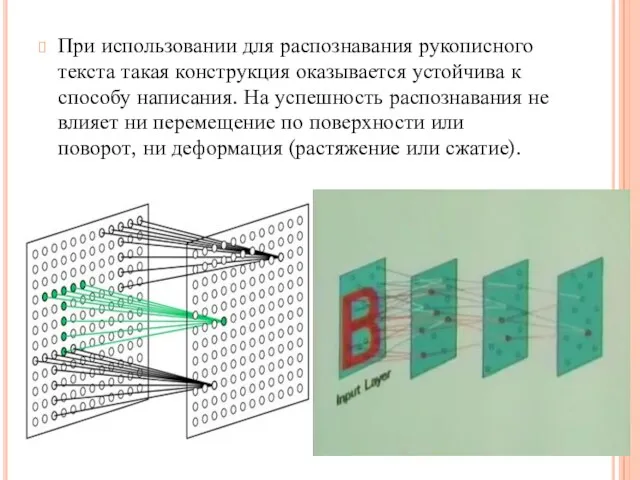

- 45. При использовании для распознавания рукописного текста такая конструкция оказывается устойчива к способу написания. На успешность распознавания

- 46. Нужно отметить, что структура этой сети необычайно сложна, и объем вычислений очень велик, поэтому компьютерные модели

- 47. Неокогнитрон часто применяется для распознавания рукописного текста и оптического распознавания символов, образов с сильно искажённой или

- 49. Скачать презентацию

Розробка схемотехнічного пристрою для обробки багаторозрядної двійкової інформації

Розробка схемотехнічного пристрою для обробки багаторозрядної двійкової інформації Автоматизоване розроблення веб-сайтів

Автоматизоване розроблення веб-сайтів Introducing the C# Class Types. Defining classes, objects and methods

Introducing the C# Class Types. Defining classes, objects and methods Программирование разветвляющихся алгоритмов. Начала программирования

Программирование разветвляющихся алгоритмов. Начала программирования Презентация Виды графических файлов

Презентация Виды графических файлов Подготовка файлов к печати. Форматы файлов, цветовые раскладки и разница между векторной и растровой графикой

Подготовка файлов к печати. Форматы файлов, цветовые раскладки и разница между векторной и растровой графикой Инструкция участия в вебинаре в системе веб-коммуникаций на базе IVA R

Инструкция участия в вебинаре в системе веб-коммуникаций на базе IVA R Task 3. Internet. Тренажёр ЕГЭ

Task 3. Internet. Тренажёр ЕГЭ Веб. 2.0. Його особливості. Соціальні сервіси Інтернету

Веб. 2.0. Його особливості. Соціальні сервіси Інтернету Рекуррентные соотношения, характерные для двух основных принципов организации рекурсии

Рекуррентные соотношения, характерные для двух основных принципов организации рекурсии Представление знаний – основа интеллектуальных систем. Лекция 15

Представление знаний – основа интеллектуальных систем. Лекция 15 Минимизация логических функций

Минимизация логических функций Компьютерные вирусы и антивирусные программы. Типы компьютерных вирусов

Компьютерные вирусы и антивирусные программы. Типы компьютерных вирусов Картографическое сопровождение поиска

Картографическое сопровождение поиска Лицензионное программное обеспечение (ПО)

Лицензионное программное обеспечение (ПО) Бесплатные сервисы для дизайна

Бесплатные сервисы для дизайна Подготовка документов в текстовом редакторе

Подготовка документов в текстовом редакторе Работа со шрифтами

Работа со шрифтами САПР Autocad 2015. Команды редактирования

САПР Autocad 2015. Команды редактирования Устройство компьютера. История развития вычислительной техники

Устройство компьютера. История развития вычислительной техники Разбор задач школьного тура 1-4

Разбор задач школьного тура 1-4 Информационная безопасность. Комплексная модель безопасности. (Лекция 13)

Информационная безопасность. Комплексная модель безопасности. (Лекция 13) Fundamentals of Programming (C++). Lecture 10

Fundamentals of Programming (C++). Lecture 10 Определение количества информации

Определение количества информации Использование 3D для обогащения опыта пользователя в ПО

Использование 3D для обогащения опыта пользователя в ПО Отчет по продвижению в социальных сетях Oson

Отчет по продвижению в социальных сетях Oson Моделирование в проектировании многофункциональных инфокоммуникационных систем и систем связи

Моделирование в проектировании многофункциональных инфокоммуникационных систем и систем связи Создание блога

Создание блога