Содержание

- 2. 1. Энтропия и информация

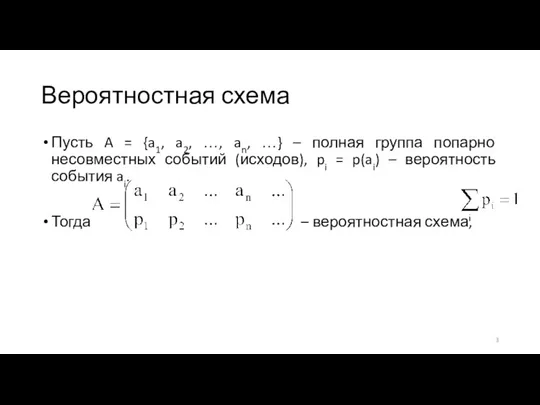

- 3. Вероятностная схема Пусть A = {a1, a2, …, an, …} – полная группа попарно несовместных событий

- 4. Дискретная вероятностная схема Если множество A не более чем счётно, то вероятностная схема A называется дискретной.

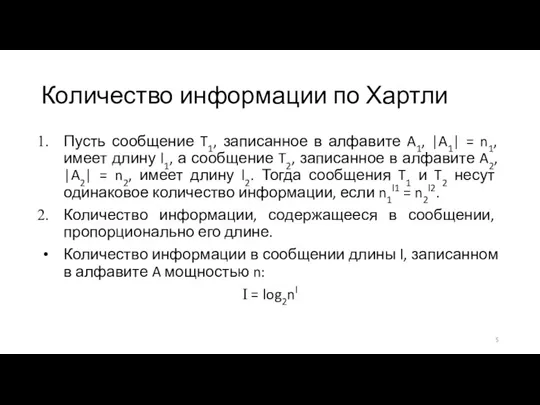

- 5. Количество информации по Хартли Пусть сообщение T1, записанное в алфавите A1, |A1| = n1, имеет длину

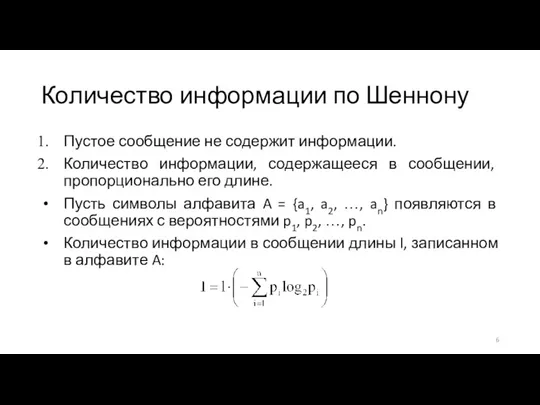

- 6. Количество информации по Шеннону Пустое сообщение не содержит информации. Количество информации, содержащееся в сообщении, пропорционально его

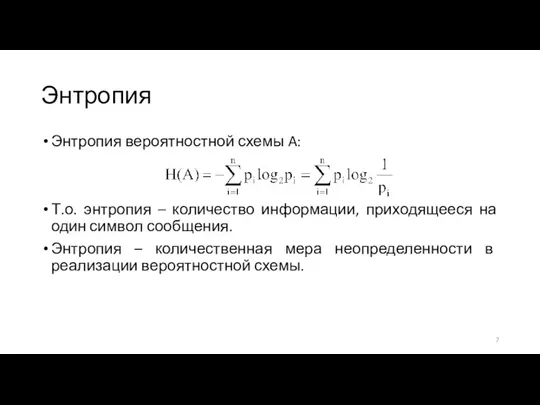

- 7. Энтропия Энтропия вероятностной схемы A: Т.о. энтропия – количество информации, приходящееся на один символ сообщения. Энтропия

- 8. Единицы измерения Основание логарифма определяет единицу измерения количества информации. Если основание логарифма 2, то информацию измеряют

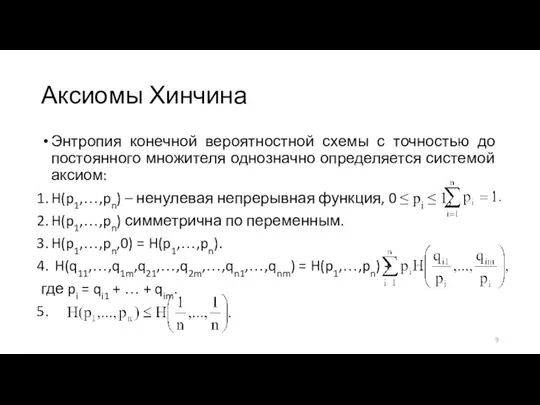

- 9. Аксиомы Хинчина Энтропия конечной вероятностной схемы с точностью до постоянного множителя однозначно определяется системой аксиом: H(p1,…,pn)

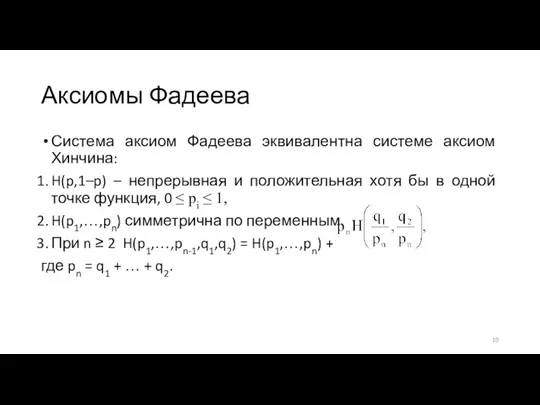

- 10. Аксиомы Фадеева Система аксиом Фадеева эквивалентна системе аксиом Хинчина: H(p,1–p) – непрерывная и положительная хотя бы

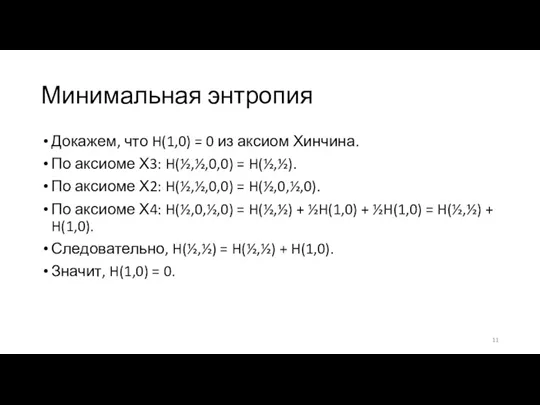

- 11. Минимальная энтропия Докажем, что H(1,0) = 0 из аксиом Хинчина. По аксиоме Х3: H(½,½,0,0) = H(½,½).

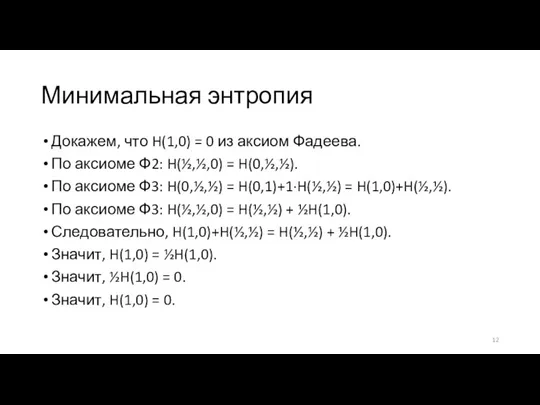

- 12. Минимальная энтропия Докажем, что H(1,0) = 0 из аксиом Фадеева. По аксиоме Ф2: H(½,½,0) = H(0,½,½).

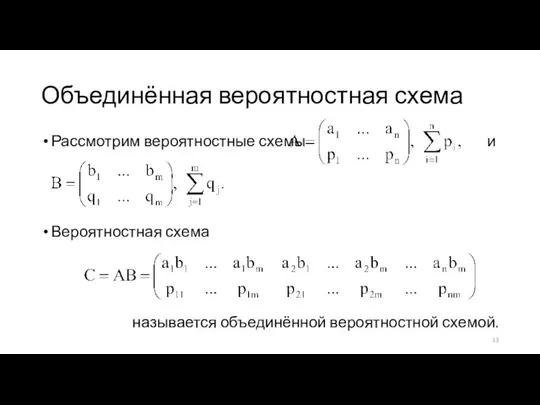

- 13. Объединённая вероятностная схема Рассмотрим вероятностные схемы и Вероятностная схема называется объединённой вероятностной схемой.

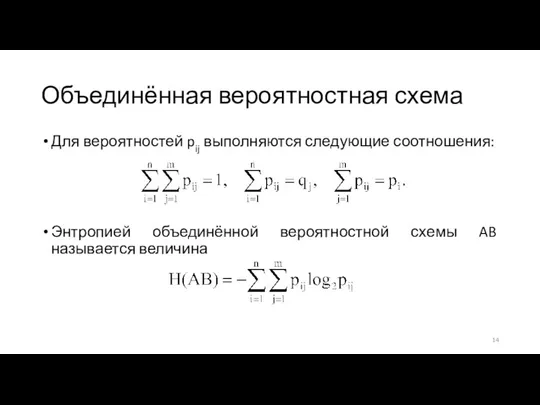

- 14. Объединённая вероятностная схема Для вероятностей pij выполняются следующие соотношения: Энтропией объединённой вероятностной схемы AB называется величина

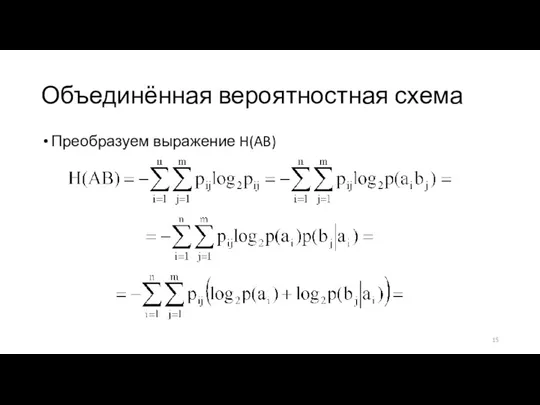

- 15. Объединённая вероятностная схема Преобразуем выражение H(AB)

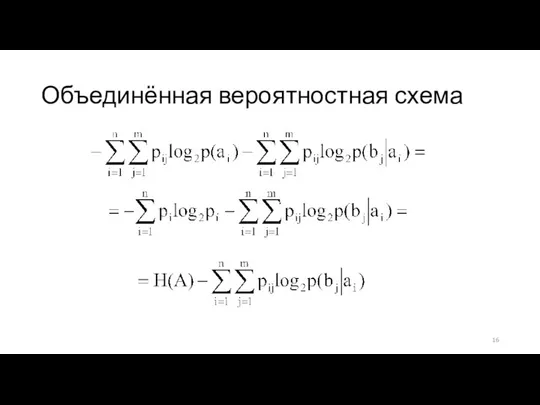

- 16. Объединённая вероятностная схема

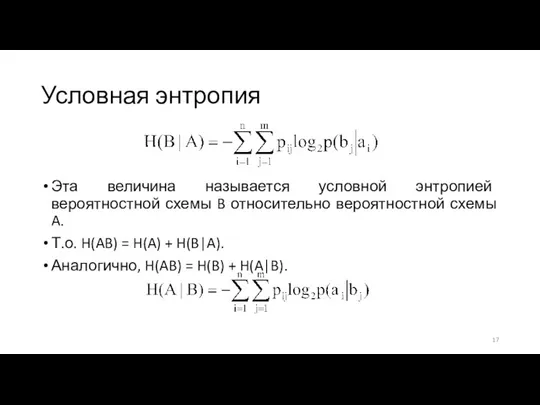

- 17. Условная энтропия Эта величина называется условной энтропией вероятностной схемы B относительно вероятностной схемы A. Т.о. H(AB)

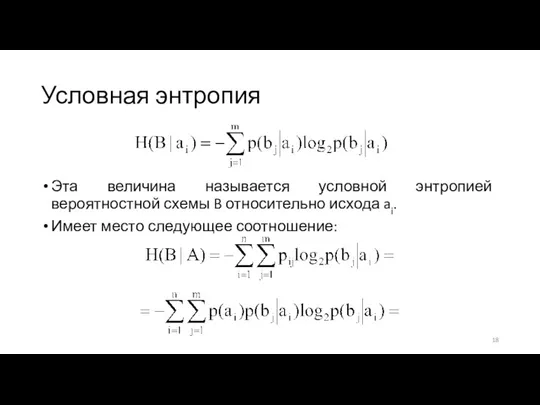

- 18. Условная энтропия Эта величина называется условной энтропией вероятностной схемы B относительно исхода ai. Имеет место следующее

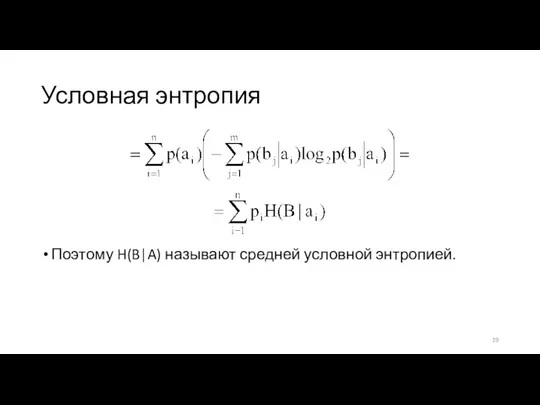

- 19. Условная энтропия Поэтому H(B|A) называют средней условной энтропией.

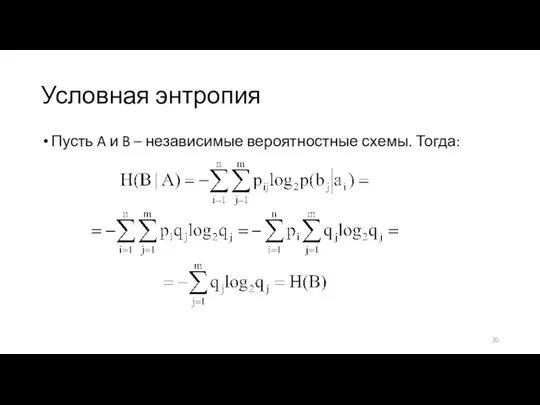

- 20. Условная энтропия Пусть A и B – независимые вероятностные схемы. Тогда:

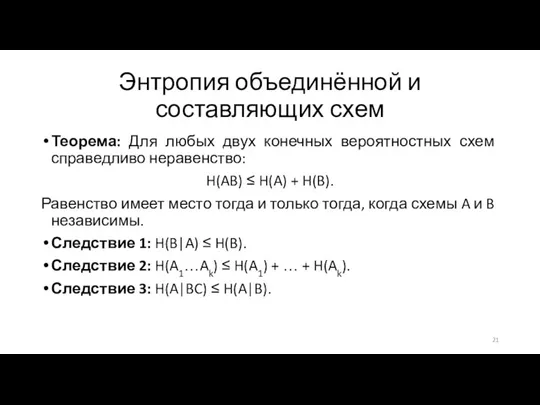

- 21. Энтропия объединённой и составляющих схем Теорема: Для любых двух конечных вероятностных схем справедливо неравенство: H(AB) ≤

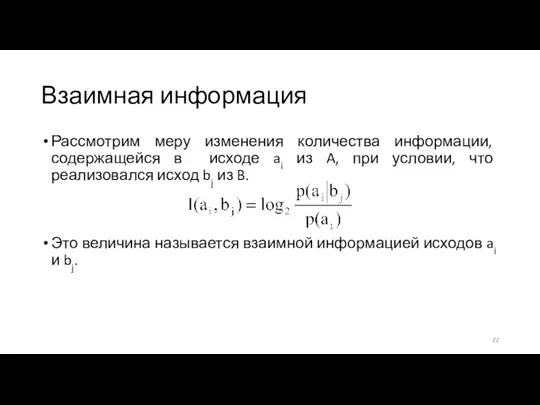

- 22. Взаимная информация Рассмотрим меру изменения количества информации, содержащейся в исходе ai из A, при условии, что

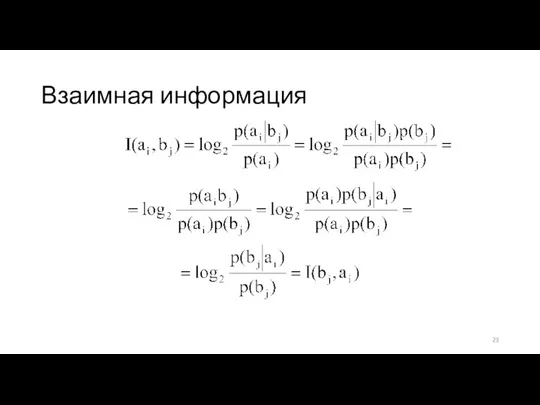

- 23. Взаимная информация

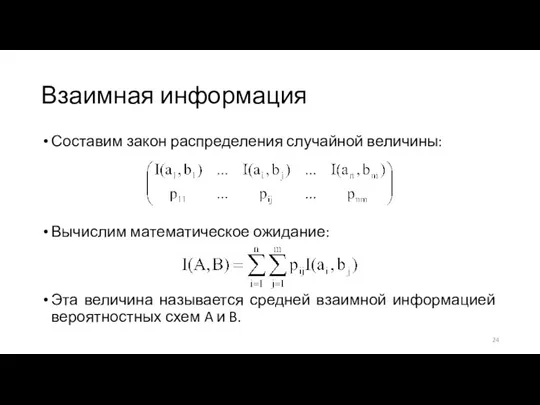

- 24. Взаимная информация Составим закон распределения случайной величины: Вычислим математическое ожидание: Эта величина называется средней взаимной информацией

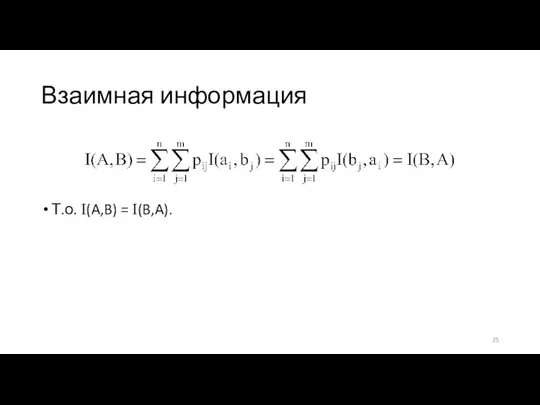

- 25. Взаимная информация Т.о. I(A,B) = I(B,A).

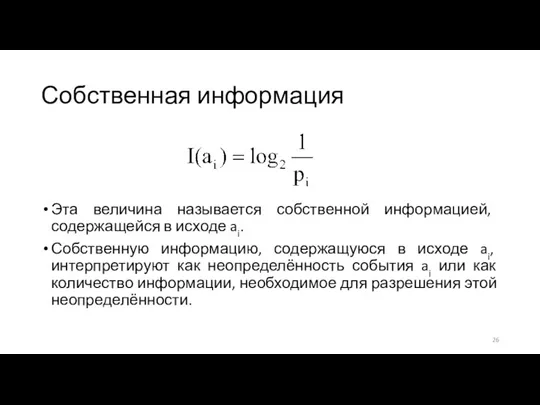

- 26. Собственная информация Эта величина называется собственной информацией, содержащейся в исходе ai. Собственную информацию, содержащуюся в исходе

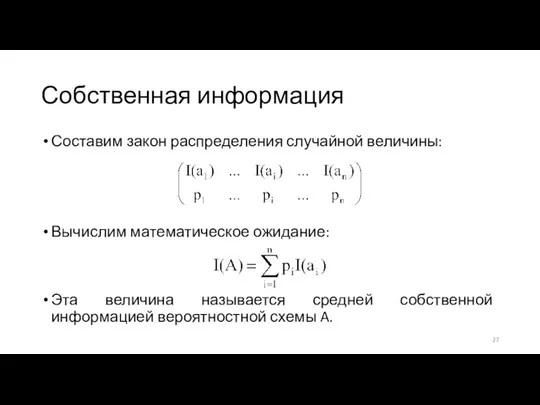

- 27. Собственная информация Составим закон распределения случайной величины: Вычислим математическое ожидание: Эта величина называется средней собственной информацией

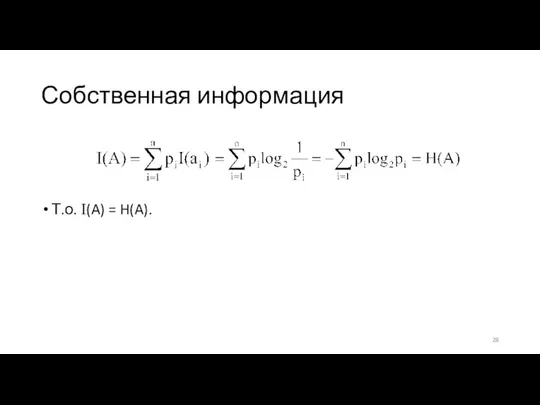

- 28. Собственная информация Т.о. I(A) = H(A).

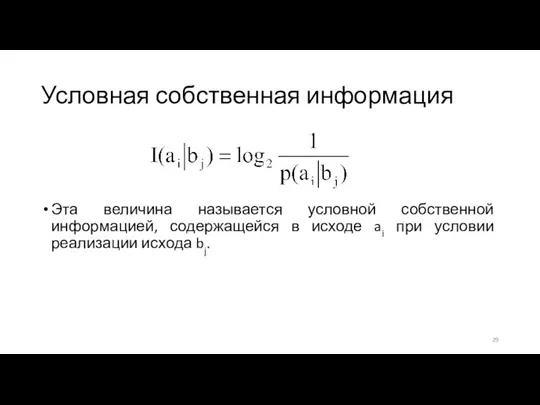

- 29. Условная собственная информация Эта величина называется условной собственной информацией, содержащейся в исходе ai при условии реализации

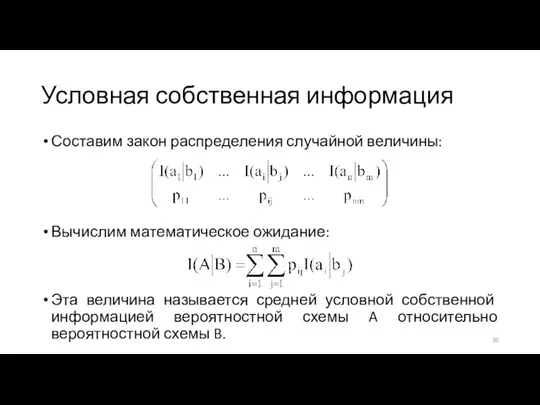

- 30. Условная собственная информация Составим закон распределения случайной величины: Вычислим математическое ожидание: Эта величина называется средней условной

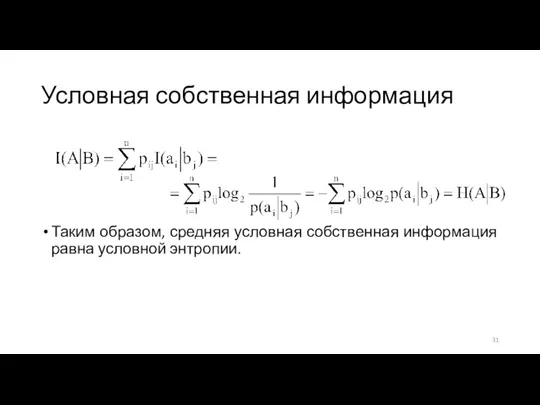

- 31. Условная собственная информация Таким образом, средняя условная собственная информация равна условной энтропии.

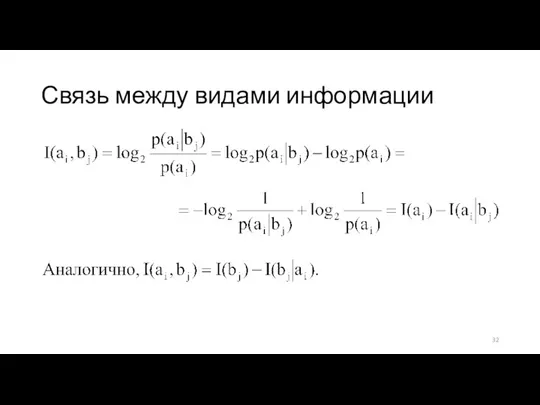

- 32. Связь между видами информации

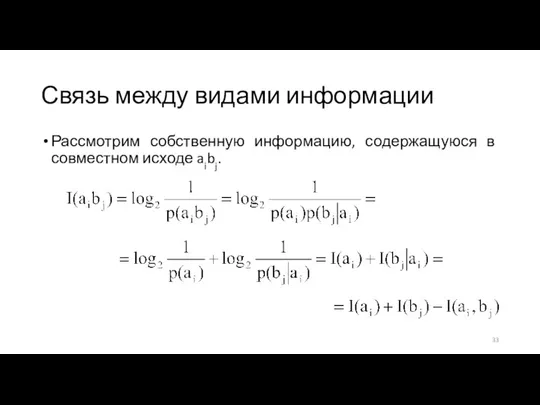

- 33. Связь между видами информации Рассмотрим собственную информацию, содержащуюся в совместном исходе aibj.

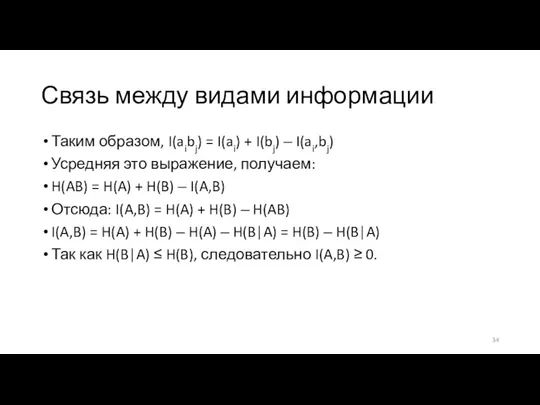

- 34. Связь между видами информации Таким образом, I(aibj) = I(ai) + I(bj) ‒ I(ai,bj) Усредняя это выражение,

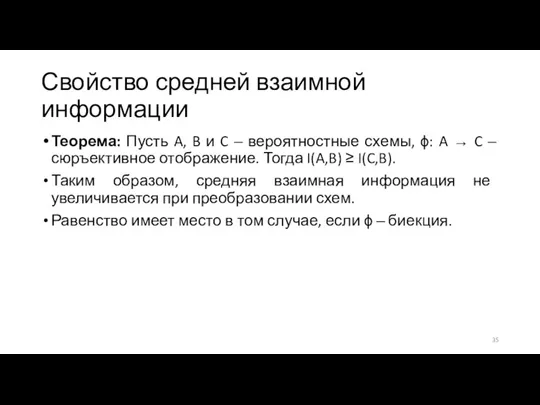

- 35. Свойство средней взаимной информации Теорема: Пусть A, B и C ‒ вероятностные схемы, ϕ: A →

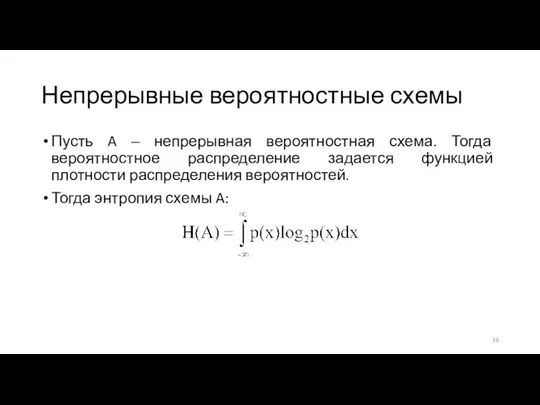

- 36. Непрерывные вероятностные схемы Пусть A ‒ непрерывная вероятностная схема. Тогда вероятностное распределение задается функцией плотности распределения

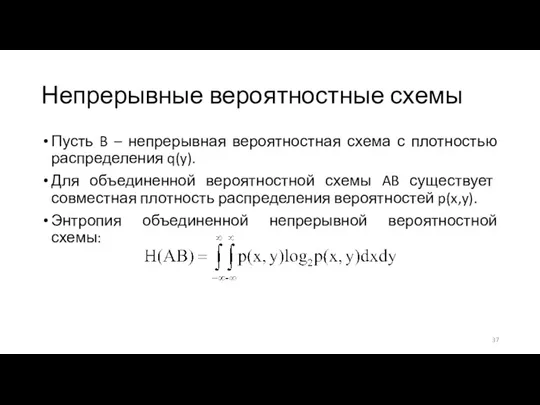

- 37. Непрерывные вероятностные схемы Пусть B – непрерывная вероятностная схема с плотностью распределения q(y). Для объединенной вероятностной

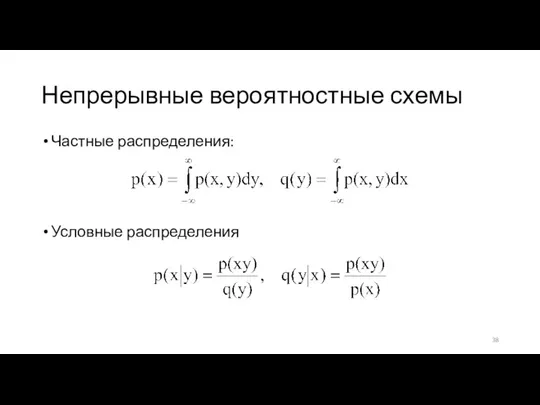

- 38. Непрерывные вероятностные схемы Частные распределения: Условные распределения

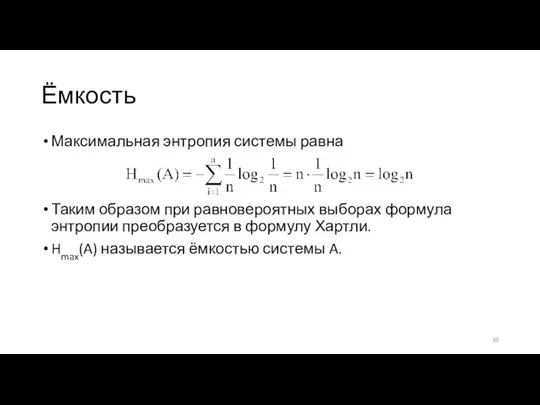

- 39. Ёмкость Максимальная энтропия системы равна Таким образом при равновероятных выборах формула энтропии преобразуется в формулу Хартли.

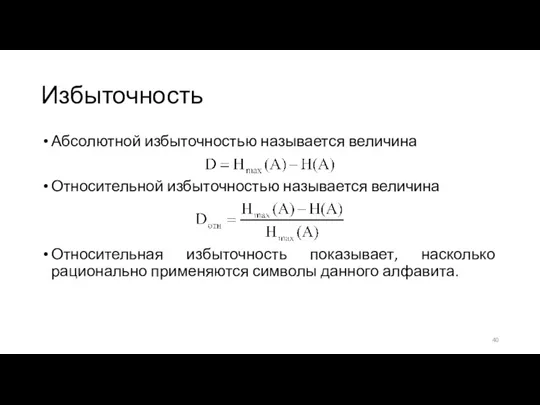

- 40. Избыточность Абсолютной избыточностью называется величина Относительной избыточностью называется величина Относительная избыточность показывает, насколько рационально применяются символы

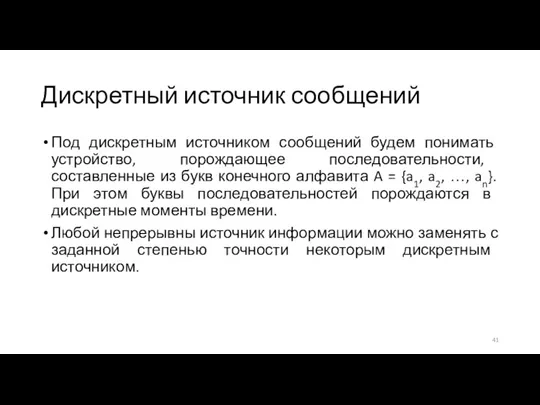

- 41. Дискретный источник сообщений Под дискретным источником сообщений будем понимать устройство, порождающее последовательности, составленные из букв конечного

- 42. Дискретный источник сообщений Пусть ct1t2…tm(ai1ai2…aim) ‒ событие, заключающееся в том, что в момент времени tj источник

- 43. Стационарный источник сообщений Источник сообщений называется стационарным, если p(ct1t2…tm(ai1ai2…aim)) = p(ct1+j t2+j…tm+j (ai1ai2…aim)) для любого j.

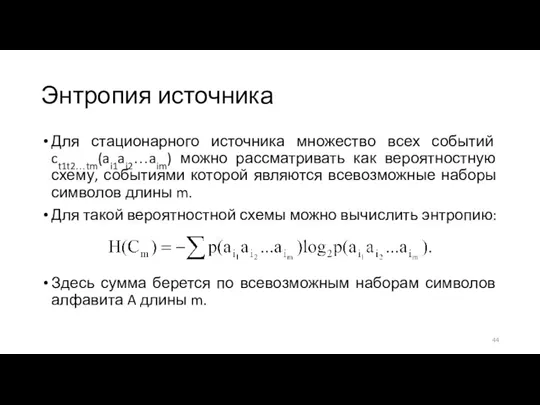

- 44. Энтропия источника Для стационарного источника множество всех событий ct1t2…tm(ai1ai2…aim) можно рассматривать как вероятностную схему, событиями которой

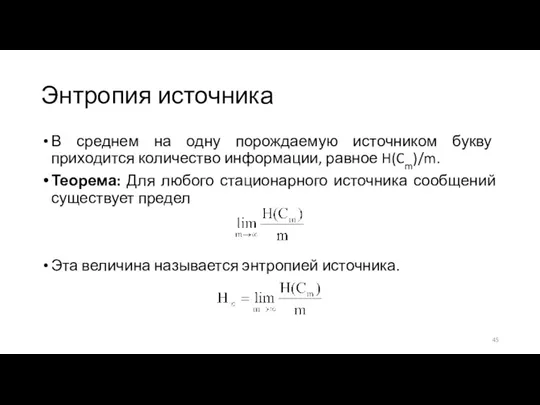

- 45. Энтропия источника В среднем на одну порождаемую источником букву приходится количество информации, равное H(Cm)/m. Теорема: Для

- 46. Энтропия источника Пусть источник порождает последовательности по схеме независимых испытаний. Тогда H(Cm) = mH(C1) = mH(A).

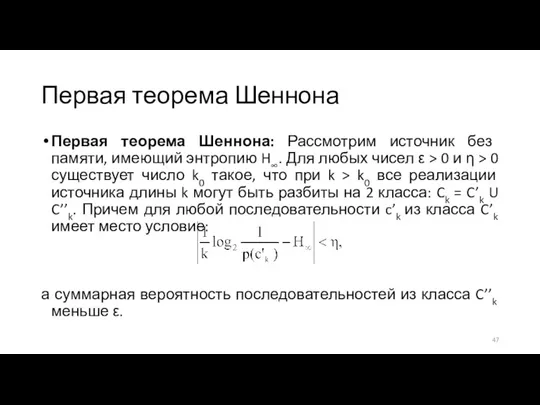

- 47. Первая теорема Шеннона Первая теорема Шеннона: Рассмотрим источник без памяти, имеющий энтропию H∞. Для любых чисел

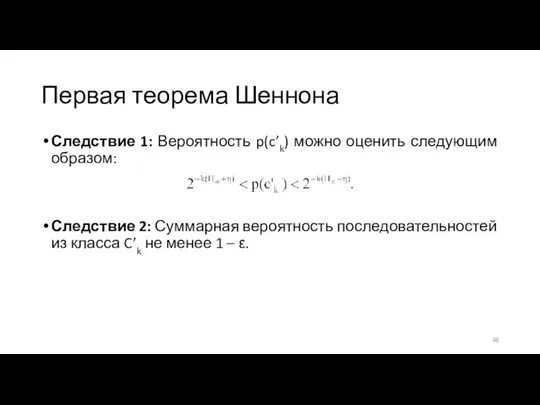

- 48. Первая теорема Шеннона Следствие 1: Вероятность p(c’k) можно оценить следующим образом: Следствие 2: Суммарная вероятность последовательностей

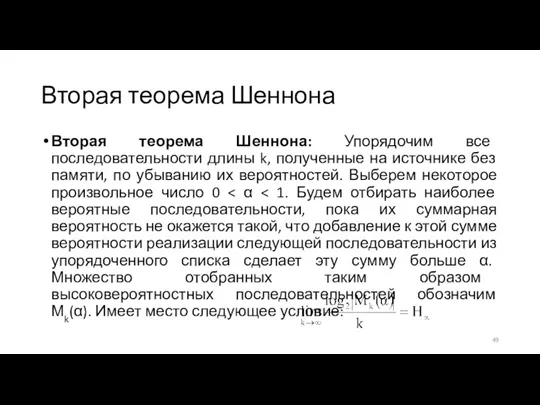

- 49. Вторая теорема Шеннона Вторая теорема Шеннона: Упорядочим все последовательности длины k, полученные на источнике без памяти,

- 51. Скачать презентацию

Представление текста, изображения и звука в компьютере

Представление текста, изображения и звука в компьютере Сортировка и поиск данных в Электронных таблицах

Сортировка и поиск данных в Электронных таблицах Этика сетевого общения

Этика сетевого общения Протокол SIP

Протокол SIP Информация. Виды информации. Свойства информации

Информация. Виды информации. Свойства информации Love for sale

Love for sale Инструкция пользователю

Инструкция пользователю Искусственный интеллект и ЭВМ

Искусственный интеллект и ЭВМ Разработка программного обеспечения модульного учебно-методического комплекса для операционной системы Windows

Разработка программного обеспечения модульного учебно-методического комплекса для операционной системы Windows Технология быстрого описания бизнес-процессов

Технология быстрого описания бизнес-процессов Что изучает информатика?

Что изучает информатика? Индикаторы развития информационного общества в России на современном этапе

Индикаторы развития информационного общества в России на современном этапе Алгоритм - модель деятельности исполнения алгоритмов

Алгоритм - модель деятельности исполнения алгоритмов Как мы рассказываем истории в цифровую эпоху

Как мы рассказываем истории в цифровую эпоху Разработка информационной системы для туристической фирмы

Разработка информационной системы для туристической фирмы База данных ЭБС IPRbooks www.iprbookshop.ru

База данных ЭБС IPRbooks www.iprbookshop.ru Введение в СУБД ORACLE. Лекция 1

Введение в СУБД ORACLE. Лекция 1 1015355

1015355 Протокол TCP/IP

Протокол TCP/IP уроки настоящего автомобилестроения

уроки настоящего автомобилестроения Кодирование числовой информации. Системы счисления. Представление чисел в компьютере

Кодирование числовой информации. Системы счисления. Представление чисел в компьютере Технология создания мультимедийной презентации

Технология создания мультимедийной презентации Цифровое депо

Цифровое депо Модель OSI. Сети доступа. Лекция 3

Модель OSI. Сети доступа. Лекция 3 Использование мини колонки. Маруся – наш помощник

Использование мини колонки. Маруся – наш помощник Реляционные базы данных

Реляционные базы данных Технические риски в интернете

Технические риски в интернете Базы данных и системы управления базами данных. Построение модели Сущность-связь (ER-диаграмма)

Базы данных и системы управления базами данных. Построение модели Сущность-связь (ER-диаграмма)