Слайд 2

Немного истории

С самого появления GPU у разработчиков появилась идея перекладывать часть

расчетов с CPU на GPU, но архитектура не позволяла это делать. Почти. Разработчикам удавалось выкрутиться и заставить GPU выполнять нужные инструкции, но зачастую это того не стоило.

Слайд 3

Краткое введение в технологию

Технология CUDA — это программно-аппаратная вычислительная архитектура Nvidia,

основанная на расширении языка Си, которая даёт возможность организации доступа к набору инструкций графического ускорителя и управления его памятью при организации параллельных вычислений.

Слайд 4

Основные возможности технологии

Унифицированное программно-аппаратное решение для параллельных вычислений на видеочипах Nvidia;

Стандартный

язык программирования Си;

Стандартные библиотеки численного анализа FFT (быстрое преобразование Фурье) и BLAS (линейная алгебра);

Оптимизированный обмен данными между CPU и GPU;

Взаимодействие с графическими API OpenGL и DirectX;

Возможность разработки на низком уровне.

Слайд 5

Основные сферы применения

Симуляция поведения различных тел

Обработка графики

Расчет геометрии

Вычисление различных хэшей

Компьютерное

зрение

Искусственный интеллект

Слайд 6

Техническая реализация

Для вызова функции на стороне GPU нужно:

Выделить память под аргументы

Скопировать

данные с хоста в блок памяти GPU.

Произвести вызов функции (будет рассмотрено далее)

Освободить память после выполнения

Слайд 7

Работа с памятью

Работа с памятью организована при помощи функций

cudaMalloc – выделение

блока памяти

cudaMalloc3D – выделение блока под трехмерный массив (width*height*depth)

cudaMalloc3DArray – аналогично cudaMalloc3D, но для массива таких объектов

cudaMallocArray – выделение массива блоков

cudaMallocPitch – выделение памяти под массивы*

cudaFree – освободить блок памяти

Слайд 8

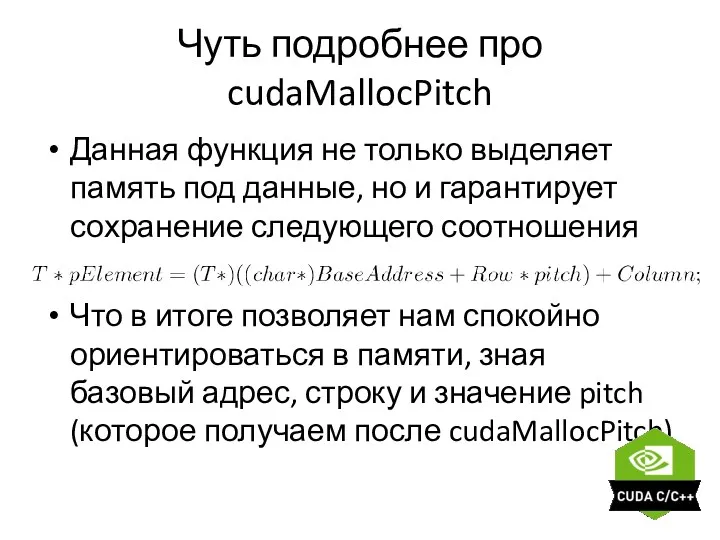

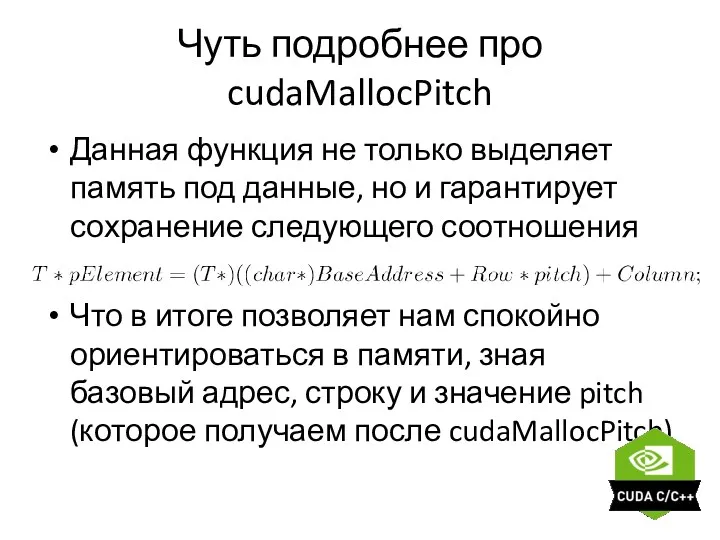

Чуть подробнее про cudaMallocPitch

Данная функция не только выделяет память под данные,

но и гарантирует сохранение следующего соотношения

Что в итоге позволяет нам спокойно ориентироваться в памяти, зная базовый адрес, строку и значение pitch (которое получаем после cudaMallocPitch)

Слайд 9

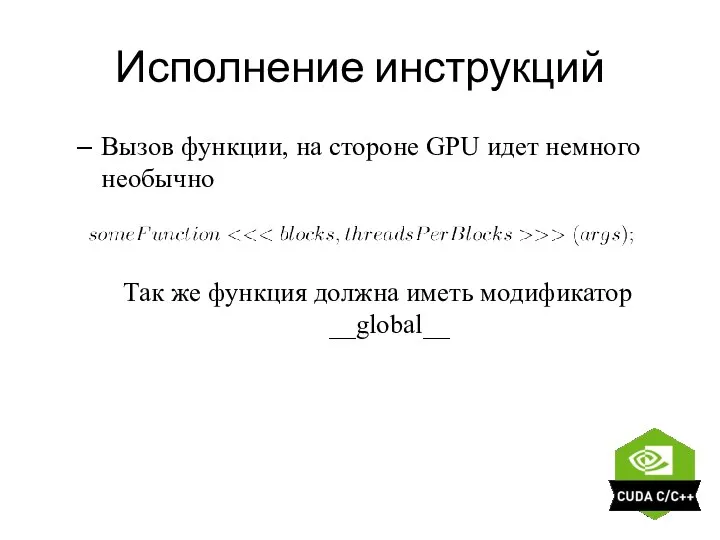

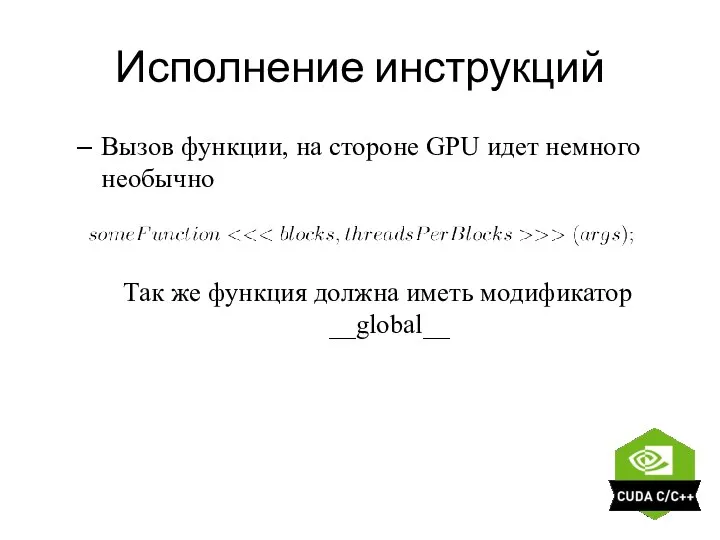

Исполнение инструкций

Вызов функции, на стороне GPU идет немного необычно

Так же функция

должна иметь модификатор __global__

Слайд 10

Плюсы технологии

Быстрые вычисления

Хорошая архитектура для многопоточности

Удобный инструментарий и отсутствие лишних телодвижений

при передаче инструкций (за исключением чутка странного вызова __global__ функций)

Удобная работа с памятью

Поддержка основных платформ

Слайд 11

Минусы технологии

Передача данных от CPU к GPU достаточно дорогая операция. Иногда

это заставляет передавать лишние данные.

Проприетарная архитектура CUDA.

Устаревшая поддержка Visual Studio 2012, но кому это нужно, когда есть он

Слайд 12

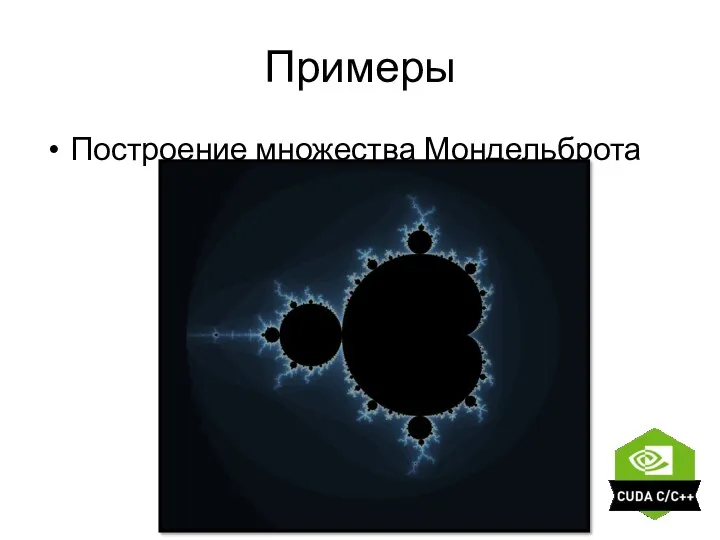

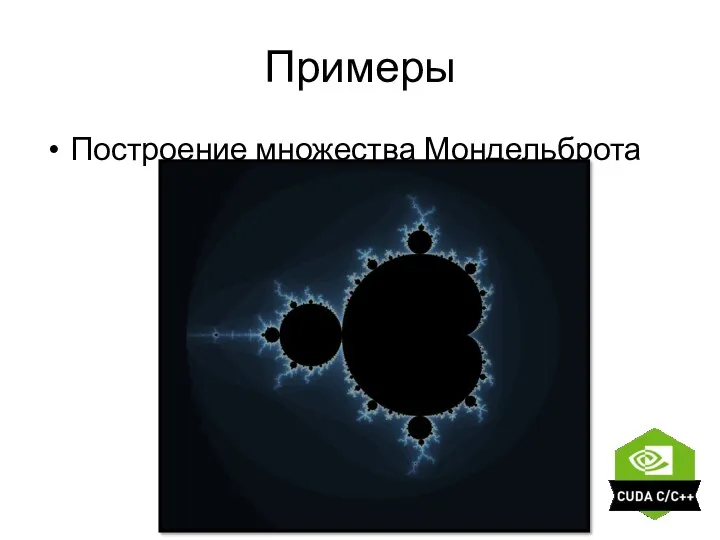

Примеры

Построение множества Мондельброта

Слайд 13

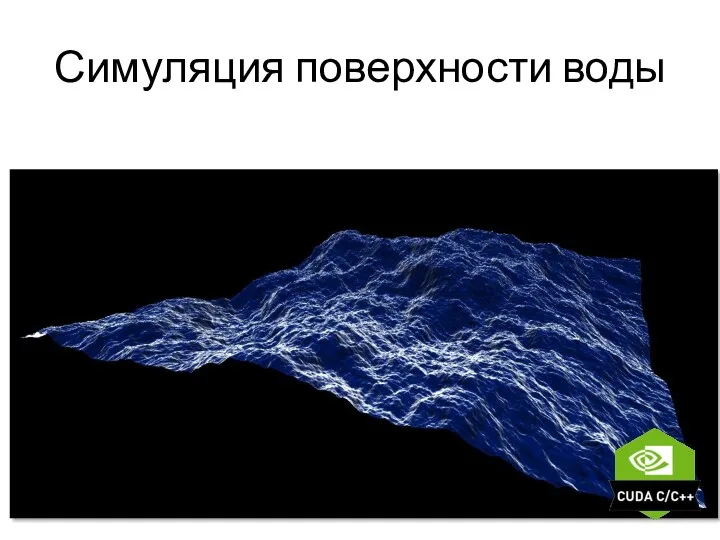

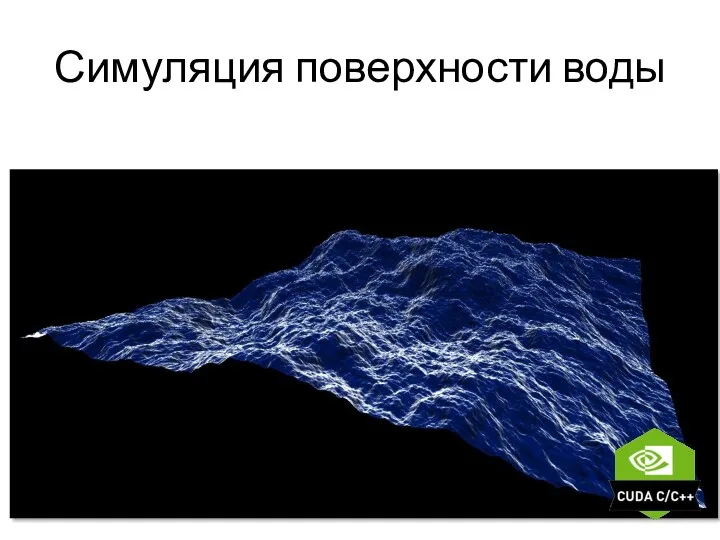

Симуляция поверхности воды

Азбука журналистики

Азбука журналистики Методы и средства хранения информации

Методы и средства хранения информации Сел қауіптілігін карторграфиялауға арналған геоақпараттық жүйелер

Сел қауіптілігін карторграфиялауға арналған геоақпараттық жүйелер Защита информации в базах данных

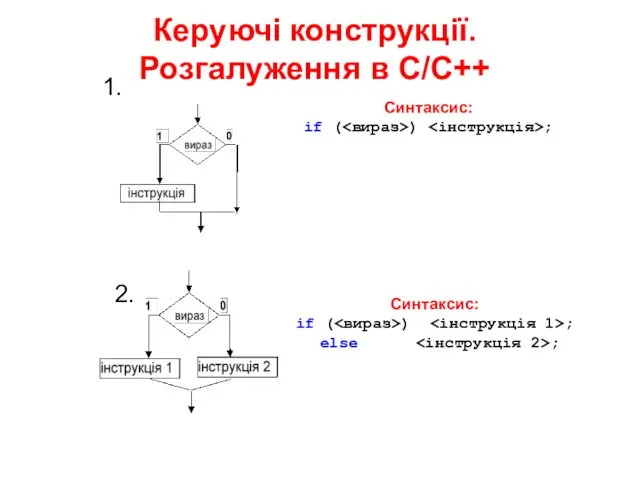

Защита информации в базах данных Керуючі конструкції. Розгалуження в С/C++

Керуючі конструкції. Розгалуження в С/C++ Вёрстка и дизайн газетной статьи

Вёрстка и дизайн газетной статьи Всемирная компьютерная сеть интернет. Опорный конспект

Всемирная компьютерная сеть интернет. Опорный конспект Составляющие информационной технологии

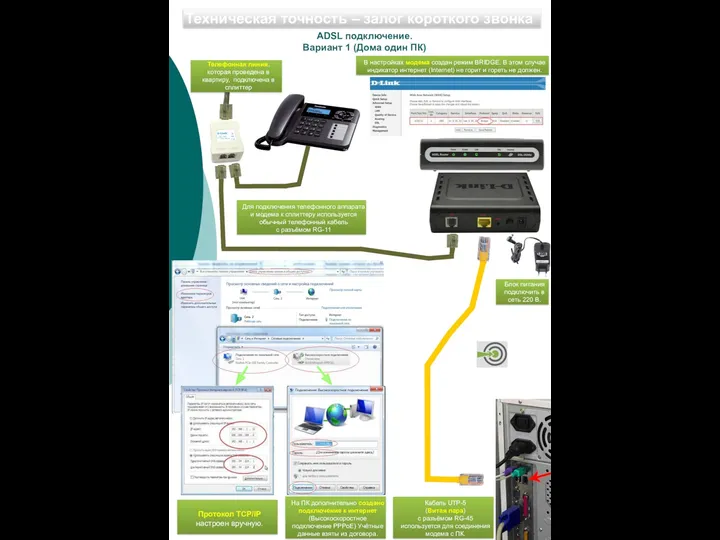

Составляющие информационной технологии Шесть видов подключения интернета

Шесть видов подключения интернета NAVY. Проблемы в создании рекламных роликов

NAVY. Проблемы в создании рекламных роликов Программирование в компьютерных системах

Программирование в компьютерных системах FaceByte UI Review

FaceByte UI Review Операционная система

Операционная система Минимальные маршруты и покрытия. Лекция 5

Минимальные маршруты и покрытия. Лекция 5 Измерение информации

Измерение информации Современная поэзия. Где смотреть

Современная поэзия. Где смотреть Презентация по теме Основы алгоритмизации

Презентация по теме Основы алгоритмизации Компьютерная лексикография (электронные словари в интернете)

Компьютерная лексикография (электронные словари в интернете) Проектная деятельность на уроках информатики

Проектная деятельность на уроках информатики Право и этика в Интернете

Право и этика в Интернете Графика в Quick Basic

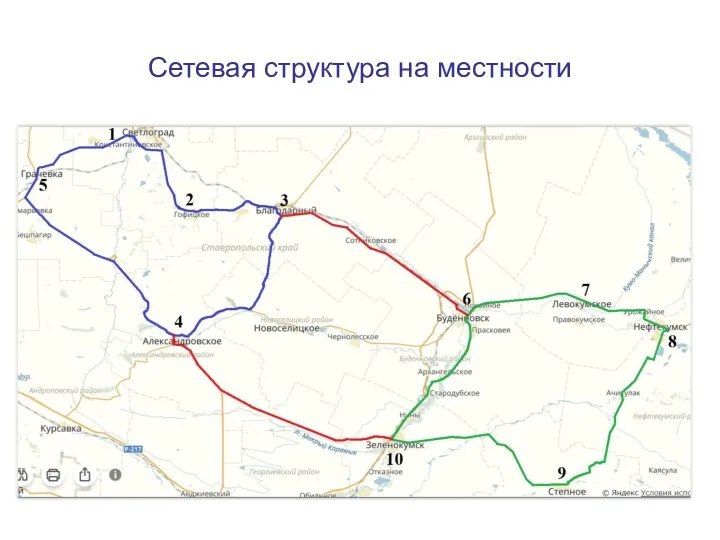

Графика в Quick Basic Сетевая структура на местности

Сетевая структура на местности Информация. Аппаратура компьютера

Информация. Аппаратура компьютера Правила создания презентаций.Урок родного (русского) языка.. 6 класс

Правила создания презентаций.Урок родного (русского) языка.. 6 класс Создание видеоклипа из цифровых фотографий

Создание видеоклипа из цифровых фотографий Сжатие, архивация и разархивация данных. Архиваторы. Работа с архивами

Сжатие, архивация и разархивация данных. Архиваторы. Работа с архивами Widgets. Custom Widgets Types

Widgets. Custom Widgets Types Презентация:Базы данных Урок 11 класс; Урок: Моделирование как метод познания.

Презентация:Базы данных Урок 11 класс; Урок: Моделирование как метод познания.