Слайд 2

План на жизнь

На следующей паре тест!

Пользоваться можно будет всем кроме соцсетей

и соседей

Слайд 3

Дистрибутивная семантика

Дистрибутивная семантика — это область лингвистики, которая занимается вычислением степени

семантической близости между лингвистическими единицами на основании их дистрибуционных признаков в больших массивах лингвистических данных.

Слайд 4

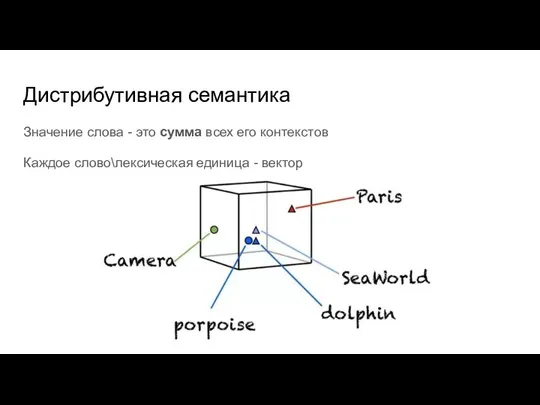

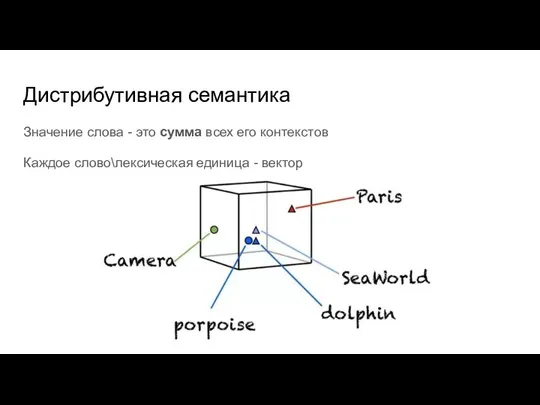

Дистрибутивная семантика

Значение слова - это сумма всех его контекстов

Каждое слово\лексическая единица

- вектор

Слайд 5

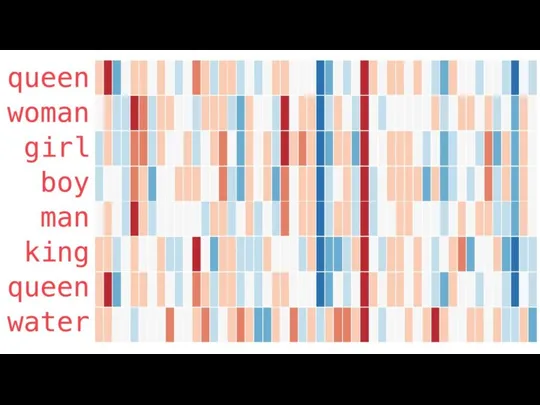

Векторное представление слов

Каждое слово - это вектор

Иначе: word embeddings

Слайд 6

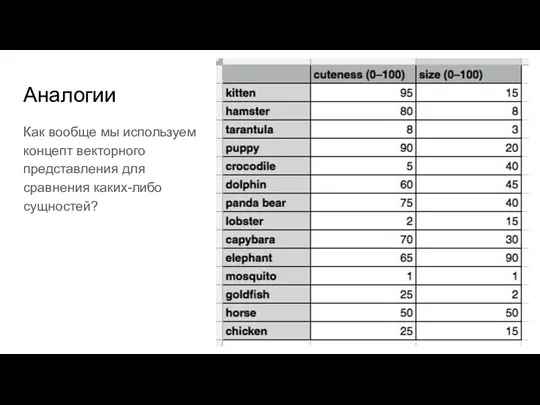

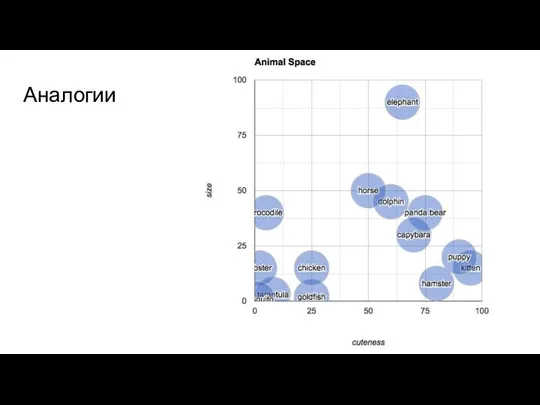

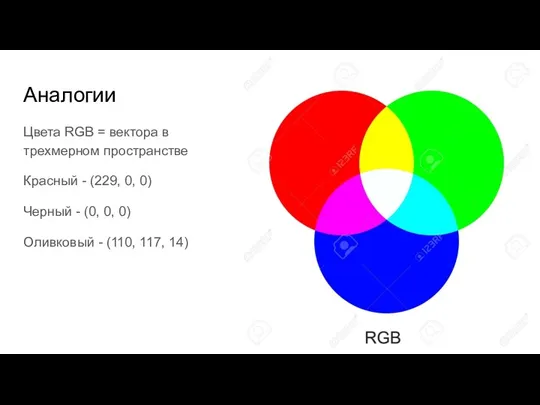

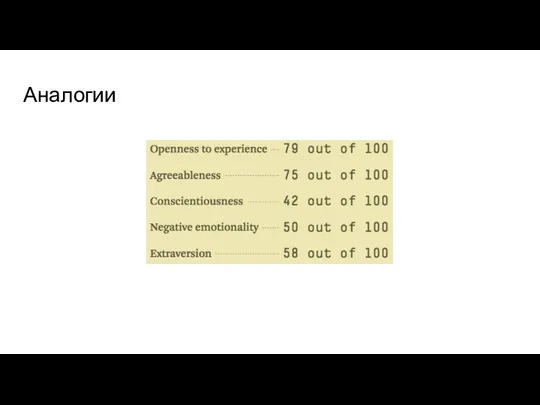

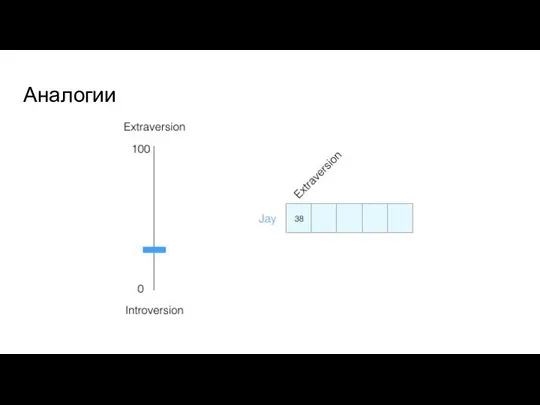

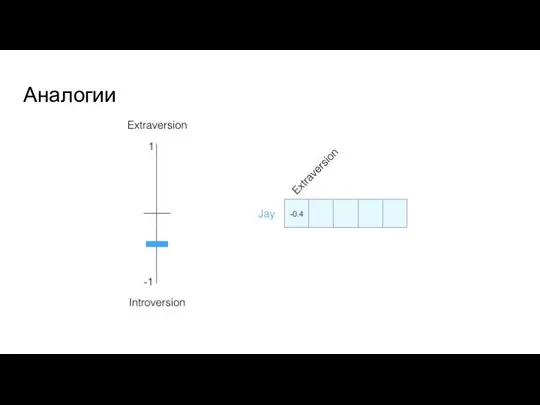

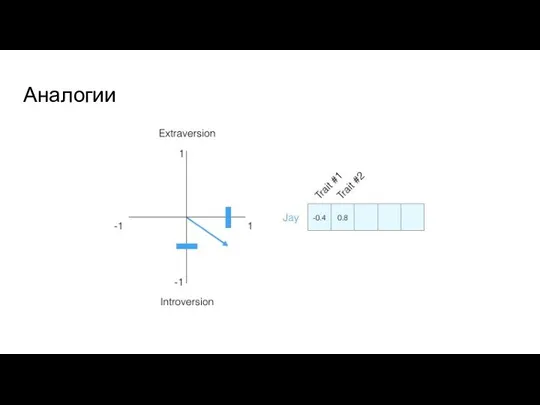

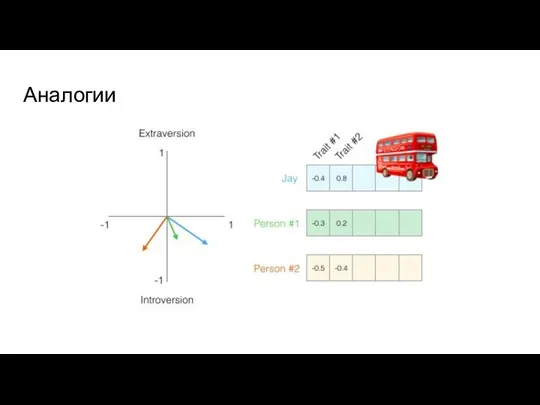

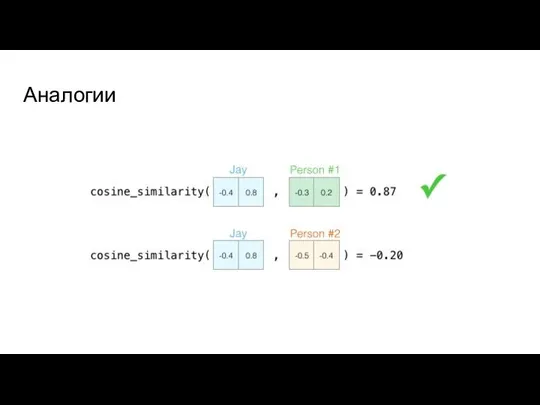

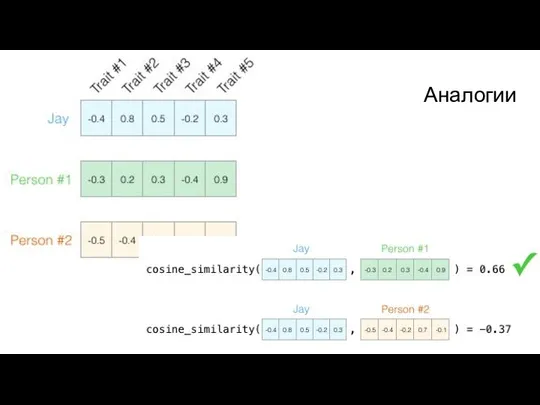

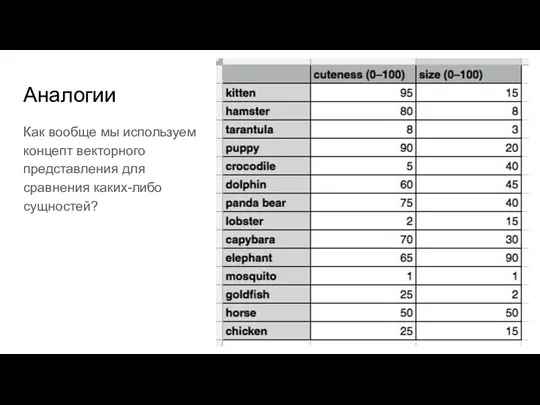

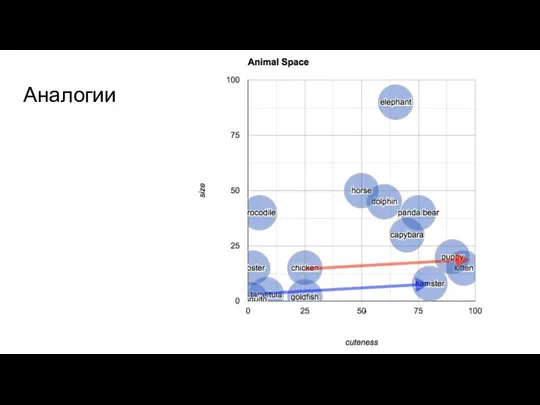

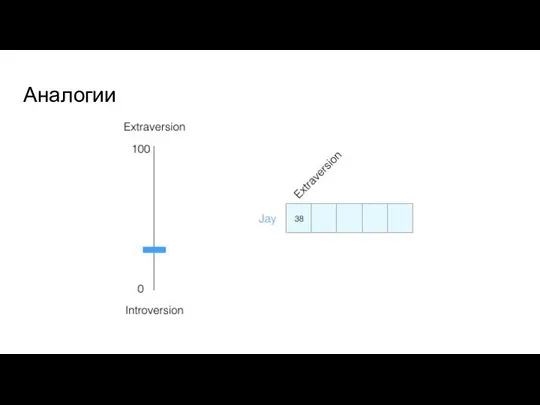

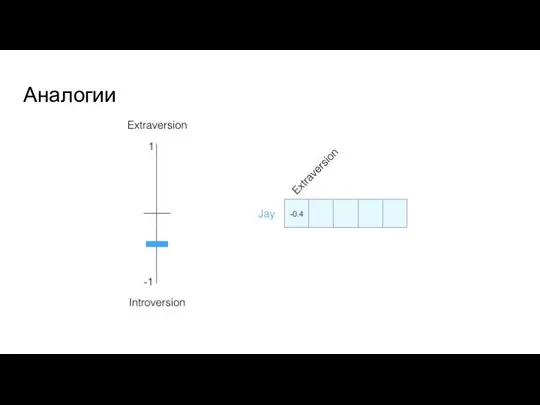

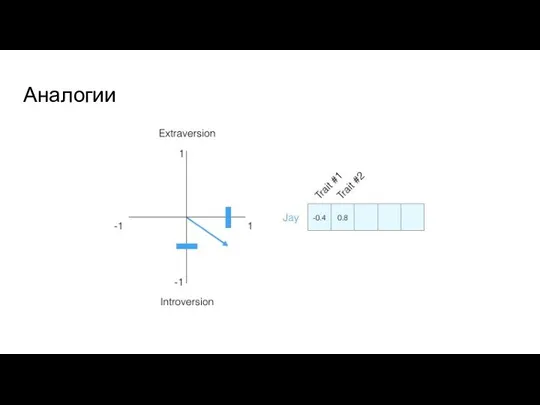

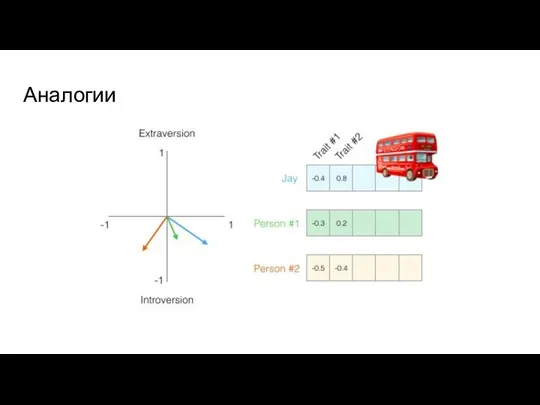

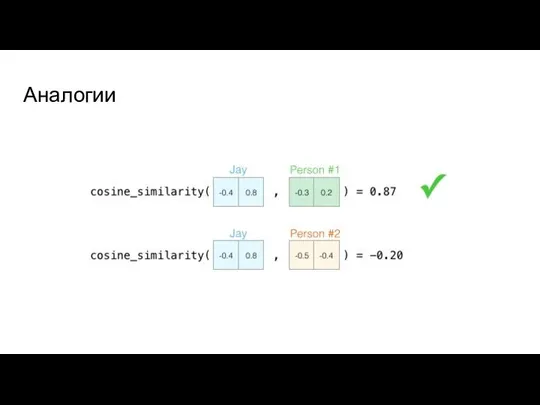

Аналогии

Как вообще мы используем концепт векторного представления для сравнения каких-либо сущностей?

Слайд 7

Слайд 8

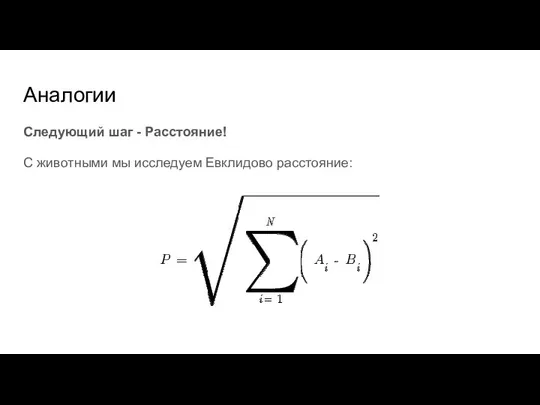

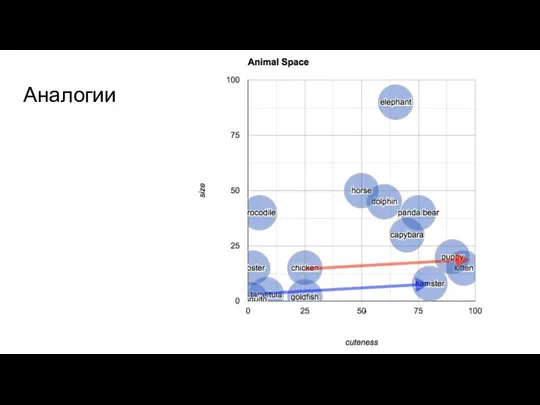

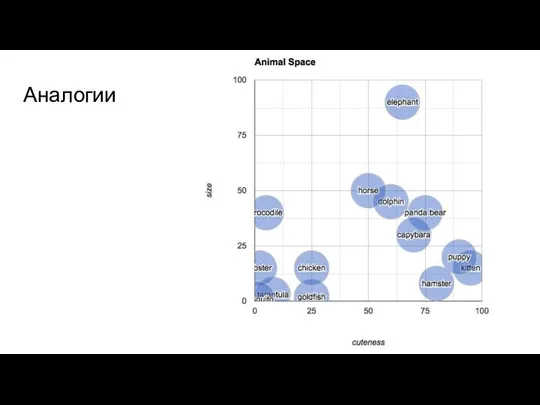

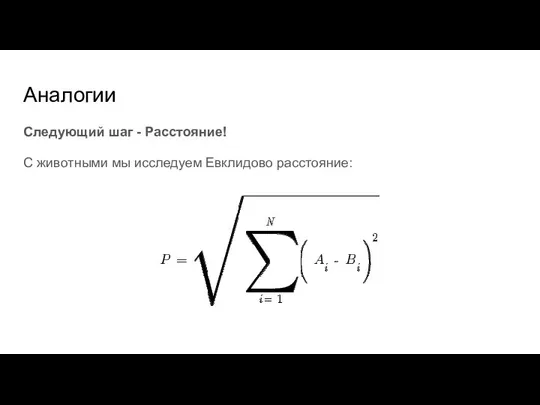

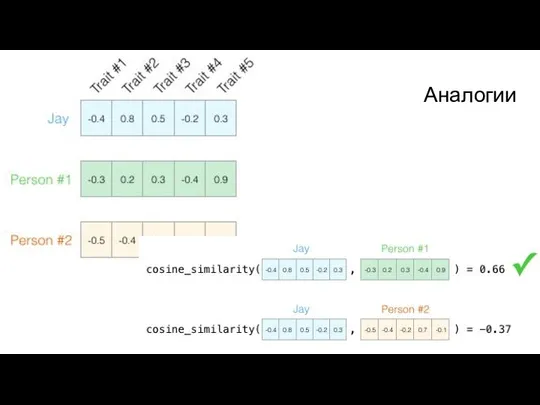

Аналогии

Следующий шаг - Расстояние!

С животными мы исследуем Евклидово расстояние:

Слайд 9

Слайд 10

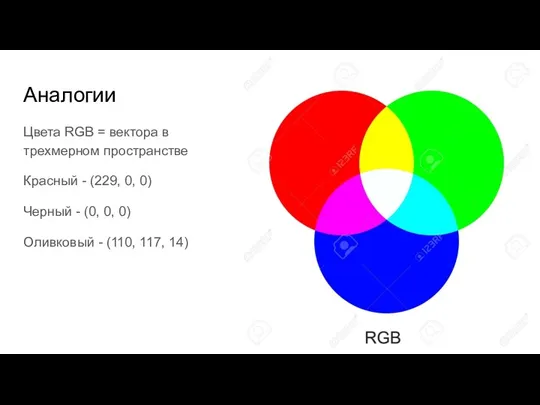

Аналогии

Цвета RGB = вектора в трехмерном пространстве

Красный - (229, 0, 0)

Черный

- (0, 0, 0)

Оливковый - (110, 117, 14)

Слайд 11

Слайд 12

Слайд 13

Слайд 14

Слайд 15

Слайд 16

Слайд 17

Слайд 18

Слайд 19

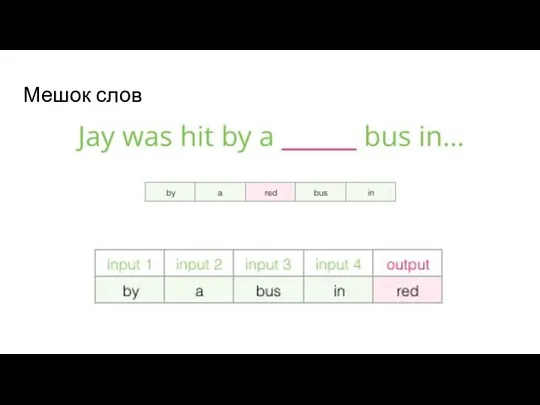

Наивный подход

Разные виды близости слов: лексическая и семантическая

петух

курица

цыпленок

Слайд 20

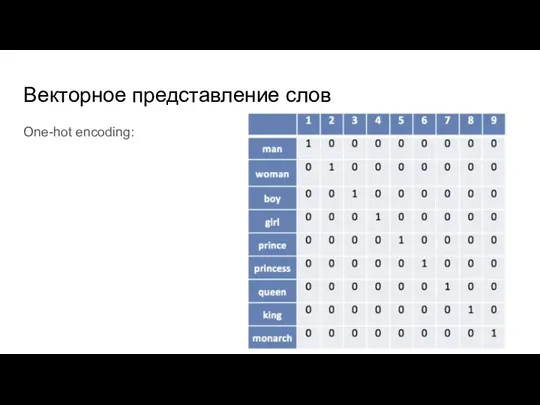

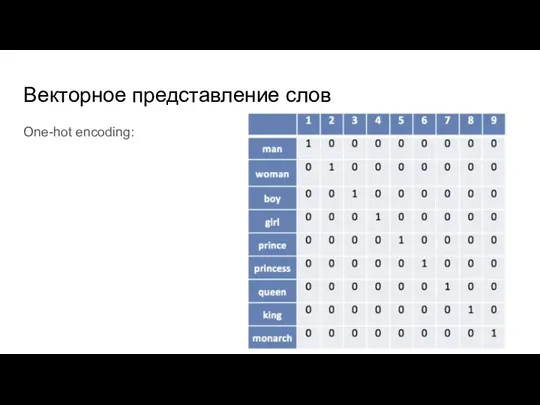

Векторное представление слов

One-hot encoding:

Слайд 21

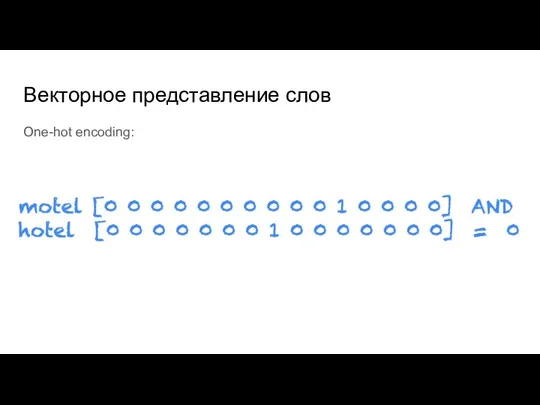

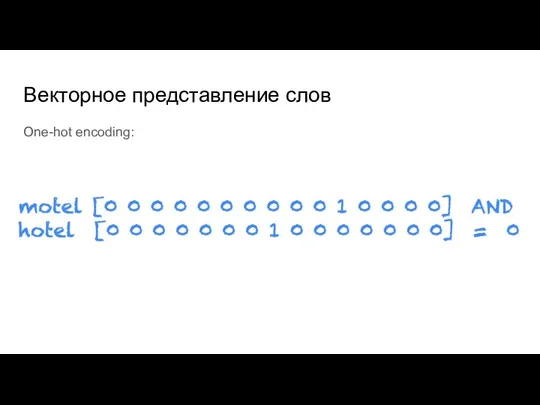

Векторное представление слов

One-hot encoding:

Слайд 22

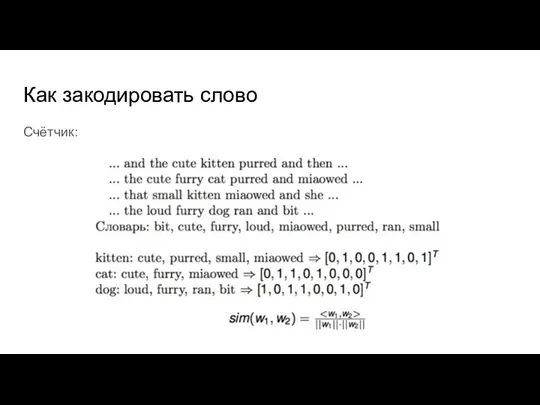

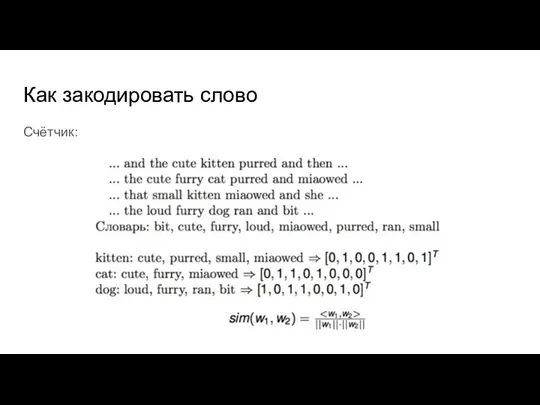

Как закодировать слово

Счётчик:

Слайд 23

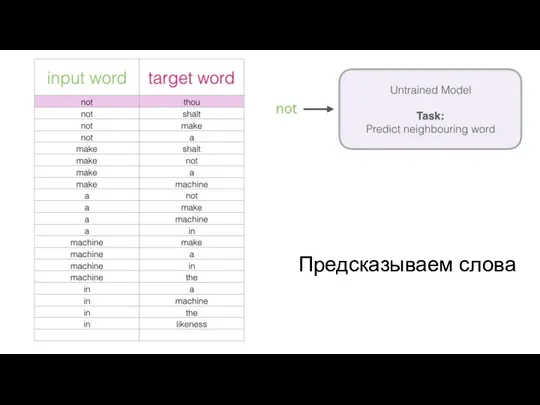

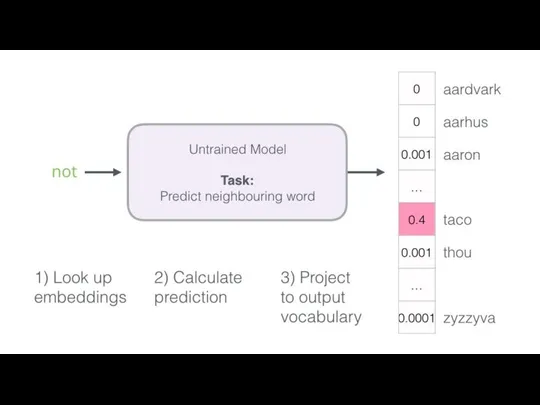

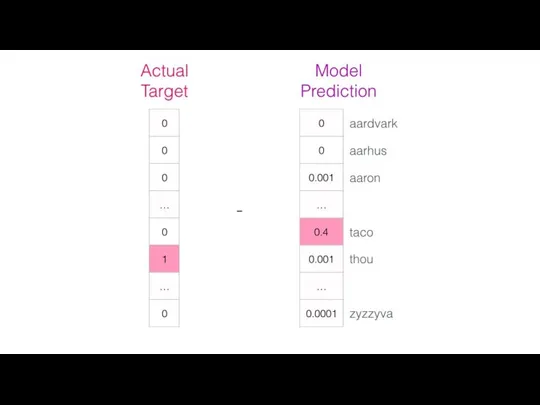

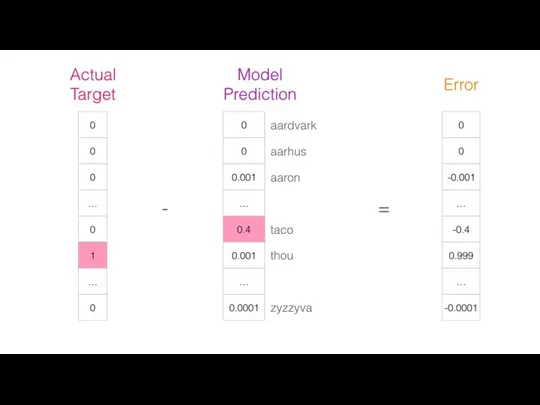

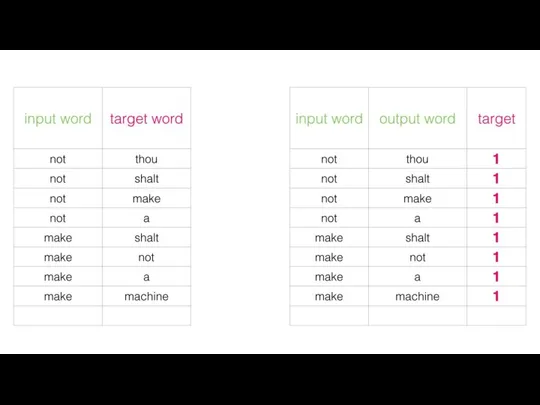

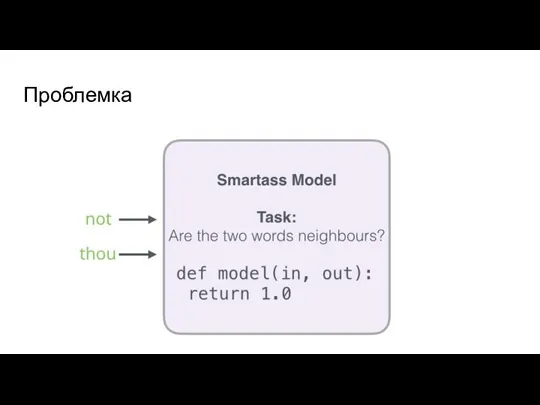

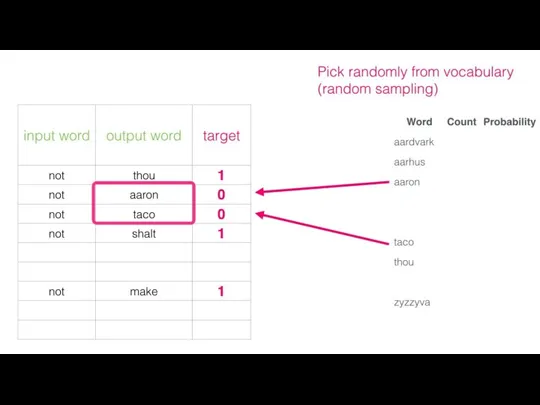

Как обучить компьютер отделять слова?

word2vec

Слайд 24

Слайд 25

Слайд 26

Слайд 27

Слайд 28

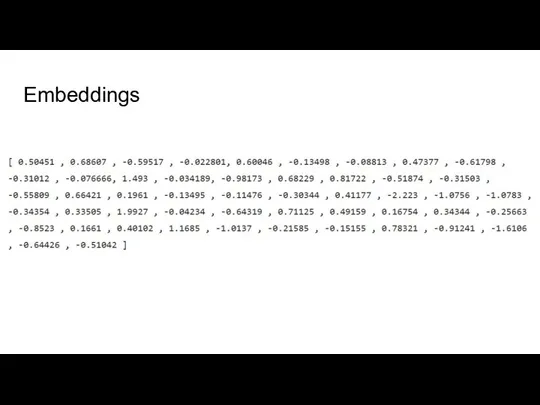

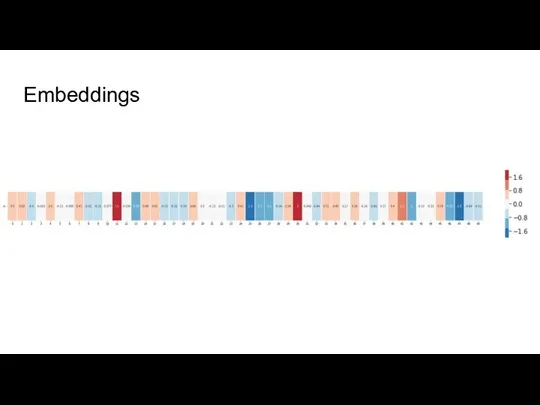

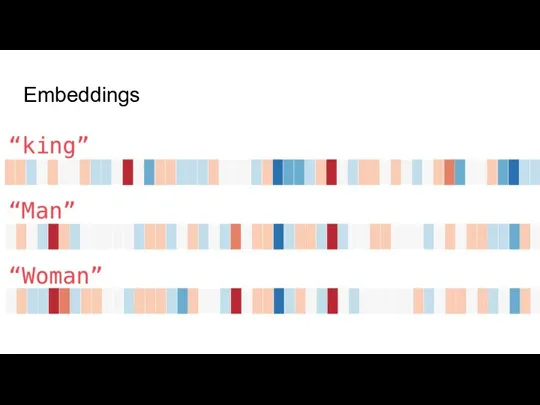

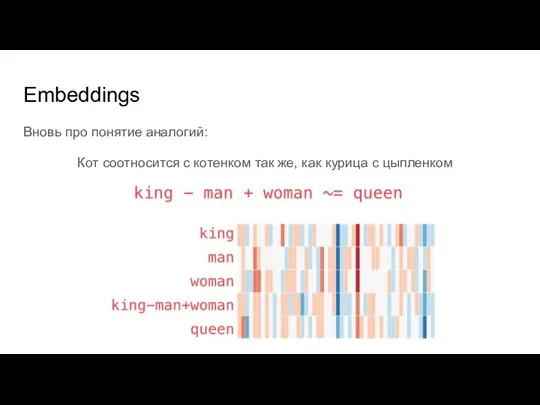

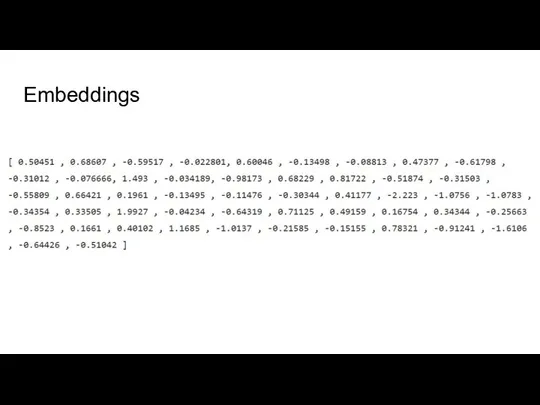

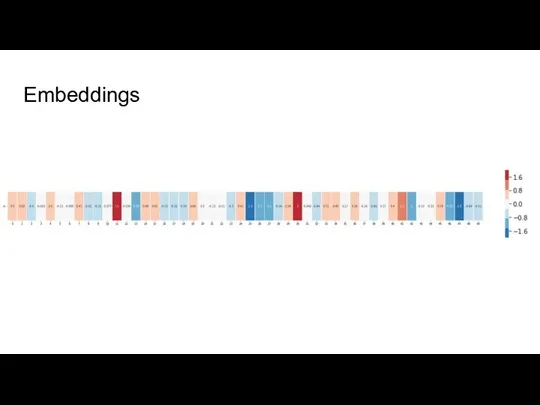

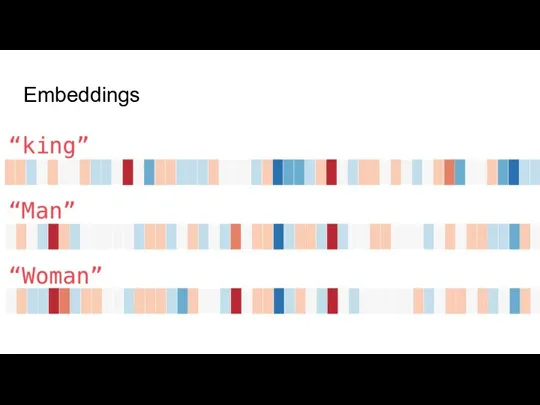

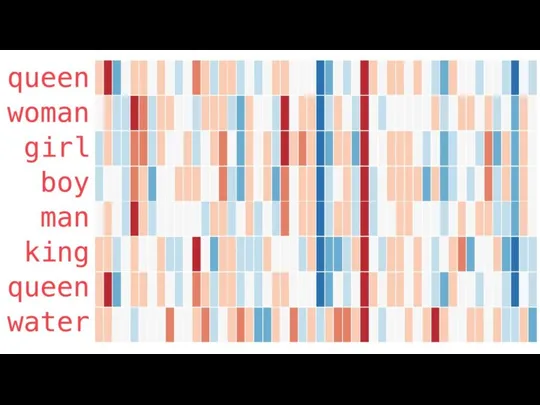

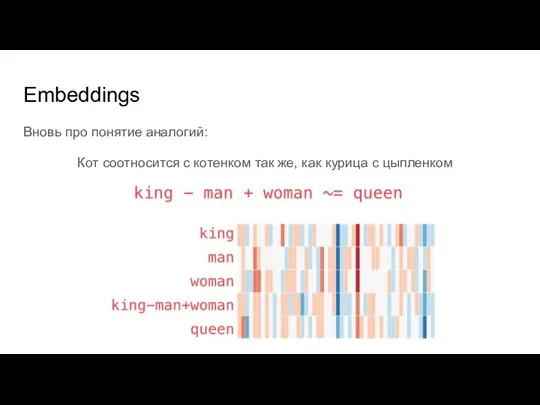

Embeddings

Вновь про понятие аналогий:

Кот соотносится с котенком так же, как курица

с цыпленком

Слайд 29

Слайд 30

Слайд 31

Слайд 32

Слайд 33

Слайд 34

Слайд 35

Слайд 36

Слайд 37

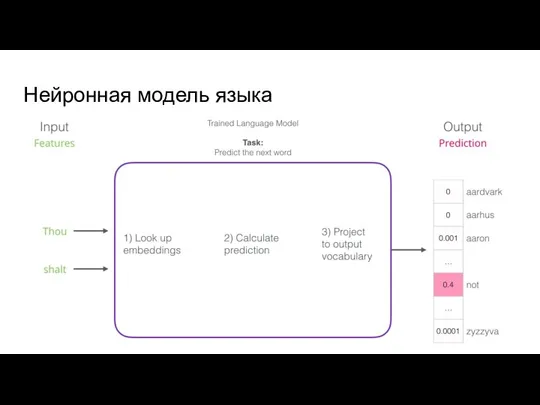

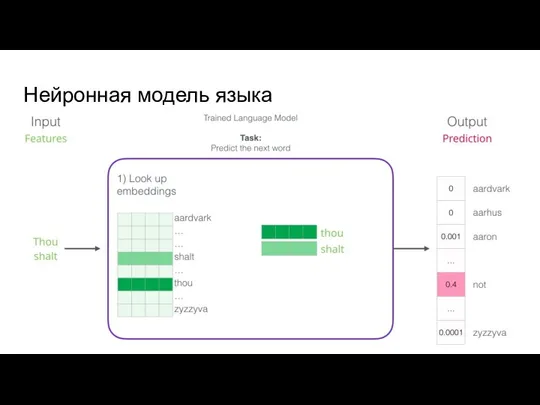

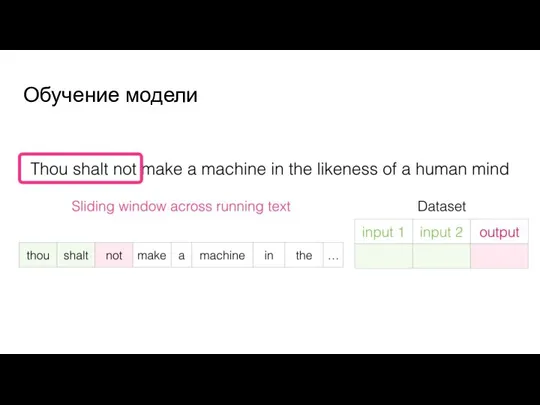

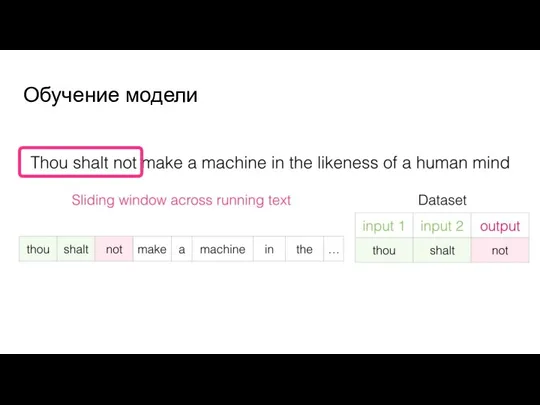

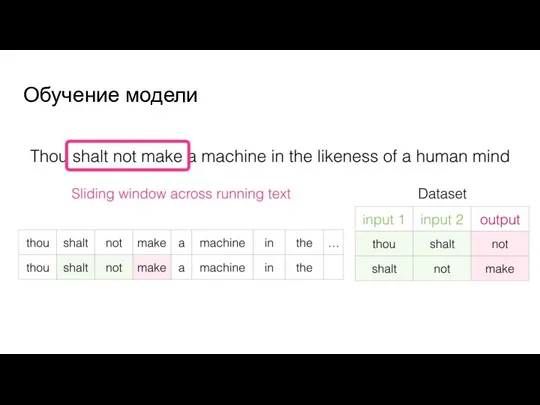

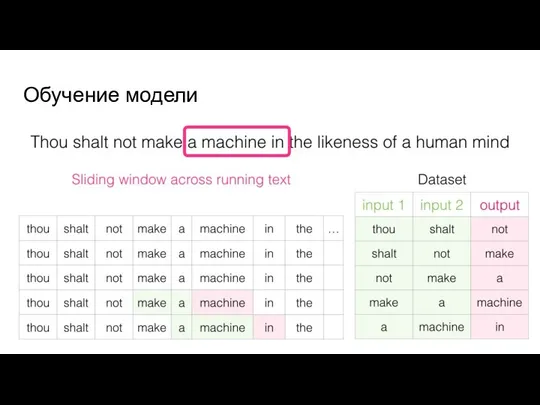

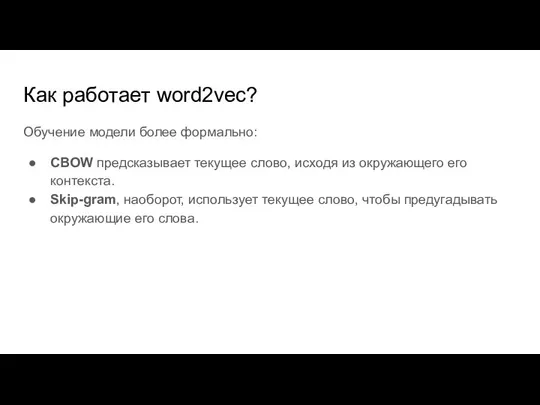

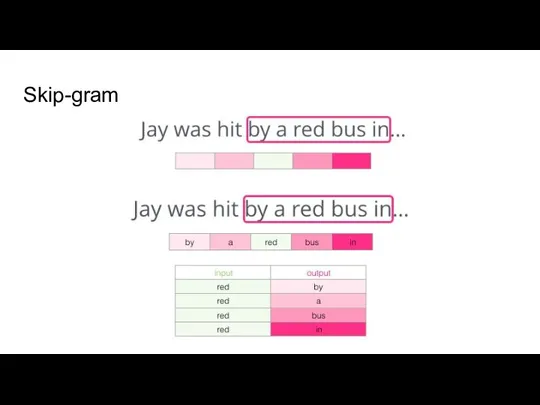

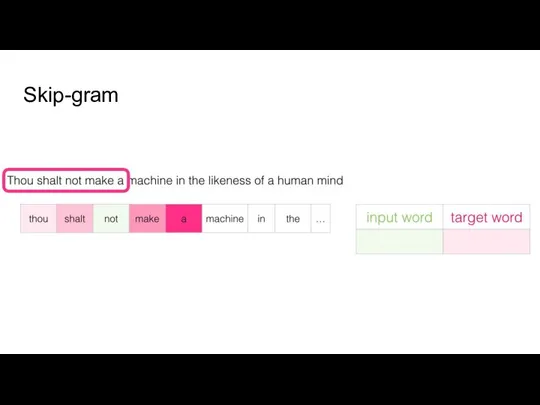

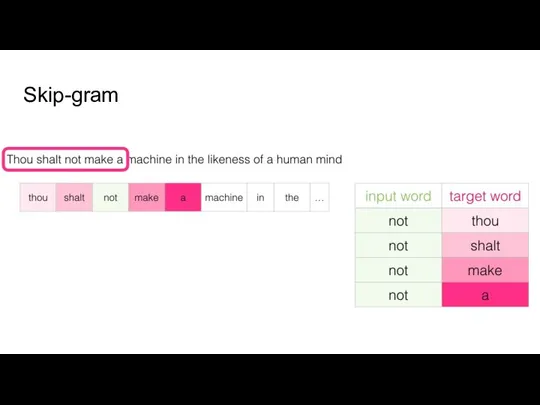

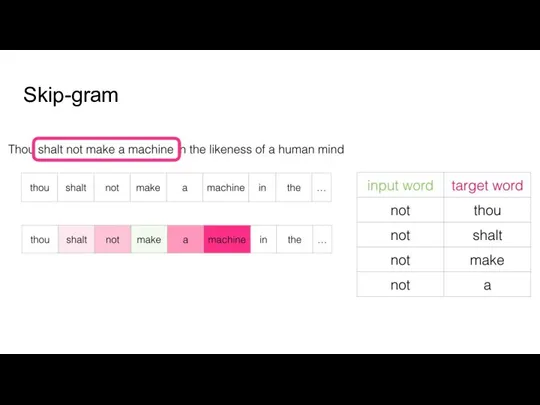

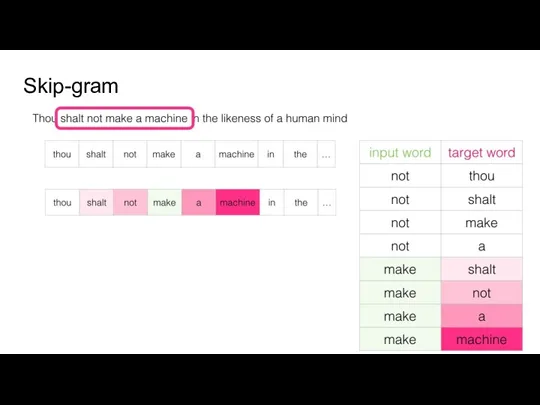

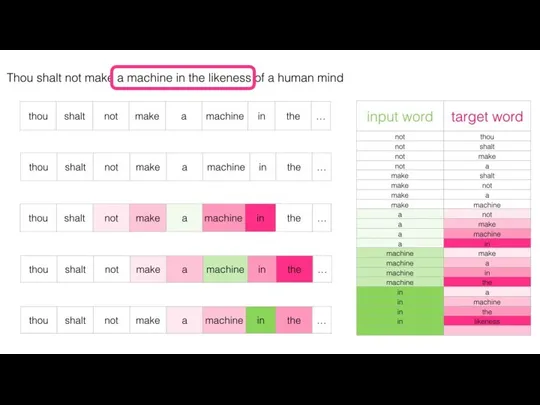

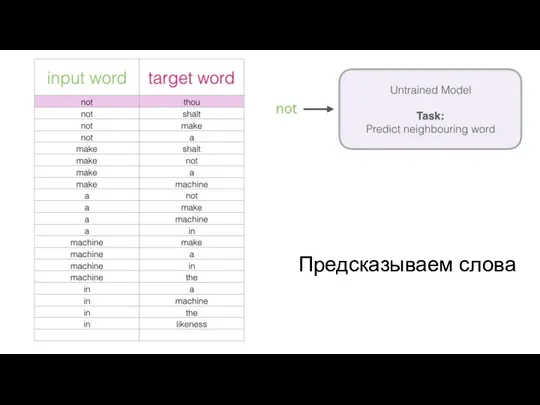

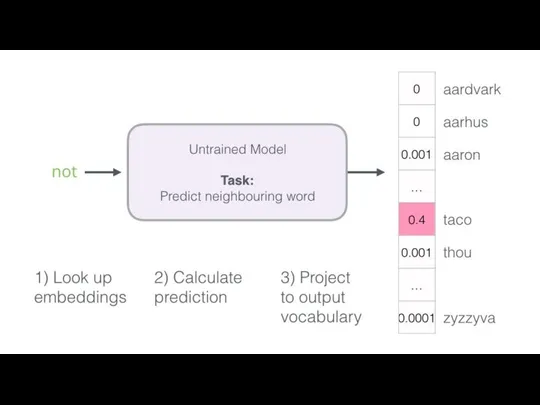

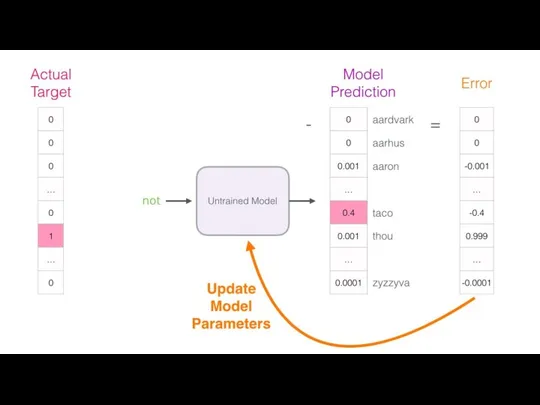

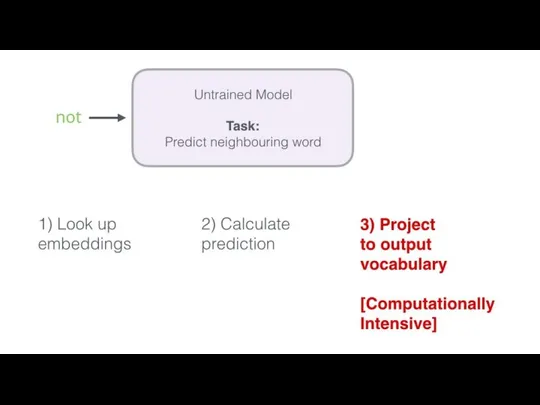

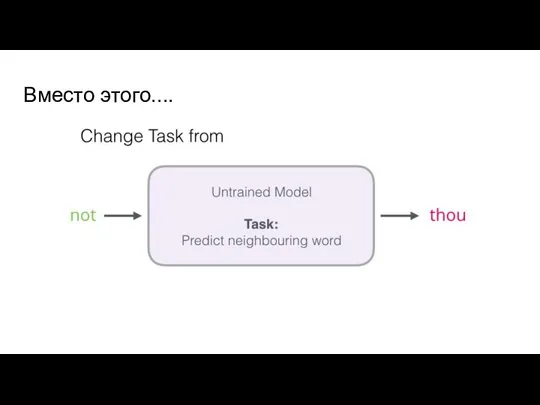

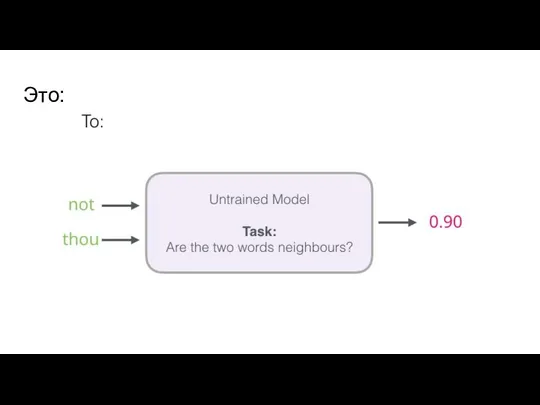

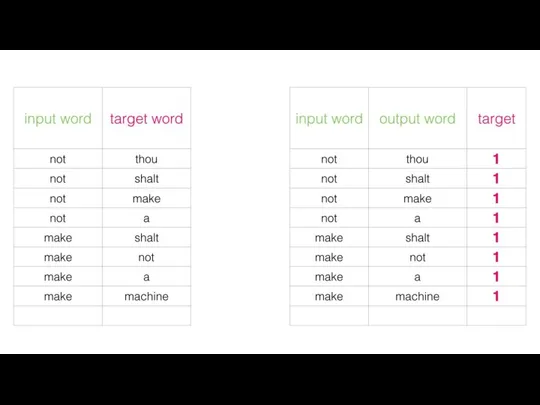

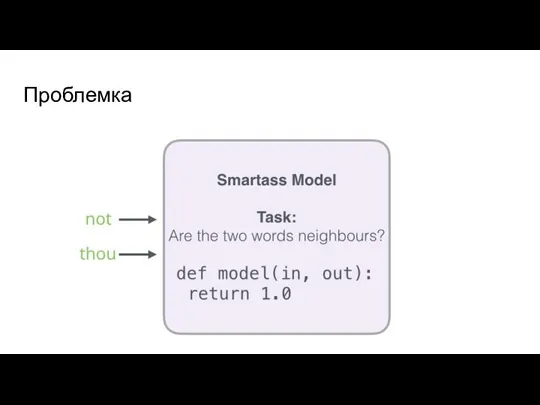

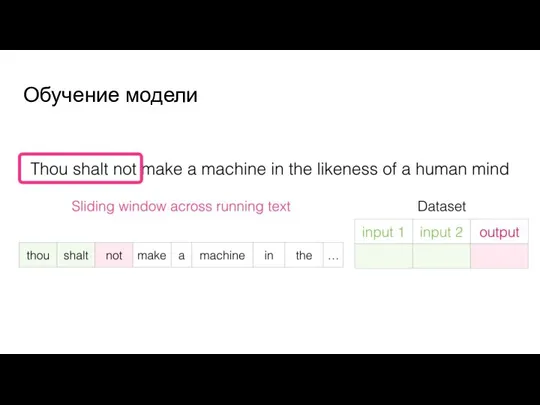

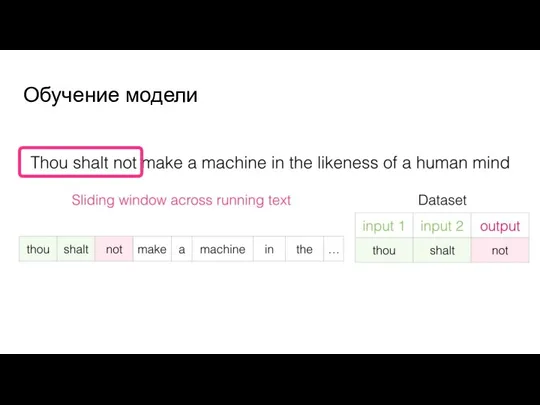

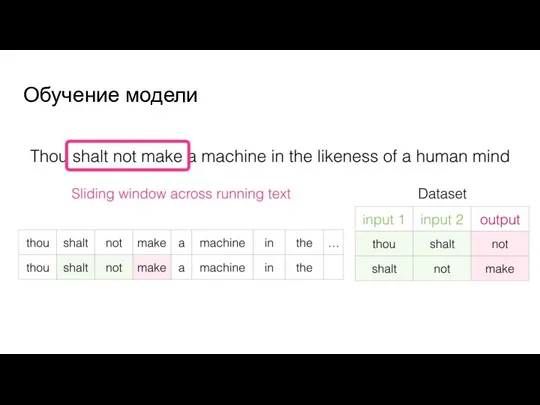

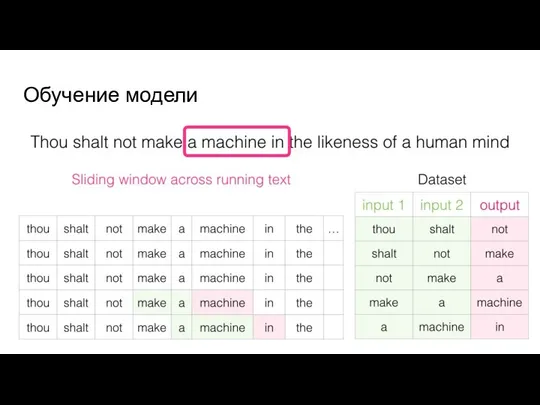

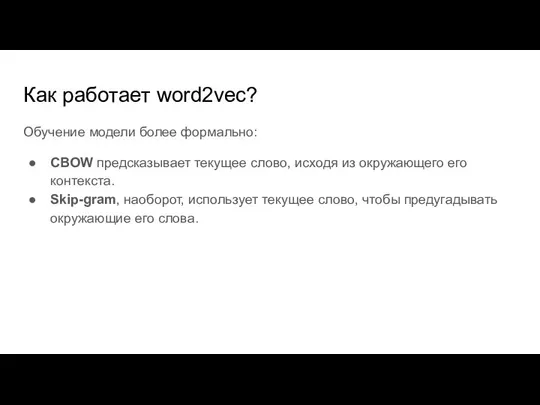

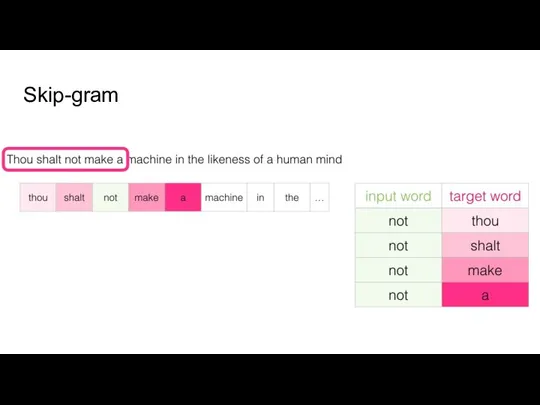

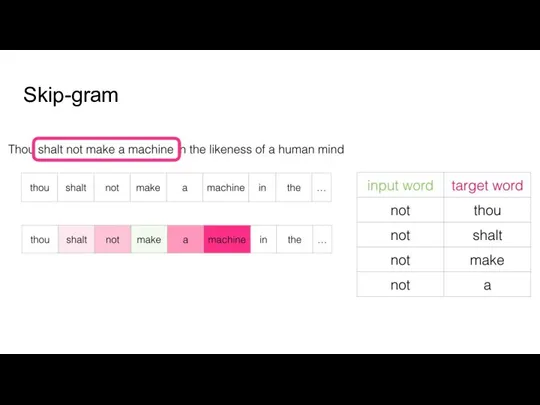

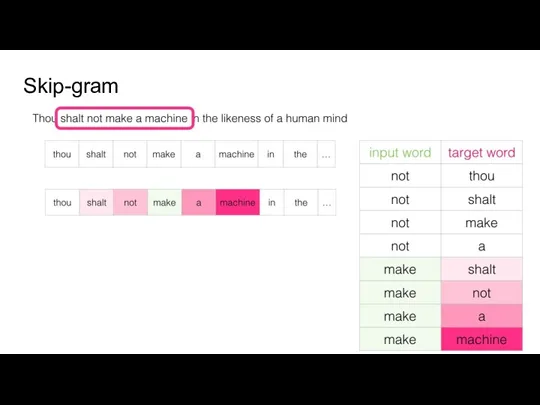

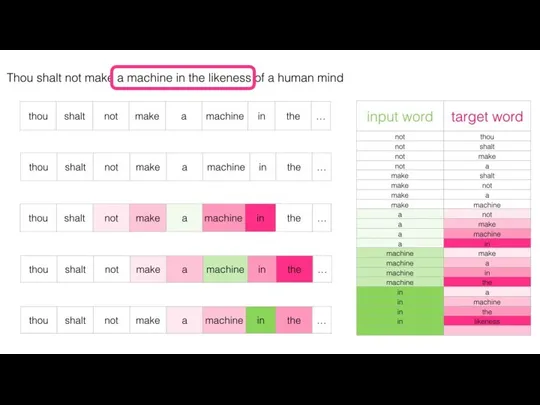

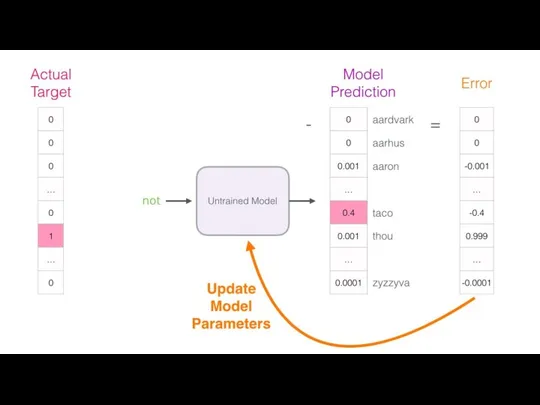

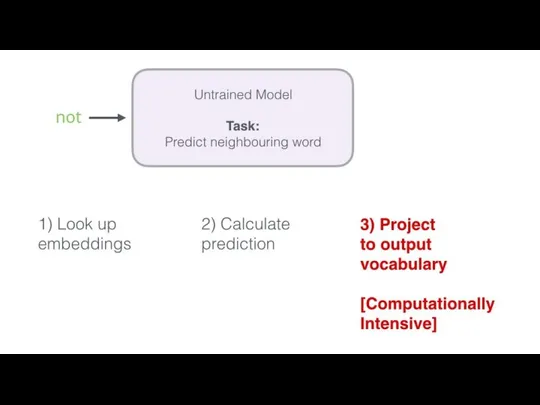

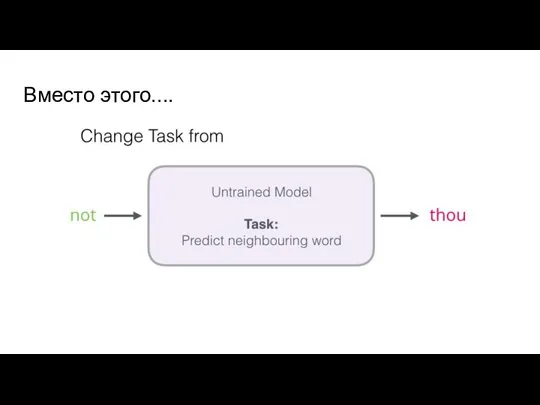

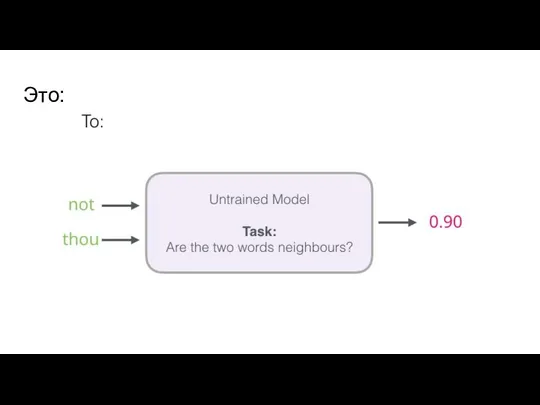

Как работает word2vec?

Обучение модели более формально:

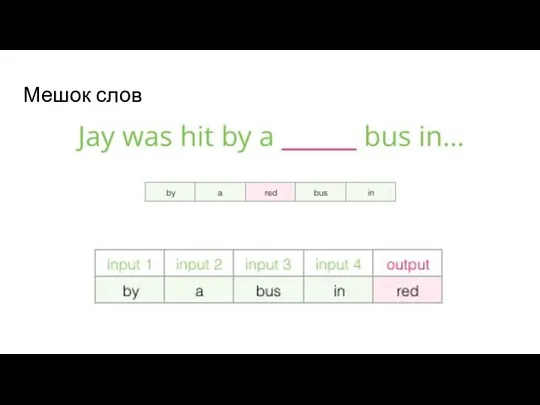

CBOW предсказывает текущее слово, исходя из

окружающего его контекста.

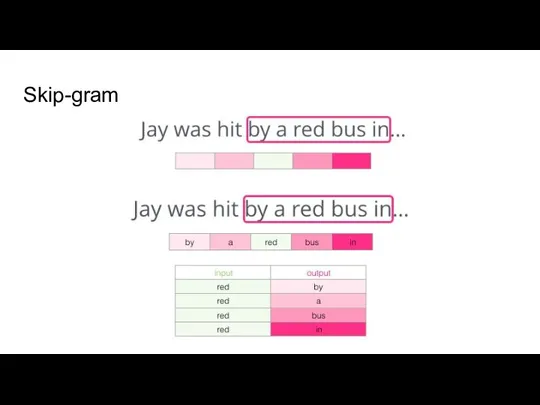

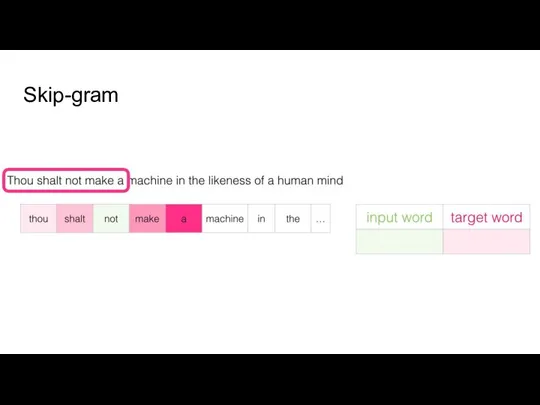

Skip-gram, наоборот, использует текущее слово, чтобы предугадывать окружающие его слова.

Слайд 38

Слайд 39

Слайд 40

Слайд 41

Слайд 42

Слайд 43

Слайд 44

Слайд 45

Слайд 46

Слайд 47

Слайд 48

Слайд 49

Слайд 50

Слайд 51

Слайд 52

Слайд 53

Слайд 54

Слайд 55

Слайд 56

Слайд 57

Ключевые концепты еще раз

Слайд 58

Слайд 59

Слайд 60

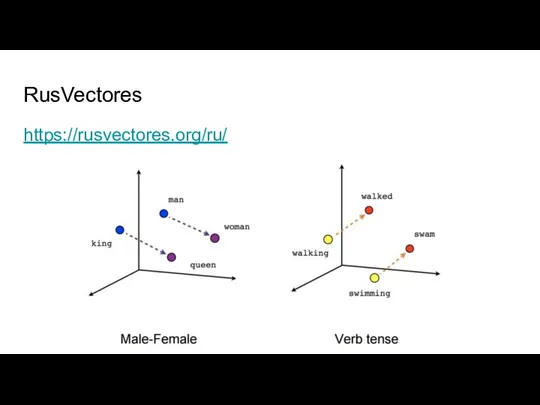

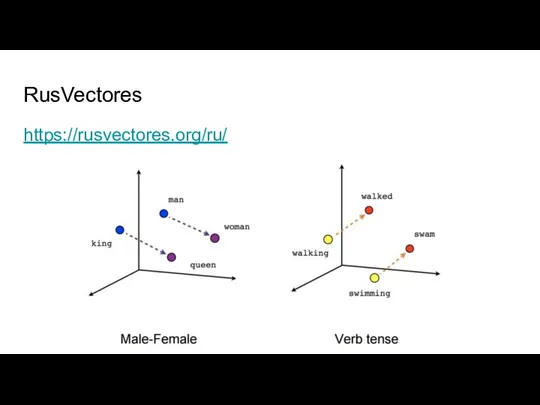

RusVectores

https://rusvectores.org/ru/

Слайд 61

Векторные романы

Ещё давайте посмотрим на векторные романы https://nevmenandr.github.io/novel2vec/

Слайд 62

Пирожки в дистрибутивной семантике

https://habr.com/ru/post/275913/

Слайд 63

Применение

разрешение лексической неоднозначности

информационный поиск

кластеризация документов

машинный перевод

автоматическое формирование словарей (словарей семантических отношений,

двуязычных словарей)

создание семантических карт

моделирование перифраз

определение тематики документа

определение тональности высказывания

Слайд 64

Слайд 65

География и математика

География и математика Свойства и признаки параллельных прямых

Свойства и признаки параллельных прямых Определители второго порядка

Определители второго порядка Временные ряды и их применение для анализа и прогнозирования

Временные ряды и их применение для анализа и прогнозирования Кривые второго порядка

Кривые второго порядка Числа 1-7.Закрепление.

Числа 1-7.Закрепление. Конспект учебного занятия по математике в 3 классе на тему: Закрепление изученного материала. Пути познания

Конспект учебного занятия по математике в 3 классе на тему: Закрепление изученного материала. Пути познания Законы логики. Файлы

Законы логики. Файлы Основы математики

Основы математики Решение систем линейных уравнений

Решение систем линейных уравнений Следствия из аксиом

Следствия из аксиом Четырехугольники. Введение

Четырехугольники. Введение Прямоугольная система координат в пространстве

Прямоугольная система координат в пространстве Числовые выражения

Числовые выражения Методическая разработка урока математики в 1 классе. Тема.Число и цифра-3

Методическая разработка урока математики в 1 классе. Тема.Число и цифра-3 Задачи с величинами: цена, количество, стоимость

Задачи с величинами: цена, количество, стоимость Сложение и вычитание дробей с одинаковыми знаменателями

Сложение и вычитание дробей с одинаковыми знаменателями Математические схемы моделирования информационных систем. Часть 2. Лекция 5

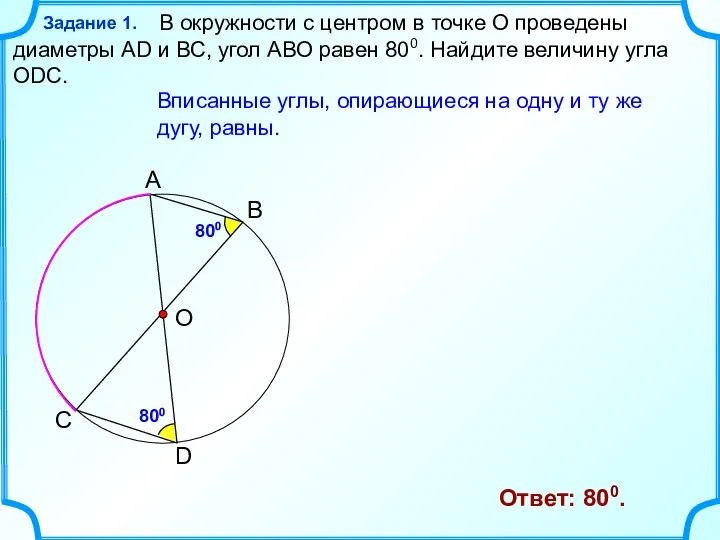

Математические схемы моделирования информационных систем. Часть 2. Лекция 5 Дуги. Хорды. Углы

Дуги. Хорды. Углы Координатная ось

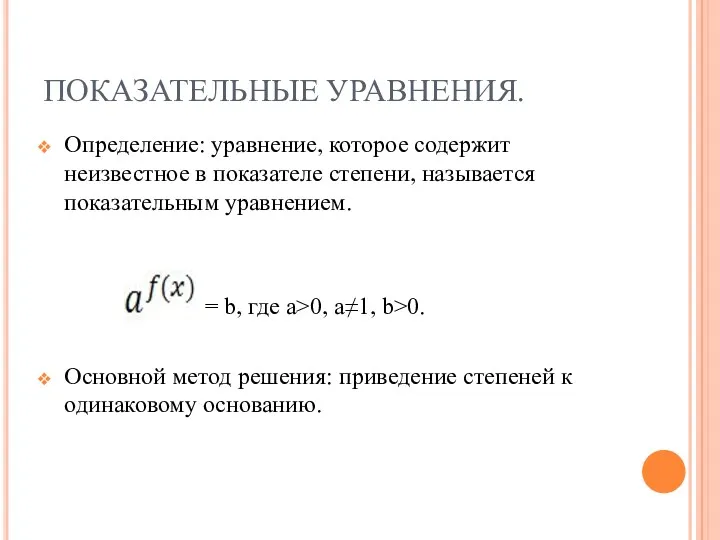

Координатная ось Показательные уравнения

Показательные уравнения Решение задач на комбинации многогранников и тел вращения

Решение задач на комбинации многогранников и тел вращения Интерпретации формул алгебры предикатов

Интерпретации формул алгебры предикатов В лабиринте великих имен и открытий. Математический калейдоскоп. 4 раунд

В лабиринте великих имен и открытий. Математический калейдоскоп. 4 раунд Составление математических задач экологического и краеведческого содержания

Составление математических задач экологического и краеведческого содержания Математическая статистика

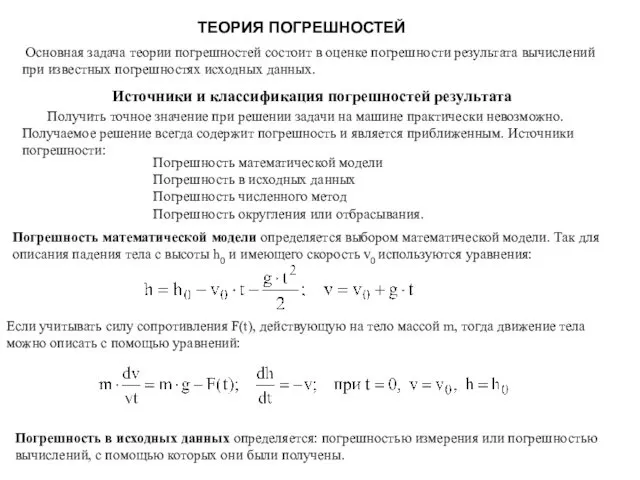

Математическая статистика Теория погрешностей

Теория погрешностей Математический поединок

Математический поединок