- Главная

- Математика

- Теорема Шеннона

Содержание

- 2. Существует множество ситуаций, когда возможные события имеют различные вероятности реализации. Например, если монета несимметрична (одна сторона

- 3. Например, пусть при бросании несимметричной четырехгранной пирамидки вероятности отдельных событий будут равны:Р1 = 1/2, р2 =

- 4. По формуле можно определить, например, количество информации, которое мы получим при бросании симметричной и однородной четырехгранной

- 5. Качественную связь между вероятностью события и количеством информации в сообщении об этом событии можно выразить так:

- 6. В 1948 году, исследуя проблему рациональной передачи информации через зашумлённый коммуникационный канал, Клод Шеннон предложил революционный

- 7. Задача. В озере обитает 12500 окуней, 25000 пескарей, а карасей и щук по 6250. Какое количество

- 9. Скачать презентацию

Слайд 2

Существует множество ситуаций, когда возможные события имеют различные вероятности реализации. Например,

Существует множество ситуаций, когда возможные события имеют различные вероятности реализации. Например,

если монета несимметрична (одна сторона тяжелее другой), то при ее бросании вероятности выпадения "орла" и "решки" будут различаться.

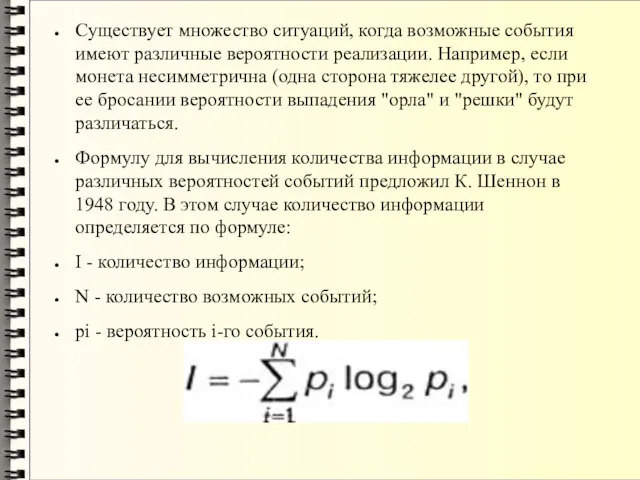

Формулу для вычисления количества информации в случае различных вероятностей событий предложил К. Шеннон в 1948 году. В этом случае количество информации определяется по формуле:

I - количество информации;

N - количество возможных событий;

рi - вероятность i-го события.

Формулу для вычисления количества информации в случае различных вероятностей событий предложил К. Шеннон в 1948 году. В этом случае количество информации определяется по формуле:

I - количество информации;

N - количество возможных событий;

рi - вероятность i-го события.

Слайд 3

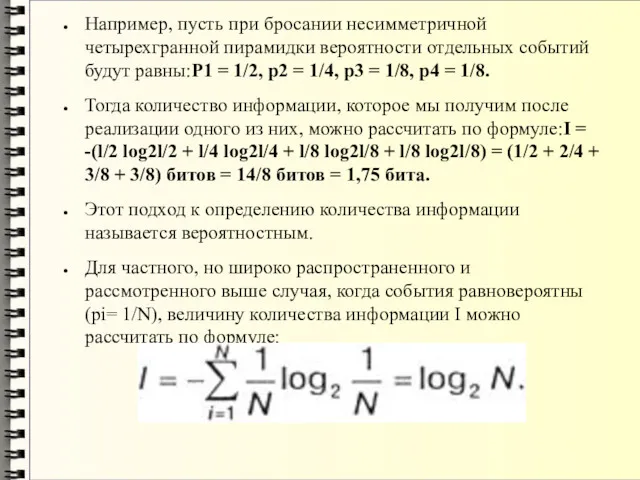

Например, пусть при бросании несимметричной четырехгранной пирамидки вероятности отдельных событий будут

Например, пусть при бросании несимметричной четырехгранной пирамидки вероятности отдельных событий будут

равны:Р1 = 1/2, р2 = 1/4, р3 = 1/8, р4 = 1/8.

Тогда количество информации, которое мы получим после реализации одного из них, можно рассчитать по формуле:I = -(l/2 log2l/2 + l/4 log2l/4 + l/8 log2l/8 + l/8 log2l/8) = (1/2 + 2/4 + 3/8 + 3/8) битов = 14/8 битов = 1,75 бита.

Этот подход к определению количества информации называется вероятностным.

Для частного, но широко распространенного и рассмотренного выше случая, когда события равновероятны (pi= 1/N), величину количества информации I можно рассчитать по формуле:

Тогда количество информации, которое мы получим после реализации одного из них, можно рассчитать по формуле:I = -(l/2 log2l/2 + l/4 log2l/4 + l/8 log2l/8 + l/8 log2l/8) = (1/2 + 2/4 + 3/8 + 3/8) битов = 14/8 битов = 1,75 бита.

Этот подход к определению количества информации называется вероятностным.

Для частного, но широко распространенного и рассмотренного выше случая, когда события равновероятны (pi= 1/N), величину количества информации I можно рассчитать по формуле:

Слайд 4

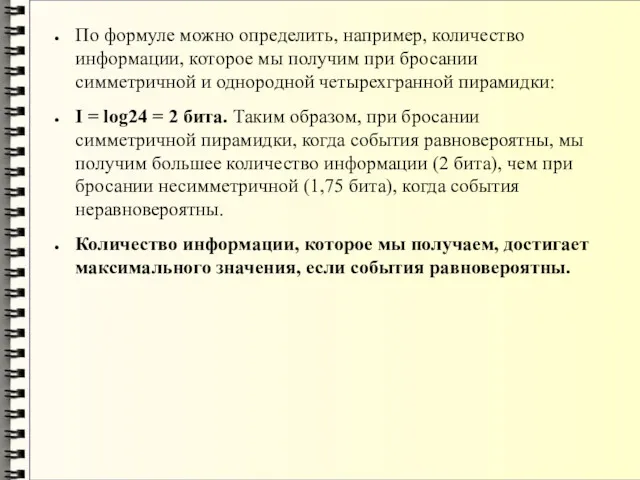

По формуле можно определить, например, количество информации, которое мы получим при

По формуле можно определить, например, количество информации, которое мы получим при

бросании симметричной и однородной четырехгранной пирамидки:

I = log24 = 2 бита. Таким образом, при бросании симметричной пирамидки, когда события равновероятны, мы получим большее количество информации (2 бита), чем при бросании несимметричной (1,75 бита), когда события неравновероятны.

Количество информации, которое мы получаем, достигает максимального значения, если события равновероятны.

I = log24 = 2 бита. Таким образом, при бросании симметричной пирамидки, когда события равновероятны, мы получим большее количество информации (2 бита), чем при бросании несимметричной (1,75 бита), когда события неравновероятны.

Количество информации, которое мы получаем, достигает максимального значения, если события равновероятны.

Слайд 5

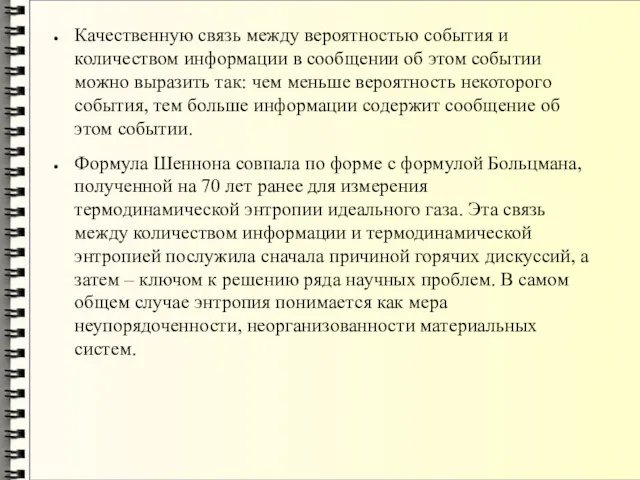

Качественную связь между вероятностью события и количеством информации в сообщении об

Качественную связь между вероятностью события и количеством информации в сообщении об

этом событии можно выразить так: чем меньше вероятность некоторого события, тем больше информации содержит сообщение об этом событии.

Формула Шеннона совпала по форме с формулой Больцмана, полученной на 70 лет ранее для измерения термодинамической энтропии идеального газа. Эта связь между количеством информации и термодинамической энтропией послужила сначала причиной горячих дискуссий, а затем – ключом к решению ряда научных проблем. В самом общем случае энтропия понимается как мера неупорядоченности, неорганизованности материальных систем.

Формула Шеннона совпала по форме с формулой Больцмана, полученной на 70 лет ранее для измерения термодинамической энтропии идеального газа. Эта связь между количеством информации и термодинамической энтропией послужила сначала причиной горячих дискуссий, а затем – ключом к решению ряда научных проблем. В самом общем случае энтропия понимается как мера неупорядоченности, неорганизованности материальных систем.

Слайд 6

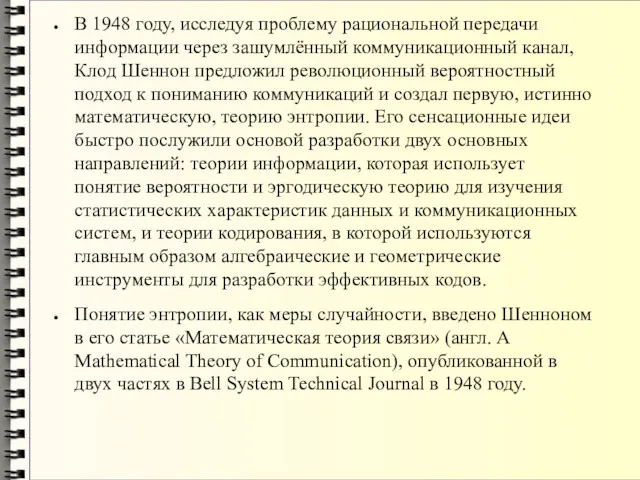

В 1948 году, исследуя проблему рациональной передачи информации через зашумлённый коммуникационный

В 1948 году, исследуя проблему рациональной передачи информации через зашумлённый коммуникационный

канал, Клод Шеннон предложил революционный вероятностный подход к пониманию коммуникаций и создал первую, истинно математическую, теорию энтропии. Его сенсационные идеи быстро послужили основой разработки двух основных направлений: теории информации, которая использует понятие вероятности и эргодическую теорию для изучения статистических характеристик данных и коммуникационных систем, и теории кодирования, в которой используются главным образом алгебраические и геометрические инструменты для разработки эффективных кодов.

Понятие энтропии, как меры случайности, введено Шенноном в его статье «Математическая теория связи» (англ. A Mathematical Theory of Communication), опубликованной в двух частях в Bell System Technical Journal в 1948 году.

Понятие энтропии, как меры случайности, введено Шенноном в его статье «Математическая теория связи» (англ. A Mathematical Theory of Communication), опубликованной в двух частях в Bell System Technical Journal в 1948 году.

Слайд 7

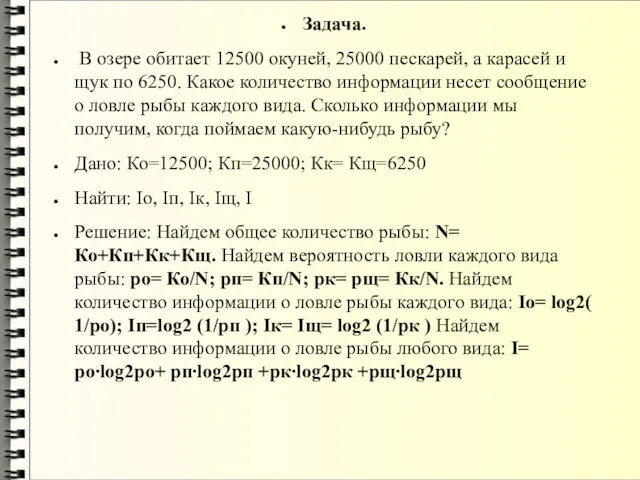

Задача.

В озере обитает 12500 окуней, 25000 пескарей, а карасей и

Задача.

В озере обитает 12500 окуней, 25000 пескарей, а карасей и

щук по 6250. Какое количество информации несет сообщение о ловле рыбы каждого вида. Сколько информации мы получим, когда поймаем какую-нибудь рыбу?

Дано: Ко=12500; Кп=25000; Кк= Кщ=6250

Найти: Iо, Iп, Iк, Iщ, I

Решение: Найдем общее количество рыбы: N= Ко+Кп+Кк+Кщ. Найдем вероятность ловли каждого вида рыбы: pо= Ко/N; pп= Кп/N; pк= pщ= Кк/N. Найдем количество информации о ловле рыбы каждого вида: Iо= log2( 1/pо); Iп=log2 (1/pп ); Iк= Iщ= log2 (1/pк ) Найдем количество информации о ловле рыбы любого вида: I= pо∙log2pо+ pп∙log2pп +pк∙log2pк +pщ∙log2pщ

Дано: Ко=12500; Кп=25000; Кк= Кщ=6250

Найти: Iо, Iп, Iк, Iщ, I

Решение: Найдем общее количество рыбы: N= Ко+Кп+Кк+Кщ. Найдем вероятность ловли каждого вида рыбы: pо= Ко/N; pп= Кп/N; pк= pщ= Кк/N. Найдем количество информации о ловле рыбы каждого вида: Iо= log2( 1/pо); Iп=log2 (1/pп ); Iк= Iщ= log2 (1/pк ) Найдем количество информации о ловле рыбы любого вида: I= pо∙log2pо+ pп∙log2pп +pк∙log2pк +pщ∙log2pщ

- Предыдущая

Тепловые двигатели

Методика изучения объёма фигуры

Методика изучения объёма фигуры Плоска система збіжних сил

Плоска система збіжних сил Приемы быстрого счета без калькулятора

Приемы быстрого счета без калькулятора Знаходимо невідомий множник; невідоме ділене або дільник. 2 клас

Знаходимо невідомий множник; невідоме ділене або дільник. 2 клас Решение заданий С1 на ЕГЭ

Решение заданий С1 на ЕГЭ Первообразная функция и неопределенный интеграл. Методы интегрирования

Первообразная функция и неопределенный интеграл. Методы интегрирования Аналитическая геометрия в пространстве. Плоскость и прямая в пространстве

Аналитическая геометрия в пространстве. Плоскость и прямая в пространстве Решение неравенств с одной переменной

Решение неравенств с одной переменной Машинная арифметика в рациональных чисел

Машинная арифметика в рациональных чисел Повышение учебной мотивации у учащихся при обучении математике

Повышение учебной мотивации у учащихся при обучении математике Образовательная система Школа 2100 Урок матемтики в 1 классе по теме Объём.Литр.

Образовательная система Школа 2100 Урок матемтики в 1 классе по теме Объём.Литр. Умножение и деление

Умножение и деление Слагаемое. Компоненты при умножении

Слагаемое. Компоненты при умножении Теорема Дезарга

Теорема Дезарга Пересечение поверхностей

Пересечение поверхностей ОГЭ по математике. Задание 1-5

ОГЭ по математике. Задание 1-5 Табличные случаи умножения и деления

Табличные случаи умножения и деления Графики уравнений, содержащих модули

Графики уравнений, содержащих модули Углы. Виды углов и их построение

Углы. Виды углов и их построение Задачи на увеличение и уменьшение на несколько единиц

Задачи на увеличение и уменьшение на несколько единиц Презентация занятия по математике Большое путешествие Дюймовочки Диск Диск

Презентация занятия по математике Большое путешествие Дюймовочки Диск Диск Тригонометрические выражения и их преобразования

Тригонометрические выражения и их преобразования Программа элективного курса Нескучные вычисления

Программа элективного курса Нескучные вычисления Формулы алгебры высказываний

Формулы алгебры высказываний Алгебра и начала анализа. Повторение

Алгебра и начала анализа. Повторение Элементы комбинаторики. Размещения

Элементы комбинаторики. Размещения Правильные многоугольники

Правильные многоугольники Основные понятия и основные законы теории вероятностей (Лекция 3)

Основные понятия и основные законы теории вероятностей (Лекция 3)