Слайд 2

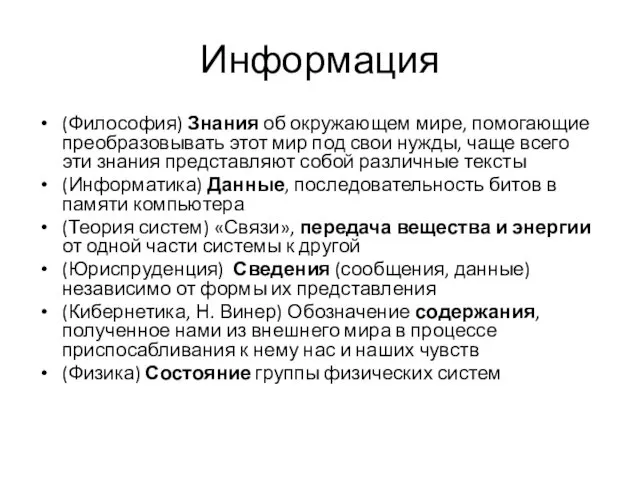

Информация

(Философия) Знания об окружающем мире, помогающие преобразовывать этот мир под свои

нужды, чаще всего эти знания представляют собой различные тексты

(Информатика) Данные, последовательность битов в памяти компьютера

(Теория систем) «Связи», передача вещества и энергии от одной части системы к другой

(Юриспруденция) Сведения (сообщения, данные) независимо от формы их представления

(Кибернетика, Н. Винер) Обозначение содержания, полученное нами из внешнего мира в процессе приспосабливания к нему нас и наших чувств

(Физика) Состояние группы физических систем

Слайд 3

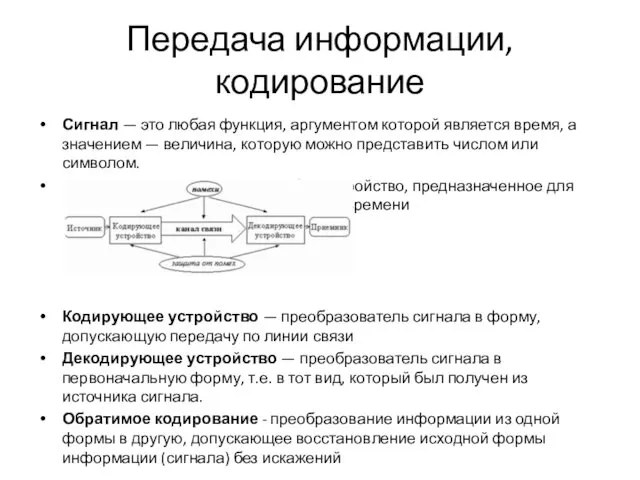

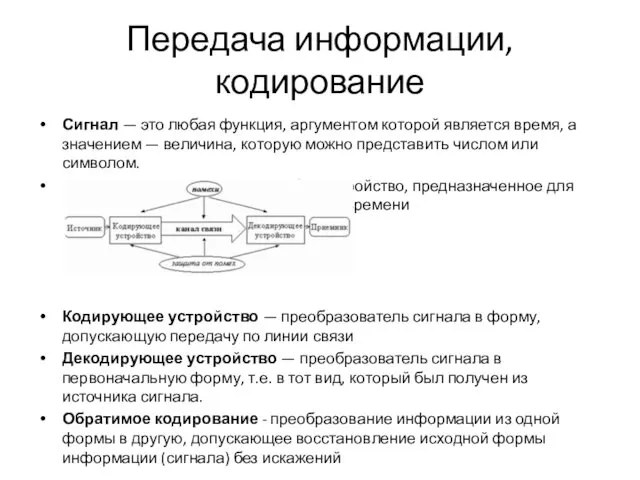

Передача информации, кодирование

Сигнал — это любая функция, аргументом которой является время,

а значением — величина, которую можно представить числом или символом.

Информационный канал - любое устройство, предназначенное для передачи сигнала в пространстве или времени

Кодирующее устройство — преобразователь сигнала в форму, допускающую передачу по линии связи

Декодирующее устройство — преобразователь сигнала в первоначальную форму, т.е. в тот вид, который был получен из источника сигнала.

Обратимое кодирование - преобразование информации из одной формы в другую, допускающее восстановление исходной формы информации (сигнала) без искажений

Слайд 4

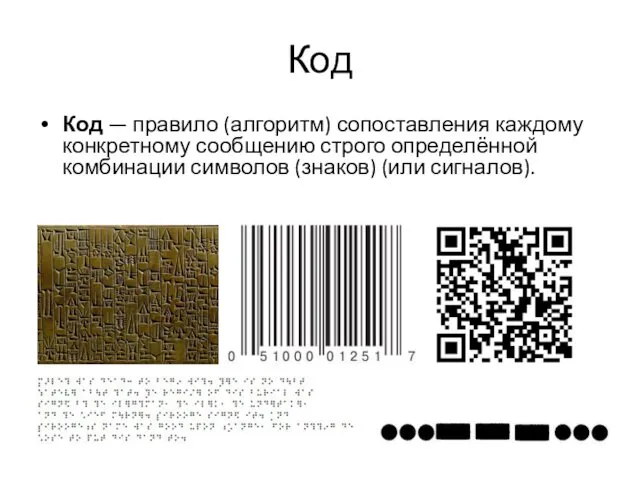

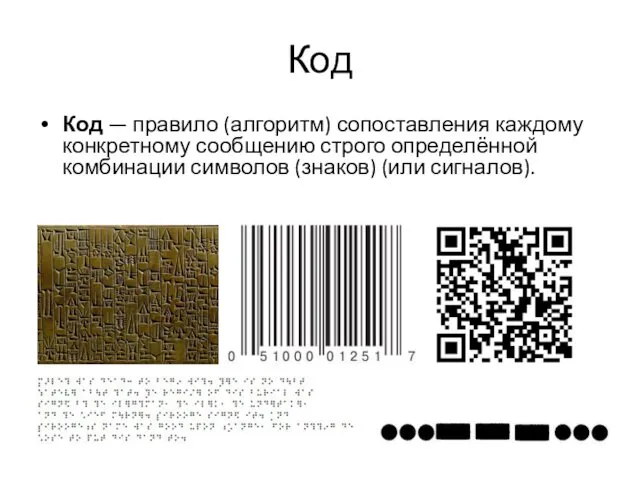

Код

Код — правило (алгоритм) сопоставления каждому конкретному сообщению строго определённой комбинации

символов (знаков) (или сигналов).

Слайд 5

Слайд 6

Слайд 7

Слайд 8

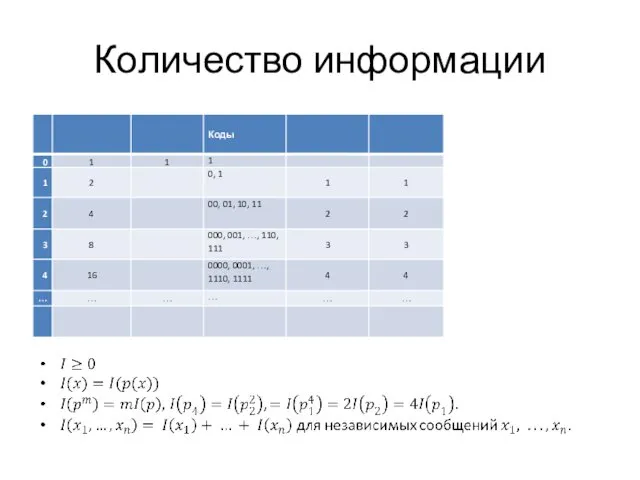

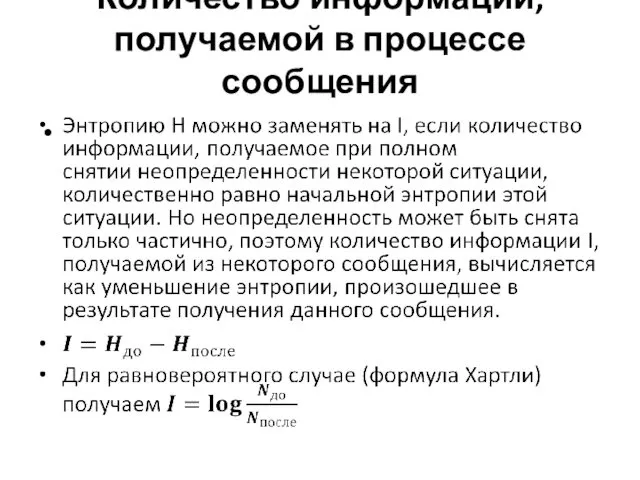

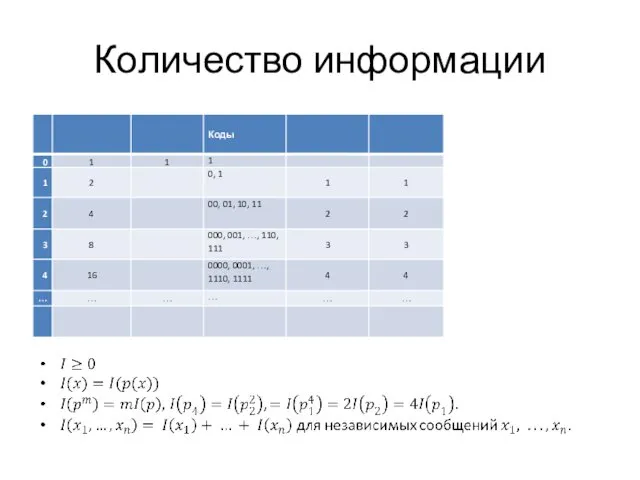

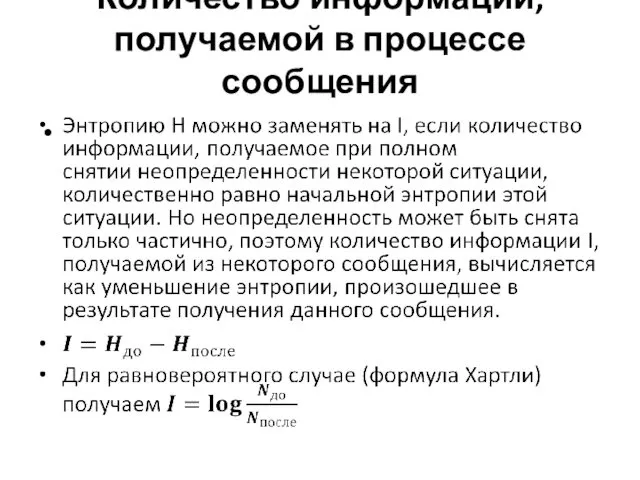

Количество информации, получаемой в процессе сообщения

Слайд 9

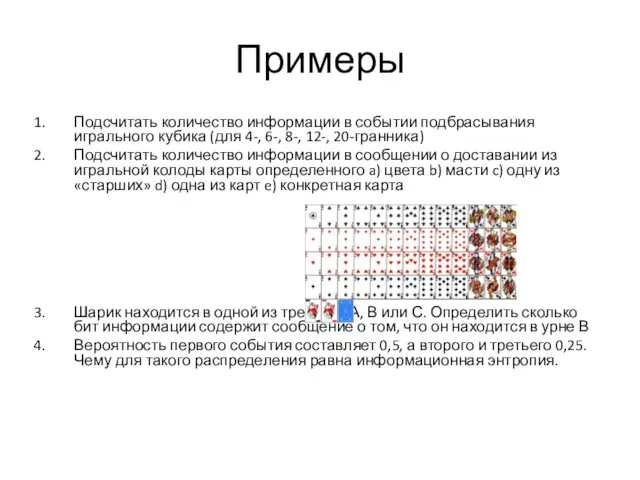

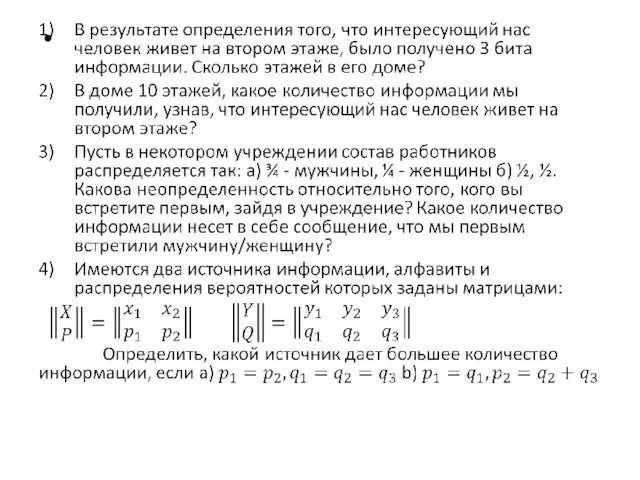

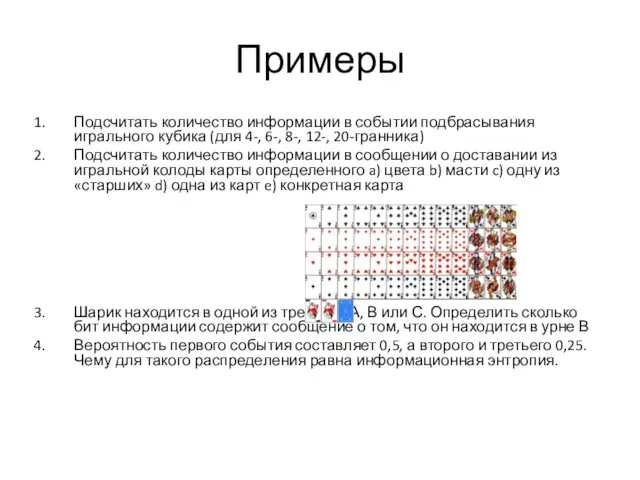

Примеры

Подсчитать количество информации в событии подбрасывания игрального кубика (для 4-, 6-,

8-, 12-, 20-гранника)

Подсчитать количество информации в сообщении о доставании из игральной колоды карты определенного a) цвета b) масти c) одну из «старших» d) одна из карт e) конкретная карта

Шарик находится в одной из трех урн: А, В или С. Определить сколько бит информации содержит сообщение о том, что он находится в урне В

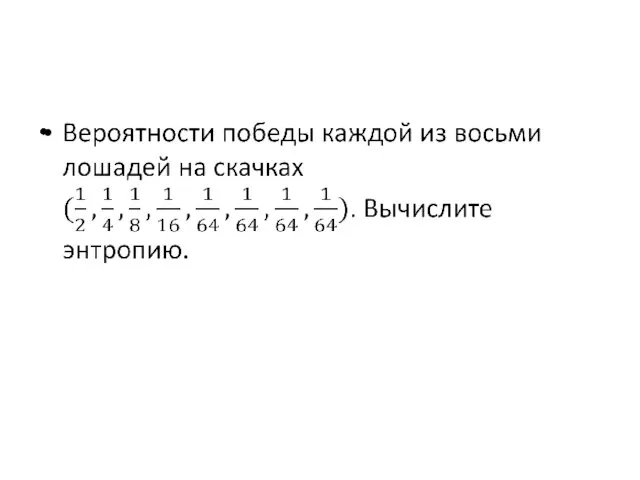

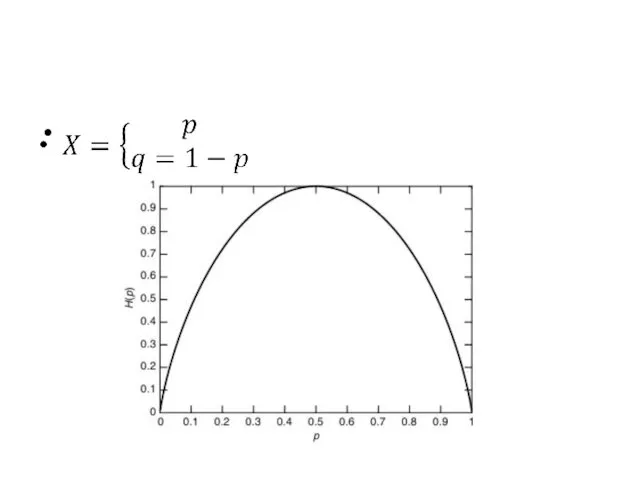

Вероятность первого события составляет 0,5, а второго и третьего 0,25. Чему для такого распределения равна информационная энтропия.

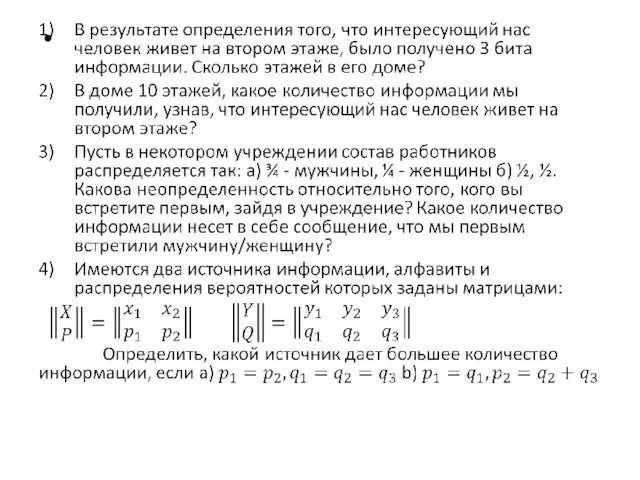

Слайд 10

Слайд 11

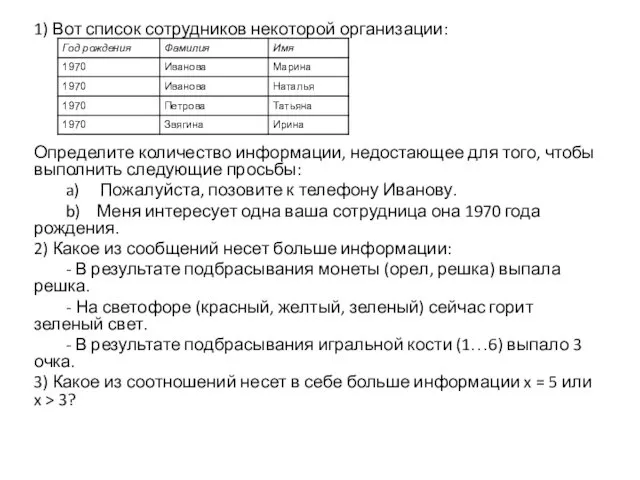

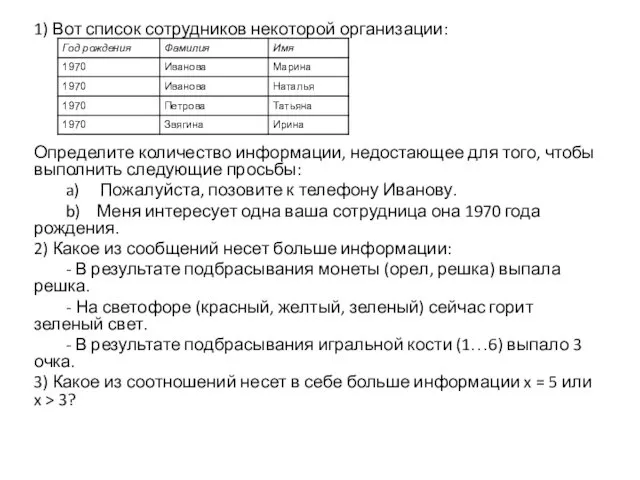

1) Вот список сотрудников некоторой организации:

Определите количество информации, недостающее для того,

чтобы выполнить следующие просьбы:

a) Пожалуйста, позовите к телефону Иванову.

b) Меня интересует одна ваша сотрудница она 1970 года рождения.

2) Какое из сообщений несет больше информации:

- В результате подбрасывания монеты (орел, решка) выпала решка.

- На светофоре (красный, желтый, зеленый) сейчас горит зеленый свет.

- В результате подбрасывания игральной кости (1…6) выпало 3 очка.

3) Какое из соотношений несет в себе больше информации x = 5 или x > 3?

Слайд 12

Слайд 13

Слайд 14

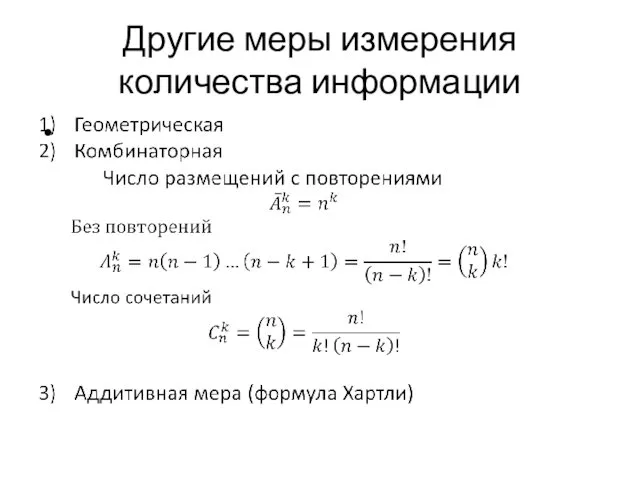

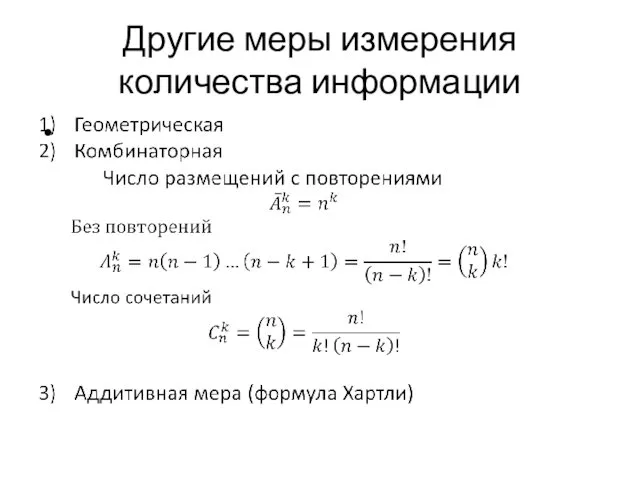

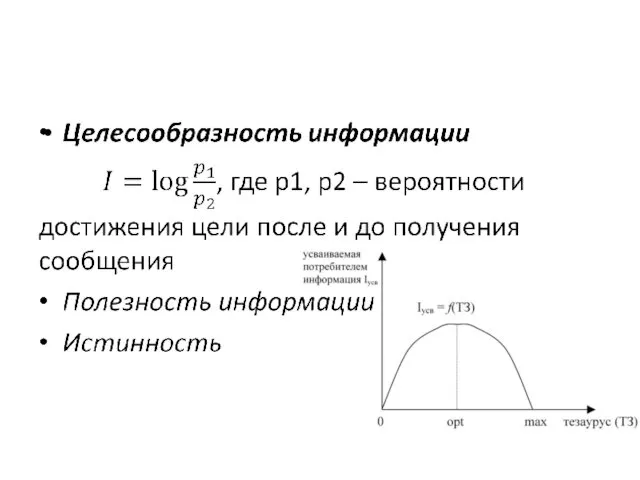

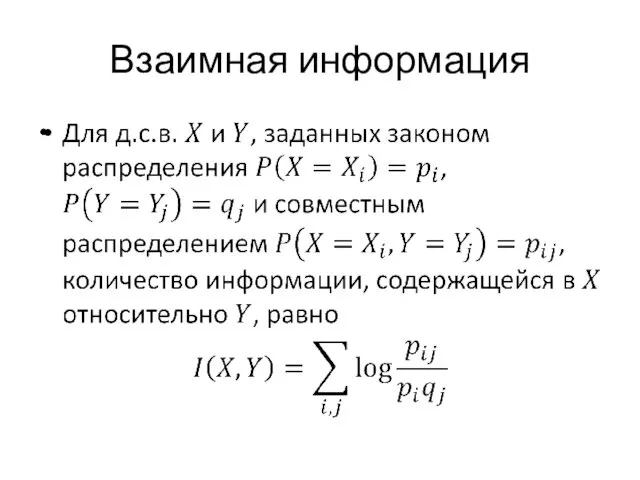

Другие меры измерения

количества информации

Слайд 15

Слайд 16

Сочетаемость слов в языке

Сочетаемость слов в языке Путешествие в страну информатики

Путешествие в страну информатики Возвещаем о спасении через веру во Христа и готовим Его учеников на личных встречах

Возвещаем о спасении через веру во Христа и готовим Его учеников на личных встречах Визитная карточка

Визитная карточка Аренда помещений в торгово -развлекательном центре в Белой церкви

Аренда помещений в торгово -развлекательном центре в Белой церкви Игра Кто умнее семиклассника? (для 7 и 11 классов)

Игра Кто умнее семиклассника? (для 7 и 11 классов) ВП_диагностический центр

ВП_диагностический центр Портфолио учителя

Портфолио учителя Основы конституционного строя Российской Федерации

Основы конституционного строя Российской Федерации Глухие фундаментные болты

Глухие фундаментные болты Вселенная

Вселенная Знакомство с буквой Ъ и буквой Ь

Знакомство с буквой Ъ и буквой Ь Вяжущие вещества

Вяжущие вещества Как писать сжатое изложение

Как писать сжатое изложение Разработка технологической части проекта мебельных предприятий

Разработка технологической части проекта мебельных предприятий Презентация к уроку химии в 8 классе Изменение числа электронов на внешнем энергетическом уровне

Презентация к уроку химии в 8 классе Изменение числа электронов на внешнем энергетическом уровне Социальное партнерство как механизм реализации ООС

Социальное партнерство как механизм реализации ООС Профилактика речевых нарушений у детей в детском саду

Профилактика речевых нарушений у детей в детском саду Управление развитием образовательной организации

Управление развитием образовательной организации Российская нефтяная компания ПАО Татнефть

Российская нефтяная компания ПАО Татнефть Возможности Power Point

Возможности Power Point Геометрия 14.04.2020

Геометрия 14.04.2020 Конструктивная характеристика одежды, обуви и кожгалантерейных изделий

Конструктивная характеристика одежды, обуви и кожгалантерейных изделий Особенности подросткового возраста

Особенности подросткового возраста Отложенный перенос эмбрионов – новые перспективы

Отложенный перенос эмбрионов – новые перспективы Истоки холодной войны и создание военно-политических блоков

Истоки холодной войны и создание военно-политических блоков Различение звуков Ы-И.

Различение звуков Ы-И. XXI век - эпоха женщины

XXI век - эпоха женщины