Содержание

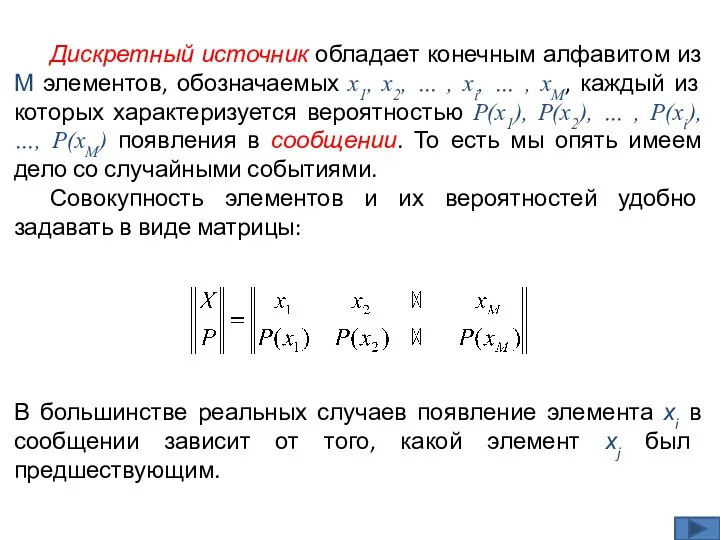

- 2. В большинстве реальных случаев появление элемента хi в сообщении зависит от того, какой элемент хj был

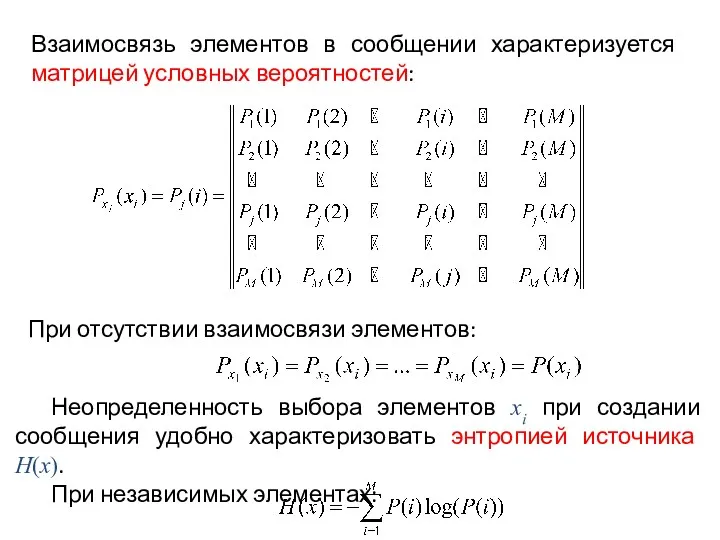

- 3. Неопределенность выбора элементов хi при создании сообщения удобно характеризовать энтропией источника H(x). При независимых элементах: При

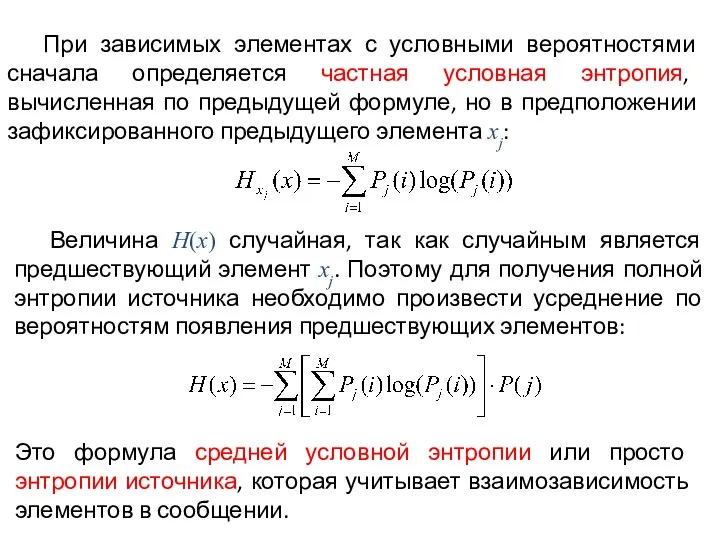

- 4. При зависимых элементах с условными вероятностями сначала определяется частная условная энтропия, вычисленная по предыдущей формуле, но

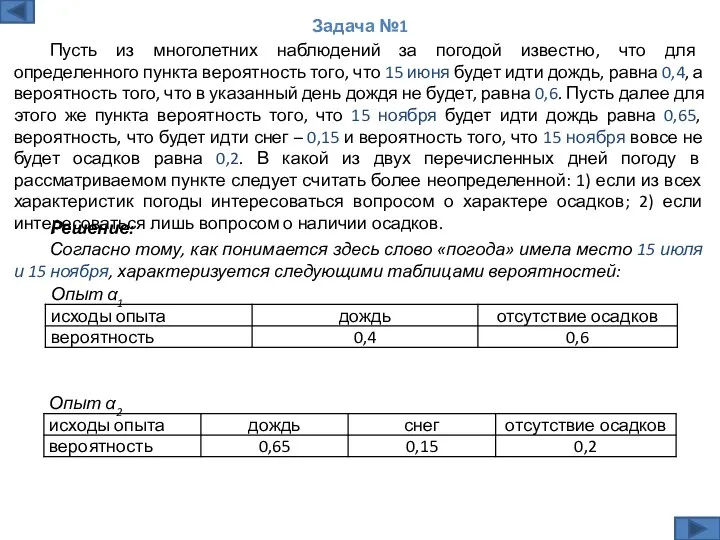

- 5. Решение: Согласно тому, как понимается здесь слово «погода» имела место 15 июля и 15 ноября, характеризуется

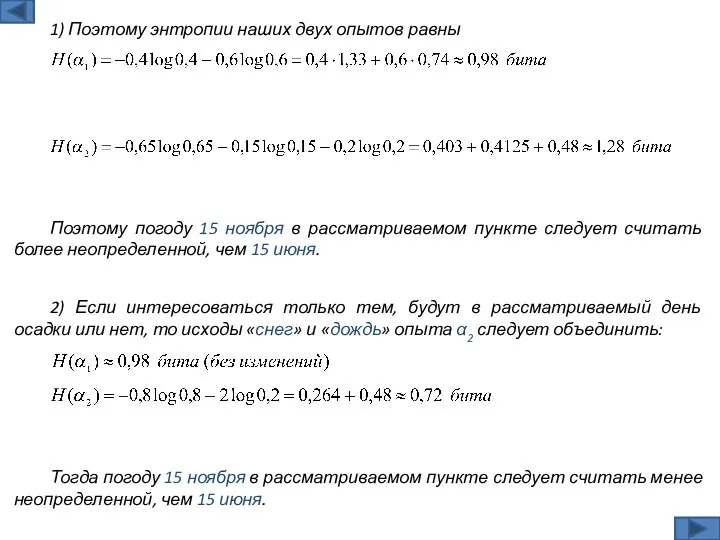

- 6. Поэтому погоду 15 ноября в рассматриваемом пункте следует считать более неопределенной, чем 15 июня. 1) Поэтому

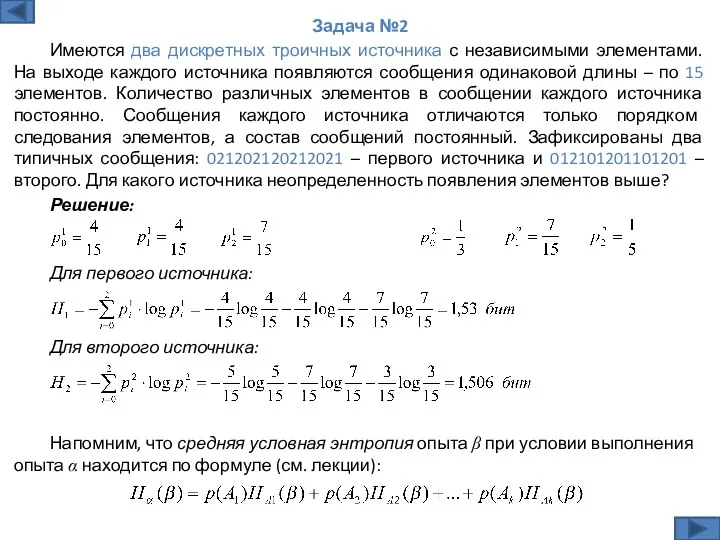

- 7. Решение: Задача №2 Имеются два дискретных троичных источника с независимыми элементами. На выходе каждого источника появляются

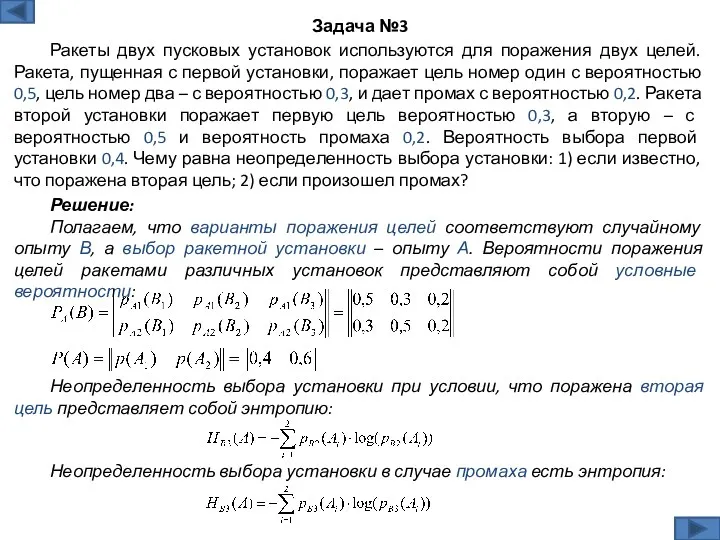

- 8. Решение: Полагаем, что варианты поражения целей соответствуют случайному опыту В, а выбор ракетной установки – опыту

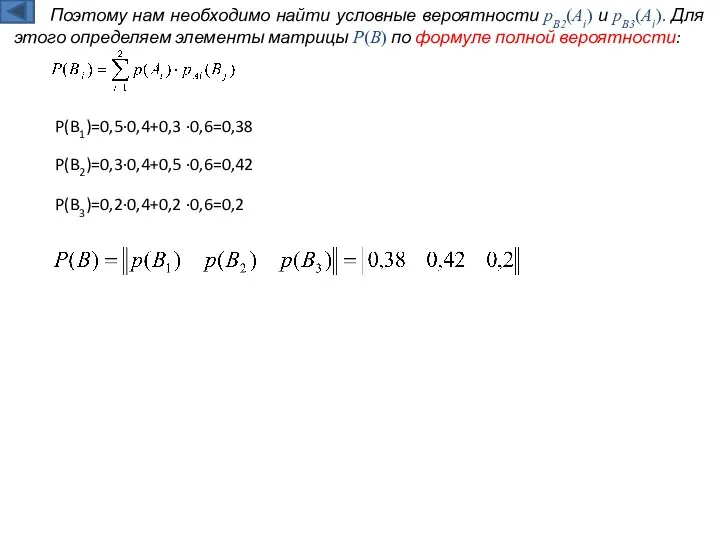

- 9. Поэтому нам необходимо найти условные вероятности pB2(Ai) и pB3(Ai). Для этого определяем элементы матрицы P(B) по

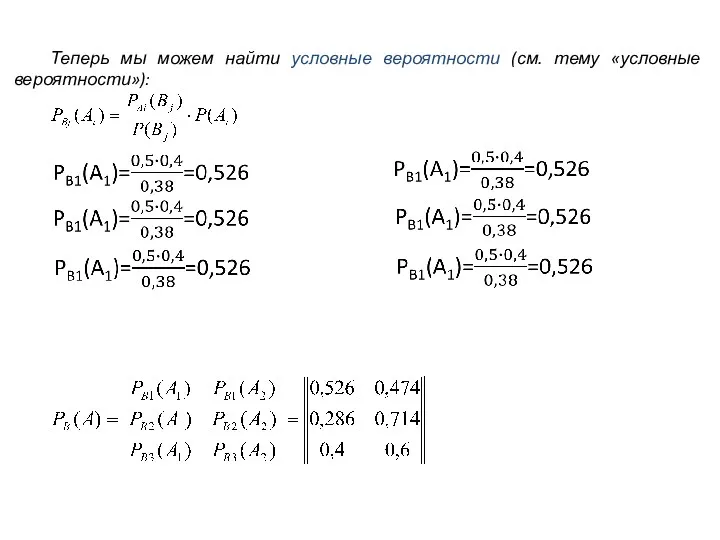

- 10. Теперь мы можем найти условные вероятности (см. тему «условные вероятности»):

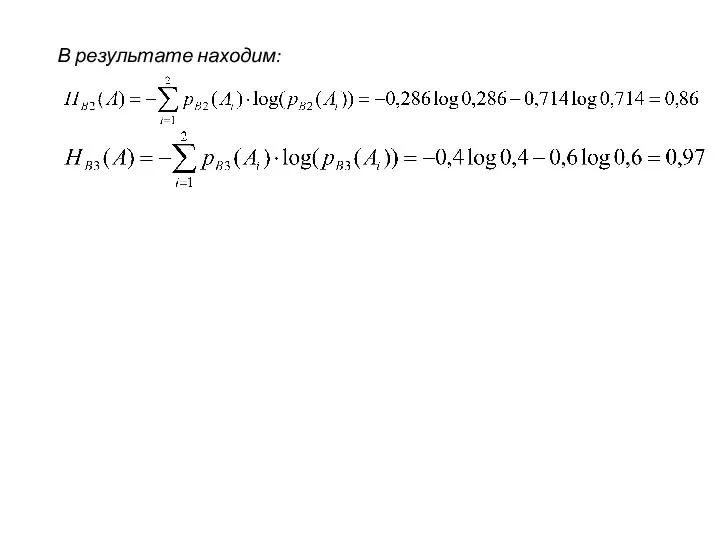

- 11. В результате находим:

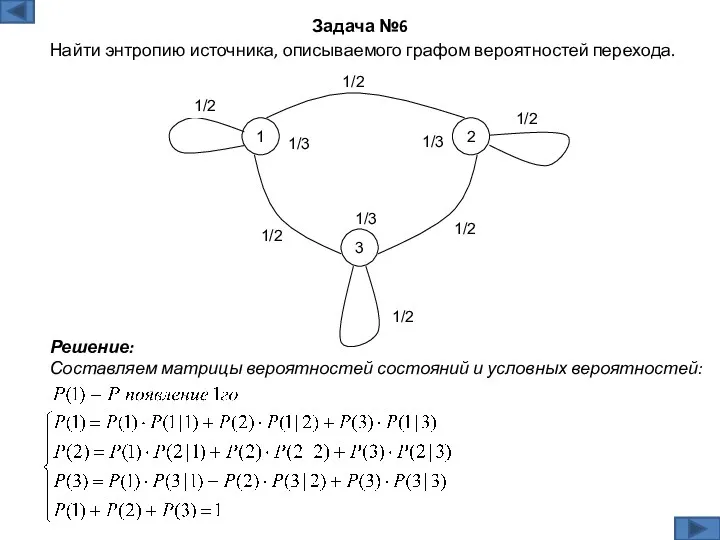

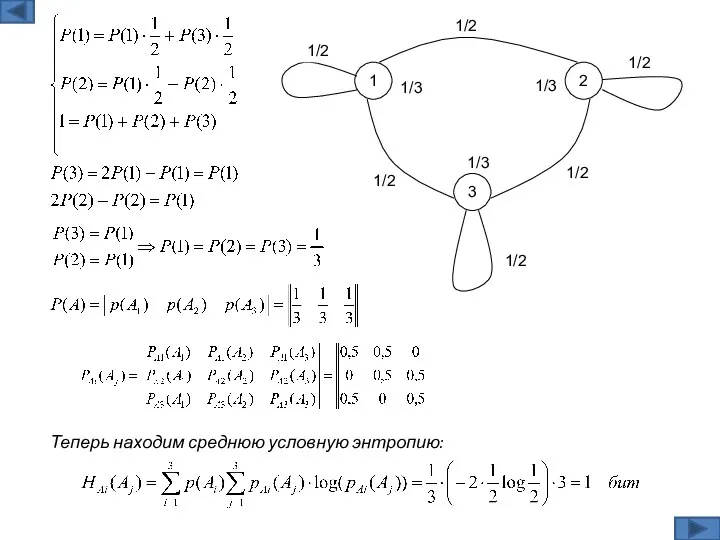

- 13. Решение: Составляем матрицы вероятностей состояний и условных вероятностей: Задача №6 Найти энтропию источника, описываемого графом вероятностей

- 14. Теперь находим среднюю условную энтропию:

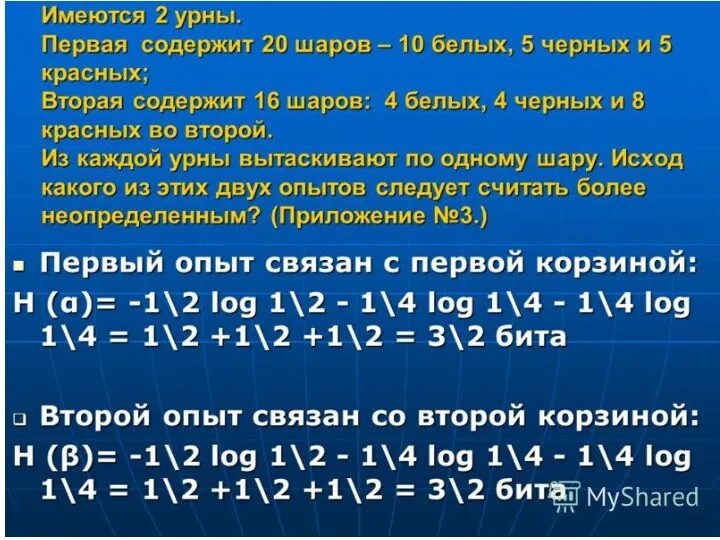

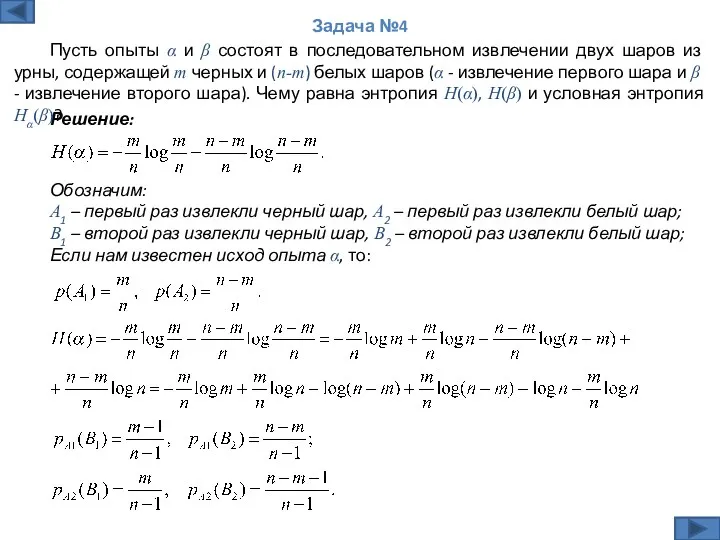

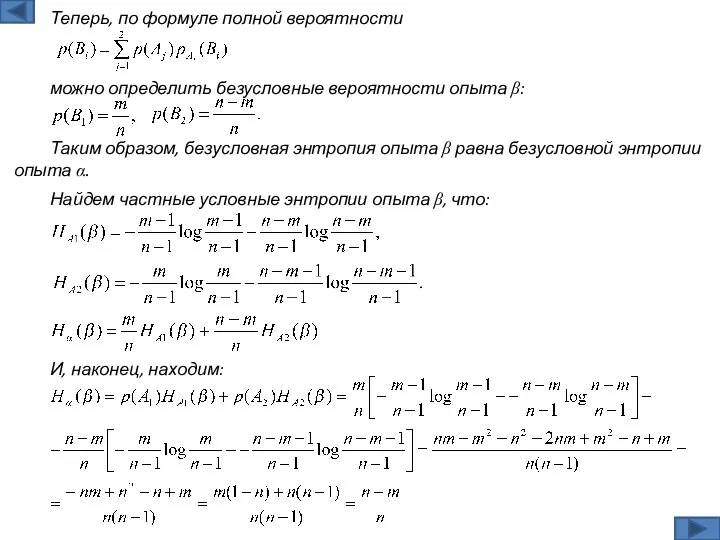

- 15. Решение: Задача №4 Пусть опыты α и β состоят в последовательном извлечении двух шаров из урны,

- 16. Таким образом, безусловная энтропия опыта β равна безусловной энтропии опыта α. можно определить безусловные вероятности опыта

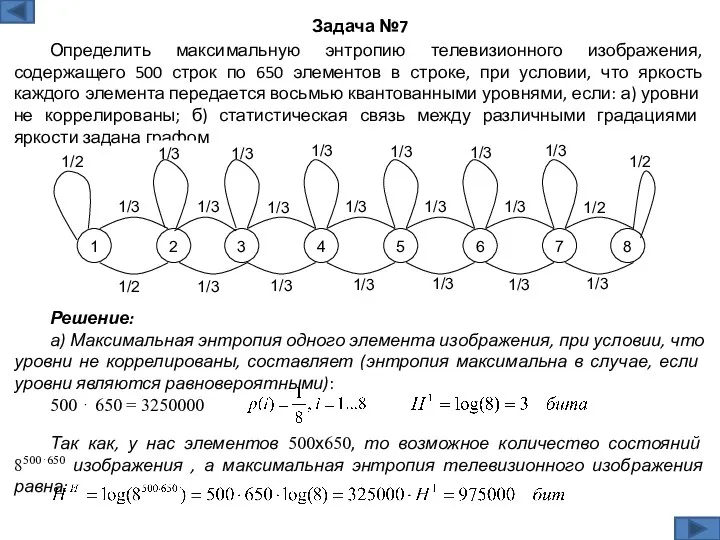

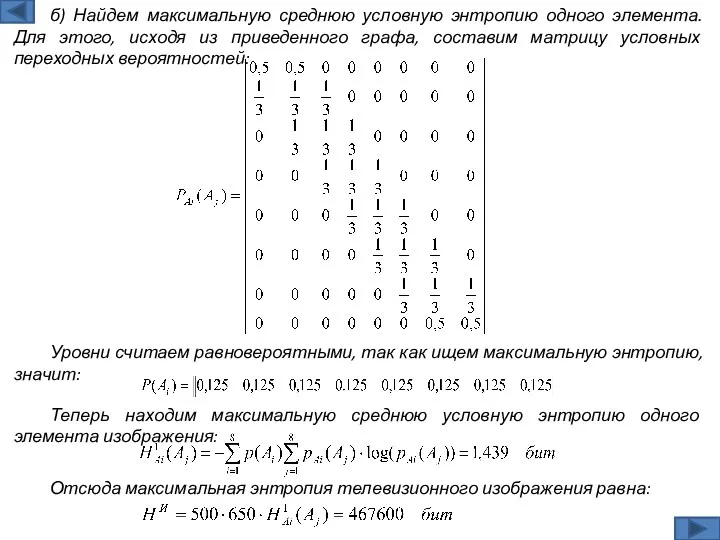

- 17. Решение: а) Максимальная энтропия одного элемента изображения, при условии, что уровни не коррелированы, составляет (энтропия максимальна

- 18. Уровни считаем равновероятными, так как ищем максимальную энтропию, значит: б) Найдем максимальную среднюю условную энтропию одного

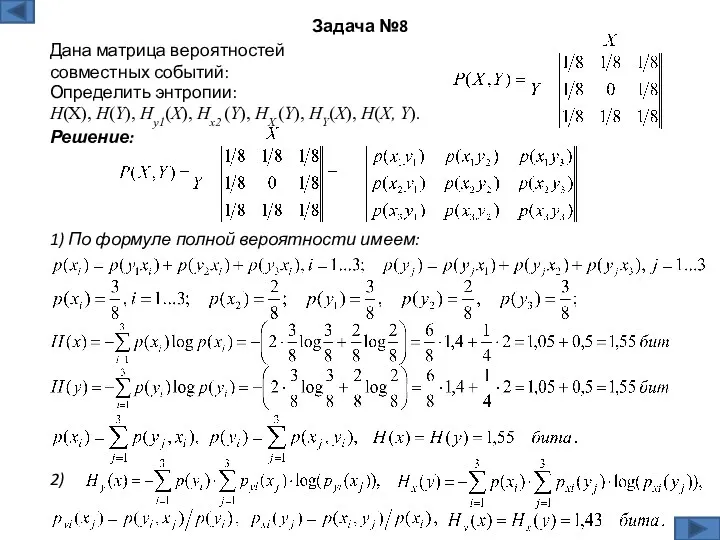

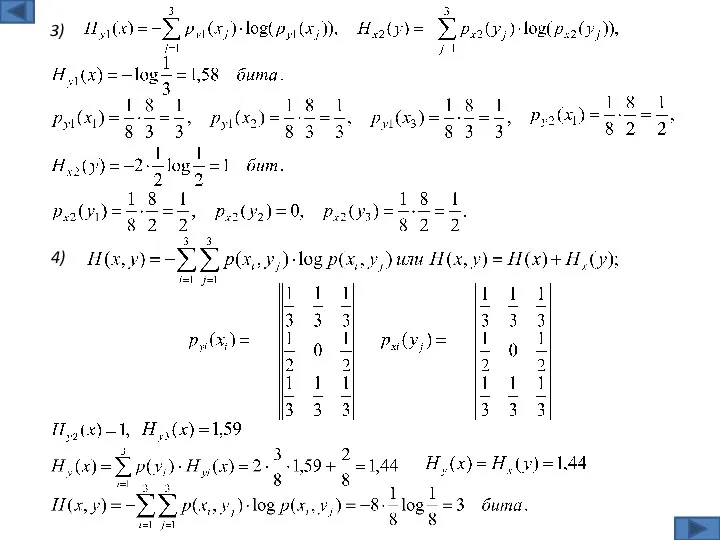

- 19. Решение: Задача №8 Дана матрица вероятностей совместных событий: 1) По формуле полной вероятности имеем: Определить энтропии:

- 20. 3) 4)

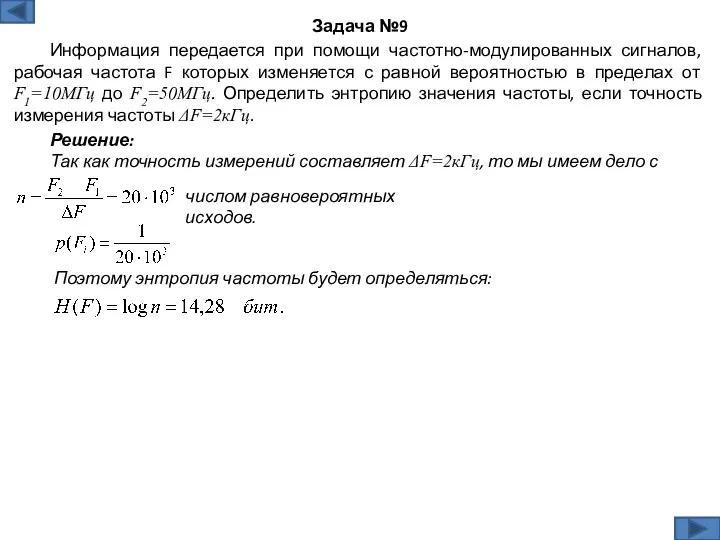

- 21. Решение: Так как точность измерений составляет ΔF=2кГц, то мы имеем дело с Задача №9 Информация передается

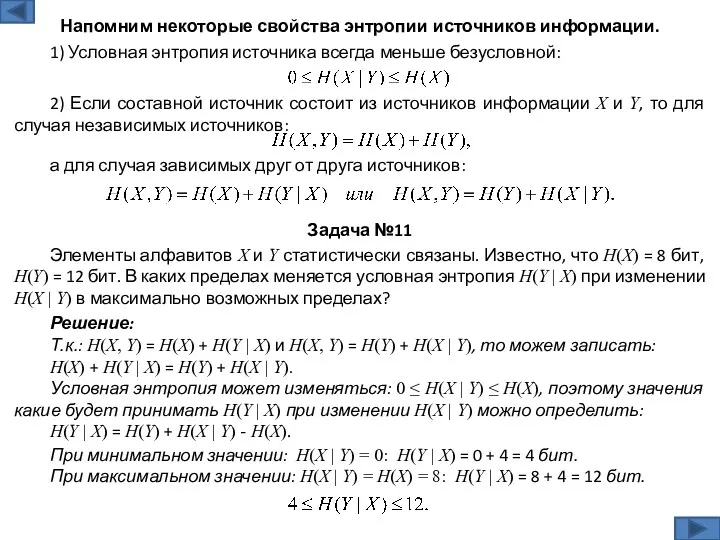

- 22. Решение: Т.к.: H(X, Y) = H(X) + H(Y | X) и H(X, Y) = H(Y) +

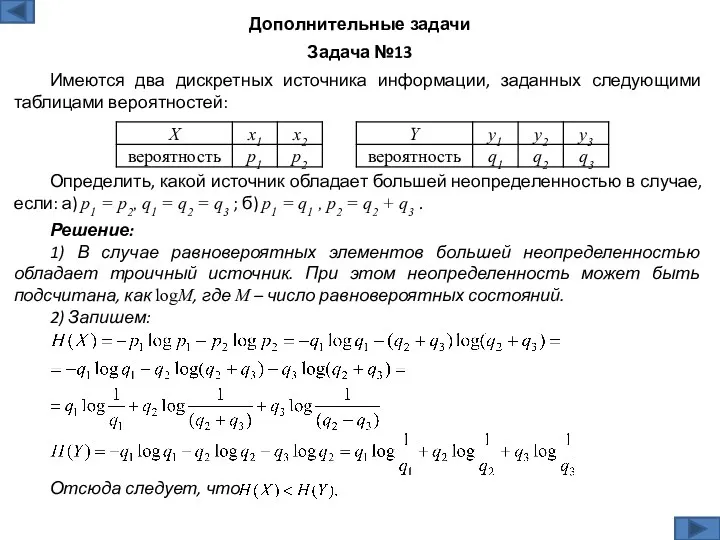

- 23. Решение: 1) В случае равновероятных элементов большей неопределенностью обладает троичный источник. При этом неопределенность может быть

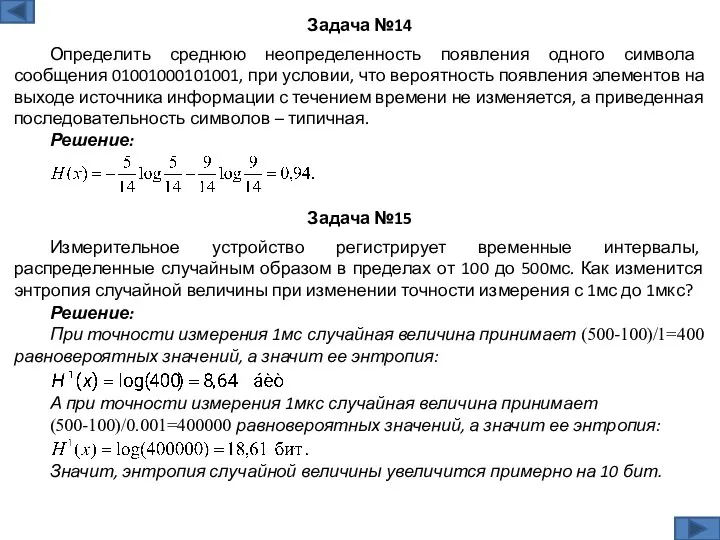

- 24. Решение: Задача №14 Определить среднюю неопределенность появления одного символа сообщения 01001000101001, при условии, что вероятность появления

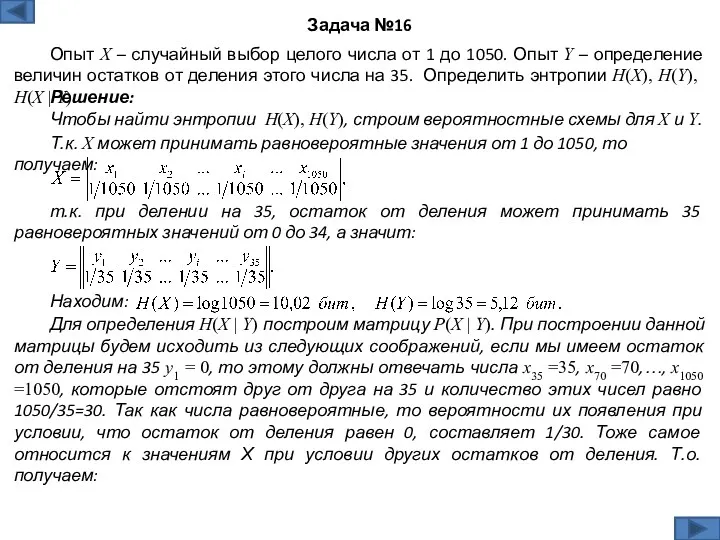

- 25. Задача №16 Опыт Х – случайный выбор целого числа от 1 до 1050. Опыт Y –

- 27. Скачать презентацию

Spanning Tree Protocol (STP) ( протокол покрывающего дерева)

Spanning Tree Protocol (STP) ( протокол покрывающего дерева) Безопасные правила цифрового поведения. 9 класс

Безопасные правила цифрового поведения. 9 класс Жадыны басқару

Жадыны басқару Презентация Microsoft Office PowerPoint

Презентация Microsoft Office PowerPoint Массивы в Паскале. Одномерные массивы

Массивы в Паскале. Одномерные массивы Проектирование Баз Данных. Основные понятия Теории Нормализации

Проектирование Баз Данных. Основные понятия Теории Нормализации Составляющие государственной системы защиты информации

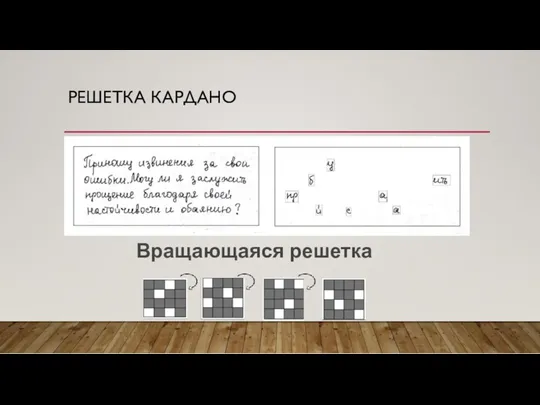

Составляющие государственной системы защиты информации Криптография. Методы шифрования текста

Криптография. Методы шифрования текста Робота з оригіналами елементів зовнішнього оформлення видань. (Тема 5)

Робота з оригіналами елементів зовнішнього оформлення видань. (Тема 5) Модели и моделирование. Модели и их типы

Модели и моделирование. Модели и их типы Atlas. Человекоподобный робот компании Boston Dynamics

Atlas. Человекоподобный робот компании Boston Dynamics Создание 3D пазл для детей младшего возраста

Создание 3D пазл для детей младшего возраста Выбор книг в библиотеке

Выбор книг в библиотеке Основы информатики и программирования

Основы информатики и программирования Решение заданий ЕГЭ по информатике №2 (А3) и №18 (А10)

Решение заданий ЕГЭ по информатике №2 (А3) и №18 (А10) Использование пиксельных изображений в векторной графике и особенности работы с коллажами в Corel Draw

Использование пиксельных изображений в векторной графике и особенности работы с коллажами в Corel Draw Тема мастер класса: Роль текущего повторения для достижения результатов обучения.

Тема мастер класса: Роль текущего повторения для достижения результатов обучения. Афиши. Основы типографики для самых маленьких

Афиши. Основы типографики для самых маленьких Основные направления развития искусственного интеллекта (лекция 2)

Основные направления развития искусственного интеллекта (лекция 2) Яким чином функціонує електронна пошта

Яким чином функціонує електронна пошта Комплексное решение для индустрии красоты на платформе 1С

Комплексное решение для индустрии красоты на платформе 1С Мультимедиа технология

Мультимедиа технология Методология управления качеством проекта профессиональной системой управления проектами MS Project

Методология управления качеством проекта профессиональной системой управления проектами MS Project Информационная система по управлению складскими запасами предприятия

Информационная система по управлению складскими запасами предприятия Методическая инструкция. Создание таблиц со схемами для отчета по выполненным работам

Методическая инструкция. Создание таблиц со схемами для отчета по выполненным работам Автоматизация обучения, оценки и развития персонала. Программные продукты и решения компании WebSoft

Автоматизация обучения, оценки и развития персонала. Программные продукты и решения компании WebSoft Информационные ресурсы БИБЛИОТЕКИ Университета для программы MBA Управление в здравоохранении

Информационные ресурсы БИБЛИОТЕКИ Университета для программы MBA Управление в здравоохранении Обзор поисковых систем

Обзор поисковых систем