Содержание

- 2. Проект: Исследование алгоритмов глобальной оптимизации Цель: Реализация и исследование качества работы и эффективности алгоритмов глобальной оптимизации

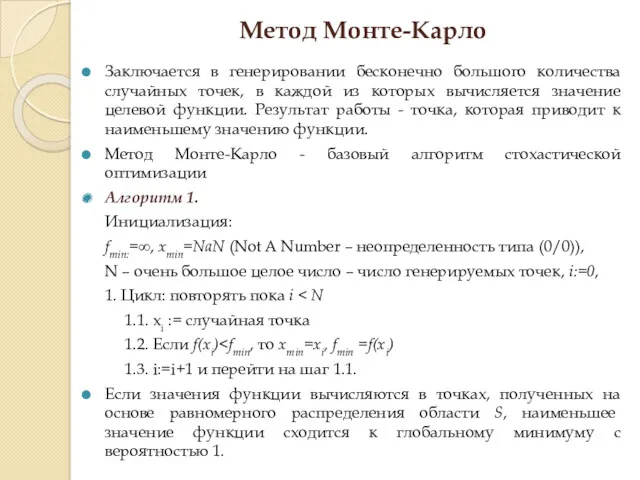

- 3. Метод Монте-Карло Заключается в генерировании бесконечно большого количества случайных точек, в каждой из которых вычисляется значение

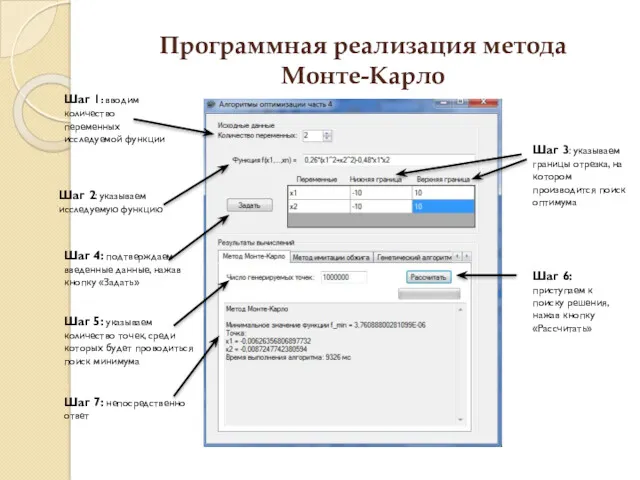

- 4. Программная реализация метода Монте-Карло Шаг 1: вводим количество переменных исследуемой функции Шаг 2: указываем исследуемую функцию

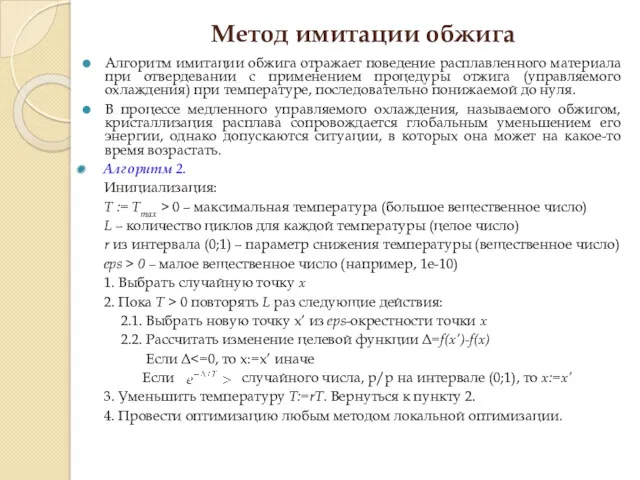

- 5. Метод имитации обжига Алгоритм имитации обжига отражает поведение расплавленного материала при отвердевании с применением процедуры отжига

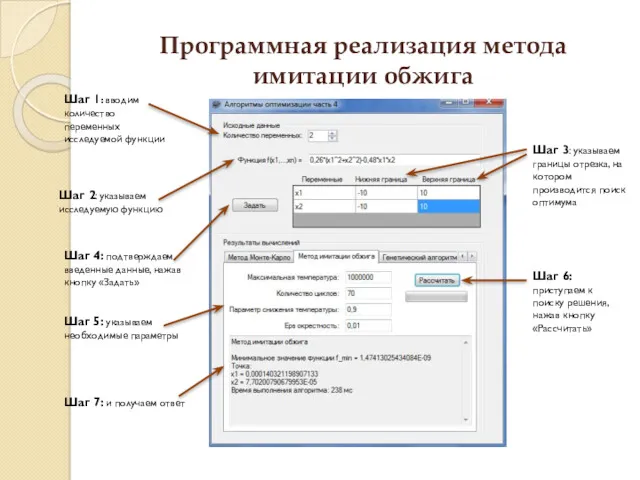

- 6. Программная реализация метода имитации обжига Шаг 1: вводим количество переменных исследуемой функции Шаг 2: указываем исследуемую

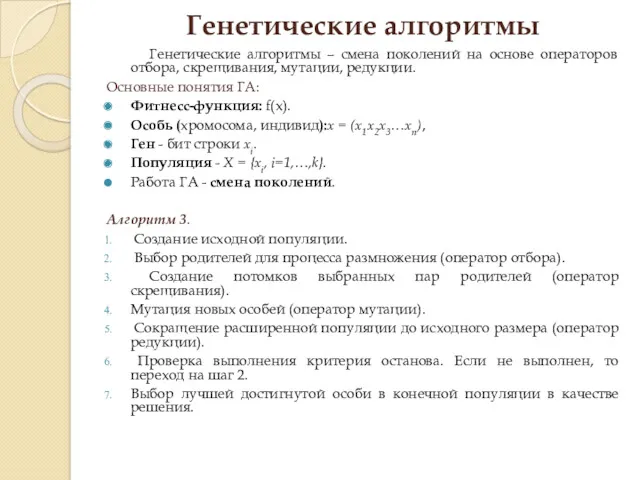

- 7. Генетические алгоритмы Генетические алгоритмы – смена поколений на основе операторов отбора, скрещивания, мутации, редукции. Основные понятия

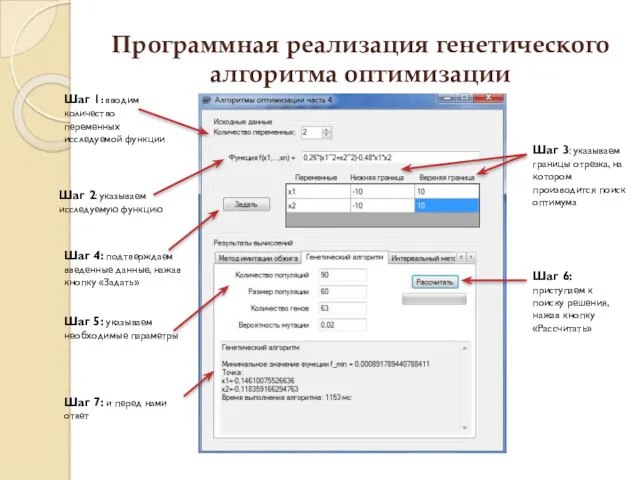

- 8. Программная реализация генетического алгоритма оптимизации Шаг 7: и перед нами ответ Шаг 5: указываем необходимые параметры

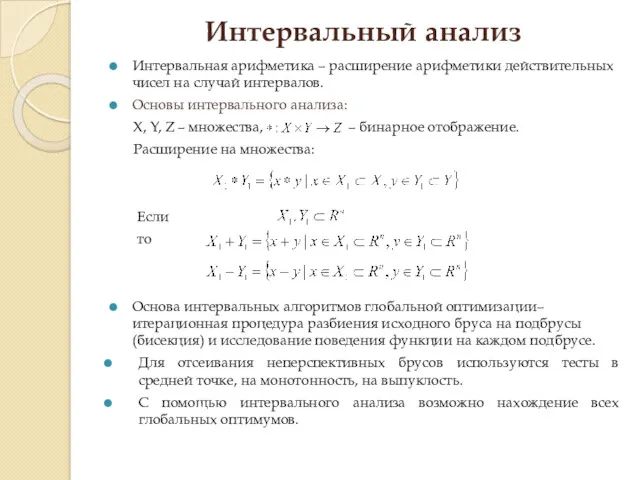

- 9. Интервальный анализ Интервальная арифметика – расширение арифметики действительных чисел на случай интервалов. Основы интервального анализа: X,

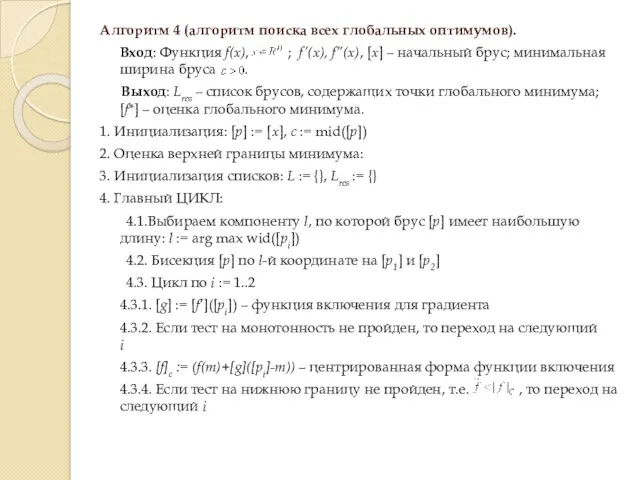

- 10. Алгоритм 4 (алгоритм поиска всех глобальных оптимумов). Вход: Функция f(x), ; f’(x), f’’(x), [x] – начальный

- 11. 4.3.5. [H] := [f’’]([pi]) – функция включения для матрицы Гессе 4.3.6. Если тест на выпуклость не

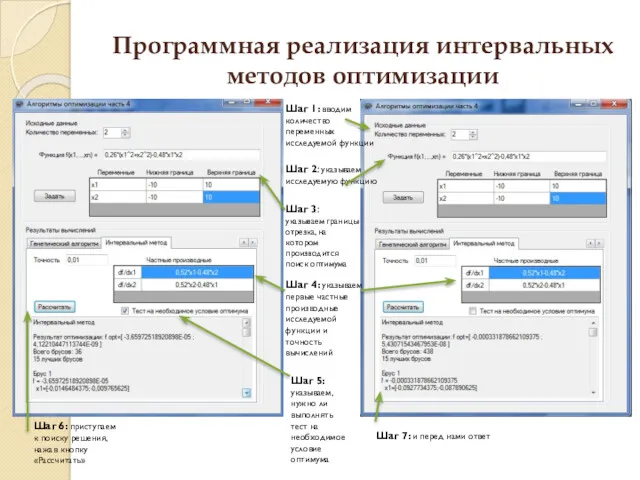

- 12. Программная реализация интервальных методов оптимизации Шаг 6: приступаем к поиску решения, нажав кнопку «Рассчитать» Шаг 1:

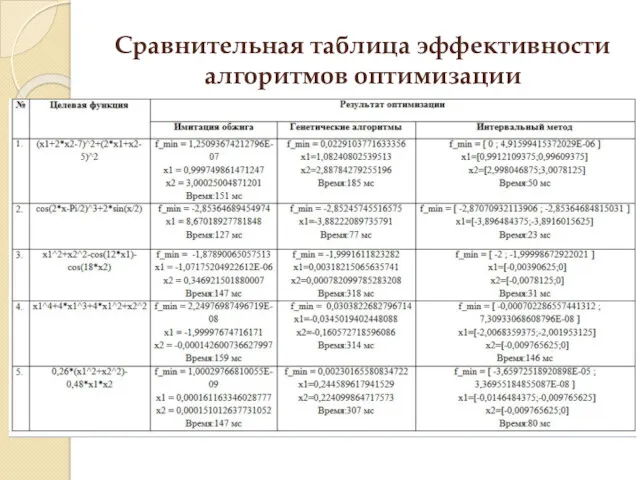

- 13. Сравнительная таблица эффективности алгоритмов оптимизации

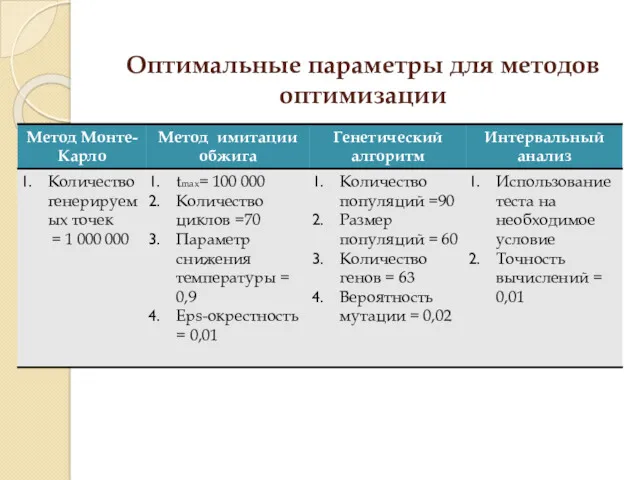

- 14. Оптимальные параметры для методов оптимизации

- 15. Заключение Были исследованы основные особенности схемы алгоритмов, тесты на проверку, особенности определения парадигм интервального анализа, а

- 17. Скачать презентацию

![4.3.5. [H] := [f’’]([pi]) – функция включения для матрицы Гессе](/_ipx/f_webp&q_80&fit_contain&s_1440x1080/imagesDir/jpg/165118/slide-10.jpg)

Операционные системы и среды

Операционные системы и среды Компьютер и здоровье школьников

Компьютер и здоровье школьников Сборка ПК

Сборка ПК Belcome. Новый туризм

Belcome. Новый туризм Построение перпендикуляра к заданной прямой

Построение перпендикуляра к заданной прямой Журналистика как творчество

Журналистика как творчество Отношения объектов и их множеств

Отношения объектов и их множеств Сеть Интернет. Веб-страница, веб-сайт

Сеть Интернет. Веб-страница, веб-сайт Классификация моделей данных

Классификация моделей данных Распознавание образов. Классификация

Распознавание образов. Классификация Язык гипертекстовой разметки HTML

Язык гипертекстовой разметки HTML 20190405_izmerenie_informatsii

20190405_izmerenie_informatsii Переключательная схема

Переключательная схема Языки программирования высокого уровня

Языки программирования высокого уровня Понятие об информации и ее передаче. Предмет изучения теории информации

Понятие об информации и ее передаче. Предмет изучения теории информации IT advancements in Finance Chat bot banking

IT advancements in Finance Chat bot banking Логические операторы. Операторы сравнения. Тернарный оператор

Логические операторы. Операторы сравнения. Тернарный оператор Работа с Joomla

Работа с Joomla Введение в программирование. Тема 5. Цикл for

Введение в программирование. Тема 5. Цикл for Eglamour SlidesCarnival

Eglamour SlidesCarnival Облачные технологии

Облачные технологии Алфавитный подход в измерении информации. 2 урок ( 10 класс )

Алфавитный подход в измерении информации. 2 урок ( 10 класс ) Змінювання значень властивостей об’єкта в програмі

Змінювання значень властивостей об’єкта в програмі Функционал рабочих приложений - КМ

Функционал рабочих приложений - КМ Виды компьютерной графики

Виды компьютерной графики Кортежи, словари и множества в Python. Лекция 11

Кортежи, словари и множества в Python. Лекция 11 Оценка количественных параметров текстовых документов. Обработка текстовой информации

Оценка количественных параметров текстовых документов. Обработка текстовой информации Основные виды опасного и запрещённого контента в Интернете и его признаки, приёмы распознавания опасностей в Интернете

Основные виды опасного и запрещённого контента в Интернете и его признаки, приёмы распознавания опасностей в Интернете