Содержание

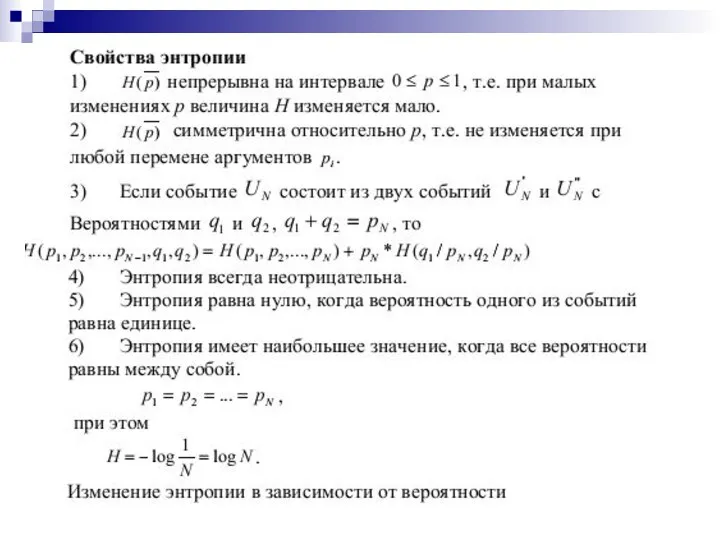

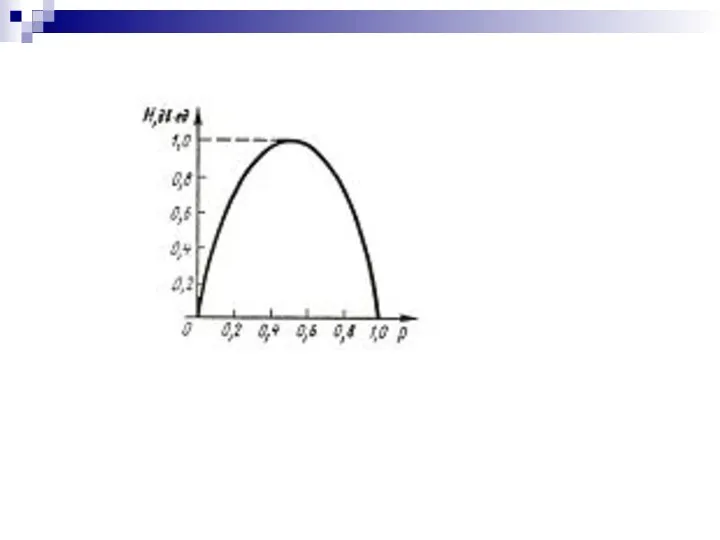

- 2. Впервые понятие энтропии ввёл Клаузилус. Свойства энтропии Энтропия всегда неотрицательна, так как значения вероятностей выражаются дробными

- 5. Энтропия ансамбля Ансамблем называется полная совокупность состояний с вероятностями их появлений, составляющими в сумме единицу: Энтропия

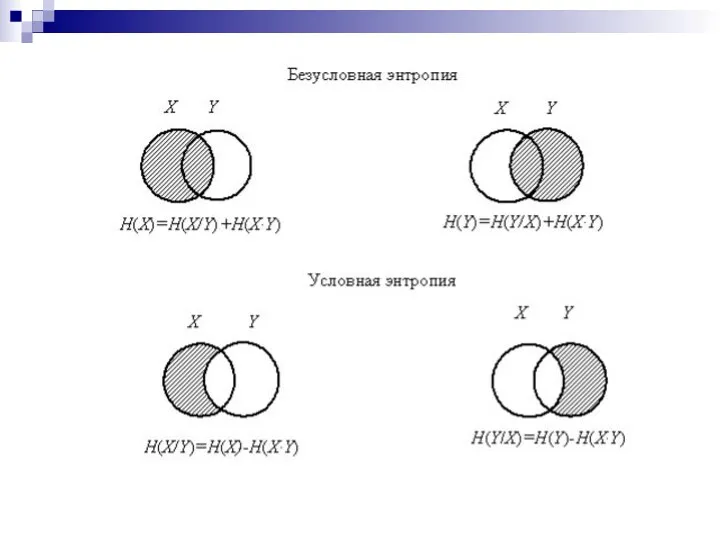

- 6. Понятие условной энтропии в теории информации используется при определении взаимозависимости между: а) символами кодируемого алфавита (между

- 7. Общая условная энтропия сообщения В относительно сообщения А характеризует количество информации, содержащееся в любом символе алфавита,

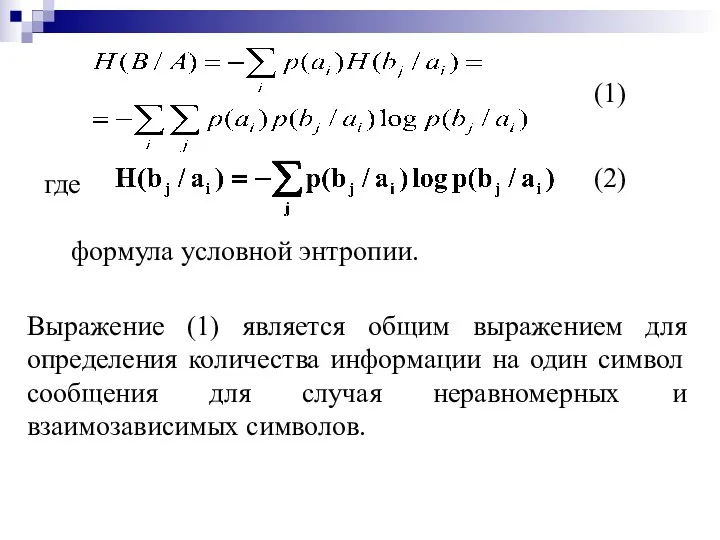

- 8. где формула условной энтропии. (2) (1) Выражение (1) является общим выражением для определения количества информации на

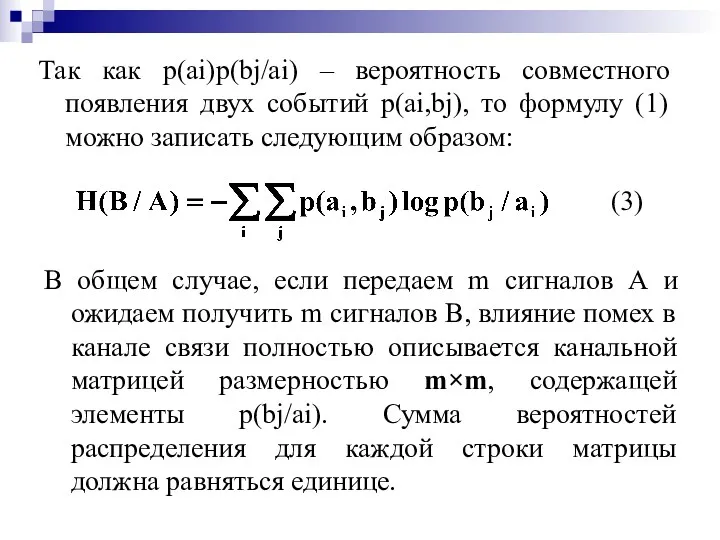

- 9. Так как p(ai)p(bj/ai) – вероятность совместного появления двух событий p(ai,bj), то формулу (1) можно записать следующим

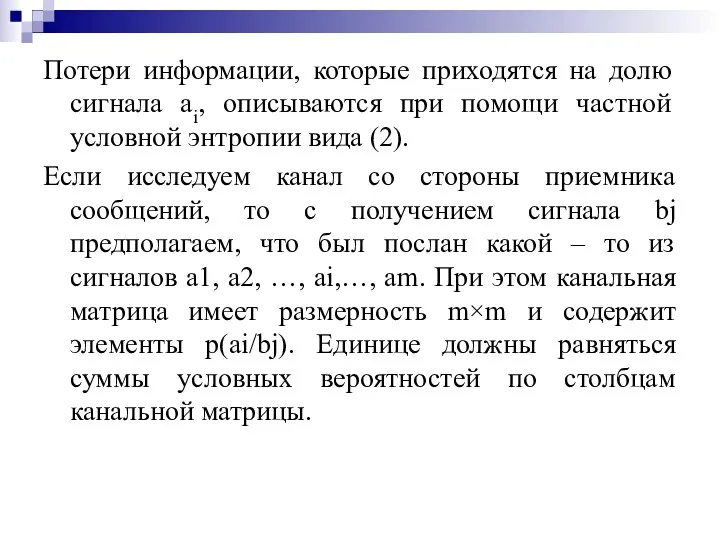

- 10. Потери информации, которые приходятся на долю сигнала ai, описываются при помощи частной условной энтропии вида (2).

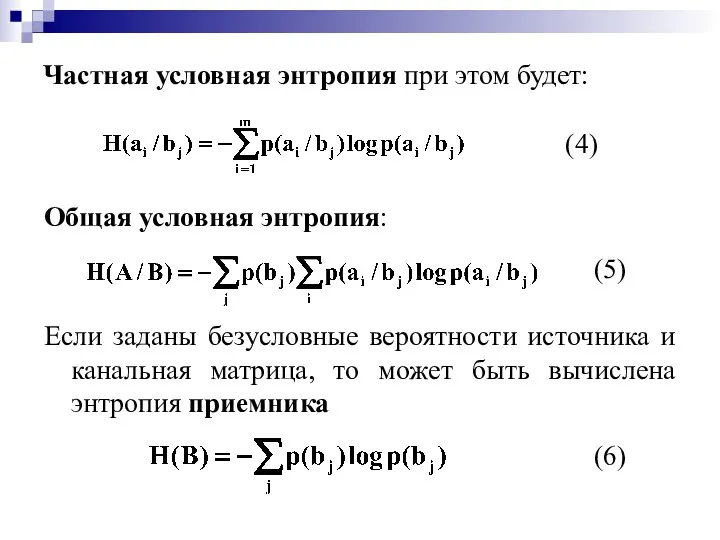

- 11. Частная условная энтропия при этом будет: (4) Общая условная энтропия: (5) Если заданы безусловные вероятности источника

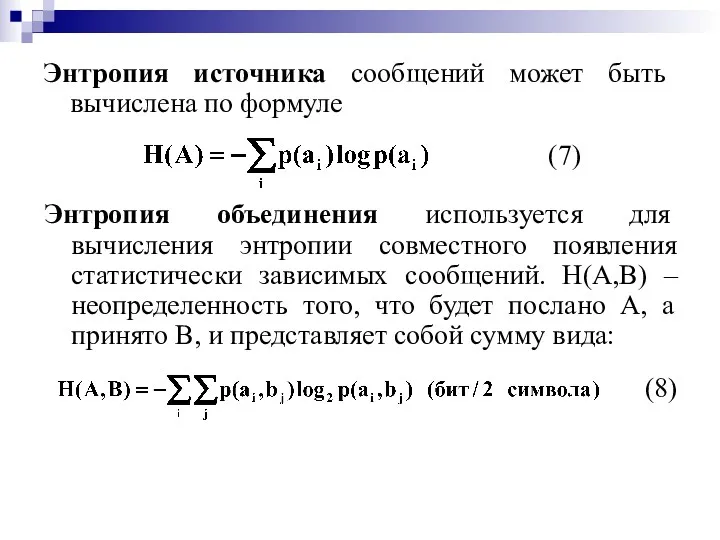

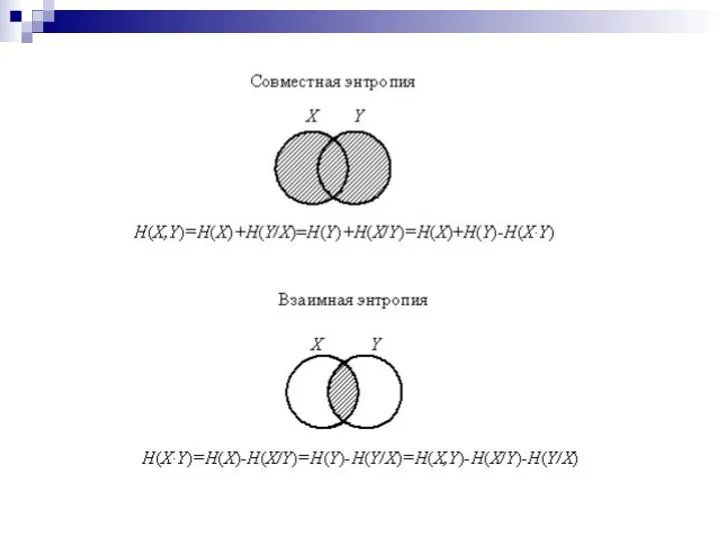

- 12. Энтропия источника сообщений может быть вычислена по формуле (7) Энтропия объединения используется для вычисления энтропии совместного

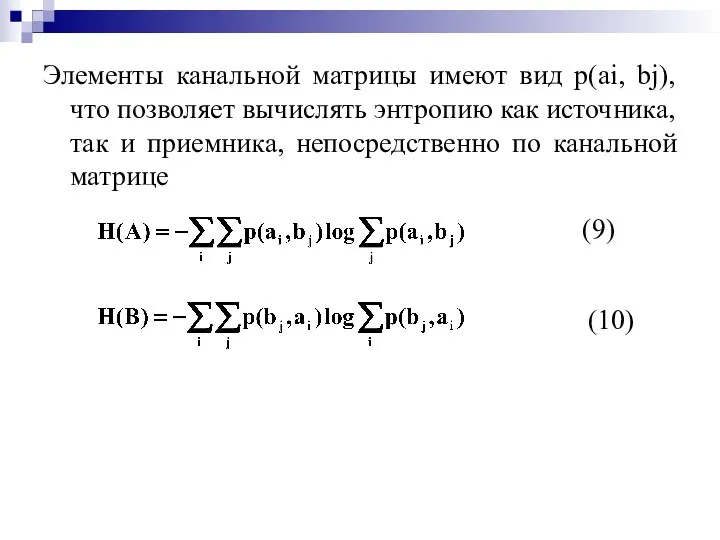

- 13. Элементы канальной матрицы имеют вид p(ai, bj), что позволяет вычислять энтропию как источника, так и приемника,

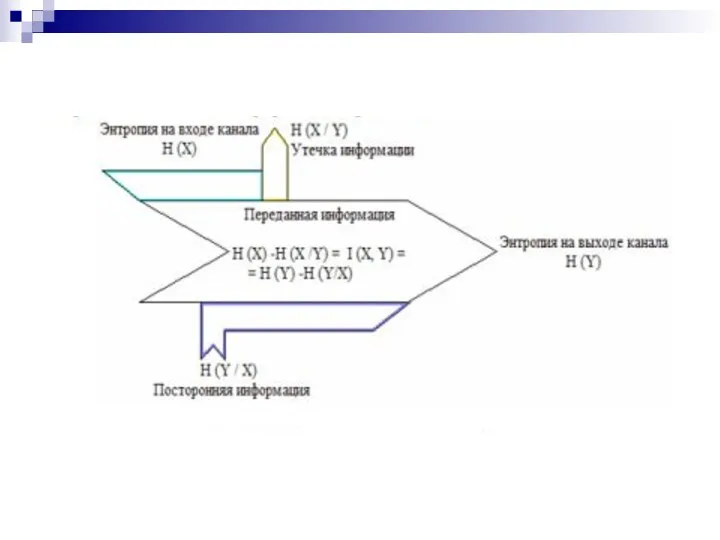

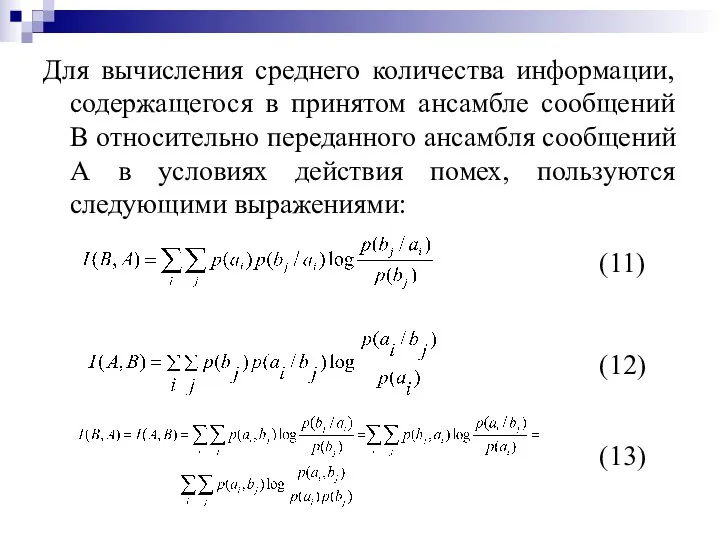

- 17. Для вычисления среднего количества информации, содержащегося в принятом ансамбле сообщений В относительно переданного ансамбля сообщений А

- 18. I(A,B) показывает какое (в среднем) количество информации содержит сообщение А о сообщении В или наоборот сообщение

- 19. Основные свойства количества информации 1. I(X,Y) = I(Y,X), т.е. количество информации, содержащееся в случайном объекте Y

- 20. Из этого также непосредственно вытекает, что энтропия есть максимальное количество информации, которое можно получить об объекте.

- 21. Если А и В- это сообщения на входе и на выходе канала связи с помехами, то

- 23. Скачать презентацию

Растровая и векторная графика

Растровая и векторная графика Как подготовить эффективную презентацию

Как подготовить эффективную презентацию Сервисы интернета

Сервисы интернета Искусственный интеллект

Искусственный интеллект МегаФон. Услуги CDN в операторском бизнесе

МегаФон. Услуги CDN в операторском бизнесе Основы алгоритмизации и объектно-ориентированного программирования

Основы алгоритмизации и объектно-ориентированного программирования Антивирустар. Компьютерлік вирус

Антивирустар. Компьютерлік вирус Принципы управления, построения и алгоритмы функционирования элементов САУ и СА

Принципы управления, построения и алгоритмы функционирования элементов САУ и СА Uvers - A New Generation Social Network

Uvers - A New Generation Social Network Программирование на языке Python

Программирование на языке Python Функции защиты от перегрузок CPU. Функции защиты от петель в сетях Ethernet с помощью управляемых коммутаторов L2

Функции защиты от перегрузок CPU. Функции защиты от петель в сетях Ethernet с помощью управляемых коммутаторов L2 مبانی کامپیوتر و برنامه سازی

مبانی کامپیوتر و برنامه سازی Решение задач общего машиностроения в программном комплексе

Решение задач общего машиностроения в программном комплексе Многопрофильная командная инженерная олимпиада для школьников 9-11 классов

Многопрофильная командная инженерная олимпиада для школьников 9-11 классов Информатика. Материалы к лекции 5. Пользовательская форма на VBA

Информатика. Материалы к лекции 5. Пользовательская форма на VBA Microsoft тарихы

Microsoft тарихы Java for web. Log4j

Java for web. Log4j Протоколи міждоменної маршрутизації. (Лекція 6)

Протоколи міждоменної маршрутизації. (Лекція 6) Физкультминутка на уроках

Физкультминутка на уроках Инструкция по запуску дистанционных курсов

Инструкция по запуску дистанционных курсов Цикл с параметром (цикл с заданным числом повторений, цикл-ДЛЯ)

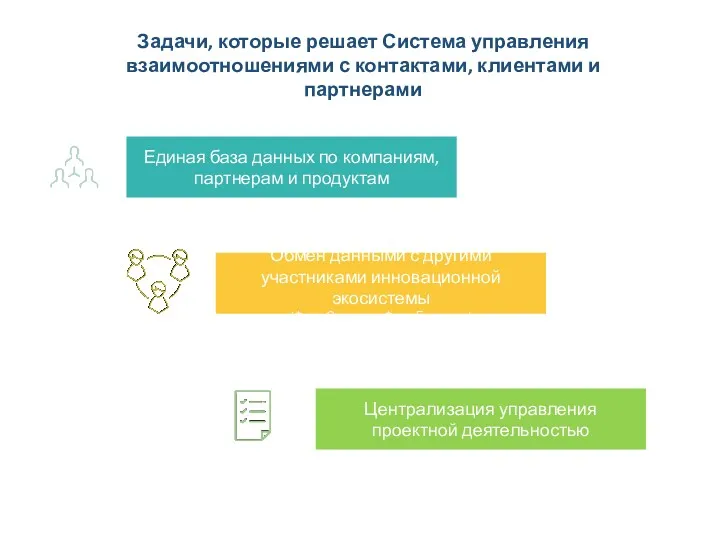

Цикл с параметром (цикл с заданным числом повторений, цикл-ДЛЯ) Задачи, которые решает Система управления взаимоотношениями с контактами, клиентами и партнерами

Задачи, которые решает Система управления взаимоотношениями с контактами, клиентами и партнерами Hire-pal. The question is … What needs to change?

Hire-pal. The question is … What needs to change? Перевод целых чисел из десятичной системы счисления в любую другую

Перевод целых чисел из десятичной системы счисления в любую другую Общение в интернете

Общение в интернете Основные этапы развития информационного общества

Основные этапы развития информационного общества Программирование на языке Python. Циклические алгоритмы

Программирование на языке Python. Циклические алгоритмы DA 101 Protecting your Domain Admin Account

DA 101 Protecting your Domain Admin Account