Содержание

- 2. Нечеткая логика выведена из теории нечетких множеств, имеющей дело с рассуждениями, которые в большей степени являются

- 3. С помощью принятия решений в ИНС, основанной на нечеткой логике, можно создать мощную систему управления. Очевидно,

- 4. Например, нейрокомпьютер для обработки изображений может снять многочисленные ограничения по видеозаписи, освещению и настройкам аппаратуры. Такая

- 5. Механизм логического вывода начинает работать с“оценки”условий освещения (другими словами, устанавливает степень сходства с другими условиями освещения,

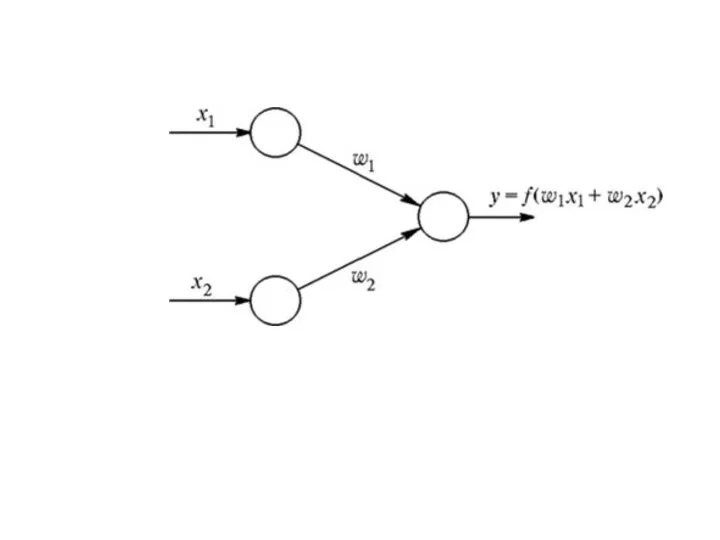

- 7. В случае применения других операций, таких как t-норма или t-конорма, придем к нейронной сети, которая будет

- 8. Нечеткая нейронная (гибридная) сеть - это нейронная сеть с четкими сигналами, весами и активационной функцией, но

- 9. Т-норма или, несокращенная, треугольная норма )является своим родом бинарной операцией , используемой в рамках вероятностных метрических

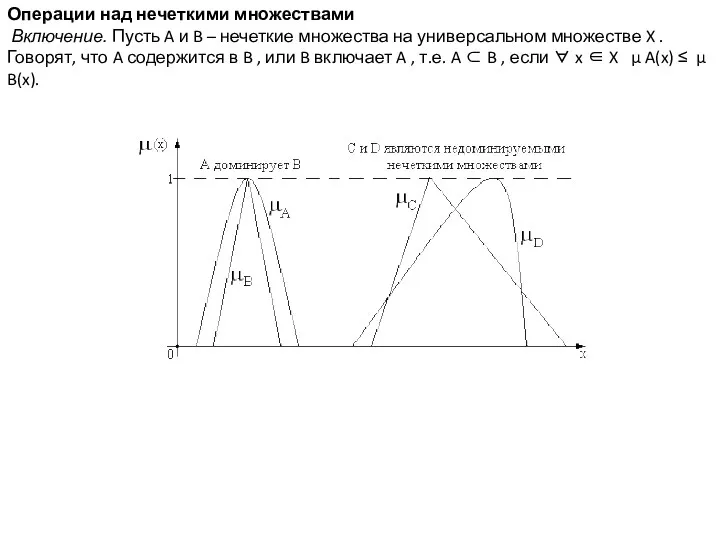

- 10. Операции над нечеткими множествами Включение. Пусть A и B – нечеткие множества на универсальном множестве X

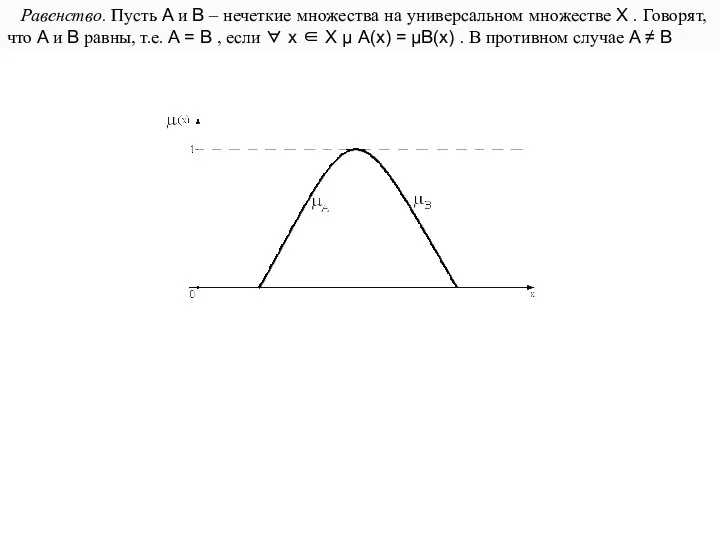

- 11. Равенство. Пусть A и B – нечеткие множества на универсальном множестве X . Говорят, что A

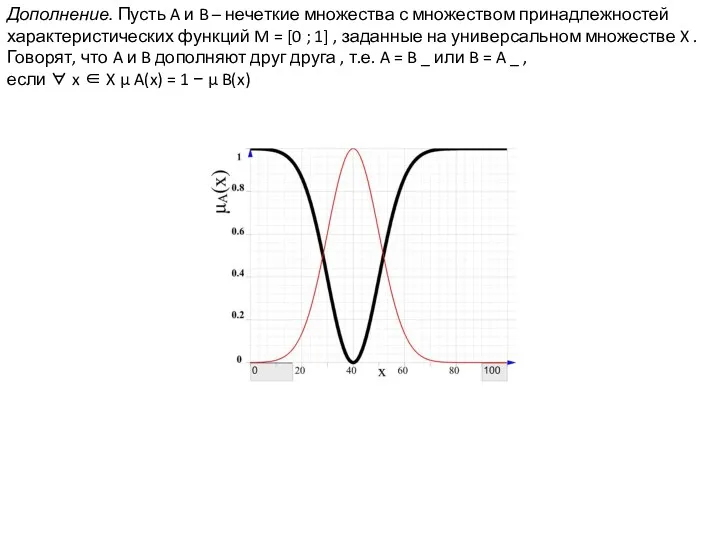

- 12. Дополнение. Пусть A и B – нечеткие множества с множеством принадлежностей характеристических функций M = [0

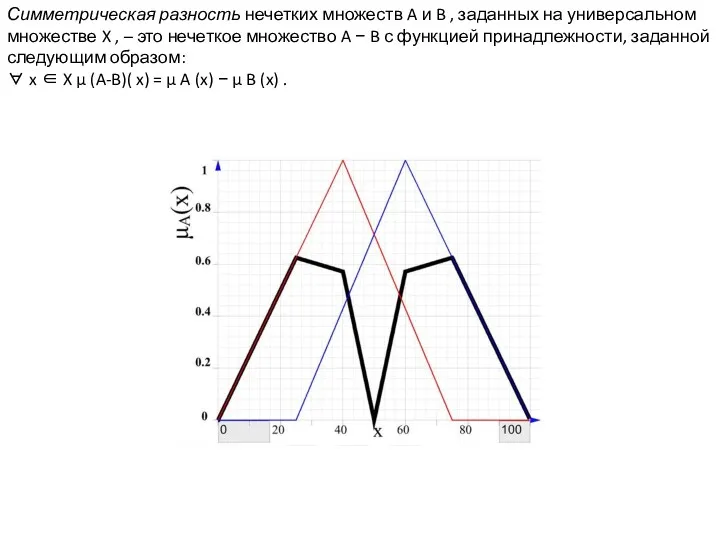

- 13. Симметрическая разность нечетких множеств A и B , заданных на универсальном множестве X , – это

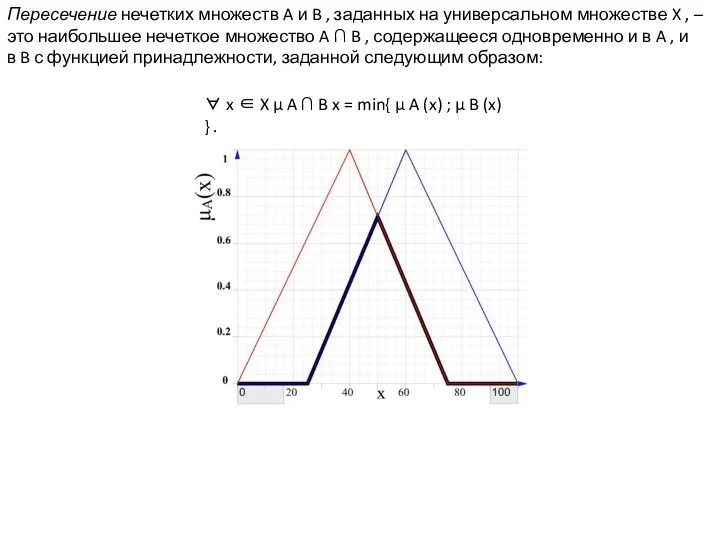

- 14. Пересечение нечетких множеств A и B , заданных на универсальном множестве X , – это наибольшее

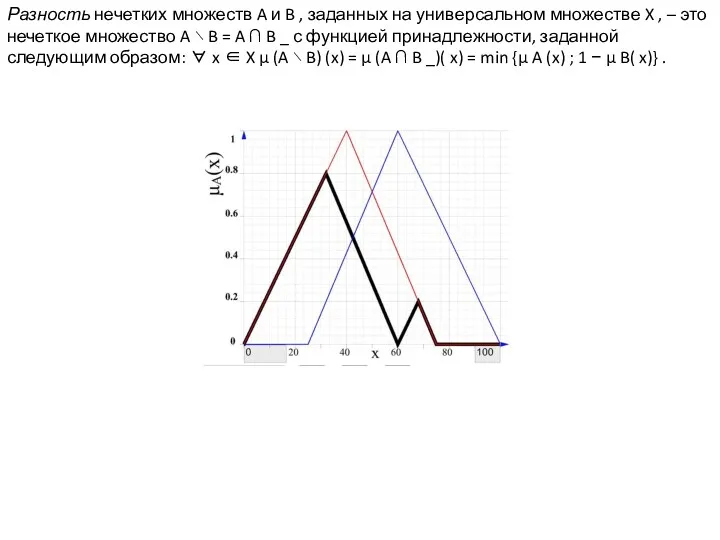

- 15. Разность нечетких множеств A и B , заданных на универсальном множестве X , – это нечеткое

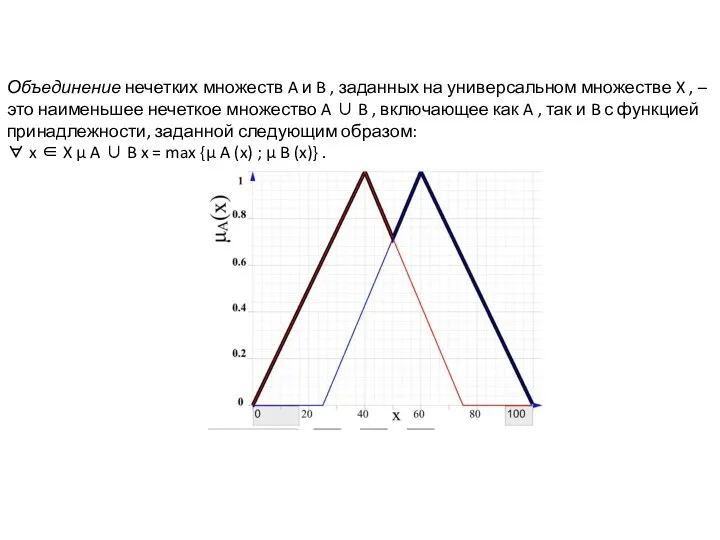

- 16. Объединение нечетких множеств A и B , заданных на универсальном множестве X , – это наименьшее

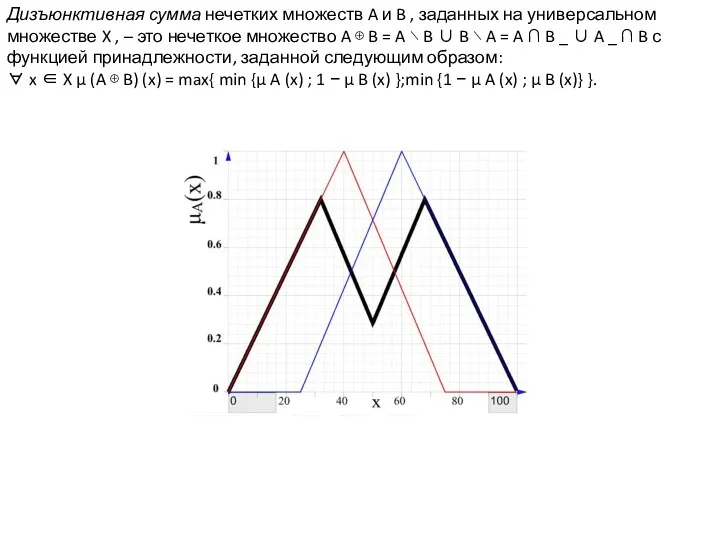

- 17. Дизъюнктивная сумма нечетких множеств A и B , заданных на универсальном множестве X , – это

- 18. Минимальная t-норма также называется t-нормой Гёделя , поскольку это стандартная семантика конъюнкции в нечеткой логике Геделя.

- 19. T-норма Лукасевича Название происходит от того факта, что t-норма является стандартной семантикой для сильной конъюнкции в

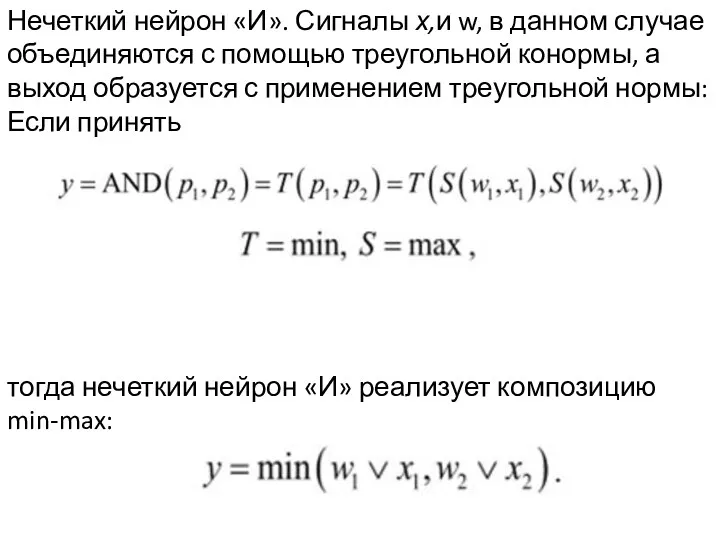

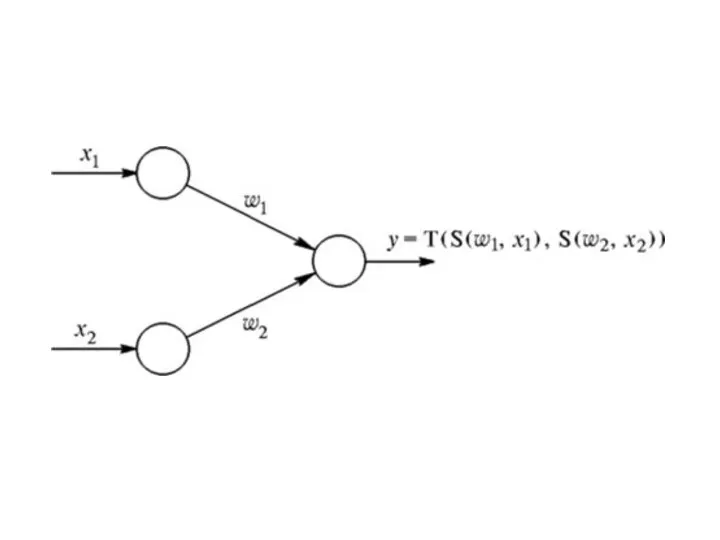

- 20. Нечеткий нейрон «И». Сигналы х,и w, в данном случае объединяются с помощью треугольной конормы, а выход

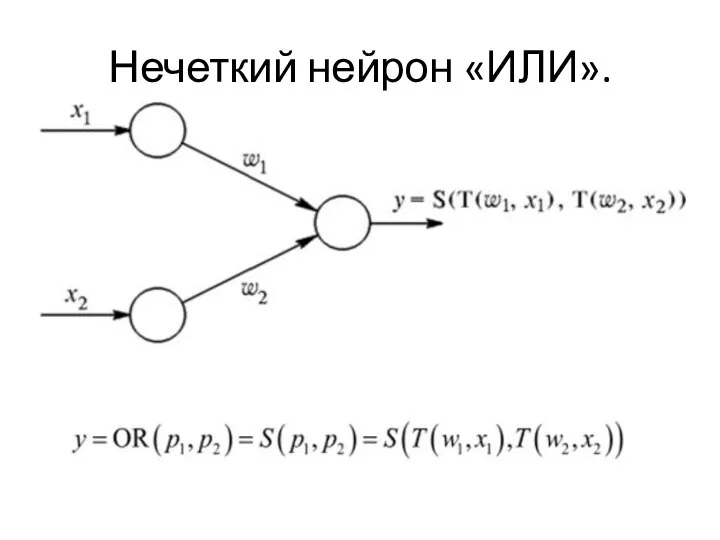

- 22. Нечеткий нейрон «ИЛИ».

- 23. Нечеткая нейронная сеть как правило состоит из четырех слоев: слоя фазификации входных переменных, слоя агрегирования значений

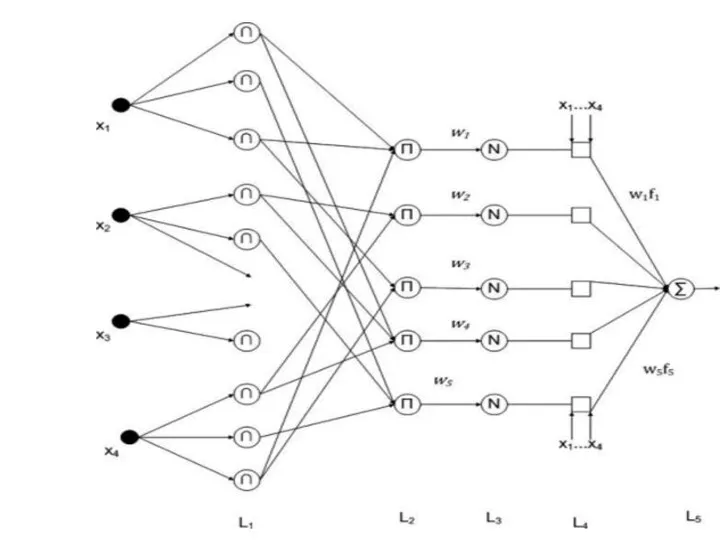

- 24. На схеме показана нечеткая нейронная сеть с четырьмя входами (п = 4). Слои обозначены символами от

- 25. Назначение слоев, следующее: первый слой - термы входных переменных(Термом называется любой элемент терм–множества(Терм-множеством называется множество всех

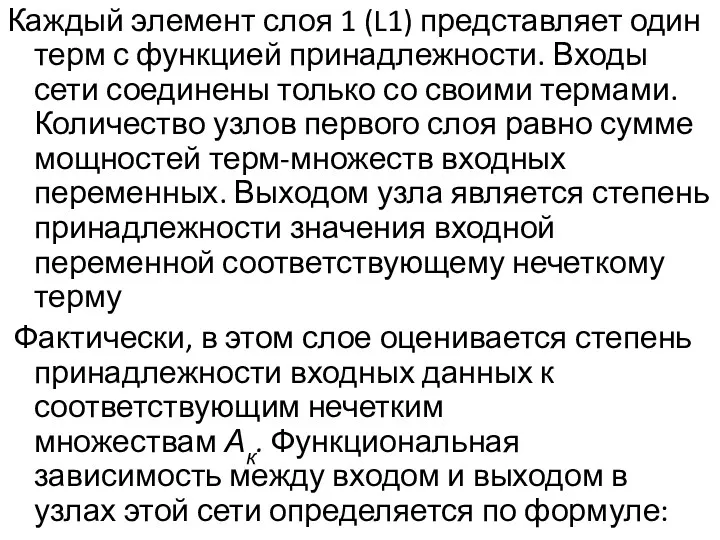

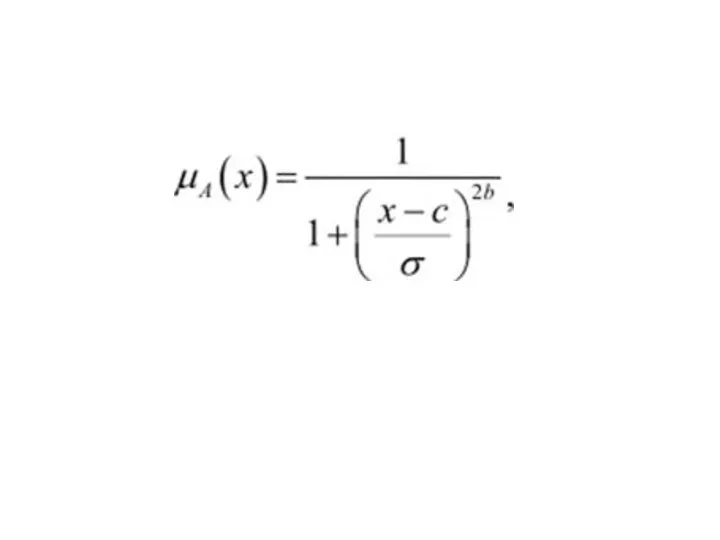

- 27. Каждый элемент слоя 1 (L1) представляет один терм с функцией принадлежности. Входы сети соединены только со

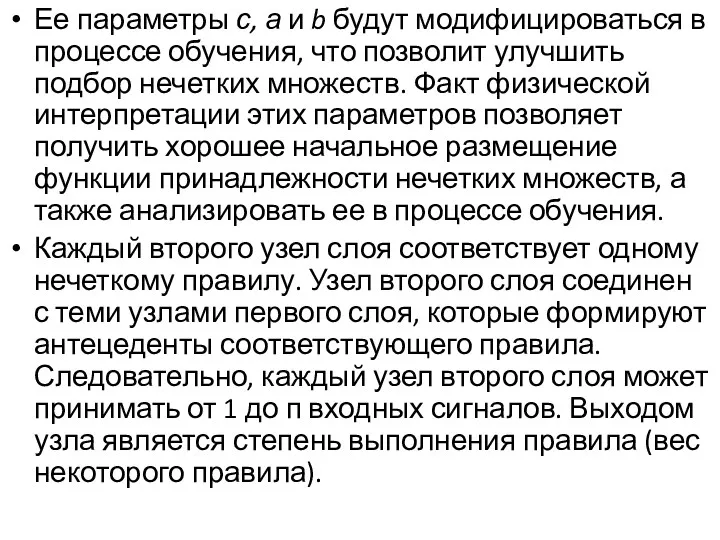

- 29. Ее параметры с, а и b будут модифицироваться в процессе обучения, что позволит улучшить подбор нечетких

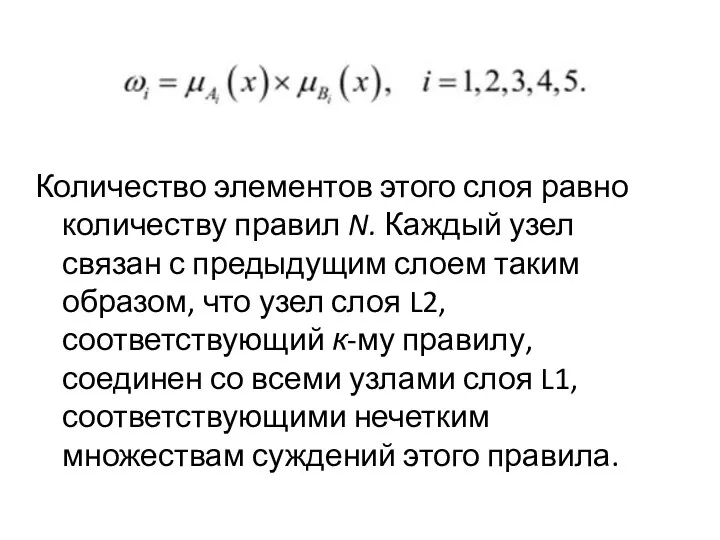

- 30. Количество элементов этого слоя равно количеству правил N. Каждый узел связан с предыдущим слоем таким образом,

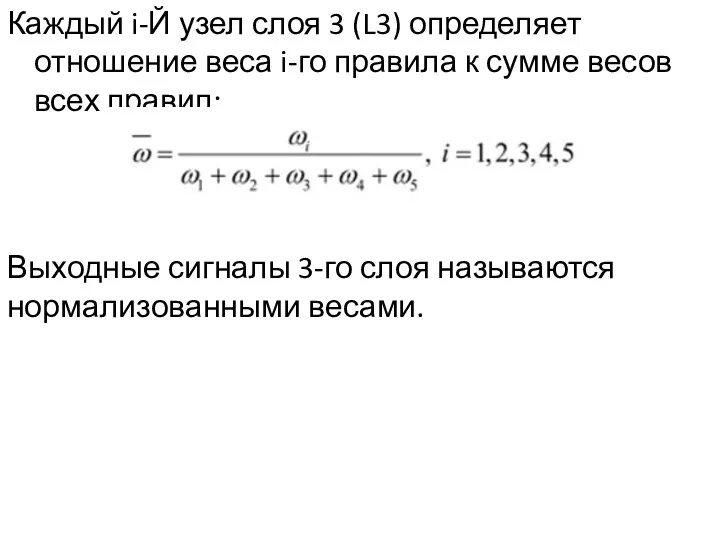

- 31. Каждый i-Й узел слоя 3 (L3) определяет отношение веса i-го правила к сумме весов всех правил:

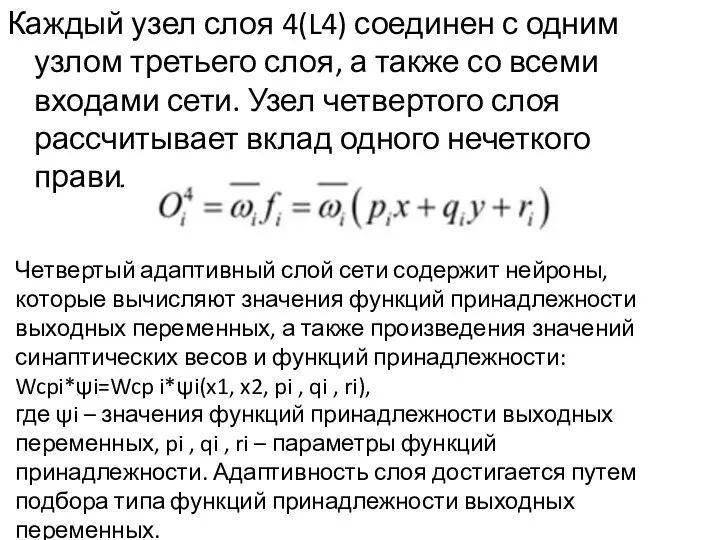

- 32. Каждый узел слоя 4(L4) соединен с одним узлом третьего слоя, а также со всеми входами сети.

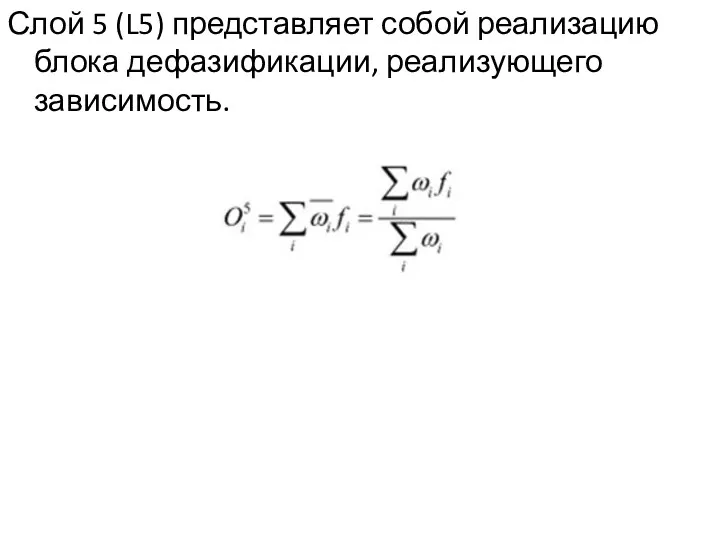

- 33. Слой 5 (L5) представляет собой реализацию блока дефазификации, реализующего зависимость.

- 35. Скачать презентацию

Как работает современный поиск

Как работает современный поиск Файлы и файловые структуры. Компьютер как унивесальное устройство для работы с информацией. Информатика. 7 класс

Файлы и файловые структуры. Компьютер как унивесальное устройство для работы с информацией. Информатика. 7 класс Кнопки. Стилистика кнопок

Кнопки. Стилистика кнопок АРМ Метролог

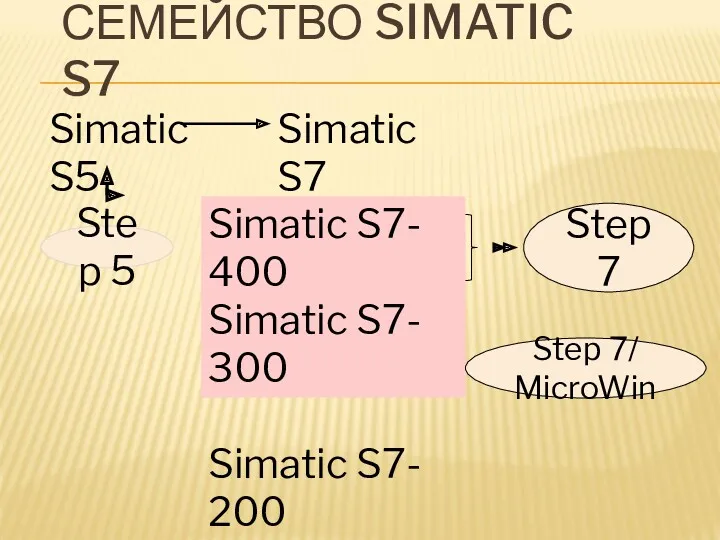

АРМ Метролог Семейство SIMATIC S7

Семейство SIMATIC S7 Нормальные формы отношений. Логическая модель реляционной базы данных. (Тема 5)

Нормальные формы отношений. Логическая модель реляционной базы данных. (Тема 5) Схемы. Многообразие схем. Информационные модели на графах. Использование графов при решении задач

Схемы. Многообразие схем. Информационные модели на графах. Использование графов при решении задач Мова запитів SQL

Мова запитів SQL Устройства ввода информации. (7класс)

Устройства ввода информации. (7класс) Игровое пространство

Игровое пространство Перегрузка операторов. Лекция 38

Перегрузка операторов. Лекция 38 Характеристики систем функціональних пристроїв. Лекція №3

Характеристики систем функціональних пристроїв. Лекція №3 Переключатели зависимые и независимые

Переключатели зависимые и независимые Базы данных: выборка данных

Базы данных: выборка данных Основні можливості роботи в Power Point

Основні можливості роботи в Power Point Информационная система учета программной литературы Кировского авиационного техникума

Информационная система учета программной литературы Кировского авиационного техникума Краткий гайд по прокачке 1-26 за Орду

Краткий гайд по прокачке 1-26 за Орду Работа с программой Octopus и сайтом статистики

Работа с программой Octopus и сайтом статистики Особенности работы с библиотечной программой MARC SQL

Особенности работы с библиотечной программой MARC SQL Виды информации по способу восприятия

Виды информации по способу восприятия Динамическое программирование. Примеры задач

Динамическое программирование. Примеры задач Модели коммуникации

Модели коммуникации Проверка знаний

Проверка знаний Володар перснів

Володар перснів Файловая система ОС UNIX. (Занятия 5 и 6)

Файловая система ОС UNIX. (Занятия 5 и 6) Розробка та дослідження систем програмування плк за допомогою циклограм

Розробка та дослідження систем програмування плк за допомогою циклограм Печатные работы сотрудников Уральского государственного медицинского университета. Выпуск 7

Печатные работы сотрудников Уральского государственного медицинского университета. Выпуск 7 Сетевые педагогические сообщества

Сетевые педагогические сообщества