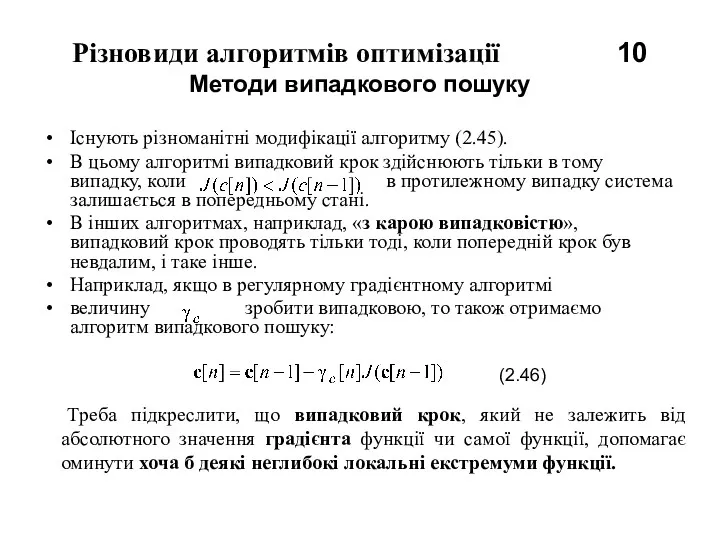

Різновиди алгоритмів оптимізації 10

Методи випадкового пошуку

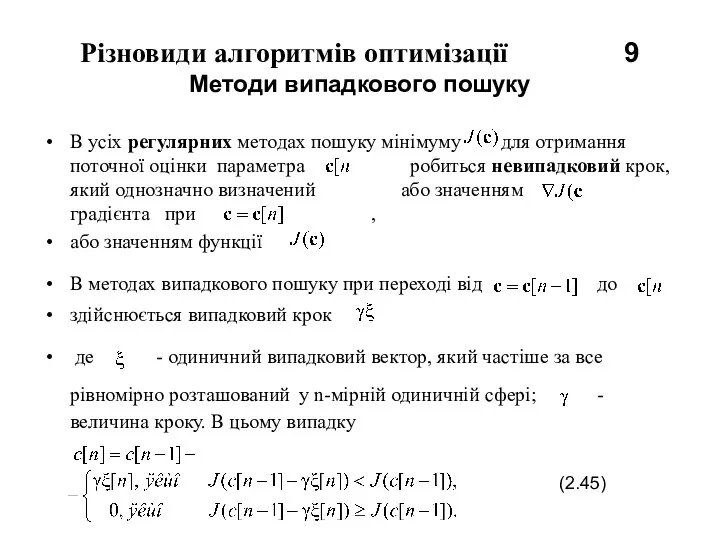

Існують різноманітні модифікації алгоритму (2.45).

В

цьому алгоритмі випадковий крок здійснюють тільки в тому випадку, коли в протилежному випадку система залишається в попередньому стані.

В інших алгоритмах, наприклад, «з карою випадковістю», випадковий крок проводять тільки тоді, коли попередній крок був невдалим, і таке інше.

Наприклад, якщо в регулярному градієнтному алгоритмі

величину зробити випадковою, то також отримаємо алгоритм випадкового пошуку:

(2.46)

Тут

- реалізація випадкової величини

Треба підкреслити, що випадковий крок, який не залежить від абсолютного значення градієнта функції чи самої функції, допомагає оминути хоча б деякі неглибокі локальні екстремуми функції.

Использование деловой графики для визуализации текстовой информации

Использование деловой графики для визуализации текстовой информации Анализ бизнес-процессов средствами BPwin

Анализ бизнес-процессов средствами BPwin Delphi – язык программирования

Delphi – язык программирования Corel draw бағдарламасымен жұмыс

Corel draw бағдарламасымен жұмыс Презентация Инновационные подходы в образовании

Презентация Инновационные подходы в образовании ГИС технологии в современной картографии

ГИС технологии в современной картографии Линейные и разветвленные алгоритмы. (Лекция 6)

Линейные и разветвленные алгоритмы. (Лекция 6) Презентация к уроку Словесное описание модели

Презентация к уроку Словесное описание модели Защита информации

Защита информации Информатика. Основные понятия информатики (часть 1)

Информатика. Основные понятия информатики (часть 1) Спеціалізовані мови програмування Python

Спеціалізовані мови програмування Python Информационные системы

Информационные системы Основы алгоритмизации и быстрое введение в язык Си

Основы алгоритмизации и быстрое введение в язык Си Библиотека STL. Классы string, vector

Библиотека STL. Классы string, vector Організація та управління базами даних. Зовнішній рівень проектування

Організація та управління базами даних. Зовнішній рівень проектування Понятие как форма мышления

Понятие как форма мышления Язык программирования C#

Язык программирования C# Кодирование информации. Особенности кодирования различных видов информации: текстовой, графической, звуковой

Кодирование информации. Особенности кодирования различных видов информации: текстовой, графической, звуковой Общественное мнение о журналистском сообществе

Общественное мнение о журналистском сообществе Майнкрафт. Викторина

Майнкрафт. Викторина Автоматизация кофейни

Автоматизация кофейни Задачи классификации и регрессии. Технологии обработки данных

Задачи классификации и регрессии. Технологии обработки данных понятие подпрограмм. Механизм реализации подпрограмм с помощью процедур и функций

понятие подпрограмм. Механизм реализации подпрограмм с помощью процедур и функций Книги PascalABC.NET. Современное программирование

Книги PascalABC.NET. Современное программирование Основы связей с общественностью: СМИ, социальные сети

Основы связей с общественностью: СМИ, социальные сети История развития языка программирования С++

История развития языка программирования С++ Контент ВКонтакте для видеокурса ВКонтакте для партнеров

Контент ВКонтакте для видеокурса ВКонтакте для партнеров Состояние и перспективы развития информационных технологий в Республике Беларусь

Состояние и перспективы развития информационных технологий в Республике Беларусь