Содержание

- 2. Тестовое задание 1. Какая связь между понятием сообщение, информация, сигнал? 2. Дайте определение информационной системы. Приведите

- 3. Что понимается под источником сообщений?

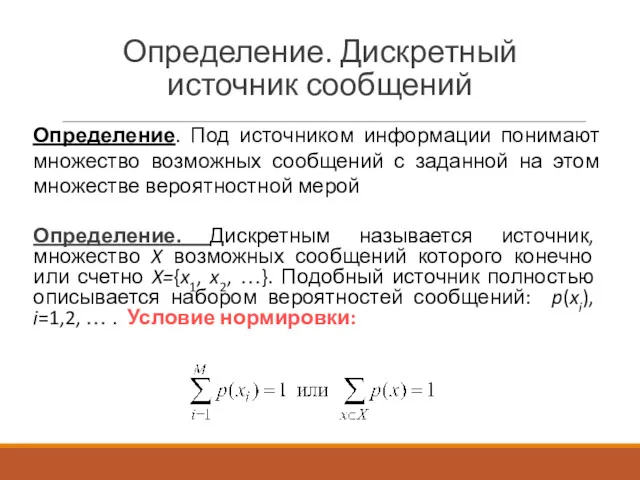

- 4. Определение. Дискретный источник сообщений Определение. Дискретным называется источник, множество X возможных сообщений которого конечно или счетно

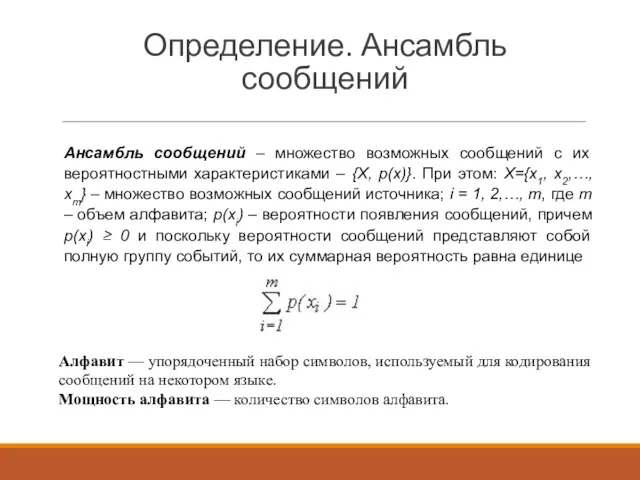

- 5. Определение. Ансамбль сообщений Ансамбль сообщений – множество возможных сообщений с их вероятностными характеристиками – {Х, р(х)}.

- 6. Что такое количество информации?

- 7. Количество информации. Определение Количество информации, I(X) - числовая величина, адекватно характеризующая актуализируемую информацию по разнообразию, сложности,

- 8. Количество информации. Определение Количество информации – мера неопределённости, «снятой»/устраненной при получении сообщения. По Хартли, для того,

- 9. Свойства количества информации 1. Количество информации в сообщении обратно – пропорционально вероятности появления данного сообщения. 2.

- 10. Мотивирующий пример (1) Как измерить количество информации, которое может быть передано при помощи такого алфавита при

- 11. Мотивирующий пример (2) Почему эта величина нас не устраивает: 1. При наличии алфавита, состоящего из одного

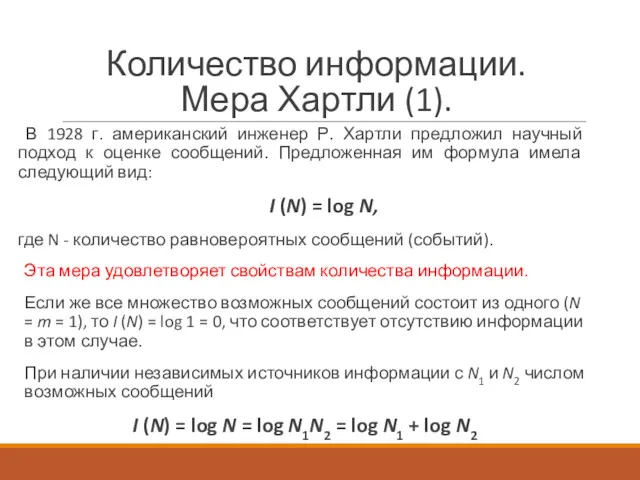

- 12. Количество информации. Мера Хартли (1). В 1928 г. американский инженер Р. Хартли предложил научный подход к

- 13. Количество информации. Мера Хартли (2). Если возможность появления любого символа алфавита равновероятна, то эта вероятность р

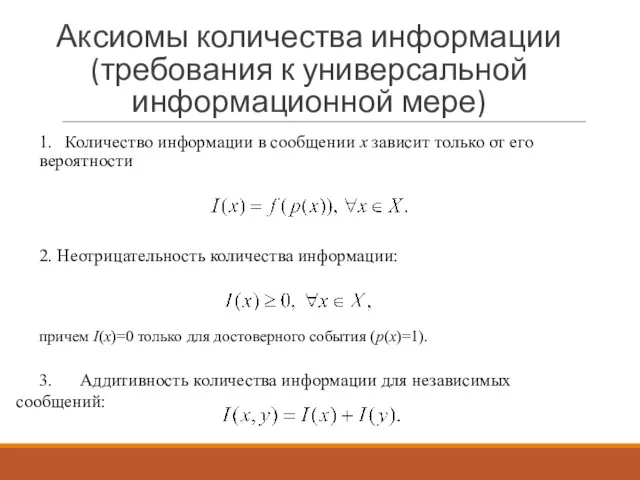

- 14. Аксиомы количества информации (требования к универсальной информационной мере) 1. Количество информации в сообщении x зависит только

- 15. В каких единицах измеряется информация?

- 16. Единицы измерения информации (1) В простейшем случае, когда m=2 I = – log2 p = –

- 17. Единицы измерения информации (2) В зависимости от основания логарифма используют следующие единицы информации: 2 – [бит]

- 18. Недостатки меры Хартли Формула Хартли позволяет определить количество информации в сообщении только для случая, когда появление

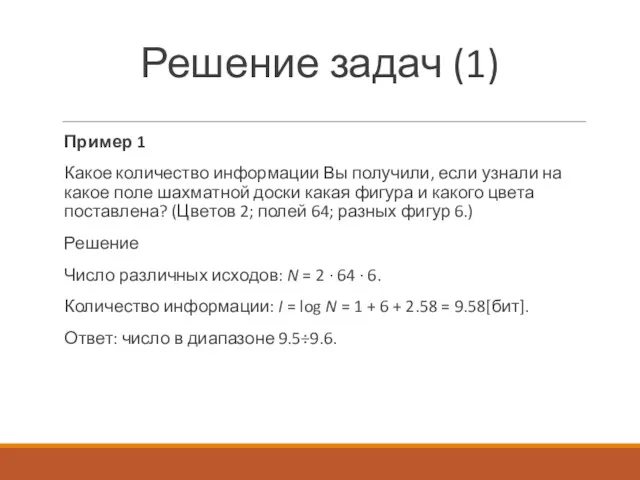

- 19. Решение задач (1) Пример 1 Какое количество информации Вы получили, если узнали на какое поле шахматной

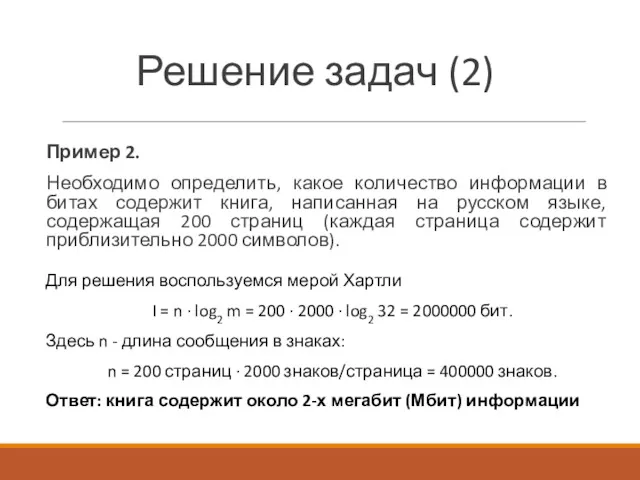

- 20. Решение задач (2) Пример 2. Необходимо определить, какое количество информации в битах содержит книга, написанная на

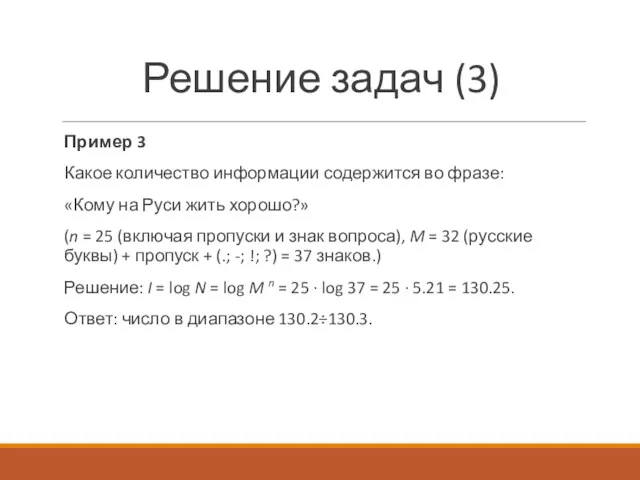

- 21. Решение задач (3) Пример 3 Какое количество информации содержится во фразе: «Кому на Руси жить хорошо?»

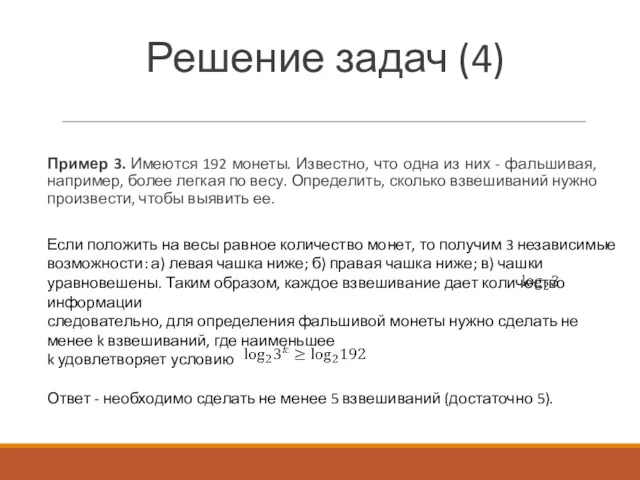

- 22. Решение задач (4) Пример 3. Имеются 192 монеты. Известно, что одна из них - фальшивая, например,

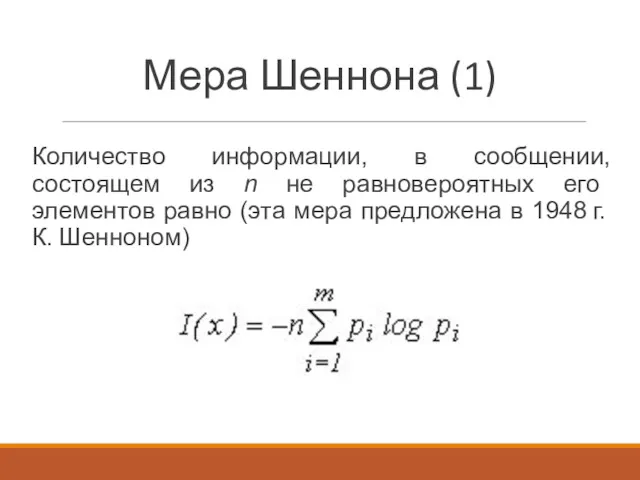

- 23. Мера Шеннона (1) Количество информации, в сообщении, состоящем из n не равновероятных его элементов равно (эта

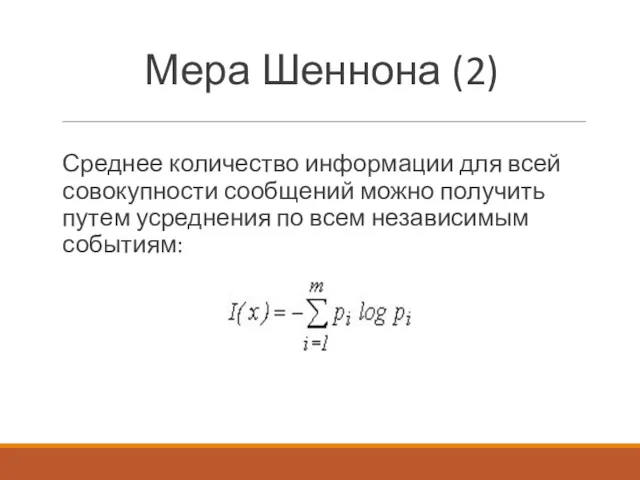

- 24. Мера Шеннона (2) Среднее количество информации для всей совокупности сообщений можно получить путем усреднения по всем

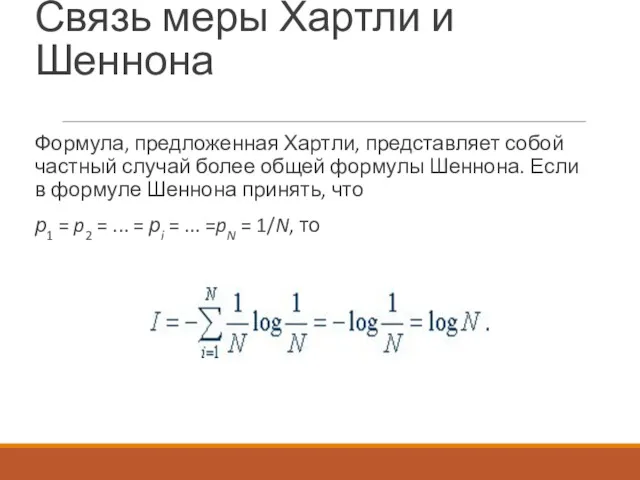

- 25. Связь меры Хартли и Шеннона Формула, предложенная Хартли, представляет собой частный случай более общей формулы Шеннона.

- 26. Недостатки меры Шеннона Не всегда представляется возможным заранее установить перечень всех состояний системы и вычислить их

- 27. Возможно ли измерить неопределенность?

- 28. Понятие энтропии (1) Впервые, сущность энтропии и ее меру открыл в 1871 году великий физик Людвиг

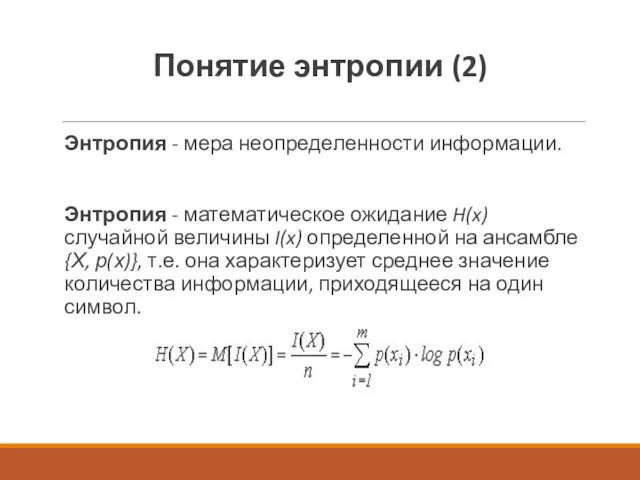

- 29. Понятие энтропии (2) Энтропия - мера неопределенности информации. Энтропия - математическое ожидание H(x) случайной величины I(x)

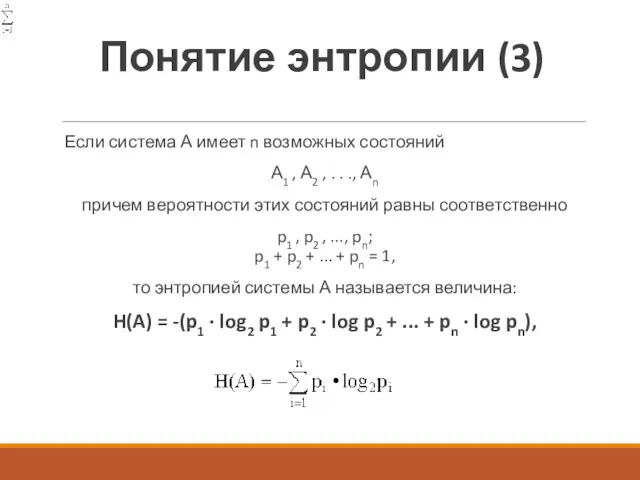

- 30. Понятие энтропии (3) Если система А имеет n возможных состояний А1 , А2 , . .

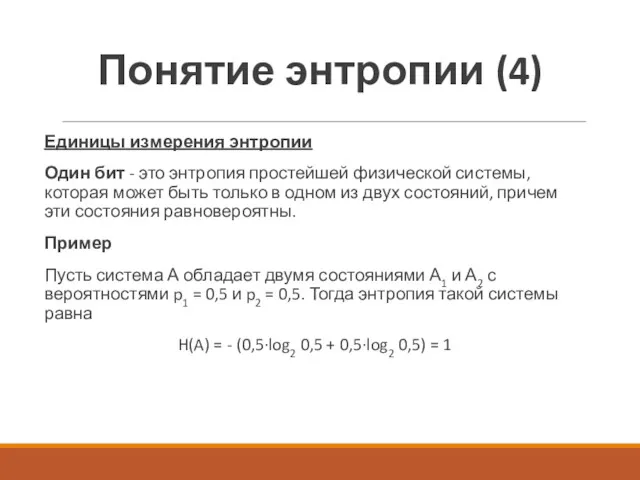

- 31. Понятие энтропии (4) Единицы измерения энтропии Один бит - это энтропия простейшей физической системы, которая может

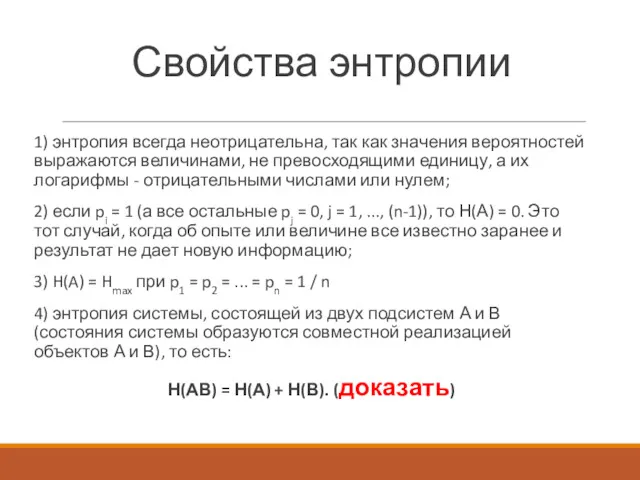

- 32. Свойства энтропии 1) энтропия всегда неотрицательна, так как значения вероятностей выражаются величинами, не превосходящими единицу, а

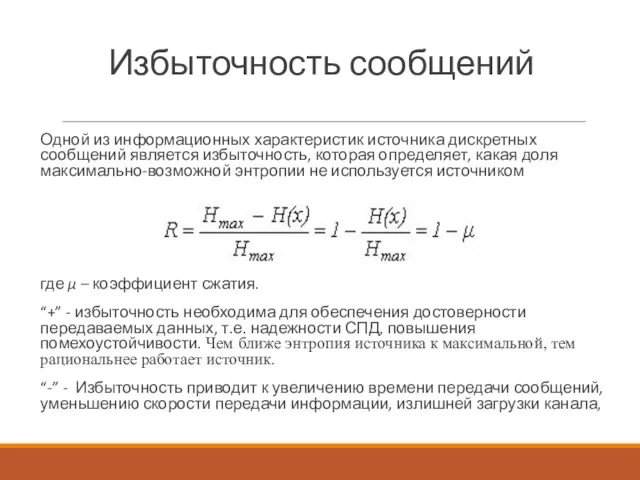

- 33. Избыточность сообщений Одной из информационных характеристик источника дискретных сообщений является избыточность, которая определяет, какая доля максимально-возможной

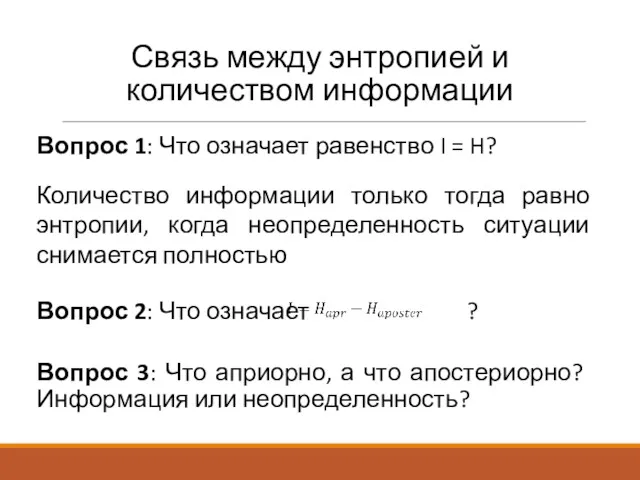

- 34. Связь между энтропией и количеством информации Вопрос 1: Что означает равенство I = H? Количество информации

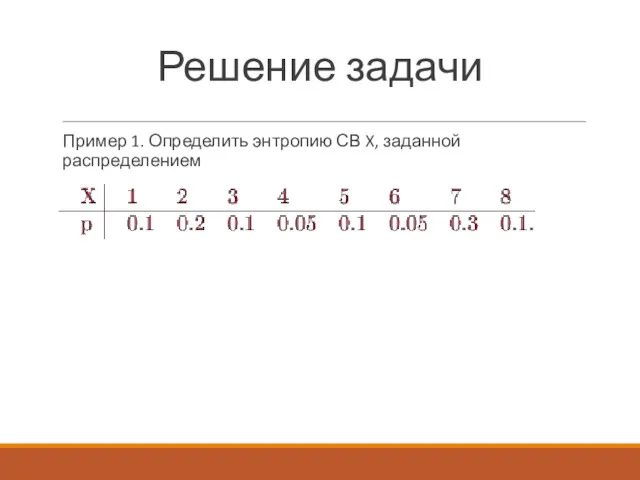

- 35. Решение задачи Пример 1. Определить энтропию СВ X, заданной распределением

- 37. Скачать презентацию

Презентация по информатике

Презентация по информатике Короткий текст. Структура новости

Короткий текст. Структура новости Приложение Delphi , его интерфейс, задачи визуального объектно-ориентированного программирования

Приложение Delphi , его интерфейс, задачи визуального объектно-ориентированного программирования Информационные революции. Информационное общество. Лекция 2

Информационные революции. Информационное общество. Лекция 2 Введение в Python

Введение в Python Структура и основные виды обеспечения САПР

Структура и основные виды обеспечения САПР Компьютерные вирусы и защита от них

Компьютерные вирусы и защита от них Цифрові моделі рельєфу

Цифрові моделі рельєфу Поиск информации в сети интернет

Поиск информации в сети интернет Информационные ресурсы

Информационные ресурсы Глобальная сеть Internet. Поиск информации

Глобальная сеть Internet. Поиск информации Genome assembly with SPAdes

Genome assembly with SPAdes Учебно-методическое пособие по теме Алгоритм для 3 классов

Учебно-методическое пособие по теме Алгоритм для 3 классов Мәтіндік құжаттарға графикалық кескінді кірістіру

Мәтіндік құжаттарға графикалық кескінді кірістіру Unix/Linux операциялық жүйелері

Unix/Linux операциялық жүйелері Знакомство со средой Python. Знакомство с IDLE

Знакомство со средой Python. Знакомство с IDLE Düzülen programmalary işe goýbermek we ýalňyşlyklary dogrulamak

Düzülen programmalary işe goýbermek we ýalňyşlyklary dogrulamak Графи. Частина 2

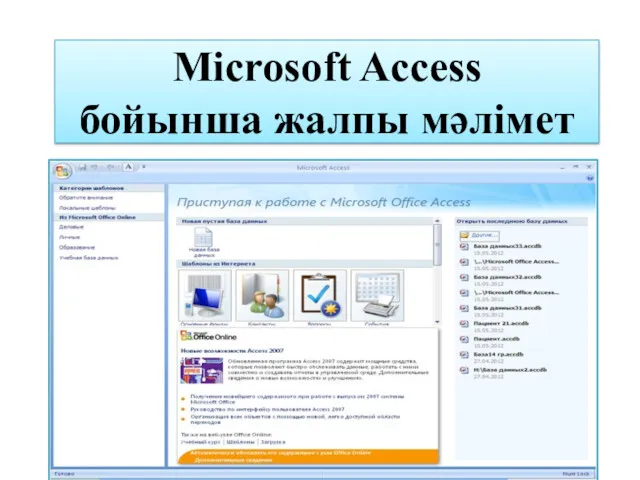

Графи. Частина 2 Microsoft Access бойынша жалпы мәлімет

Microsoft Access бойынша жалпы мәлімет Презентация к уроку Основные компоненты компьютера и их функции

Презентация к уроку Основные компоненты компьютера и их функции Правила безпечної роботи в Інтернеті

Правила безпечної роботи в Інтернеті Оператор ветвления в Паскале

Оператор ветвления в Паскале Основы информационной безопасности. Угрозы АС. (Тема 1.2)

Основы информационной безопасности. Угрозы АС. (Тема 1.2) Циклы

Циклы Программное обеспечение

Программное обеспечение Объекты и их имена

Объекты и их имена Есептеу техникасының даму тарихы

Есептеу техникасының даму тарихы Программирование на языке Python. 9 класс. Повторение

Программирование на языке Python. 9 класс. Повторение