Содержание

- 2. ПОЧЕМУ Я Лауреат премии while true года; Темный властелин бинарных мамок; Занесен в книгу рекордов Гиннеса

- 3. НАШ МАЛЕНЬКИЙ ROADMAP Немного истории; Основы машинного обучения; Нейросети; Deep learning; Вопросы – ответы. Присаживайтесь поудобнее

- 4. ВЕХИ Машина Паскаля 1642г. Артур Самуэль, создает первую шашечную программу для IBM 701 1952г. Deuz Ex

- 5. ВЕХИ 1936 AT&T Bell Labs создает синтезатор речи; 1958 Фрэнк Розенблатт (Frank Rosenblatt) придумал Персептрон —

- 6. ОСНОВНЫЕ ТЕРМИНЫ Основные понятия и обозначения: Данные о задачах обучения по прецедентам; Модели алгоритмов и методы

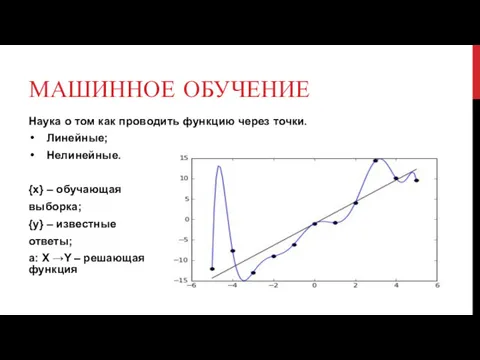

- 7. МАШИННОЕ ОБУЧЕНИЕ Наука о том как проводить функцию через точки. Линейные; Нелинейные. {х} – обучающая выборка;

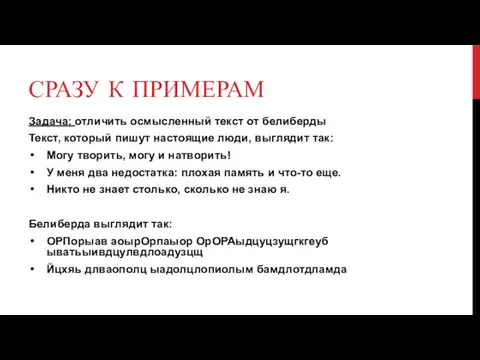

- 8. СРАЗУ К ПРИМЕРАМ Задача: отличить осмысленный текст от белиберды Текст, который пишут настоящие люди, выглядит так:

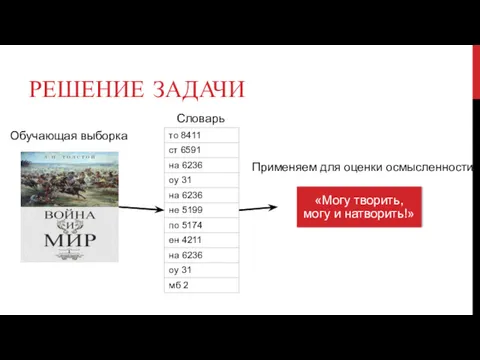

- 9. РЕШЕНИЕ ЗАДАЧИ Обучающая выборка Словарь Применяем для оценки осмысленности

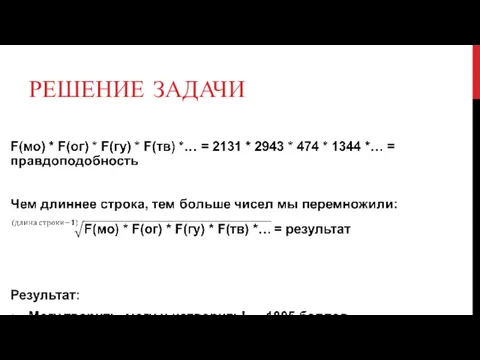

- 10. РЕШЕНИЕ ЗАДАЧИ

- 11. ОБУЧЕНИЕ И МОДЕЛЬ Обучающая выборка: Правильные и неправильные результаты; Подбор частотность выборки; Задача обучения сводится к

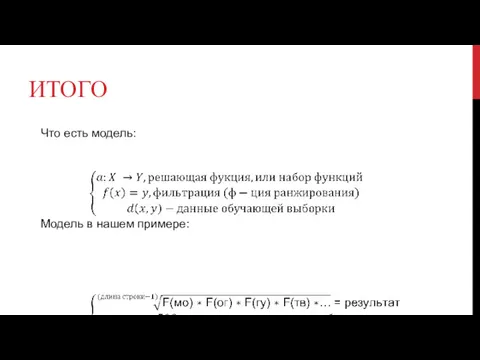

- 12. ИТОГО Что есть модель: Модель в нашем примере:

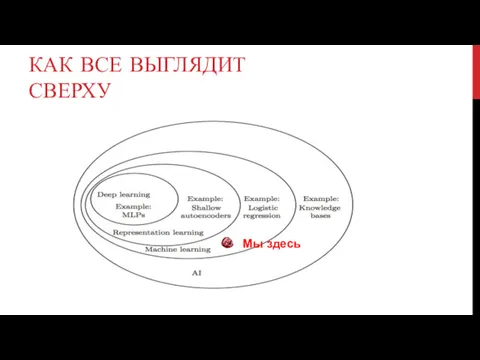

- 13. КАК ВСЕ ВЫГЛЯДИТ СВЕРХУ Мы здесь

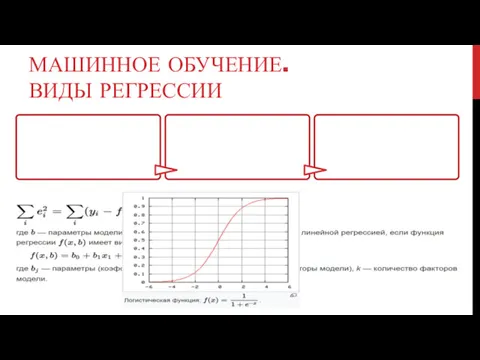

- 14. МАШИННОЕ ОБУЧЕНИЕ. ВИДЫ РЕГРЕССИИ

- 15. КАК РАБОТАЮТ НЕЙРОННЫЕ СЕТИ Нейронные сети обучаются. Самые популярные: Метод обратного распространения (Backpropagation) Метод упругого распространения

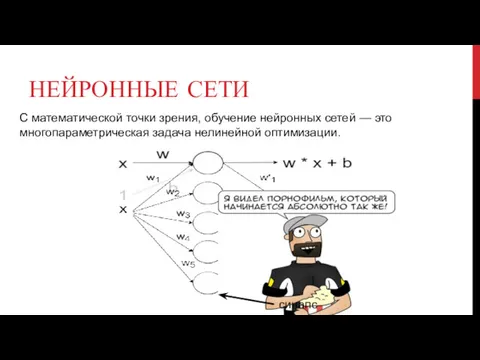

- 16. НЕЙРОННЫЕ СЕТИ С математической точки зрения, обучение нейронных сетей — это многопараметрическая задача нелинейной оптимизации. синапс

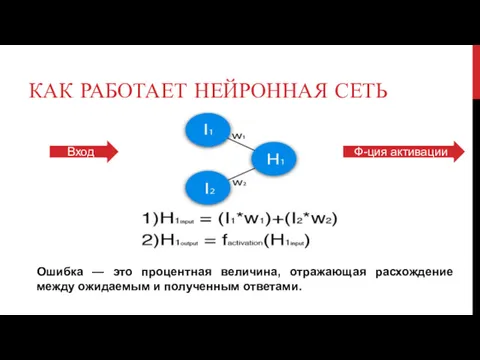

- 17. КАК РАБОТАЕТ НЕЙРОННАЯ СЕТЬ Вход Ф-ция активации Ошибка — это процентная величина, отражающая расхождение между ожидаемым

- 18. ФУНКЦИЯ АКТИВАЦИИ

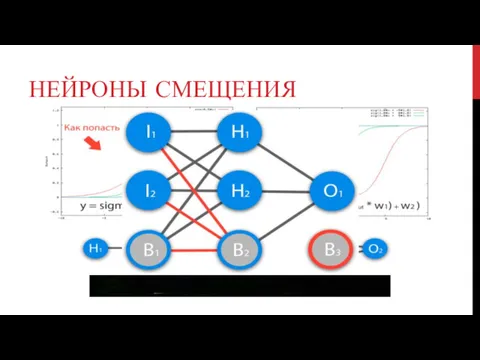

- 19. НЕЙРОНЫ СМЕЩЕНИЯ

- 20. ГРАДИЕНТНЫЙ СПУСК Способ нахождения локального минимума или максимума функции с помощью движения вдоль градиента. Градиент —

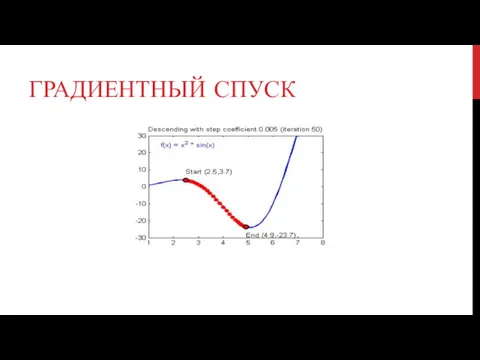

- 21. ГРАДИЕНТНЫЙ СПУСК

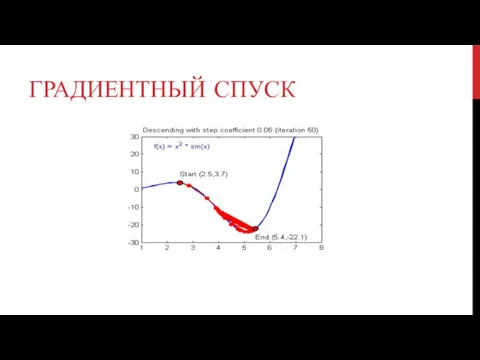

- 22. ГРАДИЕНТНЫЙ СПУСК

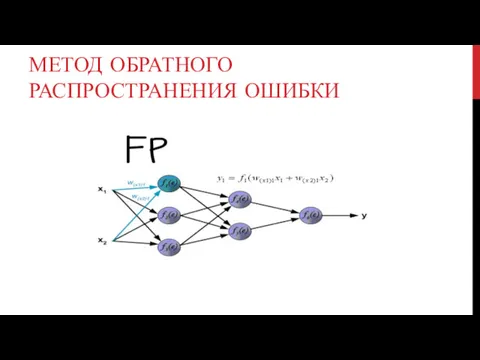

- 23. МЕТОД ОБРАТНОГО РАСПРОСТРАНЕНИЯ ОШИБКИ

- 24. ИТОГО Считаем выход нейронной сети; Вычисляем ошибку; Считаем обратный ход – улучшаем результат, минимизируем ошибку; Что

- 25. СОБСАНО ЭТО ПРЕЛЮДИЯ Что мы знаем: Машинное обучение – наука о том как проводить функцию через

- 26. ГОЛУБИННОЕ ОБУЧЕНИЕ «В 1997 году Deep Blue обыграл в шахматы Каспарова. В 2011 Watson обставил чемпионов

- 27. РАСПОЗНОВАНИЕ

- 28. КОТИКИ БЫВАЮТ РАЗНЫЕ

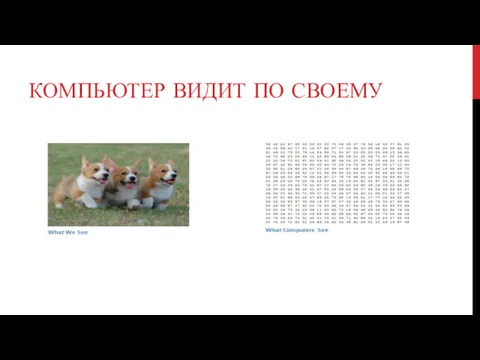

- 29. КОМПЬЮТЕР ВИДИТ ПО СВОЕМУ

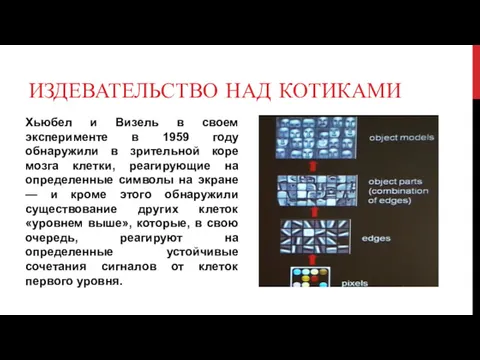

- 30. ИЗДЕВАТЕЛЬСТВО НАД КОТИКАМИ Хьюбел и Визель в своем эксперименте в 1959 году обнаружили в зрительной коре

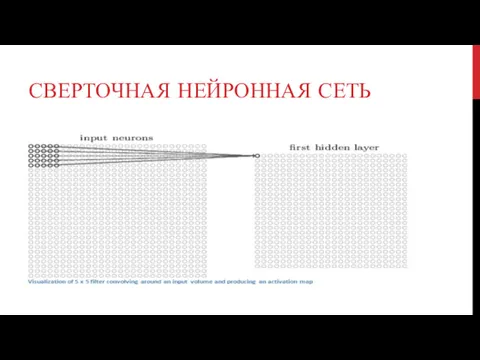

- 31. СВЕРТОЧНАЯ НЕЙРОННАЯ СЕТЬ

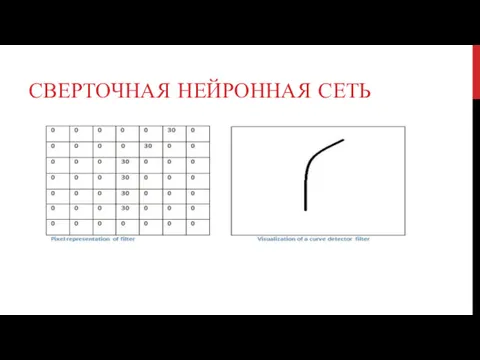

- 32. СВЕРТОЧНАЯ НЕЙРОННАЯ СЕТЬ

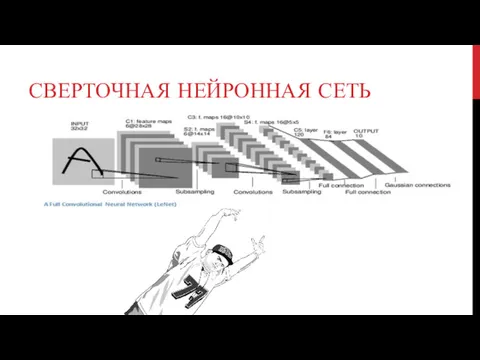

- 33. СВЕРТОЧНАЯ НЕЙРОННАЯ СЕТЬ

- 34. СВЕРТОЧНАЯ НЕЙРОННАЯ СЕТЬ

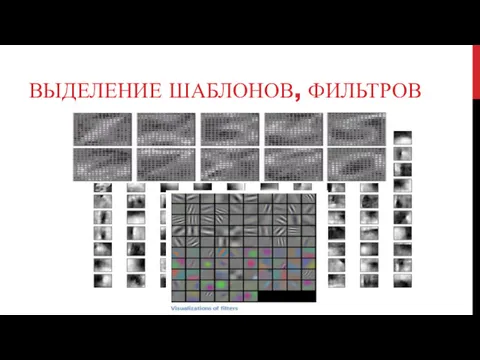

- 35. ВЫДЕЛЕНИЕ ШАБЛОНОВ, ФИЛЬТРОВ

- 36. ИГОГО Машинное обучение – чуть моложе коня Буденного; Машинное обучение – не применяется сейчас только твоей

- 37. О ЧЕМ БЫ ЕЩЕ ПОПИЗДЕТЬ? Internet of Things Bitcoins, blockchain

- 39. Скачать презентацию

Программирование в MathCAD

Программирование в MathCAD Массивы. Решение задач. Подготовка к ЕГЭ

Массивы. Решение задач. Подготовка к ЕГЭ Комп'ютерні мережі. Програма “Мережне оточення”

Комп'ютерні мережі. Програма “Мережне оточення” Презентации к уроку

Презентации к уроку Как создать группу в ВК в 2022

Как создать группу в ВК в 2022 Работа с Cisco Packet Tracer

Работа с Cisco Packet Tracer Обчислювальні машини XIX сторіччя

Обчислювальні машини XIX сторіччя Трехмерное моделирование в системе компьютерного черчения КОМПАС

Трехмерное моделирование в системе компьютерного черчения КОМПАС Ғаламтормен дұрыс жұмыс жасау – мәдениет

Ғаламтормен дұрыс жұмыс жасау – мәдениет Нетикет. Сетевой этикет

Нетикет. Сетевой этикет Презентация по теме Информация и информационные процессы

Презентация по теме Информация и информационные процессы Оформлення результатів наукової діяльності. (Тема 2. Лекція 1)

Оформлення результатів наукової діяльності. (Тема 2. Лекція 1) Дистанционное обучение

Дистанционное обучение Онлайн-аптека

Онлайн-аптека Электронная почта. Коммуникационные технологии

Электронная почта. Коммуникационные технологии Оценка количества информации

Оценка количества информации Методы и инструменты системы управления знаниями

Методы и инструменты системы управления знаниями Технология OLE

Технология OLE Блочные шифры

Блочные шифры Кодирование информации с помощью знаковых систем. Знаки: форма и значение. Знаковые системы

Кодирование информации с помощью знаковых систем. Знаки: форма и значение. Знаковые системы Основы VBA. (Тема 5)

Основы VBA. (Тема 5) Решение задач с линейными массивами

Решение задач с линейными массивами Язык HTML

Язык HTML Базы данных. Системы управления базами данных

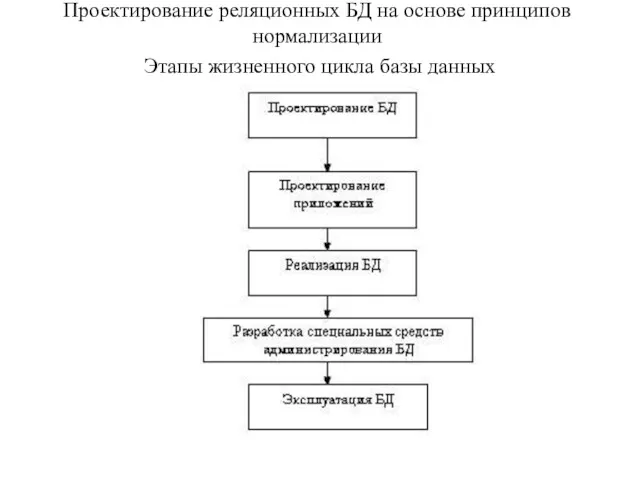

Базы данных. Системы управления базами данных Проектирование реляционных БД на основе принципов нормализации

Проектирование реляционных БД на основе принципов нормализации Algorithms for searching and sorting

Algorithms for searching and sorting Создание игры крестики нолики

Создание игры крестики нолики Интернет вещей. Технология IOT

Интернет вещей. Технология IOT