Содержание

- 2. Существуют различные подходы к измерению количества информации: 1) Алфавитный 2) Содержательный 3) Вероятностный Количество информации –

- 3. 1. АЛФАВИТНЫЙ ПОДХОД Алфавитный подход основан на подсчете числа символов в сообщении и позволяет определить количество

- 4. Основоположником алфавитного подхода измерения информации является великий российский ученый-математик Андрей Николаевич Колмогоров (1903-1987).

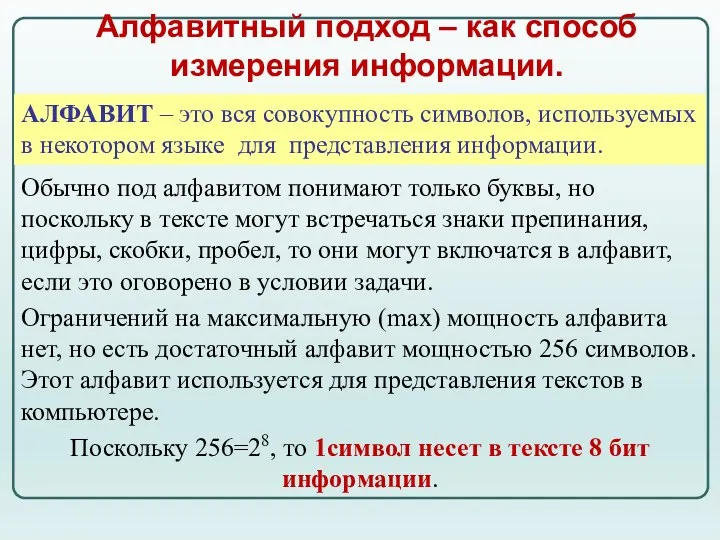

- 5. Обычно под алфавитом понимают только буквы, но поскольку в тексте могут встречаться знаки препинания, цифры, скобки,

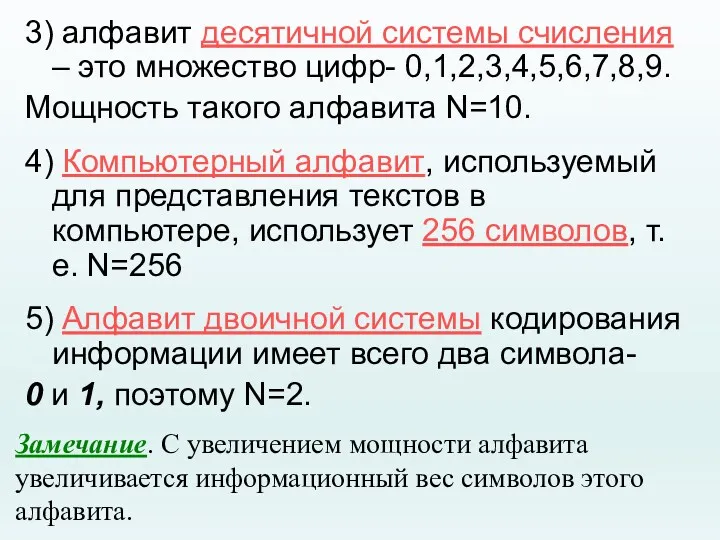

- 6. При алфавитном подходе считается, что каждый символ текста имеет определенный «информационный вес». Информационный вес символа зависит

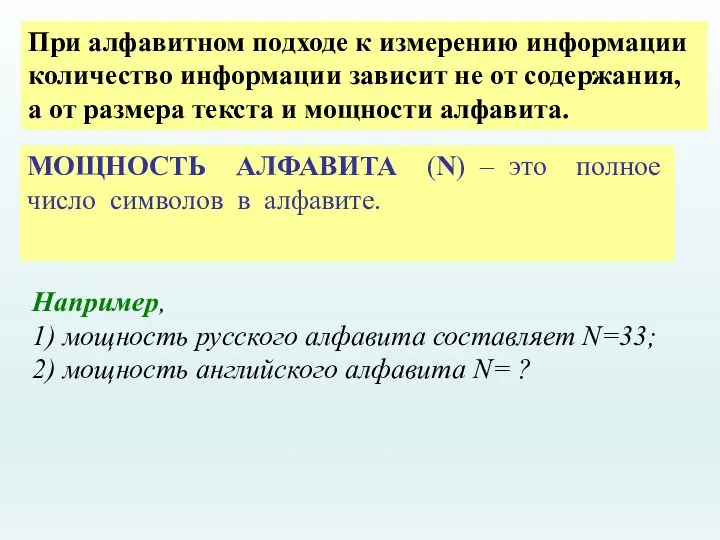

- 7. При алфавитном подходе к измерению информации количество информации зависит не от содержания, а от размера текста

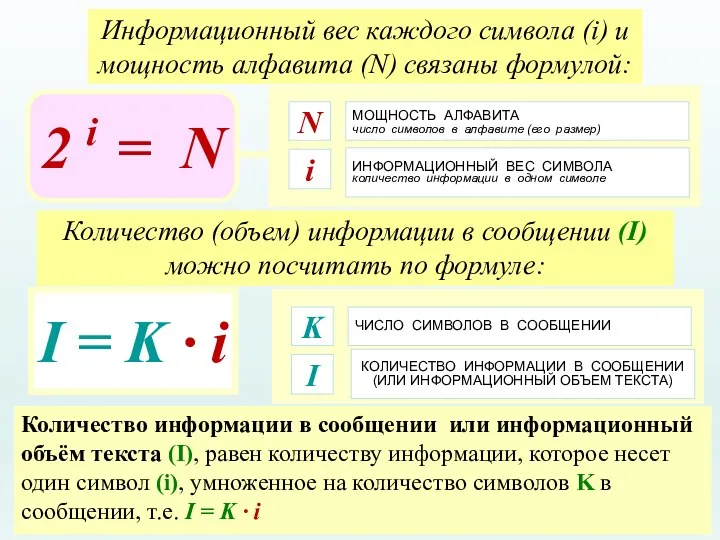

- 8. 3) алфавит десятичной системы счисления – это множество цифр- 0,1,2,3,4,5,6,7,8,9. Мощность такого алфавита N=10. 4) Компьютерный

- 9. МОЩНОСТЬ АЛФАВИТА число символов в алфавите (его размер) N ИНФОРМАЦИОННЫЙ ВЕС СИМВОЛА количество информации в одном

- 10. ЕДИНИЦЫ ИЗМЕРЕНИЯ ИНФОРМАЦИИ СИМВОЛЬНЫЙ АЛФАВИТ КОМПЬЮТЕРА русские (РУССКИЕ) буквы латинские (LAT) буквы цифры (1, 2, 3,

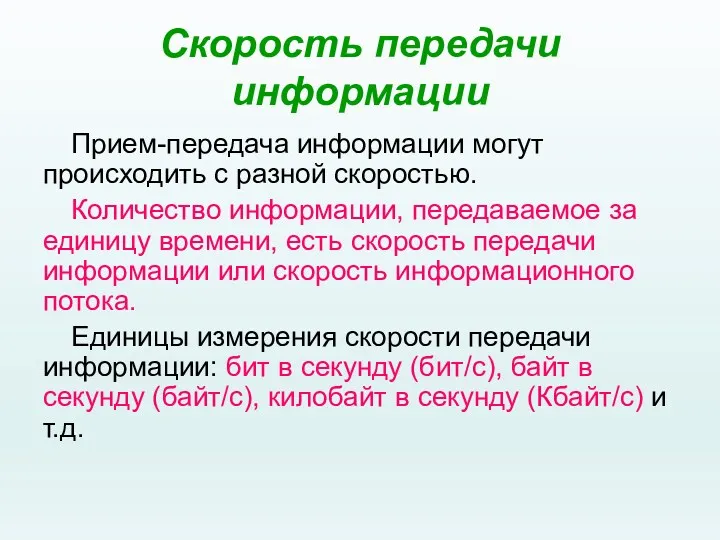

- 11. Скорость передачи информации Прием-передача информации могут происходить с разной скоростью. Количество информации, передаваемое за единицу времени,

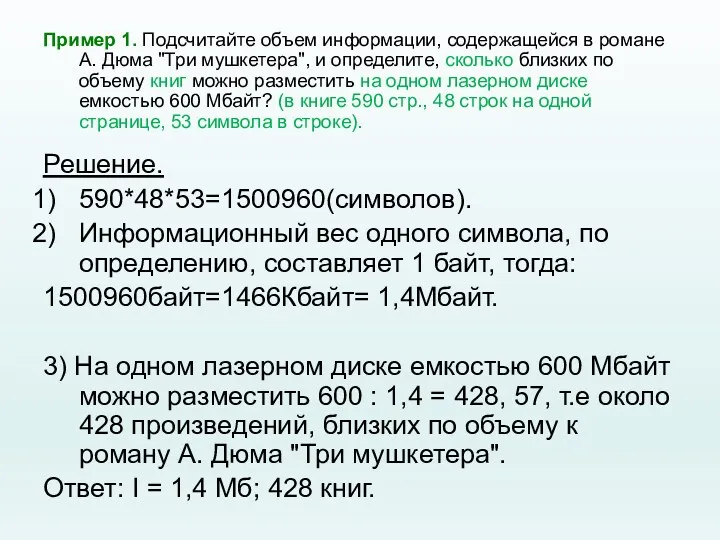

- 12. Пример 1. Подсчитайте объем информации, содержащейся в романе А. Дюма "Три мушкетера", и определите, сколько близких

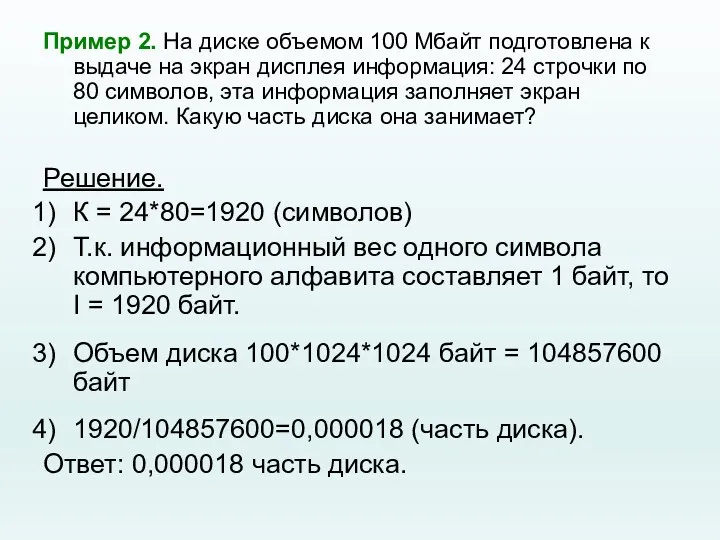

- 13. Пример 2. На диске объемом 100 Мбайт подготовлена к выдаче на экран дисплея информация: 24 строчки

- 14. Домашнее задание. ЗАДАЧА 1 Книга, подготовленная с помощью компьютера, содержит 150 страниц. На каждой странице –

- 15. 2. СОДЕРЖАТЕЛЬНЫЙ ПОДХОД (количество информации зависит от ее содержания) Основоположником этого подхода является американский учёный Клод

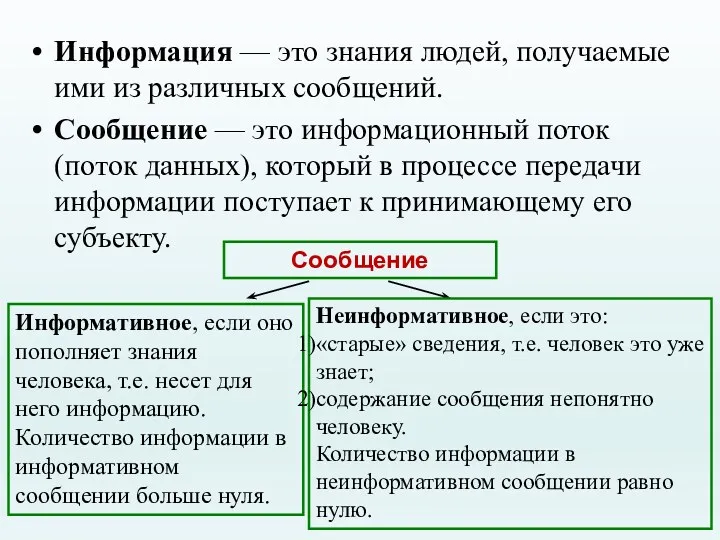

- 16. Информация — это знания людей, получаемые ими из различных сообщений. Сообщение — это информационный поток (поток

- 17. Вероятность некоторого события — это величина, которая может принимать значения от нуля до единицы. Вероятность некоторого

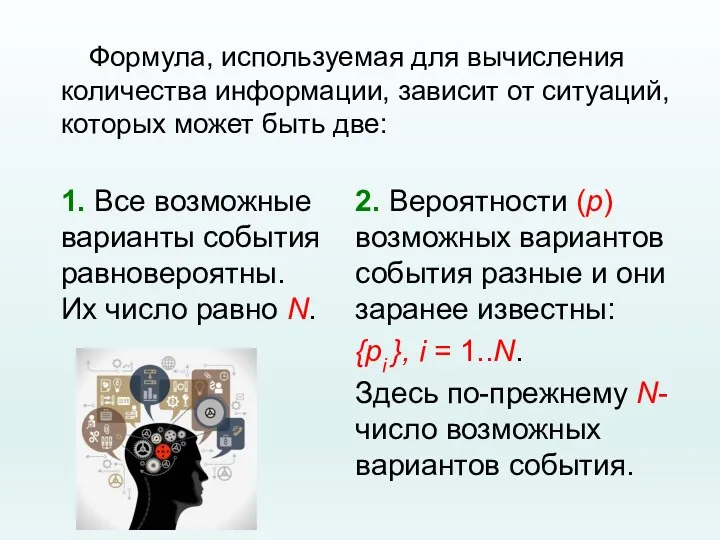

- 18. Формула, используемая для вычисления количества информации, зависит от ситуаций, которых может быть две: 1. Все возможные

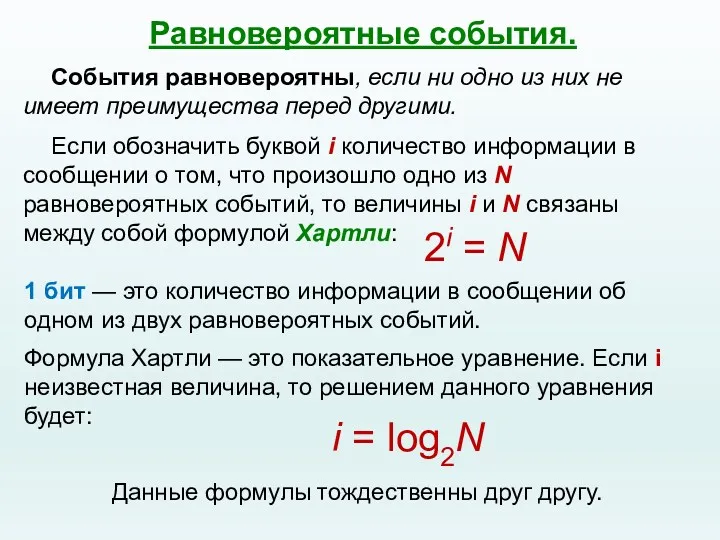

- 19. Равновероятные события. 2i = N 1 бит — это количество информации в сообщении об одном из

- 20. Примеры. Пример 1. Сколько информации содержит сообщение о том, что из колоды карт достали даму пик?

- 21. Пример 2. Сколько информации содержит сообщение о выпадении грани с числом 3 на шестигранном игральном кубике?

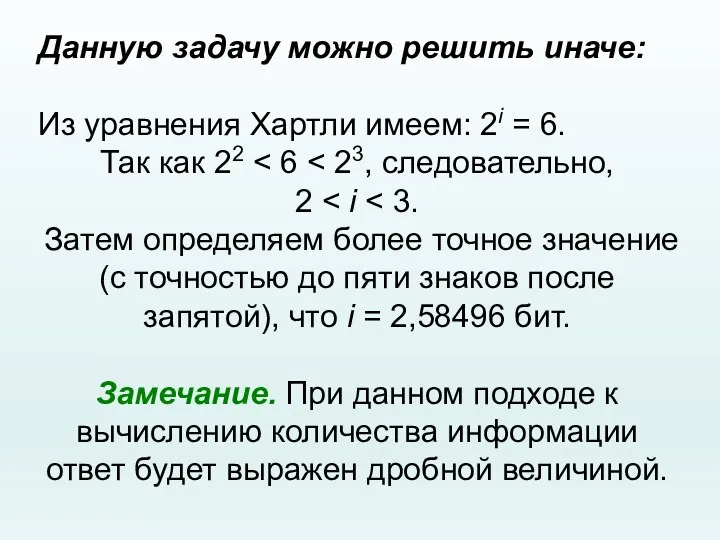

- 22. Данную задачу можно решить иначе: Из уравнения Хартли имеем: 2i = 6. Так как 22 2

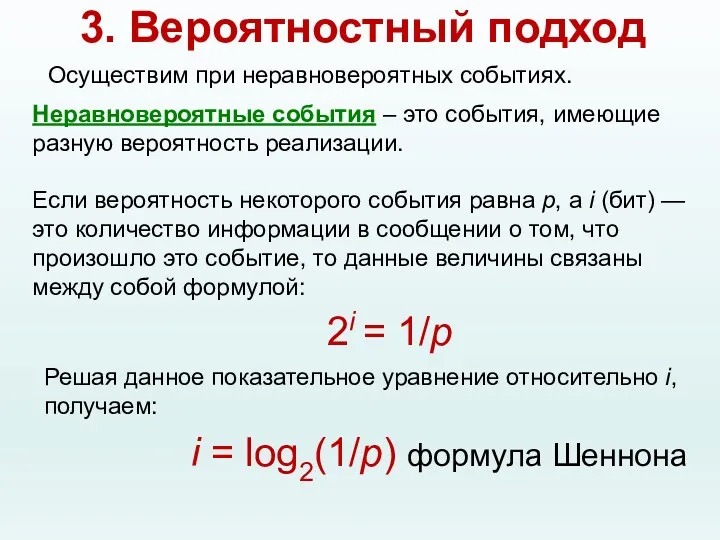

- 23. 2i = 1/p Решая данное показательное уравнение относительно i, получаем: i = log2(1/p) формула Шеннона 3.

- 24. Пример 3. На автобусной остановке останавливаются два маршрута автобусов: № 5 и № 7. Студенту дано

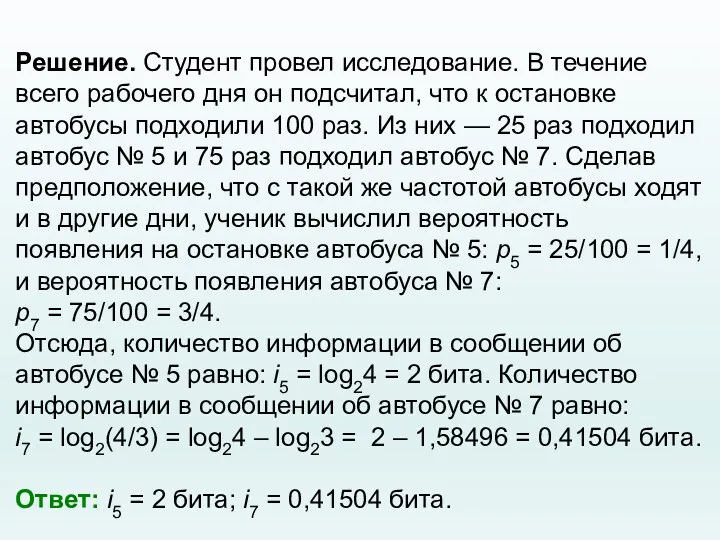

- 25. Решение. Студент провел исследование. В течение всего рабочего дня он подсчитал, что к остановке автобусы подходили

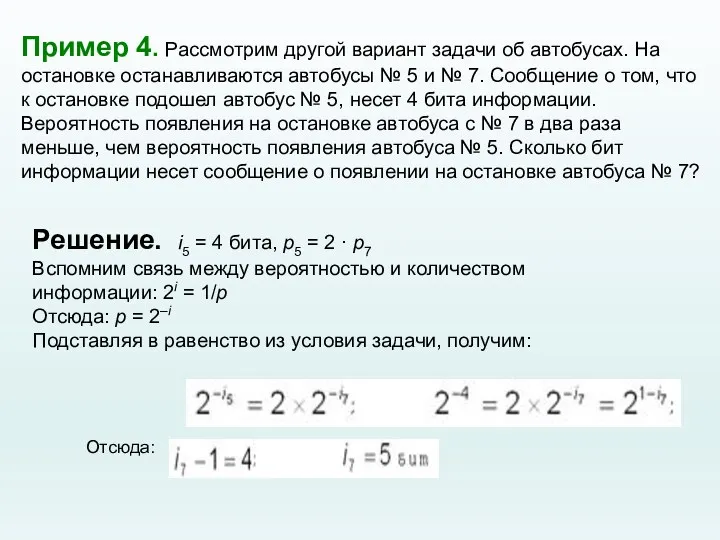

- 26. Пример 4. Рассмотрим другой вариант задачи об автобусах. На остановке останавливаются автобусы № 5 и №

- 27. Вывод: уменьшение вероятности события в 2 раза увеличивает информативность сообщения о нем на 1 бит. Очевидно

- 29. Скачать презентацию

Алгоритмы

Алгоритмы Глобальные сети

Глобальные сети Путешествие в страну Информатика. 8 класс

Путешествие в страну Информатика. 8 класс CISCO CCIE Program

CISCO CCIE Program Моделирование корреляционных зависимостей

Моделирование корреляционных зависимостей Интернет-зависимость

Интернет-зависимость Настройка коммутаторов Cisco

Настройка коммутаторов Cisco Конвергентные и цифровые технологии

Конвергентные и цифровые технологии Деловая графика в электронных таблицах.

Деловая графика в электронных таблицах. Инженерия программного обеспечения. Введение (модуль 1)

Инженерия программного обеспечения. Введение (модуль 1) Мобильные операционные системы

Мобильные операционные системы Рекомендации психолога

Рекомендации психолога Многоуровневые ИВС и эталонная модель взаимосвязи открытых систем. Занятие 05, 06

Многоуровневые ИВС и эталонная модель взаимосвязи открытых систем. Занятие 05, 06 Компьютерные объекты

Компьютерные объекты История развития компьютерной техники. 8 класс

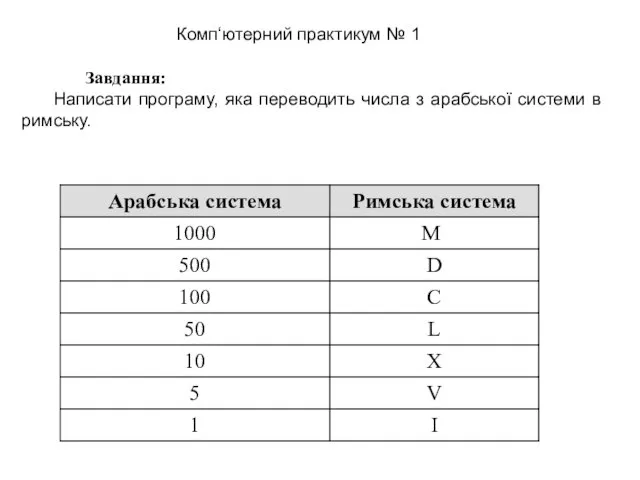

История развития компьютерной техники. 8 класс Завдання: Написати програму, яка переводить числа з арабської системи в римську

Завдання: Написати програму, яка переводить числа з арабської системи в римську OSINT(Open Source Intelligency)

OSINT(Open Source Intelligency) Урок по теме Работа со шрифтами. Форматирование текста. 8 класс.

Урок по теме Работа со шрифтами. Форматирование текста. 8 класс. Регистрация в WealTcom

Регистрация в WealTcom Презентация Перевод чисел между системами счисления, основания которых являются степенями числа 2 10 класс

Презентация Перевод чисел между системами счисления, основания которых являются степенями числа 2 10 класс Информационно-логические основы ЭВМ

Информационно-логические основы ЭВМ Тораптық утелиттердің жұмысын оқып үйрену

Тораптық утелиттердің жұмысын оқып үйрену Безопасность при использовании современных гаджетов

Безопасность при использовании современных гаджетов Тестирование мобильных приложений

Тестирование мобильных приложений Текстові і графічні обʼєкти на слайдах. Урок 30

Текстові і графічні обʼєкти на слайдах. Урок 30 Ақпарат. Компьютер. Компьютер құрылғылары,ақпараттық модель

Ақпарат. Компьютер. Компьютер құрылғылары,ақпараттық модель Первый канал

Первый канал Первоначальные сведения о мониторах

Первоначальные сведения о мониторах