Содержание

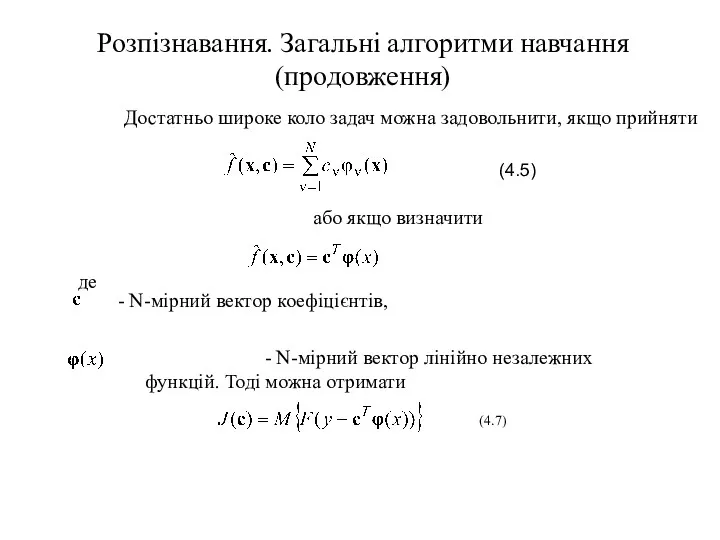

- 2. Розпізнавання. Загальні алгоритми навчання (продовження) Достатньо широке коло задач можна задовольнити, якщо прийняти або якщо визначити

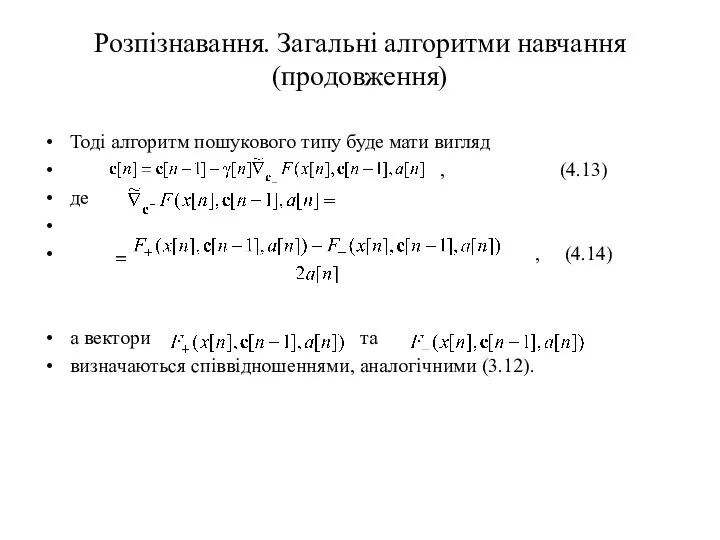

- 3. Розпізнавання. Загальні алгоритми навчання (продовження) Тоді алгоритм пошукового типу буде мати вигляд , (4.13) де ,

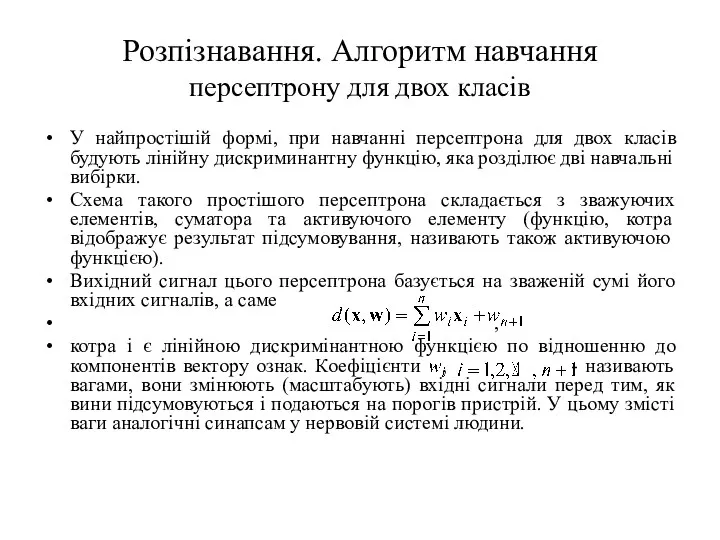

- 4. Розпізнавання. Алгоритм навчання персептрону для двох класів У найпростішій формі, при навчанні персептрона для двох класів

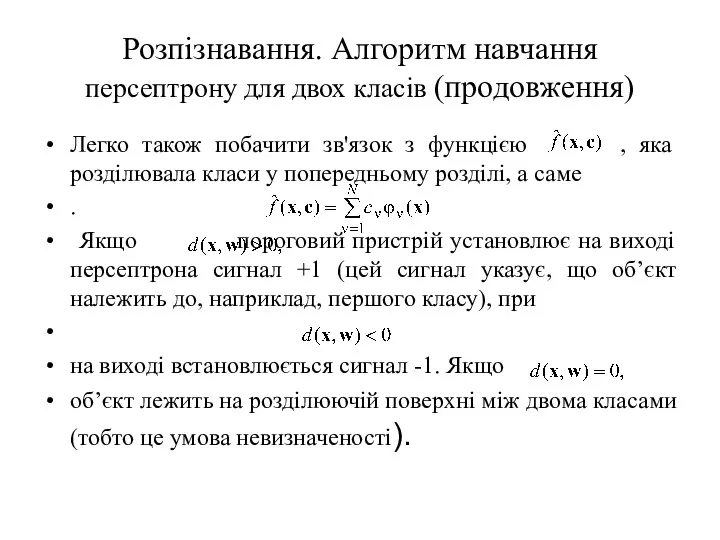

- 5. Розпізнавання. Алгоритм навчання персептрону для двох класів (продовження) Легко також побачити зв'язок з функцією , яка

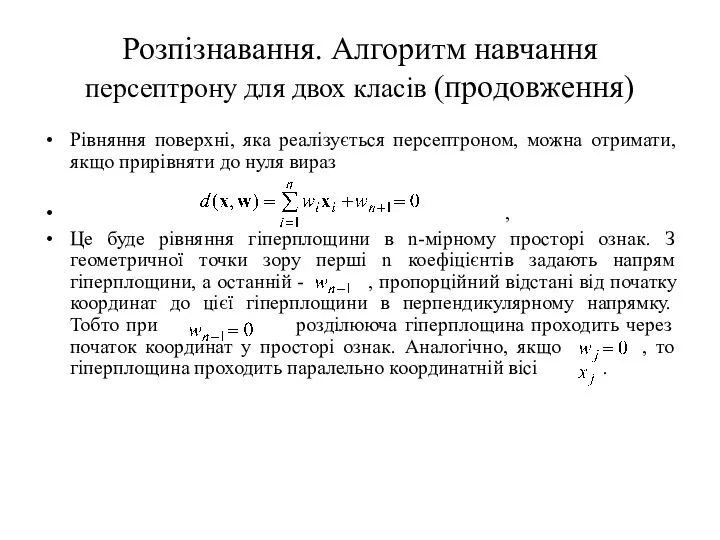

- 6. Розпізнавання. Алгоритм навчання персептрону для двох класів (продовження) Рівняння поверхні, яка реалізується персептроном, можна отримати, якщо

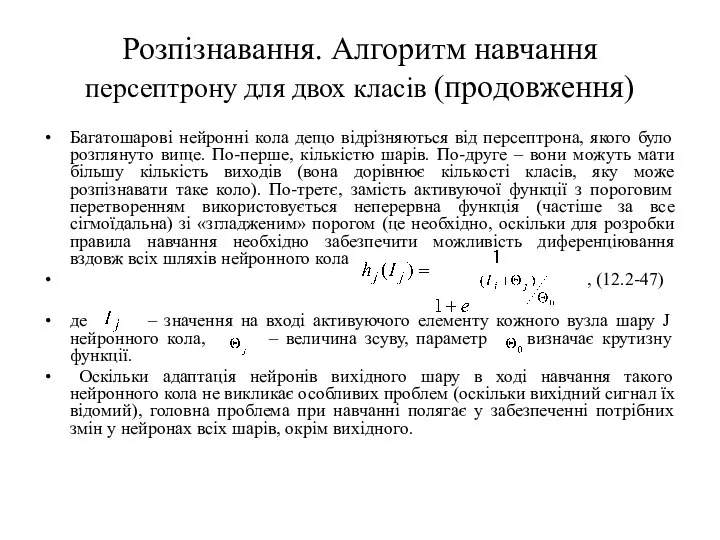

- 7. Розпізнавання. Алгоритм навчання персептрону для двох класів (продовження) Багатошарові нейронні кола дещо відрізняються від персептрона, якого

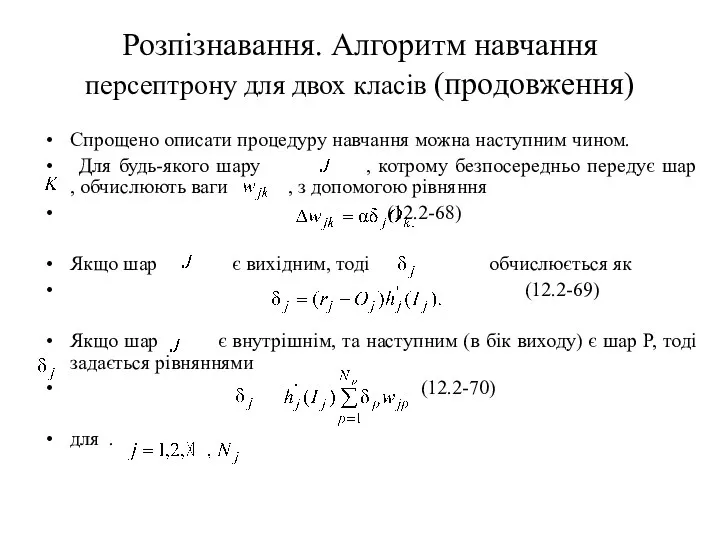

- 8. Розпізнавання. Алгоритм навчання персептрону для двох класів (продовження) Спрощено описати процедуру навчання можна наступним чином. Для

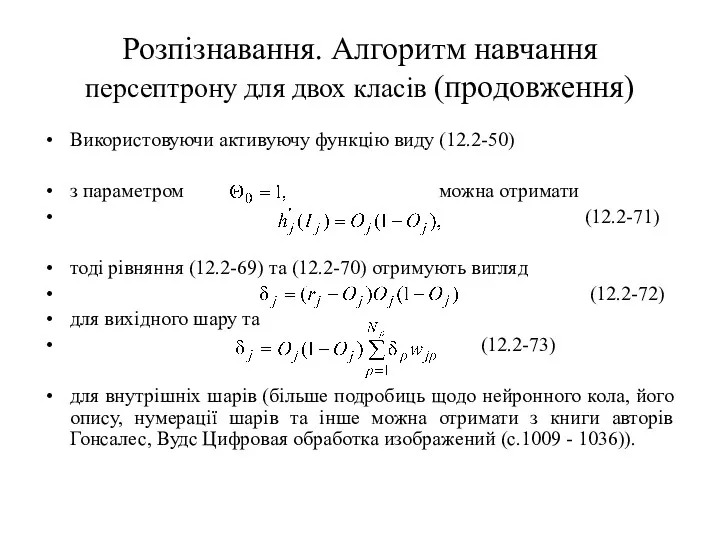

- 9. Розпізнавання. Алгоритм навчання персептрону для двох класів (продовження) Використовуючи активуючу функцію виду (12.2-50) з параметром можна

- 10. Про самонавчання Самонавчання – це навчання без (як спочатку здається) будь-яких натяків ззовні про правильність реакції

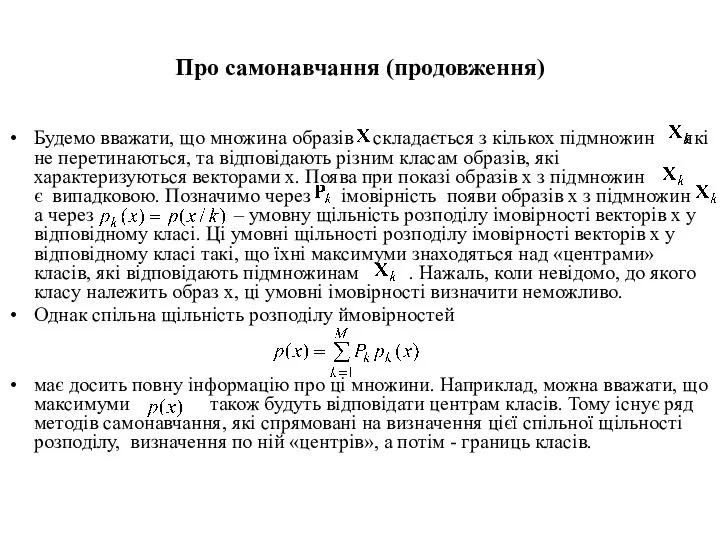

- 11. Про самонавчання (продовження) Будемо вважати, що множина образів складається з кількох підмножин які не перетинаються, та

- 13. Скачать презентацию

Рекламные и шпионские программы и защита от них

Рекламные и шпионские программы и защита от них Монадалар

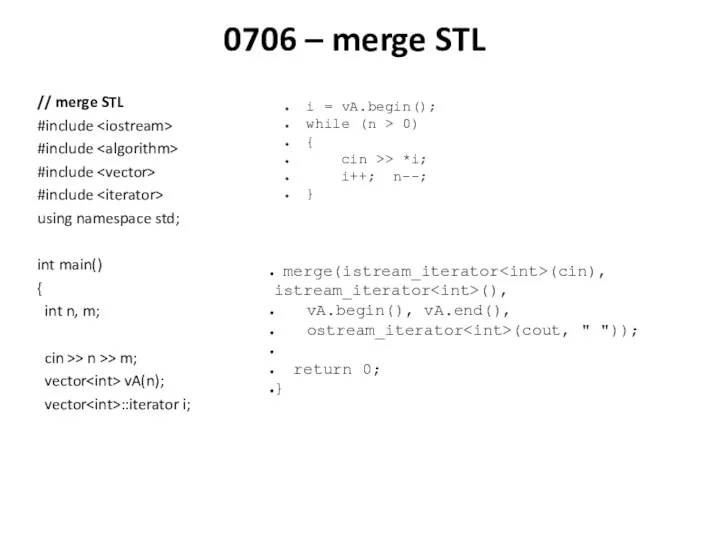

Монадалар STL алгоритмы

STL алгоритмы Нечеткая логика

Нечеткая логика Массивы в Паскале. Одномерные массивы

Массивы в Паскале. Одномерные массивы Технология Drag&Drop

Технология Drag&Drop Представление чисел в компьютере. Прямой, обратный и дополнительный код

Представление чисел в компьютере. Прямой, обратный и дополнительный код UML Unified Mogeling Language

UML Unified Mogeling Language Техническое задание на выполнение 3D - визуализации

Техническое задание на выполнение 3D - визуализации Локальные и глобальные компьютерные сети. Коммуникационные технологии

Локальные и глобальные компьютерные сети. Коммуникационные технологии Космические дали

Космические дали Утилиты и прикладное ПО. Операционные системы. Лекция 6

Утилиты и прикладное ПО. Операционные системы. Лекция 6 Технология обработки графической информации

Технология обработки графической информации Библиография библиографий

Библиография библиографий План построения научной работы

План построения научной работы Блочное описание алгоритмов. Виды алгоритмов

Блочное описание алгоритмов. Виды алгоритмов Технология работы с цифровым видео

Технология работы с цифровым видео Проектирование Баз Данных. Основные понятия Теории Нормализации

Проектирование Баз Данных. Основные понятия Теории Нормализации Установка и настройка CMS. WordPress локально

Установка и настройка CMS. WordPress локально Optimizarea activităţii de prestare a serviciilor de transport prin aplicarea modelelor matematice şi sistemelor informatice

Optimizarea activităţii de prestare a serviciilor de transport prin aplicarea modelelor matematice şi sistemelor informatice Сетевая адресация. Понятие IP-адреса и маски сети. Структура IP-адреса.Типы IP-адресов. Публичные и частные IP-адреса

Сетевая адресация. Понятие IP-адреса и маски сети. Структура IP-адреса.Типы IP-адресов. Публичные и частные IP-адреса Помехи в каналах связи

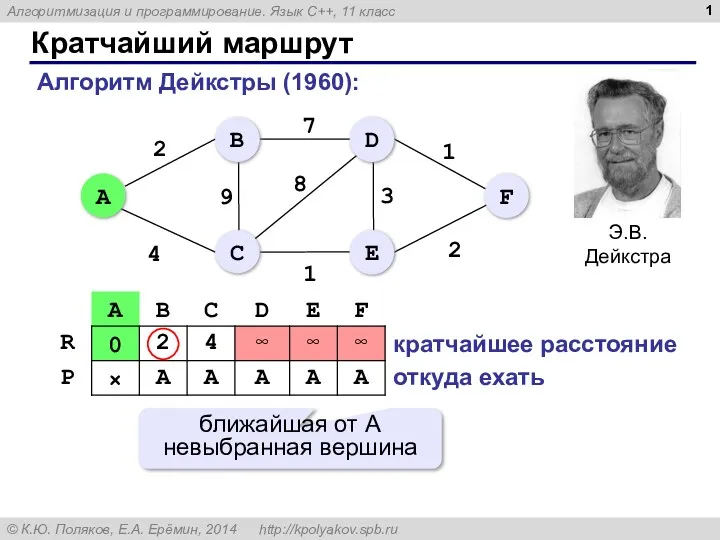

Помехи в каналах связи Кратчайший маршрут. Алгоритмизация и программирование. Язык С++, 11 класс

Кратчайший маршрут. Алгоритмизация и программирование. Язык С++, 11 класс Робототехника. Сборка к занятию №5. Изучение ременной передачи

Робототехника. Сборка к занятию №5. Изучение ременной передачи Cascading Style Sheets. Спецификация CSS

Cascading Style Sheets. Спецификация CSS Контент. Виды контента

Контент. Виды контента Возвращаемое значение функции. Оператор return

Возвращаемое значение функции. Оператор return Сетевой этикет

Сетевой этикет