Сообщения, данные, сигнал, показатели качества информации, формы представления информации презентация

Содержание

- 2. Информация и данные. Количество и качество информации

- 3. Термин «информатика» Термин информатика происходит от французского слова informatique (объединение слов information — «информация» и automatique—

- 4. Распространению термина «информатика» немало способствовал новосибирский учёный А.П. Ершов (с 1970 г. — член-корреспондент, с 1984

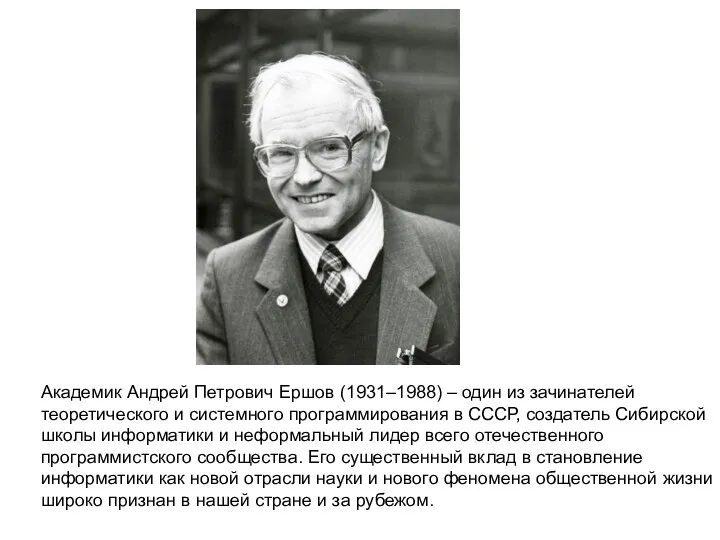

- 5. Академик Андрей Петрович Ершов (1931–1988) – один из зачинателей теоретического и системного программирования в СССР, создатель

- 6. Определения информатики Информатика — это наука и сфера практической деятельности, связанная с различными аспектами получения, хранения,

- 7. «Понятие информатики охватывает области, связанные с разработкой, созданием, использованием и материально-техническим обслуживанием систем обработки информации, включая

- 8. Не существует единственного «правильного» определения информации, но почти каждый человек имеет представление о том, что такое

- 9. Информация и данные Информация (от лат. informātiō — «разъяснение, представление, понятие о ч.-л.», от лат. informare

- 10. Информация и данные Данные — поддающееся многократной интерпретации представление информации в формализованном виде, пригодном для передачи,

- 11. Информация и данные Данные содержат информацию, но не являются самой информацией. По этому поводу часто возникает

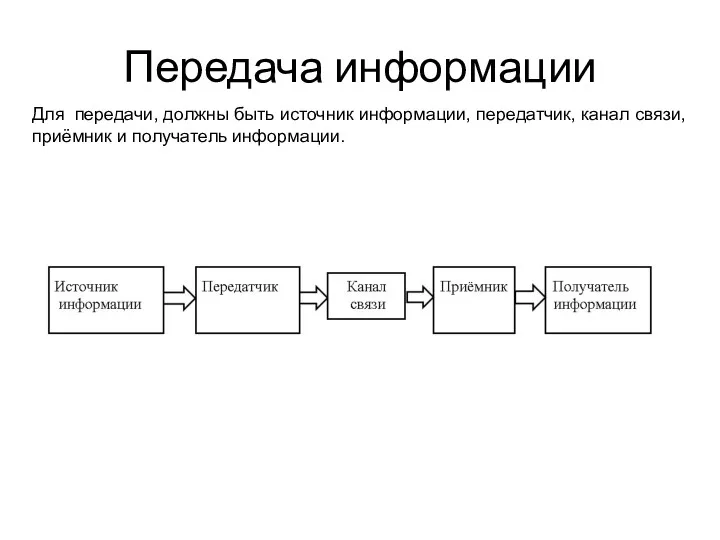

- 12. Передача информации Для передачи, должны быть источник информации, передатчик, канал связи, приёмник и получатель информации.

- 13. Качество информации Качество информации определяется некоторыми ее свойствами, отвечающими потребностям (целям, задачам) пользователей, например, полнота, достоверность,

- 14. Качество информации Доступность информации — это возможность получения информации при необходимости. Доступность складывается из двух составляющих:

- 15. Количество информации Кроме качества для нас важно и количество информации. Для измерения количества информации имеются два

- 16. Количество информации. Вероятностный подход Информацио́нная энтропи́я — мера неопределённости или непредсказуемости информации, неопределённость появления какого-либо символа

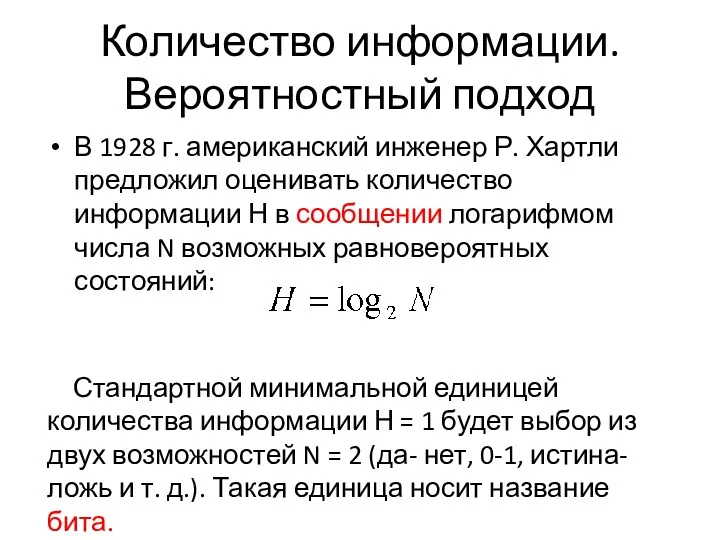

- 17. Количество информации. Вероятностный подход В 1928 г. американский инженер Р. Хартли предложил оценивать количество информации Н

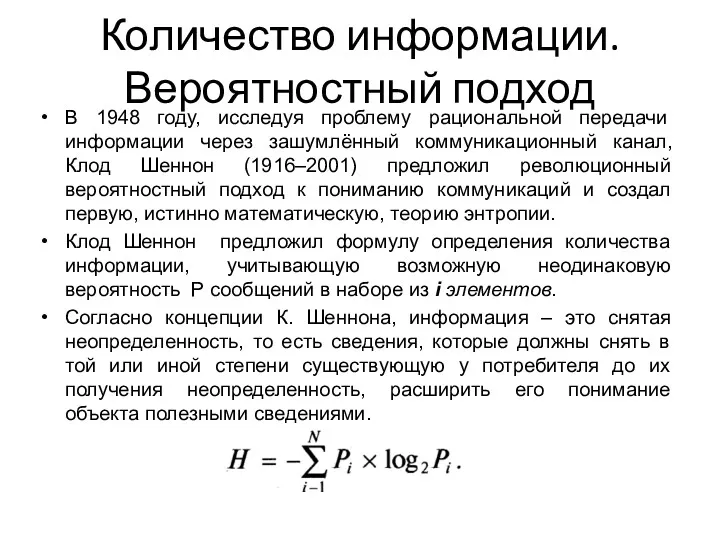

- 18. Количество информации. Вероятностный подход В 1948 году, исследуя проблему рациональной передачи информации через зашумлённый коммуникационный канал,

- 19. Количество информации. Вероятностный подход В качестве примера определим количество информации, связанное с появлением каждого символа в

- 20. Количество информации. Объёмный подход Объемный подход предполагает количественную оценку информации в определенных единицах. За минимальную единицу

- 22. Скачать презентацию

Процессор. Элементы процессора. Устройство управления. Процессор Intel 8086. Команды. Кодирование команд. Подпрограммы

Процессор. Элементы процессора. Устройство управления. Процессор Intel 8086. Команды. Кодирование команд. Подпрограммы Строковый тип данных

Строковый тип данных Кодирование и шифрование данных

Кодирование и шифрование данных Правила заполнения ежемесячной отчетности партнеров по непродленным договорам ИТС

Правила заполнения ежемесячной отчетности партнеров по непродленным договорам ИТС Защита медицинской информации

Защита медицинской информации Анализ качества медицинских публикаций

Анализ качества медицинских публикаций Дерева. Основні поняття та властивості дерев

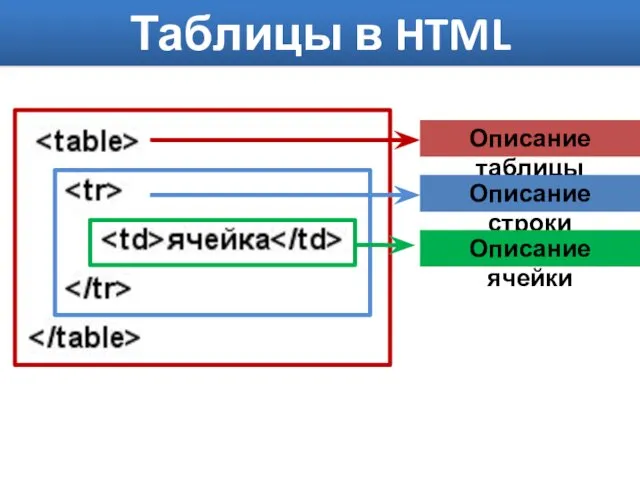

Дерева. Основні поняття та властивості дерев Таблицы в HTML

Таблицы в HTML Презентация Коммуникационные технологии

Презентация Коммуникационные технологии Комплекс по оптимизации аппаратно-программного обеспечения

Комплекс по оптимизации аппаратно-программного обеспечения Разработка проекта локальной вычислительной сети

Разработка проекта локальной вычислительной сети Создатель поисковой системы GOOGLE

Создатель поисковой системы GOOGLE нформационные ресурсы общества Информационные услуги и продукты

нформационные ресурсы общества Информационные услуги и продукты Основные проблемы построения сетей

Основные проблемы построения сетей Разработка системы управления сайтом туристического агентства

Разработка системы управления сайтом туристического агентства Поняття мультимедія. 8 клас

Поняття мультимедія. 8 клас Обработка символьной информации

Обработка символьной информации Components of computer

Components of computer 1 урок Информатики 3 класс Человек и информация

1 урок Информатики 3 класс Человек и информация Информационные системы и их классификация

Информационные системы и их классификация Системы счисления

Системы счисления Как путешествовать бюджетно или В кругосветку со среднероссийской зарплатой

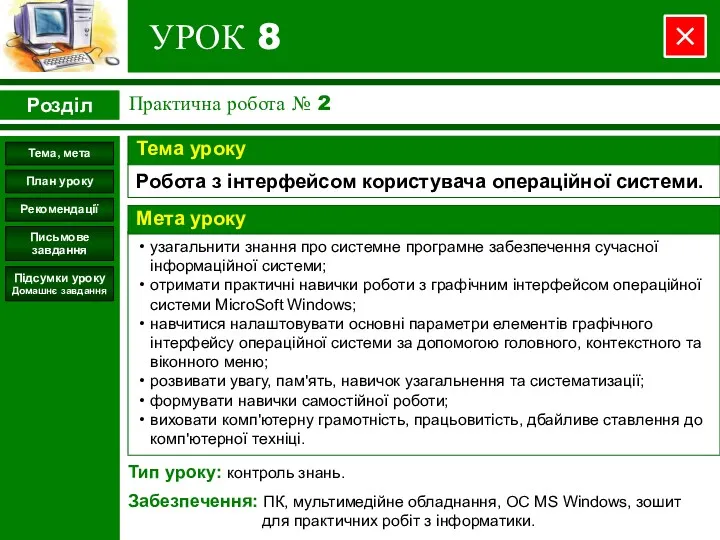

Как путешествовать бюджетно или В кругосветку со среднероссийской зарплатой Робота з інтерфейсом користувача операційної системи

Робота з інтерфейсом користувача операційної системи Протокол SNMP

Протокол SNMP Генетические алгоритмы

Генетические алгоритмы Простой Софт. Программы для дома и офиса

Простой Софт. Программы для дома и офиса Ресурсы дистанционного обучения в БФ БашГУ

Ресурсы дистанционного обучения в БФ БашГУ Программа 3-мерного моделирования Blender. Урок 22

Программа 3-мерного моделирования Blender. Урок 22