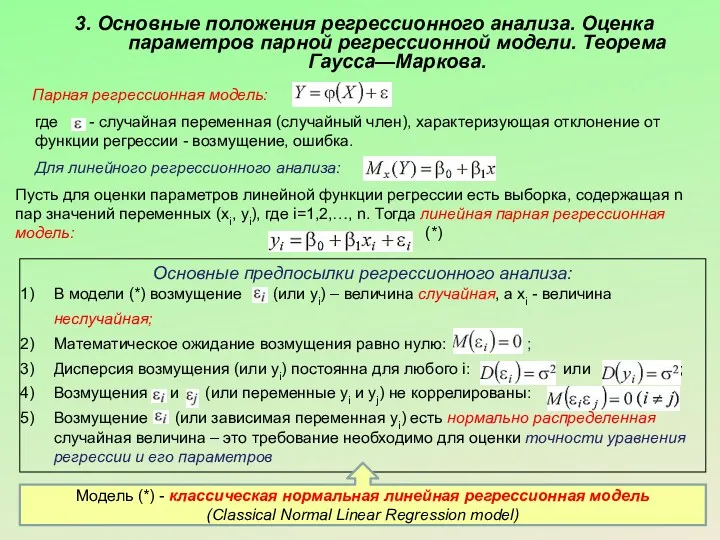

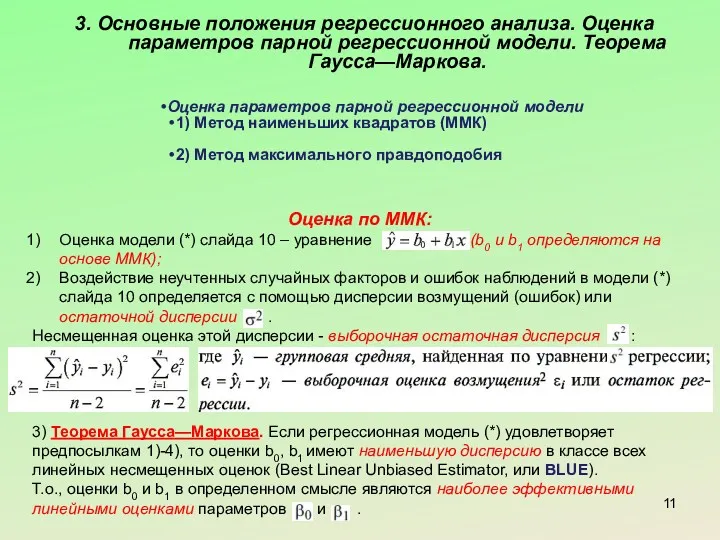

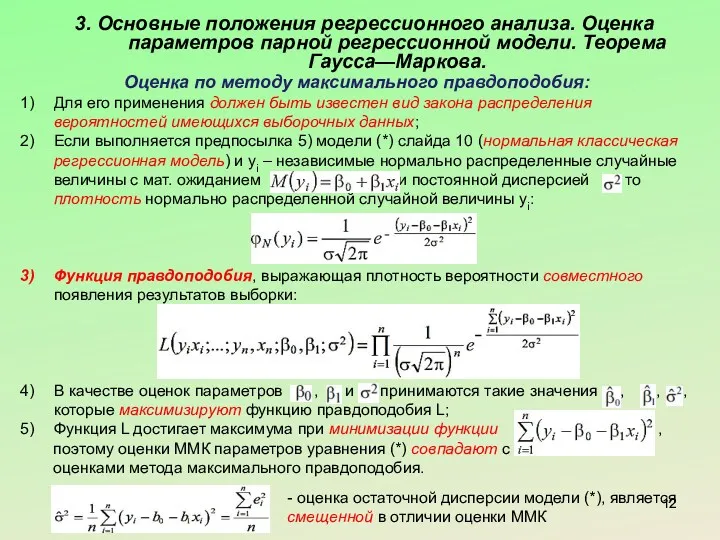

3. Основные положения регрессионного анализа. Оценка параметров парной регрессионной модели. Теорема

Гаусса—Маркова.

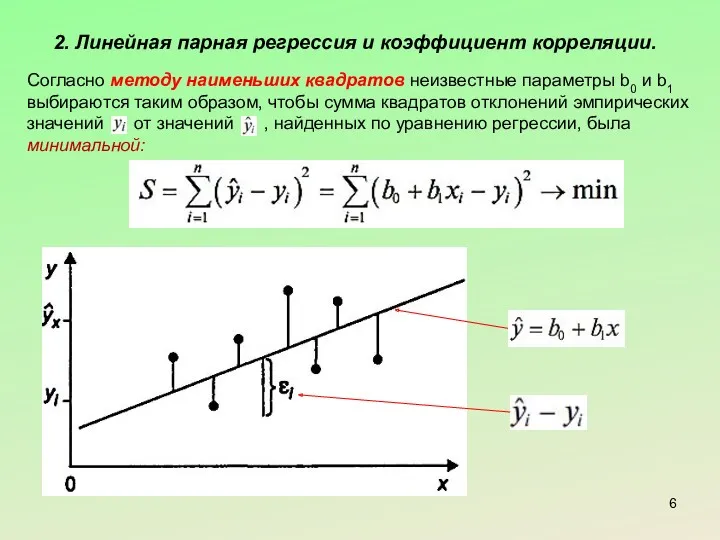

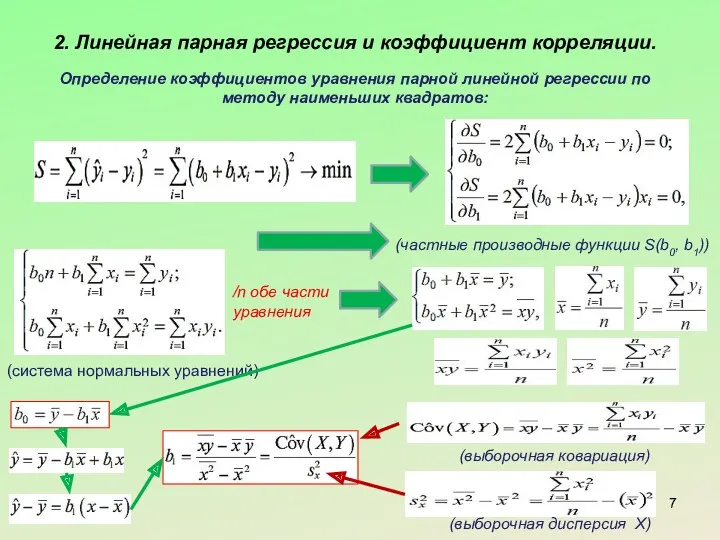

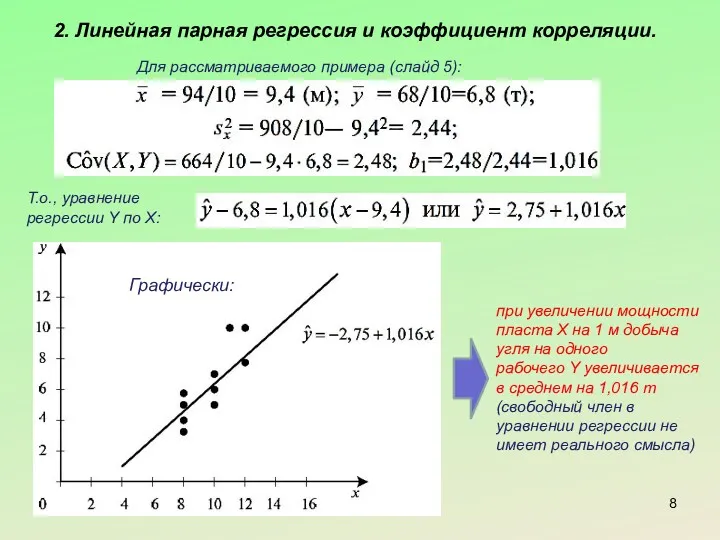

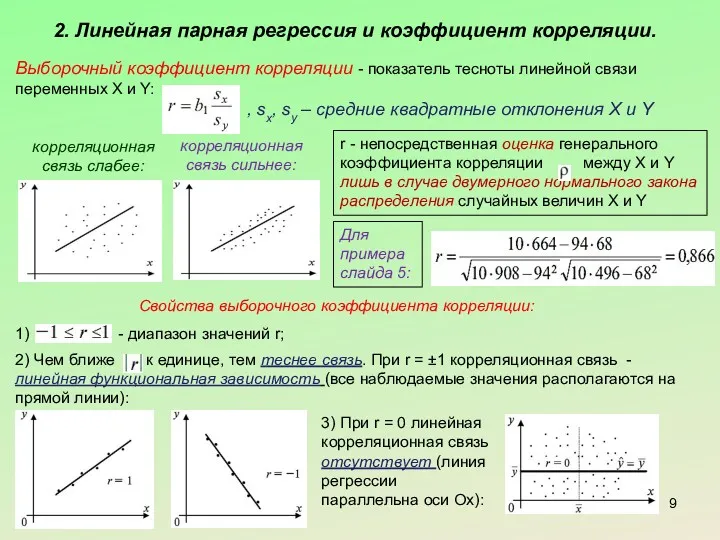

Парная регрессионная модель:

где - случайная переменная (случайный член), характеризующая отклонение от функции регрессии - возмущение, ошибка.

Для линейного регрессионного анализа:

Пусть для оценки параметров линейной функции регрессии есть выборка, содержащая n пар значений переменных (xi, yi), где i=1,2,…, n. Тогда линейная парная регрессионная модель: (*)

Основные предпосылки регрессионного анализа:

В модели (*) возмущение (или yi) – величина случайная, а xi - величина неслучайная;

Математическое ожидание возмущения равно нулю: ;

Дисперсия возмущения (или yi) постоянна для любого i: или ;

Возмущения и (или переменные yi и yj) не коррелированы: ;

Возмущение (или зависимая переменная yi) есть нормально распределенная случайная величина – это требование необходимо для оценки точности уравнения регрессии и его параметров

Модель (*) - классическая нормальная линейная регрессионная модель

(Classical Normal Linear Regression model)

Объём цилиндра

Объём цилиндра ПРЕЗЕНТАЦИЯ УРАВНЕНИЕ

ПРЕЗЕНТАЦИЯ УРАВНЕНИЕ Математика Тема: Маша и Медведь учатся считать

Математика Тема: Маша и Медведь учатся считать Что? Где? Когда? Математическая игра

Что? Где? Когда? Математическая игра Параллелепипед и ее элементы, виды и свойств. Площадь боковой и полной поверхности параллелепипеда

Параллелепипед и ее элементы, виды и свойств. Площадь боковой и полной поверхности параллелепипеда Элементы математической статистики

Элементы математической статистики Векторы в пространстве. Определение вектора в пространстве и связанные с ним понятия, равенство векторов

Векторы в пространстве. Определение вектора в пространстве и связанные с ним понятия, равенство векторов Решение логических задач

Решение логических задач устный счёт до 10

устный счёт до 10 Непараметрические критерии

Непараметрические критерии Сумма углов треугольника. Геометрия. 7 класс

Сумма углов треугольника. Геометрия. 7 класс Счастливый случай. Математическая игра

Счастливый случай. Математическая игра Параллельные прямые в пространстве. (10 класс)

Параллельные прямые в пространстве. (10 класс) состав числа 2 и 3

состав числа 2 и 3 Формулы тригонометрии

Формулы тригонометрии Деление многозначного на трёхзначное число. Решение задач.

Деление многозначного на трёхзначное число. Решение задач. Экспресс-тренинг по подготовке к ЕГЭ по математике

Экспресс-тренинг по подготовке к ЕГЭ по математике Cистема реального времени. Задачи в системах реального времени ( тема 2 )

Cистема реального времени. Задачи в системах реального времени ( тема 2 ) Презентация урока на тему: Таблица умножения и деления на 6. Закрепление. Урок-сказка.

Презентация урока на тему: Таблица умножения и деления на 6. Закрепление. Урок-сказка. Язык геометрических рисунков

Язык геометрических рисунков Основы сетевого планирования и управления (СПУ) разработками

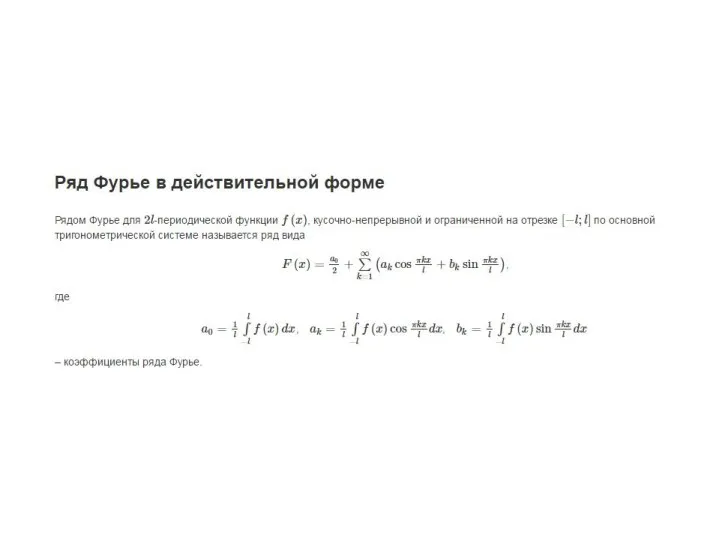

Основы сетевого планирования и управления (СПУ) разработками Ряды Фурье. Семинар 30

Ряды Фурье. Семинар 30 Расчет каналов. Гидравлика

Расчет каналов. Гидравлика Арифметическая прогрессия (9 класс)

Арифметическая прогрессия (9 класс) Формулы сокращенного умножения

Формулы сокращенного умножения Округление натуральных чисел

Округление натуральных чисел Презентация по математике Задача Диск

Презентация по математике Задача Диск Умножение вектора на число

Умножение вектора на число