Содержание

- 2. Где мы встречаем многомерные пространства? Одна из самых распространенных областей - анализ данных:

- 3. Цель визуализации Цель – получить отображение данных в 2 или 3 мерном пространстве для дальнейшего изучения

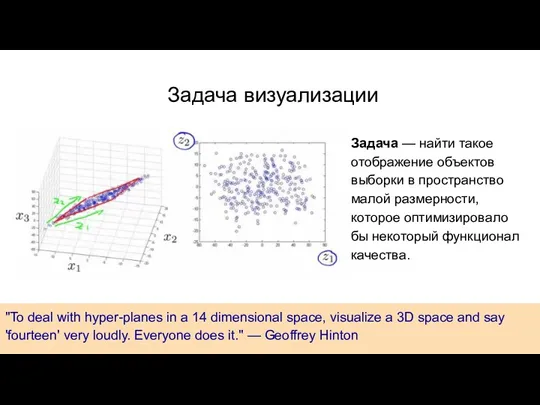

- 4. "To deal with hyper-planes in a 14 dimensional space, visualize a 3D space and say 'fourteen'

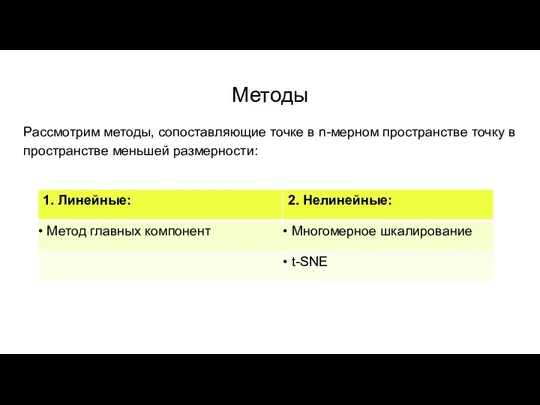

- 5. Методы Рассмотрим методы, сопоставляющие точке в n-мерном пространстве точку в пространстве меньшей размерности:

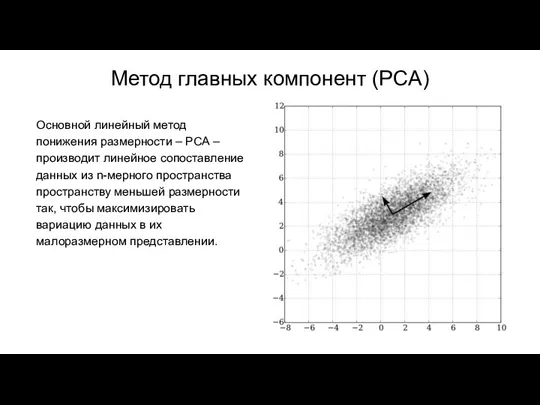

- 6. Метод главных компонент (PCA) Основной линейный метод понижения размерности – PCA – производит линейное сопоставление данных

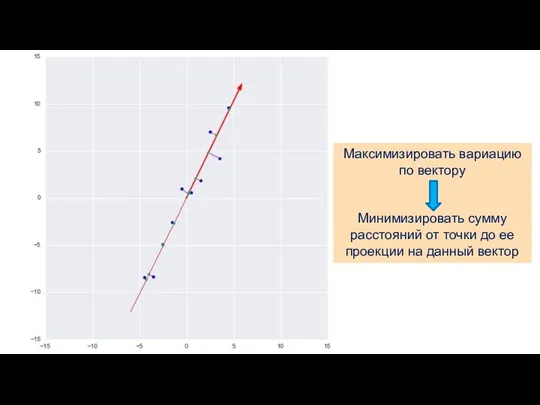

- 7. Максимизировать вариацию по вектору Минимизировать сумму расстояний от точки до ее проекции на данный вектор

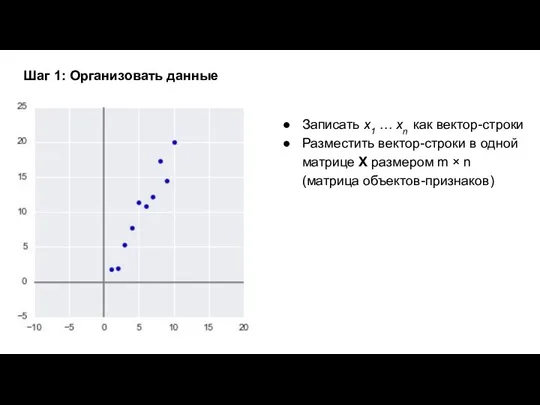

- 8. Записать x1 … xn как вектор-строки Разместить вектор-строки в одной матрице X размером m × n

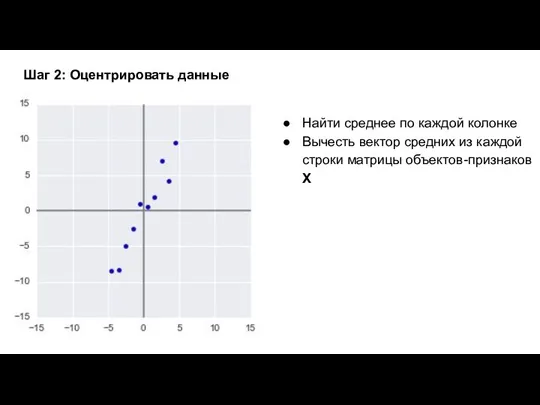

- 9. Шаг 2: Оцентрировать данные Найти среднее по каждой колонке Вычесть вектор средних из каждой строки матрицы

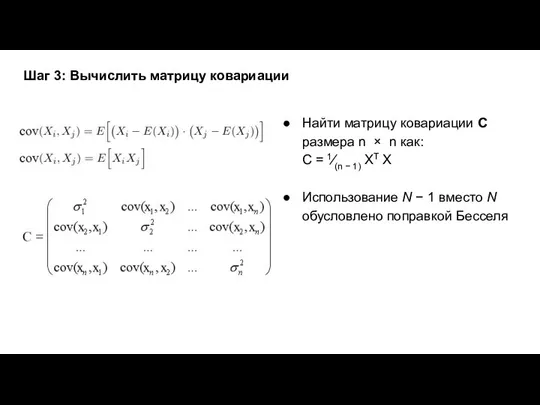

- 10. Шаг 3: Вычислить матрицу ковариации Найти матрицу ковариации С размера n × n как: C =

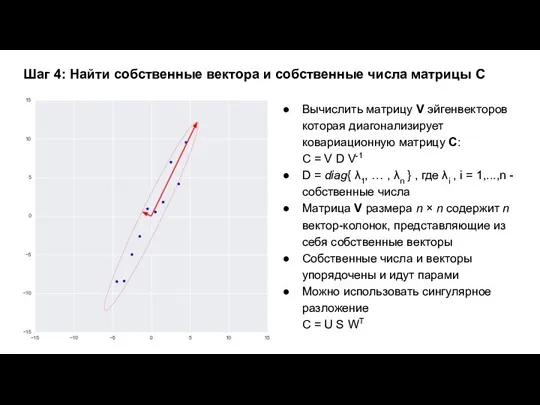

- 11. Шаг 4: Найти собственные вектора и собственные числа матрицы С Вычислить матрицу V эйгенвекторов которая диагонализирует

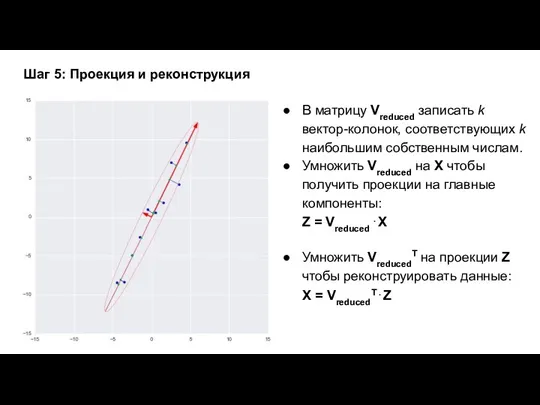

- 12. Шаг 5: Проекция и реконструкция В матрицу Vreduced записать k вектор-колонок, соответствующих k наибольшим собственным числам.

- 13. Ирисы Фишера

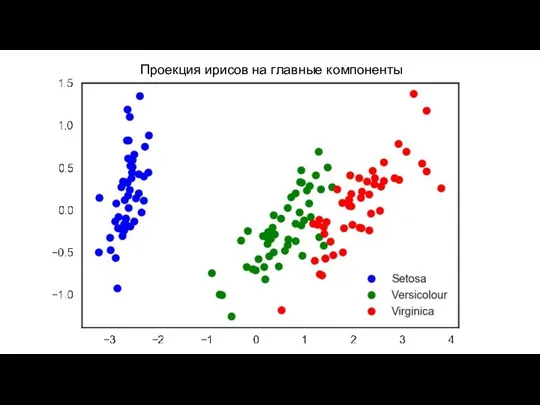

- 14. Проекция ирисов на главные компоненты

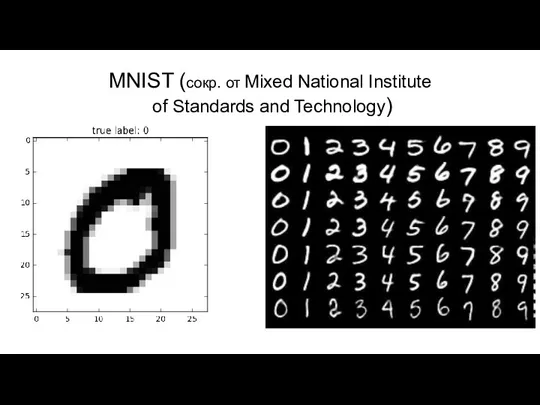

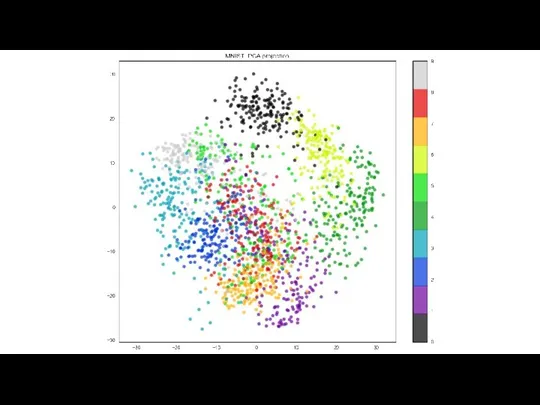

- 15. MNIST (сокр. от Mixed National Institute of Standards and Technology)

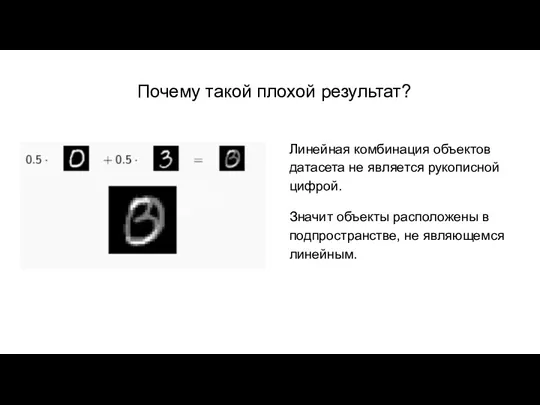

- 17. Почему такой плохой результат? Линейная комбинация объектов датасета не является рукописной цифрой. Значит объекты расположены в

- 18. Нелинейные методы Рассмотрим более простую модель и поставим задачу нелинейного понижения размерности: Задача — найти отображение

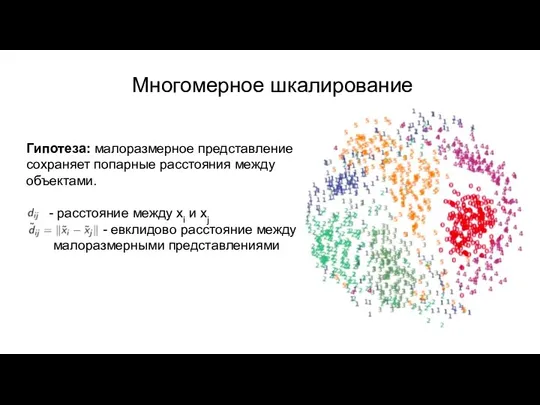

- 19. Гипотеза: малоразмерное представление сохраняет попарные расстояния между объектами. - расстояние между xi и xj - евклидово

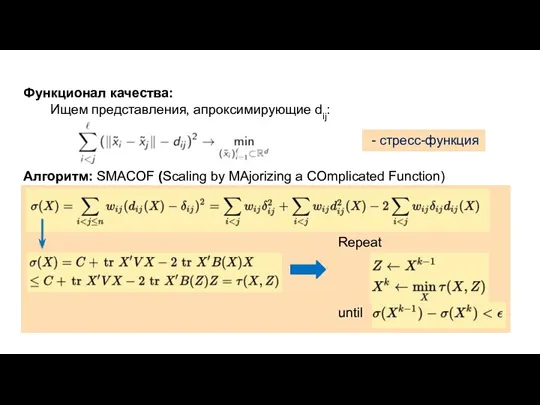

- 20. Функционал качества: Ищем представления, апроксимирующие dij: Алгоритм: SMACOF (Scaling by MAjorizing a COmplicated Function) - стресс-функция

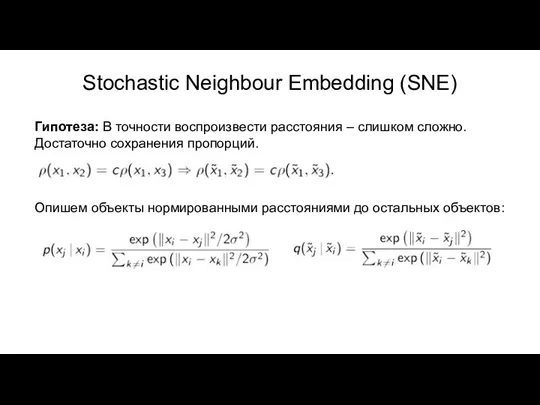

- 21. Stochastic Neighbour Embedding (SNE) Гипотеза: В точности воспроизвести расстояния – слишком сложно. Достаточно сохранения пропорций. Опишем

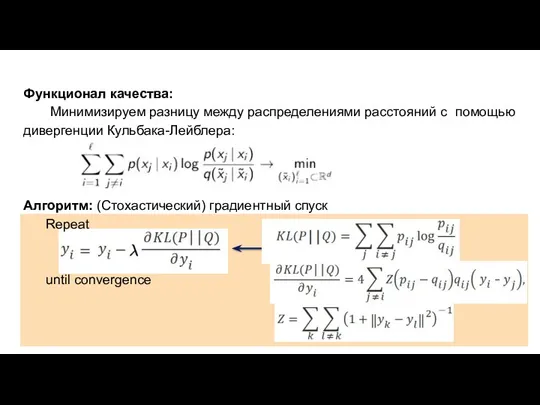

- 22. Функционал качества: Минимизируем разницу между распределениями расстояний с помощью дивергенции Кульбака-Лейблера: Алгоритм: (Стохастический) градиентный спуск Repeat

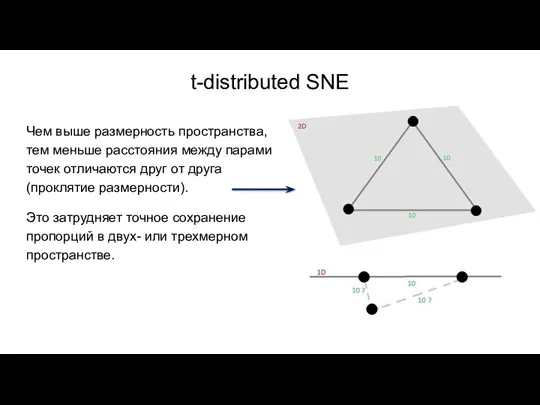

- 23. t-distributed SNE Чем выше размерность пространства, тем меньше расстояния между парами точек отличаются друг от друга

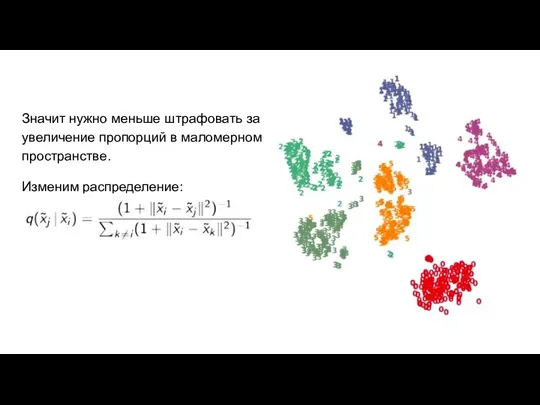

- 24. Значит нужно меньше штрафовать за увеличение пропорций в маломерном пространстве. Изменим распределение:

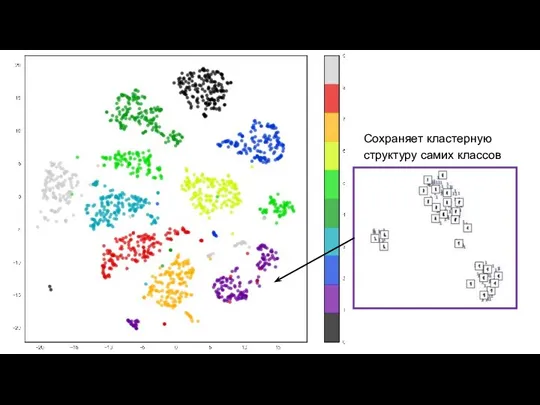

- 25. Сохраняет кластерную структуру самих классов

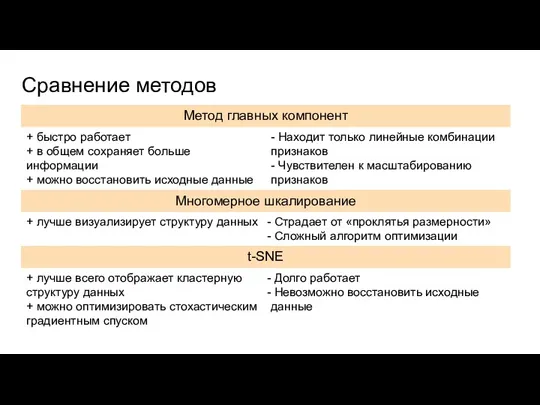

- 26. Сравнение методов

- 27. Выводы Существует множество методов визуализации многомерных данных Выбор метода сильно зависит от конкретной задачи Ключевым фактором

- 29. Скачать презентацию

Презентация Геометрические фигуры

Презентация Геометрические фигуры Изменение величин. (6 класс)

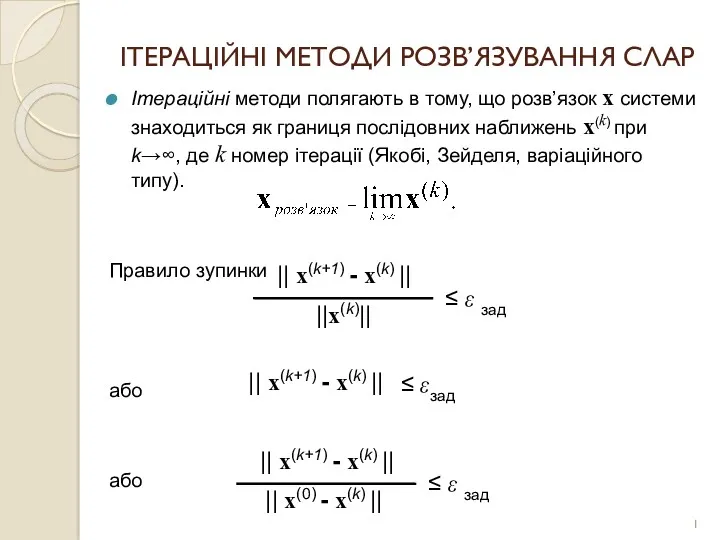

Изменение величин. (6 класс) Ітераційні методи розв’язування СЛАР (Система лінійних алгебраїчних рівнянь)

Ітераційні методи розв’язування СЛАР (Система лінійних алгебраїчних рівнянь) Способы решений систем линейных уравнений

Способы решений систем линейных уравнений Решение неравенств второй степени с одной переменной

Решение неравенств второй степени с одной переменной Первые уроки школьной отметки

Первые уроки школьной отметки Признаки параллельности прямых. Задачи на готовых чертежах

Признаки параллельности прямых. Задачи на готовых чертежах Всё по обыкновенным дробям. 6 класс

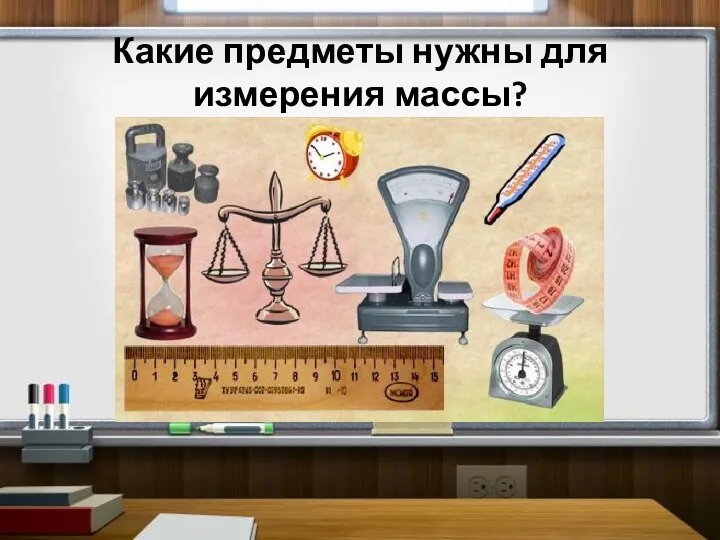

Всё по обыкновенным дробям. 6 класс Единицы массы. Центнер. Тонна

Единицы массы. Центнер. Тонна Көбейту және бөлуді пысықтау

Көбейту және бөлуді пысықтау Основы метрологии, стандартизации, сертификации и управление качеством

Основы метрологии, стандартизации, сертификации и управление качеством Стандартный вид числа

Стандартный вид числа Единицы измерения. Диск

Единицы измерения. Диск Геометрия Лобачевского

Геометрия Лобачевского Математические диктанты. Обыкновенные дроби

Математические диктанты. Обыкновенные дроби Тригонометрические неравенства и методы их решения

Тригонометрические неравенства и методы их решения Теорема Піфагора

Теорема Піфагора Софья Ковалевская

Софья Ковалевская Компоненти дії додавання. Знаходження суми чисел за малюнками. Урок №32

Компоненти дії додавання. Знаходження суми чисел за малюнками. Урок №32 Формулы косинуса суммы и разности двух аргументов

Формулы косинуса суммы и разности двух аргументов Числовые последовательности. Бесконечно большие и бесконечно малые последовательности. (Лекция 1)

Числовые последовательности. Бесконечно большие и бесконечно малые последовательности. (Лекция 1) Основное свойство дроби. 5 класс

Основное свойство дроби. 5 класс Треугольники. Подборка теории о треугольниках, их свойствах

Треугольники. Подборка теории о треугольниках, их свойствах Освоение величин в дошкольном возрасте как условие познания окружающего мира

Освоение величин в дошкольном возрасте как условие познания окружающего мира Пропорции

Пропорции Построения циркулем и линейкой

Построения циркулем и линейкой Математический диктант

Математический диктант Статистика

Статистика