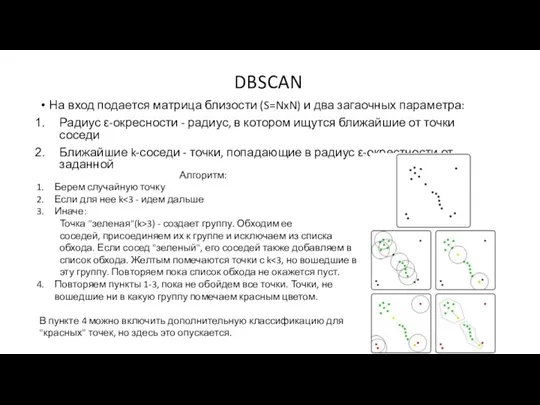

DBSCAN

На вход подается матрица близости (S=NxN) и два загаочных параметра:

Радиус ε-окресности

- радиус, в котором ищутся ближайшие от точки соседи

Ближайшие k-соседи - точки, попадающие в радиус ε-окрестности от заданной

Алгоритм:

Берем случайную точку

Если для нее k<3 - идем дальше

Иначе:

Точка "зеленая"(k>3) - создает группу. Обходим ее соседей, присоединяем их к группе и исключаем из списка обхода. Если сосед "зеленый", его соседей также добавляем в список обхода. Желтым помечаются точки с k<3, но вошедшие в эту группу. Повторяем пока список обхода не окажется пуст.

Повторяем пункты 1-3, пока не обойдем все точки. Точки, не вошедшие ни в какую группу помечаем красным цветом.

В пункте 4 можно включить дополнительную классификацию для "красных" точек, но здесь это опускается.

Сравнительный анализ СЭД на основе пользовательских оценок

Сравнительный анализ СЭД на основе пользовательских оценок Модельдер және оның тұрлері

Модельдер және оның тұрлері ЕАС ОПС. Задачи системы и роль ключевых пользователей

ЕАС ОПС. Задачи системы и роль ключевых пользователей Очередность работ при последовательной схеме технологического процесса

Очередность работ при последовательной схеме технологического процесса Електропостачання електровозної відкатки. Електровози

Електропостачання електровозної відкатки. Електровози Промышленные сети

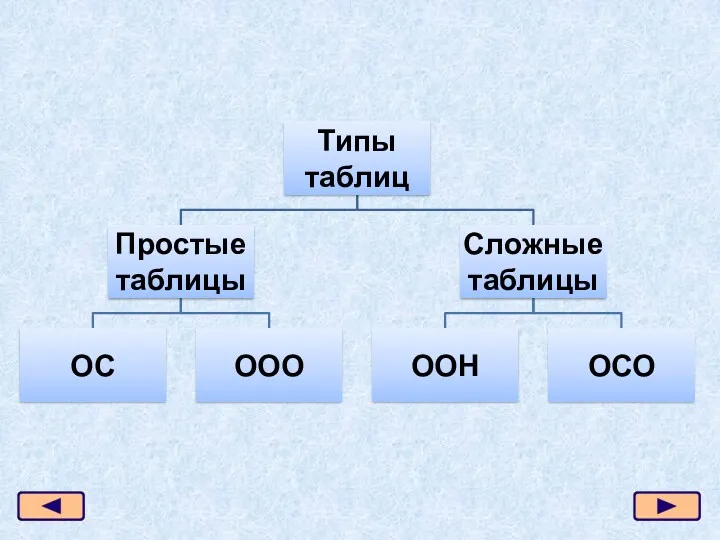

Промышленные сети Типы таблиц

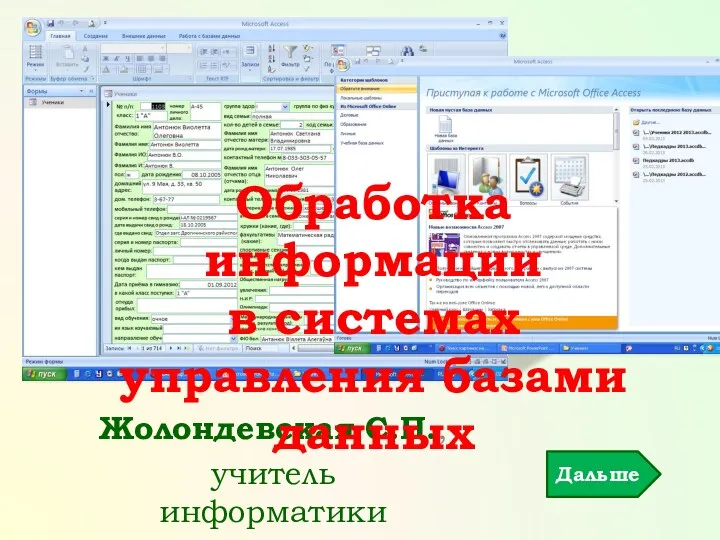

Типы таблиц Обработка информации в системах управления базами данных

Обработка информации в системах управления базами данных Регистрация на сайте Научной библиотеки МГУ (для первокурсников)

Регистрация на сайте Научной библиотеки МГУ (для первокурсников) Эволюция телефонов Nokia

Эволюция телефонов Nokia Поиск информации в базе данных. ОГЭ по информатике, задача 12

Поиск информации в базе данных. ОГЭ по информатике, задача 12 Возможности динамических, электронных таблиц. Математическая обработка числовых данных

Возможности динамических, электронных таблиц. Математическая обработка числовых данных Знакомство с графическими редакторами. Растровые рисунки

Знакомство с графическими редакторами. Растровые рисунки Язык программирования Паскаль

Язык программирования Паскаль Яка небезпека очікує дітей в інтернеті

Яка небезпека очікує дітей в інтернеті Поняття електронної таблиці. Засоби опрацювання електронних таблиць. Запуск на виконання табличного процесора

Поняття електронної таблиці. Засоби опрацювання електронних таблиць. Запуск на виконання табличного процесора Фільтрація та сортування

Фільтрація та сортування Высокопроизводительные вычисления

Высокопроизводительные вычисления Қолданбалы бағдарламалық қамсыздандыру

Қолданбалы бағдарламалық қамсыздандыру Разработка внеклассного мероприятия по информатике Путешествие в страну компьютерная графика

Разработка внеклассного мероприятия по информатике Путешествие в страну компьютерная графика Пример слайда. Sydney Opera House is Australia’s

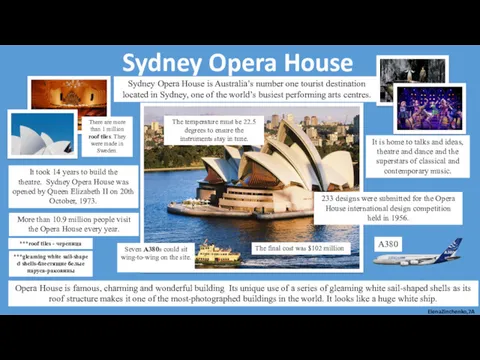

Пример слайда. Sydney Opera House is Australia’s Программирование разветвляющихся алгоритмов. Начала программирования. Условный алгоритм

Программирование разветвляющихся алгоритмов. Начала программирования. Условный алгоритм Коммуникации в соцсетях

Коммуникации в соцсетях Строки. Работа со строками. Лекция 7

Строки. Работа со строками. Лекция 7 Учебный центр. Введение в компанию 2ГИС. Продукты

Учебный центр. Введение в компанию 2ГИС. Продукты Модуль 5. Массивы. Способы их описания, формирования и обработки

Модуль 5. Массивы. Способы их описания, формирования и обработки Configuring Backup Settings (3)

Configuring Backup Settings (3) Устройство компьютера

Устройство компьютера