Содержание

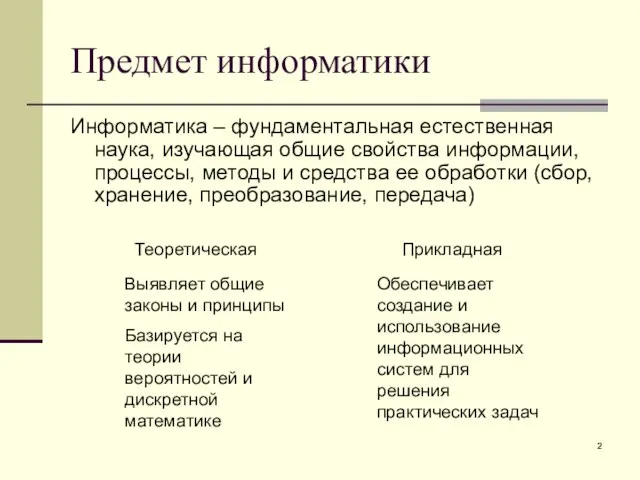

- 2. Предмет информатики Информатика – фундаментальная естественная наука, изучающая общие свойства информации, процессы, методы и средства ее

- 3. Понятие информации В широком смысле информация – это общенаучное понятие, включающее в себя обмен сведениями между

- 4. это наиболее важный ресурс современного производства: он снижает потребность в земле, труде, капитале, уменьшает расход сырья

- 5. Свойства информации Будучи объектом преобразования и использования, информация характеризуется следующими свойствами: синтаксис – свойство, определяющее способ

- 6. Свойства информации Атрибутивные свойства - это те свойства, без которых информация не существует. Неотрывность информации от

- 7. Сообщение. Сигнал Абстрактная информация всегда представляется в виде конкретного сообщения. Можно сказать, что сообщение выступает в

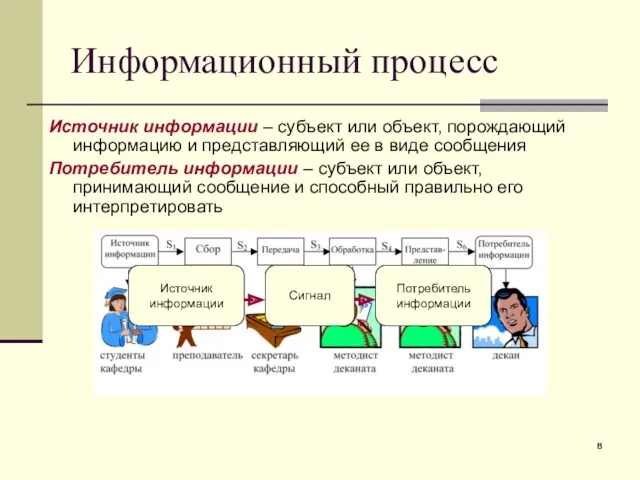

- 8. Источник информации – субъект или объект, порождающий информацию и представляющий ее в виде сообщения Потребитель информации

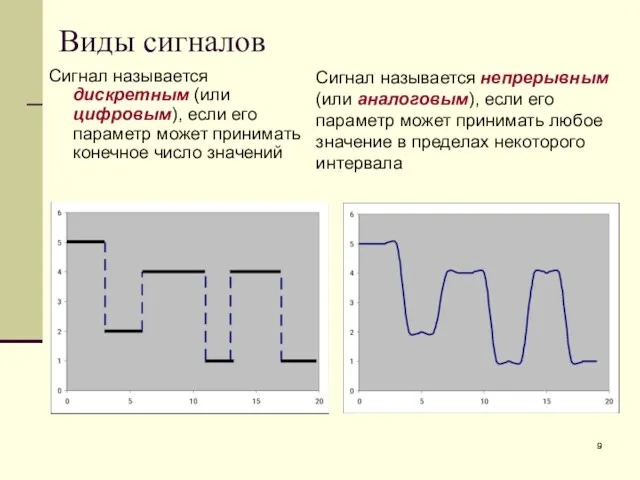

- 9. Сигнал называется дискретным (или цифровым), если его параметр может принимать конечное число значений Сигнал называется непрерывным

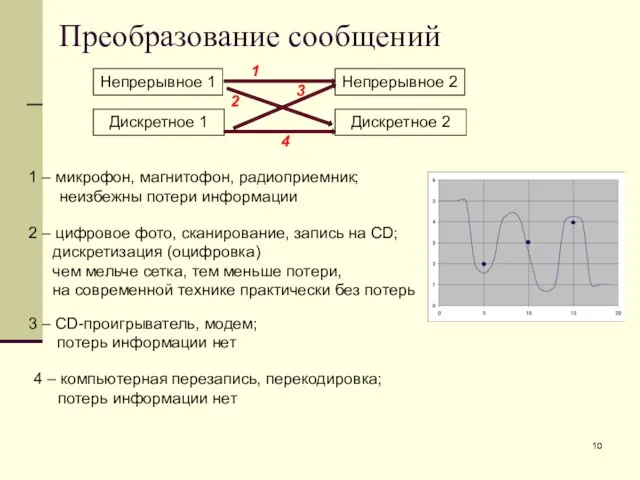

- 10. Преобразование сообщений Непрерывное 1 Непрерывное 2 Дискретное 2 Дискретное 1 1 3 2 4 1 –

- 11. Преимущества дискретной формы представления информации Возможность передачи без потерь и искажений Простота, надежность и относительная дешевизна

- 12. В информатике, как правило, измерению подвергается информация, представленная дискретным сигналом. При этом различают следующие подходы Структурный

- 13. Статистический – учитывает вероятность появления сообщений: более информативным считается то сообщение, которое менее вероятно, т.е. менее

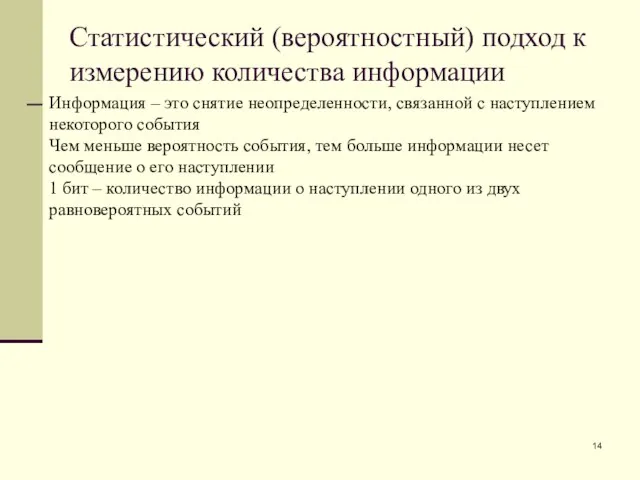

- 14. Статистический (вероятностный) подход к измерению количества информации Информация – это снятие неопределенности, связанной с наступлением некоторого

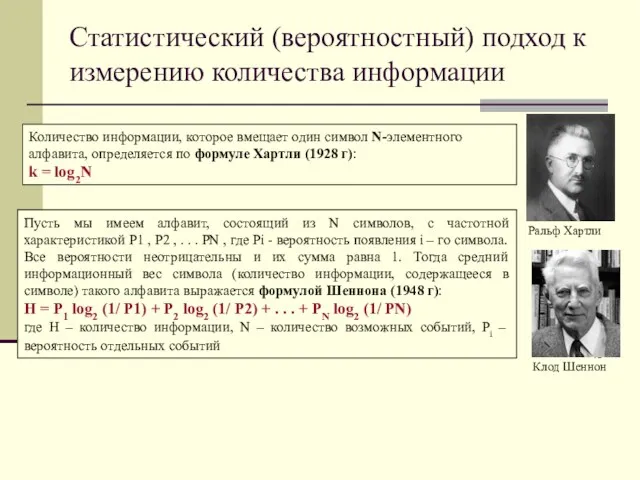

- 15. Статистический (вероятностный) подход к измерению количества информации Ральф Хартли Клод Шеннон Пусть мы имеем алфавит, состоящий

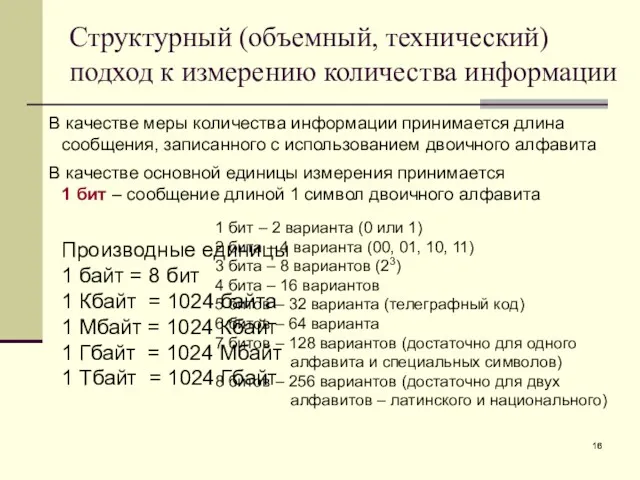

- 16. Структурный (объемный, технический) подход к измерению количества информации В качестве меры количества информации принимается длина сообщения,

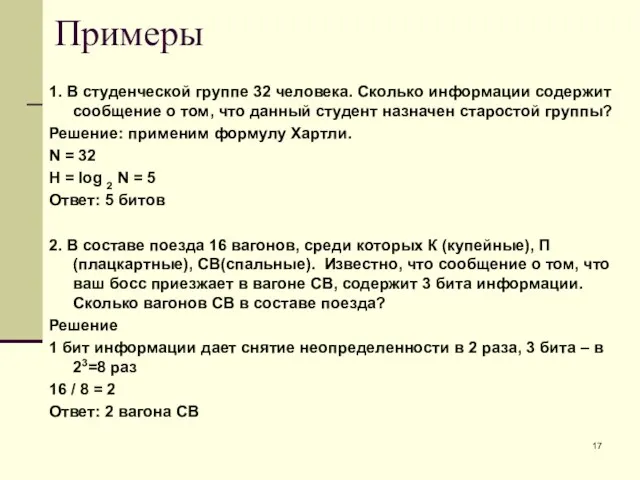

- 17. Примеры 1. В студенческой группе 32 человека. Сколько информации содержит сообщение о том, что данный студент

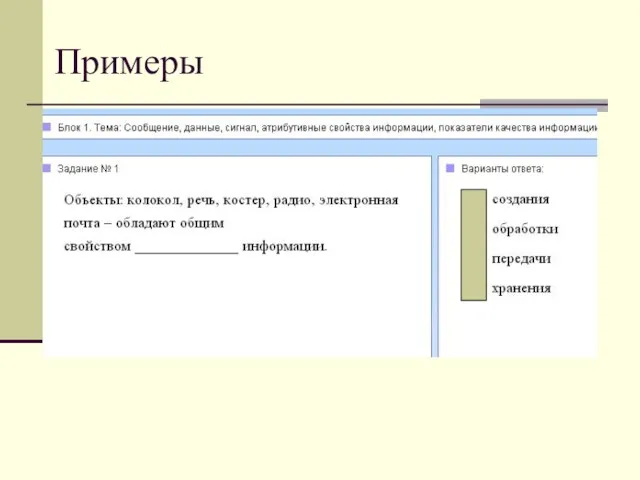

- 18. Примеры

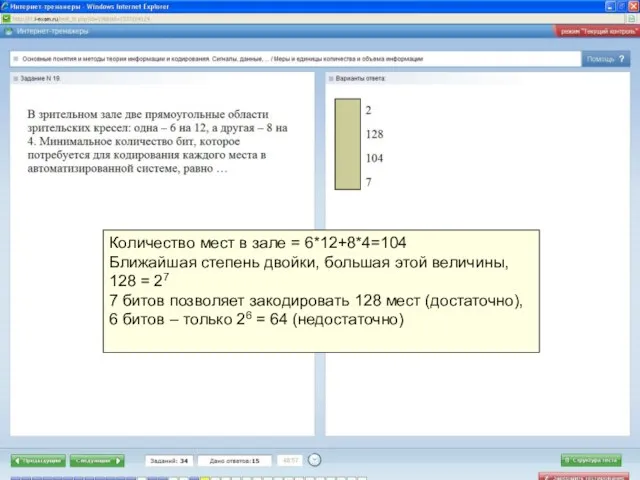

- 19. Количество мест в зале = 6*12+8*4=104 Ближайшая степень двойки, большая этой величины, 128 = 27 7

- 21. Скачать презентацию

Введение в VoIP

Введение в VoIP Зачем нужна информатика

Зачем нужна информатика API. Яндекс.Практикум

API. Яндекс.Практикум Анализ бизнес-процессов средствами BPwin

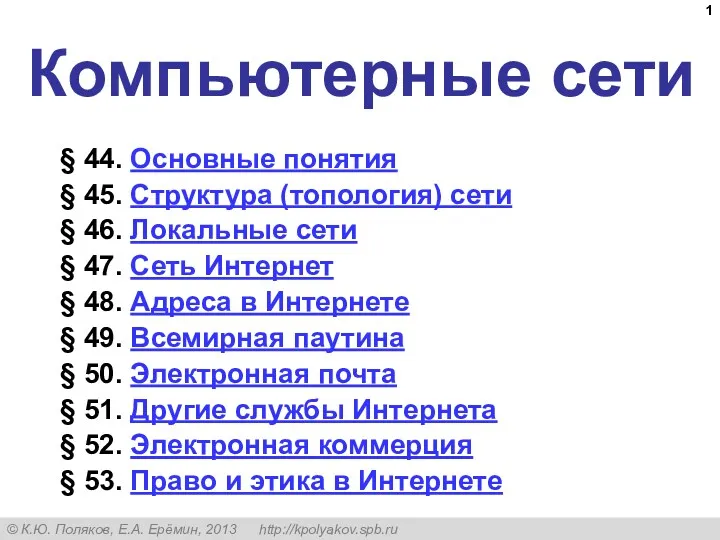

Анализ бизнес-процессов средствами BPwin Компьютерные сети. § 44. Основные понятия. 10 класс

Компьютерные сети. § 44. Основные понятия. 10 класс Проектная тематика. Компьютерные технологии анализа данных и исследования статистических закономерностей и анализ больших данных

Проектная тематика. Компьютерные технологии анализа данных и исследования статистических закономерностей и анализ больших данных Компьютерная графика

Компьютерная графика Компьютерные сети. Основы компьютерных сетей. Технология Ethernet. Часть 1

Компьютерные сети. Основы компьютерных сетей. Технология Ethernet. Часть 1 Информационное моделирование

Информационное моделирование Онтологии. Теория и примеры

Онтологии. Теория и примеры Компьютерные вирусы

Компьютерные вирусы Язык программирования JavaScript

Язык программирования JavaScript Робот LEGO WeDo – исполнитель алгоритмов

Робот LEGO WeDo – исполнитель алгоритмов Программирование на языке Паскаль

Программирование на языке Паскаль Кодирование звука и видео

Кодирование звука и видео Befree. Cons of social networks

Befree. Cons of social networks Вставка графических объектов в текстовый документ Writer

Вставка графических объектов в текстовый документ Writer Зустріч лідерів

Зустріч лідерів Форматирование символов и абзацев

Форматирование символов и абзацев Презентация по информатике

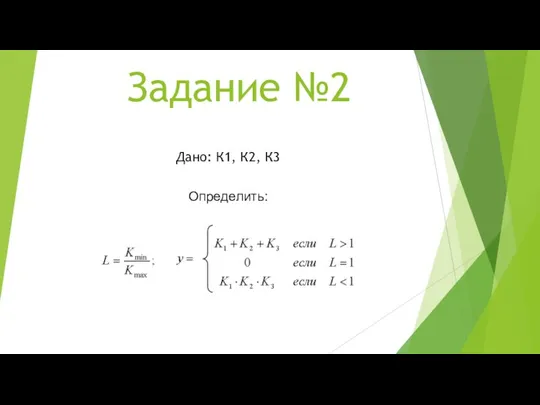

Презентация по информатике Программирование линейных алгоритмов. Начала программирования. Информатика. 8 класс

Программирование линейных алгоритмов. Начала программирования. Информатика. 8 класс Macromedia Dreamweaver. Определение сайта. Табличный дизайн. Создание шаблонов. Создание гиперссылок

Macromedia Dreamweaver. Определение сайта. Табличный дизайн. Создание шаблонов. Создание гиперссылок От простого шутера до киберспорта

От простого шутера до киберспорта Regular expressions - регулярные выражения (Java)

Regular expressions - регулярные выражения (Java) Building the user interface by using HTML5. Text, graphics and media

Building the user interface by using HTML5. Text, graphics and media Представления основанных на классах

Представления основанных на классах Основы алгоритмизации и программирования. Указатели

Основы алгоритмизации и программирования. Указатели История развития корпоративной прессы

История развития корпоративной прессы