Содержание

- 2. Понятие и задачи информатики Информатика – термин заимствован из французского языка в 1960х гг. и обозначает

- 3. По своей структуре информатика представляет собой единство трех взаимосвязанных частей - технические средства (hardware), программные средства

- 4. Цель курса информатики состоит в том, чтобы помочь всем желающим (студентам) овладеть основами компьютерной грамотности, способствовать

- 5. Понятие информации Информация – это сведения об объектах и явлениях окружающей среды, их параметрах, свойствах и

- 6. Понятие «информация» обычно предполагает наличие двух объектов – «источника» информации и «приемника» (потребителя, адресата) информации. Информация

- 7. Информация и ее свойства Адекватность информации – важнейшее свойство информации, это определенный уровень соответствия образа, создаваемого

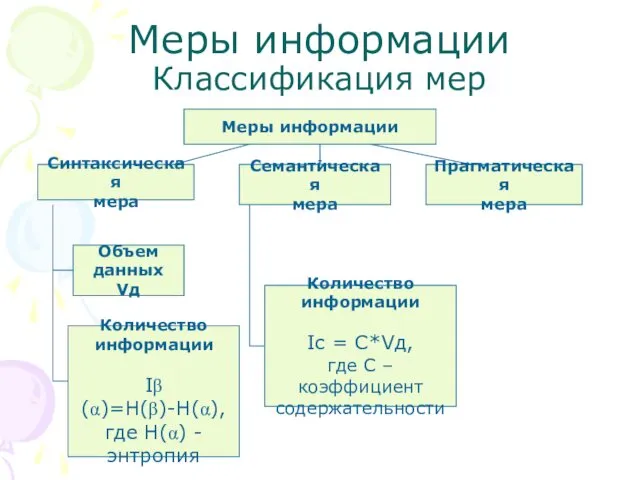

- 8. Меры информации Классификация мер Меры информации Синтаксическая мера Семантическая мера Прагматическая мера Объем данных Vд Количество

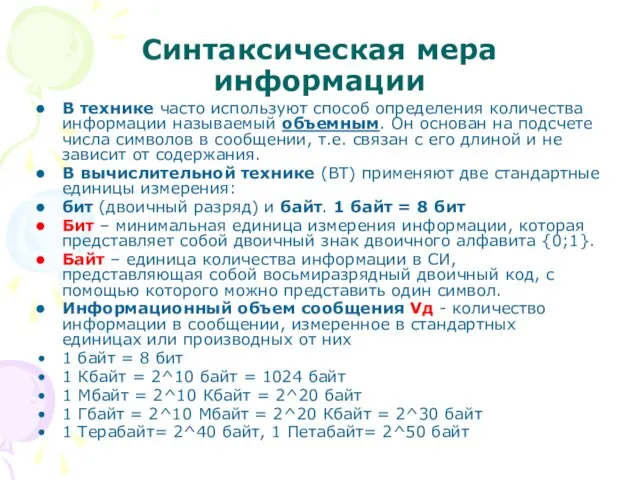

- 9. Синтаксическая мера информации В технике часто используют способ определения количества информации называемый объемным. Он основан на

- 10. Количество информации. Синтаксический подход В теории информации количеством информации называют числовую характеристику сигнала, не зависящую от

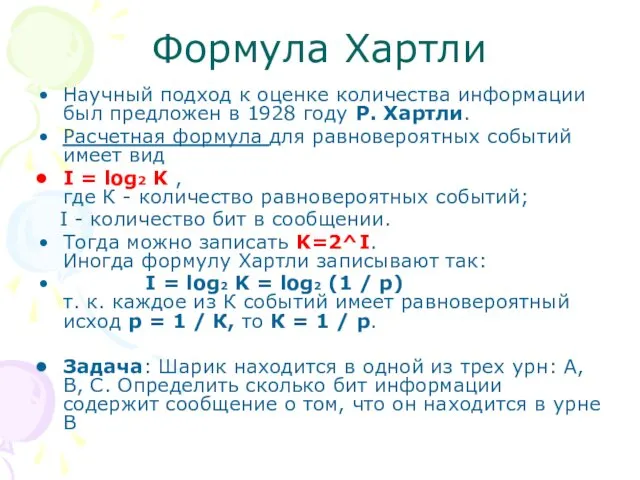

- 11. Формула Хартли Научный подход к оценке количества информации был предложен в 1928 году Р. Хартли. Расчетная

- 12. Формула Шеннона Более общий подход к вычислению количества информации в сообщении об одном из N, но

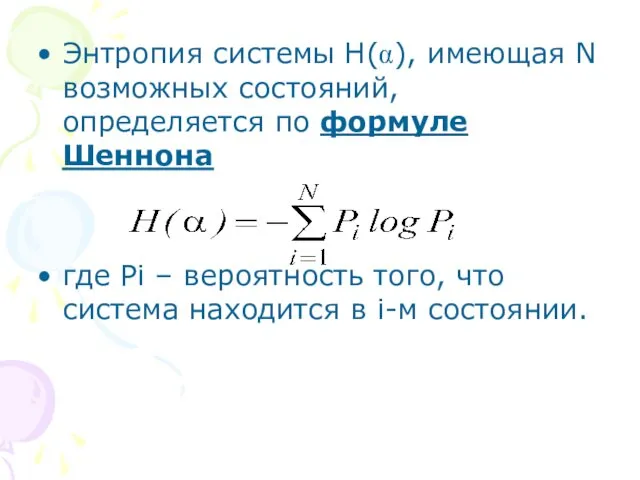

- 13. Энтропия системы H(α), имеющая N возможных состояний, определяется по формуле Шеннона где Pi – вероятность того,

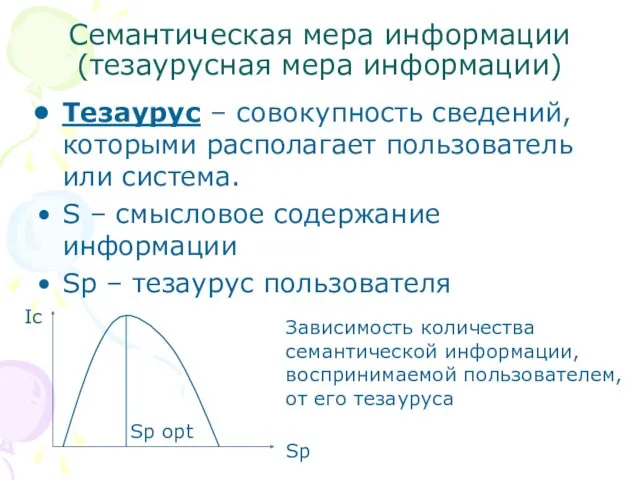

- 14. Семантическая мера информации (тезаурусная мера информации) Тезаурус – совокупность сведений, которыми располагает пользователь или система. S

- 15. Прагматическая мера информации Прагматическая мера информации определяет полезность (ценность) информации для пользователя. Это величина относительная, обусловленная

- 16. Качество информации Показатели качества информации: Репрезентативность Содержательность Достаточность (полнота) Доступность Актуальность Своевременность Точность Достоверность Устойчивость

- 17. ПРЕДСТАВЛЕНИЕ И КОДИРОВАНИЕ ИНФОРМАЦИИ Для обмена информацией с другими людьми человек использует естественные языки (русский, английский,

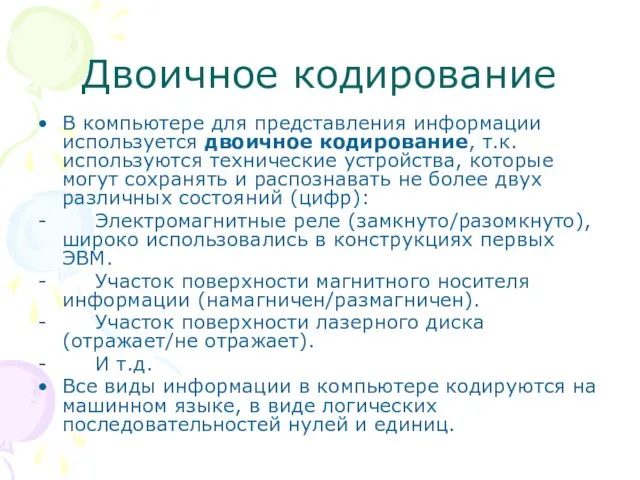

- 18. Двоичное кодирование В компьютере для представления информации используется двоичное кодирование, т.к. используются технические устройства, которые могут

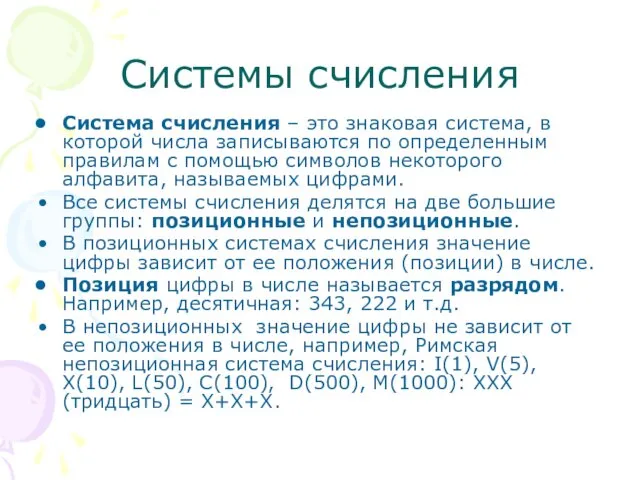

- 19. Системы счисления Система счисления – это знаковая система, в которой числа записываются по определенным правилам с

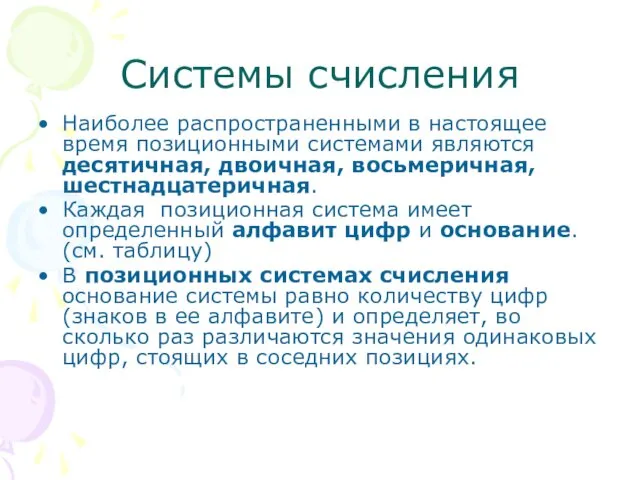

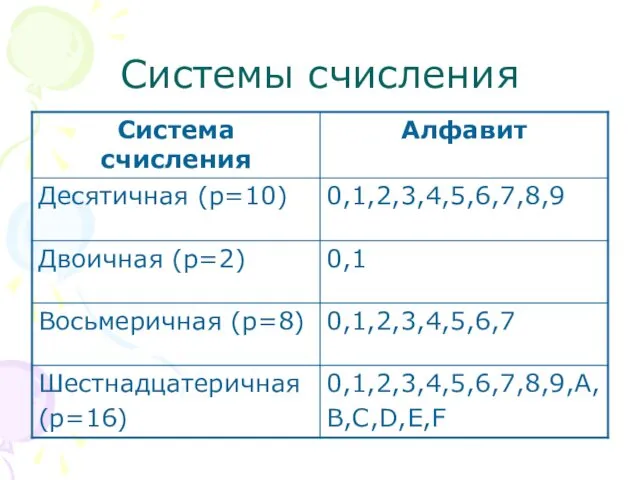

- 20. Системы счисления Наиболее распространенными в настоящее время позиционными системами являются десятичная, двоичная, восьмеричная, шестнадцатеричная. Каждая позиционная

- 21. Системы счисления

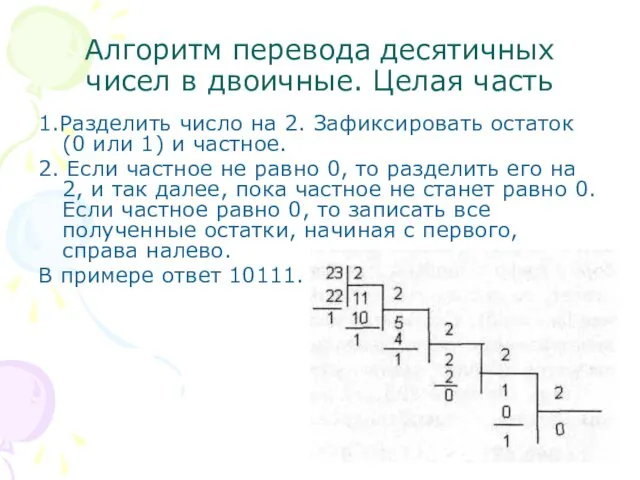

- 22. Алгоритм перевода десятичных чисел в двоичные. Целая часть 1.Разделить число на 2. Зафиксировать остаток (0 или

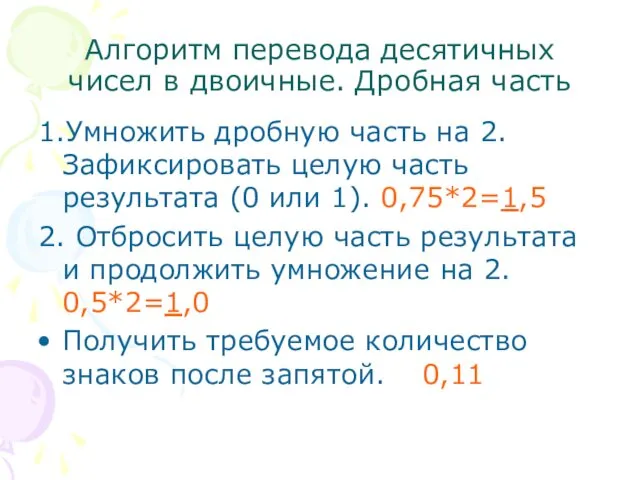

- 23. Алгоритм перевода десятичных чисел в двоичные. Дробная часть 1.Умножить дробную часть на 2. Зафиксировать целую часть

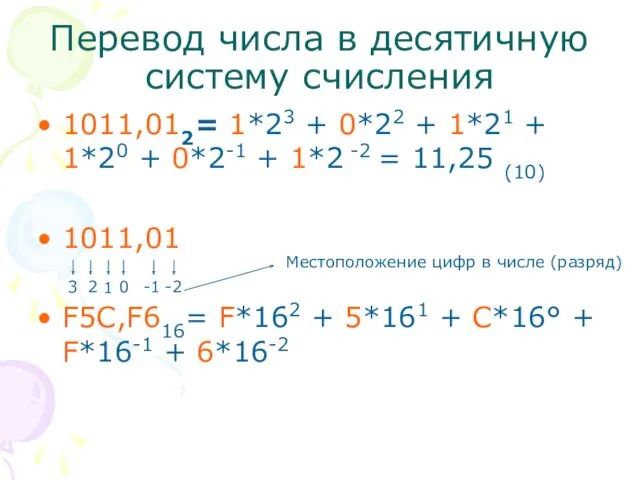

- 24. Перевод числа в десятичную систему счисления 1011,012= 1*23 + 0*22 + 1*21 + 1*20 + 0*2-1

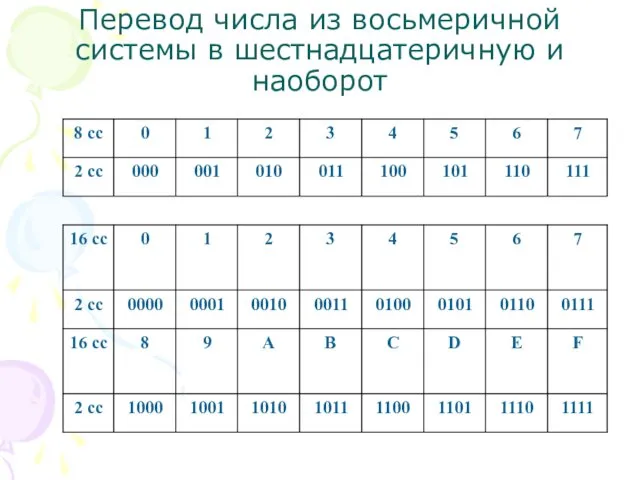

- 25. Перевод числа из восьмеричной системы в шестнадцатеричную и наоборот

- 27. Скачать презентацию

1С и Telegram

1С и Telegram Множества и логика в задачах ЕГЭ по информатике

Множества и логика в задачах ЕГЭ по информатике Средства коммуникационной техники. Средства и системы телефонной связи

Средства коммуникационной техники. Средства и системы телефонной связи Корпусная лингвистика

Корпусная лингвистика Сайти

Сайти Web - сайты и web-страницы

Web - сайты и web-страницы QR-кодирование. Что такое QR-код?

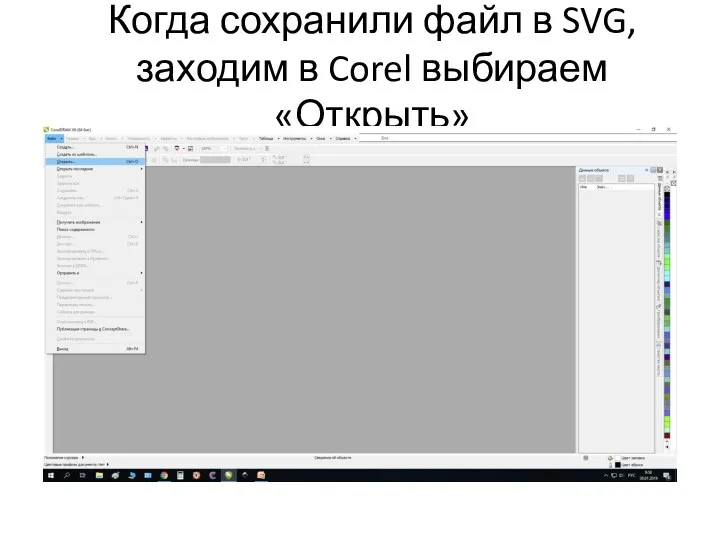

QR-кодирование. Что такое QR-код? Инструкция по работе с веб-сайтом программного обеспечения Corel

Инструкция по работе с веб-сайтом программного обеспечения Corel Информационные системы и технологии с элементами искусственного интеллекта. Лекция 8

Информационные системы и технологии с элементами искусственного интеллекта. Лекция 8 Упрощенный прием РПО

Упрощенный прием РПО Действия с информацией

Действия с информацией Диалоговые окна

Диалоговые окна Цифровая платформа Российский Фермер

Цифровая платформа Российский Фермер 16-сабақ. Ғаламтормен дұрыс жұмыс жасау -мәдениет

16-сабақ. Ғаламтормен дұрыс жұмыс жасау -мәдениет Web-страницы. Язык HTML и др. Тема 1

Web-страницы. Язык HTML и др. Тема 1 Компьютерная этика

Компьютерная этика Вспомогательные режимы построения объектов

Вспомогательные режимы построения объектов Единый портал государственных и муниципальных услуг

Единый портал государственных и муниципальных услуг Архитектурная схема ЭВМ. Состав ПК

Архитектурная схема ЭВМ. Состав ПК Разработка мобильных приложений в THUNKABLE. Начало

Разработка мобильных приложений в THUNKABLE. Начало Типы данных и их объявление

Типы данных и их объявление Мошенничество в сети Интернет

Мошенничество в сети Интернет Право в интернете

Право в интернете Информатика и информатизация общества

Информатика и информатизация общества Қазақ мерзімді баспасөзінің пайда болуы және қазақ тіліндегі алғашқы газеттер

Қазақ мерзімді баспасөзінің пайда болуы және қазақ тіліндегі алғашқы газеттер Лекция 7. Моделирование технологических процессов. Травление, литография, проявление

Лекция 7. Моделирование технологических процессов. Травление, литография, проявление Java Массивы

Java Массивы Понятие объекта

Понятие объекта