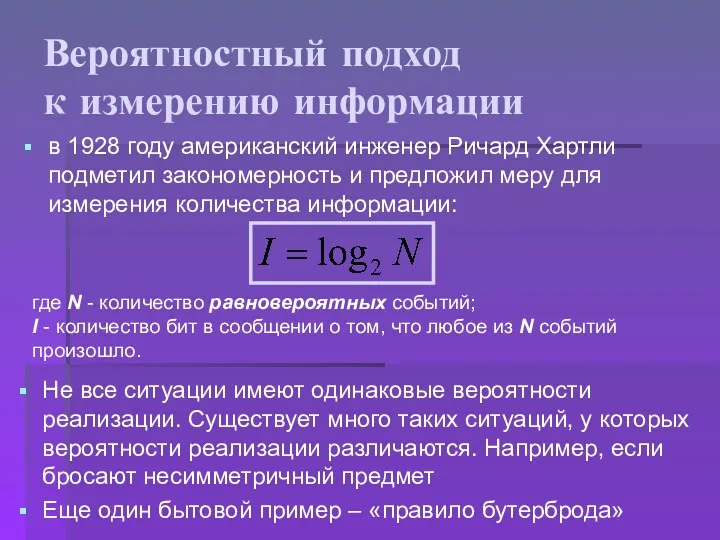

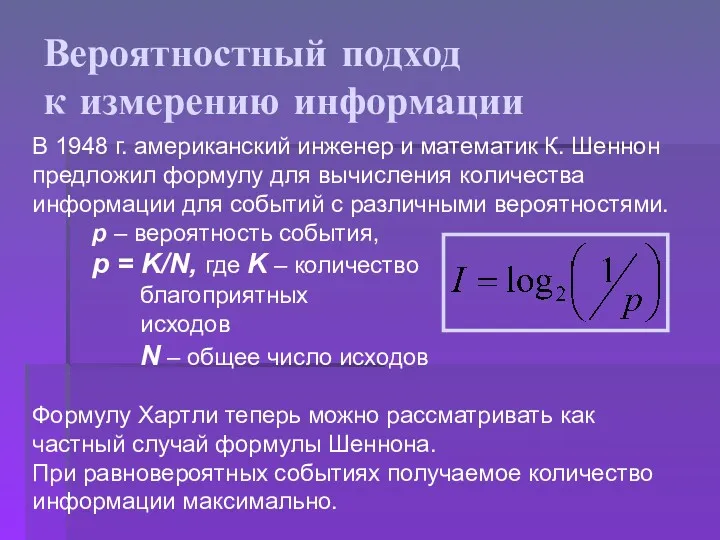

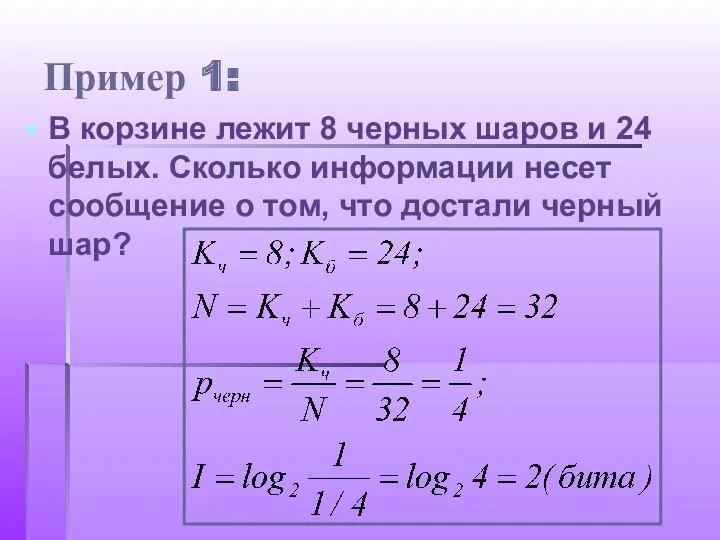

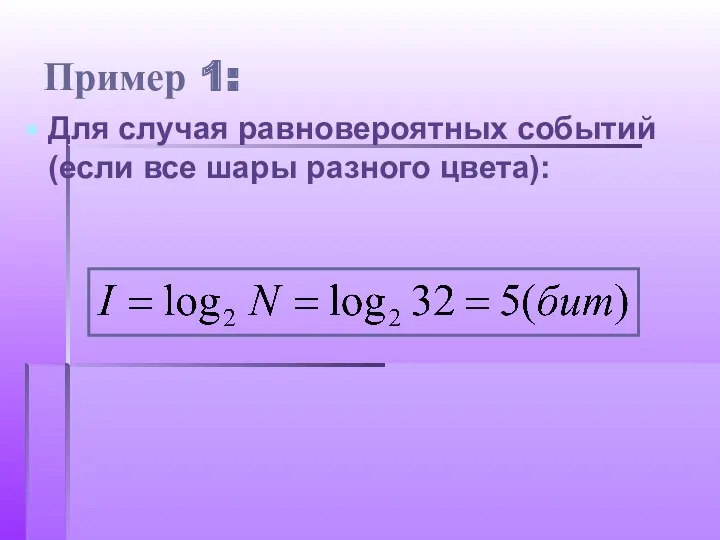

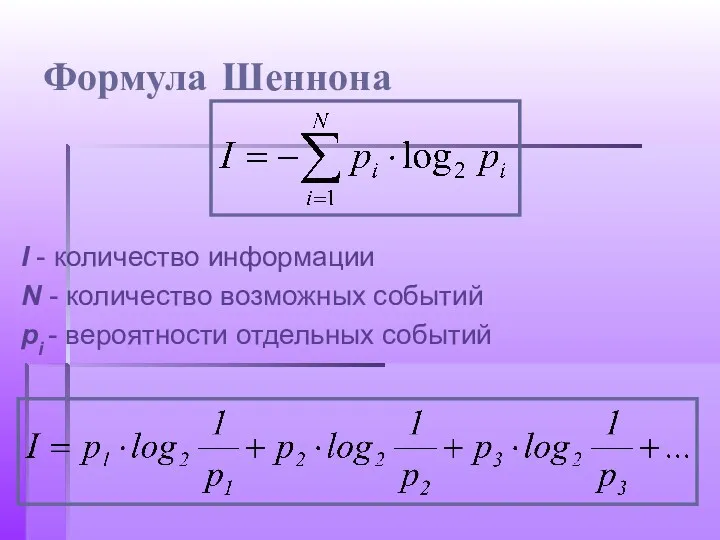

Вероятностный подход

к измерению информации

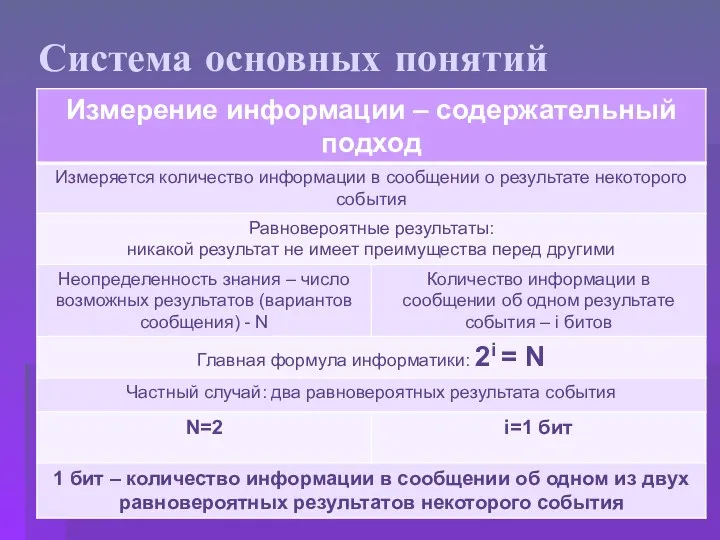

в 1928 году американский инженер Ричард Хартли

подметил закономерность и предложил меру для измерения количества информации:

где N - количество равновероятных событий;

I - количество бит в сообщении о том, что любое из N событий произошло.

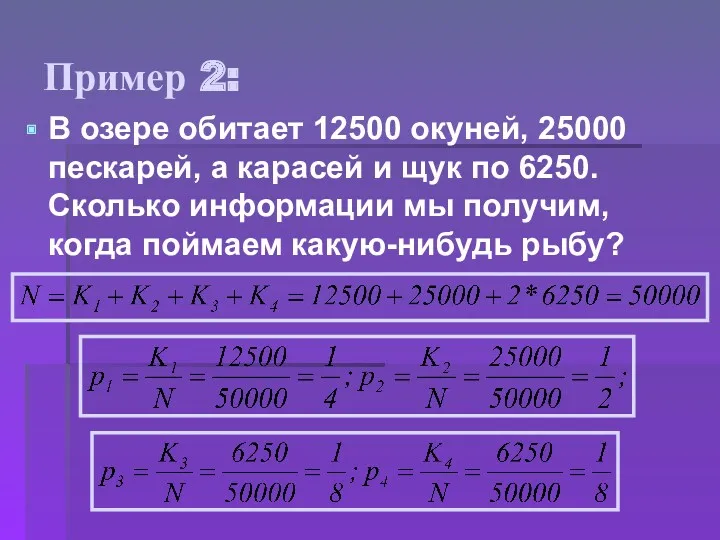

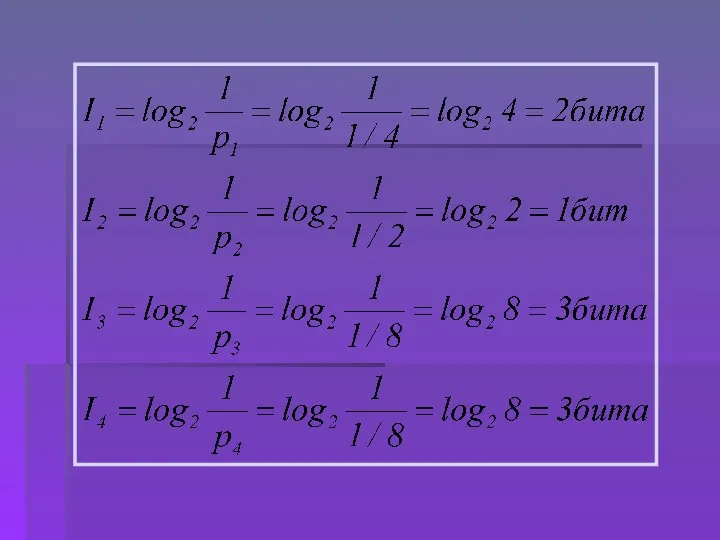

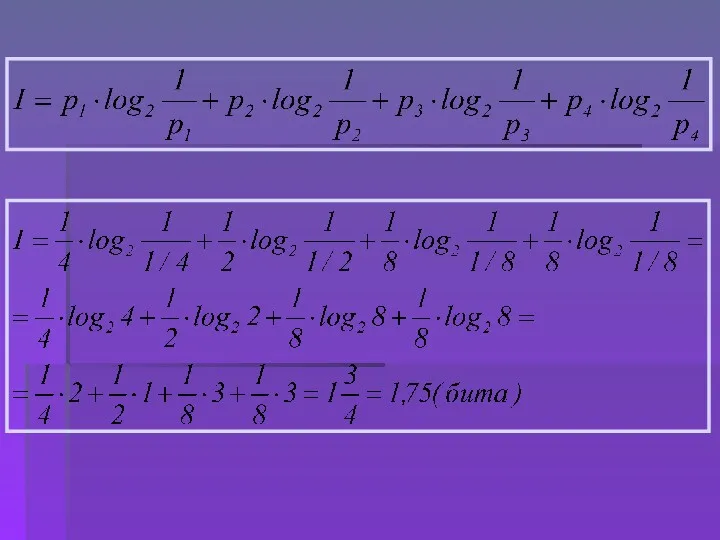

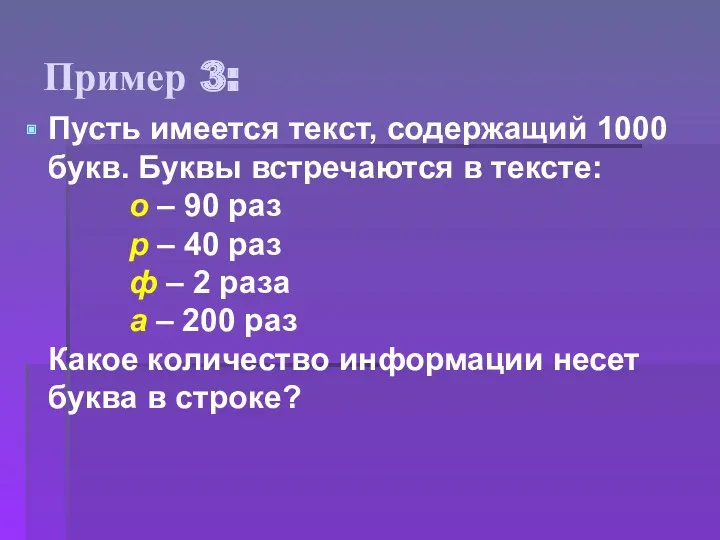

Не все ситуации имеют одинаковые вероятности реализации. Существует много таких ситуаций, у которых вероятности реализации различаются. Например, если бросают несимметричный предмет

Еще один бытовой пример – «правило бутерброда»

Основы индексного анализа

Основы индексного анализа Ethetnet жергілікті есептеу торабы

Ethetnet жергілікті есептеу торабы Английский язык - ведущий язык в мире и интернете

Английский язык - ведущий язык в мире и интернете Управляющие структуры (PHP, лекция 3)

Управляющие структуры (PHP, лекция 3) Пользовательские функции. Файлы. Лекция 6

Пользовательские функции. Файлы. Лекция 6 Тема 3. Технологии межсетевого экранирования

Тема 3. Технологии межсетевого экранирования Постреляционные базы данных

Постреляционные базы данных Создание комплексной системы непрерывного информационного обеспечения для повышение производительности качества сельхозпродукции

Создание комплексной системы непрерывного информационного обеспечения для повышение производительности качества сельхозпродукции Основные принципы Веб 2.0

Основные принципы Веб 2.0 Перечисления и массивы

Перечисления и массивы Операторы цыклов WHILE, REPEAT, FOR

Операторы цыклов WHILE, REPEAT, FOR Сетевые технологии

Сетевые технологии Интерактивные викторины для пользователей детских и школьных библиотек. Мультимедийный конспект лекции № 1

Интерактивные викторины для пользователей детских и школьных библиотек. Мультимедийный конспект лекции № 1 Какие бывают запросы?

Какие бывают запросы? Введення формул у текстовому процесорі

Введення формул у текстовому процесорі Основные понятия алгебры логики. Логические выражения и логические операции (Лекция 05)

Основные понятия алгебры логики. Логические выражения и логические операции (Лекция 05) Банкнотоприемник MEI CashFlow SC и SC Advance

Банкнотоприемник MEI CashFlow SC и SC Advance Пресс-службы в органах власти

Пресс-службы в органах власти Внутренняя оптимизация

Внутренняя оптимизация Типы алгоритмов (3)

Типы алгоритмов (3) Розробка мобільного додатку на базі Android для підрахунку кількості кроків

Розробка мобільного додатку на базі Android для підрахунку кількості кроків Современные информационные технологии в документационном обеспечении управления

Современные информационные технологии в документационном обеспечении управления Антивирусные программы

Антивирусные программы Веб-технологии: вчера, сегодня, завтра. Семинар 1. Знакомство с веб-технологиями

Веб-технологии: вчера, сегодня, завтра. Семинар 1. Знакомство с веб-технологиями Программные и аппаратные компоненты сети. (Тема 3)

Программные и аппаратные компоненты сети. (Тема 3) Панда Антивирус

Панда Антивирус Основы современных операционных систем

Основы современных операционных систем Проектирование ИО ИС. Лекция 8

Проектирование ИО ИС. Лекция 8