Содержание

- 2. Лекция № 1 42 2.1 Информация и теория информации 2.2 Сообщения и сигналы 2.3 Структурная схема

- 3. 2.1. Информация и теория информации Информация (лат. Information – разъяснение, изложение, осведомленность) – одно из общих

- 4. 2.1. Информация и теория информации Структурная теория информации рассматривает структуру построения отдельных информационных сообщений. Единица количества

- 5. Лекция № 1 21 2.1 Информация и теория информации 2.2 Сообщения и сигналы 2.3 Структурная схема

- 6. 2.2. Сообщения и сигналы Под сообщением понимают информацию, выраженную в определенной форме и подлежащую передаче. Сообщение

- 7. Лекция № 1 23 2.1 Информация и теория информации 2.2 Сообщения и сигналы 2.3 Структурная схема

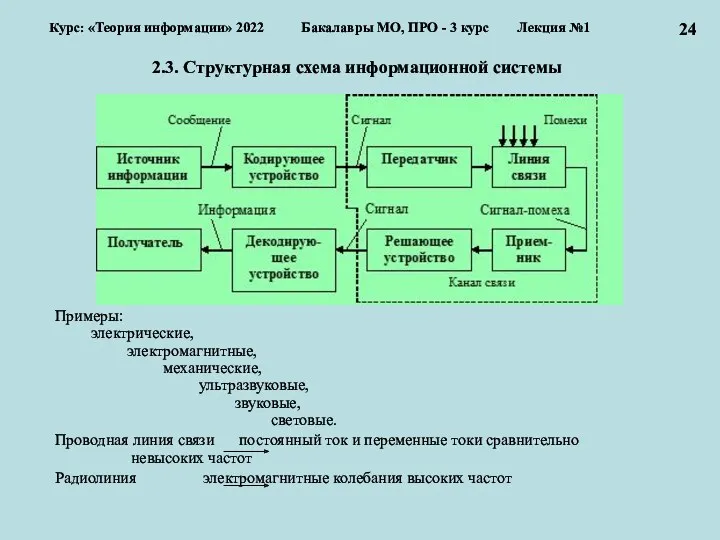

- 8. 2.3. Структурная схема информационной системы Примеры: электрические, электромагнитные, механические, ультразвуковые, звуковые, световые. Проводная линия связи постоянный

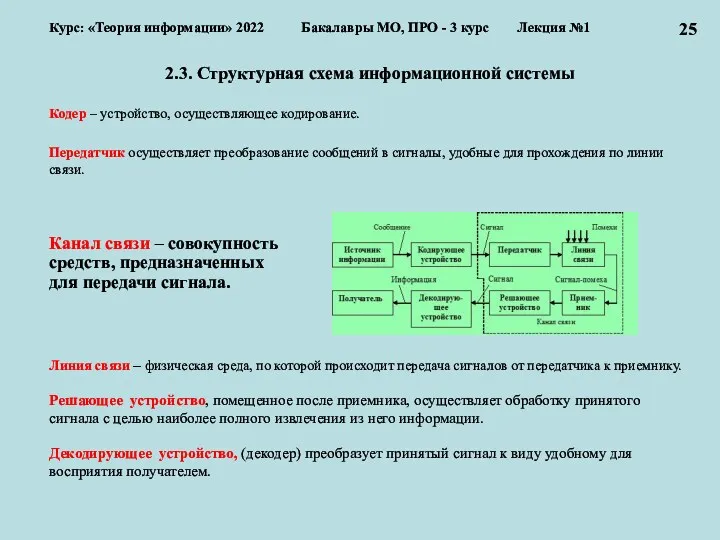

- 9. 2.3. Структурная схема информационной системы Кодер – устройство, осуществляющее кодирование. Передатчик осуществляет преобразование сообщений в сигналы,

- 10. 2.3. Структурная схема информационной системы Kодирование – преобразование сообщений в сигнал (в широком смысле). Кодирование –

- 11. Лекция № 1 27 2.1 Информация и теория информации 2.2 Сообщения и сигналы 2.3 Структурная схема

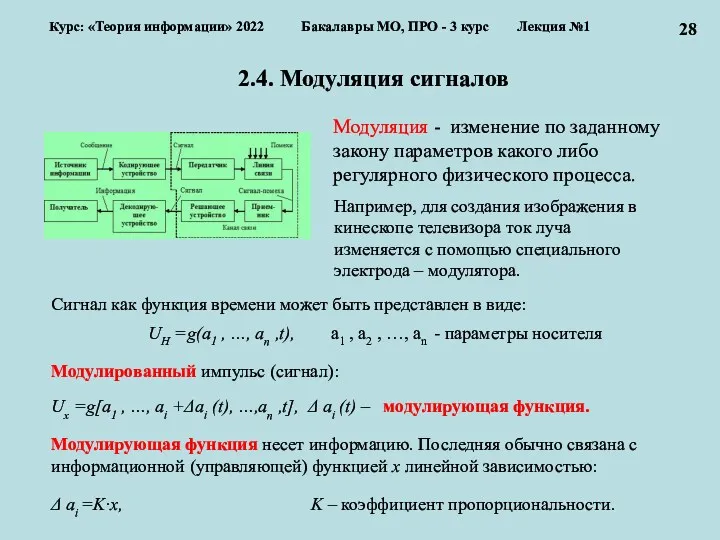

- 12. 2.4. Модуляция сигналов 28 Модуляция - изменение по заданному закону параметров какого либо регулярного физического процесса.

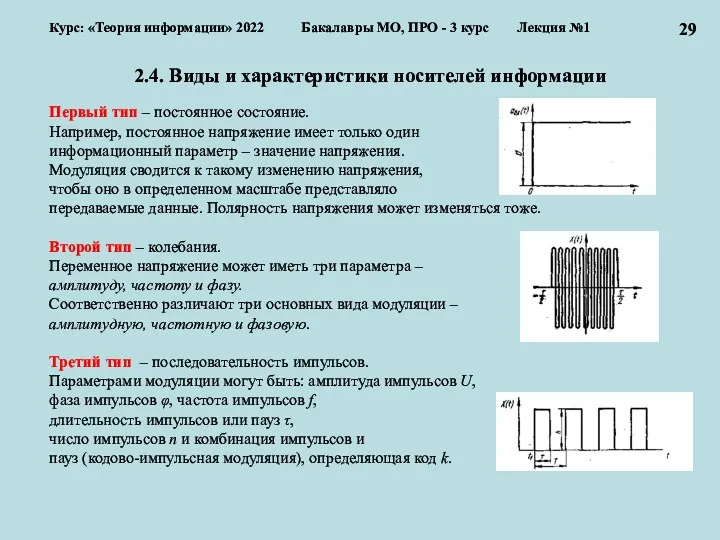

- 13. 2.4. Виды и характеристики носителей информации Первый тип – постоянное состояние. Например, постоянное напряжение имеет только

- 14. Лекция № 1 30 2.1 Информация и теория информации 2.2 Сообщения и сигналы 2.3 Структурная схема

- 15. 2.5. Классификация сигналов (1) 31 Математическая модель – это искусственно созданный объект в виде математических, знаковых

- 16. 2.5. Классификация сигналов (2) Как могут быть классифицированы данные фигуры? По форме: овал, треугольник, ромб, пятиугольник

- 17. 2.5. Классификация сигналов (3) 33 Характер изменений по времени: непрерывные и дискретные. Непрерывные по времени сообщения

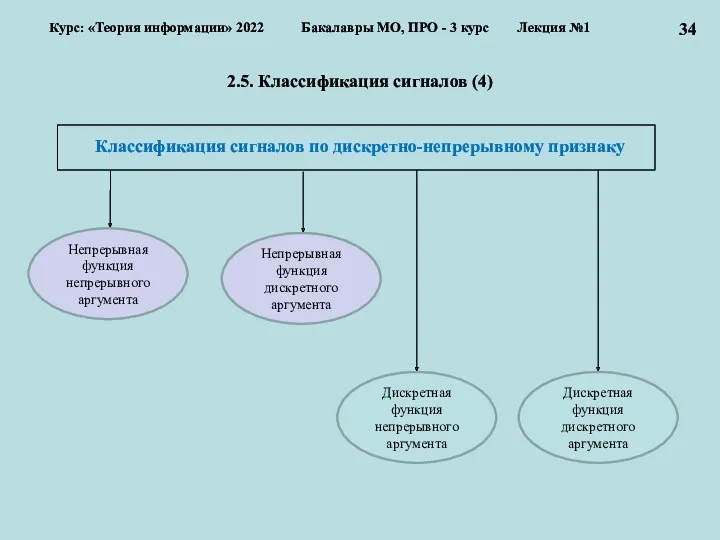

- 18. 34 Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3 курс Лекция №1 2.5. Классификация сигналов

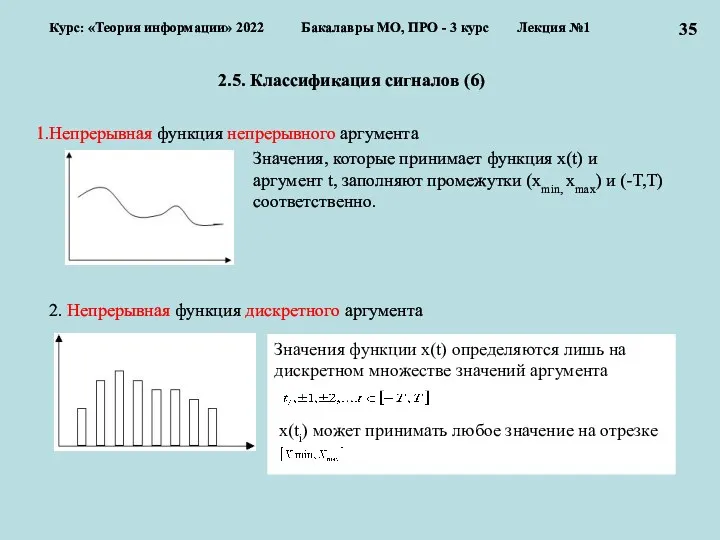

- 19. 2.5. Классификация сигналов (6) Непрерывная функция непрерывного аргумента 2. Непрерывная функция дискретного аргумента 35 Курс: «Теория

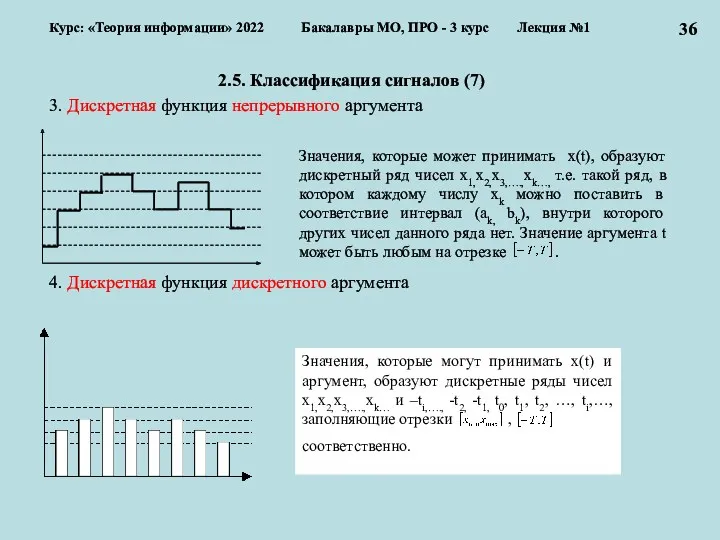

- 20. 2.5. Классификация сигналов (7) 3. Дискретная функция непрерывного аргумента 4. Дискретная функция дискретного аргумента 36 Курс:

- 21. Лекция № 1 37 2.1 Информация и теории информации 2.2. Сообщения и сигналы 2.3 Структурная схема

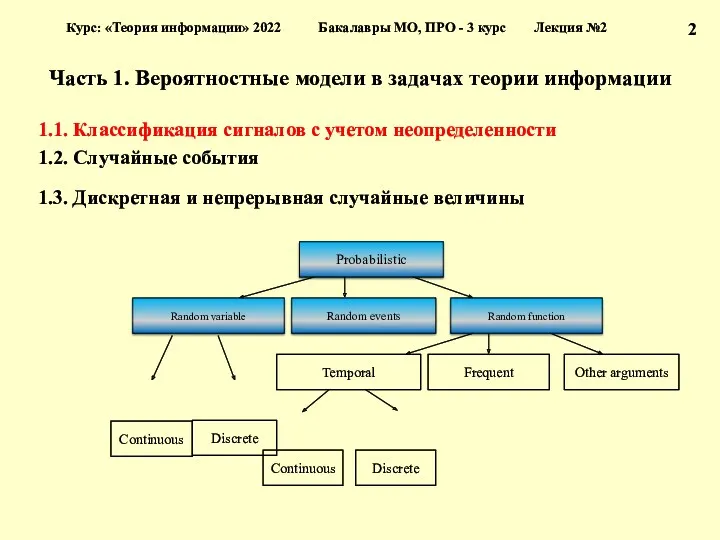

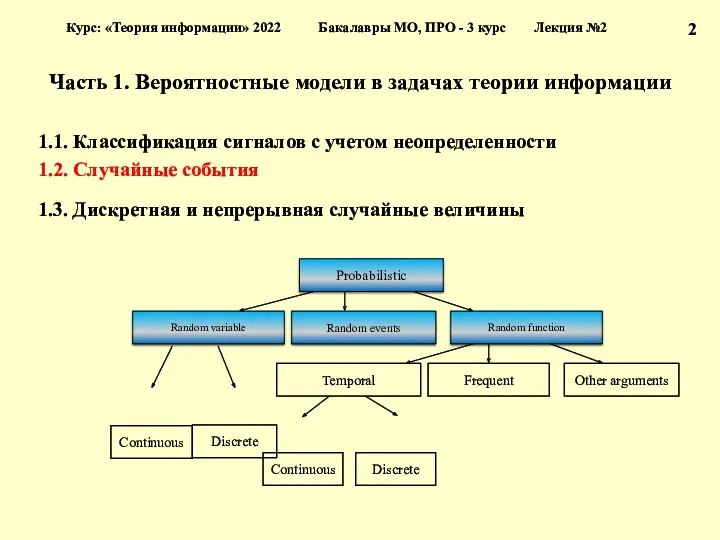

- 22. Часть 1. Вероятностные модели в задачах теории информации 1.1. Классификация сигналов с учетом неопределенности 1.2. Случайные

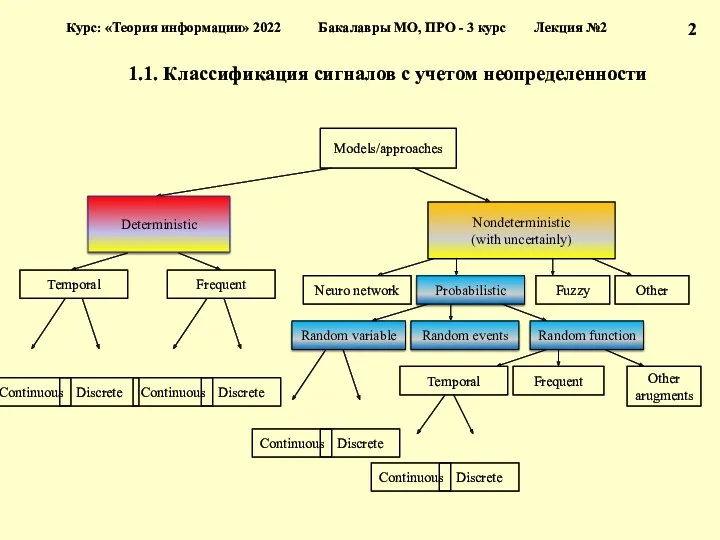

- 23. 1.1. Классификация сигналов с учетом неопределенности 2 Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3

- 24. Часть 1. Вероятностные модели в задачах теории информации 1.1. Классификация сигналов с учетом неопределенности 1.2. Случайные

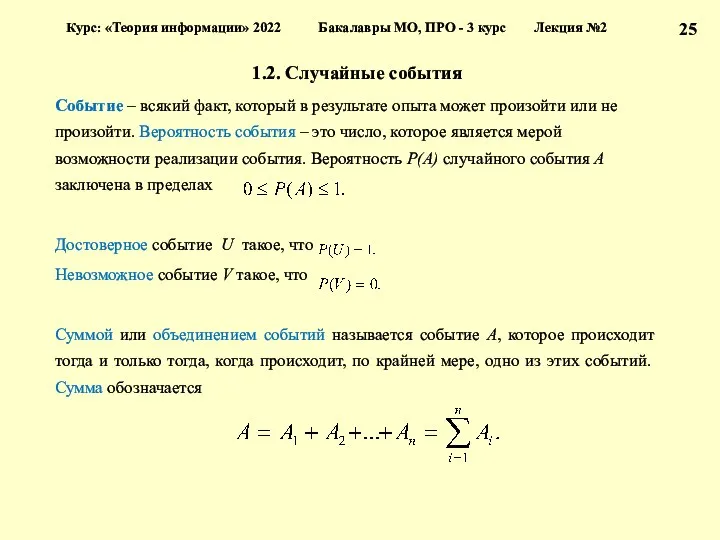

- 25. 1.2. Случайные события Событие – всякий факт, который в результате опыта может произойти или не произойти.

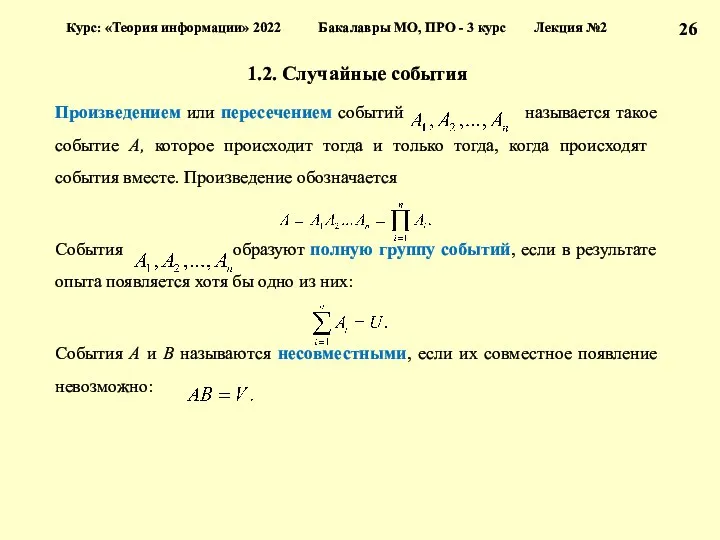

- 26. 1.2. Случайные события Произведением или пересечением событий называется такое событие A, которое происходит тогда и только

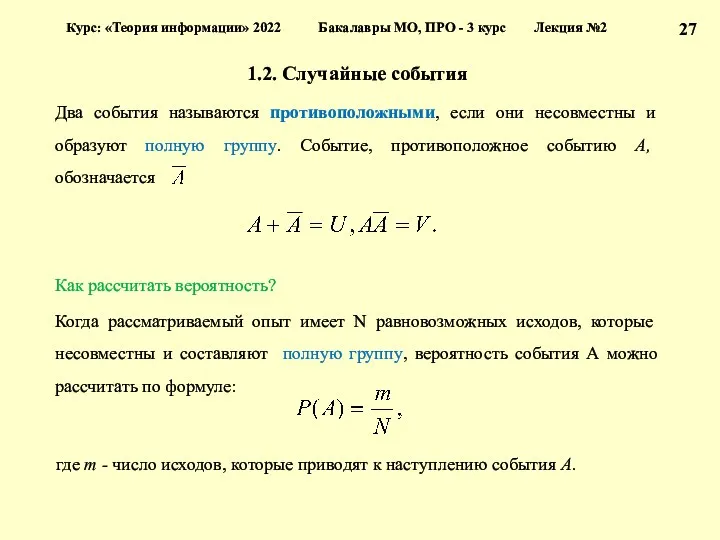

- 27. 1.2. Случайные события Два события называются противоположными, если они несовместны и образуют полную группу. Событие, противоположное

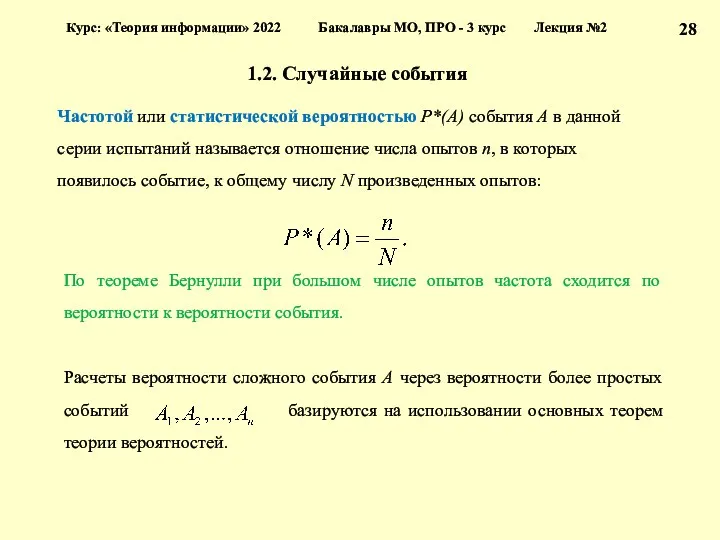

- 28. 1.2. Случайные события Частотой или статистической вероятностью P*(A) события A в данной серии испытаний называется отношение

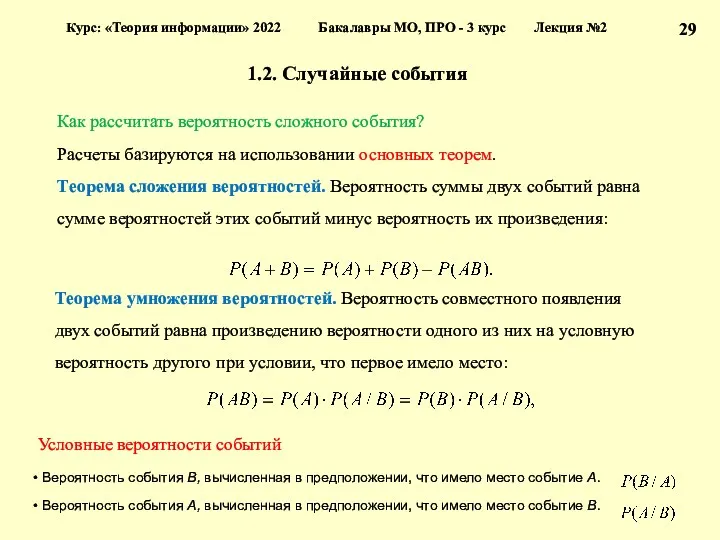

- 29. 1.2. Случайные события Как рассчитать вероятность сложного события? Расчеты базируются на использовании основных теорем. Теорема сложения

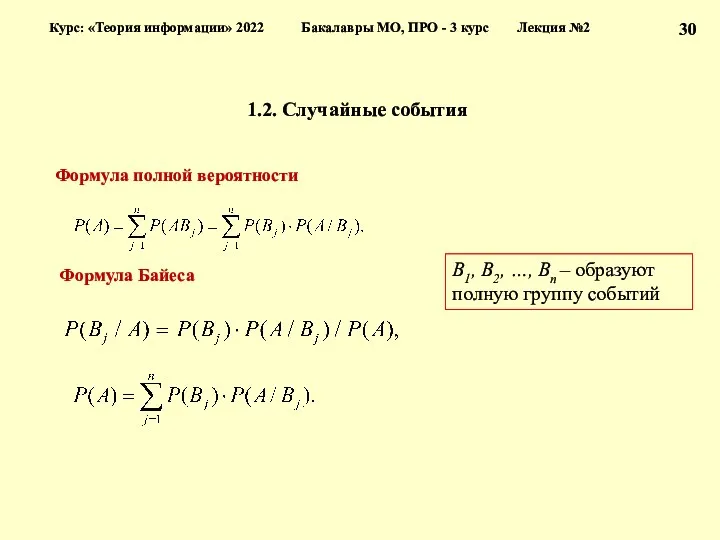

- 30. 1.2. Случайные события Формула полной вероятности Формула Байеса Курс: «Теория информации» 2022 Бакалавры МО, ПРО -

- 31. Часть 1. Вероятностные модели в задачах теории информации 1.1. Классификация сигналов с учетом неопределенности 1.2. Случайные

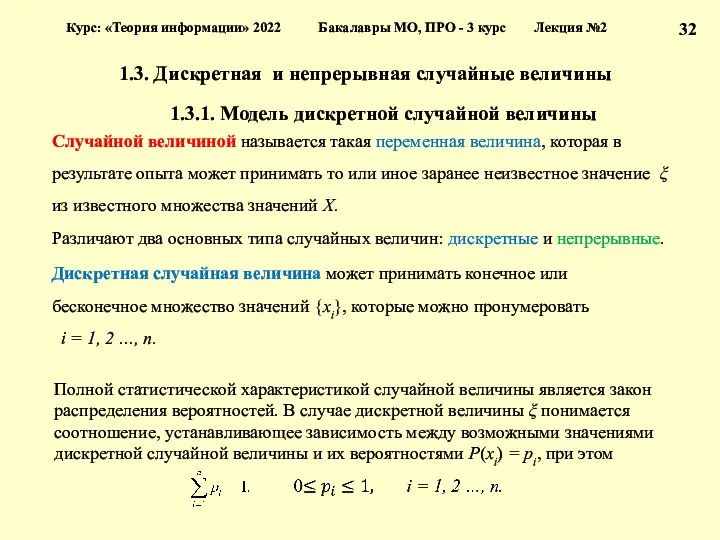

- 32. 1.3. Дискретная и непрерывная случайные величины 1.3.1. Модель дискретной случайной величины Случайной величиной называется такая переменная

- 33. 1.3.1. Дискретная случайная величина Закон распределения случайной величины можно задать в различных формах: табличный графический аналитический

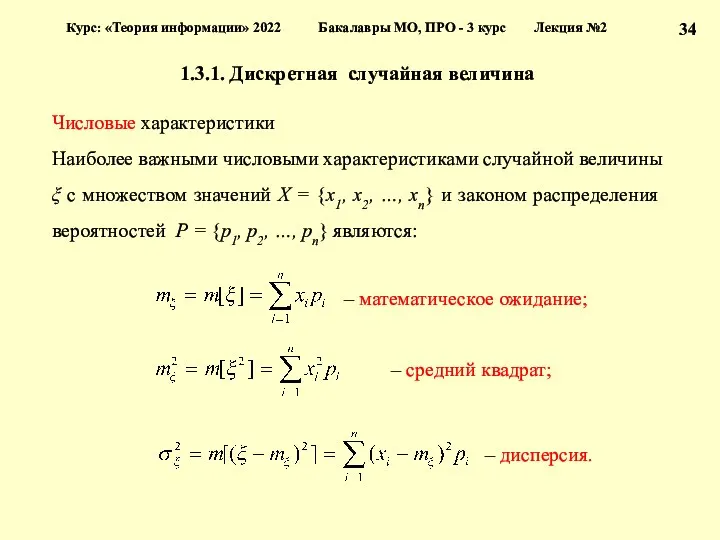

- 34. 1.3.1. Дискретная случайная величина Числовые характеристики Наиболее важными числовыми характеристиками случайной величины ξ с множеством значений

- 35. 1.3. Дискретная и непрерывная случайные величины 1.3.2. Модель непрерывной случайной величины Непрерывная случайная величина может принимать

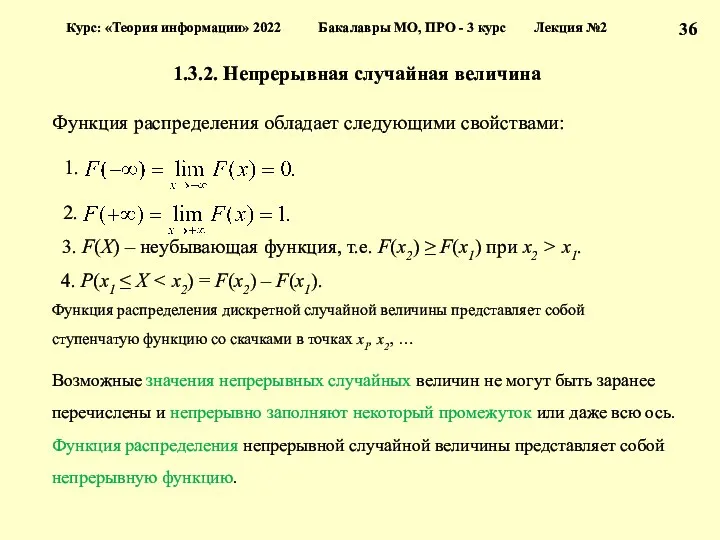

- 36. 1.3.2. Непрерывная случайная величина Функция распределения обладает следующими свойствами: 3. F(X) – неубывающая функция, т.е. F(x2)

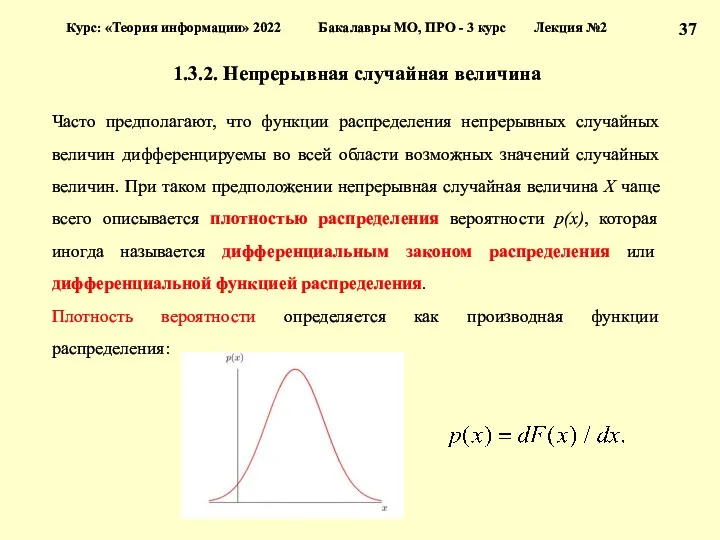

- 37. 1.3.2. Непрерывная случайная величина Часто предполагают, что функции распределения непрерывных случайных величин дифференцируемы во всей области

- 38. 1.3.2. Непрерывная случайная величина Плотность вероятности обладает следующими основными свойствами: 1. Плотность вероятности неотрицательна, т.е. p(x)

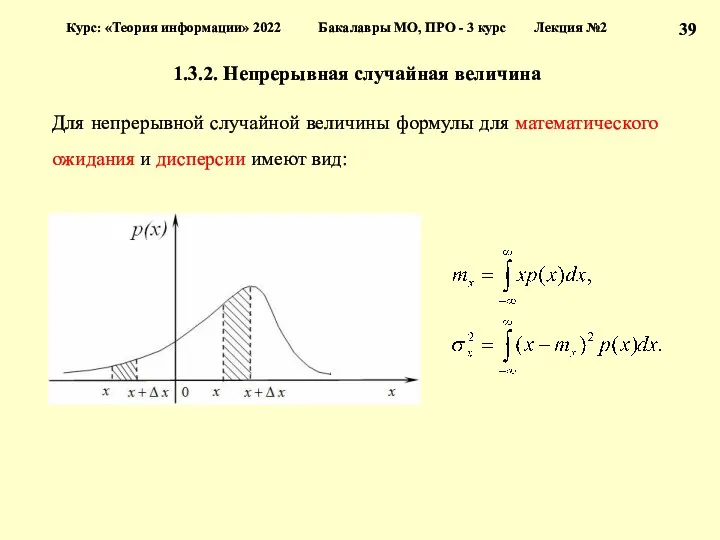

- 39. 1.3.2. Непрерывная случайная величина Для непрерывной случайной величины формулы для математического ожидания и дисперсии имеют вид:

- 40. Лекция № 2 Часть 2. Измерение информации 2.1. Информация и теории информации 2.2. Структурные меры информации

- 41. Часть 2. Измерение информации 2.1. Информация и теории информации 2.2. Структурные меры информации 2.3. Меры информации.

- 42. 2.1. Информация и теории информации Информация (лат. Information – разъяснение, изложение, осведомленность) – одно из общих

- 43. Информация и теории информации Теории информации Структурная теория информации рассматривает структуру построения отдельных информационных сообщений. Единица

- 44. Часть 2. Измерение информации 2.1. Информация и теории информации 2.2. Структурные меры информации 2.3. Меры информации.

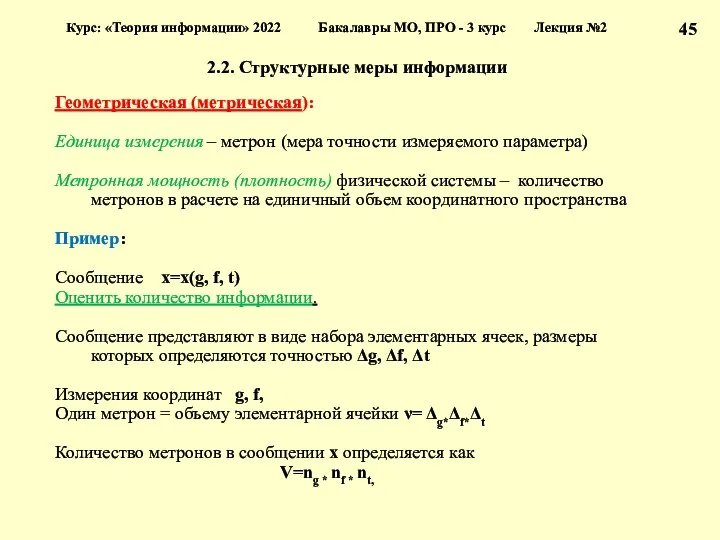

- 45. 2.2. Структурные меры информации Геометрическая (метрическая): Единица измерения – метрон (мера точности измеряемого параметра) Метронная мощность

- 46. 2.2. Структурные меры информации ng=g(tc)/Δg, nf=f(tc)/Δf, nt=tc/Δt – количество метронов, обусловленное точностью измерения координат g, f,

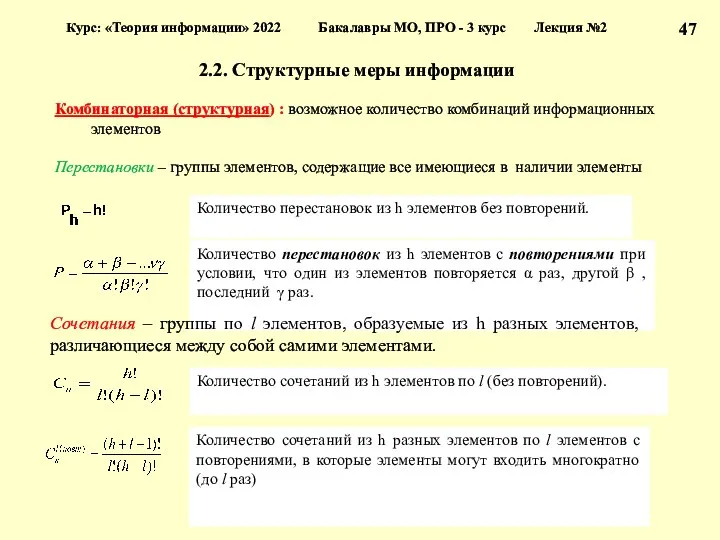

- 47. 2.2. Структурные меры информации Комбинаторная (структурная) : возможное количество комбинаций информационных элементов Перестановки – группы элементов,

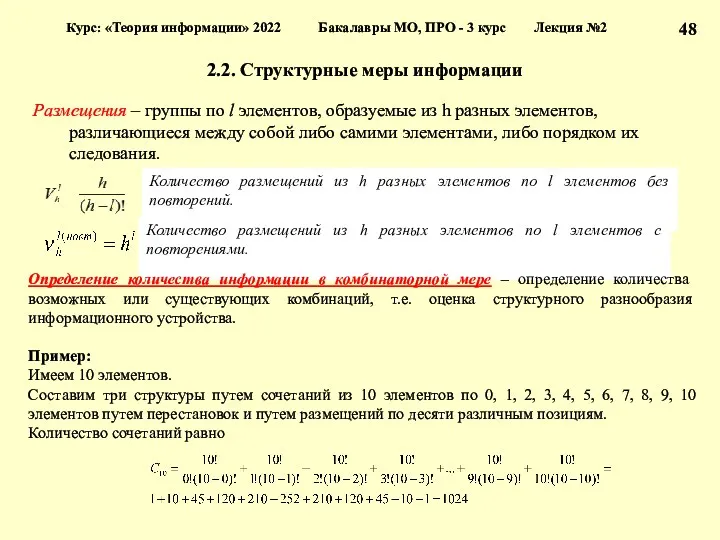

- 48. 2.2. Структурные меры информации Размещения – группы по l элементов, образуемые из h разных элементов, различающиеся

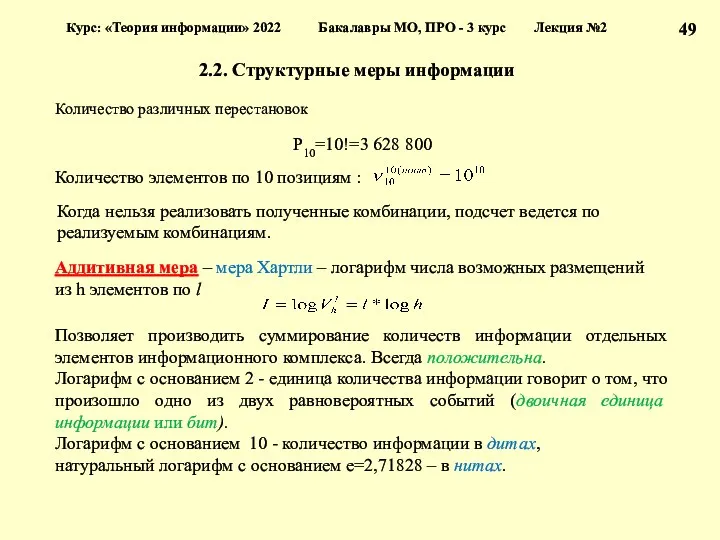

- 49. 2.2. Структурные меры информации Количество различных перестановок P10=10!=3 628 800 Количество элементов по 10 позициям :

- 50. Часть 2. Измерение информации 2.1. Информация и теории информации 2.2. Структурные меры информации 2.3. Меры информации.

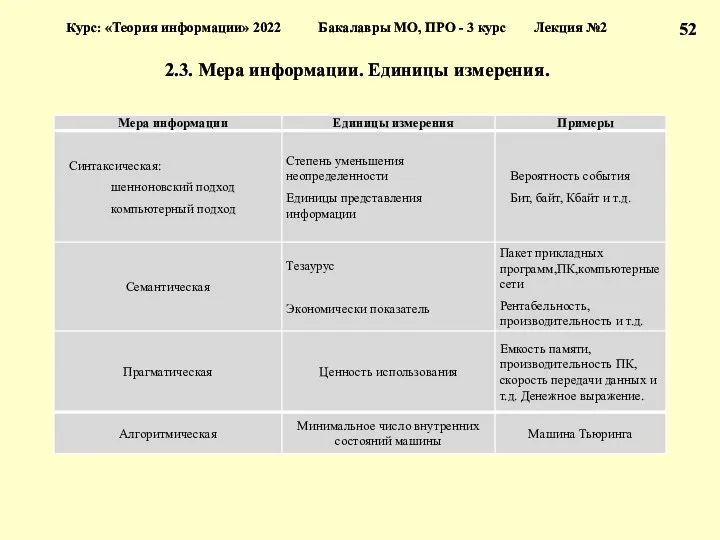

- 51. 2.3. Мера информации. Единицы измерения. Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3 курс Лекция

- 52. 2.3. Мера информации. Единицы измерения. Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3 курс Лекция

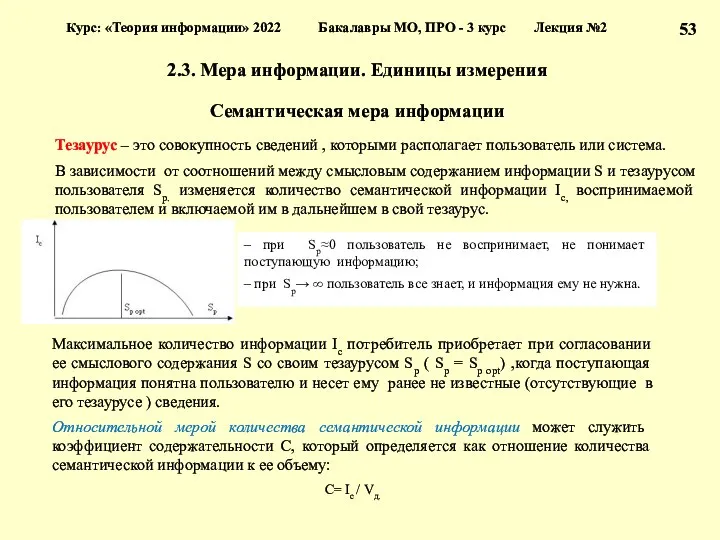

- 53. 2.3. Мера информации. Единицы измерения Семантическая мера информации Тезаурус – это совокупность сведений , которыми располагает

- 54. 2.3. Мера информации. Единицы измерения Прагматическая мера информации Эта мера определяет полезность информации (ценность) для достижения

- 55. 2.3. Мера информации. Единицы измерения Алгоритмическая мера информации Каждый согласится , что слово 0101….01 сложнее слова

- 56. Часть 2. Измерение информации 2.1. Информация и теории информации 2.2. Структурные меры информации 2.3. Меры информации.

- 57. 2.4. Качество информации Потребительские показатели качества: – репрезентативность, содержательность, достаточность – актуальность, своевременность, точность – достоверность,

- 58. 2.4. Качество информации Достаточность (полнота) означает, что она содержит минимальный , но достаточный для принятия правильного

- 59. 2.4. Качество информации Точность информации определяется степенью близости получаемой информации к реальному состоянию объекта, процесса, явления

- 60. 2.4. Качество информации Устойчивость информации отражает ее способность реагировать на изменения исходных данных без нарушения необходимой

- 61. Лекция № 2 Часть 1. Вероятностные модели в задачах теории информации 1.1. Классификация сигналов с учетом

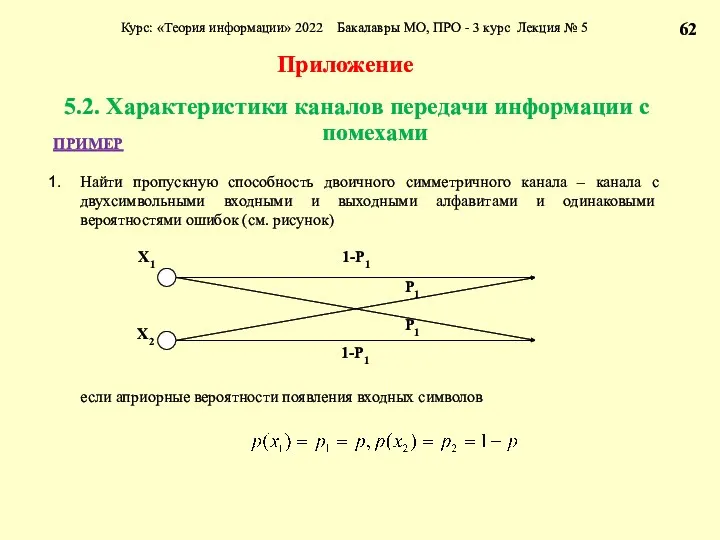

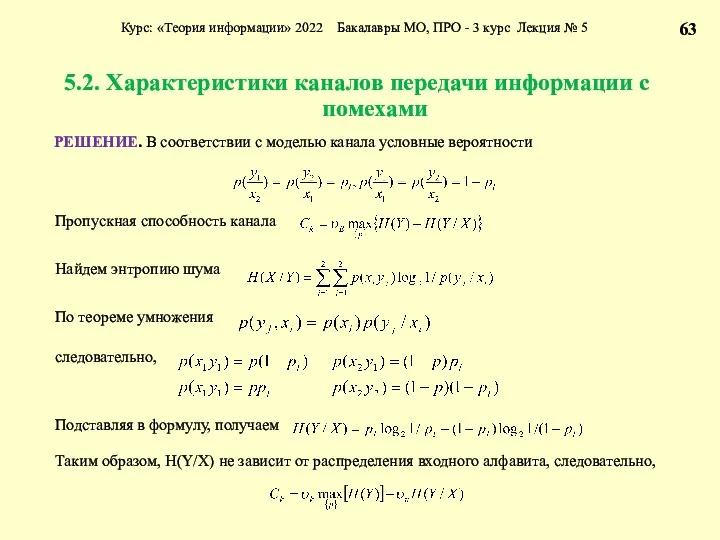

- 62. 5.2. Характеристики каналов передачи информации с помехами Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3

- 63. 5.2. Характеристики каналов передачи информации с помехами Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3

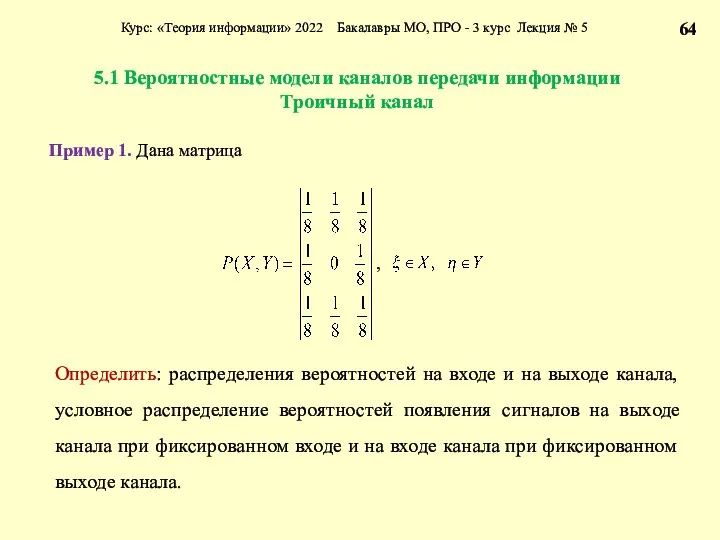

- 64. 5.1 Вероятностные модели каналов передачи информации Троичный канал Курс: «Теория информации» 2022 Бакалавры МО, ПРО -

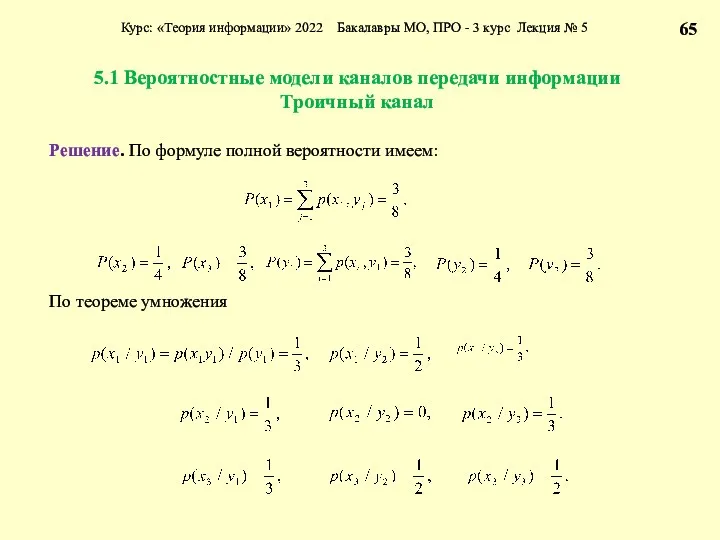

- 65. 5.1 Вероятностные модели каналов передачи информации Троичный канал Курс: «Теория информации» 2022 Бакалавры МО, ПРО -

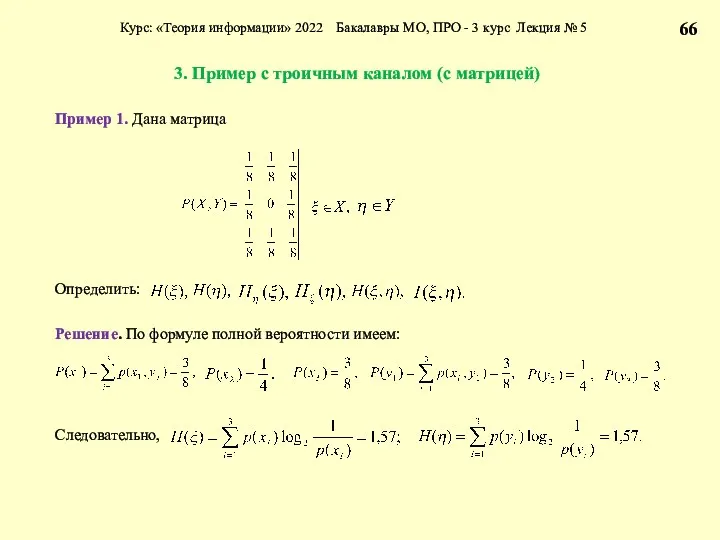

- 66. 3. Пример с троичным каналом (с матрицей) Курс: «Теория информации» 2022 Бакалавры МО, ПРО - 3

- 68. Скачать презентацию

Защита корпоративного сервера на базе Linux–сервера

Защита корпоративного сервера на базе Linux–сервера Классификация оборудования сетей NGN. Переход от телефонной сети общего пользования к мультисервисной сети

Классификация оборудования сетей NGN. Переход от телефонной сети общего пользования к мультисервисной сети Как победить умную ленту ВКонтакте

Как победить умную ленту ВКонтакте Программное обеспечение ГИС. Лекция 18

Программное обеспечение ГИС. Лекция 18 Надійність, діагностика та експлуатація комп’ютерних систем та мереж

Надійність, діагностика та експлуатація комп’ютерних систем та мереж Программное обеспечение ПК

Программное обеспечение ПК Расчетные методики ПП ЭкоСфера-предприятие. Расчет выбросов от автотранспорта (Автомойка)

Расчетные методики ПП ЭкоСфера-предприятие. Расчет выбросов от автотранспорта (Автомойка) Модульное программирование

Модульное программирование Introduction to Information Security. Basic Terminology

Introduction to Information Security. Basic Terminology Применение ИКТ на уроках физики для контроля знаний учащихся

Применение ИКТ на уроках физики для контроля знаний учащихся Интернет вещей

Интернет вещей Создание WEB-сайта Магазин бытовой электроники

Создание WEB-сайта Магазин бытовой электроники Средства массовой информации

Средства массовой информации Кодирование информации

Кодирование информации Организационное обеспечение информационной безопасности

Организационное обеспечение информационной безопасности Экспертные системы

Экспертные системы Межсетевой уровень TCPIP (часть 2)

Межсетевой уровень TCPIP (часть 2) Курс Javascript

Курс Javascript Группа Компаний СДЭК. Логистические решения

Группа Компаний СДЭК. Логистические решения Введение в XML

Введение в XML Использование информационно- коммуникационных технологий (ИКТ) на уроках английского языка

Использование информационно- коммуникационных технологий (ИКТ) на уроках английского языка Процедуры и функции в Паскале

Процедуры и функции в Паскале История развития компьютеров

История развития компьютеров Основы программирования

Основы программирования Администрирование информационных систем. Введение

Администрирование информационных систем. Введение Programming Logic and Design Seventh Edition. Chapter 4. Making Decisions

Programming Logic and Design Seventh Edition. Chapter 4. Making Decisions От печатной книги до интернет-книги

От печатной книги до интернет-книги Юные мыслители

Юные мыслители