Содержание

- 2. Теория информации Задача − представление сообщений из заданного дискретного множества последовательностью символов, принадлежащих заданному алфавиту. Цель

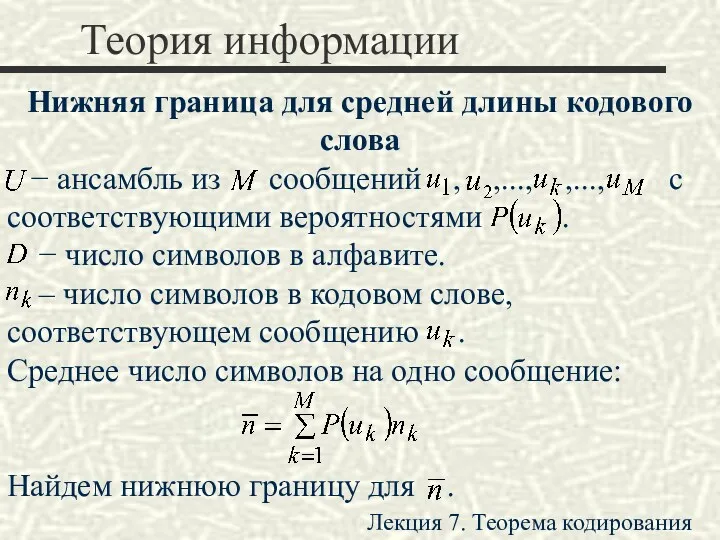

- 3. Теория информации Нижняя граница для средней длины кодового слова − ансамбль из сообщений , ,..., ,...,

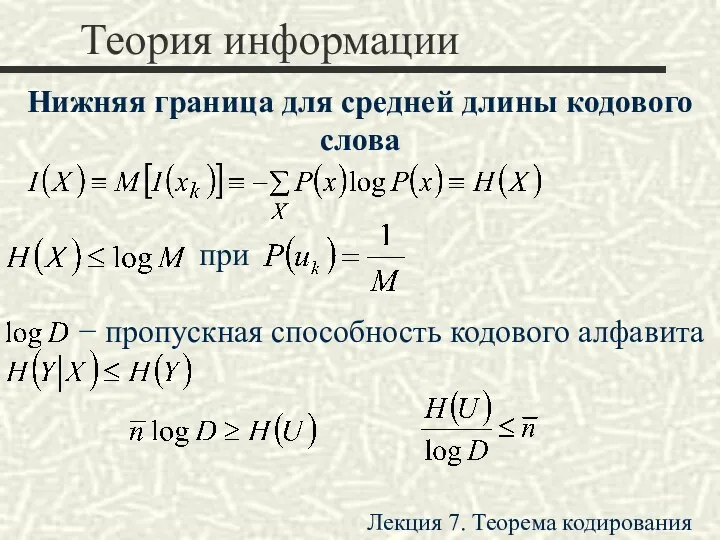

- 4. Теория информации Нижняя граница для средней длины кодового слова при − пропускная способность кодового алфавита Лекция

- 5. Теория информации Общие правила конструирования кодовых слов со средней длиной, достаточно близкой к нижней границе по

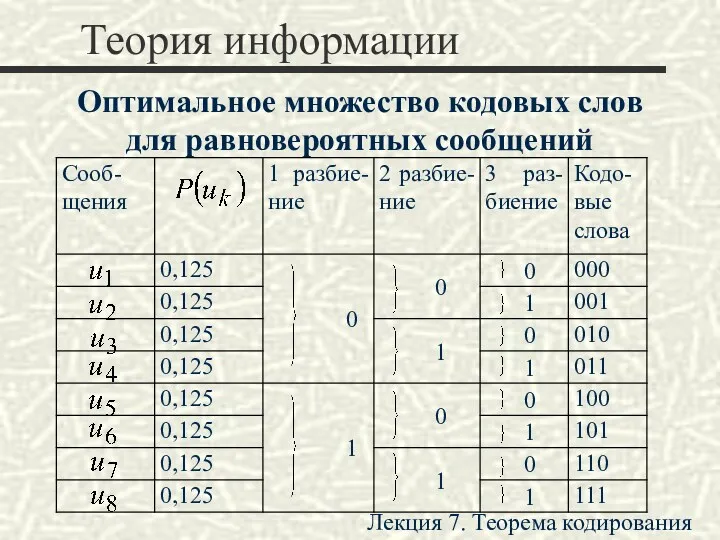

- 6. Теория информации Оптимальное множество кодовых слов для равновероятных сообщений Лекция 7. Теорема кодирования

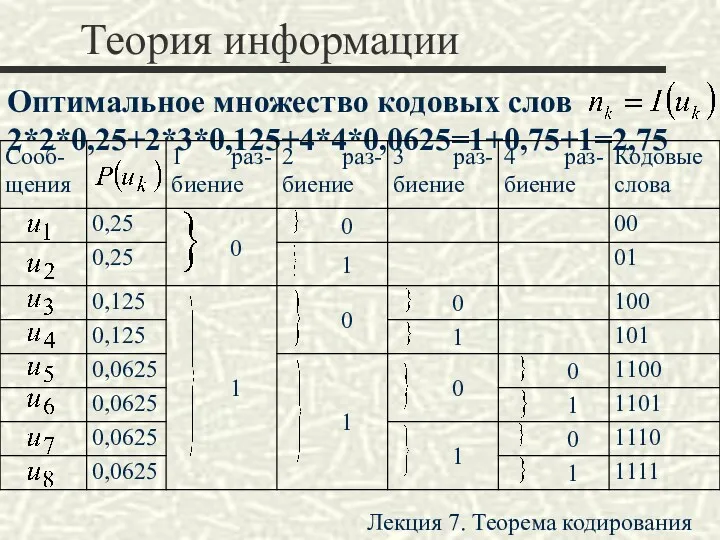

- 7. Теория информации Оптимальное множество кодовых слов 2*2*0,25+2*3*0,125+4*4*0,0625=1+0,75+1=2,75 Лекция 7. Теорема кодирования

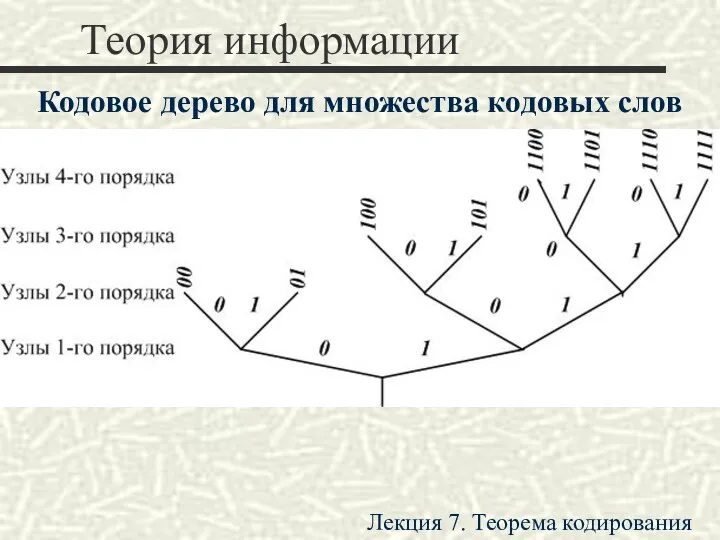

- 8. Теория информации Кодовое дерево для множества кодовых слов Лекция 7. Теорема кодирования

- 9. Теория информации Кодовое дерево для множества кодовых слов Сообщения могут быть сопоставлены только концевым узлам, иначе

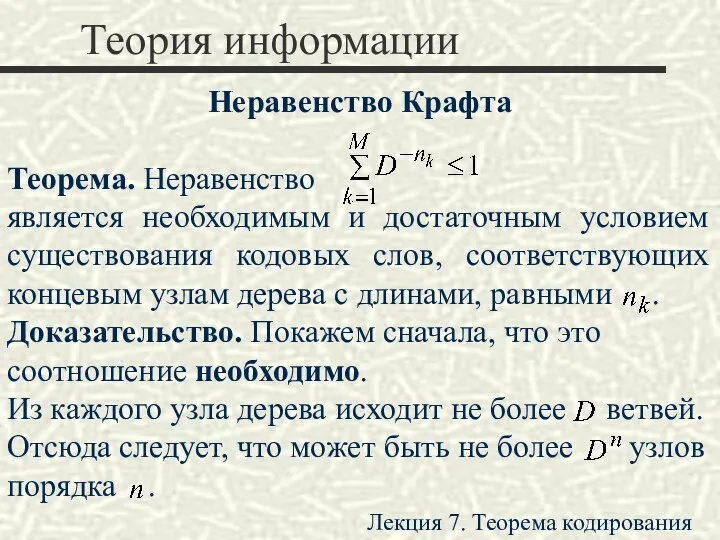

- 10. Теория информации Неравенство Крафта Теорема. Неравенство является необходимым и достаточным условием существования кодовых слов, соответствующих концевым

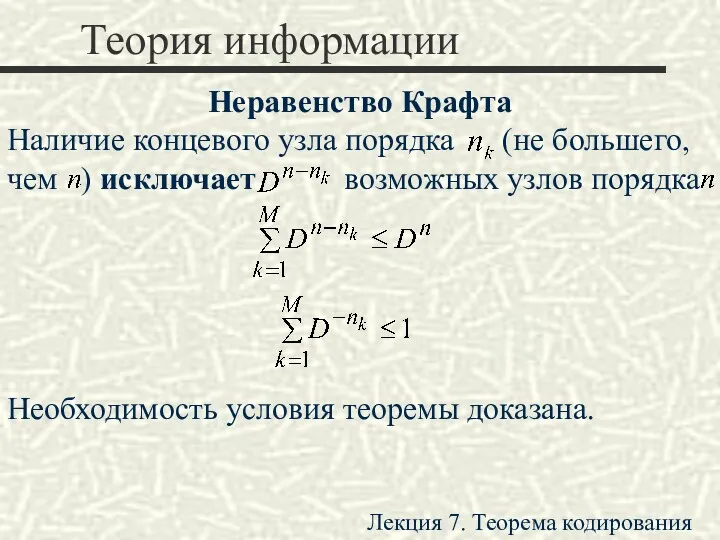

- 11. Теория информации Неравенство Крафта Наличие концевого узла порядка (не большего, чем ) исключает возможных узлов порядка

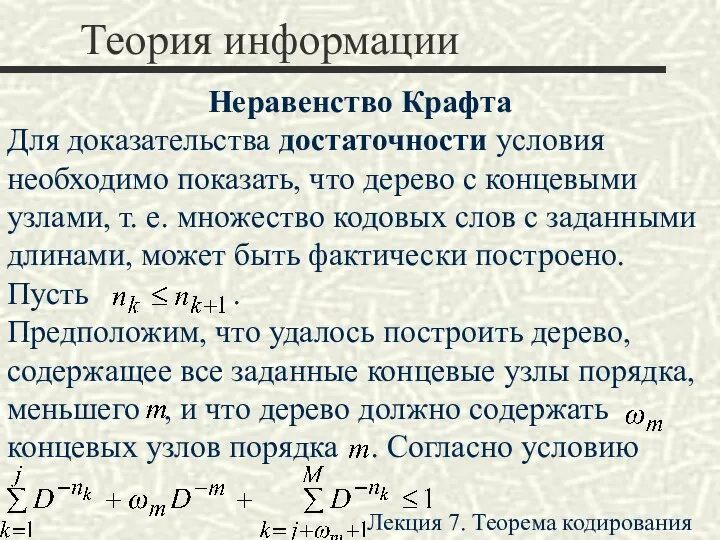

- 12. Теория информации Неравенство Крафта Для доказательства достаточности условия необходимо показать, что дерево с концевыми узлами, т.

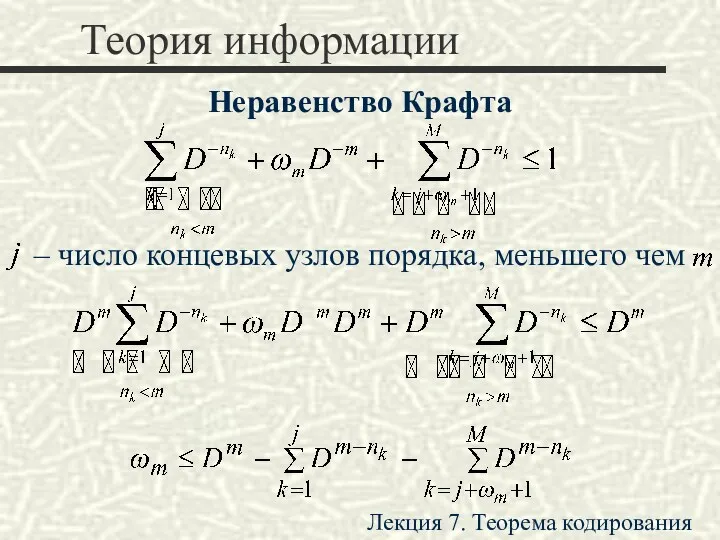

- 13. Теория информации Неравенство Крафта – число концевых узлов порядка, меньшего чем Лекция 7. Теорема кодирования

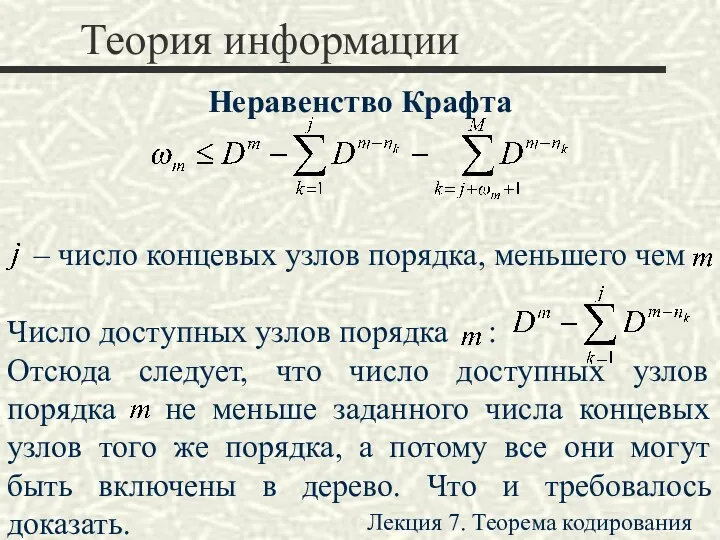

- 14. Теория информации Неравенство Крафта – число концевых узлов порядка, меньшего чем Число доступных узлов порядка :

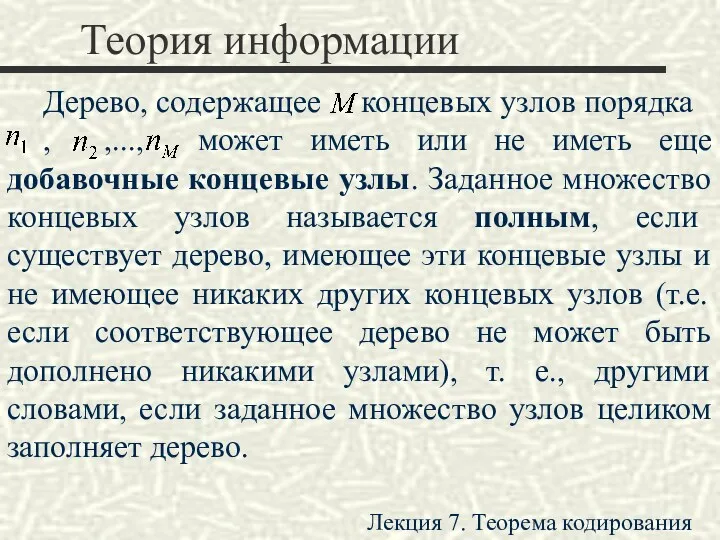

- 15. Теория информации Дерево, содержащее концевых узлов порядка , ,..., может иметь или не иметь еще добавочные

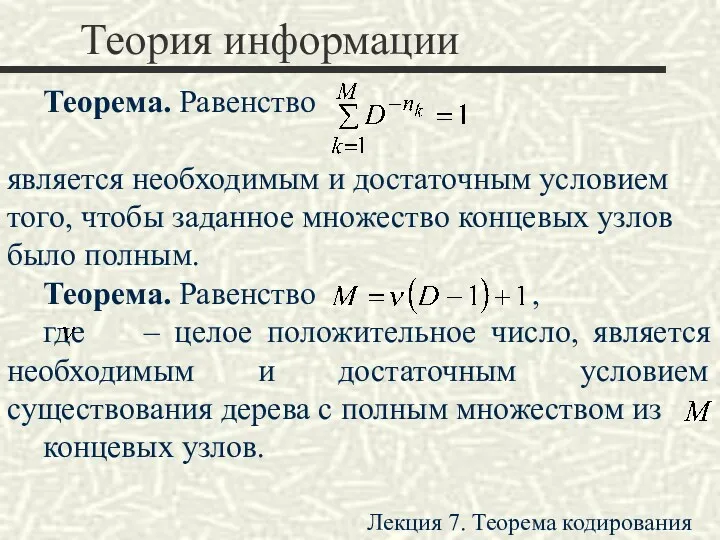

- 16. Теория информации Теорема. Равенство является необходимым и достаточным условием того, чтобы заданное множество концевых узлов было

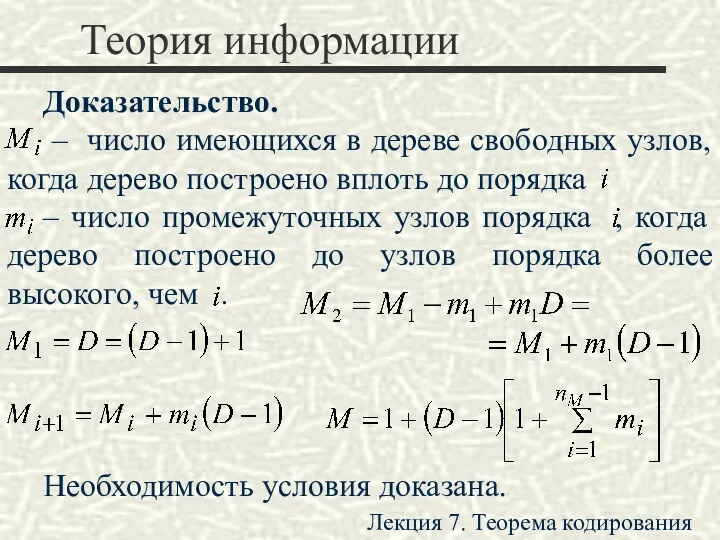

- 17. Теория информации Доказательство. – число имеющихся в дереве свободных узлов, когда дерево построено вплоть до порядка

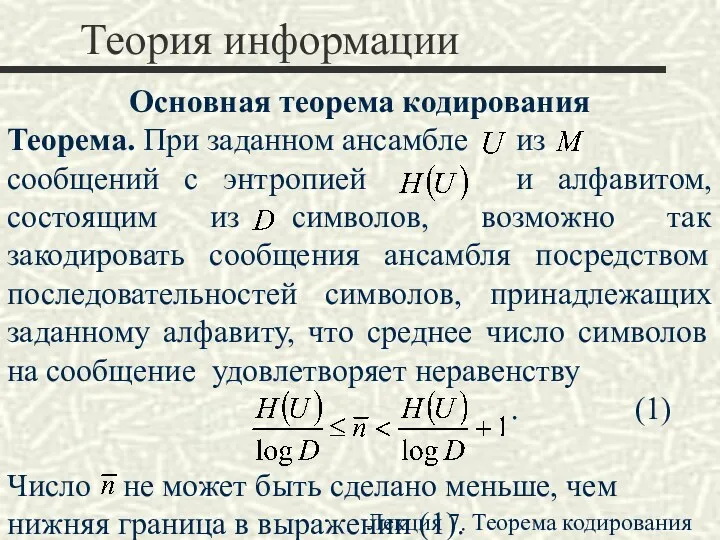

- 18. Теория информации Основная теорема кодирования Теорема. При заданном ансамбле из сообщений с энтропией и алфавитом, состоящим

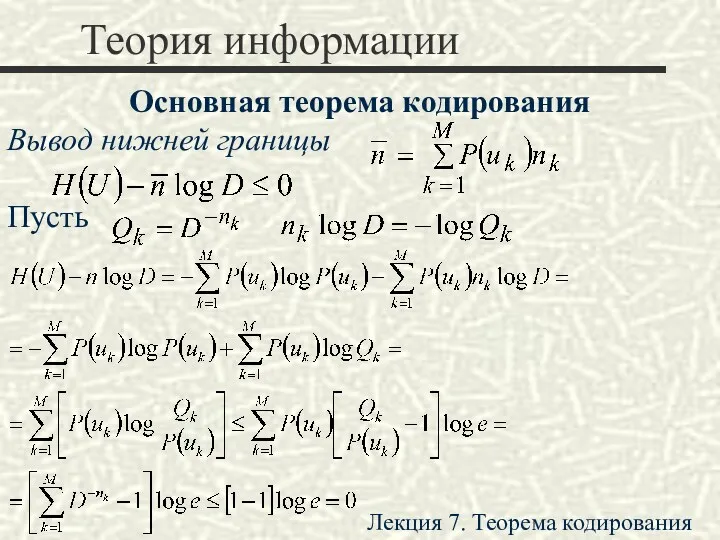

- 19. Теория информации Основная теорема кодирования Вывод нижней границы Пусть Лекция 7. Теорема кодирования

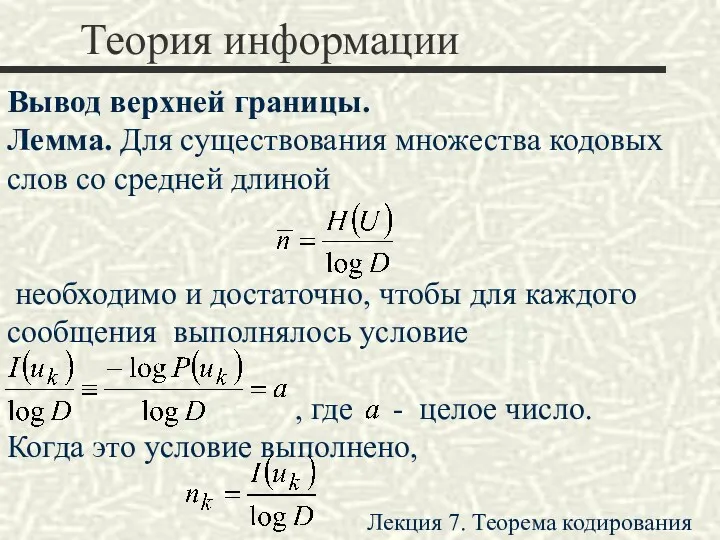

- 20. Теория информации Вывод верхней границы. Лемма. Для существования множества кодовых слов со средней длиной необходимо и

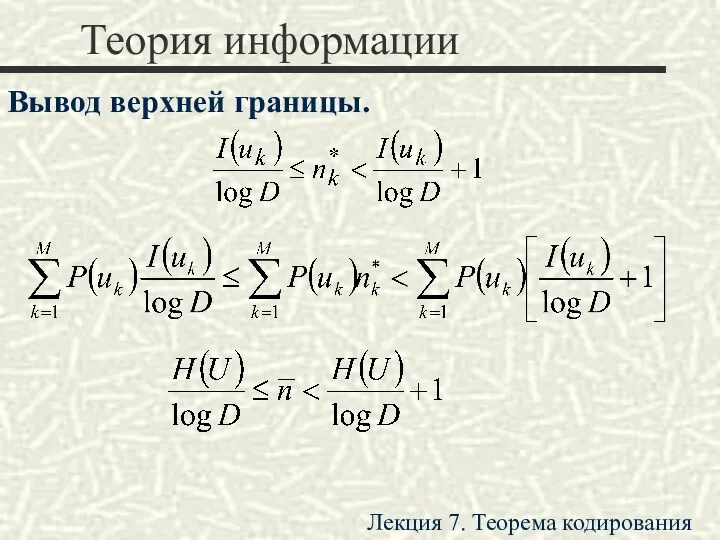

- 21. Теория информации Вывод верхней границы. Лекция 7. Теорема кодирования

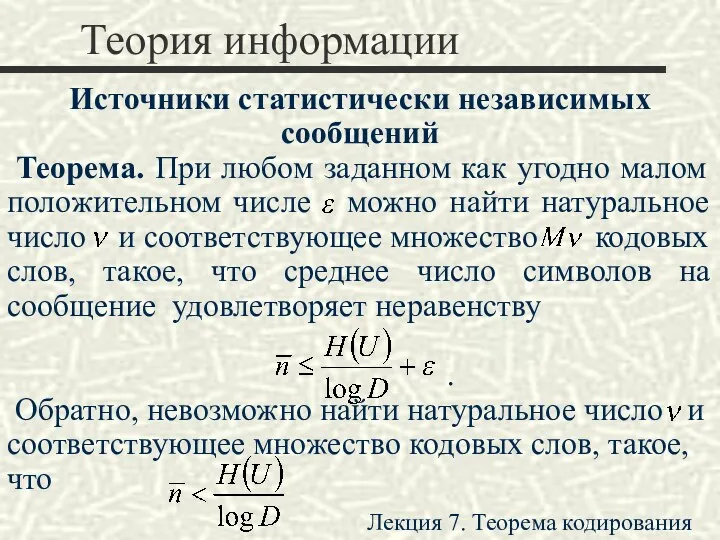

- 22. Теория информации Источники статистически независимых сообщений Теорема. При любом заданном как угодно малом положительном числе можно

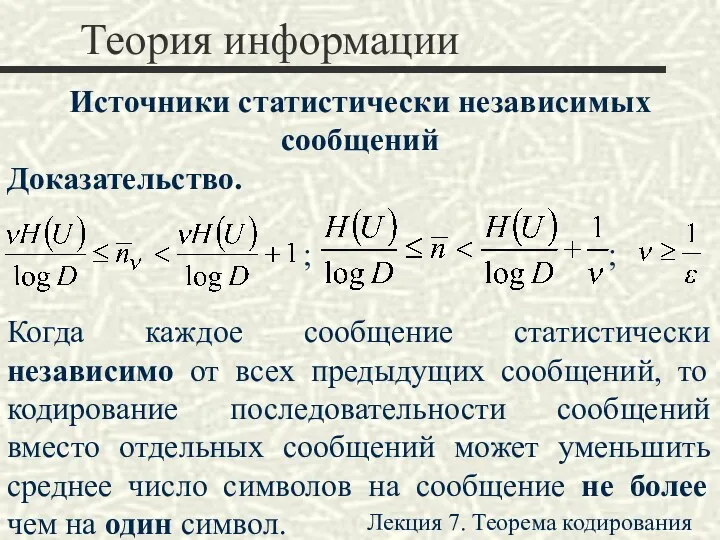

- 23. Теория информации Источники статистически независимых сообщений Доказательство. ; ; Когда каждое сообщение статистически независимо от всех

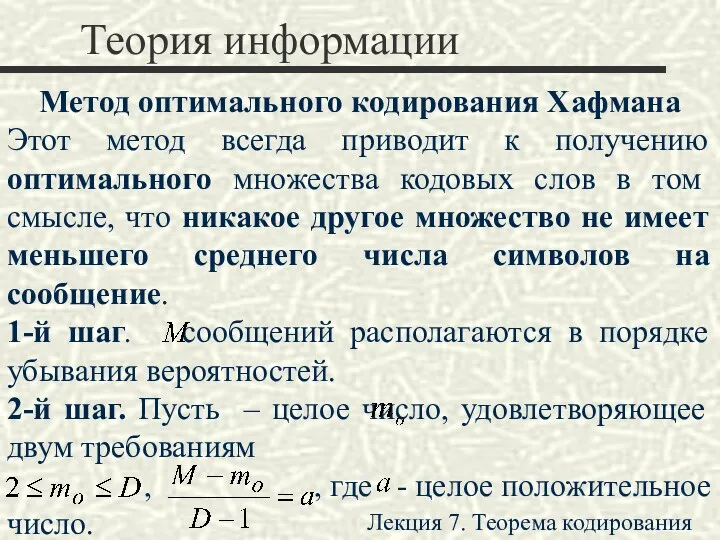

- 24. Теория информации Метод оптимального кодирования Хафмана Этот метод всегда приводит к получению оптимального множества кодовых слов

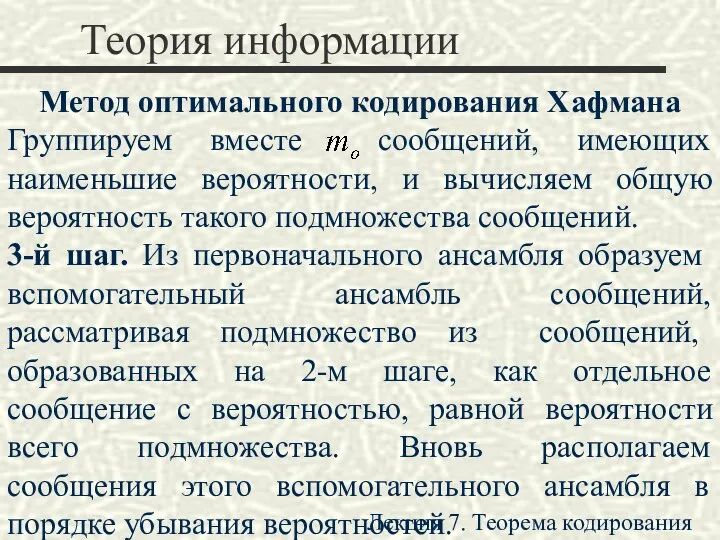

- 25. Теория информации Метод оптимального кодирования Хафмана Группируем вместе сообщений, имеющих наименьшие вероятности, и вычисляем общую вероятность

- 26. Теория информации Метод оптимального кодирования Хафмана 4-й шаг. Образуем подмножество из D сообщений вспомогательного ансамбля, имеющих

- 27. Теория информации Метод оптимального кодирования Хафмана 6-й шаг. Образуем последовательные вспомогательные ансамбли путем повторения 4-го и

- 28. Теория информации Оптимальное множество двоичных кодовых слов Лекция 7. Теорема кодирования

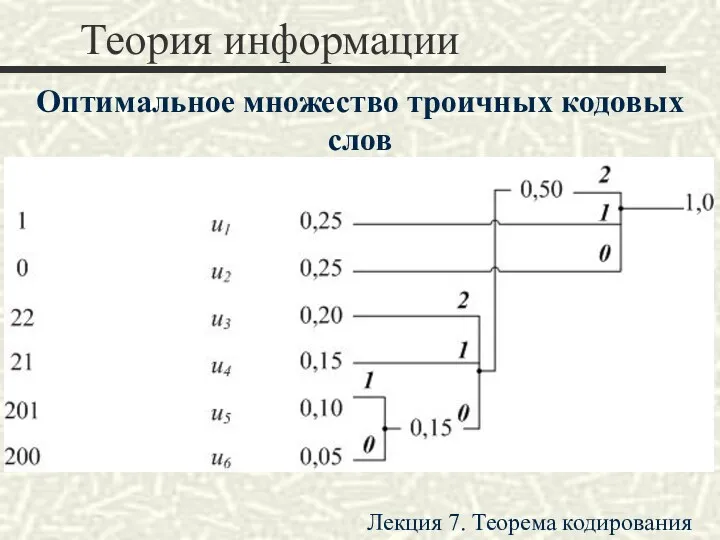

- 29. Теория информации Оптимальное множество троичных кодовых слов Лекция 7. Теорема кодирования

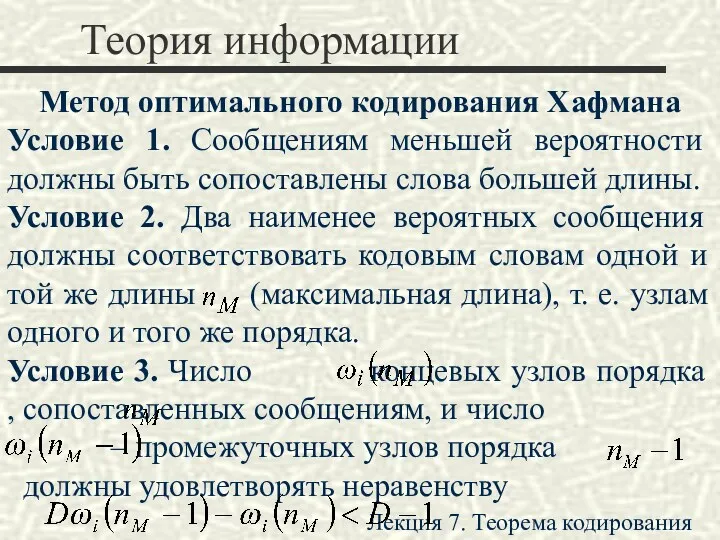

- 30. Теория информации Метод оптимального кодирования Хафмана Условие 1. Сообщениям меньшей вероятности должны быть сопоставлены слова большей

- 31. Теория информации Метод оптимального кодирования Хафмана Условие 4. Из каждого промежуточного узла порядка меньшего, чем ,

- 32. Теория информации Метод оптимального кодирования Хафмана Вспомогательное условие 6. Каждый промежуточный узел порядка, меньшего , должен

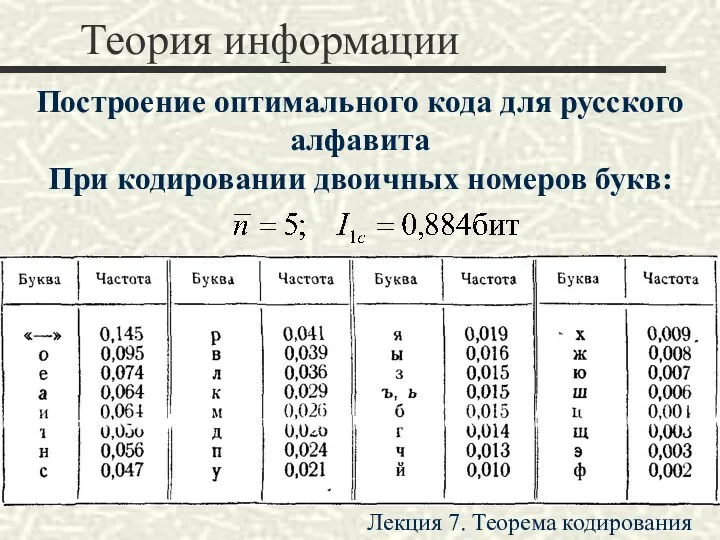

- 33. Теория информации Построение оптимального кода для русского алфавита При кодировании двоичных номеров букв: Лекция 7. Теорема

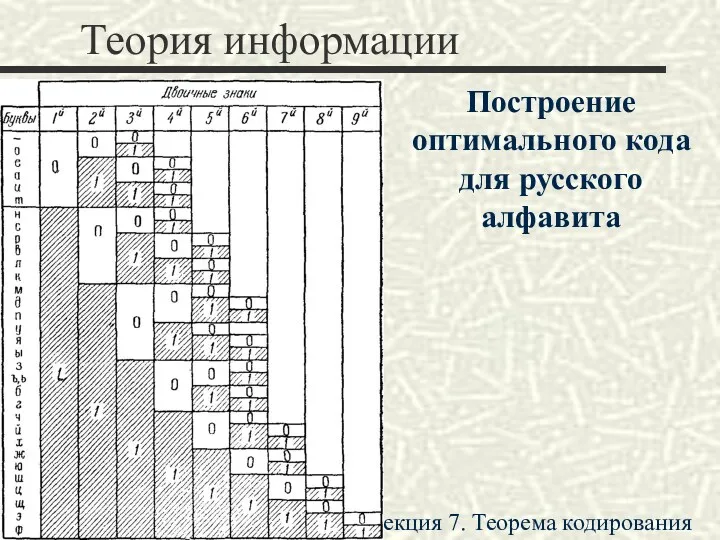

- 34. Теория информации Построение оптимального кода для русского алфавита Лекция 7. Теорема кодирования

- 36. Скачать презентацию

Формирование УУД при изучении графических и текстовых редакторов на уроках информатики и ИКТ

Формирование УУД при изучении графических и текстовых редакторов на уроках информатики и ИКТ Лайфхаки Word

Лайфхаки Word CSS (Cascading Style Sheets)

CSS (Cascading Style Sheets) История развития вычислительной техники

История развития вычислительной техники Машинно-ориентированные языки, язык ассемблера. Занятие 2

Машинно-ориентированные языки, язык ассемблера. Занятие 2 Кейіпкерлерді анимациялау

Кейіпкерлерді анимациялау IP-Телефония в NGN

IP-Телефония в NGN Урок Программирование циклических алгоритмов

Урок Программирование циклических алгоритмов Клавіатура. Алфавітно-цифрові клавіші

Клавіатура. Алфавітно-цифрові клавіші UX-дизайн: от хаоса к порядку

UX-дизайн: от хаоса к порядку Представление аналогового сигнала в цифровом виде (лекция 20)

Представление аналогового сигнала в цифровом виде (лекция 20) Представление информации в компьютере

Представление информации в компьютере Становление и развитие информационных технологий. Лекция 1

Становление и развитие информационных технологий. Лекция 1 Исследование аппаратного обеспечения компьютера и сетевого оборудования для организации работы школьного здания

Исследование аппаратного обеспечения компьютера и сетевого оборудования для организации работы школьного здания Технология XSD

Технология XSD Презентация к уроку Основные этапы разработки и исследования моделей на компьютере

Презентация к уроку Основные этапы разработки и исследования моделей на компьютере Апаратне та програмне забезпечення сучасного комп’ютера

Апаратне та програмне забезпечення сучасного комп’ютера Объекты и классы в PHP

Объекты и классы в PHP Технологии обработки графической информации

Технологии обработки графической информации Урок обобщение по теме Электрические явления.Молниеотвод

Урок обобщение по теме Электрические явления.Молниеотвод Обучающий тренинг №1 для операторов удаленного доступа

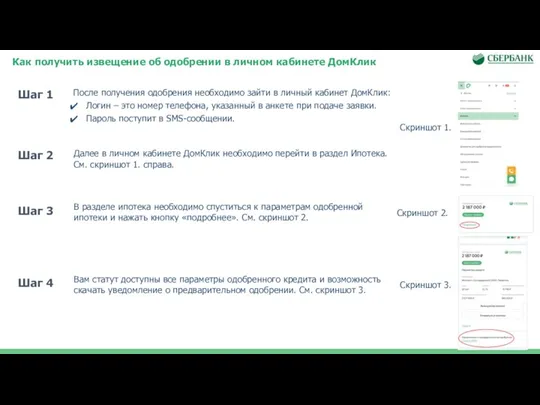

Обучающий тренинг №1 для операторов удаленного доступа Как получить извещение об одобрении в личном кабинете ДомКлик

Как получить извещение об одобрении в личном кабинете ДомКлик Своя игра по информатике, 4 класс

Своя игра по информатике, 4 класс Модули в Python

Модули в Python Блог учителя: новый инструмент для общения и обмена опытом. Как создать и вести свой блог. Российская компания ABBYY

Блог учителя: новый инструмент для общения и обмена опытом. Как создать и вести свой блог. Российская компания ABBYY Программное обеспечение конфигурации системы FX NET

Программное обеспечение конфигурации системы FX NET C & С++

C & С++ Необхідність стиску із втратами зображень, звуку, відео

Необхідність стиску із втратами зображень, звуку, відео