Содержание

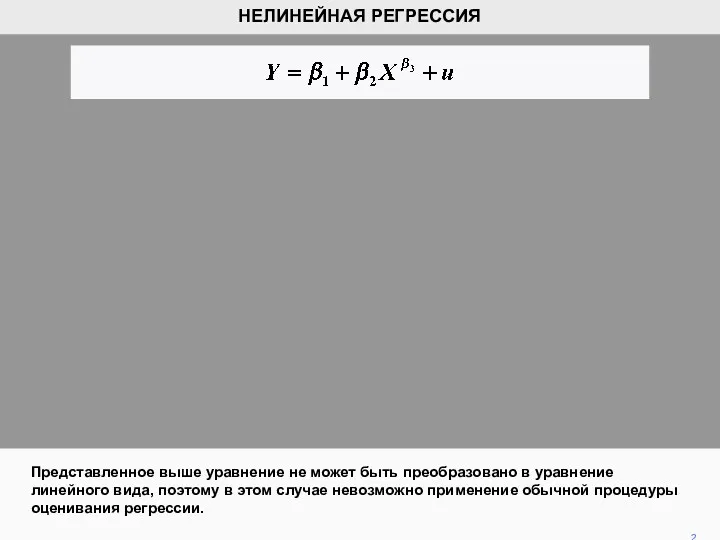

- 2. Представленное выше уравнение не может быть преобразовано в уравнение линейного вида, поэтому в этом случае невозможно

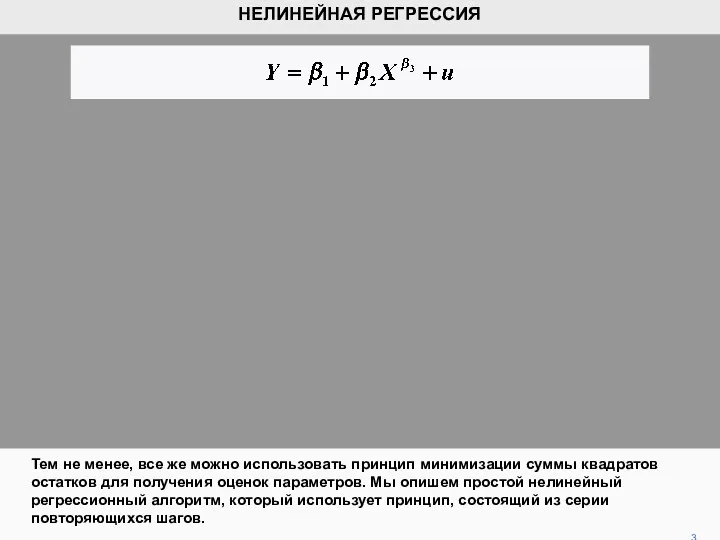

- 3. Тем не менее, все же можно использовать принцип минимизации суммы квадратов остатков для получения оценок параметров.

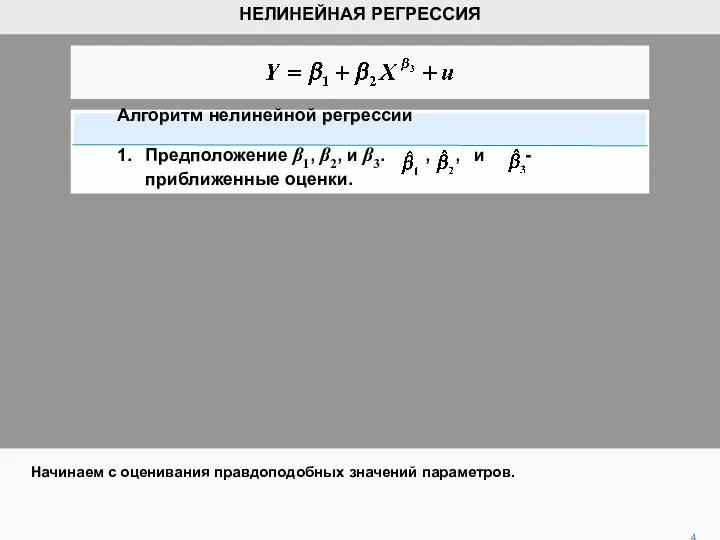

- 4. Начинаем с оценивания правдоподобных значений параметров. 4 НЕЛИНЕЙНАЯ РЕГРЕССИЯ Алгоритм нелинейной регрессии 1. Предположение β1, β2,

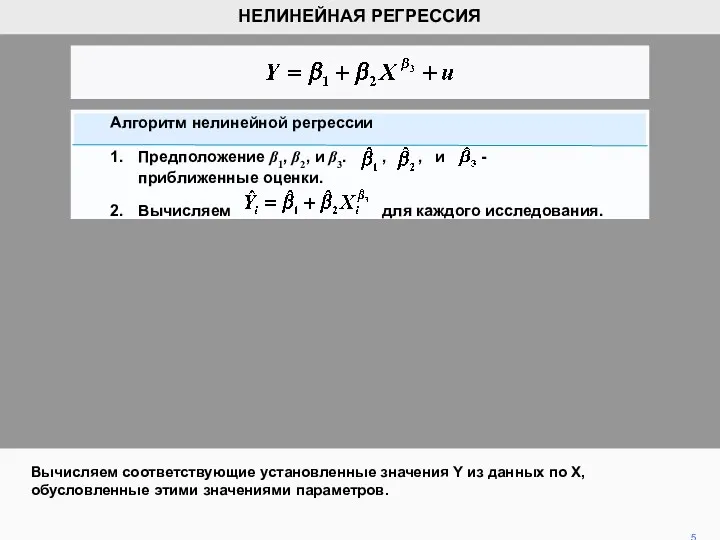

- 5. Вычисляем соответствующие установленные значения Y из данных по X, обусловленные этими значениями параметров. 5 НЕЛИНЕЙНАЯ РЕГРЕССИЯ

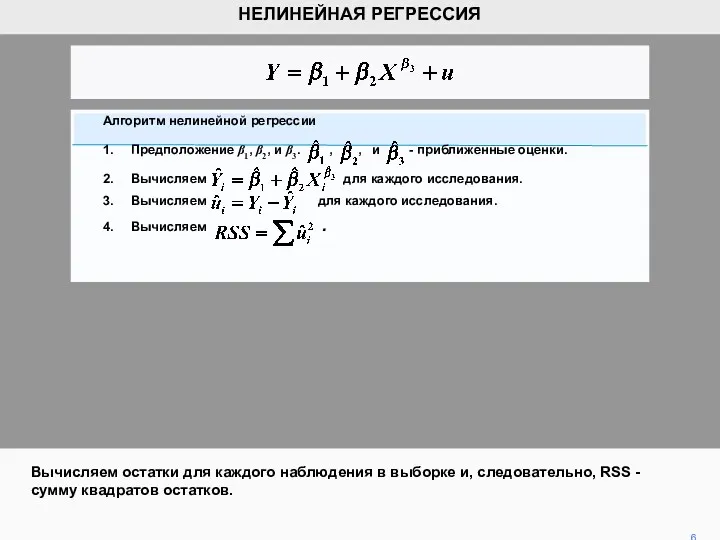

- 6. 6 НЕЛИНЕЙНАЯ РЕГРЕССИЯ Вычисляем остатки для каждого наблюдения в выборке и, следовательно, RSS - сумму квадратов

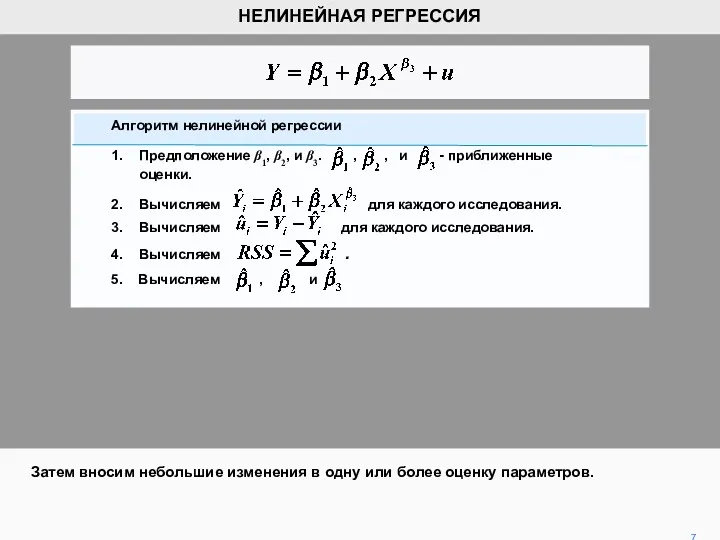

- 7. 7 НЕЛИНЕЙНАЯ РЕГРЕССИЯ Затем вносим небольшие изменения в одну или более оценку параметров. Алгоритм нелинейной регрессии

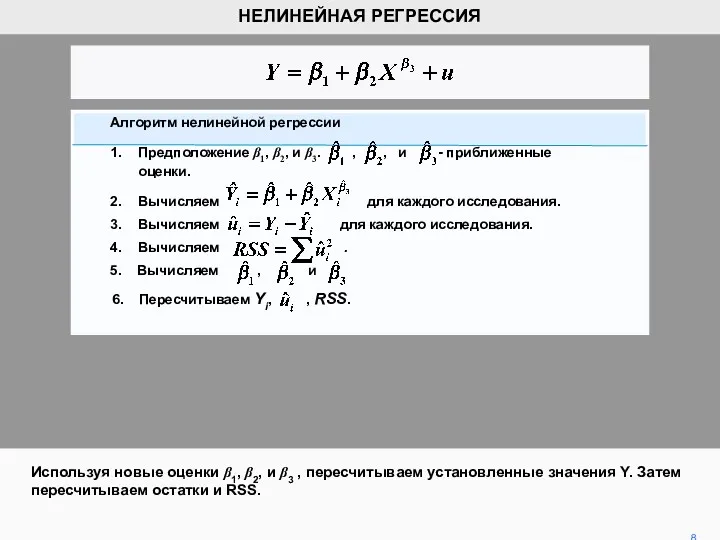

- 8. Используя новые оценки β1, β2, и β3 , пересчитываем установленные значения Y. Затем пересчитываем остатки и

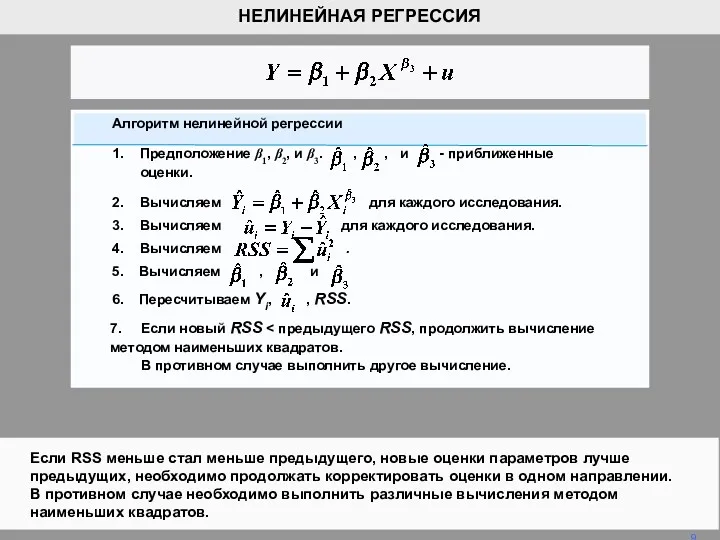

- 9. Если RSS меньше стал меньше предыдущего, новые оценки параметров лучше предыдущих, необходимо продолжать корректировать оценки в

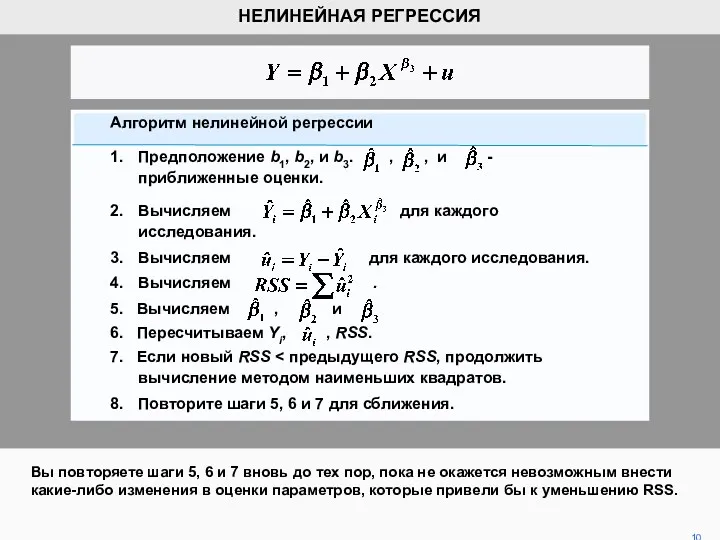

- 10. Вы повторяете шаги 5, 6 и 7 вновь до тех пор, пока не окажется невозможным внести

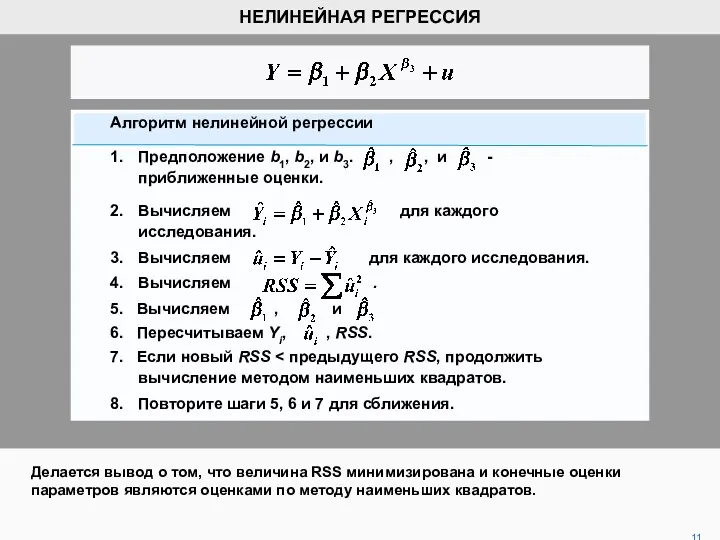

- 11. Делается вывод о том, что величина RSS минимизирована и конечные оценки параметров являются оценками по методу

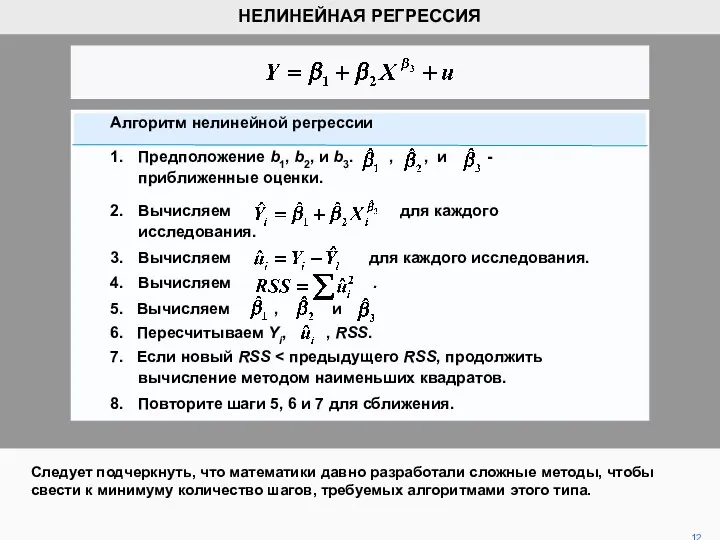

- 12. Следует подчеркнуть, что математики давно разработали сложные методы, чтобы свести к минимуму количество шагов, требуемых алгоритмами

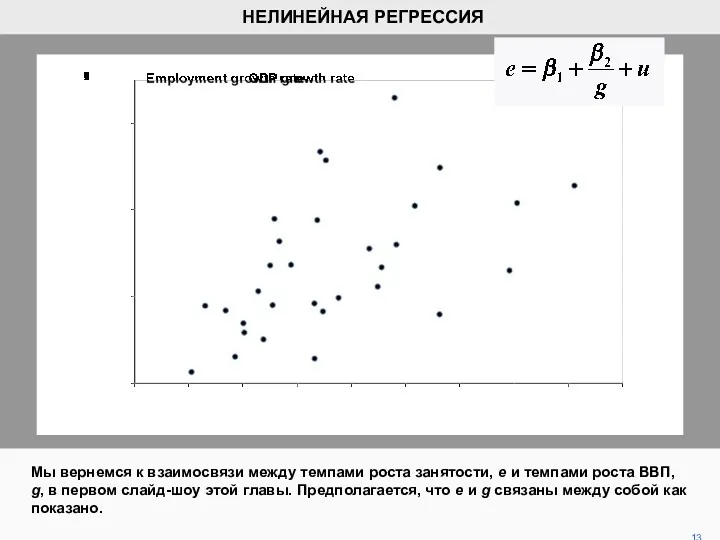

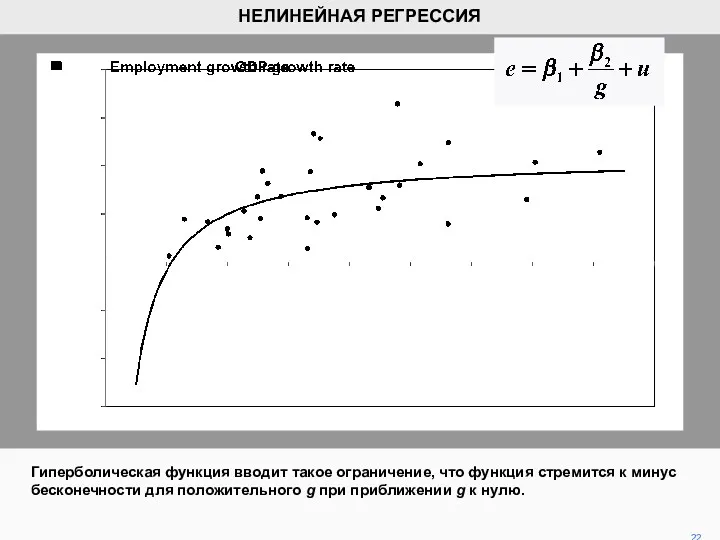

- 13. Мы вернемся к взаимосвязи между темпами роста занятости, е и темпами роста ВВП, g, в первом

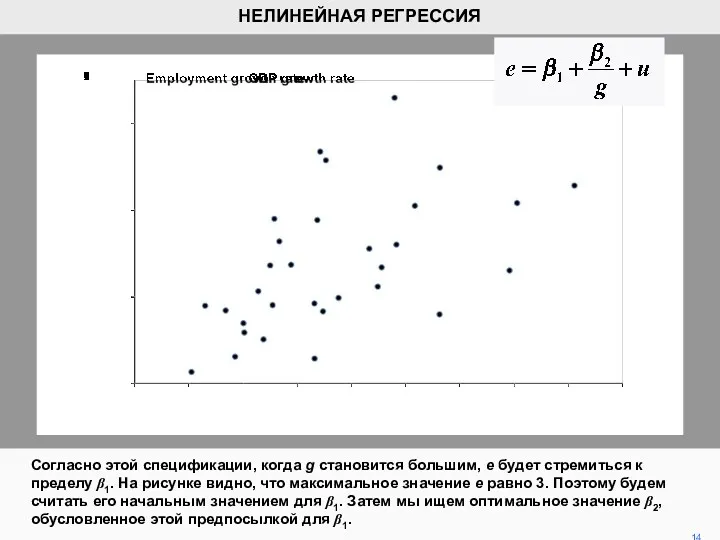

- 14. Согласно этой спецификации, когда g становится большим, e будет стремиться к пределу β1. На рисунке видно,

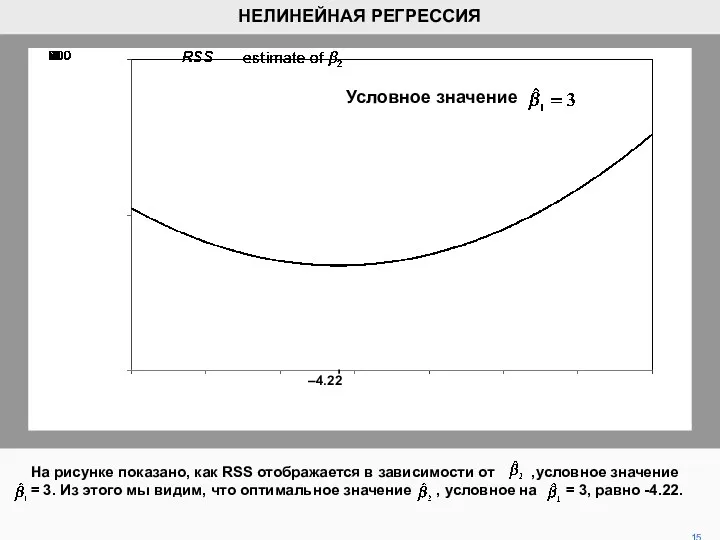

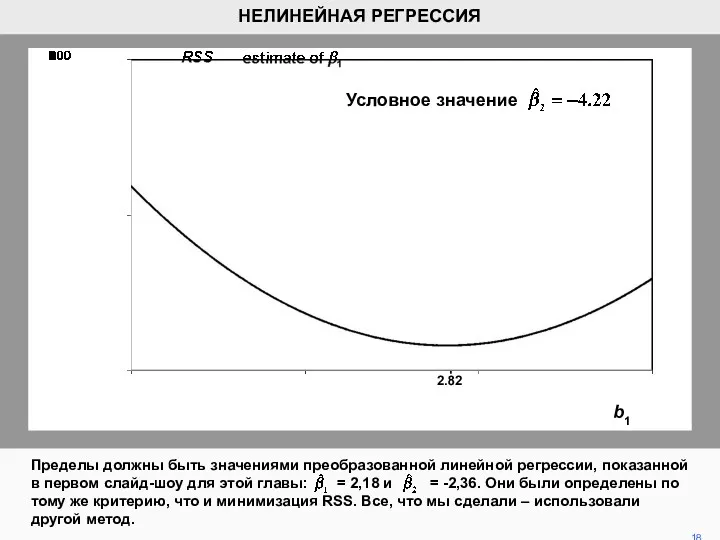

- 15. На рисунке показано, как RSS отображается в зависимости от ,условное значение = 3. Из этого мы

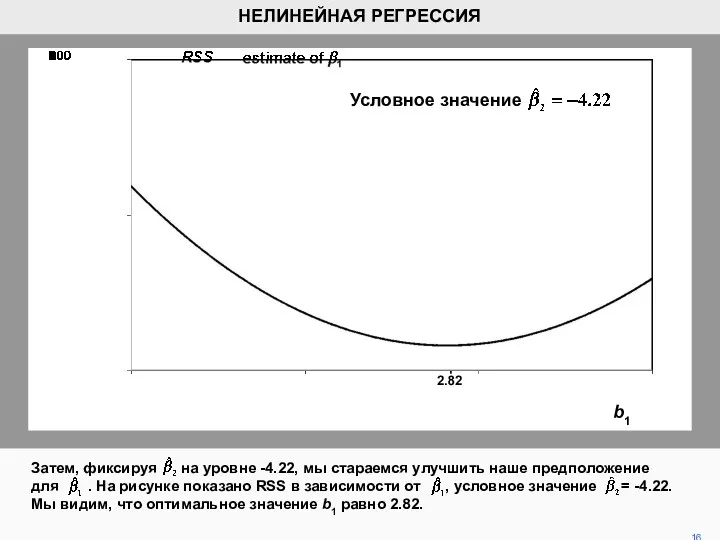

- 16. Затем, фиксируя на уровне -4.22, мы стараемся улучшить наше предположение для . На рисунке показано RSS

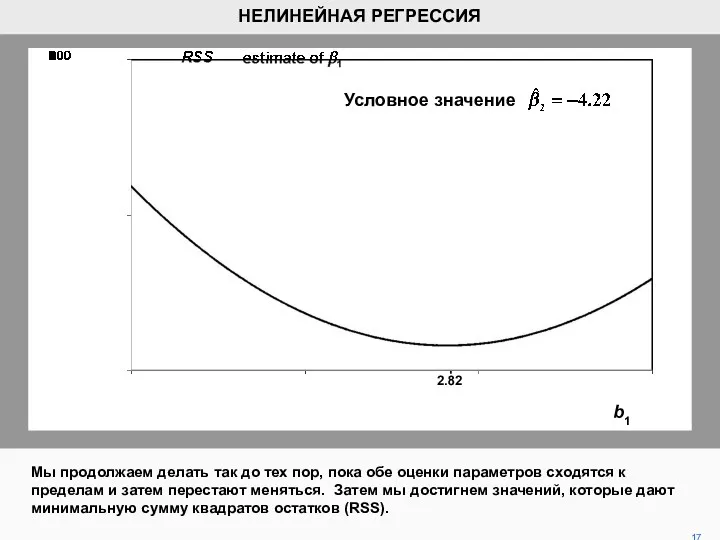

- 17. Мы продолжаем делать так до тех пор, пока обе оценки параметров сходятся к пределам и затем

- 18. Пределы должны быть значениями преобразованной линейной регрессии, показанной в первом слайд-шоу для этой главы: = 2,18

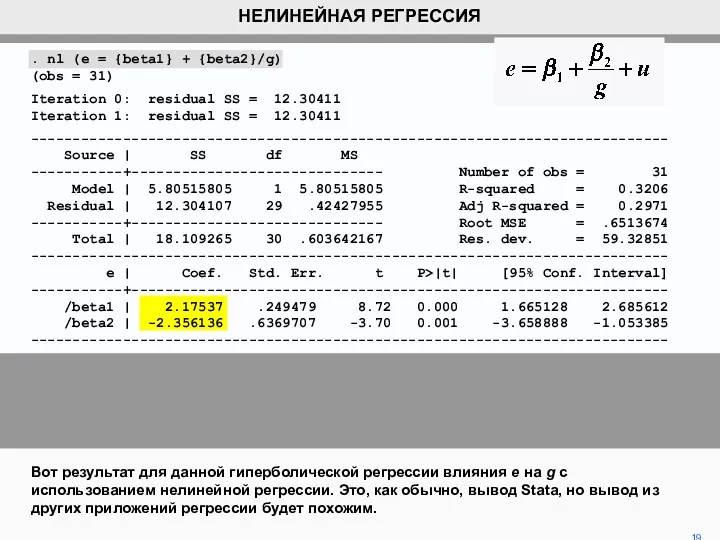

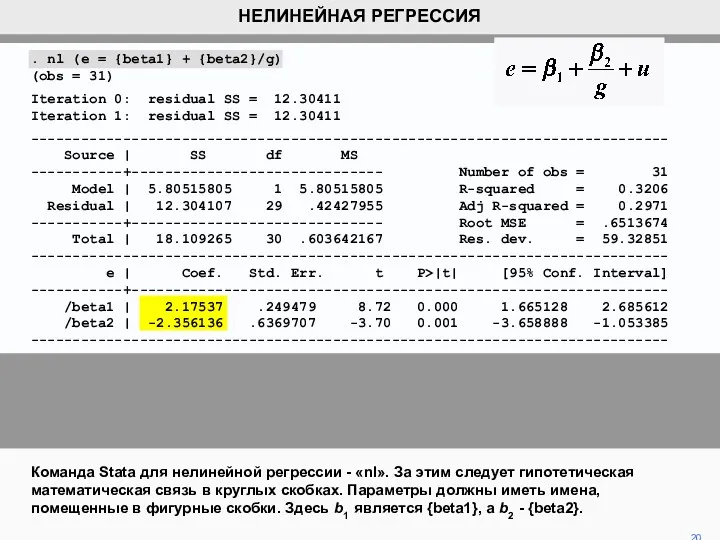

- 19. Вот результат для данной гиперболической регрессии влияния e на g с использованием нелинейной регрессии. Это, как

- 20. Команда Stata для нелинейной регрессии - «nl». За этим следует гипотетическая математическая связь в круглых скобках.

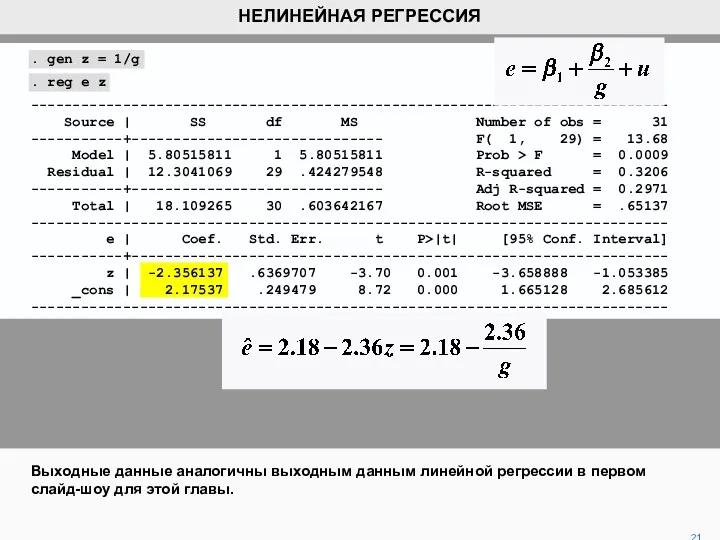

- 21. . gen z = 1/g . reg e z ---------------------------------------------------------------------------- Source | SS df MS Number

- 22. Гиперболическая функция вводит такое ограничение, что функция стремится к минус бесконечности для положительного g при приближении

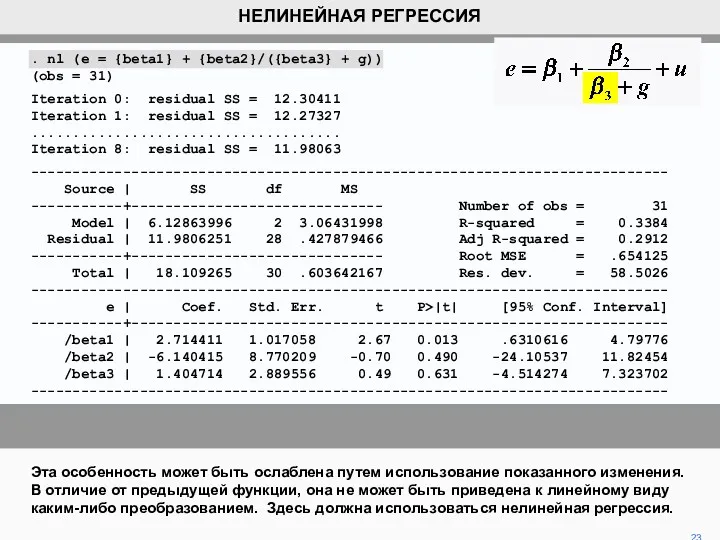

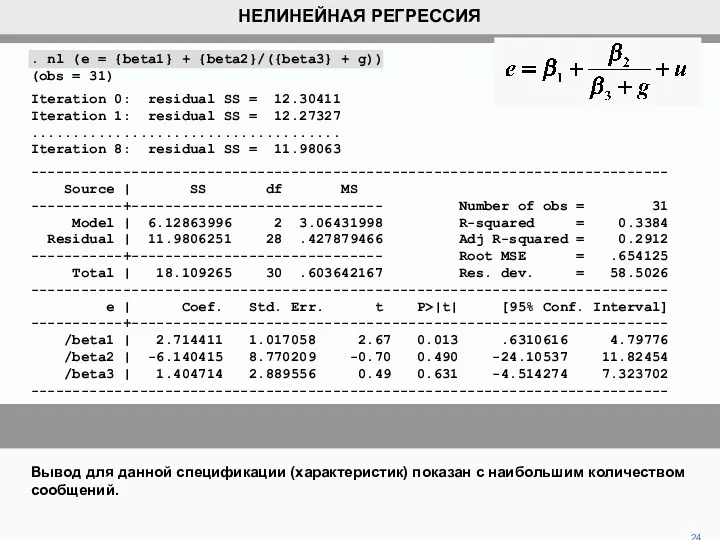

- 23. Эта особенность может быть ослаблена путем использование показанного изменения. В отличие от предыдущей функции, она не

- 24. . nl (e = {beta1} + {beta2}/({beta3} + g)) (obs = 31) Iteration 0: residual SS

- 26. Скачать презентацию

4 класс.Понятие периметр и способ нахождения периметра многоугольника

4 класс.Понятие периметр и способ нахождения периметра многоугольника Натуральные числа. 7 класс

Натуральные числа. 7 класс Взаимно обратные числа. Задание для устного счета. Упражнение 13. 6 класс

Взаимно обратные числа. Задание для устного счета. Упражнение 13. 6 класс Интегрированное занятие в старшей группе детского сада Путешествие звездочки. Ход занятия

Интегрированное занятие в старшей группе детского сада Путешествие звездочки. Ход занятия  Измерительные шкалы

Измерительные шкалы Письменное деление на двузначное число, когда в частном есть нули

Письменное деление на двузначное число, когда в частном есть нули презентация -игра Поиграем

презентация -игра Поиграем Деление десятичной дроби на десятичную дробь

Деление десятичной дроби на десятичную дробь Практическая направленность уроков математики, как средство социализации учащихся с ОВЗ

Практическая направленность уроков математики, как средство социализации учащихся с ОВЗ Презентация к уроку математики по теме: Виды треугольников. 3 класс УМК Школа России

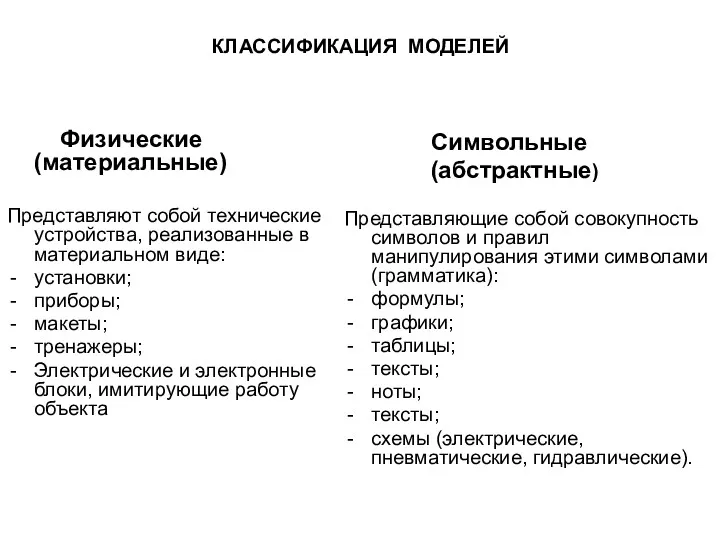

Презентация к уроку математики по теме: Виды треугольников. 3 класс УМК Школа России Классификация моделей. (Тема 1)

Классификация моделей. (Тема 1) Таңдап алынған жиынтыққа бақылау бірліктерін іріктей алу әдістері

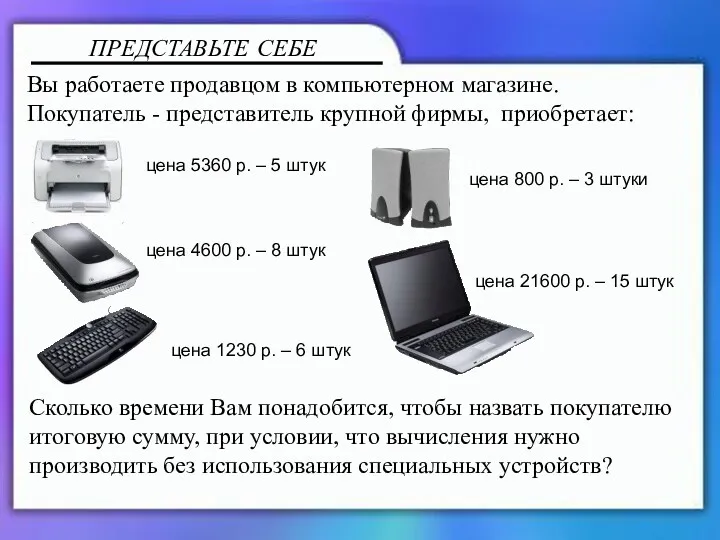

Таңдап алынған жиынтыққа бақылау бірліктерін іріктей алу әдістері Вычисления с помощью калькулятора

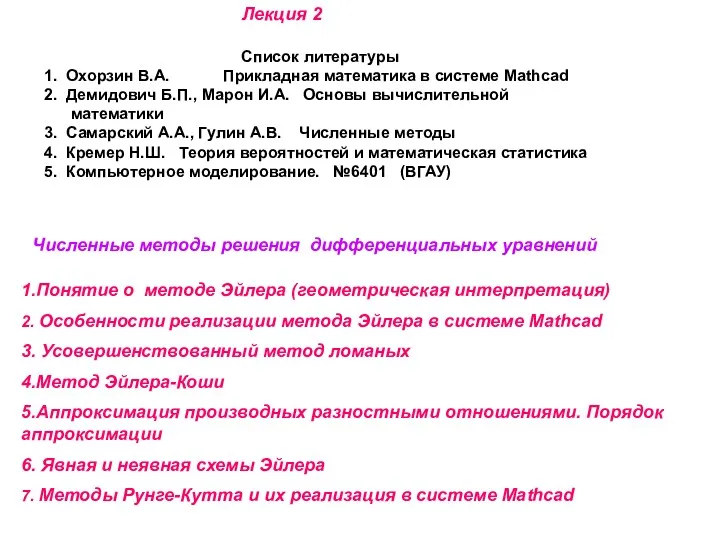

Вычисления с помощью калькулятора Численные методы решения дифференциальных уравнений. Лекция 2

Численные методы решения дифференциальных уравнений. Лекция 2 Презентация для 1-2 класса на тему Геометрия вокруг нас.

Презентация для 1-2 класса на тему Геометрия вокруг нас. Сложение и вычитание десятичных дробей

Сложение и вычитание десятичных дробей Параллельные прямые. Урок математики 6 кл

Параллельные прямые. Урок математики 6 кл Методы преобразования плоскостей проекций (Лекция 5)

Методы преобразования плоскостей проекций (Лекция 5) Возникновение и развитие алгебры

Возникновение и развитие алгебры Вычитание смешанных чисел с переходом через единицу

Вычитание смешанных чисел с переходом через единицу Лекция 4 Нечеткие множества - Базовая теория для ЛР-3 (1) (1)

Лекция 4 Нечеткие множества - Базовая теория для ЛР-3 (1) (1) Математический аукцион. Решение задач

Математический аукцион. Решение задач Обратные тригонометрические функции и их свойства. 10 класс

Обратные тригонометрические функции и их свойства. 10 класс Математика в системе развивающего обучения Л.В. Занкова в начальных классах

Математика в системе развивающего обучения Л.В. Занкова в начальных классах Измерение времени

Измерение времени Задачи на сравнение

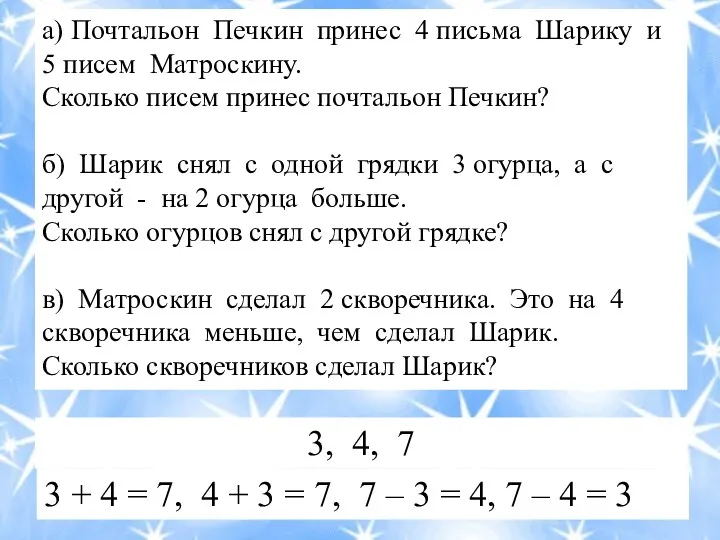

Задачи на сравнение Электронное интерактивное дидактическое мультимедийное пособие Занимательная геометрия

Электронное интерактивное дидактическое мультимедийное пособие Занимательная геометрия Четыре замечательные точки треугольника

Четыре замечательные точки треугольника