Содержание

- 2. Классификация вычислительных систем… Систематика Флинна (Flynn) классификация по способам взаимодействия последовательностей (потоков) выполняемых команд и обрабатываемых

- 3. Систематика Флинна SISD SIMD

- 4. Систематика Флинна MISD MIMD

- 5. Классификация вычислительных систем… Детализация систематики Флинна… дальнейшее разделение типов многопроцессорных систем основывается на используемых способах организации

- 6. Классификация ПВС Детализация систематики Флинна…

- 7. Классификация по взаимодействию с оперативной памятью Типы многопроцессорных систем: multiprocessors (мультипроцессоры или системы с общей разделяемой

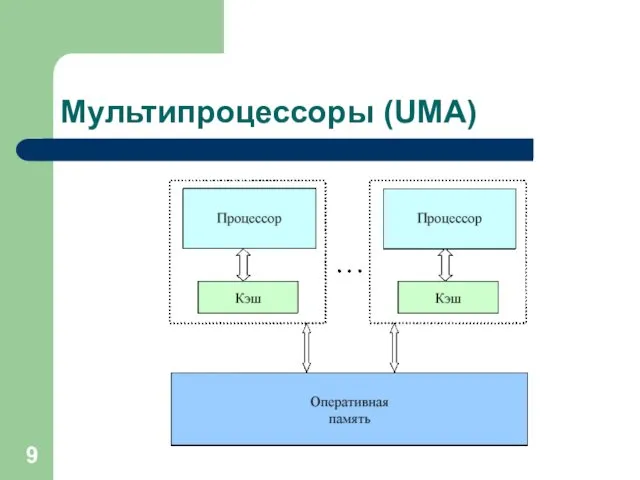

- 8. Мультипроцессоры с единой общей памятью Мультипроцессоры с использованием единой общей памяти (shared memory)… обеспечивается однородный доступ

- 9. Мультипроцессоры (UMA)

- 10. Мультипроцессоры (UMA) Проблемы: Доступ с разных процессоров к общим данным и обеспечение, в этой связи, однозначности

- 11. Мультипроцессоры (NUMA) C использованием физически распределенной памяти (distributed shared memory or DSM): неоднородный доступ к памяти

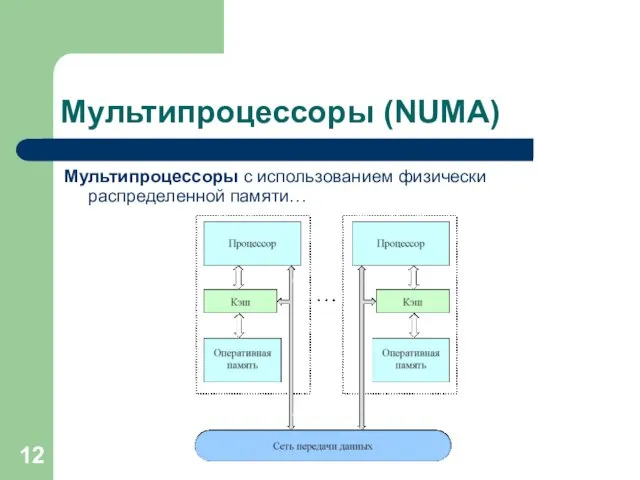

- 12. Мультипроцессоры (NUMA) Мультипроцессоры с использованием физически распределенной памяти…

- 13. Мультипроцессоры (NUMA) Мультипроцессоры с использованием физически распределенной памяти: упрощаются проблемы создания мультипроцессоров (известны примеры систем с

- 14. Мультипроцессоры (NUMA) Мультипроцессоры с использованием физически распределенной памяти: упрощаются проблемы создания мультипроцессоров (известны примеры систем с

- 15. Классификация ПВС Мультикомпьютеры… не обеспечивают общий доступ ко всей имеющейся в системах памяти (no-remote memory access

- 16. Классификация ПВС Мультикомпьютеры

- 17. Мультикомпьютеры Данный подход используется при построении двух важных типов многопроцессорных вычислительных систем: массивно-параллельных систем (massively parallel

- 18. Мультикомпьютеры. Кластеры… Кластер - множество отдельных компьютеров, объединенных в сеть, для которых при помощи специальных аппаратно-программных

- 19. Мультикомпьютеры. Кластеры… Преимущества: Могут быть образованы на базе уже существующих у потребителей отдельных компьютеров, либо же

- 20. Мультикомпьютеры. Кластеры Недостатки: Организация взаимодействия -> к значительным временным задержкам, Дополнительные ограничения на тип разрабатываемых параллельных

- 21. Мультикомпьютеры. MPP-системы MPP – Massive Parallel Processing или массивно-параллельные системы. Система строится из отдельных модулей, содержащих

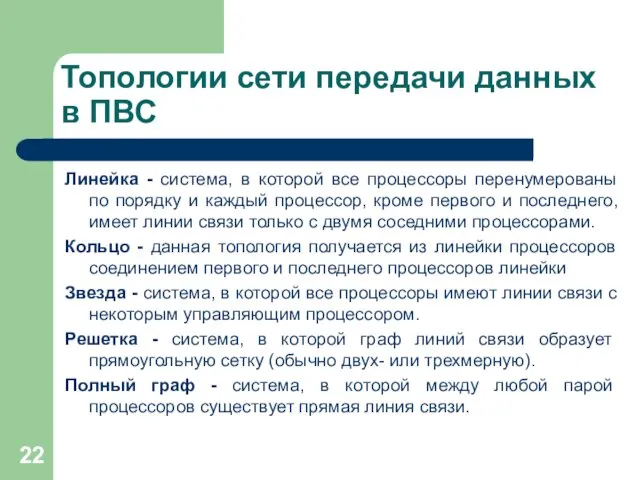

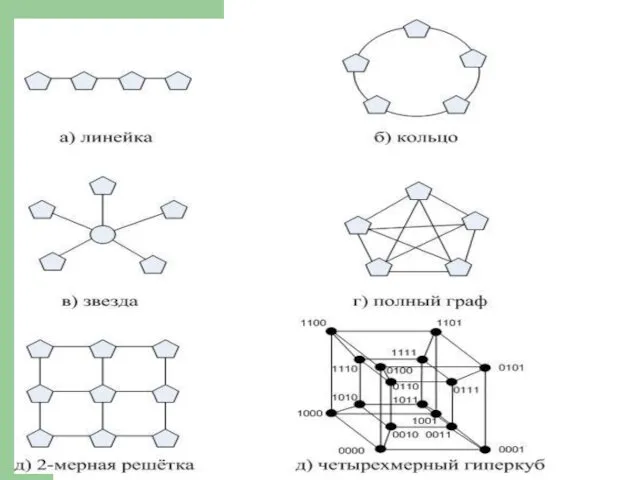

- 22. Топологии сети передачи данных в ПВС Линейка - система, в которой все процессоры перенумерованы по порядку

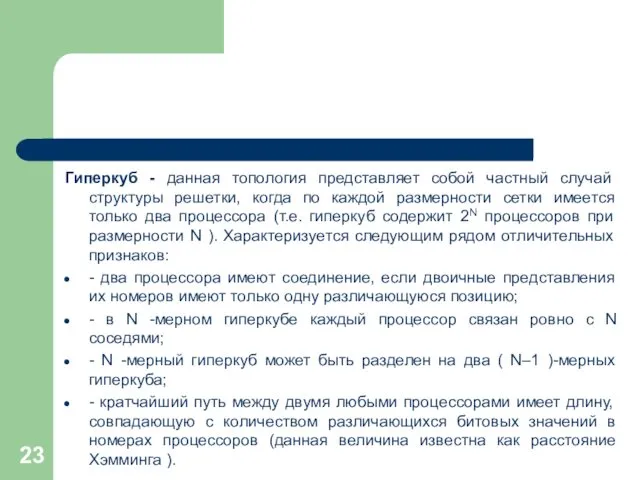

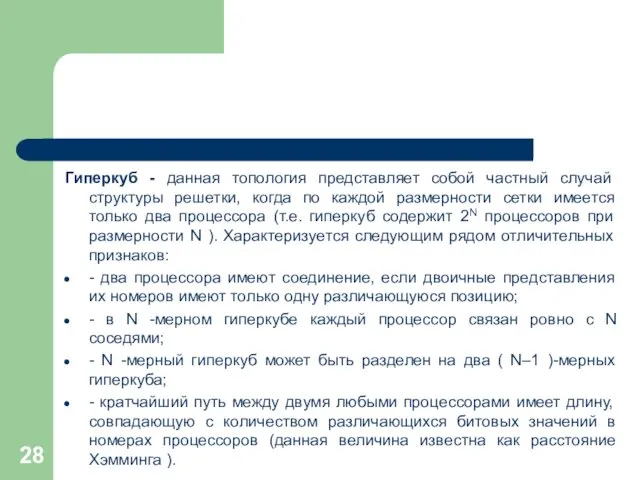

- 23. Гиперкуб - данная топология представляет собой частный случай структуры решетки, когда по каждой размерности сетки имеется

- 25. Расстояние между процессорами Архитектура кластерной системы (способ соединения процессоров друг с другом) в большей степени определяет

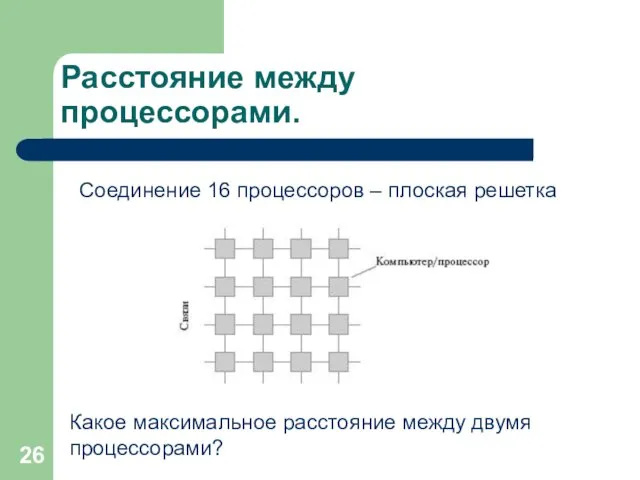

- 26. Расстояние между процессорами. Какое максимальное расстояние между двумя процессорами? Соединение 16 процессоров – плоская решетка

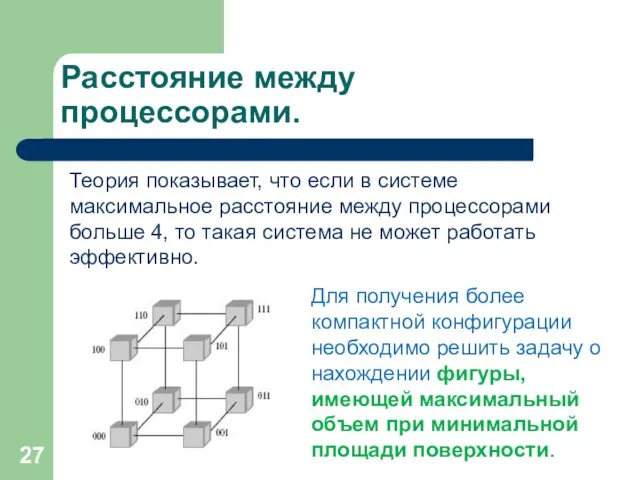

- 27. Расстояние между процессорами. Теория показывает, что если в системе максимальное расстояние между процессорами больше 4, то

- 28. Гиперкуб - данная топология представляет собой частный случай структуры решетки, когда по каждой размерности сетки имеется

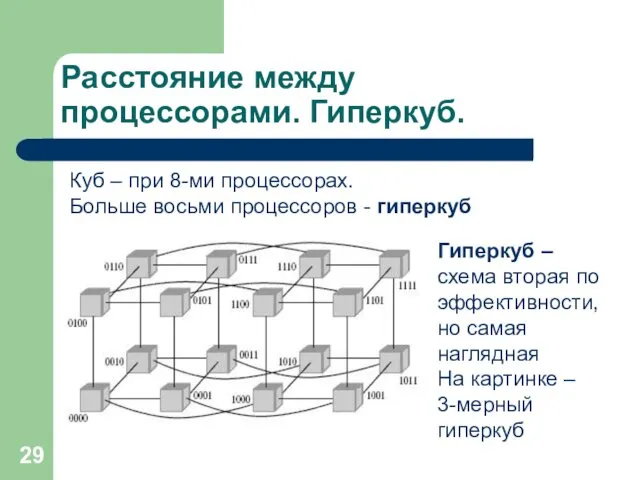

- 29. Расстояние между процессорами. Гиперкуб. Куб – при 8-ми процессорах. Больше восьми процессоров - гиперкуб Гиперкуб –

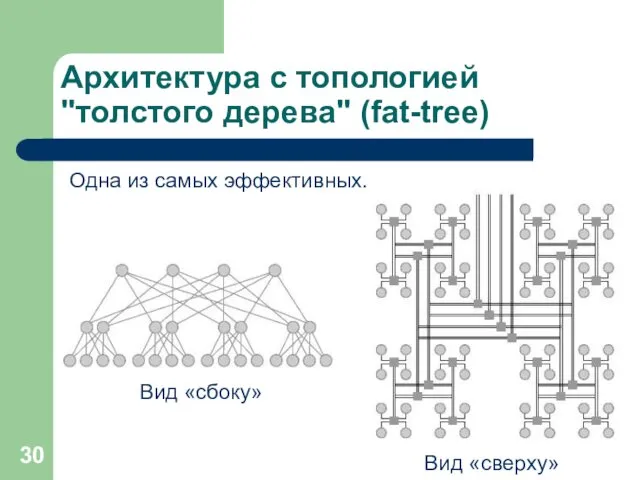

- 30. Архитектура с топологией "толстого дерева" (fat-tree) Одна из самых эффективных. Вид «сверху» Вид «сбоку»

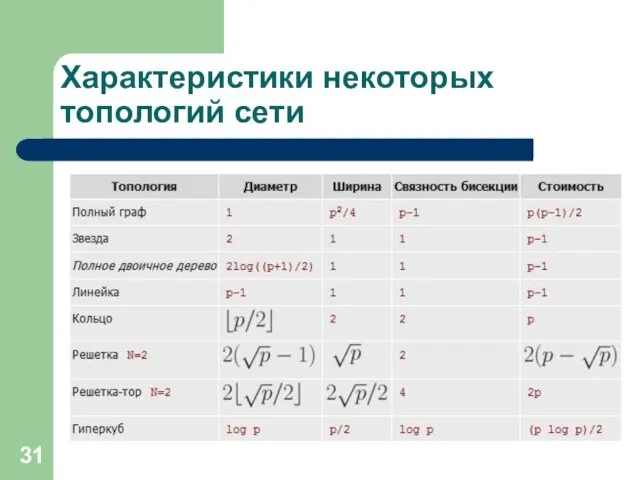

- 31. Характеристики некоторых топологий сети

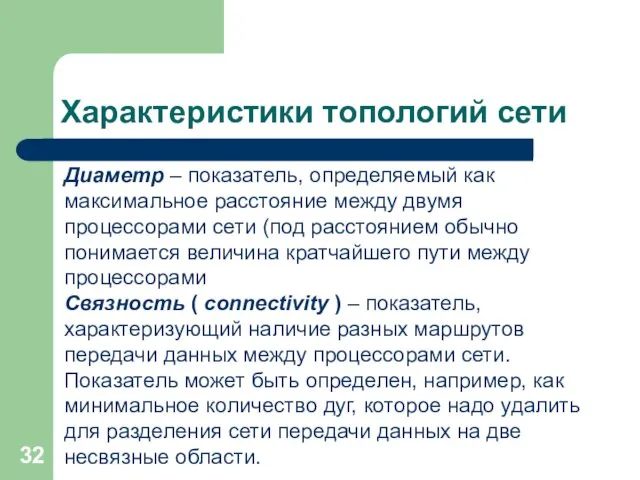

- 32. Характеристики топологий сети Диаметр – показатель, определяемый как максимальное расстояние между двумя процессорами сети (под расстоянием

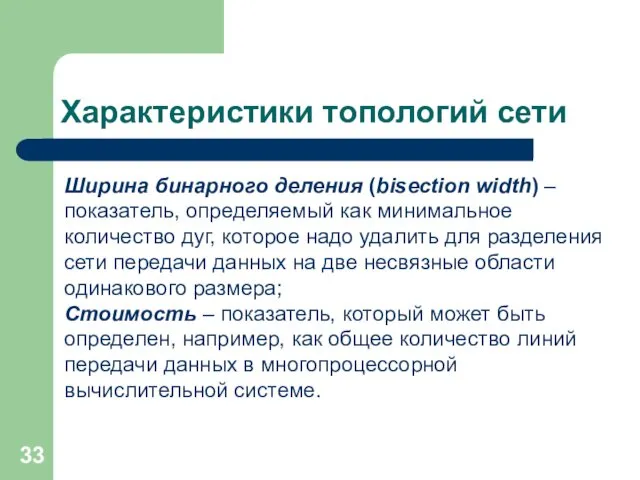

- 33. Характеристики топологий сети Ширина бинарного деления (bisection width) – показатель, определяемый как минимальное количество дуг, которое

- 34. Языки и системы программирования Базовые языки параллельного программирования: C, Fortran, Lisp, Erlang и их производные (расширения,

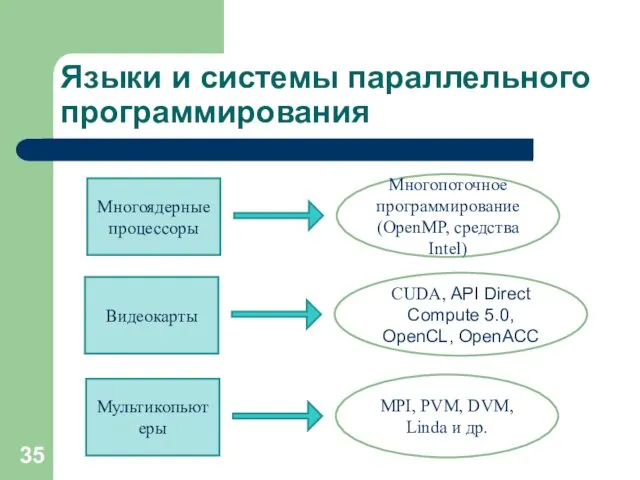

- 35. Языки и системы параллельного программирования Многоядерные процессоры Многопоточное программирование (OpenMP, средства Intel) Видеокарты CUDA, API Direct

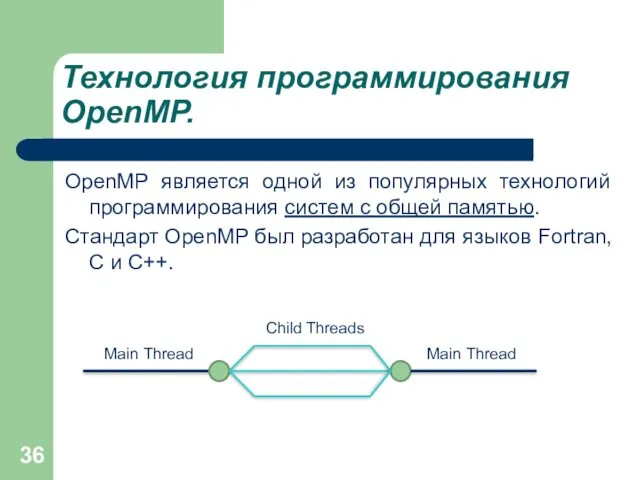

- 36. Технология программирования OpenMP. OpenMP является одной из популярных технологий программирования систем с общей памятью. Стандарт OpenMP

- 37. Система параллельного программирования PVM. PVM (Parallel Virtual Machine) позволяет объединить набор разных компьютеров, связанных сетью, в

- 38. Технология MPI вычислительные системы с распределённой памятью Программа Процессор Процессор Процессор копия копия копия

- 40. Скачать презентацию

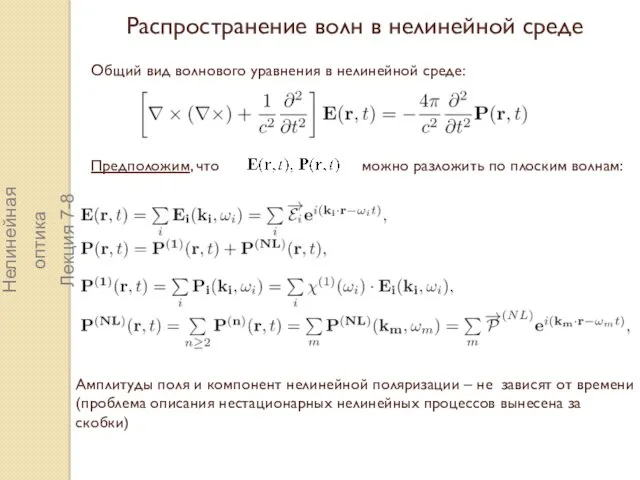

Распространение волн в нелинейной среде

Распространение волн в нелинейной среде Презентация к игре Умники и умницы

Презентация к игре Умники и умницы Инновационная стратегия бережливого производства

Инновационная стратегия бережливого производства Презентация к уроку Типы климатов России 8 класс

Презентация к уроку Типы климатов России 8 класс Роль воспитателя в развитии креативности ребенка

Роль воспитателя в развитии креативности ребенка Дерматомиозит/ полимиозит

Дерматомиозит/ полимиозит Диктант Победы

Диктант Победы Я-гражданин России.

Я-гражданин России. Графика

Графика тема 3 пед.процесс-1

тема 3 пед.процесс-1 JACOBS кофеcі

JACOBS кофеcі Устройство машин непрерывного транспорта

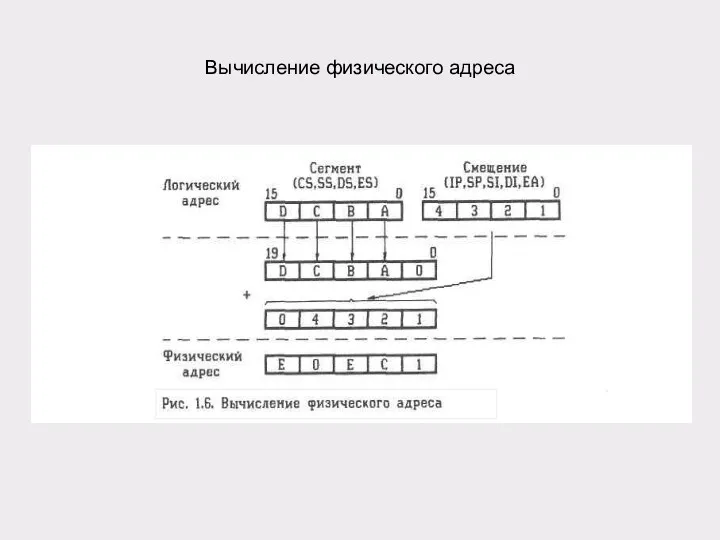

Устройство машин непрерывного транспорта Вычисление физического адреса

Вычисление физического адреса Веб-педсовет: особенности преподавания русского языка и литературы в соответствии с ГОС в 2019-2020 учебном году

Веб-педсовет: особенности преподавания русского языка и литературы в соответствии с ГОС в 2019-2020 учебном году Презентация Защита педагогической системы на аттестации

Презентация Защита педагогической системы на аттестации Крушение поезда “Невский проспект” и принятые меры по спасению пассажиров

Крушение поезда “Невский проспект” и принятые меры по спасению пассажиров Management Tools. Problem Solving

Management Tools. Problem Solving Религии народов Сибири и Дальнего Востока

Религии народов Сибири и Дальнего Востока Триггеры. Схемы простейших триггеров

Триггеры. Схемы простейших триггеров Презентация Святые защитники Земли Русской

Презентация Святые защитники Земли Русской урок 8.02.22

урок 8.02.22 Социальная сущность человека

Социальная сущность человека ВКР: Ядерный реактор

ВКР: Ядерный реактор Определение геометрической прогрессии. Формула n-го члена геометрической прогрессии

Определение геометрической прогрессии. Формула n-го члена геометрической прогрессии Группа компаний ОАО Интертрансэкспедиция

Группа компаний ОАО Интертрансэкспедиция Экономические основы страхования

Экономические основы страхования Презентация Олимпийские знатоки

Презентация Олимпийские знатоки Городецкая роспись

Городецкая роспись