Содержание

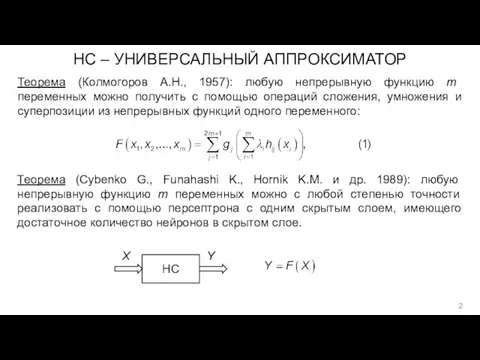

- 2. НС – УНИВЕРСАЛЬНЫЙ АППРОКСИМАТОР Теорема (Колмогоров А.Н., 1957): любую непрерывную функцию m переменных можно получить с

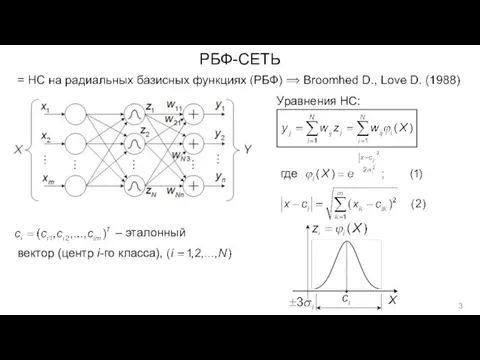

- 3. РБФ-СЕТЬ Уравнения НС: где – эталонный вектор (центр i-го класса),

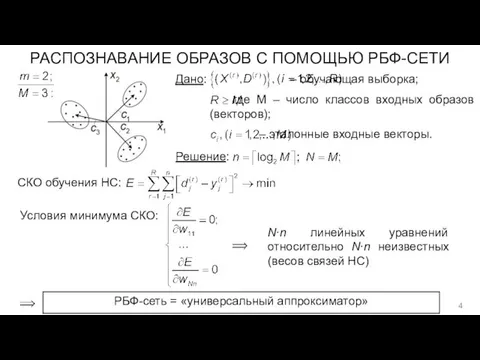

- 4. – обучающая выборка; где M – число классов входных образов (векторов); – эталонные входные векторы. РАСПОЗНАВАНИЕ

- 5. НС ХОПФИЛДА (J. Hopfield, 1982) = однослойная полносвязная динамическая НС Матрица весов: Уравнения НС: Модель динамического

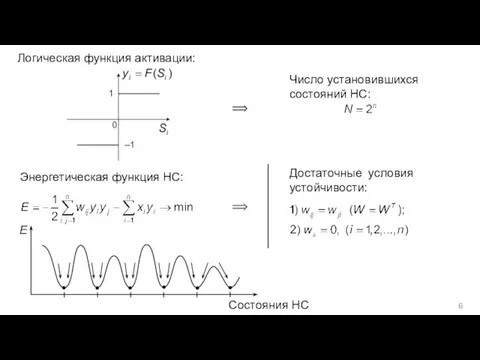

- 6. Логическая функция активации: Число установившихся состояний НС: Достаточные условия устойчивости: Энергетическая функция НС: Состояния НС

- 7. Обучающая выборка НС: где Правило выбора весов: т.е. обучение за 1 шаг. Решаемые задачи: ассоциативная память

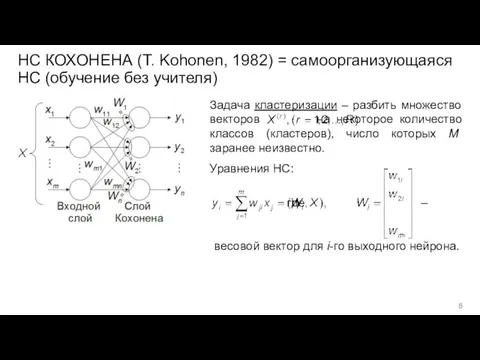

- 8. НС КОХОНЕНА (T. Kohonen, 1982) = самоорганизующаяся НС (обучение без учителя) Задача кластеризации – разбить множество

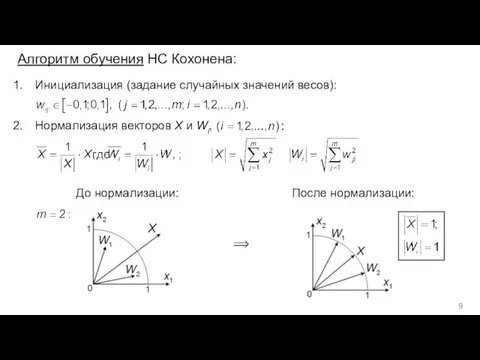

- 9. Алгоритм обучения НС Кохонена: Инициализация (задание случайных значений весов): Нормализация векторов X и Wi, До нормализации:

- 11. Скачать презентацию

Шарль Пьер Бодлер (1821-1867)

Шарль Пьер Бодлер (1821-1867) Презентация Знаменитые деятели науки и культуры Тамбовского края

Презентация Знаменитые деятели науки и культуры Тамбовского края В бизнесе всё решают связью. Коммерческое предложение ПАО Ростелеком

В бизнесе всё решают связью. Коммерческое предложение ПАО Ростелеком Западная Сибирь. Население и хозяйство

Западная Сибирь. Население и хозяйство Эбру - искусство обработки бумаги

Эбру - искусство обработки бумаги 20230228_nalogi

20230228_nalogi Размножение фуксии черенками

Размножение фуксии черенками Синдром дефицита внимания и гиперактивность

Синдром дефицита внимания и гиперактивность Правописание безударных гласных в корне слова

Правописание безударных гласных в корне слова Умный дом

Умный дом Порядок оформления и ведения эксплуатационной и технической документации. Руководство по эксплуатации машины

Порядок оформления и ведения эксплуатационной и технической документации. Руководство по эксплуатации машины Малярия. Возбудитель малярии

Малярия. Возбудитель малярии В гостях у С.Я.Маршака

В гостях у С.Я.Маршака Азотування та ціанування сталі. Дифузійна металізація. Види, призначення, застосування

Азотування та ціанування сталі. Дифузійна металізація. Види, призначення, застосування Устный журнал России верные сыны

Устный журнал России верные сыны неделя начальной школы, посвященная Г.Х.Андерсену

неделя начальной школы, посвященная Г.Х.Андерсену Выделение. Выделение у растений

Выделение. Выделение у растений Технология обработки продукта убоя для производства мясных изделий

Технология обработки продукта убоя для производства мясных изделий Презентация Музыкальная предметно-развивающая среда как средство эмоционального развития ребенка

Презентация Музыкальная предметно-развивающая среда как средство эмоционального развития ребенка Силикатная промышленность. Керамика

Силикатная промышленность. Керамика Социо-игровые технологии по В.М.Букатову

Социо-игровые технологии по В.М.Букатову Выпускная квалификационная работа. Механизированная технология заготовки высокопитательного корма

Выпускная квалификационная работа. Механизированная технология заготовки высокопитательного корма Презентация из опыта работы по теме: Развитие творческого воображения у детей дошкольного возраста посредством изобразительной деятельности

Презентация из опыта работы по теме: Развитие творческого воображения у детей дошкольного возраста посредством изобразительной деятельности Этика сетевого общения

Этика сетевого общения Открытка ко Дню Святого Валентин

Открытка ко Дню Святого Валентин Основы самоменеджмента. Лекция 2

Основы самоменеджмента. Лекция 2 Игра, как основа социального развития детей

Игра, как основа социального развития детей Моя концепция классного руководителя

Моя концепция классного руководителя