Содержание

- 2. Определим энтропию как среднее количество информации, приходящееся на одно сообщение в ансамбле сообщений (или на один

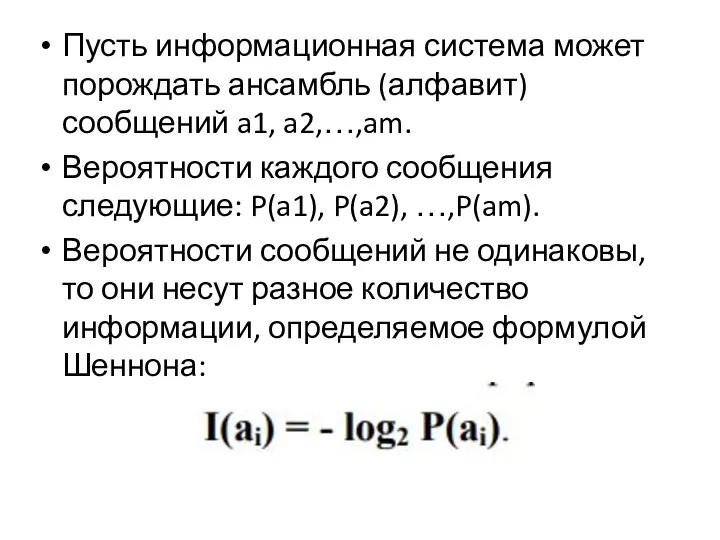

- 3. Пусть информационная система может порождать ансамбль (алфавит) сообщений a1, a2,…,am. Вероятности каждого сообщения следующие: P(a1), P(a2),

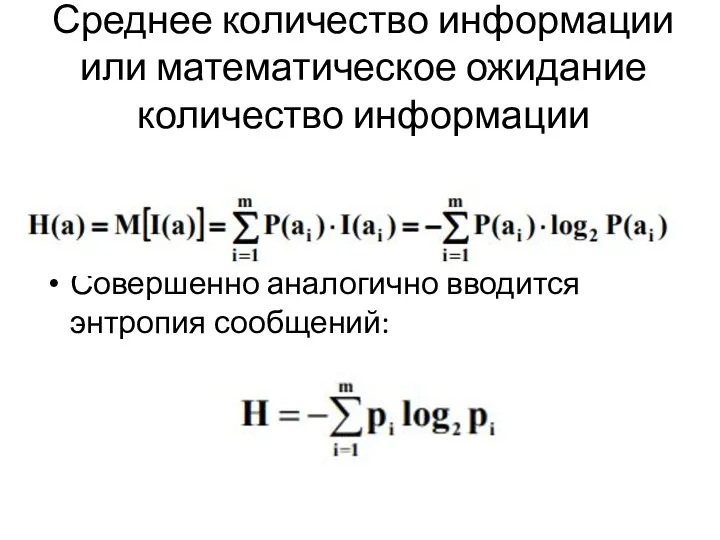

- 4. Среднее количество информации или математическое ожидание количество информации Совершенно аналогично вводится энтропия сообщений:

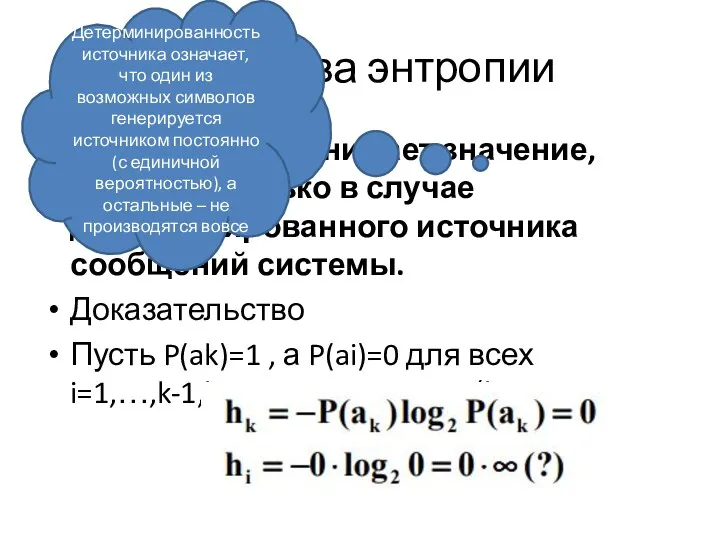

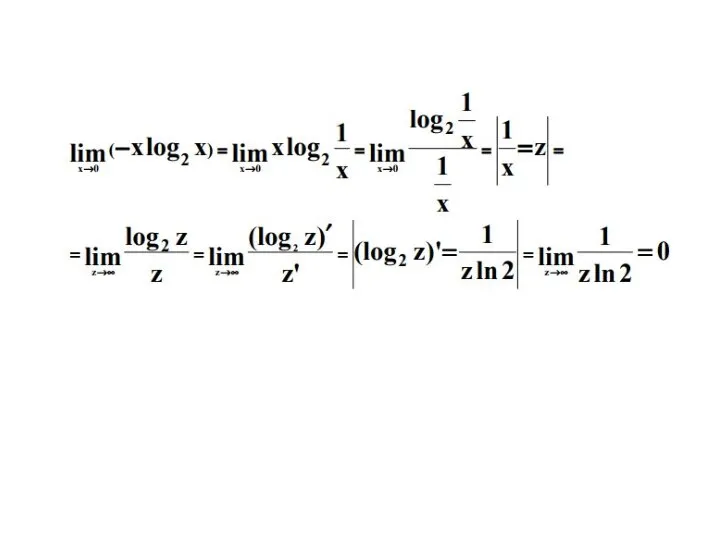

- 5. Свойства энтропии 1. Энтропия принимает значение, равное 0, только в случае детерминированного источника сообщений системы. Доказательство

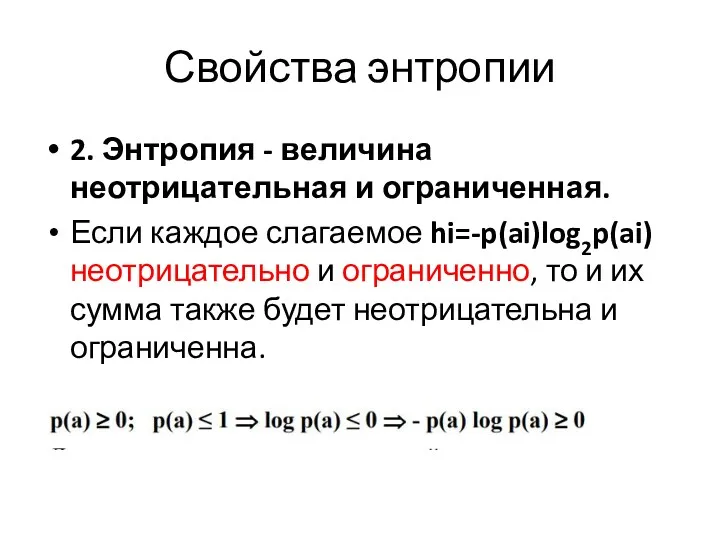

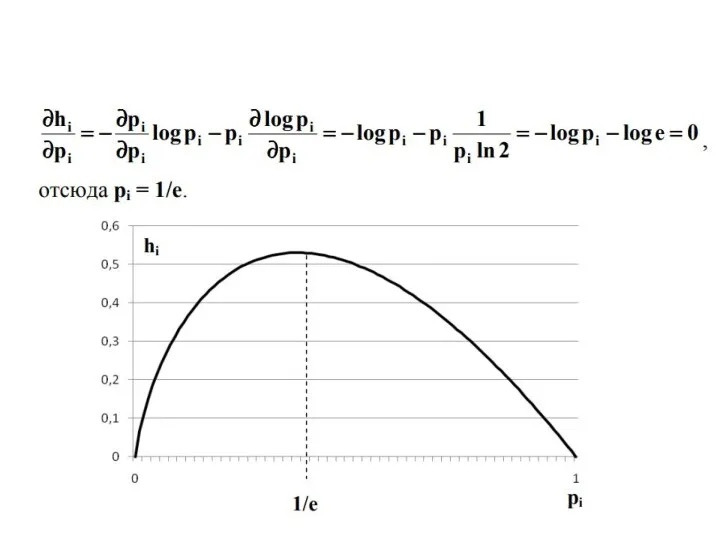

- 7. Свойства энтропии 2. Энтропия - величина неотрицательная и ограниченная. Если каждое слагаемое hi=-p(ai)log2p(ai) неотрицательно и ограниченно,

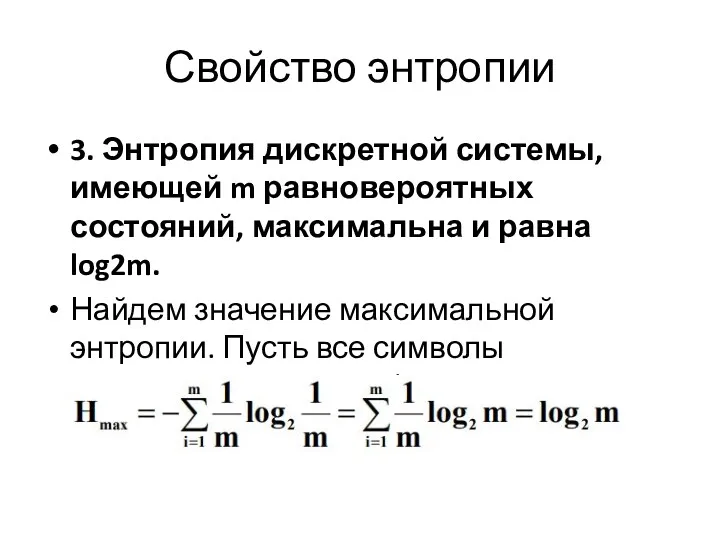

- 9. Свойство энтропии 3. Энтропия дискретной системы, имеющей m равновероятных состояний, максимальна и равна log2m. Найдем значение

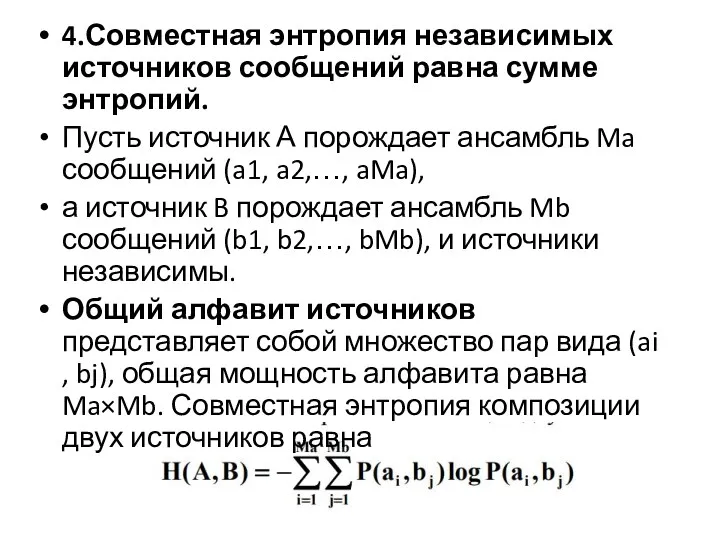

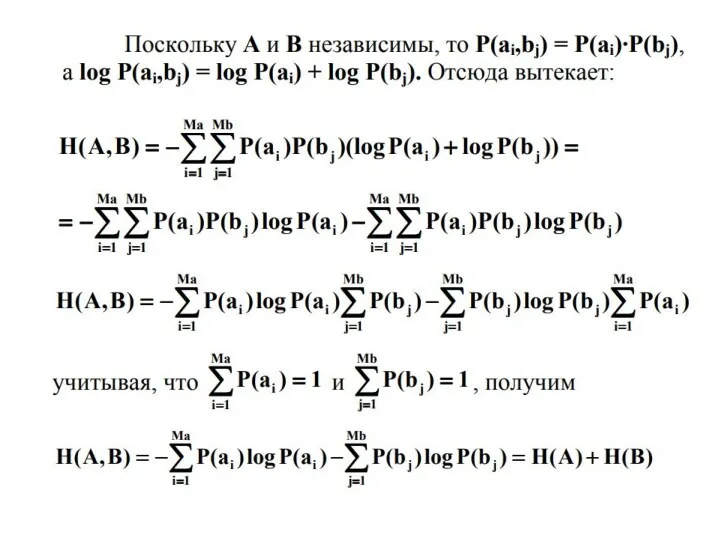

- 10. 4.Совместная энтропия независимых источников сообщений равна сумме энтропий. Пусть источник А порождает ансамбль Ma сообщений (a1,

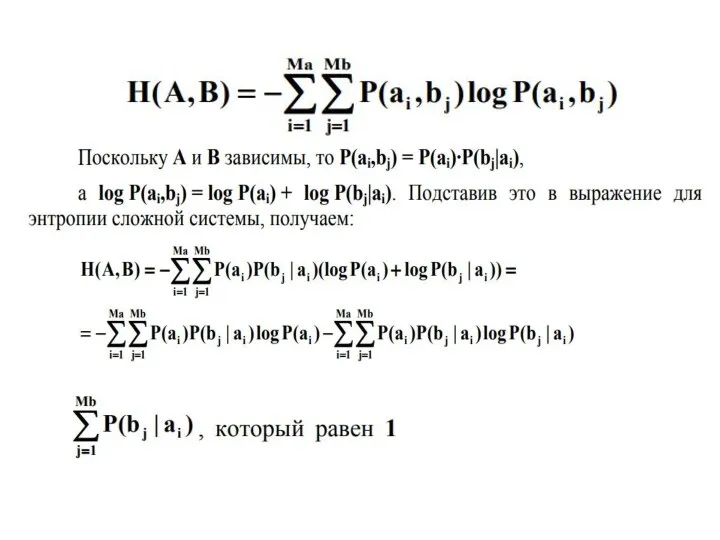

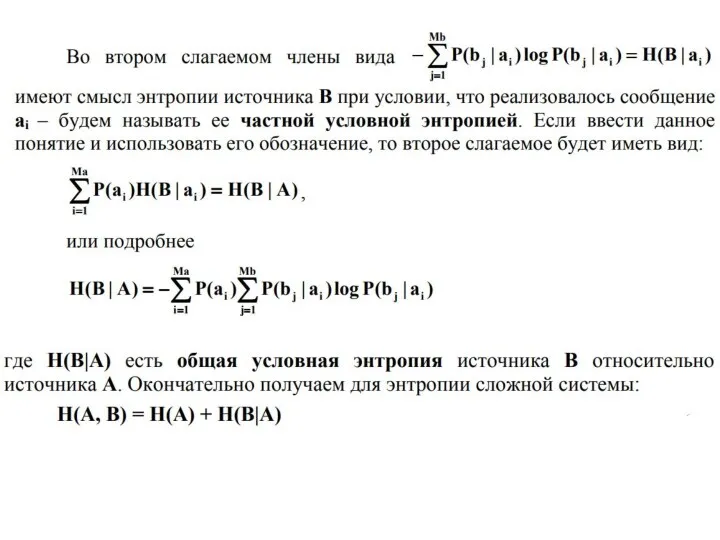

- 12. Условная энтропия Найдем совместную энтропию сложной информационной системы (композиции A, B) в том случае, если их

- 13. Условная энтропия Пусть источник А порождает ансамбль Ma сообщений (a1, a2,…, aMa), источник B порождает ансамбль

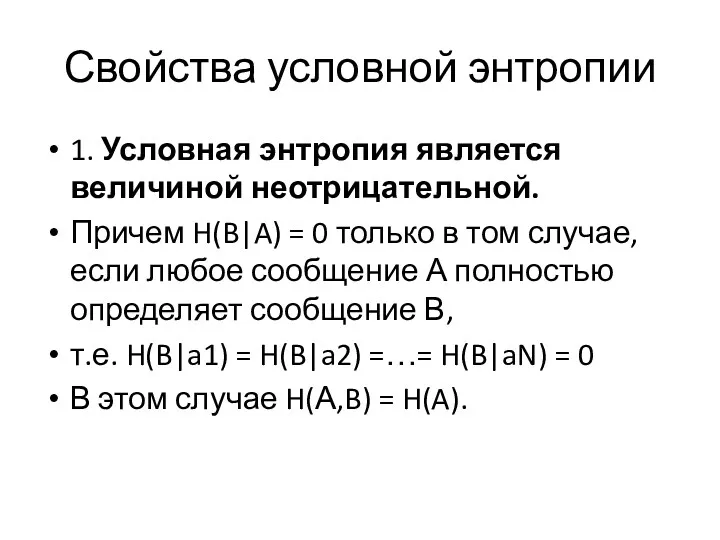

- 16. Свойства условной энтропии 1. Условная энтропия является величиной неотрицательной. Причем H(B|A) = 0 только в том

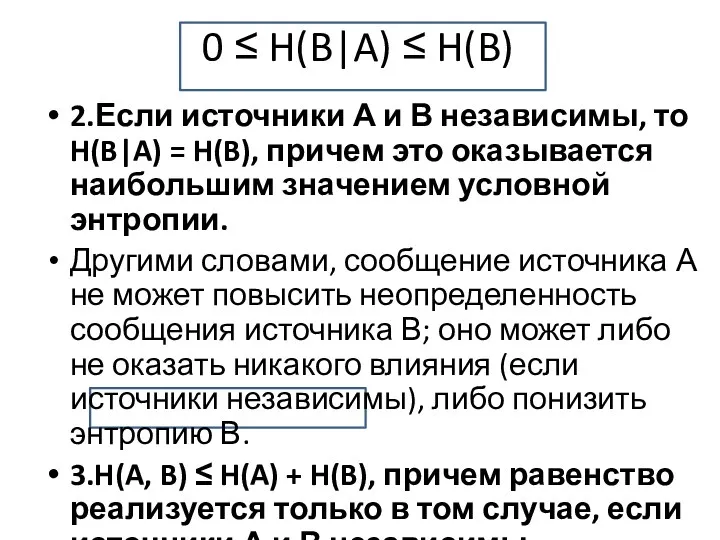

- 17. 0 ≤ H(B|A) ≤ H(B) 2.Если источники А и В независимы, то H(B|A) = H(B), причем

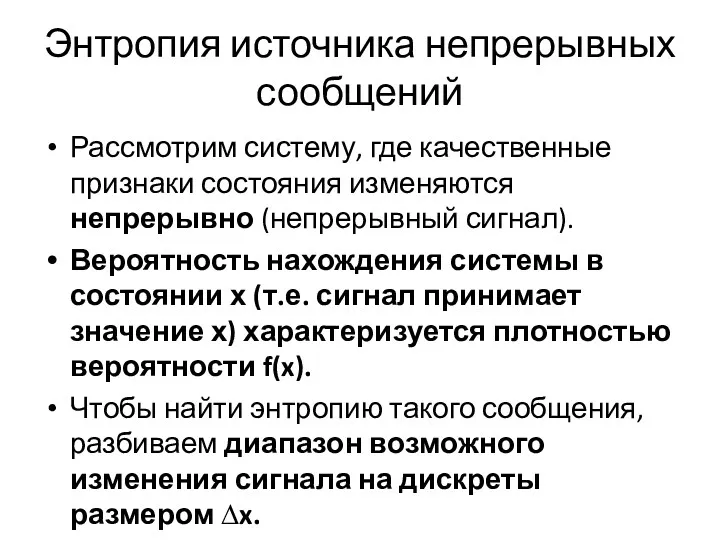

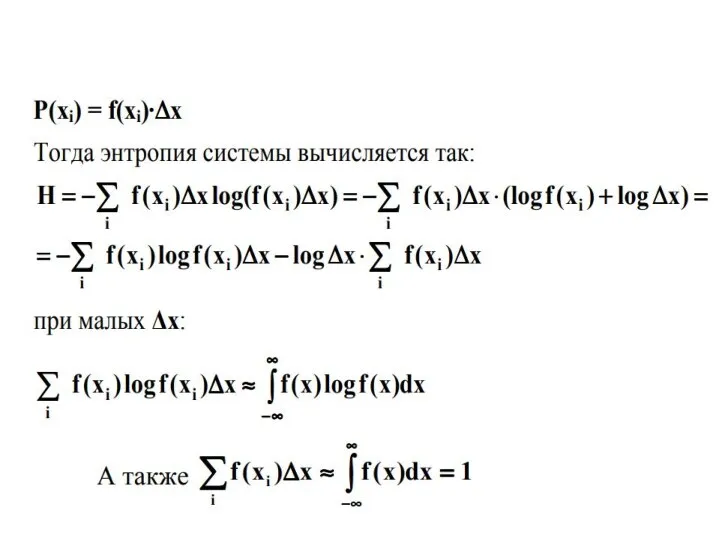

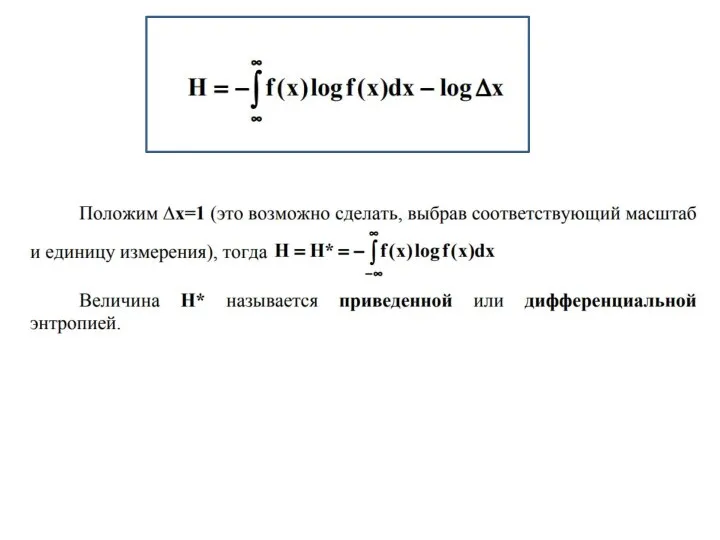

- 18. Энтропия источника непрерывных сообщений Рассмотрим систему, где качественные признаки состояния изменяются непрерывно (непрерывный сигнал). Вероятность нахождения

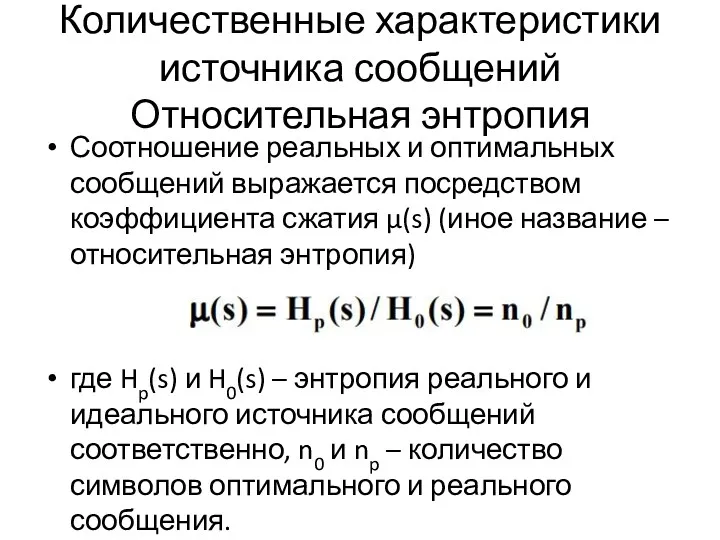

- 21. Количественные характеристики источника сообщений Относительная энтропия Соотношение реальных и оптимальных сообщений выражается посредством коэффициента сжатия µ(s)

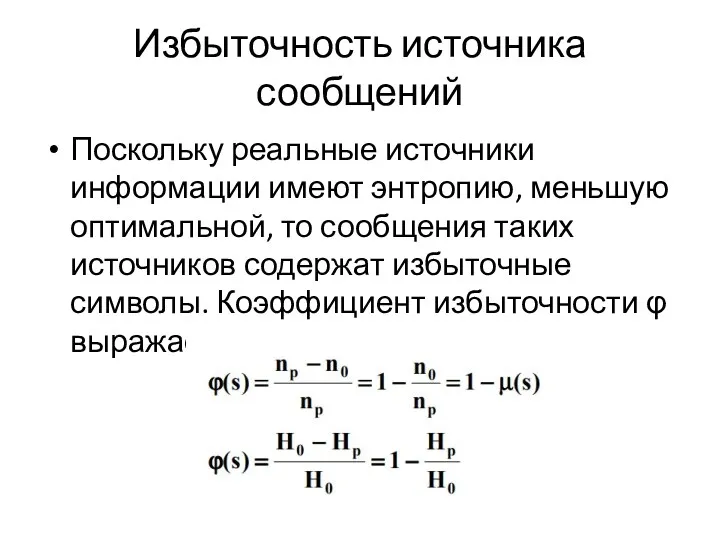

- 23. Избыточность источника сообщений Поскольку реальные источники информации имеют энтропию, меньшую оптимальной, то сообщения таких источников содержат

- 24. !!!Коэффициент избыточности показывает, какая часть реального сообщения является излишней и могла бы не передаваться, если бы

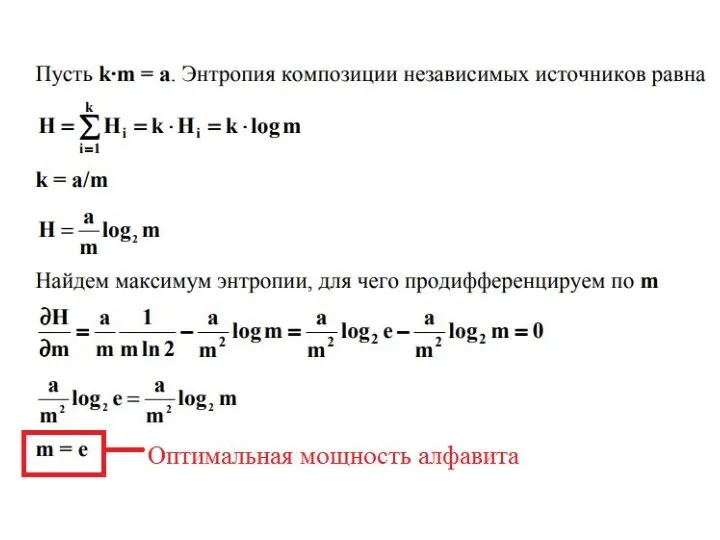

- 25. Экономичность источников информации Существует теоретический оптимум для мощности алфавита. Найдем его. !!! При какой мощности алфавита

- 27. Производительность источника сообщений Производительностью источника называется количество информации, порождаемое источником в среднем за единицу времени Пусть

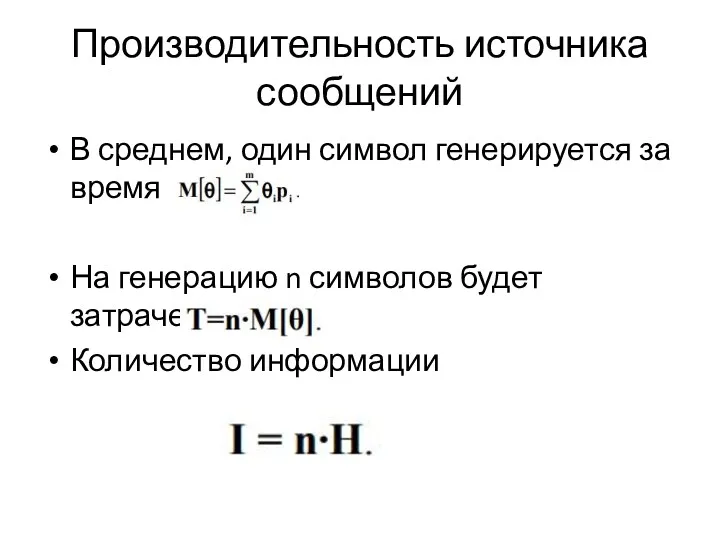

- 28. Производительность источника сообщений В среднем, один символ генерируется за время На генерацию n символов будет затрачено

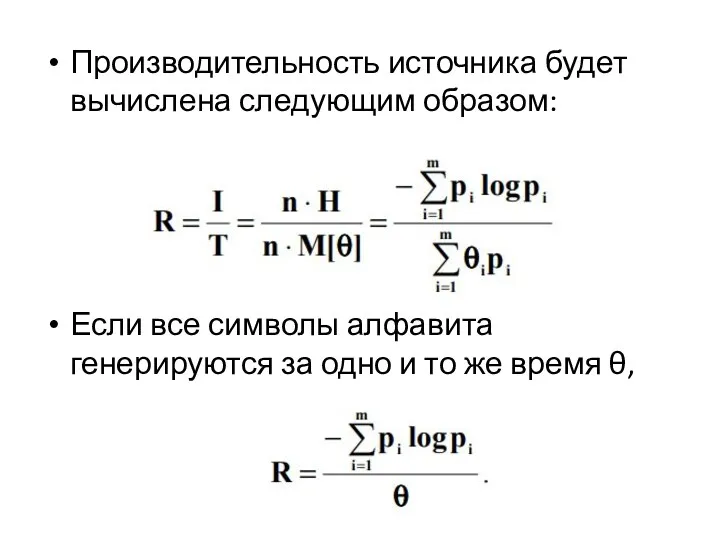

- 29. Производительность источника будет вычислена следующим образом: Если все символы алфавита генерируются за одно и то же

- 31. Скачать презентацию

Microsoft Word 2010

Microsoft Word 2010 CSS 3. Cascading Style Sheets

CSS 3. Cascading Style Sheets Самоанализ результатов профессиональной деятельности учителя информатики и ИКТ

Самоанализ результатов профессиональной деятельности учителя информатики и ИКТ Мобильное приложение

Мобильное приложение Плеер Fonmix

Плеер Fonmix Современные компьютерные технологии социального моделирования

Современные компьютерные технологии социального моделирования Медиасистема Франции

Медиасистема Франции Ведение статистики ©VEON Ltd 2016

Ведение статистики ©VEON Ltd 2016 Установка токена

Установка токена Личный кабинет клиента my.ponyexpress.ru

Личный кабинет клиента my.ponyexpress.ru Для чего нужны СМИ

Для чего нужны СМИ Разработка АРМ дизайнера образовательного опыта

Разработка АРМ дизайнера образовательного опыта Компьютерная графика

Компьютерная графика Języki i paradygmaty programowania

Języki i paradygmaty programowania Сетевой архив проектно-сметной документации

Сетевой архив проектно-сметной документации Трансформация рынка юридических услуг как результат диджитализации бизнеса

Трансформация рынка юридических услуг как результат диджитализации бизнеса Алгоритм. Свойства алгоритма

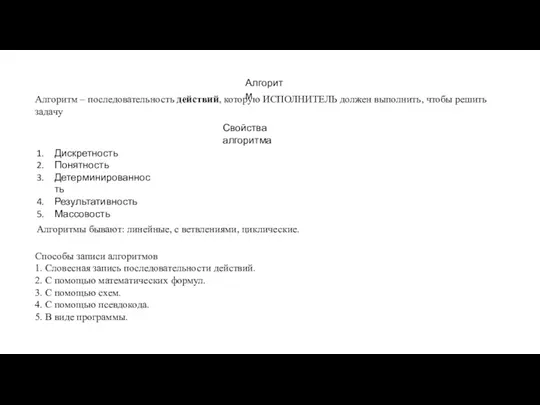

Алгоритм. Свойства алгоритма Основные процессы жизненного цикла программного средства

Основные процессы жизненного цикла программного средства Информационные ресурсы

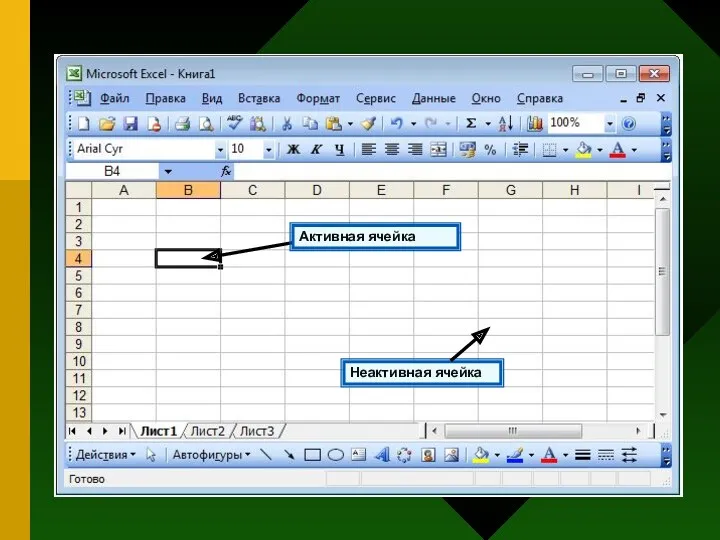

Информационные ресурсы Относительные, абсолютные и смешанные ссылки

Относительные, абсолютные и смешанные ссылки The property inspector in depth

The property inspector in depth Игра: ребус. Java. (Лекция 2)

Игра: ребус. Java. (Лекция 2) Операторы в языке Си. (Лекция 5)

Операторы в языке Си. (Лекция 5) Технические решения и проектирование подсистем автоматического управления в ЭСБ различного функционального назначения (Часть 3)

Технические решения и проектирование подсистем автоматического управления в ЭСБ различного функционального назначения (Часть 3) Файл. Полное имя файла

Файл. Полное имя файла Лабораторный практикум. Изучение информационных моделей ИЭС средствами Excel

Лабораторный практикум. Изучение информационных моделей ИЭС средствами Excel Операционные системы. Основные характеристики операционных систем. Внеаудиторная работа №6

Операционные системы. Основные характеристики операционных систем. Внеаудиторная работа №6 Презентация История развития вычислительной техники 7 класс

Презентация История развития вычислительной техники 7 класс