Клод Элвуд Шеннон

Claude Elwood Shannon

(30.04.1916 - 24.02.2001)

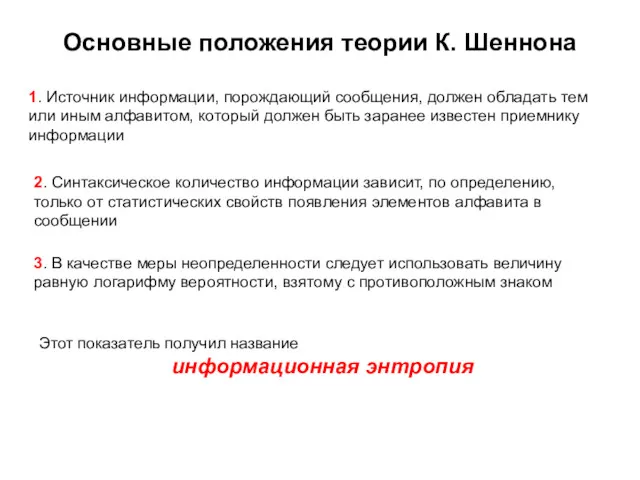

В 1936 году выпускник Мичиганского

университета Клод Шеннон, которому было тогда 21 год, имея два диплома бакалавра - по электротехнике и по математике, сумел ликвидировать разрыв между алгебраической теорией логики и ее практическим приложением. Свои идеи относительно связи между двоичным исчислением, булевой алгеброй и электрическими схемами Шеннон развил в докторской диссертации, опубликованной в 1938 году

В 1948 году опубликовал фундаментальную работу A Mathematical Theory of Communication, в которой сформулированы основы теории информации.

Большую ценность представляет другая работа – Communication Theory of Secrecy Systems (1949), в которой сформулированы математические основы криптографии.

C 1956 – член Национальной академии наук США и Американской академии искусств и наук.

Клод Элвуд Шеннон – один из создателей математической теории информации, в значительной мере предопределил своими результатами развитие общей теории дискретных автоматов, которые являются важными составляющими кибернетики

Основы информационной безопасности. Практическая работа 2. Основы криптографии

Основы информационной безопасности. Практическая работа 2. Основы криптографии Интернет-этика

Интернет-этика Сервисы сети Интернет

Сервисы сети Интернет Методическая инструкция. Создание годичного рассписания

Методическая инструкция. Создание годичного рассписания Структура языка Си. Основные функции ввода и вывода. Операторы языка. Обзор циклических операторов

Структура языка Си. Основные функции ввода и вывода. Операторы языка. Обзор циклических операторов Кесте арасындағы байланыс құрудың түлері

Кесте арасындағы байланыс құрудың түлері Открытый урок по теме Метод координат

Открытый урок по теме Метод координат Programming Logic and Design. Chapter 7. File Handling and Applications

Programming Logic and Design. Chapter 7. File Handling and Applications Выбор книг в библиотеке

Выбор книг в библиотеке Презентация.Логические законы.

Презентация.Логические законы. Презентации

Презентации Компьютерные сети. Локальная сеть

Компьютерные сети. Локальная сеть Потоки

Потоки Comments style. Стайл-гид

Comments style. Стайл-гид Проект по информатике Компьютер - помощник и друг

Проект по информатике Компьютер - помощник и друг КОМПЬЮТЕРНЫЕ ВИРУСЫ И АНТИВИРУСНЫЕ ПРОГРАММЫ

КОМПЬЮТЕРНЫЕ ВИРУСЫ И АНТИВИРУСНЫЕ ПРОГРАММЫ New Callback functionality for CBS (Callback Basic information)

New Callback functionality for CBS (Callback Basic information) Табличное решение логических задач

Табличное решение логических задач Информационные жанры

Информационные жанры Среда программирования Кумир. Чертежник

Среда программирования Кумир. Чертежник How to made a DOS Bootable

How to made a DOS Bootable Становление и развитие информационных технологий. Лекция 1

Становление и развитие информационных технологий. Лекция 1 Алгоритмы, структуры алгоритмов, структурное программирование

Алгоритмы, структуры алгоритмов, структурное программирование Проект программа GeoGebra

Проект программа GeoGebra Основы логики

Основы логики Intelektual boshqaruv tizimilari. 2-mavzu

Intelektual boshqaruv tizimilari. 2-mavzu История развития языков программирования

История развития языков программирования Internet security. About hackers, spam, threat identities

Internet security. About hackers, spam, threat identities