Содержание

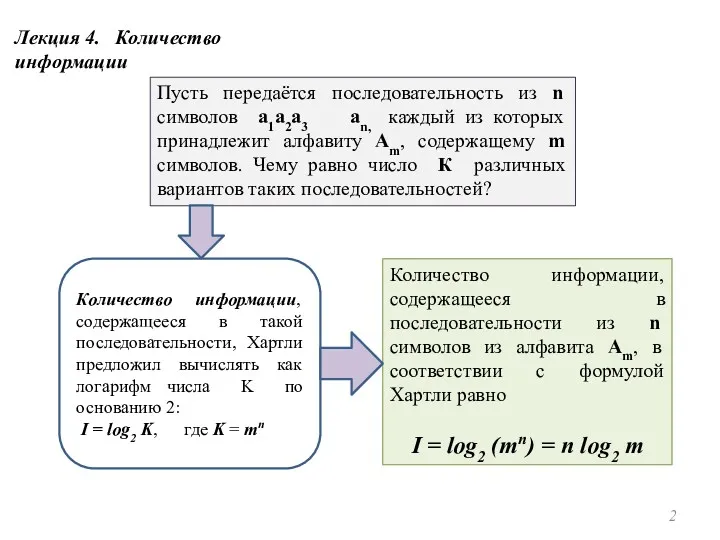

- 2. Пусть передаётся последовательность из n символов а1а2а3 аn, каждый из которых принадлежит алфавиту Am, содержащему m

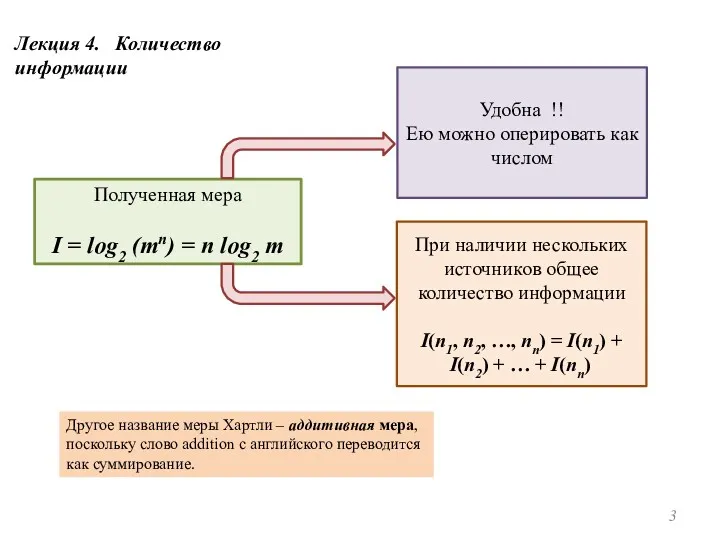

- 3. Лекция 4. Количество информации Полученная мера I = log2 (mn) = n log2 m Удобна !!

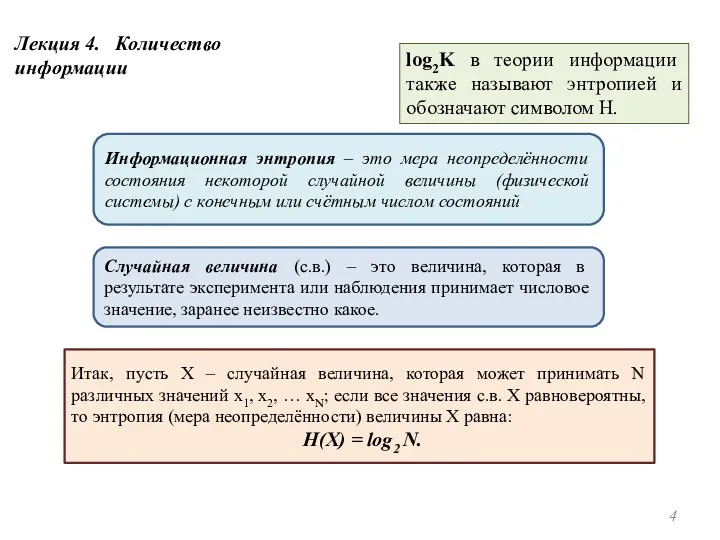

- 4. log2K в теории информации также называют энтропией и обозначают символом H. Информационная энтропия – это мера

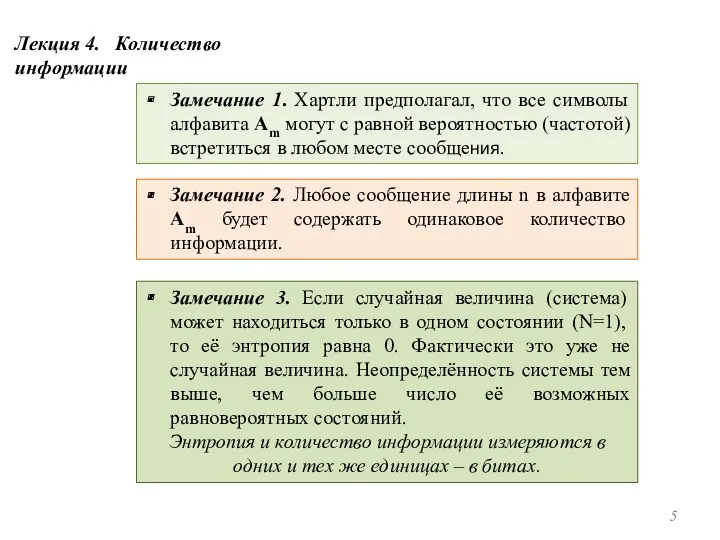

- 5. Замечание 1. Хартли предполагал, что все символы алфавита Am могут с равной вероятностью (частотой) встретиться в

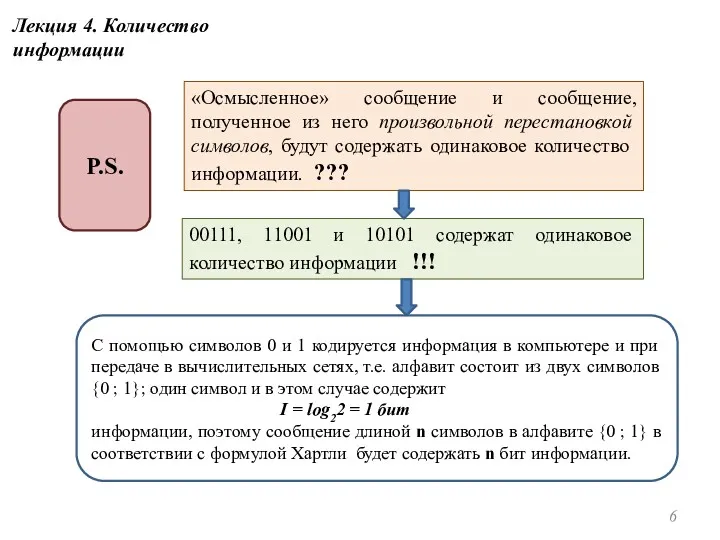

- 6. «Осмысленное» сообщение и сообщение, полученное из него произвольной перестановкой символов, будут содержать одинаковое количество информации. ???

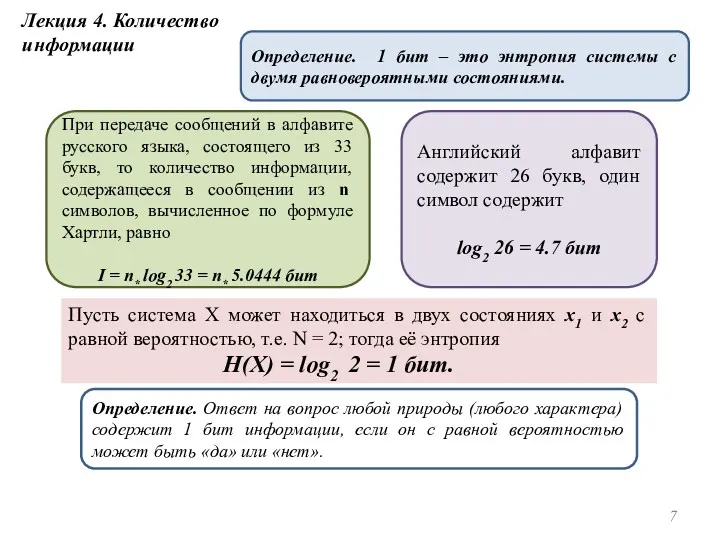

- 7. Лекция 4. Количество информации Определение. 1 бит – это энтропия системы с двумя равновероятными состояниями. Английский

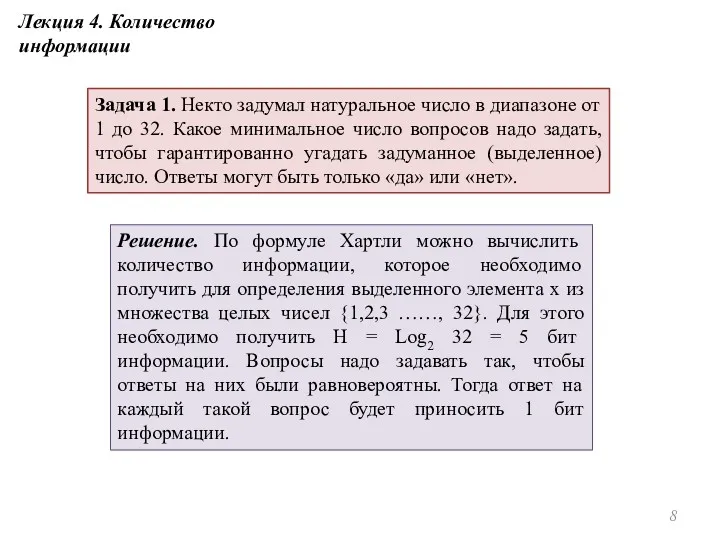

- 8. Задача 1. Некто задумал натуральное число в диапазоне от 1 до 32. Какое минимальное число вопросов

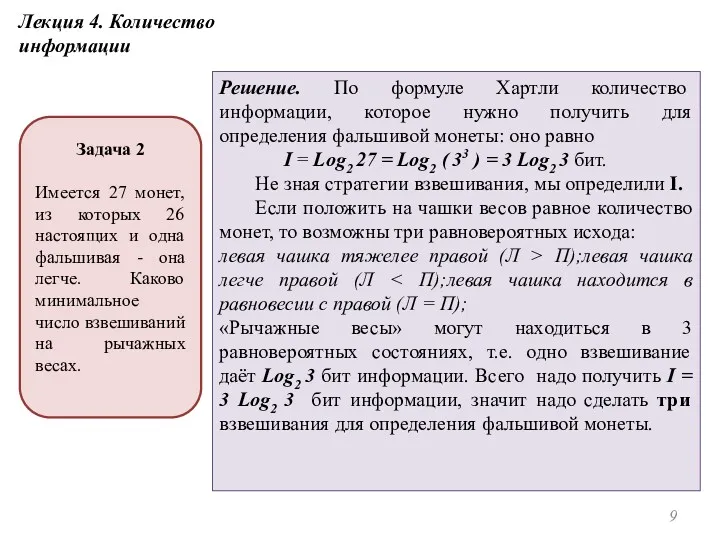

- 9. Решение. По формуле Хартли количество информации, которое нужно получить для определения фальшивой монеты: оно равно I

- 10. Лекция 4. Количество информации Синтаксический уровень Мера неопределенности зависит от указанных вероятностей, а количество информации в

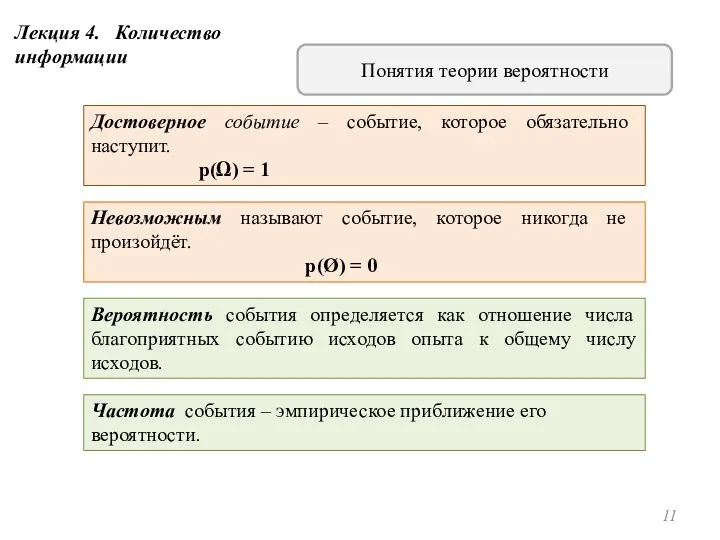

- 11. Достоверное событие – событие, которое обязательно наступит. p(Ω) = 1 Вероятность события определяется как отношение числа

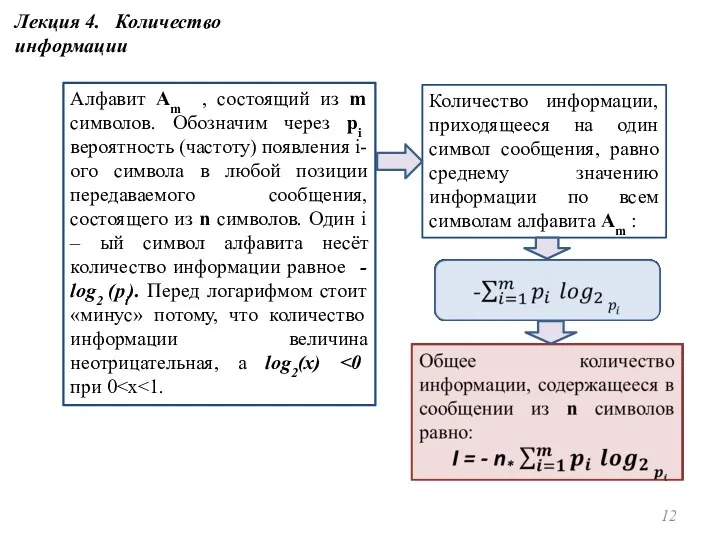

- 12. Алфавит Am , состоящий из m символов. Обозначим через pi вероятность (частоту) появления i-ого символа в

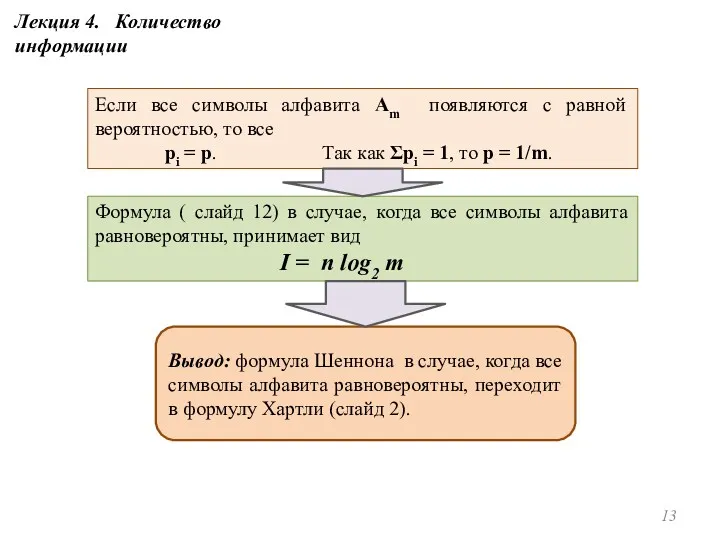

- 13. Если все символы алфавита Am появляются с равной вероятностью, то все pi = p. Так как

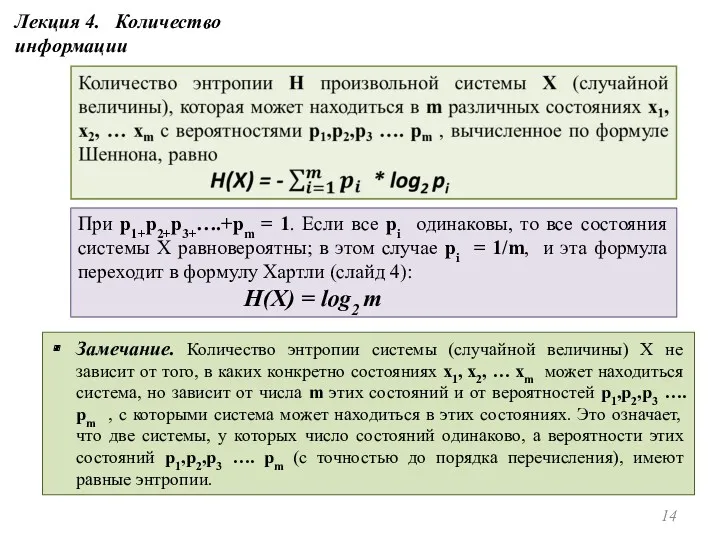

- 14. При p1+p2+p3+….+pm = 1. Если все pi одинаковы, то все состояния системы X равновероятны; в этом

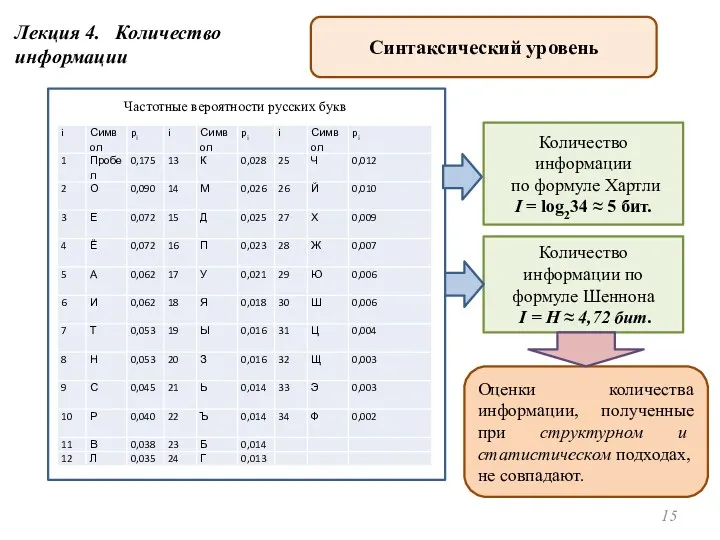

- 15. Лекция 4. Количество информации Синтаксический уровень Частотные вероятности русских букв Количество информации по формуле Хартли I

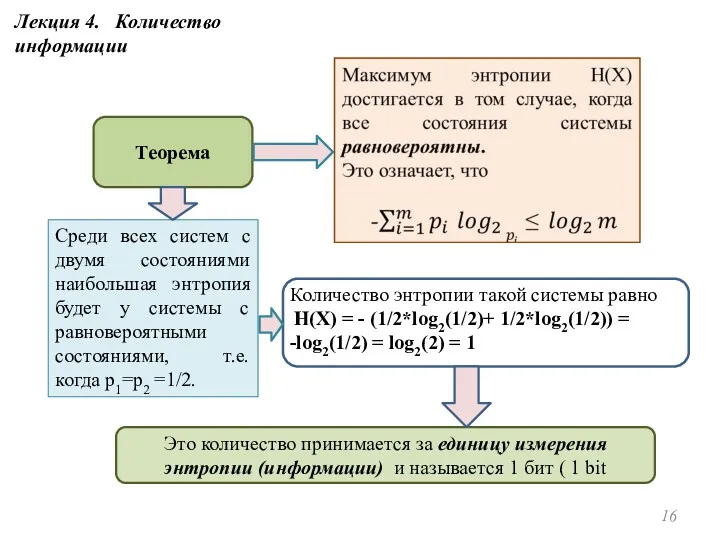

- 16. Теорема Среди всех систем с двумя состояниями наибольшая энтропия будет у системы с равновероятными состояниями, т.е.

- 18. Скачать презентацию

Безопасный Интернет

Безопасный Интернет CSS. Модель відображення

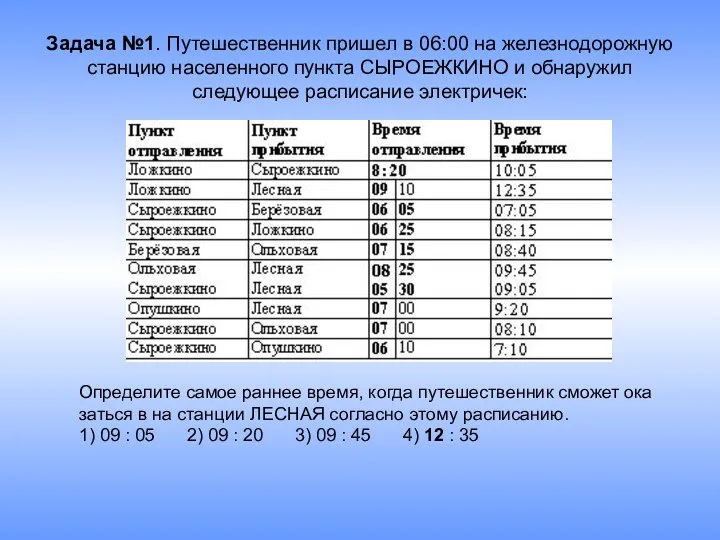

CSS. Модель відображення Задачи по информатике

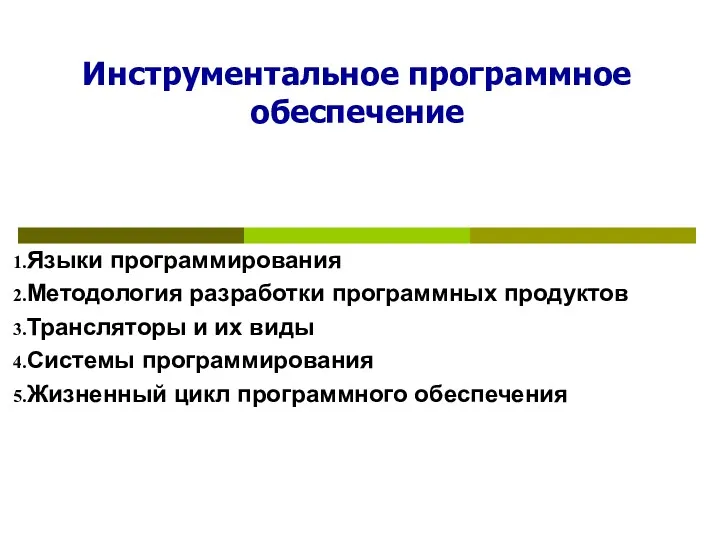

Задачи по информатике Инструментальное программное обеспечение. (Тема 7)

Инструментальное программное обеспечение. (Тема 7) Экспериментальная исследовательская студенческая пресс-служба ФНС

Экспериментальная исследовательская студенческая пресс-служба ФНС Планировщик. Планирование. Алгоритмы планирования в операционной системе

Планировщик. Планирование. Алгоритмы планирования в операционной системе Элементы криптографического анализа

Элементы криптографического анализа Операционная система

Операционная система Беспроводные решения

Беспроводные решения Компьютерные сети. Виды локальных сетей. Топология сети

Компьютерные сети. Виды локальных сетей. Топология сети Интегрированный урок по информатике Кодирование информации 3 класс

Интегрированный урок по информатике Кодирование информации 3 класс Осуществление поиска информации в Интернет. Решение задач ЕГЭ по теме

Осуществление поиска информации в Интернет. Решение задач ЕГЭ по теме Продающая презентация и проведение вебинара

Продающая презентация и проведение вебинара Приемы работы с информацией

Приемы работы с информацией Ергономіка вебсторінки

Ергономіка вебсторінки Архитектура персонального компьютера, структура вычислительных систем

Архитектура персонального компьютера, структура вычислительных систем Понятие алгоритма. Свойства алгоритма

Понятие алгоритма. Свойства алгоритма Техническое задание на разработку сайта www.lenoblspor

Техническое задание на разработку сайта www.lenoblspor Программирование и программные среды

Программирование и программные среды Требования к информационным системам

Требования к информационным системам Система счисления

Система счисления Текстовый редактор Word

Текстовый редактор Word Проверочная работа по информатике №2 (3 класс)

Проверочная работа по информатике №2 (3 класс) Двоичная арифметика

Двоичная арифметика Основы боевой подготовки. Лекция №10

Основы боевой подготовки. Лекция №10 Проект Социальные страницы ВКонтакте великих людей

Проект Социальные страницы ВКонтакте великих людей Составление анкеты в Google Forms

Составление анкеты в Google Forms Інформаційні технології та інформаційні системи

Інформаційні технології та інформаційні системи