Содержание

- 2. Три вопроса разработки компьютеров параллельного действия 1. Каков тип, размер и количество процессорных элементов? 2. Каков

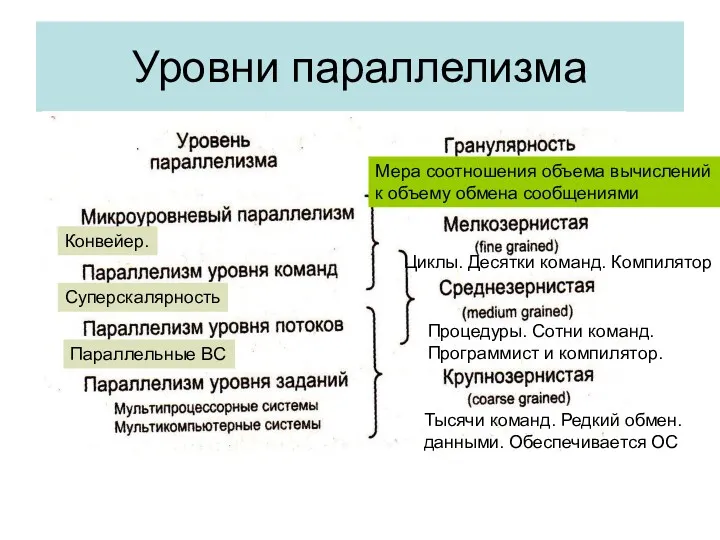

- 3. Уровни параллелизма Мера соотношения объема вычислений к объему обмена сообщениями Тысячи команд. Редкий обмен. данными. Обеспечивается

- 4. Гранулярность и коммуникационная задержка Если коммуникационная задержка минимальна, то наилучшую производительность обещает мелкоструктурное разбиение программ. Если

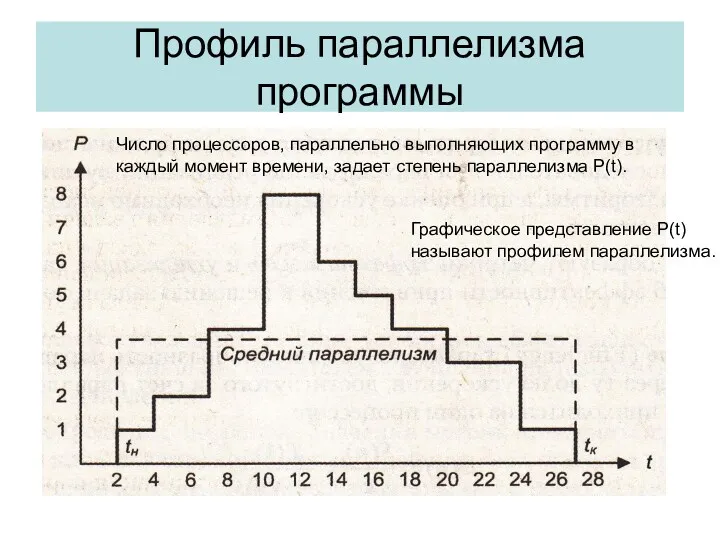

- 5. Профиль параллелизма программы Число процессоров, параллельно выполняющих программу в каждый момент времени, задает степень параллелизма P(t).

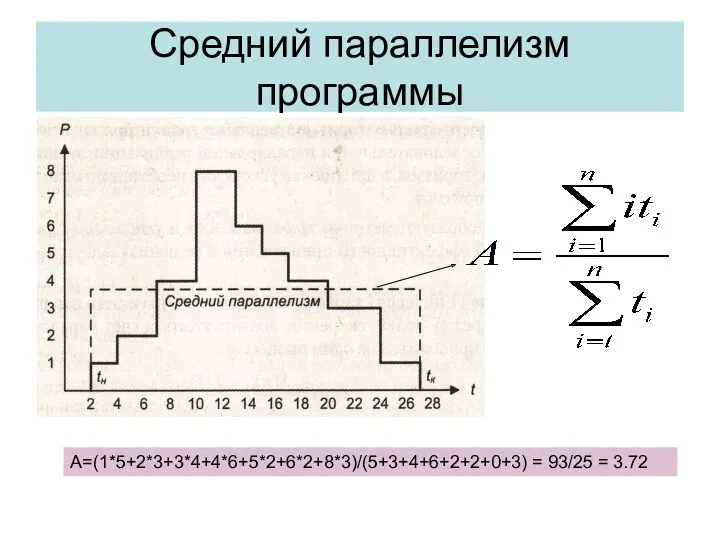

- 6. Средний параллелизм программы А=(1*5+2*3+3*4+4*6+5*2+6*2+8*3)/(5+3+4+6+2+2+0+3) = 93/25 = 3.72

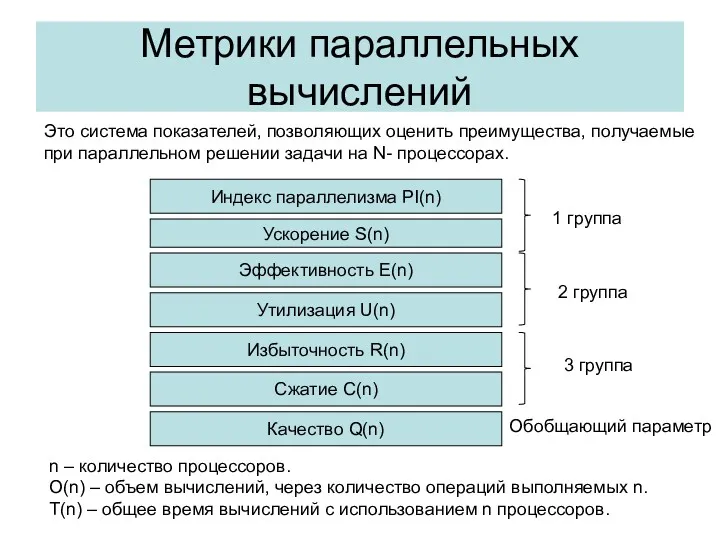

- 7. Метрики параллельных вычислений Это система показателей, позволяющих оценить преимущества, получаемые при параллельном решении задачи на N-

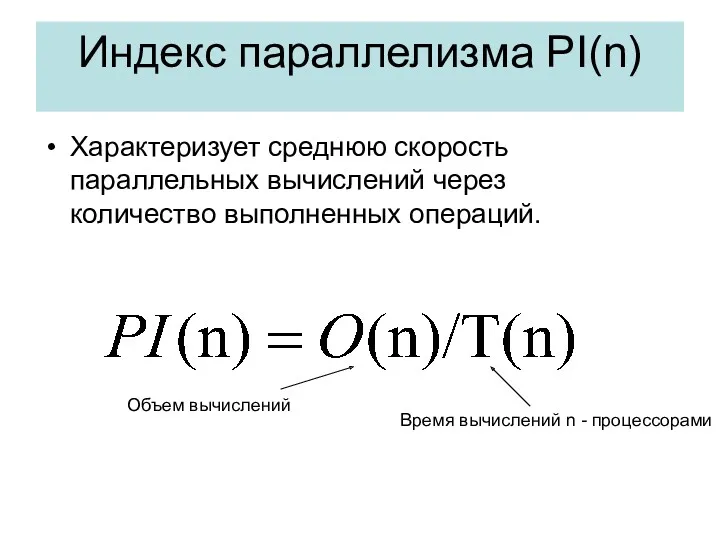

- 8. Индекс параллелизма PI(n) Характеризует среднюю скорость параллельных вычислений через количество выполненных операций. Объем вычислений Время вычислений

- 9. Ускорение Ускорение за счет параллельного выполнения программы – показатель эффективности скорости вычислений. Вычисляется как отношение времени

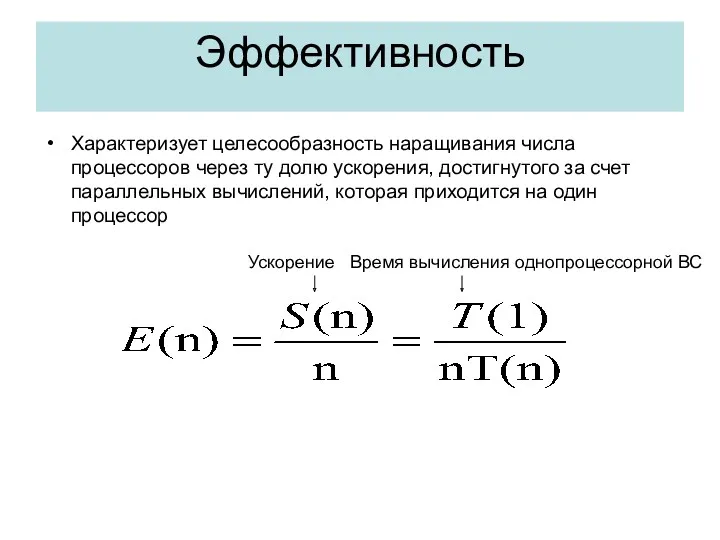

- 10. Эффективность Характеризует целесообразность наращивания числа процессоров через ту долю ускорения, достигнутого за счет параллельных вычислений, которая

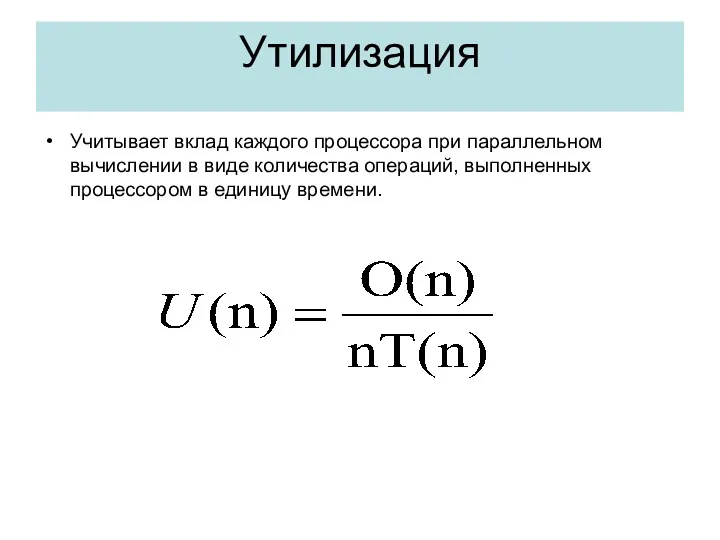

- 11. Утилизация Учитывает вклад каждого процессора при параллельном вычислении в виде количества операций, выполненных процессором в единицу

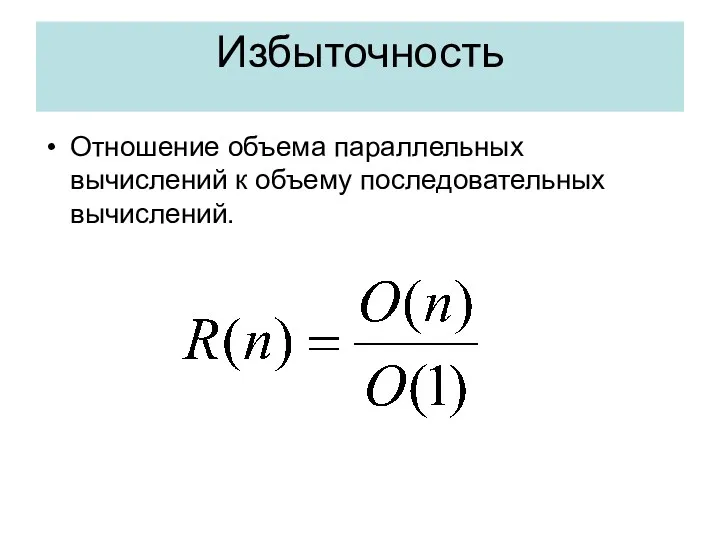

- 12. Избыточность Отношение объема параллельных вычислений к объему последовательных вычислений.

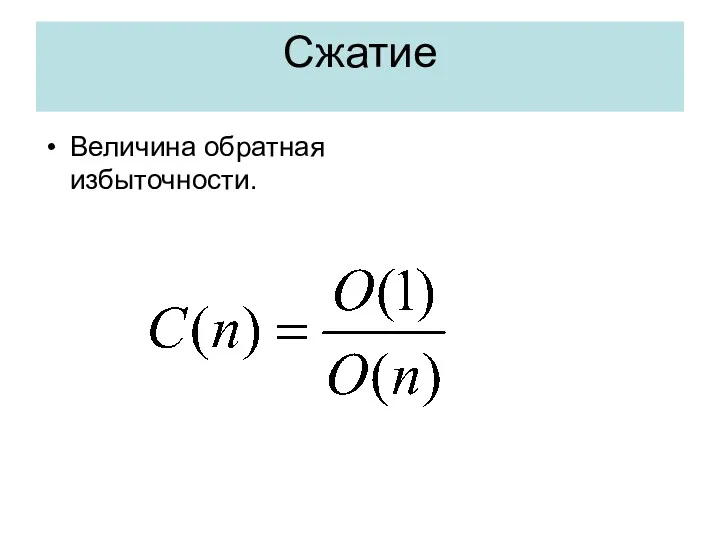

- 13. Сжатие Величина обратная избыточности.

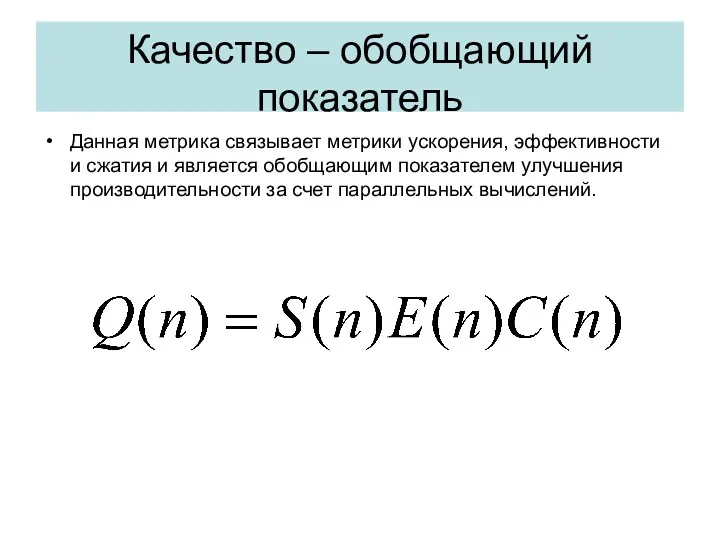

- 14. Качество – обобщающий показатель Данная метрика связывает метрики ускорения, эффективности и сжатия и является обобщающим показателем

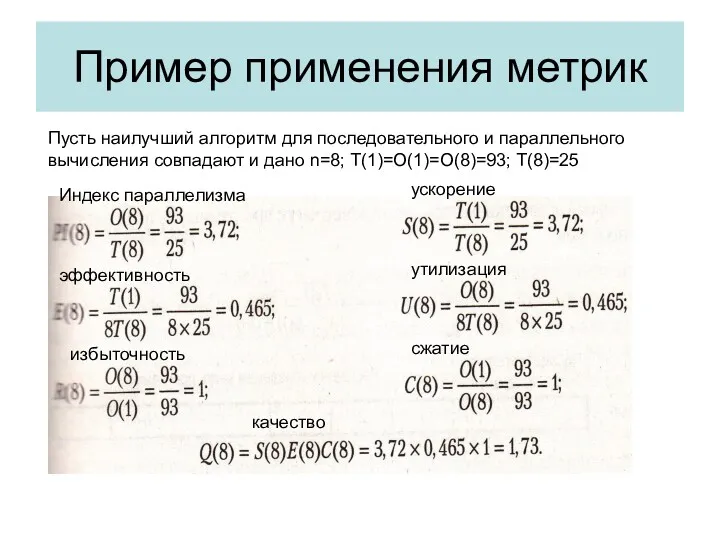

- 15. Пример применения метрик Пусть наилучший алгоритм для последовательного и параллельного вычисления совпадают и дано n=8; T(1)=O(1)=O(8)=93;

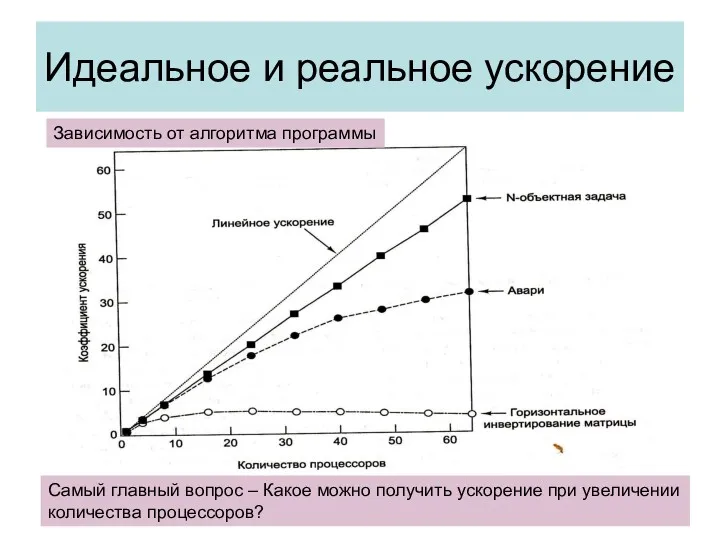

- 16. Идеальное и реальное ускорение Самый главный вопрос – Какое можно получить ускорение при увеличении количества процессоров?

- 17. Причины недостижимости идеального ускорения Все программы имеют последовательную часть, которая не может быть распараллелена: фаза инициализации;

- 18. Издержки из-за дисбаланса загрузки процессоров. Между точками синхронизации каждый из процессоров должен быть загружен одинаковым объемом

- 19. Коммуникационные издержки. Если принять, что обмен информацией и вычисления могут перекрываться, то любые коммуникации между процессорами

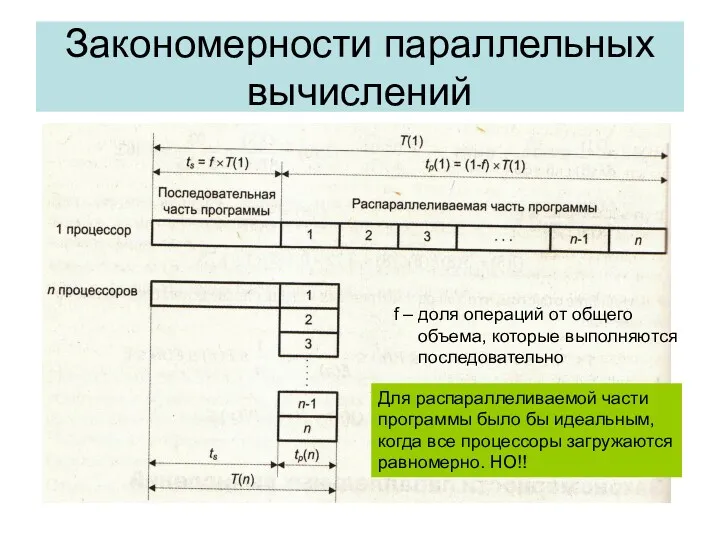

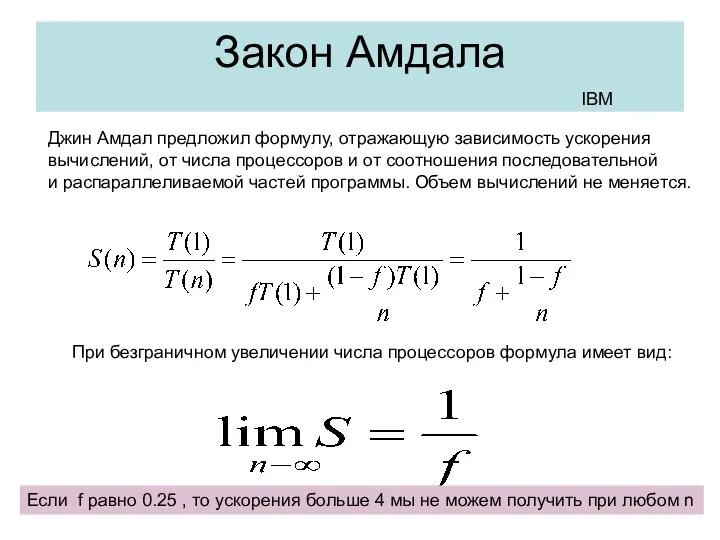

- 20. Закономерности параллельных вычислений f – доля операций от общего объема, которые выполняются последовательно Для распараллеливаемой части

- 21. Дополнительные факторы влияющие на ускорение Время ожидания в коммуникациях. Ограниченная пропускная способность каналов. Недостатки алгоритмов программной

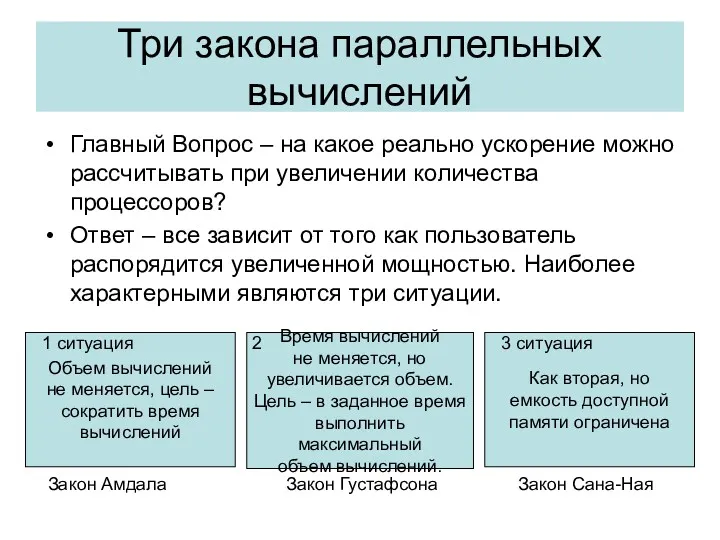

- 22. Три закона параллельных вычислений Главный Вопрос – на какое реально ускорение можно рассчитывать при увеличении количества

- 23. Закон Амдала Джин Амдал предложил формулу, отражающую зависимость ускорения вычислений, от числа процессоров и от соотношения

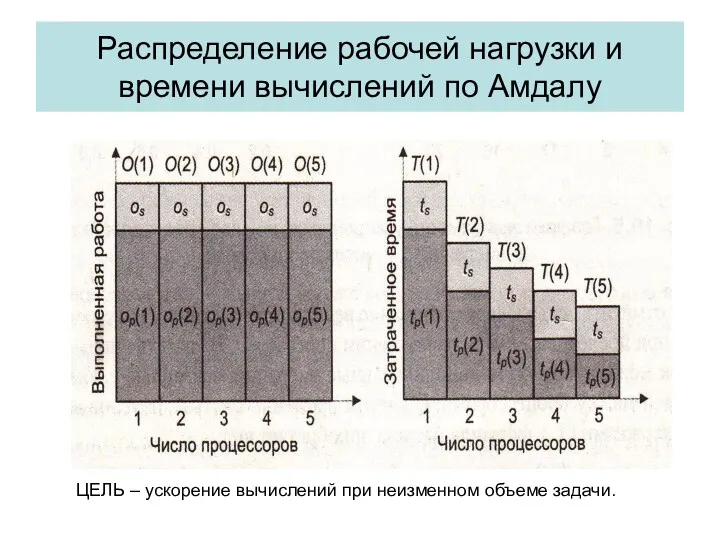

- 24. Распределение рабочей нагрузки и времени вычислений по Амдалу ЦЕЛЬ – ускорение вычислений при неизменном объеме задачи.

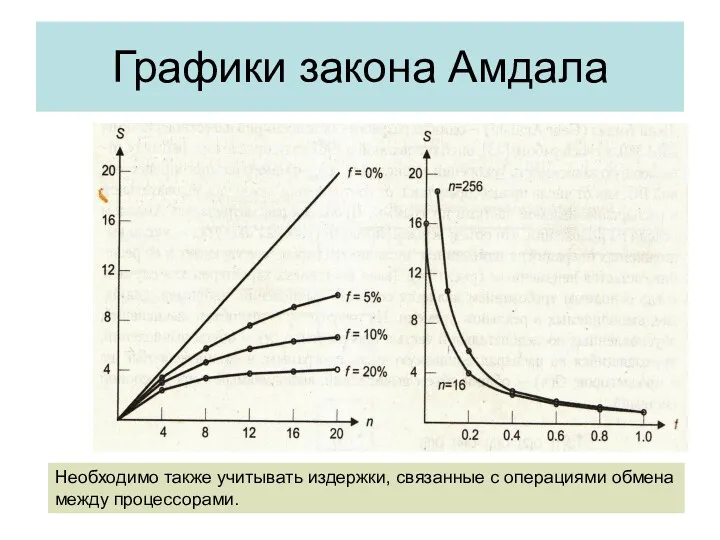

- 25. Графики закона Амдала Необходимо также учитывать издержки, связанные с операциями обмена между процессорами.

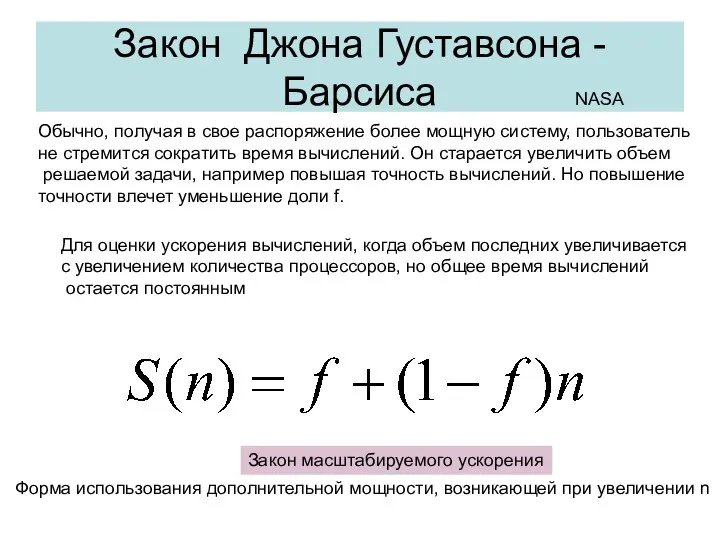

- 26. Закон Джона Густавсона - Барсиса Обычно, получая в свое распоряжение более мощную систему, пользователь не стремится

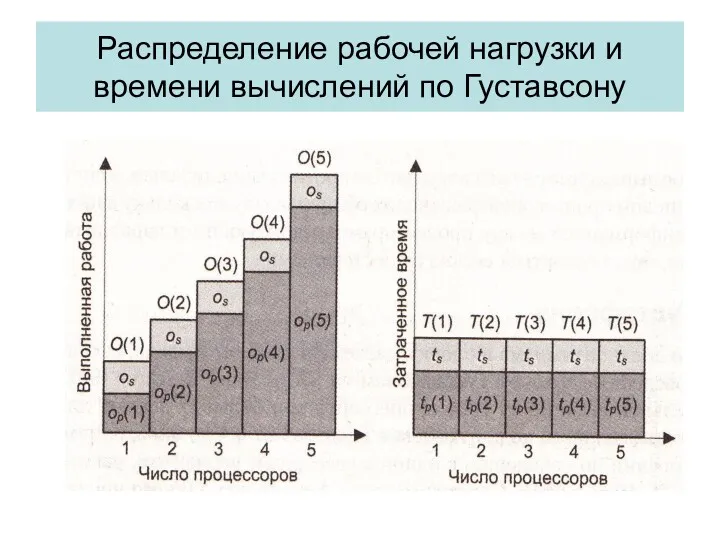

- 27. Распределение рабочей нагрузки и времени вычислений по Густавсону

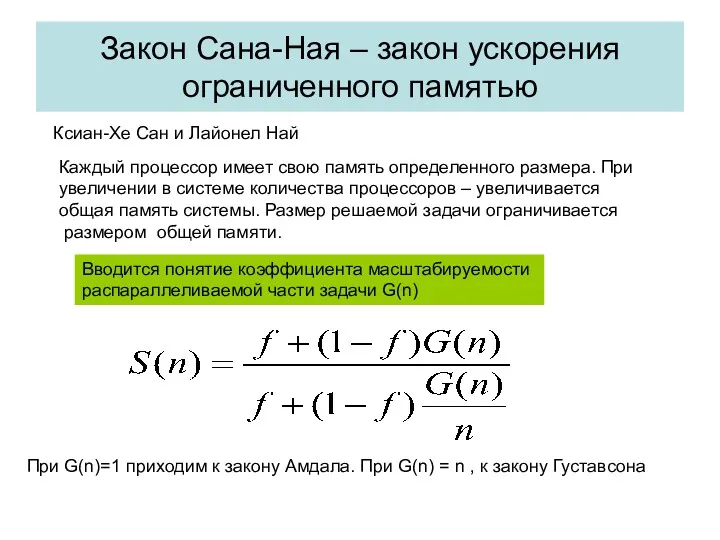

- 28. Закон Сана-Ная – закон ускорения ограниченного памятью Ксиан-Хе Сан и Лайонел Най Каждый процессор имеет свою

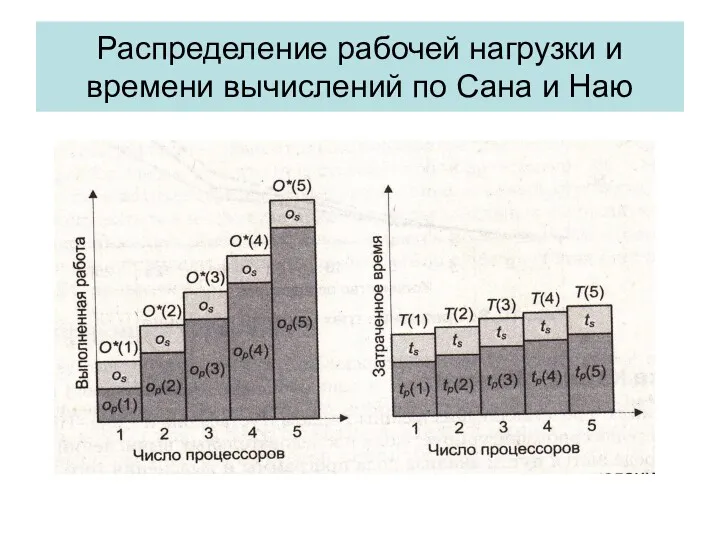

- 29. Распределение рабочей нагрузки и времени вычислений по Сана и Наю

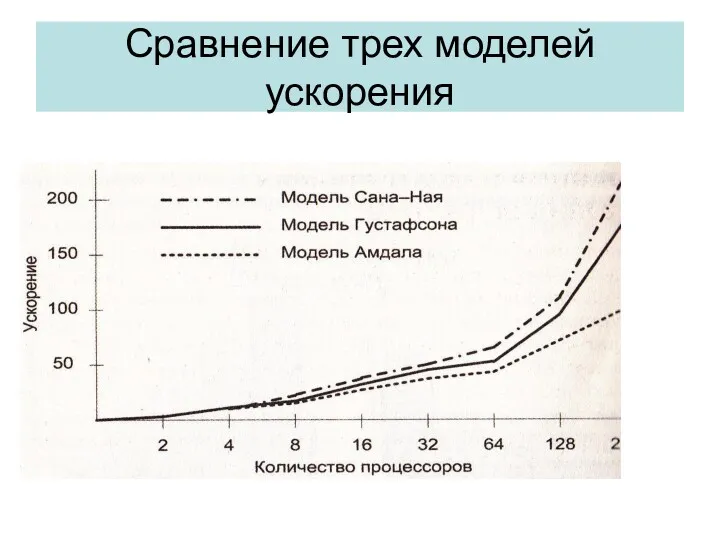

- 30. Сравнение трех моделей ускорения

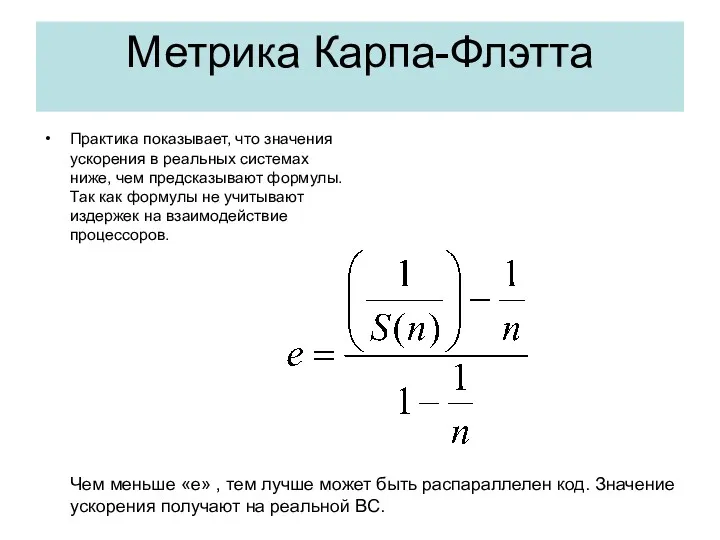

- 31. Метрика Карпа-Флэтта Практика показывает, что значения ускорения в реальных системах ниже, чем предсказывают формулы. Так как

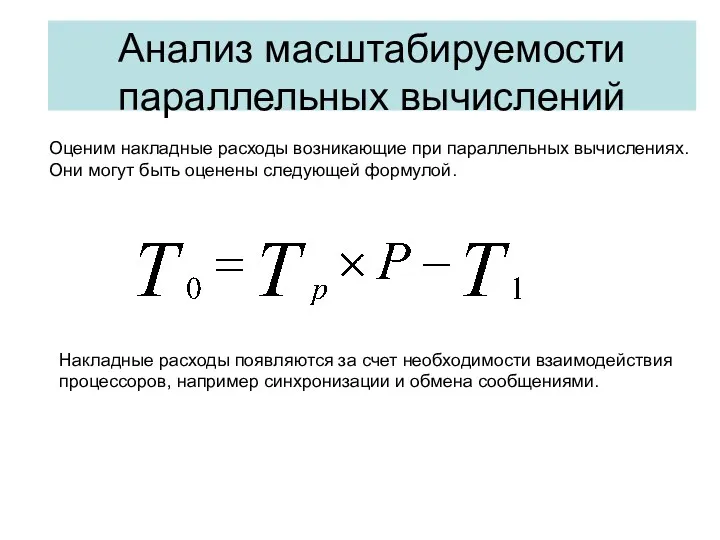

- 32. Анализ масштабируемости параллельных вычислений Оценим накладные расходы возникающие при параллельных вычислениях. Они могут быть оценены следующей

- 34. Скачать презентацию

Режими роботи з текстовим документом

Режими роботи з текстовим документом Массивы в Java. Тема 3.1

Массивы в Java. Тема 3.1 Основные сведения об алгоритмах. 11 класс

Основные сведения об алгоритмах. 11 класс Электронный ЮУрГУ. Форум. Таджикский язык

Электронный ЮУрГУ. Форум. Таджикский язык Элементы управления

Элементы управления Хакеры. История появления

Хакеры. История появления Компьютерные методы обработки геологической информации

Компьютерные методы обработки геологической информации Киберугрозы. Защита от киберугроз

Киберугрозы. Защита от киберугроз Тестовые артефакты, документация. Risk-Based Testing

Тестовые артефакты, документация. Risk-Based Testing Сайт проекта Вернем реки городу

Сайт проекта Вернем реки городу Test cases creation. Part 1. Tat training

Test cases creation. Part 1. Tat training Принципы сотовой связи. (Лекция 10)

Принципы сотовой связи. (Лекция 10) Метод излучательности (Radiosity)

Метод излучательности (Radiosity) Двоичная арифметика

Двоичная арифметика Windows XP

Windows XP Библиотека в социальных сетях

Библиотека в социальных сетях 8 класс, урок Информационные процессы в технике.

8 класс, урок Информационные процессы в технике. Правила оформления библиографического списка литературы к научной работе

Правила оформления библиографического списка литературы к научной работе Автоматизована обробка інформації в системі пенсійного забезпечення України

Автоматизована обробка інформації в системі пенсійного забезпечення України Тест по теме:Условный оператор Диск

Тест по теме:Условный оператор Диск Интеллектуальная игра по информатике для 5 классов Самый умный

Интеллектуальная игра по информатике для 5 классов Самый умный Библиотечно-библиографическая классификация (ББК)

Библиотечно-библиографическая классификация (ББК) Как устроен компьютер. §29. Современные компьютерные системы

Как устроен компьютер. §29. Современные компьютерные системы Интернет будущего

Интернет будущего GOA stall artwork

GOA stall artwork Виртуальное и живое общение в современном мире

Виртуальное и живое общение в современном мире ICT practical work 2

ICT practical work 2 Автоматизированная информационная система Молодежь России

Автоматизированная информационная система Молодежь России